一种考虑海浪干扰的无人艇回收分布式决策仿真系统

(一)技术领域

1.本发明属于人工智能与海洋工程技术领域,特别涉及一种考虑海浪干扰的无人艇回收分布式决策仿真系统。

(二)

背景技术:

2.海面无人艇作为海洋环境设备的一员,是一种自主式海洋航行器,能够在无人为参与控制下,独立航行并执行任务,以其高灵活性、可拓展性和强自主性等独特优势发挥着不可或缺的作用。目前,海面无人艇归航引导回收需要花费大量的人力物力,难以适应当代海洋作业的需求。首先,无人艇动力学和动力学模型参数不确定性,导致在工程应用中控制器性能差;其次,海面环境复杂,未知扰动繁多,给归航路径规划和轨迹跟踪带来了极大挑战;最后,母船的回收装置与海面无人艇之间自主对接受到诸多限制,高精度引导回收控制是亟待解决的难点。

3.传统的控制算法,面对复杂的海洋环境,相较于地面的自动驾驶任务,无人艇的控制为欠驱动的运动模型,常常不能得到很好的效果。论文《混合海浪作用下无人艇泊船姿态自动控制方法》中设定海浪的遭遇角为45

°

,90

°

和130

°

,测试3种对比控制方法的艏摇角、横摇角以及舵角的响应角度,设计特定的海浪遭遇角进行仿真实验,实验对比详尽,但在仿真实验中并未采用模拟物理交互的方式实现无人艇控制,然而真实海浪运动的情况更复杂,仅通过特定遭遇角无法还原实际海浪作用;论文《基于深度强化学习的无人艇控制研究》中采用ddpg算法,并将算法融入到传统控制模型中。虽然该论文中同样采用了强化学习算法对船体进行控制,但对于海浪的数学建模过于简单,且只考虑了横摇角对船体的影响,难以证明方案可应用于实际环境。

(三)

技术实现要素:

4.本发明旨在提供一种考虑海浪干扰的无人艇回收分布式决策仿真系统,提供一种虚拟环境下的无人艇决策、训练与控制方案。利用其分布式通信的特点,更易于使用迁移学习技术将该方案应用到现实场景中。为模拟复杂海况中海浪对控制器的扰动,本方案中未采用控制领域中常用的海浪模拟方法,即间接的将海浪扰动进行数学建模,并作为扰动信号加入控制器进行反馈控制;而是采用直接物理仿真的方式,在虚拟环境中基于规则生成海浪波,计算机通过计算无人艇与流体的实时物理交互,模拟海浪对船体的影响。采用强化学习算法,使智能体可观测到环境的部分信息并做出动作,实现无人艇的自主训练与决策。在复杂海况下,相比传统控制器具有更强的鲁棒性,可以更好的应对海浪干扰。

5.为实现上述目的,本发明采用如下技术方案:

6.s1、在虚幻引擎(ue4)中,搭建无人艇回收任务的仿真环境并完成对接舱体的3d建模,具体包括以下子步骤:

7.s11、在仿真环境中,利用多个gerstner波的叠加,实现对于复杂海况中的海浪环境的模拟;

8.s12、将无人艇抽象为智能体,为无人艇设计在离散动作空间下的运动控制器,动作空间中包含左转、右转、前进、后退、左前方向行进、右前方向行进、左后方向行进、右后方向行进以及无动作,共计九种可执行动作;

9.s13、对与无人艇实现对接的舱体进行建模,对接舱上设置三个不共线的可观测点,作为环境中状态空间的一部分,无人艇可观测到对接舱体实时相对位姿;

10.s14、完成环境规则模块的搭建,包括智能体随机初始化生成位置、奖励机制设定、碰撞机制设定以及胜利和失败的判定条件设定;

11.具体的奖励函数设置,可由如下公式表示:

[0012][0013]

式中:α,β,γ为平衡距离变化与累计碰撞力对奖励的影响所设计的权重系数,-ε为船体损毁惩罚系数,-μ为出界惩罚系数,-η为翻船惩罚系数,φ为终局奖励系数,α,β,γ,ε,μ,η,φ均为可调超参数,是常数,d

t

表示本次通信过程无人艇与对接舱的多个可观测点最终的平均距离大小,d

t-1

为上一次通信过程无人艇与对接舱的多个可观测点最终的平均距离大小,d

max

表示无人艇与最终目标点限制的最大距离,如果距离超出d

max

则代表无人艇超出地图边界,fc表示本轮任务中无人艇与对接舱产生过的累计碰撞力,累计碰撞力越大,产生的惩罚越大,当累计碰撞力大于设置的上限f

max

,将会判定本轮为负,给予-ε的惩罚;当无人艇行驶开出地图边界,同样判负,给予-μ的惩罚;当无人艇因为海浪或者碰撞造成船体打翻,判负并给予-η的惩罚,最终如果任务胜利,会给予φ的终局奖励;

[0014]

s2、基于duelingnetwork算法,搭建智能体决策模块,针对本应用场景,优化神经网络结构,使决策模块具有短时记忆功能,可以让智能体在该模型下能更好的预测未来状态,具体包括以下子步骤:

[0015]

s21、分别记录过去四个时刻下对接舱与无人艇的相对位置,作为智能体的部分可观测的状态信息,计算每个时刻下的三个观测点与无人艇的坐标之差:

[0016]

p

it

(x,y,z)=q

it

(x,y,z)-w

t

(x,y,z)

[0017]

式中:q

it

(x,y,z)为对接舱可观测点的坐标,其中i表示为对接舱的第i个可观测点,t表示其为第t时刻的坐标,w

t

(x,y,z)表示第t时刻的无人艇坐标,p

it

(x,y,z)表示t时刻对接舱的第i个可观测点与无人艇的坐标差值;

[0018]

s22、将步骤s21所得的相对位置信息进行展平处理,赋值到神经网络的节点中,作为智能体神经网络输入层的输入;

[0019]

s23、利用神经网络拟合优势函数以及最优状态价值函数,网络节点的输出可评价动作的好坏,根据动作的评价可选择当前状态下最优动作;

[0020]

s24、使用优先经验回放机制,建立经验池,存入的信息为每一次通信所保存的四个时刻的环境状态、执行动作、环境奖励以及状态转移后的新的环境状态,训练神经网络时根据每条经验的重要性的不同,赋予不同采样概率,依照其概率分布随机抽取经验;

[0021]

s3、建立强化学习控制器与仿真环境的分布式通信系统,将控制器置于服务器端,仿真环境置于服务端,具体包括以下子步骤:

[0022]

s31、将强化学习控制器置于服务器端,服务器端共包含两条线程,主线程接收来自于仿真环境四个时刻的环境信息,完成神经网络的前向传播,计算最终智能体所需执行动作的编号,并将该条经验存入经验池;线程2负责从经验池取出数据,完成神经网络的前向传播与反向传播,实现智能体的异步训练;

[0023]

s32、将仿真环境置于客户端,每四分之一个通信时间,采样一次环境状态信息,并将相关信息存入状态数组,通信时接收服务器端传来的动作指令,并将状态数组传至服务器端;

[0024]

具体的通信过程如下所示:

[0025]

首先,服务器端主线程阻塞,等待接收客户端通信数据;线程2持续从经验池中取出数据训练神经网络,每当神经网络训练一轮结束时,线程2向主线程发送消息,如果此时主线程未接收到客户端通信数据,线程2开启下一轮训练;如果主线程已接收到客户端通信数据,线程2挂起,主线程接收数据并送入神经网络完成前向传播,计算动作评分,选择最优动作,将对应的动作编号发送至客户端,并将本轮状态信息,执行动作以及所获奖励存入经验池后,线程2唤醒,主线程阻塞,等待接收客户端的下一轮通信数据;其次,客户端接收服务器端传过来的动作编号,令无人艇每一帧都反复执行该动作直至下一次通信为止,设定每次通信间隔为0.8秒,客户端每0.2秒记录并计算一次环境状态信息,存入状态数组,在通信时将状态数组打包为结构体,传至服务器端;

[0026]

s4、启动服务器与客户端,开启智能体的训练与控制,具体包括以下子步骤:

[0027]

s41、启动服务器端,等待客户端连接;

[0028]

s42、启动客户端,环境初始化,随机智能体生成位置;

[0029]

s43、客户端向服务器发送连接请求,建立连接;

[0030]

s44、开启ai控制,开启一轮任务的训练,服务器与客户端每隔0.8秒通信一次,交互数据;

[0031]

s45、根据环境规则下的判定条件,判断训练是否结束,给予终局奖励或失败惩罚,开启下一轮训练并重复执行s41到s45,如果断开通信连接,执行s46;

[0032]

s46、保存训练好的神经网络模型,方便应用于下次训练。

[0033]

本发明具有如下的有益效果:

[0034]

(1)本发明在仿真环境下对海浪波进行物理模拟,可实现实时物理交互,针对控制系统,相较传统方法中对海浪进行数学建模,并作为信号输入进控制器的方法,对于复杂海洋环境,具有更强的可验证性以及实用性;

[0035]

(2)本发明采用深度强化学习算法实现无人艇的自动控制,算法根据智能体与场景交互得到经验训练模型并做出决策,有较强的鲁棒性;针对该应用场景,优化基于dueling network算法的神经网络结构,将过去四个时刻的状态都作为神经网络的输入,可以让智能体对未来时刻状态具有一定预测能力,无人艇应对实时变化且难以预测的海浪环境,具有更好的表现效果;

[0036]

(3)本发明采用分布式的通信方法,该方法将训练过程与决策过程多线程异步执行,进而提高训练效率;通过调整通信频率,可实现实际环境中对智能体的远程控制,而无

需将运算单元搭载至无人艇上;

[0037]

(4)本发明将决策模块与仿真模块隔离,分别搭载至服务器端和客户端,在虚拟环境下可以得到现实场景中难以获得的经验数据,如翻船、碰撞或损毁,保存仿真模块下训练的神经网络模型,进一步投入真实场景训练,可实现对真实环境的迁移学习任务。

(四)附图说明

[0038]

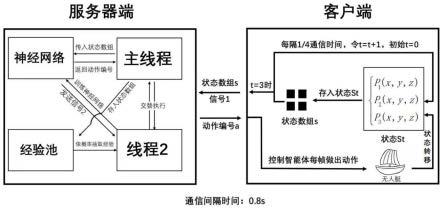

图1为系统整体框架图;

[0039]

图2为一维gerstner波示意图;

[0040]

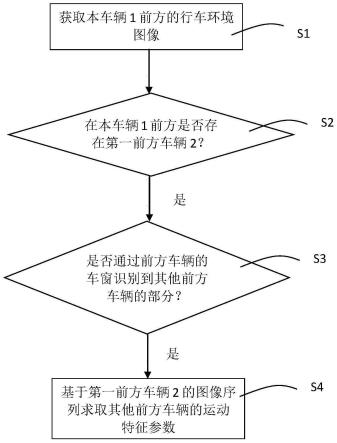

图3为智能体训练流程图;

[0041]

图4为包含可观测点信息的对接舱三视图;

[0042]

图5为可观测多个时刻信息的dueling network算法神经网络图;

[0043]

图6为训练界面效果图。

(五)具体实施方式

[0044]

为了使本发明的目的、技术方案以及优点更加清楚明白,以下结合附图及试验实例,对本发明进行进一步的详细说明。应当理解,此处所描述的具体实施例仅用于解释本发明,并不用于限定本发明。本发明系统整体框架图如图1所示。

[0045]

s1、在虚幻引擎(ue4)中,搭建无人艇回收任务的仿真环境并完成对接舱体的3d建模,具体包括以下子步骤:

[0046]

s11、在仿真环境中,利用多个gerstner波的叠加,实现对于复杂海况中的海浪环境的模拟;

[0047]

波形叠加是模拟海浪波动的一种方法,可通过叠加不同周期,不同振幅以及不同方向的波形模拟出流体的波动效果。单个gerstner波不同于正弦以及余弦波形,其波峰尖锐,波谷平缓,更接近于真实的海洋表面,为模拟真实海水表面,需要使用多个gerstner波进行叠加,多个gerstner波叠加后的计算公式可写为如下形式:

[0048][0049]

式中:x,y为坐标点在xz平面的位置分量,q为波浪的陡峭参数,如果q为0,则产生的是通常的正弦波,d控制波浪的运动方向,a为波浪的振幅,t为不断变化的时间变量,用以产生波移动的效果,为频率,与波长有关,为相位,i表示叠加的第几个gerstner波。

[0050]

s12、将无人艇抽象为智能体,为无人艇设计在离散动作空间下的运动控制器,动作空间中包含左转、右转、前进、后退、左前方向行进、右前方向行进、左后方向行进、右后方向行进以及无动作,共计九种可执行动作;

[0051]

s13、对与无人艇实现对接的舱体进行建模,对接舱上设置三个不共线的可观测

点,作为环境中状态空间的一部分,无人艇可观测到对接舱体实时相对位姿;

[0052]

对于刚体而言,运动状态可以分为平动和转动,如果能够确定刚体上面的三个不共线点的位置,便可以得知其实时的运动状态,因此在对接舱上需设置三个不共线的可观测点,令智能体得到对接舱的三个可观测点相对于无人艇自身的位置信息,智能体便可通过其信息还原出整个对接舱的运动状态,最终则可以利用智能体的自主学习能力完成无人艇对接回收工作。

[0053]

s14、完成环境规则模块的搭建,包括智能体随机初始化生成位置、奖励机制设定、碰撞机制设定以及胜利和失败的判定条件设定;

[0054]

智能体在每次的新一轮任务开始时,其出生点会随机被设置在最终回收位置附近的一定范围之内。在任务进程中,会检测无人艇与对接舱体产生的碰撞的力的大小,并且会记录下来一轮中累计产生的力的大小,当无人艇能够以最合适的角度进入对接舱时,会产生最小的碰撞力,对船体本身的损伤最小;反之,如果以错误的角度接触对接舱,不仅会让船体无法进入到对接舱体之内,同时也会因为无法进入而反复尝试,最终累计下来的碰撞力会造成对无人艇体的不可挽回的损害。所以对于可能会对无人艇造成损伤的情况,在奖励函数中对累计受力设置了一定的惩罚项。任务的胜利条件为,在不造成无人艇的大量损伤的情况下,成功进入到对接舱之内完成对接;任务的失败条件分为以下几种:分别是船体被打翻,船开出了地图边界之外以及超出了一轮所应有的训练时间。当达成失败或胜利条件时,将会重置环境相关信息,无人艇随机位置生成,进行新一轮的训练。具体的奖励函数设置,可由如下公式表示:

[0055][0056]

式中:α,β,γ为平衡距离变化与累计碰撞力对奖励的影响所设计的权重系数,-ε为船体损毁惩罚系数,-μ为出界惩罚系数,-η为翻船惩罚系数,φ为终局奖励系数,α,β,γ,ε,μ,η,φ均为可调超参数,是常数,d

t

表示本次通信过程无人艇与对接舱的多个可观测点最终的平均距离大小,d

t-1

为上一次通信过程无人艇与对接舱的多个可观测点最终的平均距离大小,d

max

表示无人艇与最终目标点限制的最大距离,如果距离超出d

max

则代表无人艇超出地图边界,fc表示本轮任务中无人艇与对接舱产生过的累计碰撞力,累计碰撞力越大,产生的惩罚越大,当累计碰撞力大于设置的上限f

max

,将会判定本轮为负,给予-ε的惩罚;当无人艇行驶开出地图边界,同样判负,给予-μ的惩罚;当无人艇因为海浪或者碰撞造成船体打翻,判负并给予-η的惩罚,最终如果任务胜利,会给予φ的终局奖励。

[0057]

s2、基于duelingnetwork算法,搭建智能体决策模块,针对本应用场景,优化神经网络结构,使决策模块具有短时记忆功能,可以让智能体在该模型下能更好的预测未来状态,具体包括以下子步骤:

[0058]

s21、分别记录过去四个时刻下对接舱与无人艇的相对位置,作为智能体的部分可观测的状态信息,计算每个时刻下的三个观测点与无人艇的坐标之差:

[0059]

p

it

(x,y,z)=q

it

(x,y,z)-w

t

(x,y,z)

[0060]

式中:q

it

(x,y,z)为对接舱可观测点的坐标,其中i表示为对接舱的第i个可观测点,t表示其为第t时刻的坐标,w

t

(x,y,z)表示第t时刻的无人艇坐标,p

it

(x,y,z)表示t时刻对接舱的第i个可观测点与无人艇的坐标差值;

[0061]

s22、将步骤s21所得的相对位置信息进行展平处理,赋值到神经网络的节点中,作为智能体神经网络输入层的输入;

[0062]

s23、利用神经网络拟合优势函数以及最优状态价值函数,网络节点的输出可评价动作的好坏,根据动作的评价可选择当前状态下最优动作;

[0063]

dueling network算法为dqn(deeping q-learning)算法的一种改进,在dqn中,使用q(s,a;ω)价值网络来拟合最优动作价值函数q

*

(s,a),其中s表示为当前状态,a表示为输出动作,ω为神经网络的参数,神经网络的输出动作,即能使得q

*

(s,a)取最大值的动作,该过程可用如下公式表示:

[0064]a*

=argmaxaq(s,a;ω)

[0065]

式中:a

*

表示当前的最优动作,即为智能体最终选择的动作。

[0066]

dqn采用td(temporal difference learning)算法更新其价值网络,通过构建td target:y

t

来计算损失函数,从而实现神经网络的反向传播。根据价值网络的性质,可以构建如下公式:

[0067]

q(s

t

,a

t

;ω)≈r

t

γq(s

t 1

,a

t 1

;ω)

[0068]

式中:q(s

t

,a

t

;ω)表示该时刻对于未来奖励总和的期望,r

t

为实际获得的奖励,q(s

t 1

,a

t 1

;ω)为下一时刻对于未来奖励总和的期望,γ为折扣因子,其取值在0到1之间,表示未来的奖励的重要性低于当前的奖励,设置r

t

γq(s

t 1

,a

t 1

;ω)该项为td target,以此可构建损失函数l

t

为:

[0069][0070]

传统的dqn算法会出现高估问题,在dueling network算法中,对其网络结构进行了改进,使用两个神经网络a(s,a;ωa),v(s;ωv)分别拟合优势函数a

*

(s,a)以及最优状态价值函数v

*

(s),ωa为拟合优势函数的神经网络参数,ωv为拟合最优状态价值函数的神经网络参数,其中优势函数,最优状态价值函数以及最优动作价值函数三者的关系可由下述公式表示:

[0071]a*

(s,a)=q

*

(s,a)-v

*

(s)

[0072]

根据优势函数,最优状态价值函数以及最优动作价值函数三者的性质,经推导,可以建立神经网络之间的关系表达式,如下所示:

[0073]

q(s,a;ωa,ωv)=v(s;ωv) a(s,a;ωa)-maxaa(s,a;ωa)

[0074]

式中:max

a a(s,a;ωa)表示神经网络a(s,a;ωa)输出的最大值。最终,可通过a(s,a;ωa),v(s;ωv)两个神经网络的运算得到q(s,a;ωa,ωv),代替dqn算法中单一的价值网络q(s,a;ω),并可有效减少高估问题对模型的影响。

[0075]

s24、使用优先经验回放机制,建立经验池,存入的信息为每一次通信所保存的四个时刻的环境状态、执行动作、环境奖励以及状态转移后的新的环境状态,训练神经网络时根据每条经验的重要性的不同,赋予不同采样概率,依照其概率分布随机抽取经验;

[0076]

训练神经网络时,从经验池取出数据,但并不是每一条经验都同等重要。在本场景下,无人艇在较远位置处时,只需应对海浪干扰朝向目标位置行进即可,这种经验在本场景下更常见,其重要性相对较低;而当无人艇已经行驶到对接舱附近,要开始进行对接工作时,其既需面对海浪干扰,也需要避免与对接舱体产生多余的碰撞,相对而言难度更大,更难训练,应设以更高的权重值。

[0077]

优先经验回放机制通过判断td error的大小,来衡量每一条经验的重要性,td error可由下述公式表示:

[0078]

δ

t

=q(s

t

,a

t

;ωa,ωv)-r

t-γq(s

t 1

,a

t 1

;ωa,ωv)

[0079]

式中:δ

t

为td error,q(s

t

,a

t

;ωa,ωv)为当前时刻的神经网络的最终预测结果,r

t

为此时观测到的实际奖励,γ为折扣因子,q(s

t 1

,a

t 1

;ωa,ωv)表示下一时刻的神经网络的最终预测结果。

[0080]

每条经验的采样频率可由下式表示:

[0081]

p

t

=ζ

·

(|δ

t

| ρ)

[0082]

式中:p

t

为该条经验的采样概率,ζ为超参数,是一个正实数的,|δ

t

|为td error的大小,ρ为一个很小的常数,避免|δ

t

|为0时抽样概率为0。

[0083]

s3、建立强化学习控制器与仿真环境的分布式通信系统,将控制器置于服务器端,仿真环境置于服务端,具体包括以下子步骤:

[0084]

s31、将强化学习控制器置于服务器端,服务器端共包含两条线程,主线程接收来自于仿真环境四个时刻的环境信息,完成神经网络的前向传播,计算最终智能体所需执行动作的编号,并将该条经验存入经验池;线程2负责从经验池取出数据,完成神经网络的前向传播与反向传播,实现智能体的异步训练;

[0085]

s32、将仿真环境置于客户端,每四分之一个通信时间,采样一次环境状态信息,并将相关信息存入状态数组,通信时接收服务器端传来的动作指令,并将状态数组传至服务器端;

[0086]

具体的通信过程如下所示:

[0087]

首先,服务器端主线程阻塞,等待接收客户端通信数据;线程2持续从经验池中取出数据训练神经网络,每当神经网络训练一轮结束时,线程2向主线程发送消息,如果此时主线程未接收到客户端通信数据,线程2开启下一轮训练;如果主线程已接收到客户端通信数据,线程2挂起,主线程接收数据并送入神经网络完成前向传播,计算动作评分,选择最优动作,将对应的动作编号发送至客户端,并将本轮状态信息,执行动作以及所获奖励存入经验池后,线程2唤醒,主线程阻塞,等待接收客户端的下一轮通信数据;其次,客户端接收服务器端传过来的动作编号,令无人艇每一帧都反复执行该动作直至下一次通信为止,设定每次通信间隔为0.8秒,客户端每0.2秒记录并计算一次环境状态信息,存入状态数组,在通信时将状态数组打包为结构体,传至服务器端;

[0088]

s4、启动服务器与客户端,开启智能体的训练与控制,具体包括以下子步骤:

[0089]

s41、启动服务器端,等待客户端连接;

[0090]

s42、启动客户端,环境初始化,随机智能体生成位置;

[0091]

s43、客户端向服务器发送连接请求,建立连接;

[0092]

s44、开启ai控制,开启一轮任务的训练,服务器与客户端每隔0.8秒通信一次,交

互数据;

[0093]

s45、根据环境规则下的判定条件,判断训练是否结束,给予终局奖励或失败惩罚,开启下一轮训练并重复执行s41到s45,如果断开通信连接,执行s46;

[0094]

s46、保存训练好的神经网络模型,方便应用于下次训练。

[0095]

结合具体实施例,对考虑海浪干扰的无人艇回收分布式决策仿真系统做进一步说明:

[0096]

图1为系统整体框架图,为服务器与客户端、决策模块与环境模块通信交互的全过程。首先服务器端主线程阻塞,等待接收客户端通信数据;线程2持续从经验池中取出数据训练神经网络,每当神经网络训练一轮结束时,线程2向主线程发送信号2,如果此时主线程未接收到客户端发过来的信号1,线程2开启下一轮训练;如果主线程已接收到客户端通信数据,则线程2挂起,主线程接收数据并送入神经网络完成前向传播,计算动作评分,选择最优动作,将对应的动作编号发送至客户端,并将本轮状态信息,执行动作以及所获奖励存入经验池后,线程2唤醒,主线程阻塞,等待接收客户端的下一轮通信数据。客户端一侧在接收到服务器端传过来的动作编号后,令无人艇每一帧都反复执行该动作直至下一次通信为止,设定每次通信间隔为0.8秒,客户端每0.2秒记录并计算一次环境状态信息,存入状态数组,在通信时将状态数组打包为结构体,传至服务器端。

[0097]

图2为一维gerstner波的示意图,其波峰尖锐,相比于正弦波而言更适宜模拟海浪波的效果。在虚幻引擎中,想要模拟出海浪的效果,需要将多个不同方向,不同速度,不同幅值以及不同频率的gerstner波叠加在一起,最后实现出复杂的,动态的,可进行物理交互的海浪效果。

[0098]

图3为智能体训练流程图,展示了每一轮智能体与环境交互时的判断过程。智能体在任务开始时,其出生点会随机被设置在最终回收位置附近的一定范围之内。在任务进程中,会检测无人艇与对接舱体产生的碰撞的力的大小,并且会记录下来一轮中累计产生的力的大小,当无人艇能够以最合适的角度进入对接舱时,会产生最小的碰撞力,对船体本身的损伤最小;任务的胜利条件为,在不造成无人艇的大量损伤的情况下,成功进入到对接舱之内完成对接;任务的失败条件分为以下几种:分别是船体被打翻,船开出了地图边界之外以及超出了一轮所应有的训练时间。当达成失败或胜利条件时,将会重置环境相关信息,无人艇随机位置生成,进行新一轮的训练。智能体在每一次与环境交互过程中,都会对上述情况进行判断,以及选择不同的分支,得到不同的奖励值。

[0099]

图4为包含可观测点信息的对接舱三视图,对接舱上设置三个不共线的可观测点,作为环境中状态空间的一部分,使无人艇可观测到对接舱体的实时相对位姿,智能体得到对接舱的三个可观测点相对于无人艇自身的位置信息,便可通过其信息还原出整个对接舱的运动状态,最终则可以利用智能体的自主学习能力完成无人艇对接回收工作。

[0100]

图5为可观测多个时刻信息的dueling network算法的神经网络示意图,通信过程中,决策模块首先会获得状态矩阵s,将状态矩阵s展平为一维的特征向量,并将其传入神经网络的输入层,神经网络可同时观测到四个时刻的状态信息,构建两个神经网络a(s,a;ωa),v(s;ωv)分别拟合优势函数a

*

(s,a)以及最优状态价值函数v

*

(s),最后通过计算得出最优的动作的预测,将预测的动作编号传给环境模块中。

[0101]

图6为最终的训练界面效果图,展示的是客户端部分,六张子图展示了一轮训练的

全过程,无人艇随机初始化生成位置,决策模块通过神经网络的预测控制船体运动,并将采集的经验数据放入经验池,无人艇会朝向对接舱方向行进,以获取更大的奖励,当最终完成对接时,智能体获取终局奖励,结束本轮的训练过程,并开启下一轮的训练。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。