1.本发明属于计算机视觉技术领域,具体涉及一种基于水滴态感知视场融合的单车环视图像实时拼接方法。

背景技术:

2.随着技术的不断发展和人们对工作、生活需求的提高,汽车已经走进了千家万户,成为人们生活中的必备品。驾驶员们希望汽车感知影像系统更加全面、广阔、无死角地展现汽车周围的环境信息,从而辅助驾驶员实现更加精准安全的车辆控制。现在,最新一代的汽车环视技术已经能实现汽车周围环境的3davm显示,较为传统的倒车影像技术也能为驾驶员提高一定的帮助。然而这些技术都是针对小轿车等乘用车型提出的,虽然能较好地满足小轿车司机的感知需求,但当面临大型商用车车距大、车座高、车头车尾不固连等特点时,传统环视技术难以弥补大型车辆的周身盲区,给驾驶员的操作行为带来诸多不便。因此,针对大型车辆的汽车环视感知技术渐渐凸显其研究的迫切需求,尤其是解决其车头车身不固连的感知难题与大型车辆之间相互遮挡的感知难题。

3.汽车环视技术在汽车周围架设能覆盖车辆周边所有视场范围的4到8个广角摄像头,对同一时刻采集到的多路视频影像处理成一幅车辆周边360度的车身俯视图,最后在中控台的屏幕上显示,让驾驶员清楚查看车辆周边是否存在障碍物并了解障碍物的相对方位与距离,帮助驾驶员操作车辆。不仅非常直观,而且不存在任何盲点,可以协助驾驶员从容操控车辆泊车入位或通过复杂路面,有效减少刮蹭、碰撞、陷落等事故的发生。目前的汽车环视技术假设相机与汽车固连,将整个车辆作为刚体进行处理。整体的技术路线采用静态拼接方法,首先对固连的多路相机分别进行相机校正,获取每路相机去畸变的图像;其次分别计算每一路相机图像到投影平面的变换参数,并制作查表;然后将各路图像通过查表都投影在同一个投影平面上,并进行图像融合处理,形成统一的投影平面图像;最后通过虚拟视点等方法将投影平面转换到虚拟成像面上进行显示。目前,静态拼接方法由于相机架设简单、参数计算容易,成像实时性高等优点受到业内人士的追捧。然而在面临抖动、转动等参数变化情况时,静态拼接方法中的查表参数并不能随之变化,这使得目前汽车环视技术无法适应于卡车、挂车等会发生车体转动的大型非刚体特种车辆。

4.针对上述问题,研究者们对图像拼接的上游工作——特征点生成与匹配这一领域展开了大量研究。截止2020年,目前最新的特征生成与匹配方法已能达到15fps,初步满足图像预处理的实时性要求。卡车、挂车等会发生车体转动的汽车环视图像的动态拼接已经成为可能。

5.因此,水滴态感知视场融合的单车环视图像实时动态拼接方法为可转动的非刚体车辆提供汽车实时环视动态拼接图像,同时为车辆提供同一尺度下的三维感知视场融合模型,对特种车辆的感知显示具有重要意义,有极高的实用价值。

技术实现要素:

6.有鉴于此,本发明提供一种水滴态感知视场融合的单车环视图像实时动态拼接方法,根据特征点生成与匹配方法在汽车环视视觉系统设计、特征生成、特征匹配、图像拼接与去抖、参数表更新、投影平面融合等方面对汽车环视系统进行改进,使汽车环视系统参数表具备更新能力,环视能力覆盖卡车、挂车等会发生车体转动的大型非刚体特种车辆,为车辆提供同一尺度下的三维感知视场融合模型,使汽车环视技术能兼顾精度和效率,实现无盲区的实时动态图像拼接。

7.一种基于水滴态感知视场融合的单车环视图像实时动态拼接方法,包括以下步骤:

8.步骤s1、设置车辆环视视觉系统,并对车辆环视视觉系统参数进行标定;

9.步骤s2、令车辆环视视觉系统采用水滴态感知视场模型,其符合一般二次曲面约束,即:

[0010][0011]

式中,f(p)为与感知深度p有关的视场高度函数;p

vf

为在高度为0时的感知深度,pv为在高度为车辆高度hv时对应的车辆水平感知深度;

[0012]

建立相机的二维图像坐标系及三维的3d投影坐标系,将相机图像中的像素点一一投影到水滴态三维感知视场模型所在的3d投影坐标系中,则:

[0013]

当高度为0时,像素点在二维图像坐标系和3d投影坐标系中的对应关系如下:

[0014][0015]

其中,(x

′

,y

′

)表示像素点在二维图像坐标系中坐标,(x,y,z)表示像素在3d投影坐标系中对应的坐标;α,β均为常数,α为抬升系数,β为曲率系数,m表示图像宽度,即像素数;

[0016]

当高度不为0时,像素点在二维图像坐标系和3d投影坐标系中的对应关系如下:

[0017][0018]

其中,γ为分辨率调节系数;

[0019]

根据方程(1)和(2)求解出各个像素点映射至水滴态感知视场的坐标(x,y,z),以及相应的感知深度p;

[0020]

步骤s3、基于步骤s1标定的车辆环视视觉系统参数以及步骤s2得到的像素点在二维图像坐标系和3d投影坐标系中的对应关系,求解图像坐标系中二维像素点到3d模型所在的d投影坐标系中对应像素的相对运动,建立车辆环视视觉系统的初始参数表;

[0021]

步骤s4、同步获取车辆环视视觉系统中各个相机的视频数据,并行提取特征点,进行特征匹配,进而更新所述参数表;

[0022]

步骤s5、基于更新后的所述参数表,将车辆各个相机图像投影在水滴态感知模型上,进而对图像进行拼接。

[0023]

较佳的,所述步骤s4中,对各个相机的视频数据进行防抖处理,然后再更新所述参数表。

[0024]

较佳的,所述水滴态感知视场模型为碗状模型,碗壁为设定类型曲线绕中心轴旋转构成的曲面,碗底为碗壁所包围的圆形,碗底中心为车辆投影在水平面的长方形。

[0025]

较佳的,所述设定类型曲线为抛物线、圆弧或其他二次曲线。

[0026]

较佳的,采用superpoint架构进行特征点提取。

[0027]

较佳的,采用superglue架构实现特征匹配。

[0028]

较佳的,所述车辆环视视觉系统包括4个相机,分别置于车头车牌上部、左后车门骨架中部、车尾车牌上部与右后车门骨架中部。

[0029]

较佳的,所述车辆环视视觉系统的载体采用阿克曼运动模型车辆。

[0030]

较佳的,所述相机成像模型采用scaramuzza提出的泰勒展开式相机成像模型。

[0031]

较佳的,车辆环视视觉系统的重叠视场朝向载体两侧。

[0032]

本发明具有如下有益效果:

[0033]

本发明提出一种水滴态感知视场融合的单车环视图像实时动态拼接方法,该方法使用汽车环视视觉系统提供的全景图像信息,能够感知大范围环境信息,为卡车等可转动的非刚体特种车辆提供汽车实时环视动态拼接图像,并可为车辆提供同一尺度下的水滴态三维感知视场融合图像,实现无盲区、大范围的实时环境显示;

[0034]

通过基于superpoint架构的特征点提取算法与基于superglue架构的特征匹配算法可以有效改进特征匹配结果,剔除无法用于位姿估计的匹配点对,提升相机之间相对位置参数的精度和可靠性;

[0035]

通过在统一框架下将视频防抖与拼接相结合,可以获得稳定的动态全景拼接图像;结合构建的水滴模型与相关投影矩阵,可为车辆提供实时3d全景环视图像。

附图说明

[0036]

图1为本发明感知方法中的汽车环视视觉系统硬件结构示意图;

[0037]

图2为本发明感知方法的汽车环视视觉系统在载体上的安装方式示意图;

[0038]

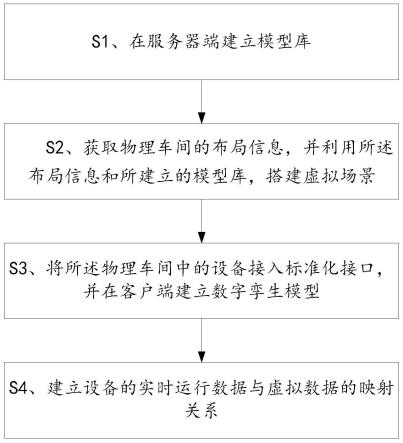

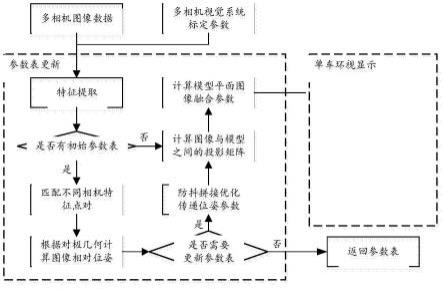

图3为本发明车辆实时图像拼接融合的算法流程图;

[0039]

图4为本发明单车水滴态感知视场模型图;

[0040]

图5为本发明单车水滴态环视感知模型图。

具体实施方式

[0041]

下面结合附图并举实施例,对本发明进行详细描述,本领域技术人员可以根据本说明书所阐述的内容了解本发明的优点及功能。本发明还可以通过另外不同的方式加以实施及应用。

[0042]

本发明涉及一种水滴态感知视场融合的单车环视图像实时动态拼接方法,包括汽

车环视视觉系统的硬件结构和软件算法。其中,汽车环视视觉系统的硬件结构由相同的若干相机组成,这些相机具有相同的图像采集性能,汽车环视视觉系统整体感知范围在水平方向上可以覆盖汽车环视视觉系统载体的周围区域,实现水平方向上没有盲区的环境信息感知,本实施例中,汽车环视视觉系统的硬件由4个带有硬件同步触发功能的相机组成,在水平方向上具有360

°

的视野范围。

[0043]

单车环视图像实时动态拼接方法的算法流程如下:

[0044]

步骤s1、根据汽车环视视觉系统中每个相机视场角大小、所需感知环境深度和载体运动约束按照一定标准确定相机的排布方式、相机的数量和相机间的基线长度,并根据相机类型选用适当的相机成像模型对汽车环视视觉系统参数进行标定,需要标定的参数包括相机成像模型内参和表示相机间位姿关系的初始外参;

[0045]

其中,所述汽车环视视觉系统的载体是阿克曼运动模型车辆,汽车环视视觉系统的重叠视场朝向纹理特征更加丰富的载体两侧,在载体运行时可以使更多的环境特征被不同的相机观测,有利于汽车环视视觉系统位姿估计时计算相机之间的关系。所述相机成像模型采用scaramuzza提出的泰勒展开式相机成像模型,该模型可以适用于畸变较大的大视场相机,其内参包含逆投影参数和投影参数,通过标定的逆投影参数可以解算图像像素点对应空间点在相机坐标系下的方向向量,即观测方向向量,通过标定的投影参数可以根据相机坐标系下空间点的三维坐标解算该点成像位置的像素坐标。

[0046]

步骤s2、建立单车车辆水滴视场模型并确定平面图像坐标到水滴视场模型的对应关系。水滴态感知视场模型为类碗状模型,碗壁可为抛物线、圆弧或其他二次曲线绕中心轴旋转构成的曲面,碗底为碗壁所包围的圆形,碗底中心为车辆投影在水平面的长方形。车辆采集的图像数据将根据360度经纬线分布投影在碗壁上,补充车辆周围360度环视视野。感知视场上部可不闭合。

[0047]

为满足车辆感知需求,感知视场底部应为曲率较小图像,近似为车辆俯视图,从而提供较为清晰的车辆周身环境图像;感知视场侧壁应为曲率较高图像,近似为车辆侧视图,从而提供车辆周边详细环境。假设车辆车长lv、车宽wv、车高hv,在车辆高度hv处,车辆水平感知深度pv,车辆底部水平感知深度p

vf

。则在车辆高度hv处,应为车辆侧视正视图像,即对应感知视场侧壁的中心。感知视场模型应符合一般二次曲面约束,即:

[0048][0049]

式中,f(p)为与感知深度p有关的视场高度函数;由式中可知,在高度为0即地面时,感知深度为p

vf

,在高度为车辆高度hv时,对应车辆水平感知深度为pv。

[0050]

以车体某侧一相机为例,其平面视场图像分辨率为m

×

n,选取图像左下角像素点作为坐标原点,以图像长为x轴,宽为y轴,建立二维笛卡尔坐标系,作为二维图像坐标系。二维图像坐标系中图像各点(x

′

,y

′

)与原图像坐标(u,v)的对应关系为:

[0051][0052]

其中,n为图像宽度的总像素数。

[0053]

其次,在三维空间中建立三维笛卡尔坐标系,作为3d投影坐标系,,该坐标系的xoy平面与地面重合,其中原点o位于车辆俯视图像的几何中心,x方向指向车头方向,z轴方向

铅直向上。根据初始确定的二次曲线约束,提出的水滴态三维感知视场模型在3d投影坐标系中可表示为:

[0054][0055]

α,β为常数,其中,α为抬升系数,决定视场模型的整体高度;β为曲率系数,决定投影模型侧壁的弯曲程度。以上参数可根据实际的使用场景进行动态调整。

[0056]

在二维图像坐标系与3d投影坐标系的基础上,根据各像素坐标间的映射关系将二维图像中的像素一一投影到水滴态三维感知视场模型中。假设相机视场为90

°

,其映射至3d投影坐标系中的第一卦限。当高度为0(地面)时,水滴态感知视场模型与地面的切线为一个半径为p

vf

的圆,其坐标对应关系如下:

[0057][0058]

当高度不为0时,其坐标对应关系满足:

[0059][0060]

其中,γ为分辨率调节系数,其作用为调整平面图像的纵向分辨率以适应水滴态感知视场模型的高度,使在车辆高度hv处,应为车辆侧视正视图像,即对应感知视场侧壁的中心。根据所示4个方程,可以求解出平面图像中的各个像素点映射至水滴态感知视场的坐标(x,y,z),以及相应的感知深度p。

[0061]

假设相机中心像素点对应视场侧壁正视点。若相机视场为w,则车辆所配置的相机数量应大于(其中,[

·

]表示向上取整)。在车辆静止情况下,计算各路相机图像与车辆水滴态感知视场的投影对应关系,即相机图像像素(m*n)与水滴态感知视场像素(2π*p

vf

*2hv*θ,其中θ为分辨率调节系数)对应投影映射。

[0062]

步骤s3、求解图像坐标系中二维像素点到3d模型所在的三维笛卡尔坐标系中对应像素的相对运动。在相机内参已知的前提下,即可转化为求解像素点所在相机坐标系相对3d模型所处坐标系的位姿,包括3d模型所处坐标系到相机坐标系的旋转矩阵r和平移向量t,其数学描述如下:

[0063][0064]

其中,p为点在图像坐标系下的二维坐标,pc为点在相机坐标系下坐标,k为相机内参矩阵,pw为点在3d模型所处世界坐标系下的坐标,ω为点的深度,即为所需求解的位姿。令pw=[xw,yw,zw]

t

,pc=[xc,yc,zc]

t

,p

′

=[xc/zc,yc/zc,1]

t

=[u1,v1,1]

t

,其中,p

′

代

表像素点在相机归一化坐标系下的表示。p=[u,v,1]代表像素点在像素坐标系下扩展为齐次坐标后的坐标表示,得完整的数学表达式:

[0065][0066]

在相机内参已知的前提下,首先将2d平面像素坐标转化为相机归一化坐标,其次根据对应的归一化约束条件获得关于姿态参数的方程,为求解对应旋转和平移矩阵中的12个未知参数,需要选取至少6组点对来求解方程,得到平面图像坐标与水滴模型对应点坐标之间的映射矩阵,结合表示相机间位姿关系的初始外参,建立初始参数表。

[0067]

步骤s4、通过硬件同步触发多个相机,使多个相机同步采集视频数据,并在多个线程中使用superpoint架构特征提取算法并行提取多幅图像的特征点,特征点信息包括关键点的位置和局部描述子。此后,基于二维特征点逆投影得到的观测方向向量夹角来筛选匹配结果,引入sampson误差检查匹配结果是否满足对极几何约束,剔除误差超过阈值的匹配点对以提高匹配准确度。所述sampson误差计算方法为:

[0068][0069]

其中,为二维特征点逆投影后在相机坐标系中的单位方向向量,e

12

为两图像间的本质矩阵。

[0070]

其中,所述superpoint架构特征点提取算法是一种使用神经网络方法生成特征点的提取算法。首先在仿真空间中构建点线面等虚拟特征并记录对应的特征点坐标,尽可能完整得构建虚拟数据集,然后对神经网络进行训练。通过神经网络生成数据点的方法使特征点在图像中更接近均匀分布,并通过降采样图像构建图像金字塔,在多幅图像中提取特征点,使特征点具有尺度不变性,在编程实现时通过多线程编程并行处理多个相机的图像特征提取过程,使特征提取能够高效完成。

[0071]

在同一关键帧下,使用superglue架构特征匹配算法对不同相机所获取的同一时刻图像进行处理,计算相机之间的相对位置关系,假设相机i外参矩阵为ti,相机j外参矩阵为tj,则相机i、j相对位姿为t

ij

。第n帧时相对位姿为第n 1帧时相对位姿为计算相机间的位姿变化函数,若:

[0072][0073]

则对n 1帧相机位姿进行更新,从而更新参数表。

[0074]

步骤s5、对于同一相机,使用superglue架构特征匹配算法对该相机所获取视频流中的相邻两帧图像进行处理,计算两帧图像之间的相对位置关系,从而对各相机采集到的视频流进行防抖处理。设相机i在第n-1帧的图像计算矩阵为ci(n-1),第n-1帧到第n帧之间对应的相对位置关系为fi(n),在第n帧的图像计算矩阵为ci(n)=fi(n)

·ci

(n-1)。通过最优化能量函数

[0075][0076]

得到相机i在第n-1帧到第n帧之间的防抖变换矩阵pi(n),其中r为第n帧前一定数量的图像,一般根据情况可设为30-50之间,ω

n,r

为常数,代表两项之间的权重。

[0077]

其中,所述superglue架构特征点匹配算法是一种用图神经网络方法进行特征点匹配的匹配算法。所述特征匹配过程中,匹配不同图像的二维特征点时将特征点按照遍历顺序构建成一个图,在每个特征点对应的图集合内进行匹配,提高特征匹配的效率和准确度。使用二维特征点逆投影得到的观测方向向量夹角筛选匹配结果,避免引入过大的误差并减少错误匹配,提高相机位姿构建的精度,并使用sampson误差检查匹配结果是否满足对极几何约束,剔除误差超过阈值的匹配点对,提高特征匹配的准确度。

[0078]

步骤s6、假设相机i与相机j在第n帧时相对位姿为可得相机i与相机j第n帧图像间的单应性矩阵从而完成对应同一时间的两相机间的图像拼接。通过优化以下能量函数:

[0079][0080]

得到最优化的pi,pj,参数,其中,pi,pj为前一步计算的防抖变换矩阵,β为常数,代表防抖项与拼接项之间的权重。通过优化后的pi,pj得到防抖校正后的模拟相机位姿,结合参数更新相机间相对位姿,更新优化后的参数表。

[0081]

步骤s7、在多个相机处理线程中分别调用参数表,将各路相机预处理后的图像投影到水滴态感知视场模型中。将感知视场面上的多幅图像重合处进行融合处理,消除重影现象与拼接缝。对整个水滴态感知视场进行全局亮度归一化与白平衡处理,输出车辆水滴态环视感知视场数据。

[0082]

其中,各路相机采集图像到水滴态感知视场模型的投影与虚拟视点采集水滴态感知视场到虚拟投影面的投影均可采取透视变换与逆透视变换方法。首先提取图像中的关键特征点,包括但不限于传统的棋盘格角点与车道线等显著特征,其次根据车辆前后对应关系将提取到的特征点均匀分布放置在投影平面上,然后根据图像特征点与投影平面特征点之间的对应关系计算图像平面与投影平面的单应性变换矩阵,最后将图像平面所有像素都通过单应性变换阵变换到投影平面上。

[0083]

实施例:

[0084]

本实施案例提供一种水滴态感知视场融合的多车环视图像实时动态拼接方法,该方法使用的硬件结构示意图如图1所示,该图显示4个相机组成的汽车环视视觉系统,分别置于车头车牌上部、左后车门骨架中部、车尾车牌上部与右后车门骨架中部,形成车辆前左后右四个视角;图2是汽车环视视觉系统在所述载体上的安装排布方式示意图,每个相机的水平视场角约为120

°

,根据本发明中对汽车环视视觉系统视野范围的要求,汽车环视视觉系统在水平方向上的视场范围完全覆盖载体周围区域,并且相机的排布方式使多相机视觉系统的4处重叠视场朝向载体两侧。

[0085]

如图3所示,所述的多车环视图像实时动态拼接方法包括以下步骤:

[0086]

步骤s1、汽车环视视觉系统图像采集。利用电路按照15hz的频率同步触发4个相

机,获取时间基准一致并包含时间戳信息的4个相机的图像数据,同时获取预先标定的泰勒展开式内参和位姿变换外参,并与对应的相机图像相关联。在本实施案例中,4个相机按照所述的设计方式排布,通过gmsl接口接收触发信号并返回图像信息,泰勒展开式内参包含仿射变换参数5个参数、逆投影泰勒展开式系数4个参数和投影泰勒展开式系数9个参数,位姿变换外参包含cayley旋转参数和平移向量参数共6个参数。

[0087]

步骤s2、汽车环视视觉系统参数表初始化。使用9*9棋盘格标定板作为特征标志物,棋盘格大小为10cm*10cm。调整棋盘格在车前相机的位置,使棋盘格占据图像中央区域大于整个图像区域的三分之一。在图像中任选棋盘格中心的四个角点,并记录四个角点分别对应的图像坐标。在水滴态感知视场的前方投影面上选取对应的四个位置点,使棋盘格在汽车环视中所占据视场角度与位置点在水滴态视场模型中所占据的视场角度相同。计算图像特征点坐标与水滴模型选取点坐标之间的单应性矩阵。依次计算4个相机对应单应性矩阵参数,存入参数表完成初始化。若已有初始化参数表,直接跳至步骤s3。

[0088]

步骤s3、汽车环视视觉系统参数表实时更新。本实施案例中,使用superpoint架构特征提取算法提取图像特征。神经网络数据集在虚拟仿真软件中生成。在数据集中分别构建正方体、长方体、球体等经典几何物体,将物体上的顶点、内点等特殊角点作为特征点,记录此特征点数据作为网络训练集。在提取角点后使用四叉树算法分割图像,均匀地在图像中提取1000个关键点,使特征点在图像中均匀分布,降采样所得图像金字塔内的多个图像进行特征提取,使特征点具有尺度不变性。通过所述特征提取算法获得的特征点信息包括关键点位置以及卷积网络所得描述子,通过多线程编程并行提取每个相机图像的特征点。

[0089]

superglue架构特征匹配算法用于相机图像间实时位姿估计。该过程首先使用图神经网络方法来匹配点对。在特征提取算法的基础上,首先构建特征点图。任意选取特征点集中的一个特征点,逆时针依次记录其周围的特征点从而形成图。图中包含中心点位置信息与周围点位置信息。将不同图像的图分别送入神经网络中,从而即可匹配特征点对。考虑初始化状态和实时更新状态,在初始化状态时仅匹配不同相机图像在重叠视场区域内的二维特征点,剔除观测方向向量夹角小于1.5

°

或大于60

°

的匹配点对,并使用0.01作为sampson误差阈值检查匹配点对是否满足对极几何约束,然后使用三角测量方法解算地图点位置,同时将汽车环视视觉系统相机位姿初始化;在实时更新状态中,首先通过不同相机的二维特征点进行匹配,根据初始化位姿方向,剔除所有夹角均小于15

°

或大于178.5

°

的匹配点对,然后使用非线性优化方法求解多相机视觉系统的当前相机,在本实施案例中,非线性优化基于levenberg-marquardt迭代优化算法实现。解算出相机位姿后即可更新参数表。

[0090]

步骤s4、环视系统各相机图像防抖预处理。在本实施例中,基于步骤s3中的特征点提取与匹配方法,对各相机采集的图像进行帧间相对位姿估计,获得每帧图像之间的相对位置关系,获得相对变换矩阵f。根据获得的所有相对变换矩阵,可计算出当前的图像计算矩阵c,第一帧图像的图像计算矩阵可设置为单位矩阵。在获得图像计算矩阵c的基础上,通过迭代方式,优化防抖项e,计算各相机每一帧的防抖变换矩阵p,从而去除各相机因自身抖动引起的位姿变化,同时优化平滑相邻两帧图像,减小图像抖动,优化视频观感。

[0091]

步骤s5、统一框架下的环视图像防抖与拼接。通过步骤s3获得的初始参数表,获取各相机间的位姿关系,从而计算出相机间图像对应的单应性矩阵h。取相邻两相机的防抖变换矩阵p与对应的单应性矩阵h,进行统一框架下的去抖与拼接优化,基于计算出的防抖变

换矩阵p,通过最小化能量函数,得到当前帧两相机图像之间的最优单应性矩阵相比于优化前的单应性矩阵h,优化后的一方面可缓解拼接完成后相邻图像的抖动程度,另一方面可以减少拼接图像的重影与扭曲现象。由优化后的单应性矩阵重新计算相机间的位姿,结合对应图像平面到水滴态感知视场的单应性矩阵,再次更新参数表。

[0092]

步骤s6、单车环视图像显示。在本实施案例中,在更新完参数表之后,即可将车辆4个相机图像通过逆透视变换方法投影在水滴态感知模型上。其中,水滴态感知视场模型如图4所示。在图像重叠区域,求解出重叠区域中心线。以中心线为距离中心,重叠区域对左图的加权系数从左起由1至0递减,重叠区域对右图的加权系数从右起由1至0递减。将左右图在重叠区域中加权融合,消除拼接缝。然后将图像强度进行归一化处理,防止局部过亮。从而实现单车环视图像显示。单车水滴态感知模型如图5所示。

[0093]

综上所述,以上仅为本发明的较佳实施例而已,并非用于限定本发明的保护范围,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。