1.本发明涉及交通控制技术领域,具体为基于多智能体约束策略优化的无信号交叉口协同控制方法。

背景技术:

2.自动驾驶技术的应用能够避免人为错误,增加交通安全性、方便残疾人出行并缓解交通拥堵情况,极大地提高未来交通系统的智能化水平。安全性、舒适性与高效性是自动驾驶的功能设计目标。然而,当前自动驾驶技术仍然未具备全场景下的安全驾驶能力,安全性问题急需解决,同时在舒适性与高效性方面仍需进一步改善。道路交叉口是城市地区的典型场景,比高速公路上的自动驾驶更加复杂,更具挑战性。在交叉路口,车辆从不同的交叉路口入口进入,在交叉路口区域交叉其特定的轨迹,并在不同的出口离开交叉路口。车辆之间复杂的冲突关系导致在交叉路口避免碰撞的车辆决策复杂,需要复杂的多智能体协同的自动驾驶设计来保证交通安全,提高交通效率与驾乘舒适性。

3.传统自动驾驶决策通常基于形式化或公式化的方法设计,在庞大的解空间中搜索与计算令表征安全、舒适与效率的目标函数值最大化的最优控制量,该方式计算效率欠缺,通常需秒级的求解时间,对控制单元计算性能要求较高,无法匹配自动驾驶应用对控制输出的毫秒级高实时性要求;在高动态变化且高复杂度的交通场景中,由于优化问题的复杂性与计算资源的短缺性,该类基于计算的形式化方法在复杂的交通场景中难以实际应用。为解决传统基于计算的方法在实时性方面的问题,近年来越来越多的研究将深度学习用于自动驾驶领域,但深度神经网络存在只能根据既有数据学习以及无法在与环境交互中更新网络的缺点,少量已知交通场景训练得到的网络无法在未知海量的真实交通环境中保持训练网络时预期的性能。

4.强化学习能够通过智能体与环境不断交互来提升当前策略,并通过奖励函数来引导策略的更新;深度强化学习将深度神经网络引入强化学习中,结合神经网络的学习能力与强化学习的决策能力,近几年逐渐被尝试应用于自动驾驶领域,具有广阔的应用前景。然而,当前深度强化学习方法,如ppo(proximal policy optimization)、ddpg(deep deterministic policy optimization)、a3c(asynchronous advantage actor-critic)等,均采用的单一奖励函数引导策略更新,无法保障策略满足特定约束,由于强化学习策略探索的随机性,在如交叉口等复杂场景探索新的策略时可能会发生碰撞风险,导致其应用于自动驾驶领域时无法始终满足安全基线,仍然难以被汽车行业广泛采用。例如,已有基于ppo算法的无信号道路交叉口协同控制,利用单一奖励函数来综合表征道路交叉口的效率与安全,导致策略在通行效率与安全性方面博弈,收敛后的神经网络模型性能仍然有10%的交叉口车辆碰撞概率,无法在真实交通场景中实际应用。安全性是自动驾驶的基线,而非与其他性能折衷权衡一个子方面,需设计全新的深度强化学习方法,能够在保障满足设定约束,如安全约束的前提下,以奖励函数最大化为目标更新策略。

5.综上,安全性、舒适性与高效性是自动驾驶功能设计追求的目标。当前自动驾驶技

术仍然未具备全场景下的安全驾驶能力,安全性问题急需解决,同时在舒适性与高效性方面仍需进一步改善。道路交叉口是城市地区的典型场景,比高速公路上的自动驾驶更加复杂,更具挑战性。为解决自动驾驶领域传统基于计算的方法由于计算效率低所导致的实时性违背问题,以及基于传统强化学习算法由于未考虑安全约束所导致的安全性违背问题,我们提出一种新型的基于多智能体约束策略优化的无信号交叉口协同控制方法。

技术实现要素:

6.本部分的目的在于概述本发明的实施方式的一些方面以及简要介绍一些较佳实施方式。在本部分以及本技术的说明书摘要和发明名称中可能会做些简化或省略以避免使本部分、说明书摘要和发明名称的目的模糊,而这种简化或省略不能用于限制本发明的范围。

7.鉴于现有技术中存在的问题,提出了本发明。

8.因此,本发明的目的是提供基于多智能体约束策略优化的无信号交叉口协同控制方法,在实现了交叉口零碰撞的同时,确保通行的高效率与舒适性。

9.为解决上述技术问题,根据本发明的一个方面,本发明提供了如下技术方案:

10.基于多智能体约束策略优化的无信号交叉口协同控制方法,其包括如下两个部分:

11.第一部分:多智能体约束策略优化(macpo)算法,actor-critic框架的基础上,引入了额外的基于损失函数的critic神经网络,用于保障策略更新时安全约束能够得到满足。macpo算法主要包括以下两个子步骤:

12.步骤1:智能体轨迹采样,在多智能体环境中每个智能体都将独立与环境进行交互,并实时观测当前环境,假设第i个智能体观测到的局部空间为si,macpo算法收集到的当前策略πk下多智能体环境提供的状态空间为s=[s1,s2,...,sn]。策略神经网络将状态空间映射为n维动作空间a=[a1,a2,...,an],并将该动作空间后依次分配给环境中的多智能体。多智能体根据获得的动作与环境进行交互,获得新的状态空间,奖励函数与开销函数,以此形成算法与环境交互的闭环,当策略更新次数达到一定程度时中止训练。

[0013]

步骤2:策略评估优化,分别使用基于奖励函数与基于损失函数的价值函数来评估当前策略,并利用策略梯度算法更新神经网络。macpo算法将综合利用搜集到的轨迹来分别更新策略神经网络与基于奖励函数和开销函数的价值神经网络。在更新策略神经网络时本发明在信任域理论的基础上提出安全等级的概念,当基于奖励函数的策略更新违背基于开销函数的安全约束时,使策略更新朝着不违背安全约束且使奖励函数值最大的方向进行。

[0014]

第二部分:基于多智能体约束策略优化的无信号交叉口协同控制方法,将所提出的macpo算法应用于道路交叉口协同控制,集中调控交叉口范围内的所有车辆,实现通行的安全性、高效性与舒适性。基于多智能体约束策略优化的无信号交叉口协同控制方法主要包括以下两个子部分:

[0015]

步骤1:状态空间与行为空间建模,本发明定义多智能体环境中共有8台车,每台车均有自己独立的局部观测空间,包括离开道路交叉口的距离di与当前的车速vi。定义全局状态空间为s=[d1,d2,...,d8,v1,v2,...,v8]。多智能体环境的行为空间由每个单独智能体的

局部动作组成,本发明将车辆的预期车速作为策略神经网络的输出,因此定义行为空间为a=[v

′1,v

′2....,v

′8]。

[0016]

步骤2:奖励函数与开销函数设计,本发明的奖励函数与多智能体的车速、加速度以及是否有安全事故发生相联系,用奖励函数来引导策略向使多智能体环境安全、高效与舒适的方向更新;开销函数与智能体间的距离与环境中是否有碰撞发生相联系,macpo算法利用开销函数来判断当前策略的安全等级,并引导策略向不违背安全约束的方向更新。

[0017]

作为本发明所述的基于多智能体约束策略优化的无信号交叉口协同控制方法的一种优选方案,其中:所述第一部分的具体流程为在策略梯度与actor-critic框架基础上,通过引入另一个表征安全性约束的基于开销的神经网络建立信任域,确保策略在满足安全约束的前提下更新,首先,初始化三个神经网络的参数,包括策略神经网络、基于奖励函数的神经网络与基于开销函数的神经网络;其次,采集环境中与多智能体相关的信息,并根据策略神经网络产生的动作与环境进行交互,采样智能体轨迹,即状态和行为动作序列;进而,经由基于奖励函数与基于开销函数的价值神经网络评估策略,并通过策略梯度与信任域约束共同更新策略网络与两个价值神经网络参数,上述步骤循环至到达设定的迭代次数上限,macpo作为第二部分道路交叉口协同控制的基础算法。

[0018]

作为本发明所述的基于多智能体约束策略优化的无信号交叉口协同控制方法的一种优选方案,其中:所述第二部分中,将所提出的macpo算法应用于道路交叉口协同控制,集中调控交叉口范围内的所有车辆,其中状态空间定义为车辆到交叉口出口的距离与车速信息,动作空间定义为车速控制信息,开销函数考虑道路车辆间的安全距离,奖励函数考虑全局的舒适、效率与安全性能。

[0019]

与现有技术相比,本发明的有益效果是:

[0020]

(1)提出的多智能体约束策略优化(macpo)算法,通过采用单独的开销神经网络约束多智能体的危险行为,保证在探索最优解的时候,最优解始终在安全范围内,解决了现有强化学习方法由于安全性不足难以在自动驾驶等安全关键型领域广泛应用的问题;

[0021]

(2)所提出的基于macpo的无信号道路交叉口协同控制方法,通过采用单独的基于开销函数的神经网络,设置出了科学合理的奖励函数与开销函数,状态与动作空间,确保了道路交叉口车辆通行的安全、舒适与效率,首次实现强化学习在道路交叉口的零碰撞率;

[0022]

(3)通过基于从状态向智能体动作的映射的强化学习算法大大减少了计算时间,确保应用于智能体控制时能够实时获得最优解。

[0023]

(4)提出的多智能体约束策略优化强化学习算法macpo在策略梯度的基础上引入了表征安全性约束的信任域,确保策略在满足安全约束的前提下更新,解决了现有强化学习方法由于安全性不足难以在自动驾驶等安全关键型领域广泛应用的难题,并将其应用于无交通信号灯交叉路口的车辆协同控制,实现交叉口通行的安全性、高效性与舒适性。本发明在仿真环境中验证了本发明提出的macpo算法进行道路交叉口协同控制的性能,与传统基于计算的模型预测控制方法相比,计算效率提升了70.76倍;与非安全约束的强化学习算法相比,首次实现了交通场景的零碰撞率,并具备更好的车辆舒适性与路口通行效率。

附图说明

[0024]

为了更清楚地说明本发明实施方式的技术方案,下面将结合附图和详细实施方式

对本发明进行详细说明,显而易见地,下面描述中的附图仅仅是本发明的一些实施方式,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其它的附图。其中:

[0025]

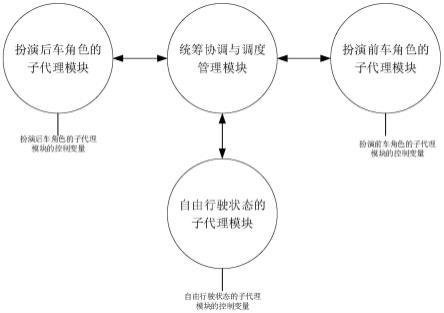

图1为本发明基于多智能体约束策略优化的无信号交叉口协同控制方法架构图;

[0026]

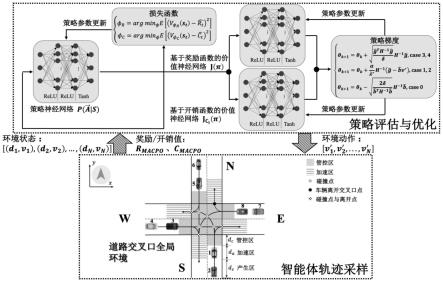

图2为本发明macpo算法流程图;

[0027]

图3为本发明无信号道路交叉口场景示意图;

[0028]

图4为本发明无左转车辆离开交叉口距离计算示意图;

[0029]

图5为本发明直行车辆离开交叉口距离计算示意图;

[0030]

图6为本发明右转车辆离开交叉口距离计算图;

[0031]

图7为本发明macpo与mappo-sc、mappo算法性能对比图。

具体实施方式

[0032]

为使本发明的上述目的、特征和优点能够更加明显易懂,下面结合附图对本发明的具体实施方式做详细的说明。

[0033]

在下面的描述中阐述了很多具体细节以便于充分理解本发明,但是本发明还可以采用其他不同于在此描述的其它方式来实施,本领域技术人员可以在不违背本发明内涵的情况下做类似推广,因此本发明不受下面公开的具体实施方式的限制。

[0034]

其次,本发明结合示意图进行详细描述,在详述本发明实施方式时,为便于说明,表示器件结构的剖面图会不依一般比例作局部放大,而且所述示意图只是示例,其在此不应限制本发明保护的范围。此外,在实际制作中应包含长度、宽度及深度的三维空间尺寸。

[0035]

为使本发明的目的、技术方案和优点更加清楚,下面将结合附图对本发明的实施方式作进一步地详细描述。

[0036]

本发明提供如下技术方案:基于多智能体约束策略优化的无信号交叉口协同控制方法,在实现了交叉口零碰撞的同时,确保通行的高效率与舒适性;

[0037]

实施例1

[0038]

该方法主要包括如下两个部分:

[0039]

第一部分:多智能体约束策略优化(macpo)算法,在策略梯度与actor-critic框架基础上,通过引入另一个表征安全性约束的基于开销的神经网络建立信任域,确保策略在满足安全约束的前提下更新,如图2所示,首先,初始化三个神经网络的参数,包括策略神经网络、基于奖励函数的神经网络与基于开销函数的神经网络;其次,采集环境中与多智能体相关的信息,并根据策略神经网络产生的动作与环境进行交互,采样智能体轨迹,即状态和行为动作序列;进而,经由基于奖励函数与基于开销函数的价值神经网络评估策略,并通过策略梯度与信任域约束共同更新策略网络与两个价值神经网络参数,上述步骤循环至到达设定的迭代次数上限,macpo作为第二部分道路交叉口协同控制的基础算法。

[0040]

第二部分:基于多智能体约束策略优化的无信号交叉口协同控制方法,将所提出的macpo算法应用于道路交叉口协同控制,集中调控交叉口范围内的所有车辆,其中状态空间定义为车辆到交叉口出口的距离与车速信息,动作空间定义为车速控制信息,开销函数考虑道路车辆间的安全距离,奖励函数考虑全局的舒适、效率与安全性能,从而实现交叉口通行的零碰撞率,并具备高车辆舒适性与路口通行效率。

[0041]

1.多智能体约束策略优化(macpo)算法

[0042]

该部分主要包括两个子步骤:智能体轨迹采样与策略评估优化,其中智能体轨迹采样主要进行智能体与环境互动的过程中状态行为序列的搜集,用于采样所有设定回合的轨迹,以进行下个子步骤的策略评估优化,策略评估优化根据采样得到的轨迹,利用基于奖励函数与基于开销函数的价值神经网络评估当前策略,并通过策略梯度与信任域约束共同更新策略网络与两个价值神经网络参数,以优化策略实现在满足信任域的前提下产生令奖励函数最大化的最优动作序列。

[0043]

(1)智能体轨迹采样

[0044]

该子步骤进行智能体状态行为序列的搜集,策略神经网络接收由环境传来的状态s=[d1,d2,...,dn,v1,v2,...,vn]作为神经网络的输入,并一次性输出交通环境中所有智能体的动作a=[v

′1,v

′2,...,v

′n]。在多智能体环境中,若当前环境中智能体数目为n,在每个时间步长,每个智能体均采取独立的动作,将多智能体环境中所有智能体在时间t的行为整合为将当前环境中所有智能体在时间t的局部观测空间定义为并结合全局环境信息整合为全局观测空间智能体i在时间t时采取动作后观测到的新状态为结合全局信息后得到新的状态空间用公式可描述为s

t

×at

→st 1

。智能体同时还将获得全局环境奖励r

t

,全局环境开销c

t

,用公式可描述为s

t

×at

×st 1

→rt

,c

t

。若轨迹的长度为t,macpo算法利用的轨迹为

[0045]

(2)策略评估与优化

[0046]

该子步骤根据上一步骤搜集到的多智能体状态行为轨迹,进行策略的评估与优化,分别使用基于奖励与开销的价值函数来评估当前策略的表现,开销价值函数用于评估当前策略对于多智能体安全约束的满足程度,奖励价值函数用于当前评估策略对于多智能体累积期望奖励的达成程度,并通过策略梯度与信任域约束共同更新策略网络与两个价值神经网络参数。

[0047]

a)策略神经网络评估与优化过程

[0048]

本发明使用形式化的参数θk来表征当前策略策略πk,更新后的策略π

k 1

的策略参数为θ

k 1

若策略的更新量为δθ,定义策略更新为:

[0049]

θ

k 1

=θk δθ

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0050]

下面论述如何寻找策略的更新量δθ。

[0051]

并非每次策略更新都会违背安全约束,本发明使用信任域方法更新未违背安全约束的策略。对于违背安全约束的策略更新,需要通过解对偶问题来求得不违背安全约束且使奖励函数期望最大的策略。对于在策略更新量超出信任域时仍不能满足安全约束的情况通过自然梯度来更新策略。

[0052]

首先,计算基于奖励价值函数的神经网络梯度和与基于开销价值函数的神经网络梯度

[0053][0054][0055]

其中n

traj

为轨迹数量,n

timestep

为总时间步长,是基于奖励函数的优势函数,为基于开销函数的优势函数。

[0056]

进一步,利用基于奖励函数与开销函数的价值函数神经网络梯度来更新策略神经网络,其中根据梯度计算当前策略安全等级判断因子和b:

[0057][0058][0059]

其中γ为折扣因子,h为基于约束的黑塞矩阵。

[0060]

若极小表示安全梯度极小,策略违背预先设置的约束条件的情况几乎不存在,无需划分安全区域与危险区域,可以忽略损失策略的更新,将此种情况标记为安全等级4。

[0061]

若b<0且表示策略不可解(基于kl散度的信任域与设定的安全边界无交点),且基于全局的策略更新没有违背安全约束,将此种情况标记为安全等级3。

[0062]

若b>0且表示策略可解(基于kl散度的信任域与设定的安全边界存在交点),当前策略在安全边界内,但策略更新后将超出设定的安全边界,若不限制当前策略更新将会发生危险,将此种情况标记为安全等级2。

[0063]

若b>0且表示策略可解(基于kl散度的信任域与设定的安全边界存在交点),当前策略在安全边界外,且更新后的策略仍在安全边界外,若不限制当前策略更新将会发生危险,将此种情况标记为安全等级1。

[0064]

若b<0且表示策略可解(基于kl散度的信任域与设定的安全边界无交点),且基于全局的策略更新违背安全约束,则在信任域的约束下策略无论如何更新都不能扭转当前策略的危险情况,将此种情况标记为安全等级0。

[0065]

当检测到情况3-4时,基于约束限制的问题近似于传统策略更新问题,无需通过安全约束引导,更新策略为:

[0066][0067]

当检测到情况1-2时,凸优化问题可解(feasible),策略更新规则为:

[0068][0069]

其中

[0070][0071][0072][0073]

在求得v

*

与λ

*

之后使用共轭梯度算法来计算策略更新时的方向xk:

[0074][0075]

在这之后便可以通过下式来更新当前策略:

[0076][0077]

其中α由回溯线性搜索求得。

[0078]

当检测到情况0时,凸优化问题不可解,利用自然梯度来修正当前策略,更新策略为:

[0079][0080]

b)基于奖励的价值神经网络与基于开销的价值神经网络评估优化

[0081]

基于奖励的价值神经网络参数更新规则如下:

[0082][0083]

基于开销的价值神经网络参数更新规则如下:

[0084][0085]

2.基于多智能体约束策略优化的无信号交叉口协同控制方法

[0086]

为了能够将提出的强化学习算法macpo应用到无信号道路交叉口的协同控制中,如图3所示,需将考虑安全约束的道路交叉口协同控制问题转化为约束马尔可夫决策过程框架,定义问题的状态空间、动作空间、奖励函数与损失函数。

[0087]

(1)状态空间与行为空间建模

[0088]

为了降低模型的复杂度,本文将表征智能体位置的笛卡尔坐标(x,y)用车辆离开交叉口的距离代替,并通过交通场景中的车速来更全面地表征车辆信息。在v2i通信的架构下,路侧单元rsu将会实时搜集信号覆盖范围内的n台车辆发送的距离和速度信息,并将n台车辆发送的信息与全局环境信息结合起来作为macpo算法的状态空间。故本发明的状态空间为:

[0089]

s=[d1,d2,

…

,dn,v1,v2,

…

,vn]

[0090]

为了得到更精确的环境信息,本文对不同转向车辆离开交叉口的距离分别进行计算。

[0091]

a)左转

[0092]

当车辆还未进入交叉口时,车辆离开交叉口的距离为:

[0093][0094]

若车辆已经进入交叉口,车辆离开交叉口的距离为:

[0095][0096]

b)直行

[0097]

当车辆还未进入交叉口时,车辆离开交叉口的距离为:

[0098][0099]

若车辆已经进入交叉口,车辆离开交叉口的距离为:

[0100][0101]

c)右转

[0102]

当车辆还未进入交叉口时,车辆离开交叉口的距离为:

[0103][0104]

若车辆已经进入交叉口,车辆离开交叉口的距离为:

[0105][0106]

在获取交通场景中的所有车辆离开交叉口的距离与车速后,将其与rsu存储的全局环境信息结合后作为策略神经网络的输入,神经网络输出环境中所有车辆的车速以控制全局车辆,形成闭环。

[0107]

本发明定义神经网络的输出为为预期车速,在实际交通场景中,多智能体将根据各自获得的预期车速来调整节气门开度或直接采取刹车措施。因此定义macpo算法的动作空间为a=[v

′1,v

′2,

…

,v

′n]。

[0108]

(2)奖励函数与开销函数设计

[0109]

开销函数强调提高交通场景的安全性并降低潜在的碰撞风险。为此,本发明设计碰撞安全阈值cs参数,当有碰撞可能性的两车间距小于cs时损失函数值加1,当发生碰撞后损失函数值加50。定义密集损失函数为:

[0110][0111]

定义稀疏损失函数为:

[0112]cs

=εcδ

collision

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(22)

[0113]

总损失函数c

macpo

为密集损失函数与稀疏损失函数之和:

[0114]

[0115]

其中当有碰撞可能性的两车间距小于cs时否则当碰撞发生时δ

collision

=1,否则δ

collision

=0。

[0116]

本发明在设计奖励函数时综合考虑交通环境中的安全、效率与驾驶人员的舒适性。macpo算法的奖励函数r

macpo

包括密集奖励函数与稀疏奖励函数。密集奖励函数设置为:

[0117][0118]

稀疏奖励函数定义为:

[0119][0120]

总奖励函数r

macpo

设置为:

[0121][0122]

其中εc、εv、εa、均为可设置的权重超参数。

[0123]

仿真验证

[0124]

仿真平台为carla 0.9.12版本,基于pytorch框架搭建了强化学习模型,gpu为nvidia geforce rtx 3090。本专利将道路交叉口分为车辆产生区、车辆加速区、与强化学习实际控制区。所有车辆都在车辆产生区内产生,并均有随机的初始位置与速度。为了更好的模拟真实交通场景,车辆速度区间为0~10m/s,在产生区车辆距离进入交叉口的最远距离为35m,最近距离为20m,在加速区车辆距离进入交叉口的最远距离为20m,最近距离为15m。当任一车辆进入强化学习管控区,使用本文提出的macpo算法控制交通场景中的所有车辆。控制周期(时间步长)被设置为0.1s,车辆的数目为n=8,每一个路口两台车。策略与价值神经网络结构分别为16

×

128

×

128

×

8与16

×

128

×

128

×

1,通过添加高斯分布的方差σ=-1.5e-6

t来产生实际车辆速度v=n(μ,σ)的随机性。每一次策略迭代均搜集2048个样本数量,通过adam优化器来优化策略、奖励与开销函数。学习率从1e-3开始线性衰减到0。训练算法迭代更新1024次后停止。

[0125]

本专利对比了公开的macpo算法相对于传统基于计算的mpc方法、奖励函数未考虑安全性的经典强化学习方法mappo、奖励函数考虑安全性的mappo-sc的优势,表1为各个方法的参数设置。本发明对比了各方法在道路交叉口通行的安全性、舒适性与效率,其中安全性通过碰撞概率与安全距离违背次数衡量,舒适性通过车辆加速度衡量,效率通过路口通行用时衡量。同时,对比了本发明公开的方法与传统基于计算的mpc方法在计算效率方面的性能。

[0126]

表1.试验参数设置

[0127]

[0128][0129]

表2.macpo对比mpc的性能优势

[0130] macpompc平均回合长度10.4s32.9s平均回合加速度0.024330.0641安全距离违反次数00平均计算时间0.010950.77483

[0131]

表2给出了100次仿真测试的统计结果,结果显示本发明公开的方法在计算效率、交叉口通行效率、车辆加速度等方面均优于mpc方法,其中mpc计算结果平均时长为本公开方法的70.76倍,8台车成功通行所用的时长为本发明公开方法的3.16倍,平均加速度为本发明的2.63倍,安全距离违背次数均为0。

[0132]

图7为本发明公开的方法macpo与mappo-sc、mappo算法的训练曲线,实线代表训练曲线的平均值,阴影部分代表方差。图7(a)-图7(e)为macpo与mappo-sc、mappo在回合平均奖励、安全开销、碰撞概率、通行用时、加速度方面的对比结果。在奖励获得方面,macpo算法的最高奖励值高于mappo-sc、mappo算法,产生这一差距的原因是macpo算法构建了单独的安全开销神经网络,能够保持0开销函数和碰撞惩罚。在安全开销方面,macpo算法通过策略迭代将开销函数值约束在本文预设的值附近,从而实现了理想的开销函数,使得交通场景中的潜在碰撞风险明显小于mappo-sc与mappo算法。在碰撞概率方面,macpo算法收敛后,由于其有开销函数来约束交通场景中的潜在碰撞风险,实现了零碰撞率,并从第150次更新开始一直保持到了策略更新结束。由于收敛后mappo-sc的开销函数相对于mappo算法较小,因此我们可以观察到策略收敛后mappo整体上的碰撞率高于mappo-sc算法。还可以观察到即使是带有安全约束的mappo-sc算法在整个训练过程中也不能实现0碰撞率,这进一步说明了传统mappo算法在应用到高动态变化、高安全性要求的无人驾驶环境中的局限性。在路口通行用时方面,未考虑安全约束的mappo算法有着最高的通行效率,有安全约束的mappo-sc算法的通行效率较mappo算法较低,而将安全作为最优先级的macpo算法有着最低的通行效率。这是因为为了降低交通场景中的潜在碰撞风险,在macpo算法控制下的车辆必须严格控制自车距离周围车辆的距离,限制车辆采取冒险激进的通行策略,尽管这样可能会增大通行效率。还可以观察到macpo算法的通行效率相对于mappo-sc以及mappo算法差距并不悬

殊,通过牺牲约一至三秒的通行时间,macpo算法实现了安全的交通通行场景。作为影响驾驶舒适性的关键因素,瞬时的剧烈加速或减速均会在很大程度上降低驾驶员的驾驶体验,为了提升驾驶舒适性,本发明提出的macpo算法也考虑了车辆的加速度值。实验仿真结果表明macpo算法控制下车辆的平均加速度与取绝对值后的加速度平均值均为最小,具备最高的舒适性。

[0133]

实施效果显示,本发明公开多智能体约束策略优化强化学习算法macpo进行道路交叉口协同控制的性能,与传统基于计算的模型预测控制方法相比,计算效率提升了70.76倍;与非安全约束的强化学习算法相比,首次实现了交通场景的零碰撞率,并具备更好的车辆舒适性与路口通行效率。

[0134]

虽然在上文中已经参考实施方式对本发明进行了描述,然而在不脱离本发明的范围的情况下,可以对其进行各种改进并且可以用等效物替换其中的部件。尤其是,只要不存在结构冲突,本发明所披露的实施方式中的各项特征均可通过任意方式相互结合起来使用,在本说明书中未对这些组合的情况进行穷举性的描述仅仅是出于省略篇幅和节约资源的考虑。因此,本发明并不局限于文中公开的特定实施方式,而是包括落入权利要求的范围内的所有技术方案。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。