1.本发明涉及一种增强现实设备。具体而言,本发明涉及一种能够进行音频识别的增强现实设备及其控制方法。

背景技术:

2.增强现实(augmented reality;ar)是一种将三维虚拟图像叠加在真实图像或背景上作为单个图像显示的技术。即,增强现实被定义为通过在通过透明玻璃向用户提供真实图像的状态下向玻璃输出对应于虚拟对象的图像信息来扩展用户的感官和认识的技术。

3.最近,内装有相机和全球定位系统(global positioning system,gps)等各种传感器的移动终端和智能手机的普及正在扩散,使用高速移动互联网的各种融合服务被引入,从而使用移动设备的增强现实服务正在迅速扩散。

4.另一方面,深度学习等人工智能技术也被应用于处理音频信息。作为与音频相关的处理技术之一的音频识别技术的开发目的在于检测音频输入由哪个主体产生以及在相关主体的什么情况下产生。

5.随着人工智能的发展,音频识别的准确性不断提高,而随着设备计算能力的提高,音频识别所需的时间减少,因此用户可以对输入的音频信息实时进行音频识别。

6.因此,正在进行通过将音频识别技术与增强现实设备融合来扩展用户的感觉区域的各种研究。

技术实现要素:

7.技术问题

8.本发明的目的在于提供能够通过使用音频识别技术向用户直观地通知在附近发生的事件的增强现实设备及其控制方法。

9.并且,本发明的目的在于提供能够识别在附近产生的音频信息,使得用户可以识别在可视区域之外产生的音频的增强现实设备及其控制方法。

10.并且,本发明的目的在于提供实时检测在附近产生的声音的标签(label)和源点,并据此输出虚拟对象的增强现实设备及其控制方法。

11.并且,本发明的目的在于提供通过使音频信息和图像信息联动来提供虚拟对象以扩展用户的认知区域的一种增强现实设备及其控制方法。

12.此外,本发明的目的在于提供一种基于在附近产生的音频信息的属性进行操作的增强现实设备。

13.解决问题的方案

14.根据本发明的增强现实设备的特征在于包括:透视(see-through)显示单元,形成为使得用户的眼睛能够看穿,输出虚拟对象的图像信息;音频输入单元,接收在距显示单元预设距离内产生的音频信号的输入;以及控制单元,用于识别对应于音频信号的事件信息,并控制上述透视显示单元的操作以输出对应于识别的事件信息的虚拟对象的图像信息。

15.此外,根据本发明的增强现实设备的另一实施例,图像信息包括与音频信号相关的文本、图像及位置信息中的至少一种,控制单元检测产生音频信号的地点的位置,并控制透视显示单元的操作,使得上述图像信息包括与检测的位置相关的信息。

16.发明的效果

17.根据本发明,具有如下优点,即,通过将在用户看不见的区域中产生的声音转换为视觉信息并输出,从而用户可以准确地识别在周围产生的声音。

18.此外,根据本发明,失去听力的用户也可以具有与通过他/她的眼睛看到与在附近产生的各种声音有关的信息相同的效果。

19.另外,根据本发明,通过将在附近产生的音频信号与增强现实产生的虚拟对象相组合,可以得到最大化用户感觉区域的效果。

附图说明

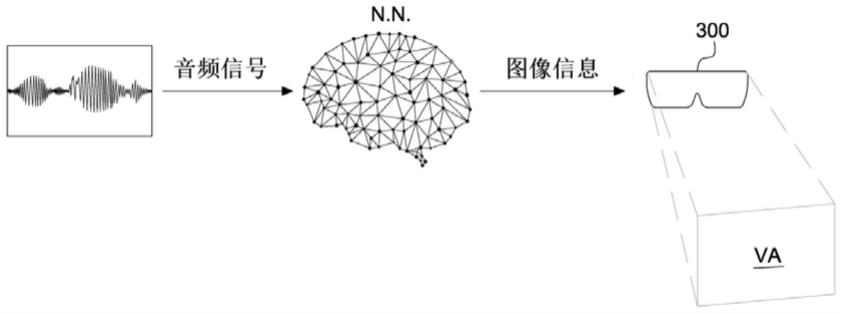

20.图1为示出包括增强现实设备的系统的概念图。

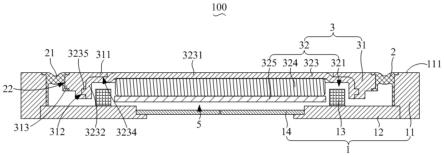

21.图2为增强现实设备的透视图。

22.图3为示出增强现实设备的组件的框图。

23.图4为示出根据本发明的增强现实设备的控制方法的流程图。

24.图5至图8为示出根据本发明的增强现实设备的实施例的图。

具体实施方式

25.用于实施发明的最佳方式

26.增强现实设备的特征在于包括:透视显示单元,形成为使得用户的眼睛能够看穿,输出虚拟对象;音频输入单元,接收在距显示单元预设距离内产生的音频信号的输入;以及控制单元,用于识别对应于音频信号的事件信息,并控制上述透视显示单元的操作以输出对应于识别的事件信息的虚拟对象的图像信息。

27.用于实施发明的方式

28.在下文中,将参照附图对本说明书所公开的实施例进行详细描述,但本说明书中所使用的技术术语仅用于描述具体实施例,并非意在限制本说明书所公开的技术思想。

29.如上所述,增强现实设备的用户想要获得关于增强现实设备上的交互元素的功能的信息。因此,本文描述的实施例涉及通过透视显示设备提供如上所述的信息。例如,如下文详细描述的,透视显示设备被配置为提供关于增强现实设备的双向元素的功能的信息作为显示在增强现实设备的用户视野上的增强现实图像。

30.图1为示出包括增强现实设备的系统的概念图。参照图1说明本发明的一实施例,通过输入单元100接收音频信号输入,控制单元200识别对应于接收输入的音频信号的事件信息,并且可以控制透视显示单元300输出对应于识别的事件信息的虚拟对象的图像信息。具体而言,可以接收音频信号输入,且将相关音频信号通过人工神经网络检测、识别并与图像信息匹配,然后通过显示单元300可视地发送给用户。其中,如下面稍后将描述的,显示单元300可以以智能眼镜的形式被提供。智能眼镜是基于现有技术的,可以包括:框架部,支撑眼镜形状;固定部,将智能眼镜固定在用户;以及镜头部,安装在框架上,使用户可以透过可视区域看到的同时确认增强现实图像信息。智能眼镜还可以包括相机和各种传感器,并且

还可以包括能够检测音频信号的麦克风。根据一实施例,增强现实设备可以被配置为以用户直观的方式使音频信号和图像信息进行相互作用的增强现实显示器。其中,增强现实显示器是上述显示单元300,并且可以是ar眼镜或头戴式显示器中的一种。其中,透镜部可以由如玻璃或塑料的透明或透视材料形成,使得当用户佩戴显示单元300时用户可以清楚地观察实际场景。此外,还可以通过镜头部投影数字ar图像信息等内容。因此,用户可以在佩戴显示单元300的状态下同时观察现实世界的场景和投影的数字图像信息。

31.图2为增强现实设备的透视图,示出包括增强现实设备的物理空间的示例性实施例。用户可以通过增强现实设备中的透视显示单元300看到可视区域va,可以通过图2确认该实施例。所描述的透视显示单元300可以以护目镜、眼镜等的形式被提供,使得用户的双手自由。透视显示单元300包括:ar输出单元310,被配置为对于用户实现物理空间外观的视觉信息增强;以及信息显示单元320,用于引导音频信号的方向和位置。通过ar输出单元310使从物理空间发出的光通过透视显示单元300,使得用户可以直接看到真实物理空间,同时看到与真实物理空间重叠的一个或多个虚拟对象。根据一实施例,当用户的视线通过ar输出单元310直接指向可视区域va时,透视显示单元300以关于增强现实设备的一个或多个功能的信息的形式显示一个或多个虚拟对象。其中,显示的信息是以适当的方式获得的。例如,可以从计算装置通过网络、从远程计算装置或从增强现实设备等接收显示的信息。

32.根据本发明的透视显示单元300可以以如图2所示的护目镜的形式实现,但其实现方法不受限制,而可以以任何其他合适的形式来实现。参照图2对一实施例进行简约说明,用户可以通过透视显示单元300实时视觉上确认可视区域va,当在可视区域va内产生音频信号时,通过检测产生音频信号的地点的位置,可以在信息显示单元320中的相关位置的方向上显示位置信息,并且将虚拟对象的图像信息10以重叠的方式投影到产生音频信号的位置。详细而言,可以通过将音频信号的信息,即,音频信号的类型和声音视觉地投影,使得即使不能听觉上确认的用户也可以视觉上确认音频信号。

33.在下文中,将参照图3详细描述本发明的增强现实设备。图3为示出增强现实设备的组件的框图。

34.参照图3,根据一实施例,本发明的增强现实设备可以包括:透视显示单元300,形成为使得用户的眼睛能够看穿,输出虚拟对象的图像信息10;音频输入单元100,接收在距显示单元300预设距离内产生的音频信号的输入;及控制单元200,用于识别对应于音频信号的事件信息,并控制透视显示单元300的操作以输出对应于识别的事件信息的虚拟对象的图像信息10。

35.详细而言,输入单元100是接收音频信号和图像信号并将其发送到控制单元200的构成,且可以包括麦克风110、相机120及发送单元130。麦克风110是接收在距显示单元300预定距离内产生的音频信号的输入的构成,当在用户佩戴显示单元300时在预定距离内产生音频信号时,可以通过麦克风110输入相关音频信号,通过发送单元130发送到控制单元200。此时,输入单元100安装在透视显示单元300的一部分上,并且还包括用于拍摄一个方向的相机120,从而可以通过相机120拍摄用户佩戴的显示单元300的正面方向的画面。详细而言,通过显示单元300看到的用户的可视区域va可以被相机120拍摄,可以通过发送单元130向控制单元200同时发送图像信号。

36.控制单元200包括基于从输入单元100输入并发送的音频信号和图像信号检测信

息、识别并匹配所提供的事件信息的检测单元210、识别单元220及匹配单元230。检测单元210通过检测从输入单元100发送的音频信号的类型和产生相关音频信号的地点的位置来控制透视显示单元300的操作以包括与图像信息10有关的信息。详细而言,音频信号和图像信号可以从输入单元100被发送到控制单元200,其中,检测单元210可以检测音频信号的类型或状况等,并从图像信号中检测到与音频信号对应的图像信号。根据一实施例,如图2所示,婴儿哭声(baby cry)通过输入单元100的麦克风110被输入为音频信号,并且哭泣的婴儿通过相机120被输入为图像信号并发送到控制单元200时,在检测单元210通过两个或更多的音频传感器检测到产生发送的音频信号的地点的距离、音频信号的大小等,从而可以检测产生相关音频信号的地点的位置。也就是说,当婴儿的哭声作为音频信号被输入时,可以确认产生相关哭声的方向和位置,并通过检测单元210进行检测。同时,通过根据输入的图像信号检测产生哭声的方向和位置的图像信号,可以更详细地进行分析。通过检测单元210检测到的音频信号的方向、位置及图像信号可以通过识别单元220进行具体识别。具体而言,识别单元220通过预先安装的人工神经网络识别音频信号的类型或状况,并从图像信号中识别并提取与相关音频信号的类型或状况相对应的图像信息10。具体而言,根据图2,通过分析音频信号的波长、波形、频率等,从而能够通过人工神经网络将相关音频信号识别为婴儿的哭声。此外,在识别音频信号的同时,可以识别与识别出的音频信息对应的图像信号。也就是说,当音频信号被识别为婴儿的哭声时,可以从输入的图像信号中找到婴儿并识别。此后,当分别识别音频信号和图像信号时,将这两个信息进行匹配,控制透视显示单元的操作,使得在透视显示单元300的屏幕中产生上述音频信号的位置的图像信号与虚拟对象的图像信息10重叠。即,当婴儿的哭声被输入为音频信号且在图像信号中也发现婴儿时,可以对婴儿和婴儿的哭声进行匹配,控制使得在婴儿周围通过增强现实重叠婴儿哭声信息。其中,重叠的图像信息10可以包括与识别的音频信号相关的文本、图像和位置信息中的至少一种。文本可以由字母表示,并且可以将如人、物体或动物等产生音频信号的主体显示为图像。此外,可以将产生音频信号的地点的位置信息提供为文本、图像或方向、地点表示等。关于由控制单元200识别并匹配的音频信号的图像信息10可以通过显示单元300被输出。详细而言,显示单元300包括ar输出单元310和信息显示单元320。ar输出单元310是在佩戴显示单元300的用户的可视区域中通过增强现实将图像信息10重叠输出的构成,信息显示单元320可被配置为沿着显示单元300的圆周方向表示产生音频信号的地点的位置或方向信息。

37.在下文中,将参照图4详细描述根据本发明的增强现实设备的控制方法。图4为示出根据本发明的增强现实设备的控制方法的流程图。

38.参照图4说明的话,在用户佩戴透视显示单元300之后,用户可以贯穿ar输出单元310确认可视区域va。此时,当在距显示单元300预定距离内产生音频信号时,可以通过输入单元100接收相关音频信号输入。当输入音频信号时,识别对应于相关音频信号的事件信息,通过ar输出单元310和信息显示单元320在可视区域va中输出对应于识别的事件信息的虚拟对象的图像信息10。但是,在识别出事件信息后,首先判断音频信号产生位置是否在可视区域内,若在可视区域内,则可以投影图像信息10,若在可视区域外,则可以输出位置信息,使得用户将相关音频信号产生位置移动到可视区域内。详细而言,基于用户佩戴的透视显示单元300的一部分指向的方向,通过控制单元200检测输入音频信号的方向,并可以控

制透视显示单元300的操作,使得图像信息10包括与检测的方向相关的信息。其中,作为图像信息10包括的与检测的方向相关的信息,可以通过信息显示单元320表示音频信号检测方向和位置,并可以在音频信号检测地点通过增强现实重叠图像信息10。具体而言,当产生音频信号的地点的位置在用户通过透视显示单元300可见的可视区域之外时,控制单元200可以控制透视显示单元300的操作,以输出与位置相关的图像信息10。此外,当产生音频信号的地点的位置在可视区域内时,可以控制透视显示单元300的操作,使得在透视显示单元的屏幕中投影产生音频信号的位置的一部分上重叠虚拟对象的图像信息10。

39.在下文中,将参照图5至图8通过实施例进行更详细说明。图5至图8为示出根据本发明的增强现实设备的实施例的图。

40.首先,参照图5,当音频信号产生在用户通过透视显示单元300可见的可视区域va之外,即,在图5中通过ar输出单元310用户不可见的左侧侧门产生敲门声时,与产生相关音频信号的地点的位置有关的图像信息10可以通过ar输出单元310被输出。详细而言,参照图5,当在用户的可视区域va内没有产生敲门声时,表示产生音频信号的地点的位置或方向,以便将用户的可视区域va切换到产生音频信号的位置。即,当从左侧侧门产生声音时,可以表示作为一种声音的敲门声(knock),并且通过使用方向表示和箭头等来输出与位置相关的图像信息10。更详细而言,还可以一起标记生成音频信号的对象来输出。同时,通过在沿显示单元300的外围设置的多个信息显示单元320上表示相关方向的信息,可以向用户立即通知在相关方向上产生音频信号。此时,信息显示单元320可以通过led通知或振动通知等向用户引导方向信息。

41.图6是用户在图5的可视区域va中确认与方向或位置相关的图像信息10之后,通过将用户的头向左转动来使生成音频信号的地点的位置进入可视区域va中的画面。如图6所示,在图5的画面中产生音频信号的位置不包括在可视区域va中时,向用户引导位置和方向,从而用户可以向产生音频信号的位置转换可视区域va。因此,如图6所示,当产生音频信号的地点的位置在可视区域内时,可以控制透视显示单元300的操作,使得在透视显示单元300的屏幕中投影产生音频信号的位置的ar输出单元310的一部分上重叠虚拟对象的图像信息10。也就是说,门发出敲门声,用户向门方向转换可视区域va,从而门属于可视区域va中时,可以通过与图像或文本等重叠来标记音频信号的类型和声音,以便引导在产生音频信号的门发生敲门声。此时,可以根据音频信号的类型和对象等而不同地显示重叠的图像信息10。具体而言,可以根据如事物、人、动物等的对象来表示图标,或通过话气泡的形状和颜色的差异等,用户可以直观地确认声音对象。详细而言,将通过比较图6至图8来进行说明。

42.图6为从门发出敲门声的音频信号,如图6所示,可以在要生成音频信号的事物中表示指示线的圆角矩形框中用文字标记声音的种类和声音。此外,图7涉及人进行对话的音频信号,当进行对话的人进入可视区域va内时,可以重叠并表示关于音频信号的图像信息10,此时,人的对话可以通过对话泡以与相关人匹配的方式重叠。因此,用户可以在不听的状态下与人沟通。图8涉及动物声音被输入为音频信号的情况的实施例,在狗叫声被输入为音频信号的情况下,在相关狗的周围匹配弯曲的指示线,该指示线作为图像信息10被提供,此时,在图像信息10中表示代表狗的图标,从而可以直观地确认由狗产生的音频信号。

43.根据如上所述的实施例,在本发明中,在接收到音频信号输入之后,通过与显示单

元300的图像信号匹配来将相关类型的音频信号与图像信息10匹配,从而可以向用户视觉上提供音频信号信息。此时,识别音频信号、从图像信号中提取与相关音频信号的类型相对应的图像信号、并将音频信号和图像信号匹配来以图像信息10表示的过程可以由预先安装在控制单元200的人工神经网络实现,随着用户对本发明的增强现实设备的重复使用,人工神经网络可以进行训练,从而提供更准确和扩展的信息。

44.在本说明书中,透视显示单元300已被描述为智能眼镜类型的实施例,但这只是实施例之一,而可以通过如移动电话、笔记本电脑及可穿戴设备等的图像处理装置和音频分析装置等来实现。

45.上述本发明涉及一个实施例,其仅仅是一个实施例,本领域的技术人员可以据此做出各种修改和等同的其他实施例。因此,本发明的范围不受上述实施例和附图的限制。

46.产业上可利用性

47.根据本发明,具有如下优点,即,通过将在用户看不见的区域中产生的声音转换为视觉信息并输出,从而用户可以准确地识别在周围产生的声音。

48.此外,根据本发明,失去听力的用户也可以具有与通过他/她的眼睛看到与在附近产生的各种声音有关的信息相同的效果。

49.另外,根据本发明,通过将在附近产生的音频信号与增强现实产生的虚拟对象相组合,可以得到最大化用户感觉区域的效果。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。