1.本技术属于图像处理技术领域,具体涉及一种基于深度监督和逐步学习的肠道息肉检测方法。

背景技术:

2.医学图像检测是人工智能辅助诊断的重要组成部分,它可以为医生提供一些细节信息,辅助医生进行诊断。对于常见的癌症结肠癌来说,早期发现并切除息肉是预防癌症发作的有效手段。在肠镜捕获图像中检测息肉对于预防结肠癌有重要意义。最近,自然图像的图像检测取得了很大的进展,相比之下,医学图像中的检测问题仍面临着巨大的挑战。由于医学图像的数据集一般比较小,检测目标的形状又具有很大区别,所以很难将自然图像的检测方法的直接迁移应用到医学图像检测中去。因此,如何准确捕捉图像特征,提高模型的泛化能力,对医学图像检测的进一步探索至关重要。

3.最近,基于卷积神经网络(cnn)的医学图像检测方法在许多数据集中取得了良好的表现。其中最具代表性的方法是u-net,它通过跳跃连接很好地捕获了上下文信息。但是由于cnn模型的自顶向下建模方法以及息肉形态的多变性,这些模型缺乏对全局信息的捕获能力和泛化能力,很多时候会识别不出一些不明显的息肉。xie等人在2021年提出了segformer,将transformer应用到图像检测领域,并提出了一种多阶段特征聚合多分支解码器,通过简单的上采样然后并行融合分别预测不同尺度和深度的特征。ange等人提出的caranet利用反向注意力提取小物体的细节信息,然后通过transformer对全局关系进行建模。caranet对于小物体的检测非常精准,在医学图像检测任务中创造了新的记录。这些基于transformer的方法对检测的主体把握的很好,但是对于低级纹理信息的处理还有所欠缺,导致检测结果的边界并不精准。

技术实现要素:

4.本发明要克服现有技术的缺点,提供基于深度监督和逐步学习的肠道息肉检测方法。通过transformer中的变体pvt来提取特征,用卷积层来捕获多尺度的细节信息,通过深度监督的方式逐层进行学习,逐步融合各层特征以获得精确的检测结果。

5.为实现上述目的,本发明所采取的技术方案为:

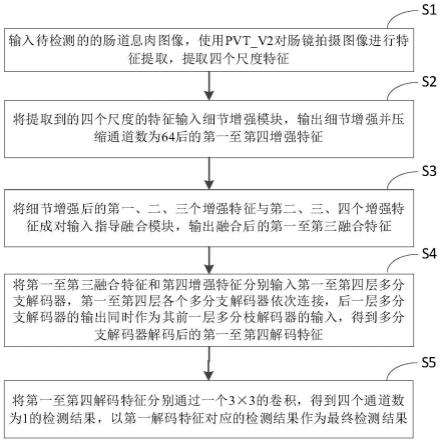

6.一种基于深度监督和逐步学习的肠道息肉检测方法,包括:

7.输入待检测的352

×

352

×

3的肠道息肉图像,使用pvt_v2对肠镜拍摄图像进行特征提取,提取四个尺度特征,四个尺度分别为88

×

88

×

64、44

×

44

×

128、22

×

22

×

320和11

×

11

×

512;

8.将提取到的四个尺度的特征输入细节增强模块,输出细节增强并压缩通道数为64后的第一至第四增强特征;

9.将细节增强后的第一、二、三个增强特征与第二、三、四个增强特征成对输入指导融合模块,输出融合后的第一至第三融合特征;

10.将第一至第三融合特征和第四增强特征分别输入第一至第四层多分支解码器,第一至第四层各个多分支解码器依次连接,后一层多分支解码器的输出同时作为其前一层多分枝解码器的输入,得到多分支解码器解码后的第一至第四解码特征;

11.将第一至第四解码特征分别通过一个3

×

3的卷积,得到四个通道数为1的检测结果,以第一解码特征对应的检测结果作为最终检测结果。

12.进一步的,所述细节增强模块,执行如下操作:

13.s21、将提取得到的任一尺度特征通过一层1

×

1卷积,使其压缩到64个通道并保持原有空间尺度,去除检测任务中冗余的通道信息,输出尺度为hi×

wi×

64,hi、wi分别为特征的高度和宽度;

14.s22、将s21的结果分别通过1

×

1,3

×

3,5

×

5,7

×

7的4个卷积核,得到捕获了不同尺度信息的四个特征尺度均为hi×

wi×

64;

15.s23、将s22的结果在通道维度上进行拼接,得到尺度为hi×

wi×

256的融合特征

16.s24、将获得的特征通过两层3

×

3卷积,融合捕获了不同尺度信息的特征,生成增强特征其尺度为hi×

wi×

64。

17.进一步的,所述指导融合模块,执行如下操作:

18.s31、对于提取到的四个增强特征将其以的对应关系输入指导融合模块;

19.s32、将用双线性插值的方式进行上采样,得到与的空间维度相同的特征

20.s33、将上采样后的特征通过空间注意处理,得到注意力权重smap

i 1

表示,计算公式如下:

[0021][0022]

其中,sa(

·

)为空间注意力;

[0023]

s34、令特征和smap

i 1

进行元素乘法,突出显著区域的特征,计算公式如下:

[0024][0025]

其中,为元素乘法;

[0026]

s35、将与进行残差连接,使之保留低层特征的信息,提高训练稳定性,计算公式如下:

[0027][0028]

s36、将与在通道维度上拼接融合,得到尺度为hi×

wi×

128的结果

[0029]

s37、将获得的特征通过一层3

×

3卷积,融合捕获不同尺度信息的特征,输出融合特征其尺度为hi×

wi×

64。

[0030]

进一步的,所述第四层多分支解码器,执行如下操作:

[0031]

s411、将第四增强特征输入一个1

×

1卷积,进一步学习不同通道上的信息得到尺度为11

×

11

×

64结果;

[0032]

s412、将s41的结果分别通过1

×

1,3

×

3,5

×

5的4个卷积核,得到捕获了不同尺度信息的3个特征三个特征的尺度均为hi×

wi×

64;

[0033]

s413、将s42的三个结果在通道维度上进行拼接,得到尺度为hi×

wi×

192的融合特征

[0034]

s414、将获得的特征通过两层3

×

3卷积,融合捕获了不同尺度信息的特征,生成解码特征其尺度为hi×

wi×

64;

[0035]

所述第一至第三层多分支解码器,解码过程如下:

[0036]

s421、将融合特征和前一个多分支解码器输出的解码特征在通道维度上进行拼接,得到尺度为hi×

wi×

64的融合特征

[0037]

s422、将输入一个1

×

1卷积,融合该层特征和上层特征的结果得到尺度为hi×

wi×

64的结果

[0038]

s423、将分别通过1

×

1,3

×

3,5

×

5的3个卷积核,得到捕获了不同尺度信息的3个特征三个特征的尺度均为hi×

wi×

64;

[0039]

s424、将特征在通道维度上进行拼接,得到尺度为hi×

wi×

192的融合特征

[0040]

s425、将获得的特征通过两层3

×

3卷积,融合捕获了不同尺度信息的特征,生成解码特征其尺度为hi×

wi×

64。

[0041]

本技术提供的基于深度监督和逐步学习的肠道息肉检测方法,利用利用深度监督对pvt_v2提取的特征进行逐层学习。通过细节增强捕获细节信息并去除冗余的通道信息,利用指导融合模块逐步融合高语义信息和低语义信息,让高层学习结果指导低层的学习。并通过多分支解码器进行检测,得到更准确的肠道息肉检测结果。

附图说明

[0042]

图1为本技术基于深度监督和逐步学习的肠道息肉检测方法的流程图;

[0043]

图2为本技术网络模型整体架构图;

[0044]

图3为本技术实施例细节增强模块结构示意图;

[0045]

图4为本技术指导融合模块结构示意图;

[0046]

图5为本技术多分支解码器模块结构示意图;

[0047]

图6为本技术空间注意sa模块结构示意图。

具体实施方式

[0048]

为了使本技术的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本技术进行进一步详细说明。应当理解,此处描述的具体实施例仅用以解释本技术,并不用于限定本技术。

[0049]

在一个实施例中,提供了一种基于深度监督和逐步学习的肠道息肉检测方法,充分利用了transformer的全局依赖捕获能力和cnn的细节捕获能力,实现肠道息肉图像的准确检测。

[0050]

具体的,如图1所示,本实施例中基于深度监督和逐步学习的肠道息肉检测方法,包括:

[0051]

步骤s1、输入待检测的352

×

352

×

3的肠道息肉图像,使用pvt_v2对肠镜拍摄图像进行特征提取,提取四个尺度特征,四个尺度分别为88

×

88

×

64、44

×

44

×

128、22

×

22

×

320和11

×

11

×

512。

[0052]

首先,获取待检测肠道息肉图像,然后缩放为352

×

352

×

3,作为后续处理的输入图像。

[0053]

本实例中,为了更好利用transformer的自注意力机制更好的捕获图像中的全局依赖关系,使用pvt_v2骨干网络对图像进行特征提取。利用pvt_v2对输入的353

×

352

×

3肠道息肉图像进行特征提取,旨在提取不同尺度的特征,高层次的网络的感受野比较大,语义信息表征能力强,能够准确的定位目标位置;低层次的网络的感受野比较小,几何细节信息表征能力强,有助于补全边界细节信息。

[0054]

经过pvt_v2进行特征提取后,得到的四个尺度的特征分别为88

×

88

×

64、44

×

44

×

128、22

×

22

×

320和11

×

11

×

512,在图2中对应pvt1、pvt2、pvt3和pvt4的输出。

[0055]

步骤s2、将提取到的四个尺度的特征输入细节增强模块,输出细节增强并压缩通道数为64后的第一至第四增强特征。

[0056]

本实例中,如图2所示,对于四个不同尺度的特征输出先通道压缩以去除通道冗余信息并提高模型计算速度,然后分别通过四个大小不一的卷积核提取不同尺度的细节特征,再将这些不同尺度的特征在通道维度上连接起来,通过两层3

×

3的卷积核融合各尺度的信息并降低通道数。

[0057]

肠镜拍摄图像通过pvt_v2的特征提取得到四个尺度的特征其尺度分别为88

×

88

×

64,44

×

44

×

128,22

×

22

×

320,11

×

11

×

512,将其分别输入细节增强模块。本实施例中细节增强模块如图3所示,过程如下:

[0058]

s21、将提取得到的任一特征f

io

通过一层1

×

1卷积,使其压缩到64个通道并保持原有空间尺度,去除检测任务中冗余的通道信息,输出尺度为hi×

wi×

64,hi、hi分别为特征f

io

的高度和宽度。

[0059]

s22、将s21的结果分别通过1

×

1,3

×

3,5

×

5,7

×

7的4个卷积核,得到捕获了不同尺度信息的四个特征尺度均为hi×

wi×

64。

[0060]

s23、将s22的结果在通道维度上进行拼接,得到尺度为hi×

wi×

256的融合特征

[0061]

s24、将获得的特征通过两层3

×

3卷积,融合捕获了不同尺度信息的特征,生成增强特征其尺度为hi×

wi×

64。

[0062]

步骤s3、将细节增强后的第一、二、三个增强特征与第二、三、四个增强特征成对输入指导融合模块,输出融合后的第一至第三融合特征。

[0063]

本实例中,如图4所示,对于输入特征和由上采样后通过sa模块生成空间注意力图smap

i 1

,用空间注意力图与低层特征进行元素乘法,得到凸显显著区域的并于作跳跃连接。将结果与拼接后用3

×

3的卷积层融合,得到输出

[0064]

本实施例中指导融合模块过程如下:

[0065]

s31、对于提取到的四个增强特征将其以的对应关系输入指导融合模块。

[0066]

s32、将用双线性插值的方式进行上采样,得到与的空间维度相同的特征

[0067]

s33、将上采样后的特征通过空间注意处理,得到注意力权重,用smap

i 1

表示,计算公式如下:

[0068][0069]

其中,sa(

·

)为空间注意力,sa模块结构如图6所示。

[0070]

s34、令特征和smap

i 1

进行元素乘法,突出显著区域的特征,计算公式如下:

[0071][0072]

其中,为元素乘法。

[0073]

s35、将与进行残差连接,使之保留低层特征的信息,提高训练稳定性,计算公式如下:

[0074][0075]

s36、将与在通道维度上拼接融合,得到尺度为hi×

wi×

128的结果

[0076]

s37、将获得的特征通过一层3

×

3卷积,融合捕获不同尺度信息的特征,输出融合特征其尺度为hi×

wi×

64。

[0077]

步骤s4、将第一至第三融合特征和第四增强特征分别输入第一至第四层多分支解码器,第一至第四层各个多分支解码器依次连接,后一层多分支解码器的输出同时作为其前一层多分枝解码器的输入,得到多分支解码器解码后的第一至第四解码特征。

[0078]

本实例中,分别将第一至第三融合特征和第四增强特征输入到各自对应的多分支解码器,第四增强特征输入到第四层多分支解码器,第一至第三融合特征依次输入到第一至第三层多分支解码器。

[0079]

如图5所示,多分支解码器对于输入特征,先通过1

×

1卷积,进一步学习不同通道上的信息为,再通过三个不同的卷积分支提取不同尺度的信息,再次拼接融合得到最后的结果

[0080]

本实施例,将第四增强特征输入第四层多分支解码器,其尺度为11

×

11

×

64,解码过程如下:

[0081]

s411、将第四增强特征输入一个1

×

1卷积,进一步学习不同通道上的信息得到尺度为11

×

11

×

64结果。

[0082]

s412、将s41的结果分别通过1

×

1,3

×

3,5

×

5的4个卷积核,得到捕获了不同尺度信息的3个特征三个特征的尺度均为hi×

wi×

64。

[0083]

s413、将s42的三个结果在通道维度上进行拼接,得到尺度为hi×

wi×

192的融合特征

[0084]

s414、将获得的特征通过两层3

×

3卷积,融合捕获了不同尺度信息的特征,生成解码特征其尺度为hi×

wi×

64。

[0085]

本实施例中,对于第一至第三层多分支解码器,输入特征为融合特征和上一个多分支解码器输出的解码特征先拼接通道后融合为再通过三个不同的卷积分支提取不同尺度的信息,再次拼接融合得到最后的结果

[0086]

本实施例中,第一至第三层多分支解码器,解码过程如下:

[0087]

s421、将融合特征和前一个多分支解码器输出的解码特征在通道维度上进行拼接,得到尺度为hi×

wi×

64的融合特征

[0088]

本实施例将前一个多分支解码器的输出用双线性插值的方式进行上采样,得到与的空间维度相同的特征然后将和在通道维度上进行拼接,得到尺度为hi×

wi×

64的融合特征

[0089]

s422、将输入一个1

×

1卷积,融合该层特征和上层特征的结果得到尺度为hi×

wi×

64的结果

[0090]

s423、将分别通过1

×

1,3

×

3,5

×

5的3个卷积核,得到捕获了不同尺度信息的3个特征三个特征的尺度均为hi×

wi×

64。

[0091]

s424、将特征在通道维度上进行拼接,得到尺度为hi×

wi×

192的融合特征

[0092]

s425、将获得的特征通过两层3

×

3卷积,融合捕获了不同尺度信息的特征,生成解码特征其尺度为hi×

wi×

64。

[0093]

步骤s5、将第一至第四解码特征分别通过一个3

×

3的卷积,得到四个通道数为1的检测结果,以第一解码特征对应的检测结果作为最终检测结果。

[0094]

本步骤将解码后的特征分别通过一个3

×

3的卷积,得到四个通道数为1的检测结果。

[0095]

在训练时,还将检测结果用插值法上采样的原图大小,计算损失函数并执行反向传播,来完成整个网络模型的训练。在训练好网络模型之后,采用训练好的网络模型,对输入的肠道息肉图像进行检测,输出检测结果。

[0096]

本实例中利用bce损失和iou损失来计算最终的显著目标检测结果与真实标签之间的损失。

[0097]

本实例中利用二进制交叉熵(bce)计算真实标签和检测结果之间的差距。bce是分类中一种广泛使用的损失,计算的公式如下:

[0098][0099]

iou损失主要用于测量两幅图像在整体上的相似性,计算公式如下:

[0100][0101]

其中,g(x,y)∈[0,1]是检测图片的真实标签,p(x,y)∈[0,1]是模型对检测图片的检测结果。

[0102]

在使用训练好的模型时,只使用第一层的多分支解码器的输出结果,将其用3

×

3卷积把通道数降为1,得到每一个像素是息肉目标的概率值。将概率值大于等于0.5的标注为是息肉目标的白色像素,将概率值小于等于0.5的像素标注为不是息肉目标的黑色像素,得到最终的检测结果,即以白色像素标注息肉目标的黑白图像。

[0103]

本实例中,利用交互编码器融合了主体特征和边缘特征,再反馈给主体编码器和边缘编码器进行二次迭代,二次迭代的输出将具有更清晰的边缘特征,更符合实际标签。

[0104]

本实施例利用多分支融合网络,将主体与边缘分开进行特征的多尺度提取和融合,有利于显著目标的边缘刻画。在实例中引入标签解耦的方法,该方法对肠道息肉图像标签进行解耦,利用距离变换法将原有标签解耦为主体标签和边缘标签,解耦后的标签有利

于对模型的监督和评估。

[0105]

本实施例设计了细节增强模块、指导融合模块和多分支解码模块。在使用transformer骨干网络提取特征的基础上,用卷积神经网络进行局部信息的增强和特征融合。用深度监督使每一层的特征融合结果都得到学习,逐步融合得到清晰准确的最终结果。在transformer的自注意力机制准确定位检测区域的基础上,用卷积神经网络捕捉细节信息并进行融合,充分利用两者的优势,得到清晰准确的结果。

[0106]

以上所述实施例仅表达了本技术的几种实施方式,其描述较为具体和详细,但并不能因此而理解为对发明专利范围的限制。应当指出的是,对于本领域的普通技术人员来说,在不脱离本技术构思的前提下,还可以做出若干变形和改进,这些都属于本技术的保护范围。因此,本技术专利的保护范围应以所附权利要求为准。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。