1.本技术涉及固态存储设备领域,尤其涉及一种固态存储设备及写/读数据的方法。

背景技术:

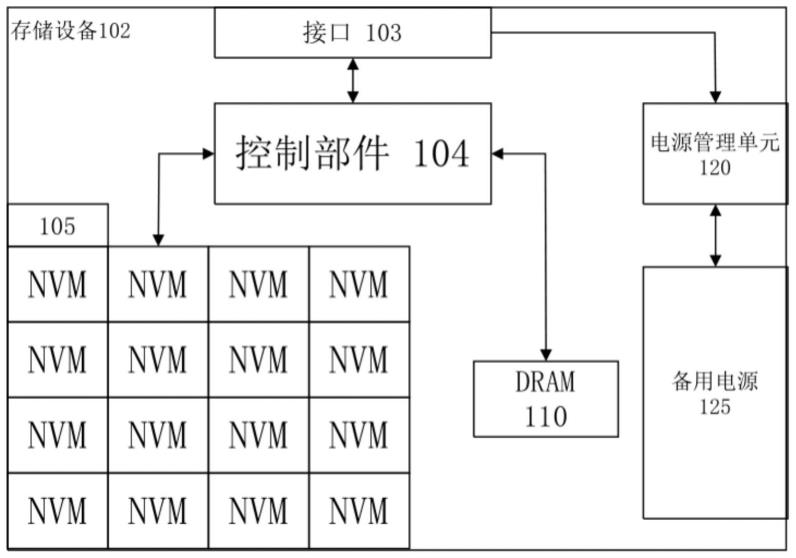

2.随着科技的进步,对于电子设备的存储能力和反应速度提出了越来越高的要求。图1示出了现有技术中的ssd(solid storage device,固态存储设备)的框图。

3.固态存储设备102同主机相耦合,用于为主机提供存储能力。主机同固态存储设备102之间可通过多种方式相耦合,耦合方式包括但不限于通过例如sata(serial advancedtechnology attachment,串行高级技术附件)、scsi(small computer system interface,小型计算机系统接口)、sas(serial attached scsi,串行连接scsi)、ide(integrateddrive electronics,集成驱动器电子)、usb(universal serial bus,通用串行总线)、pcie(peripheral component interconnect express,pcie,高速外围组件互联)、nvme(nvmexpress,高速非易失存储)、以太网、光纤通道、无线通信网络等连接主机与固态存储设备102。主机可以是能够通过上述方式同存储设备相通信的信息处理设备,例如,个人计算机、平板电脑、服务器、便携式计算机、网络交换机、路由器、蜂窝电话、个人数字助理等。存储设备102包括接口103、控制部件104、一个或多个nvm(non-volatile memory,非易失存储器)芯片105以及dram(dynamic random access memory,动态随机访问存储器)110。nand闪存、相变存储器、feram、mram等是常见的nvm。接口103可适配于通过例如sata、ide、usb、pcie、nvme、sas、以太网、光纤通道等方式与主机交换数据。控制部件104用于控制在接口103、nvm芯片105以及固件存储器110之间的数据传输,还用于存储管理、主机逻辑地址到闪存物理地址映射、擦除均衡、坏块管理等。可通过软件、硬件、固件或其组合的多种方式实现控制部件104。控制部件104可以是fpga(field-programmable gate array,现场可编程门阵列)、asic(application specific integrated circuit,应用专用集成电路)或者其组合的形式。控制部件104也可以包括处理器或者控制器,在处理器或控制器中执行软件来操纵控制部件104的硬件来处理主机io命令。控制部件104还耦合到dram 110,并可访问dram 110的数据。在dram可存储ftl表和/或缓存的主机io命令的数据。

4.控制部件104包括闪存接口控制器(或称为闪存通道控制器)。闪存接口控制器耦合到nvm芯片105,并以遵循nvm芯片105的接口协议的方式向nvm芯片105发出命令,以操作nvm芯片105,并接收从nvm芯片105输出的命令执行结果。nvm芯片105的接口协议包括“toggle”、“onfi”等公知的接口协议或标准。

5.存储器目标(target)是nand闪存封装内的共享芯片使能(ce,chip enable)信号的一个或多个逻辑单元(lun,logic unit)。每个逻辑单元具有逻辑单元号(logic unitnumber)。nand闪存封装内可包括一个或多个管芯(die)。典型地,逻辑单元对应于单一的管芯。逻辑单元可包括多个平面(plane)。逻辑单元内的多个平面可以并行存取,而nand闪存芯片内的多个逻辑单元可以彼此独立地执行命令和报告状态。在可从http://www.micron.com/~/media/documents/products/other%20documents/onfi3_

0gold.ashx获得的“open nand flash interface specification(revision 3.0)”中,提供了关于目标(target)、逻辑单元、lun、平面(plane)的含义,其为现有技术的一部分,后文出现的lun均表示逻辑单元的简称。

6.固态存储设备中包括多个nvm芯片。每个nvm芯片包括一个或多个物理管芯(die)或逻辑单元(lun,logic unit)。管芯或逻辑单元之间可以并行响应读写操作。在同一管芯或逻辑单元上的多个读、写或擦除操作顺序执行。

7.存储介质上通常按页来存储和读取数据。而按块来擦除数据。块包含多个页。存储介质上的页(称为物理页)具有固定的尺寸,例如17664字节。物理页也可以具有其他的尺寸。物理页中可以包括多个数据帧(data frame),数据帧具有指定的尺寸,例如4096或4416字节。

8.ssd固件在运行时需要利用ftl(flash translation layer,闪存转换层)来维护逻辑地址(lba,32位)和物理地址(pba,32位)的映射关系,逻辑地址构成了操作系统等上层软件所感知到的固态存储设备的存储空间,物理地址是用于访问固态存储设备的物理存储单元的地址。这张ftl映射关系表保存在ssd的dram中。由于dram属于易失性存储,设备掉电以后映射表会丢失,所以需要固件在重新上电后恢复此映射表,以保证原始用户数据不会丢失。当发生意外断电时,由电源管理单元120管理备用电源125向存储设备提供临时的电能,用于备份元数据以及处理尚未完成的命令。备用电源125包括超级电容、铝电容、钽聚合物电容、锂电池等。

9.现有技术中,在固态存储设备的每个物理页中附加地存储该物理页所对应的逻辑地址。在固态存储设备启动时,需要访问所有物理页,以获得每个物理页所对应的逻辑地址,在dram中重建ftl表。

10.ssd的存储介质是闪存,而闪存技术随着3d堆叠技术的发展,容量密度也在不断提升,例如基于176层闪存堆叠技术的ssd,单盘可以实现32tb甚至更大容量。而ftl表的大小和ssd的容量成正比,所以ssd大容量的同时会带来一个问题,那就是ftl表会更大,例如32tb的ssd对应ftl表的大小约为32gb。

11.逻辑地址lba和物理地址pba分别为32位,将ftl表划分为64份(64个数据流),当某一份数据流上对应的逻辑地址有新的写命令发生时,固件会记录日志,每一份数据流都有自己独立的更新日志。固件在恢复映射表时,可以利用多个cpu并发操作,按照日志记录的先后顺序,以打补丁的方式恢复各个数据流。

12.随着ssd容量的增大,需要管理的逻辑地址和物理地址也随之增多。以32tb的ssd为例,固件内部管理的逻辑地址以4kb为单位,即每个固件内部逻辑地址管理一个4k大小的数据,32位逻辑地址最多能管理4g*4k=16tb的数据,如需管理32tb数据,32位的逻辑地址已经不能满足需求,需要扩充至64位的逻辑地址。同样,32tb的ssd与16tb的ssd相比,物理块的数量也翻了一倍,如果仅简单的将32位物理地址也扩充至64位物理地址,会大大增加ftl表的大小(增加至4倍),从而增加所需dram的空间,提高成本。同时,ftl表的增大,每份数据流也随之增大,各个数据流所独有的更新日志也会随之增多,大大增加恢复数据流的时间,从而影响整个ssd的上电恢复时间。

13.因此,如何缩短大容量存储设备异常掉电的恢复时间,是目前本领域技术人员需要解决的技术问题。

技术实现要素:

14.本技术提供了一种固态存储设备及写/读数据的方法,可以限制大容量存储设备的ftl表的指数级增大,从而缩短了大容量存储设备异常掉电的恢复时间。

15.为解决上述技术问题,本技术提供如下技术方案:

16.一种固态存储设备,包括:逻辑地址空间和物理地址空间;将逻辑地址空间按照预定大小划分为若干逻辑块,将所有逻辑块按照预定的规律划分为不同的逻辑分区;将物理地址空间的多个物理die合并为一个物理分区,一个物理分区与一个lun相映射;物理地址空间对应的lun索引为逻辑分区索引和物理分区索引确定,逻辑分区索引由逻辑地址空间的逻辑地址确定,物理分区索引由物理地址空间的物理die确定。

17.如上所述的固态存储设备,其中,优选的是,每个逻辑分区由独立的cpu管理。

18.如上所述的固态存储设备,其中,优选的是,将逻辑分区索引作为物理地址的最高有效位,将物理分区lun索引作为物理地址的次高有效位;将计算得到的lun索引在物理地址中覆盖物理分区索引,并将物理地址中逻辑分区索引所占用的比特位设置为物理地址的无效位。

19.如上所述的固态存储设备,其中,优选的是,16tb ssd的物理地址pba的0-22位记录的是块

×

页,16tb ssd的物理地址pba的23-25位记录的是数据帧索引,16tb ssd的物理地址pba的26-31位记录的是lun索引。

20.如上所述的固态存储设备,其中,优选的是,32tb ssd的物理地址pba的0

‑‑

22位记录的是块

×

页,32tb ssd的物理地址pba的23-26位记录的是数据帧索引,32tb ssd的物理地址pba的27-31位记录的是lun索引。

21.如上所述的固态存储设备,其中,优选的是,还包括ftl表;ftl表被划分为多个数据流并发单元,每个数据流并发单元中包含有多个数据流,一个数据流并发单元中的所有数据流在一个cpu上被处理;其中,划分的数据流并发单元的数量与固态存储设备的容量呈正比。

22.一种写数据的方法,包括如下步骤:响应于接收到写命令,依据写命令指示的逻辑地址分配存储写命令指示的数据的物理空间;依据写命令指示的逻辑地址,得到逻辑地址所属的逻辑分区;依据逻辑分区索引和存储写命令指示的数据的物理空间所属的物理分区索引,得到lun索引;将lun索引、数据帧索引和块

×

页记录于物理地址中;将逻辑地址和物理地址的映射关系记录于ftl表中,以更新ftl表;响应于向分配的物理空间中写入数据完毕,写命令完成。

23.如上所述的写数据的方法,其中,优选的是,还包括:将ftl表划分为多个数据流并发单元,每个数据流并发单元中包含有多个数据流,一个数据流并发单元中的所有数据流在一个cpu上被处理;其中,划分的数据流并发单元的数量与固态存储设备的容量呈正比。

24.一种读数据的方法,包括如下步骤:响应于接收到读命令,依据读命令指示的逻辑地址查询ftl表得到物理地址,其中物理地址中记录有lun索引、数据帧索引和块

×

页;依据读命令指示的逻辑地址,得到逻辑地址所属的逻辑分区;依据逻辑分区索引和lun索引,得到物理分区索引;在物理分区索引所指示的物理分区中,依据块

×

页和数据帧索引读出读命令指示的数据。

25.如上所述的读数据的方法,其中,优选的是,还包括:将ftl表划分为多个数据流并

发单元,每个数据流并发单元中包含有多个数据流,一个数据流并发单元中的所有数据流在一个cpu上被处理;其中,划分的数据流并发单元的数量与固态存储设备的容量呈正比。

26.相对上述背景技术,本发明所提供固态存储设备及写/读数据的方法,可以限制大容量存储设备的ftl表的指数级增大,从而缩短了大容量存储设备异常掉电的恢复时间。

附图说明

27.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明中记载的一些实施例,对于本领域普通技术人员来讲,还可以根据这些附图获得其他的附图。

28.图1示出了现有技术中的固态存储设备的框图;

29.图2示出了相关实施例中的固态存储设备的逻辑地址的格式示意图;

30.图3示出了相关实施例中的固态存储设备的物理地址的格式示意图;

31.图4是本技术实施例提供的固态存储设备的逻辑地址的格式示意图;

32.图5是本技术实施例提供的固态存储设备的物理地址的格式示意图;

33.图6是本技术实施例提供的写数据的方法的流程图;

34.图7是本技术实施例提供的读数据的方法的流程图;

35.图8是本技术实施例提供的针对ftl表的数据流的划分示意图;

36.图9a是本技术实施例提供的cpu并发处理64份数据流的示意图;

37.图9b是本技术实施例提供的cpu并发处理128份数据流的示意图。

具体实施方式

38.下面详细描述本技术的实施例,所述实施例的示例在附图中示出,其中自始至终相同或类似的标号表示相同或类似的元件或具有相同或类似功能的元件。下面通过参考附图描述的实施例是示例性的,仅用于解释本技术,而不能解释为对本技术的限制。

39.固件内部管理的逻辑地址lba是以4k为单位的,即每个固件内部逻辑地址lba管理一个4k大小的数据,逻辑地址lba对应的物理地址pba也是32位格式表征,如果按照传统ftl表映射实现,大容量ssd(例如:16tb、32tb ssd)和小容量ssd(例如:8tb ssd)的物理地址pba具有相同的格式。

40.请参阅图2,图2示出了相关实施例中的固态存储设备的逻辑地址的格式示意图。

41.8tb ssd的逻辑地址(lba)空间具有n个逻辑块,分别是逻辑块lba0、逻辑块lba1、逻辑块lba2、逻辑块lba3、

……

、逻辑块lban。当然,16tb ssd和32tb ssd的逻辑地址(lba)空间也和8tb ssd的逻辑地址(lba)空间形式相同。

42.请参阅图3,图3示出了相关实施例中几种容量固态存储设备的物理地址的格式示意图。

43.8tb ssd的物理地址pba的0-20位记录的是块

×

页,8tb ssd的物理地址pba的21-24位记录的是数据帧索引,8tb ssd的物理地址pba的25-31位记录的是lun索引。其中“块

×

页”表示的是存储空间中以块和页为单位的存储空间,具体为进行数据读写时以页为单位,进行数据擦除时以块(多个页组成)为单位。

44.16tb ssd的物理地址pba的0-21位记录的是块

×

页,16tb ssd的物理地址pba的22-25位记录的是数据帧索引,16tb ssd的物理地址pba的26-31位记录的是lun索引。

45.32tb ssd的物理地址pba的0-22位记录的是块

×

页,32tb ssd的物理地址pba的23-26位记录的是数据帧索引,32tb ssd的物理地址pba的27-31位记录的是lun索引。

46.由于功耗的限制,ssd同时并发操作的lun的个数最大为128个(32位表征,2的7次方=128)。而8tb ssd的物理die的个数也为128个,可同时并发操作的lun的最大数量与物理die的数量相同,均为128个,能够满足映射要求。但是,16tb ssd的物理die的个数为256个,32tbssd的物理die的个数为512个,可同时并发操作的lun的最大数量与物理die的数量不同,物理die的数量已经超过可同时并发操作的lun的最大数量。

47.为了避免大容量ssd(例如:16tb、32tb)的ftl表的大小出现较大的增大,将大容量ssd的逻辑地址lba和物理地址pba均保持在相同位数(如32位),并且将大容量ssd的可同时并发操作的lun的最大数量与物理die的数量保持相同。请参阅图4,图4是本技术实施例提供的固态存储设备的逻辑地址的格式示意图。

48.逻辑地址(lba)空间是连续的地址空间,固件将逻辑地址(lba)空间按照预定大小划分为若干相同大小的区域,每个区域被称为逻辑块。作为一个例子,将逻辑地址空间按照512kb大小划分为n份,形成n个相同大小的逻辑块。例如:形成逻辑块lba0、

……

、逻辑块lban。

49.按照预定的规律将若干个逻辑块划分为不同的逻辑分区。例如:将每32个逻辑块划分为一个逻辑分区。作为一个例子,将上述划分的逻辑块lba0、

……

、逻辑块lba31划分为逻辑分区0,将逻辑块lba32、

……

、逻辑块lba63划分为逻辑分区1,将逻辑块lba64、

……

、逻辑块lba95划分为逻辑分区2,将逻辑块lba96、

……

、逻辑块lba127划分为逻辑分区3,

……

,以此类推,直至将逻辑块lban划分至最后一个逻辑分区n。还作为一个例子,在16tb ssd中,lba 0~127划分为逻辑分区0,lba 128~255划分为逻辑分区1,lba 256~383划分为逻辑分区0,lba 384~511划分为逻辑分区1,lba 512~639划分为逻辑分区0;在32tb ssd中,lba 0~127划分为逻辑分区0,lba 128~255划分为逻辑分区1,lba 256~383划分为逻辑分区2,lba 384~511划分为逻辑分区3,lba 512~639划分为逻辑分区0。

50.每个逻辑分区均由独立的cpu管理,这意味着所有逻辑分区可同时并发操作。作为一个例子,cpu0管理逻辑分区0,cpu1管理逻辑分区1,cpu2管理逻辑分区2,cpu3管理逻辑分区3,

……

,cpum管理逻辑分区n。

51.请参阅图5,图5是本技术实施例提供的固态存储设备的物理地址的格式示意图。

52.为了将大容量ssd的物理地址pba限制在预定的位数(如:32位),物理地址pba中的lun索引所占的比特位需要相应的减少,并且物理地址pba中的lun索引还需要能反映出物理分区。

53.通过逻辑地址lba计算出逻辑分区索引,例如:根据逻辑地址lba30得到逻辑分区索引为0,根据逻辑地址lba60得到逻辑分区索引为1,根据逻辑地址lba90得到逻辑分区索引为3。通过逻辑分区索引和物理分区索引计算得到物理地址中最终记录的lun索引。作为一个例子,将逻辑分区索引作为物理地址的最高有效位(msb,most significant bit),将物理分区索引作为物理地址的次高有效位,然后通过逻辑分区索引和物理分区索引计算出lun索引,并将计算得到的lun索引在物理地址中覆盖物理分区索引,并将物理地址中逻辑

分区索引所占用的比特位设置为无效位,从而可以将物理地址控制32位。作为另一个例子,lun索引(例如:0-127)=逻辑分区索引*可同时并发操作的lun的最大个数(例如:64或32) 物理分区索引。通过上述方法,可以使物理地址仍然保持在32位,从而控制ftl表只按照逻辑空间的增加而增加,避免ftl表因物理地空间的增加而增加,也就在一定程度上限制大容量ssd的ftl表的增大。

54.将大容量ssd的多个物理die合并为一个物理分区一个物理分区与一个lun相映射,从而使得一个lun对应的物理die较多,进而在lun的个数不变的情况下,每个lun中所对应的块的数量增加,满足了固件处理最大lun的个数限制。另外,在每个lun中所包含的块的数量增加的情况下,相应的物理地址中的块

×

页所占用的比特位也相应的增加,那么就需要减少物理地址中的其他部分所占用的比特位。

55.作为一个例子,16tb ssd的物理地址pba的0-22位记录的是块

×

页,16tb ssd的物理地址pba的23-25位记录的是数据帧索引,16tb ssd的物理地址pba的26-31位记录的是lun索引,其中lun索引是通过物理分区索引和逻辑分区索引得到的,物理分区索引被临时记录于26-31位,逻辑分区索引被临时记录于32位,通过被临时记录于26-31位的物理分区索引和被临时记录于32位的逻辑分区索引得到lun索引被最终记录于26-31位,从而使得形成的16tb ssd的物理地址pba保持在32位。

56.作为另一个例子,32tb ssd的物理地址pba的0

‑‑

22位记录的是块

×

页,32tb ssd的物理地址pba的23-26位记录的是数据帧索引,32tb ssd的物理地址pba的27-31位记录的是lun索引,其中lun索引是通过物理分区索引和逻辑分区索引得到的,物理分区索引被临时记录于27-31位,逻辑分区索引被临时记录于31-33位,通过被临时记录于27-31位的物理分区索引和被临时记录于31-33位的逻辑分区索引得到的lun索引被最终记录于27-31位,从而使得形成的32tb ssd的物理地址pba保持在32位。

57.由于本技术通过增加逻辑分区和物理分区,可以精简大容量物理地址长度,在ssd容量增大的情况下,物理地址保持在原来位数,控制ftl表可以只按逻辑地址的增加而增加,可以在一定程度上限制大容量ssd的ftl表的增大,因此可以避免因ftl表增大使所需的dram空间增大,从而降低大容量ssd的成本。另外,还由于本技术可以在一定程度上限制大容量ssd的ftl表的增大,因此在固件恢复ftl表时,可以避免每份数据流的增大,也避免各个数据流所独有的更新日志增多,大大缩短大容量ssd异常掉电后的恢复时间。

58.请参阅图6,图6是本技术实施例提供的写数据的方法的流程图。

59.本技术提供了一种写数据的方法,包括如下步骤:

60.步骤s610、响应于接收到写命令,依据写命令指示的逻辑地址分配存储写命令指示的数据的物理空间。

61.存储设备的固件获取主机提供的写命令,写命令指示了逻辑地址以及待写入的数据。并且,存储设备的固件还依据逻辑地址为写命令指示的待写入的数据分配物理空间,将写命令指示的待写入的数据写入该物理空间中,以存储该数据。

62.步骤s620、依据写命令指示的逻辑地址,得到逻辑地址所属的逻辑分区。

63.逻辑地址(lba)空间是连续的地址空间,固件将逻辑地址(lba)空间按照预定大小划分为若干相同大小的区域,每个区域被称为逻辑块。作为一个例子,将逻辑地址空间按照512kb大小划分为n份,形成n个相同大小的逻辑块。例如:形成逻辑块lba0、

……

、逻辑块

lban。

64.按照预定的规律将若干个逻辑块划分为不同的逻辑分区。例如:将每32个逻辑块划分为一个逻辑分区。作为一个例子,将上述划分的逻辑块lba0、

……

、逻辑块lba31划分为逻辑分区0,将逻辑块lba32、

……

、逻辑块lba63划分为逻辑分区1,将逻辑块lba64、

……

、逻辑块lba95划分为逻辑分区2,将逻辑块lba96、

……

、逻辑块lba127划分为逻辑分区3,

……

,直至将逻辑块lban划分至最后一个逻辑分区n。还作为一个例子,在16tb ssd中,lba 0~127划分为逻辑分区0,可以简化表示为lba 0~127:逻辑分区0,同理,lba128~255:逻辑分区1,lba 256~383:逻辑分区0,lba 384~511:逻辑分区1,lba 512~639:逻辑分区0;在32tb ssd中,lba 0~127:逻辑分区0,lba 128~255:逻辑分区1,lba 256~383:逻辑分区2,lba 384~511:逻辑分区3,lba 512~639:逻辑分区0。

65.存储设备的固件接收到主机提供的写命令后,还依据预定的规律通过逻辑地址得到逻辑地址所属的逻辑分区。

66.步骤s630、依据逻辑分区索引和存储写命令指示的数据的物理空间所属的物理分区索引,得到lun索引。

67.将大容量的存储设备的一个或多个物理die合并为一个物理分区一个物理分区与一个lun相映射,从而使得一个lun对应的物理die较多,进而在lun的个数不变的情况下,每个lun中所包含的块的数量增加,满足了固件处理最大lun的个数限制。

68.存储设备的固件依据写命令指示的逻辑地址分配存储写命令所指示的数据的物理空间。由于本技术将存储设备的一个或多个物理die合并为一个物理分区,一个物理分区对应一个lun所以依据写命令所分配的物理空间必然属于某一物理分区,对应某一lun,某一lun必然属于某一逻辑分区,因此本技术中在所分配的物理空间的物理地址pba中记录了lun索引,其中lun索引是通过物理分区索引和逻辑分区索引得到的。

69.步骤s640、将lun索引、数据帧索引和块

×

页记录于物理地址中。

70.作为一个例子,16tb ssd的物理地址pba的0-22位记录的是块

×

页,16tb ssd的物理地址pba的23-25位记录的是数据帧索引,16tb ssd的物理地址pba的26-31位记录的是lun索引,其中lun索引是通过物理分区索引和逻辑分区索引得到的,物理分区索引被临时记录于26-31位,逻辑分区索引被临时记录于32位,通过被临时记录于26-31位的物理分区索引和被临时记录于32位的逻辑分区索引得到的lun索引被最终记录于26-31位,从而使得形成的16tb ssd的物理地址pba保持在32位。

71.作为又一个例子,32tb ssd的物理地址pba的0-22位记录的是块和页,32tb ssd的物理地址pba的23-26位记录的是数据帧索引,32tb ssd的物理地址pba的27-31位记录的是lun索引,其中lun索引通过物理分区索引和逻辑分区索引得到的,物理分区索引被临时记录于27-31位,逻辑分区索引被临时记录于31-33位,通过被临时记录于27-31位的物理分区索引和被临时记录于31-33位的逻辑分区索引得到的lun索引被最终记录于27-31位,从而使得形成的32tb ssd的物理地址pba保持在32位。

72.步骤s650、将逻辑地址和物理地址的映射关系记录于ftl表中,以更新ftl表。

73.将写命令指示的逻辑地址以及依据逻辑地址分配的物理空间的物理地址记录于ftl表中,其中物理地址中记录有lun索引、数据帧索引和块

×

页的物理地址。待将该写命令指示的逻辑地址和分配的物理空间的物理地址记录于ftl表中后,完成对ftl表的更新。

74.步骤s660、响应于向分配的物理空间中写入数据完毕,写命令完成。

75.将写命令所指示的数据存储至分配的物理空间后,以及将逻辑地址和物理地址的映射关系记录于ftl表中后,存储设备的固件向主机发送写命令完成的信息。

76.请参阅图7,图7是本技术实施例提供的读数据的方法的流程图。

77.本技术提供了一种读数据的方法,包括如下步骤:

78.步骤s710、响应于接收到读命令,依据读命令指示的逻辑地址查询ftl表得到物理地址,其中物理地址中记录有lun索引、数据帧索引和块

×

页。

79.存储设备的固件获取主机提供的读命令,读命令指示了逻辑地址以及待读取的数据。并且,由于ftl表中记录逻辑地址和物理地址的映射关系,因此存储设备的固件还依据逻辑地址查询ftl表,得到待读取数据存储的物理地址,其中物理地址中记录有lun索引、数据帧索引和块

×

页。

80.作为一个例子,16tb ssd的物理地址pba的0-22位记录的是块

×

页,16tb ssd的物理地址pba的23-25位记录的是数据帧索引,16tb ssd的物理地址pba的26-31位记录的是lun索引,其中lun索引是通过物理分区索引和逻辑分区索引得到的,物理分区索引被临时记录于26-31位,逻辑分区索引被临时记录于32位,通过被临时记录于26-31位的物理分区索引和被临时记录于32位的逻辑分区索引得到的lun索引被最终记录于26-31位,从而使得形成的16tb ssd的物理地址pba保持在32位。

81.作为又一个例子,32tb ssd的物理地址pba的0-22位记录的是块和页,32tb ssd的物理地址pba的23-26位记录的是数据帧索引,32tb ssd的物理地址pba的27-31位记录的是lun索引,其中lun索引通过物理分区索引和逻辑分区索引得到的,物理分区索引被临时记录于27-31位,逻辑分区索引被临时记录于31-33位,通过被临时记录于27-31位的物理分区索引和被临时记录于31-33位的逻辑分区索引得到的lun索引被最终记录于27-31位,从而使得形成的32tb ssd的物理地址pba保持在32位。

82.步骤s720、依据读命令指示的逻辑地址,得到逻辑地址所属的逻辑分区。

83.逻辑地址(lba)空间是连续的地址空间,固件将逻辑地址(lba)空间按照预定大小划分为若干相同大小的区域,每个区域被称为逻辑块。作为一个例子,将逻辑地址空间按照512kb大小划分为n份,形成n个相同大小的逻辑块。例如:形成逻辑块lba0、

……

、逻辑块lban。

84.按照预定的规律将若干个逻辑块划分为不同的逻辑分区。例如:将每32个逻辑块划分为一个逻辑分区。作为一个例子,将上述划分的逻辑块lba0、

……

、逻辑块lba31划分为逻辑分区0,将逻辑块lba32、

……

、逻辑块lba63划分为逻辑分区1,将逻辑块lba64、

……

、逻辑块lba95划分为逻辑分区2,将逻辑块lba96、

……

、逻辑块lba127划分为逻辑分区3,

……

,以此类推,直至将逻辑块lban划分至最后一个逻辑分区n。还作为一个例子,在16tb ssd中,lba 0~127划分为逻辑分区0,lba 128~255划分为逻辑分区1,lba 256~383划分为逻辑分区0,lba 384~511划分为逻辑分区1,lba 512~639划分为逻辑分区0;在32tb ssd中,lba 0~127划分为逻辑分区0,lba 128~255划分为逻辑分区1,lba 256~383划分为逻辑分区2,lba 384~511划分为逻辑分区3,lba 512~639划分为逻辑分区0。

85.存储设备的固件接收到主机提供的读命令后,还依据预定的规律通过逻辑地址得到逻辑地址所属的逻辑分区。

bit),将物理分区索引作为物理地址的次高有效位,然后通过逻辑分区索引和物理分区索引计算出lun索引,并将计算得到的lun索引在物理地址中覆盖物理分区索引,并将物理地址中逻辑分区索引所占用的比特位设置为无效位,从而可以将物理地址控制32位。作为另一个例子,lun索引(例如:0-127)=逻辑分区索引*可同时并发操作的lun的最大个数(例如:64或32) 物理分区索引。

100.作为一个例子,16tb ssd的物理地址pba的0-22位记录的是块

×

页,16tb ssd的物理地址pba的23-25位记录的是数据帧索引,16tb ssd的物理地址pba的26-31位记录的是lun索引,其中lun索引是通过物理分区索引和逻辑分区索引得到的,物理分区索引被临时记录于26-31位,逻辑分区索引被临时记录于32位,通过被临时记录于26-31位的物理分区索引和被临时记录于32位的逻辑分区索引得到lun索引被最终记录于26-31位,从而使得形成的16tb ssd的物理地址pba保持在32位。

101.作为另一个例子,32tb ssd的物理地址pba的0

‑‑

22位记录的是块

×

页,32tb ssd的物理地址pba的23-26位记录的是数据帧索引,32tb ssd的物理地址pba的27-31位记录的是lun索引,其中lun索引是通过物理分区索引和逻辑分区索引得到的,物理分区索引被临时记录于27-31位,逻辑分区索引被临时记录于31-33位,通过被临时记录于27-31位的物理分区索引和被临时记录于31-33位的逻辑分区索引得到的lun索引被最终记录于27-31位,从而使得形成的32tb ssd的物理地址pba保持在32位。

102.上述逻辑地址及物理地址记录于ftl表中,物理地址中记录有lun索引、数据帧索引和块

×

页的物理地址。本技术的ftl表还被划分为多个数据流并发单元,划分的数据流并发单元的数量与固态存储设备的容量呈正比,每个数据流并发单元中包含有多个数据流,一个数据流并发单元中的所有数据流在一个cpu上被处理。这样,本技术提供的固态存储设备的每个cpu上处理的日志数据就较为均衡,从而使得整个ssd上电恢复时间总体较短。

103.请参阅图8,图8是本技术实施例提供的针对ftl表的数据流的划分示意图。

104.将ftl表划分为多个数据流并发单元,每个数据流并发单元中包含有多个数据流,一个数据流并发单元中的所有数据流在一个cpu上被处理。其中,划分的数据流并发单元的数量与ssd的容量呈正比,也就是ssd的容量较大,则其ftl表划分的数据流并发单元的数量较多,ssd的容量较小,则ftl表划分的数据流并发单元的数量较少。

105.作为一个例子,将16tbssd的ftl表划分为64份(64个数据流stream并发单元),例如:数据流并发单元1、数据流并发单元2、

…

、数据流并发单元64。由于16tb ssd的ftl表的大小为16gb,若按照64分来划分,每份数据流并发单元的大小会是16gb/64=250mb。

106.作为另一个例子,将32tb ssd的ftl表划分为64份(64个数据流并发单元),例如:数据流并发单元1、数据流并发单元2、

…

、数据流并发单元64。由于32tb ssd的ftl表的大小为32gb,若按照64份来划分,每份数据流并发单元的大小会是32gb/64=500mb。

107.将32tb ssd的ftl表划分为128份(128个数据流并发单元),例如:数据流并发单元1、数据流并发单元2、

…

、数据流并发单元128。由于32tb ssd的ftl表的大小为32gb,若按照128份来划分,每份数据流并发单元的大小会是32gb/128=250mb。这样,每份数据流的大小不变,所管理的逻辑地址范围也不变,当有新的写发生时,每份数据流上记录的日志数量也不会有明显变化。减少数据流上记录的日志数量,可以减少大容量ssd上电恢复时间。

108.异常上电恢复时,多个cpu会并行恢复各个数据流并发单元,由于数据流并发单元

的个数远多于cpu的个数,所以会出现多个数据流并发单元在一个cpu上排队等待的情况。那么,将32tb ssd的ftl表划分为128份相较于划分为64份,每份数据流并发单元记录的日志数量较少,每个cpu上处理的日志数据就较为均衡,从而使得整个ssd上电恢复时间总体较短。

109.基于上述,一方面,通过增加ftl分区,解决因为ftl表大小增加,pba地址位表征不足问题;另一方面,增加ftl表数据流数量,减少在有新的写命令时各个数据流记录日志的数量,提高上电恢复cpu处理并发度,保证ftl表重构并发处理单元的负载均衡。综合两方面优化,使得对于大容量ssd在异常掉电的情况下,也能保证较短恢复时间,帮助业务快速恢复。请参阅图9a,图9a是本技术实施例提供的cpu并发处理64份数据流的示意图。

110.作为一个例子,将32tb ssd的ftl表划分为64份数据流并发单元,cpu0处理数据流并发单元10(图中简单标记为数据流10,后文同理)、数据流并发单元18,cpu1处理数据流并发单元11、数据流并发单元21,cpu2处理数据流并发单元12、数据流并发单元30,cpu3处理数据流并发单元13、数据流并发单元43,cpu4处理数据流并发单元14、数据流并发单元49,cpu5处理数据流并发单元15、数据流并发单元60。数据流并发单元21的较大,因此在其他数据流单元处理完成后,cpu1还会持续处理数据流并发单元21,从而整个ssd上电恢复时间总体较长。

111.请参阅图9b,图9b是本技术实施例提供的cpu并发处理128份数据流的示意图。

112.作为另一个例子,将32tb ssd的ftl表划分为128份数据流并发单元,cpu0处理数据流并发单元10、数据流并发单元18、数据流并发单元30、数据流并发单元39,cpu1处理数据流并发单元11、数据流并发单元21、数据流并发单元31、数据流并发单元42,cpu2处理数据流并发单元12、数据流并发单元25、数据流并发单元33、数据流并发单元43,cpu3处理数据流并发单元13、数据流并发单元26、数据流并发单元34、数据流并发单元50,cpu4处理数据流并发单元14、数据流并发单元27、数据流并发单元37、数据流并发单元56,cpu5处理数据流并发单元15、数据流并发单元28、数据流并发单元38、数据流并发单元60。虽然,数据流并发单元42和数据流并发单元43也较大,但是由于ftl表划分的份数较多,所以每个数据流并发单元的大小均不是很大,因此cpu1持续处理数据流并发单元42和cpu2持续处理数据流并发单元43的时间均较短,从而整个ssd上电恢复时间总体较短。

113.本技术限制大容量ssd的ftl表的指数级增大,避免了所需的dram空间增大,节省了成本。另外,本技术可以在一定程度上限制大容量ssd的ftl表的增大,并且还使得每份数据流减小,因此避免了各个数据流所独有的更新日志增多,大大缩短了大容量ssd异常掉电后的恢复时间,帮助业务部署快速恢复,满足了市场需求。

114.对于本领域技术人员而言,显然本发明不限于上述示范性实施例的细节,而且在不背离本发明的精神或基本特征的情况下,能够以其他的具体形式实现本发明。因此,无论从哪一点来看,均应将实施例看作是示范性的,而且是非限制性的,本发明的范围由所附权利要求而不是上述说明限定,因此旨在将落在权利要求的等同要件的含义和范围内的所有变化囊括在本发明内。不应将权利要求中的任何附图标记视为限制所涉及的权利要求。

115.此外,应当理解,虽然本说明书按照实施方式加以描述,但并非每个实施方式仅包含一个独立的技术方案,说明书的这种叙述方式仅仅是为清楚起见,本领域技术人员应当将说明书作为一个整体,各实施例中的技术方案也可以经适当组合,形成本领域技术人员

可以理解的其他实施方式。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。