1.本发明涉及隐私保护技术领域,具体是一种面向联邦生成对抗网络的隐私增强方法。

背景技术:

2.由于物联网终端设备的离散性特点,仅靠一个中央服务器来收集和分析这些终端数据是很困难的。在基于边缘计算的物联网场景中,边缘服务器的出现可以有效缓解这一问题。然而,由于安全和隐私问题,这些终端物联网数据仍然可能受到各种攻击,如来自服务提供商、恶意用户和第三方应用程序的攻击等。在过去的几年里,人工智能算法已经被用于物联网数据分析,但也存在安全风险,如隐私泄露。恶意的对手可以利用人工智能算法中的各种漏洞来破坏人工智能系统的安全性。

3.生成式对抗网络是一种对抗性的人工智能算法,可以生成用于数据增强或其他应用的合成数据。在物联网场景中,数据分布在多个数据源中,每个数据源的规模和多样性都过于有限,训练一个准确的生成式对抗网络是一个严峻的挑战。联邦学习作为一种分布式机器学习范式,它使分布的终端设备能够在不公布原始数据的情况下参与全局模型训练。这为终端数据提供了一定程度的隐私保护。虽然联邦学习下的生成式对抗网络只是通过对抗性训练获知训练数据的分布,但对它的重复采样仍可能暴露原始数据特征。攻击者甚至可以在分布式边缘节点上发起深度的梯度泄漏攻击来推断模型。为了抵御梯度攻击,基于梯度消毒方法的联邦生成对抗网络通过对梯度裁剪和添加噪音以提供差分隐私保证。然而,这种方法对梯度的修改会影响生成网络的收敛性能,导致合成数据的质量较差。

技术实现要素:

4.本发明的目的在于提供一种面向联邦生成对抗网络的隐私增强方法,以解决上述背景技术中提出的问题。

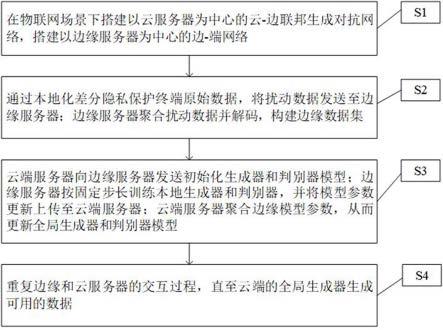

5.本发明的技术方案是:一种面向联邦生成对抗网络的隐私增强方法,包括以下步骤:s1、在物联网场景下搭建以云服务器为中心的云-边联邦生成对抗网络,搭建以边缘服务器为中心的边-端网络;s2、通过本地化差分隐私技术保护终端原始数据,将扰动数据发送至边缘服务器;边缘服务器端聚合扰动数据并解码,构建边缘数据集;s3、云端服务器向边缘服务器发送初始化生成器和判别器模型;边缘服务器按固定步长训练本地生成器和判别器,并将模型参数更新上传至云端服务器;云端服务器聚合边缘模型参数,从而更新全局生成器和判别器模型;s4、重复边缘和云服务器的交互过程,直至云端的全局生成器生成可用的数据。

6.优选的,所述s1步骤包括:s101、由一个云端服务器和多个边缘服务器组成云-边联邦生成对抗网络结构;

s102、每一个边缘服务器和其边缘网络下对应的多个终端设备组成边缘网络结构。

7.优选的,所述s2步骤包括:s201、终端设备使用满足条件的本地化差分隐私机制生成本地扰动数据;s202、终端设备上传扰动后的数据至边缘服务器;s203、边缘服务器聚合来自多个终端的扰动数据集并解码,构建一个用于联邦训练的隐私保护边缘数据集。

8.优选的,所述s3步骤包括:s301、云端服务器向所有边缘服务器发送初始化生成器和判别器模型;s302、在每一轮联邦学习通讯过程中,云端服务器选择一部分边缘服务器按固定步长训练本地生成器和判别器,并将模型参数更新上传至云端服务器;s303、云端服务器聚合接受到的边缘模型参数更新,求出全局参数更新以更新全局生成器和判别器模型;s304、云端服务器再将更新后的全局模型发送至所有边缘服务器,边缘服务器使用新的全局模型替换s302步骤中训练的本地模型。

9.优选的,所述s4步骤包括:s401、重复执行s302-s304步骤的联邦学习通讯过程,设定期望的通讯轮数或全局生成器合成数据的质量;s402、当联邦生成对抗网络达到指定的联邦学习通讯轮数或云端全局生成器合成数据的质量,停止联邦学习通讯,在保障终端数据隐私的同时,生成可用的数据。

10.本发明通过改进在此提供一种面向联邦生成对抗网络的隐私增强方法,与现有技术相比,具有如下改进及优点:本发明利用边缘服务器聚合边缘网络下的终端隐私数据,减轻了联邦生成对抗网络对终端设备计算能力和通讯能力的严格要求;在不损失边缘模型本地梯度精度的情况下,有效抵抗攻击者对边缘服务器的梯度泄漏攻击;可以在生成高质量合成数据的同时有效地维护客户端数据隐私。

附图说明

11.下面结合附图和实施例对本发明作进一步解释:图1为本发明实施例提供的面向联邦生成对抗网络的隐私增强方法的流程图;图2为本发明实施例提供的联邦生成对抗网络系统图;图3为本发明实施例提供的客户端原始数据隐私保护效果图;图4为本发明实施例提供的边缘服务器本地训练规则图;图5为本发明实施例提供的联邦生成对抗网络合成数据效果图。

具体实施方式

12.下面对本发明进行详细说明,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施

例,都属于本发明保护的范围。

13.本发明通过改进在此提供一种面向联邦生成对抗网络的隐私增强方法,本发明的技术方案是:如图1所示,一种面向联邦生成对抗网络的隐私增强方法,包括以下步骤:s1、在物联网场景下搭建以云服务器为中心的云-边联邦生成对抗网络,搭建以边缘服务器为中心的边-端网络,确定云-边网络路由和边-端网络路由;s2、通过本地化差分隐私技术保护终端原始数据,将扰动数据发送至边缘服务器;边缘服务器端聚合扰动数据并解码,构建边缘数据集;s3、云端服务器向边缘服务器发送初始化生成器和判别器模型;边缘服务器按固定步长训练本地生成器和判别器,并将模型参数更新上传至云端服务器;云端服务器聚合边缘模型参数,从而更新全局生成器和判别器模型;s4、重复边缘和云服务器的交互过程,直至云端的全局生成器生成可用的数据。

14.本实施例中,来自终端设备的原始数据是隐私性最高的数据,因此针对联邦生成对抗网络的隐私保护任务包括终端设备数据隐私和边缘模型隐私,具体涉及以下三部分:终端设备:终端设备数据是联邦训练数据的来源也是整个联邦学习过程中隐私风险最高的部分,一般的联邦学习在终端设备上直接训练本地数据,然而设备不同的计算能力和通讯能力会导致训练效果难以达到预期。因此,必须保障终端设备的隐私,并提供一个较稳定的计算力保证。

15.边缘服务器:边缘设备具有一定的存储能力和较为稳定的计算能力,在边缘设备上收集对应终端隐私保护后的数据,并利用这些隐私数据训练边缘本地的生成器和判别器模型。在联邦学习的每轮通讯中,所有边缘服务器接受上一轮的全局模型做为本地模型,被选中的边缘服务器参与全局模型训练。

16.云端服务器:云端服务器聚合并平均接收到的边缘服务器的隐私保护参数更新以更新全局模型,并返回至边缘服务器,在达到指定的联邦学习通讯轮数或期待的合成数据质量后,云端服务器用全局生成器生成高质量的合成数据。

17.在本实施例中,上述步骤s1步骤包括s101~s103:s101、由一个云端服务器和多个边缘服务器组成云-边联邦生成对抗网络结构。云端服务器搭建出多个分布式联邦学习网络,对每个边缘服务器编号。该网络下的边缘服务器有较好的存储能力、通信能力和计算能力。为了避免边缘服务器的合谋和窜通等恶意操作,不设立边缘服务器与边缘服务器之间的通信信道,只构建独立的云端服务器与边缘服务器的通信信道;s102、每一个边缘服务器和其边缘网络下对应的多个终端设备组成边缘网络结构。边缘服务器搭建出一个分布式边缘网络,对每个终端设备编号,该网络下的设备可能计算能力不同、数据结构不同、带宽能力不同等。同样的,为了保护终端设备隐私和避免终端设备的合谋,不设立彼此间的通信信道,只构建独立的边缘服务器与终端设备的通信信道。本实例中的网络结构如图2提供的联邦生成对抗网络系统图所示,云端与边缘服务器的独立交互、边缘服务器与终端设备的独立交互。

18.在本实施例中,上述步骤s2步骤包括s201~s203:s201、终端设备使用满足条件的本地化差分隐私机制生成本地扰动数据。尽管联

邦学习可以保证终端设备原始数据的隐私,但对本地模型的梯度泄露攻击依然会泄露部分隐私信息。终端设备的构成复杂,比如个人电脑、智能手机、传感器和穿戴设备等,其无法保证这些设备的计算力具备训练本地模型的能力。因此,将终端设备的数据在保证隐私的前提下发送至边缘设备,以确保联邦生成对抗网络训练的计算力要求;需要进一步说明的是,边-端网络中的终端设备数据属于分布式的结构,一般的中心化隐私保护方法无法作用于分布式设备。为了从源头上保护终端设备的敏感数据,需要在数据离开设备之前扰动原始数据,使收集到的数据其不再具备敏感性。

19.关于差分隐私模型:当数据集d包含关于alice的私人信息的记录时,设置一个任意的查询操作f,如计数、求和、平均值、中位数等,得到的结果是f(d)。如果随机算法m在d中处理的查询结果与只有一处不同的邻接数据集d'中的结果相同,那么可以认为alice的真实信息没有被识别。随机算法m通过随机化输出结果提供隐私保护,在数据集的真实值中加入与差分隐私分布一致的噪声,以保护数据集的隐私。其定义如下:给定,一个随机机制m满足-差分隐私,当且仅当对于两个相邻的数据集d和d',对于所有m的可能输出s,有:本地化差分隐私(local differential privacy,ldp)作为差分隐私的一个变体,实现了分布式数据结构的隐私保护,并且不依赖可信的服务器即可实现数据的聚合解码。其定义如下,给定对于任意算法m,当任意两条记录x和x'输出相同的结果x

*

如果满足:则该算法m满足。本地化差分隐私通过添加人工噪声确保终端设备本地的任意两条记录输出的似是而非性来保护本地的每条记录隐私,将隐私保护的过程从边缘数据收集器转移到终端设备本地,避免数据收集过程中泄露。ldp有多种实现添加噪声的机制,比如rappor、olh、拉普拉斯机制等。在本实例中,联邦生成对抗网络收集和生成的是图像数据,高斯机制更适用于图像数据中。

20.高斯机制是在精确查询结果中加入高斯分布的噪声,以实现差分隐私的隐私保护,并通过非严格的隐私保护进行放松。其中两个参数和是常数。高斯机制的定义如下:假设有一个函数f,其灵敏度为。一个随机算法m=f(d) n提供-差分隐私,其中是服从高斯分布的随机噪声,尺度参数。其中敏感性衡量查询函数f(d)和f(d')之间的最大距离,有:。

21.终端设备在本地部署本地化差分隐私保护机制,根据对应的边缘服务器预先设置的隐私保护参数,扰动原始数据。扰动后的数据不再具备原始数据的特征,查询其任意两条本地数据输出类似的结果,从而无法推断出具体数据信息。

22.在本实例中,选择不同的隐私保护参数会对后续的整个联邦生成对抗网络的训练结果造成影响。较小的隐私预算会带来更多的噪声,使保护后的数据敏感性降低而数据

可用性也随之降低;较大的隐私预算添加的噪声数量较小,对原始数据的隐私保护程度不够,导致隐私泄露的风险。如图3提供的本实例原始数据隐私保护效果图,当为0.1时,过量的噪声导致数据效用下降,当为0.9时添加的噪声不足以提供充足的隐私保护。

23.s202、终端设备上传扰动后的数据至边缘服务器而不是原始本地数据集。由于终端设备计算力的不同,以及作为数据源的高敏感性使得本地训练代价较高。每个边缘服务器对应的终端设备处理在一个周期内生成的数据,在设备本地执行给定隐私保护预算的本地化差分隐私编码工作。

24.完成编码后原始数据的扰动报告发送给对应的边缘服务器,此步骤确保了终端设备没有离开设备,并保证了离开设备的扰动报告难以泄露隐私信息。

25.s203、边缘服务器聚合来自多个终端的扰动数据集并解码,构建一个用于联邦训练的隐私保护边缘数据集。边缘服务器收集边缘网络内所有终端设备的扰动报告,并在服务器中存储这些扰动报告。根据从云端服务区获得隐私预算和其他本地化差分隐私参数,解码这些扰动报告,使数据其具有可用性。

26.在边缘服务器端重构隐私数据集包含了对应网络的所有终端设备数据,其满足了给定的差分隐私的隐私保障,但同样的也损失了一定的数据效用。使用这些数据训练本地模型可能会导致训练结果不如真实数据。此步骤构造了用于联邦学习的边缘隐私数据集,即便攻击者对边缘服务区发起攻击,也只能获取隐私保护后的扰动报告而无法了解终端真实数据的具体值。

27.本实例选择手写数字识别数据集mnist,包含60,000个训练示例和10,000个28乘28尺寸的灰度手写数字图像的测试示例。目前深度学习中的神经网络种类繁多用途各不相同,在本实例中使用深度卷积神经网络(convolutional neural network (cnn))。深度卷积神经网络主要用于处理深度学习任务中的图像分类、目标识别等。在本实施例中用到的硬件参数为amd

®ꢀ

ryzen

®ꢀ

r9-5950x 16核心32线程3.4 ghz cpu以及12 gb nvidia rtx 3080ti gpu,编程环境为64gb内存,ubuntu 20.04.5,python 3.8,以及cuda 11.5版本的pytorch 1.9。

28.在本实例中,上述步骤s3包括s301~s304:s301、云端服务器向所有边缘服务器发送初始化生成器和判别器模型。本实例使用的联邦生成对抗网络隐私保护系统图如图2所示。在云端服务器正式开始联邦学习任务之前,初始化全局生成器和判别器模型,将初始化模型发送至边缘网络中的全部边缘服务器,用作边缘服务器的初始化本地模型。

29.联邦学习的分布式训练规则无需收集训练数据,只接受本地模型训练的更新,从而解决了数据孤岛的问题并提供了隐私保护能力。其中,本实例中的联邦学习定义如下:有n个参与者各自持有本地训练数据集d1,d2,...,dn。在联邦学习中,每个参与者合作训练全局模型,而不把本地数据di暴露给第三方。参数服务器将n参与者发送的权重汇总为,其中wi是第i个参与者上传的参数,pi是本地数据集占总数据集的比例。该模型通过最小化损失函数得到。公式如下。

30.其中li(wi)是第i个参与者本地模型的输出结果,y是真实训练标签。

31.在本实例中,为了训练联邦生成对抗网络,根据生成式对抗网络的定义,将边缘服务器的本地训练模型设置为生成器和判别器模型。生成式对抗网络是一个无监督的生成模型,其中生成器g用于生成给定随机噪声向量的合成数据,而判别器d用于区分真实数据和生成器的合成数据。学习过程可以被看作是两个网络之间的v(d,g)最小化博弈,其定义如下。

32.其中pz(x)是先验输入噪声变量,p(x)是真实训练数据。d的输出值在[0,1]区间内,它的值越接近1,说明生成的样本与真实样本越相似。这个博弈过程期望最小化kl(kullback-leibler)散度,最大化生成分布和真实样本分布之间的js(jensen-shannon)散度。然而,kl发散是一个不对称的度量,导致无法生成真实样本,这是一个巨大的惩罚。在这种情况下,生成器会生成更多重复但“安全”的样本,而不是多样化的样本,这也被称为模型崩溃。

[0033]

本实例中使用wasserstein generative adversarial network

ꢀ‑ꢀ

gradient penalty (wgan-gp)通过直接约束批判者的输出相对于其输入的梯度规范,并对随机样本的梯度规范施加惩罚,考虑了该约束的软版本。随机样本的梯度惩罚放宽了梯度约束,有利于联邦学习框架中梯度更新的传输。因此,本实例选择wgan-gp作为联邦学习中的生成式对抗网络。

[0034]

s302、在每一轮联邦学习通讯过程中,云端服务器选择一部分边缘服务器按固定步长训练本地生成器和判别器,并将模型参数更新上传至云端服务器。由于生成式对抗网络计算量和参数量庞大,即便使用具备一定计算能力带宽的边缘服务器上传参数,也会消耗过多的资源。一般的,在联邦学习每一轮训练过程中,随机选择一部分的参与者本地训练;在本实例中,设置边缘服务器数量为20,随机选择参与者的比例为0.5,即每轮联邦学习的训练随机选择10个边缘客户端本地训练。进一步,将边缘服务器的本地批训练大小设置为32,设定生成器训练步长为5,即在本地批训练中每完成5次判别器模型训练后,训练一次生成器模型。本实例中边缘服务器的本地训练规则如图4所示。

[0035]

本地生成器g输入随机样本,生成合成数据集z,判别器d输入扰动数据集和合成数据,输出合成数据集的真伪性。在这个过程中,g期望生成高质量的合成数据,使其数据分布接近扰动数据;d则期望尽可能地判别出合成数据的真伪性。在完成本地训练之后,边缘服务器同时将生成器和判别器模型的参数上传至云端服务器。

[0036]

s303、云端服务器聚合接受到的边缘模型参数更新,求出全局参数更新以更新全局生成器和判别器模型。云端服务器在联邦学习的每一轮训练中,接受来自选中参与者的参数更新。在本实例中,云端服务器将被选中的10个参与者的参数聚合,通过权重计算公式加权平均这些权重。从而计算得到该轮联邦学习练中的全局生成器和判别器模型;

s304、云端服务器再将更新后的全局模型发送至所有边缘服务器,边缘服务器使用新的全局模型替换s302步骤中训练的本地模型。云端服务器将新的全局生成器和判别器模型发送至所有边缘服务器而不是上一轮的参与者,在本实例中如图2所示,云端服务器与边缘服务器的交互过程,将全局模型发送给所有边缘服务器。

[0037]

至此,一个通讯周期的联邦学习完成。接下来,返回到步骤s302,云端服务器继续随机选择10个参与者,被选中的边缘服务器用获得的新的全局模型开始新的本地生成器和判别器模型训练。训练完成后,执行步骤s303至s304,在给定的联邦学习通讯轮数内或达到期望的合成数据质量前,不停地重复s302至s304步骤。

[0038]

在本实例中,上述步骤s4包括s401~s402:s401、重复执行s302-s304步骤的联邦学习通讯过程,设定期望的通讯轮数或全局生成器合成数据的质量。联邦生成对抗网络的模型收敛不同于一般的联邦学习训练过程,在到达指定轮数后如果生成器和判别器的损失趋近稳定且不再有减小的趋势,则达到了收敛的效果。或是设置合成数据质量衡量指标如fid等,当合成数据的质量非常接近于原始数据时,则停止继续训练。在本实例中,制定了具体的联邦学习通讯轮数,观察在某一轮数下的合成数据质量以及隐私保护效果。

[0039]

s402、当联邦生成对抗网络达到指定的联邦学习通讯轮数或云端全局生成器合成数据的质量,停止联邦学习通讯。从而实现在保障终端数据隐私的同时,生成可用的数据。

[0040]

在本实例中,设置联邦生成对抗网络的总通讯轮数为1000次,取250、500、750、1000次的全局生成器模型,生成部分合成数据。本实例提供的联邦生成对抗网络合成数据效果图如图5所示。随着全局联邦训练的轮数增多,全局生成器合成数据的质量也随之增加,合成的数据具有可用性。

[0041]

在本实施例中,用于训练的mnist数据集包含原始图像信息,如果不对原始数据,会导致联邦训练过程中发生隐私信息泄露,如果只对梯度更新隐私保护,则有可能推断出模型的具体参数从而泄露隐私。因此本发明实施例中提到的原始数据隐私保护是有必要的。从以上结果可知,面向联邦生成对抗网络,本发明提出的方法可以有效的增强各阶段的隐私保障,对保护个人隐私具有一定的现实以及未来意义。

[0042]

上述说明,使本领域专业技术人员能够实现或使用本发明。对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所公开的原理和新颖特点相一致的最宽的范围。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。