1.本发明涉及神经网络剪枝技术领域,具体涉及一种基于特征知识的卷积核重利用剪枝方法。

背景技术:

2.随着人工智能的蓬勃发展,深度神经网络已经深入到各行各业中。而其中卷积神经网络(cnn)广泛应用于计算机视觉应用,包括行人检测和车辆检测,目标分类和目标定位,以及视频分类这些领域中,有许多像这样的研究方向集中在只有少量精细筛选训练数据的专业领域。在这些情况下,通过对先前在更大的有标记视觉数据集上训练的现有深度神经网络进行微调,例如来自imagenet的图像或来自sports-1m的视频,可以显著提高精度和效果。从只有十五亿参数的gpt-2发展到拥有一千七百五十亿参数模型的gpt-3,人们已开始发现了由模型规模的扩大以及训练对象数量的增多等原因所产生出的巨大可观的收益,其中最具关键意义的技术特点之一便是模型对标注数据的直接依赖性已明显地减少,这也让目前许多标注数据相对匮乏的应用场景中也开始可以直接使用市场上一些性能较为强劲的ai仿真模型,为未来ai模型的进一步大量的产业化和使用也扫除出了阻碍。虽然这种形式的迁移学习可以提供各个目标任务最顶尖的准确性,但由于这些神经网络大多数都是重量级架构,所以这类网络在推理或精细调优时所需要的时间、硬件以及内存代价很高,在很多时候无法进行实际部署,从而导致了高精度网络无法应用在实际场景的情况。与此同时,构建一个高性能的轻量级神经网络也就有了重要意义。在上述研究背景下,神经网络模型压缩这项技术由此而生。深度神经网络的部署问题主要来源于模型的计算量、模型的推理速度和模型大小的问题。最近的研究表明cnn具有有效的和不重要的过滤器,但是这项技术在很多场景下带来的是不可避免的精度下降问题,该问题成为了神经网络压缩领域中主要攻克的难关和探索点之一。

技术实现要素:

3.本发明旨在针对现有技术的技术缺陷,提供一种基于特征知识的卷积核重利用剪枝方法,以解决常规剪枝方法在精度和压缩率等方面有待改善的技术问题。

4.为实现以上技术目的,本发明采用以下技术方案:

5.一种基于特征知识的卷积核重利用剪枝方法,该方法利用神经网络剪枝中被丢弃的卷积核的特征知识,对剪枝后的网络结构进行重参数化并微调。

6.作为优选,该方法包括:通过熵度量卷积核之间的相似度,通过互信息将被移除卷积核与保留卷积核进行配对,再利用熵建模自适应加权公式,将配对卷积核进行重参数化,以重利用被移除卷积核的特征信息。

7.作为优选,该方法还包括:通过掩码和预留网络参数,在剪枝的过程中模拟压缩后架构推理过程,并且在微调的过程中利用预留网络参数和反向传播对剪枝剪去的滤波器进行更新。

8.作为优选,该方法包括以下步骤:

9.步骤1):对于给定的待压缩神经网络m,设定网络剪枝率v;

10.步骤2):依据卷积核级别的神经网络剪枝算法,将网络m中卷积层进行重要性排序;

11.步骤3):当步骤2)得到c个排序后的卷积核后,按照剪枝率v将卷积核分为被移除卷积核组wd和保留的卷积核组w

l

;

12.步骤4):在步骤3)中的得到两个卷积核组,计算wd和w

l

中两两之间的互信息量,选择互信息量最大的k个卷积核对group;

13.步骤5):对步骤4)中的group,基于卷积核之间的熵信息计算自适应参数α;具体的自适应参数公式为:

[0014][0015]

其中β和γ以及b是固定超参数,用于控制公式的缩放力度和偏移量;

[0016]

步骤6):将步骤4)中的α带入重参数化公式中,具体的重参数化公式为:

[0017]wl

′

=αw

l

(1-α)wd[0018]

其中w

l

′

为重参数化后的卷积核,wd和w

l

为步骤3)中得到的卷积核组;以此得到重参数化后的w

l

′

,并替换w

l

;

[0019]

步骤7):神经网络参数乘以掩码数组mask,将选定的被移除卷积核参数至0,其余参数不变,以实现模拟剪枝的效果;

[0020]

步骤8):将步骤7)中得到的网络,进行重训练,得到微调后的网络m1;通过网络参数与反向传播将wd更新为非零,由此完成一轮算法得到结果网络。

[0021]

本发明利用神经网络剪枝中被丢弃的卷积核的特征知识,对剪枝后的网络结构进行重参数化并微调,不仅实现了对特征信息的重利用以实现精度回升,并且保证了优化后的神经网络结构依旧是压缩后的网络结构,达成了网络结构与精度双优化的效果。首先该方法通过熵度量了卷积核之间的相似度,通过互信息将被移除卷积核与保留卷积核进行配对,再利用熵建模了自适应加权公式,将配对卷积核进行重参数化,以重利用被移除卷积核的特征信息,能够在神经网络剪枝的前提下起到精度回升作用。接着使用一种维护性能的剪枝微调方法。该方法通过掩码和预留网络参数,在剪枝的过程中实现模拟压缩后架构推理过程的同时能够保留原模型的结构,并且在微调的过程中利用预留网络参数和反向传播对剪枝剪去的滤波器进行更新,完善了维护性能的剪枝微调方法,不断更新被移除滤波器的特征信息。

[0022]

本发明提出的方法中主要包含一种基于特征知识的卷积核重利用剪枝算法。该算法在训练的精度以及压缩率上,都达到了最优。

[0023]

与现有方法相比,本发明具有以下突出优点:

[0024]

第一,基于广泛的统计验证,我们实证证明,神经网络剪枝将会对神经网络特征信息造成损伤,对有效信息覆盖率大的网络造成的精度损失相对较大。

[0025]

第二,据我们所知,神经网络剪枝后利用被移除卷积核进行精度提升首次被引入剪枝社区,可以轻松地融入大多数现有卷积核级剪枝算法中,以实现精度回升。

[0026]

第三,我们介绍了一种新的剪枝优化方法,通过剪枝后的卷积核重参数化过程。

具体实施方式

[0027]

以下将对本发明的具体实施方式进行详细描述。为了避免过多不必要的细节,在以下实施例中对属于公知的结构或功能将不进行详细描述。以下实施例中所使用的近似性语言可用于定量表述,表明在不改变基本功能的情况下可允许数量有一定的变动。除有定义外,以下实施例中所用的技术和科学术语具有与本发明所属领域技术人员普遍理解的相同含义。

[0028]

一种基于特征知识的卷积核重利用剪枝方法,该方法包括以下步骤:

[0029]

步骤1):对于给定的待压缩神经网络m,设定网络剪枝率v;

[0030]

步骤2):依据卷积核级别的神经网络剪枝算法,将网络m中卷积层进行重要性排序;

[0031]

步骤3):当步骤2)得到c个排序后的卷积核后,按照剪枝率v将卷积核分为被移除卷积核组wd和保留的卷积核组w

l

;

[0032]

步骤4):在步骤3)中的得到两个卷积核组,计算wd和w

l

中两两之间的互信息量,选择互信息量最大的k个卷积核对group;

[0033]

步骤5):对步骤4)中的group,基于卷积核之间的熵信息计算自适应参数α;具体的自适应参数公式为:

[0034][0035]

其中β和γ以及b是固定超参数,用于控制公式的缩放力度和偏移量;

[0036]

步骤6):将步骤4)中的α带入重参数化公式中,具体的重参数化公式为:

[0037]wl

′

=αw

l

(1-α)wd[0038]

其中w

l

′

为重参数化后的卷积核,wd和w

l

为步骤3)中得到的卷积核组;以此得到重参数化后的w

l

′

,并替换w

l

;

[0039]

步骤7):神经网络参数乘以掩码数组mask,将选定的被移除卷积核参数至0,其余参数不变,以实现模拟剪枝的效果;

[0040]

步骤8):将步骤7)中得到的网络,进行重训练,得到微调后的网络m1;通过网络参数与反向传播将wd更新为非零,由此完成一轮算法得到结果网络。

[0041]

本发明的效果通过以下仿真实验作进一步的说明。

[0042]

1、仿真条件

[0043]

本发明在gtx 1080ti gpu环境上进行开发,开发的深度学习框架基于pytorch。本发明中主要用的语言为python。

[0044]

2、仿真内容

[0045]

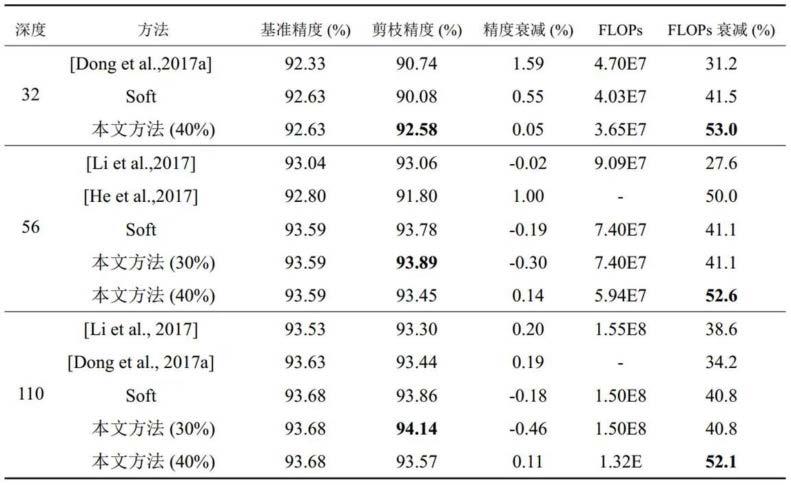

我们在cifar10以及cifar100数据集上进行仿真,cifar-10数据集由10类32x32的彩色图片组成,一共包含60000张图片,每一类包含6000图片。其中50000张图片作为训练集,10000张图片作为测试集。cifar-10数据集被划分成了5个训练的batch和1个测试的batch,每个batch均包含10000张图片。测试集batch的图片是从每个类别中随机挑选的1000张图片组成的,训练集batch以随机的顺序包含剩下的50000张图片。不过一些训练集batch可能出现包含某一类图片比其他类的图片数量多的情况。训练集batch包含来自每一类的5000张图片,一共50000张训练图片。表1为在cifar10上的结果。cifar-100数据集与

cifar-10数据集相似,不同的是他由100个类所组成,每个类包含600个图像,其中有500张是训练集图片和100张测试集图片。cifar-100中的类别是由超类所组成的,详细来说每个类有一个细标签和一个粗标签,细标签代表着该图片所在的类,粗标签代表着该图片所在的超类,该数据集一共有20个超类,每个超类有五个细标签,这样便组成了100个类。cifar-100由于含有较多的类别,训练速度相对于cifar-100较慢,带来的结果的信服度也会相对较高。表2为在cifar100上的结果。可以发现,相比于其他的方法,本发明的精度更高。

[0046]

表1本发明与其余剪枝方法在cifar-10数据集上的比较

[0047][0048]

表2本发明与其余剪枝方法在cifar-100数据集上的比较

[0049][0050]

以上对本发明的实施例进行了详细说明,但所述内容仅为本发明的较佳实施例,并不用以限制本发明。凡在本发明的申请范围内所做的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。