1.本发明属于遥感影像识别技术领域,具体涉及一种遥感图像小样本场景分类方法,可用于自然灾害检测、城市规划、环境监测、植被制图及土地覆盖分析。

背景技术:

2.遥感是远距离获取目标信息的一种探测技术,随着遥感技术的快速发展,遥感图像在军事和民用领域都发挥着越来越重要的作用。场景分类根据图像内容将每个遥感图像划分为不同的场景类别,是理解遥感图像的重要手段,其在自然灾害检测、城市规划、环境监测、植被制图、土地覆盖分析等领域有广泛应用前景。

3.在深度学习引起注意之前,场景分类模型主要通过可以实际应用于提取图像的底层特征和中层特征来进行分类,并基于这些特征进行编码操作。近年来,基于大量可用的数据集的出现、机器学习理论的进步以及可用计算资源的增加,深度学习模型显示出了强大的能力学习。其中卷积神经网络是图像处理中最主流的深度学习模型之一,在场景分类领域中也是使用最多且性能最好的一种网络模型。

4.然而,基于深度学习的遥感图像场景分类存在两个基本问题。一是模型依赖于大量的标记训练样本,而获取人工标注的高分辨率遥感图像是非常困难和耗时的,如果可用的标记数据不足,深度学习模型就会有过拟合的风险从而导致性能下降。二是深度神经网络可以对已经训练过的的场景类别的测试样本进行较高的准确率预测,但在面对训练阶段从未见过的类别样本时,模型则很难对其进行分类。

5.在这种背景下,关于小样本遥感图像场景分类的研究受到了广泛关注。小样本学习是受人类快速学习能力的启发出现的一个新的研究方向,它使机器视觉系统能够从有限的注释数据中快速学习新的任务。许多现有的小样本学习模型专注于设计不同的架构。比如基于度量学习的小样本方法通过设计不同的结构与度量方式,来寻找一个最优的度量空间,基于元学习的方法则是通过设计元学习器来指导学习算法,希望模型就可以快速地泛化到一个新任务中。

6.li在论文《dla-matchnet for few-shot remote sensing image scene classification》中提出了一种深度小样本学习遥感场景分类方法。该方法通过设计自适应判别学习匹配网络,采用注意力机制与特征融合方案,将通道注意模块和空间注意模块与特征网络相结合,提高了特征表示能力。但该方法由于将图像提取为一个紧凑的图像级表示,导致丢失了大部分的判别信息,特别是当训练样本的数量较少时,这种损失很难恢复,影响最终分类结果。

7.高峰在申请号为202111495585.5的专利文献中提出了一种《基于双原型网络的遥感图像小样本场景分类方法》,该方法设计了“原型自校准”和“原型互校准”两种操作,在训练过程中使得原型更加具有代表性,更有利于后续基于原型的分类预测,但该方法由于没有深度提取遥感图像的层次特征,容易受到复杂背景、尺度变换这些信息的干扰,导致分类精度下降。

技术实现要素:

8.本发明的目的在于针对上述现有技术中的不足,提供一种基于多尺度双流架构的遥感图像小样本场景分类方法,以减少图像判别信息的丢失,避免复杂背景和物体尺度剧烈变化对场景分类的影响,提高分类精度。

9.为实现上述目的,本发明的技术方案包括如下:

10.(1)从公开网站获取三个不同的遥感图像数据集,对数据集中的图像依次进行裁剪、随机水平翻转、随机亮度增强、随机色彩增强和随机对比度增强的预处理;

11.(2)对预处理后的数据集随机采样,获得训练支持集s1与训练查询集t1,验证支持集s2与验证查询集t2,测试支持集s3与测试查询集t3;

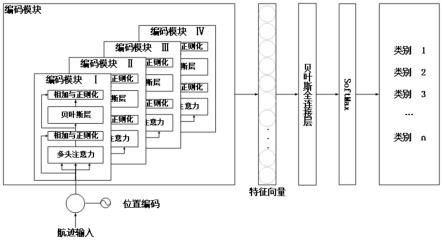

12.(3)构建整体双流网络:

13.3a)建立由注意力深度嵌入模块a、类别相关注意力模块b和度量模块c连接构成的全局流网络;

14.3b)选用现有的原型网络作为局部流网络;

15.3c)建立由向量构建操作和贪婪边界搜索组成的的关键区域定位模块;

16.3d)将全局流网络和局部流网络通过关键区域定位模块连接,得到整体双流网络;

17.(4)利用训练支持集s1与训练查询集t1,通过小样本情景训练方法对整体双流网络进行训练,得到训练后的双流网络;

18.(5)将输入验证支持集s2与验证查询集t2输入到训练后的双流网络进行网络参数微调,保存指标最高的网络作为最优双流网络模型;

19.(6)将测试支持集s3与测试查询集t3输入到最优双流网络模型,得到最终分类结果。

20.与现有技术相比,本发明至少具有如下一种或多种技术效果:

21.1.本发明由于构建了一个双流网络,分别从整个图像和最重要区域计算样本所属类别的概率,减少了图像判别信息的丢失和物体尺度变化的影响。

22.2.本发明通过设计类别相关注意力模块得到场景类别相关的注意力特征图,可以在度量过程中增加描述子的权重,减少背景信息对场景分类的干扰。

23.3.本发明通过设计关键区域定位来得到图像的关键性区域,能够快速定位全局图像中信息量最大的区域,同时能够连接全局流与局部流,以便于突出有利于场景分类的重要物体。

24.实验结果表明本发明与现有的其他方法相比具有更好的场景分类精度。

附图说明

25.图1是本发明的实现总流程图;

26.图2为本发明中类别相关注意力模块计算输出注意力特征图m的子流程图;

27.图3为本发明中建立关键区域定位模块的子流程图。

具体实施方式

28.以下结合附图对本发明的具体实施例和效果做进一步详细描述。

29.参照图1,本发明的实现步骤如下:

30.步骤1,获取遥感图像数据集,并对其进行数据预处理:

31.从公开网站获取三个不同的遥感图像数据集,将数据集中的图像裁剪至224

×

224,再对裁剪后的图像依次进行随机水平翻转、随机亮度增强、随机色彩增强和随机对比度增强的预处理,得到预处理后的遥感图像。

32.步骤2,对预处理后的数据集随机采样获得支持集与查询集。

33.对预处理后的数据集随机采样,获得训练支持集s1与训练查询集t1,验证支持集s2与验证查询集t2,测试支持集s3与测试查询集t3,具体实现如下:

34.2.1)对预处理后的三个不同的遥感图像数据集分别进行划分,即将nwpu-resisc45数据集按25:10:10的比例划分为训练集、验证集、测试集,将whu-rs19数据集按9:5:5的比例划分为训练集、验证集、测试集,将uc-merced数据集按10:6:5的比例划分为训练集、验证集、测试集;

35.2.2)分别从各数据集的训练集中随机选取c个类别,每个类别随机采样k张图像,由这c

×

k张图像构成训练支持集s1,同时在这c个类别剩余图像的每个类别中等量随机选择n张图像,构成训练查询集t1;

36.2.3)从各数据集的验证集中随机选取c个类别,每个类别随机采样k张图像,由这c

×

k张图像构成验证支持集s2;再在这c个类别剩余图像的每个类别中等量随机选择n张图像,构成验证查询集t2;

37.2.4)从各数据集的测试集中随机选取c个类别,每个类别随机采样k张图像,由这c

×

k张图像构成测试支持集s3,在这c个类别剩余图像的每个类别中等量随机选择n张图像,构成测试查询集t3。

38.步骤3,构建整体双流网络。

39.3.1)建立全局流网络:

40.3.1.1)建立由一个卷积层、四个卷积块、平均池化层、通道数为128的1

×

1卷积层级联构成的注意力深度嵌入模块a;该卷积层由通道数为64的7

×

7卷积滤波器和3

×

3的最大池化操作组成,每个卷积块都由4个3

×

3卷积滤波器组成,每两个卷积滤波器后添加一个跳连接操作,第一卷积块通道数为64,第二卷积块通道数为128,第三卷积块通道数为256,第四卷积块通道数为512;

41.3.1.2)建立类别相关注意力模块b,用于计算输出注意力特征图m:

42.参照图2,该类别相关注意力模块b的具体计算如下:

43.输入特征分别经过权重为wg的全连接层得到压缩特征fg(xj),经过权重为wk的全连接层和softmax函数得到全局注意力特征图fk(xj);

44.对压缩特征fg(xj)和全局注意力特征图fk(xj)进行加权求和,并将其结果依次通过一个权重为的全连接层、relu激活函数、一个权重为的全连接层和sigmoid函数,得到权重向量di:

[0045][0046]

其中,δ表示relu激活函数,σ表示sigmoid激活函数,和均为全连接网络的权重,分别用于按比例缩减特征图维度和扩张特征图维度,n表示特征图像素的总数,fg(xj)

=wg·

xj是压缩特征,fk(xj)=softmax(wk·

xj)是计算沿着像素点j的注意力特征图,表示矩阵乘法;

[0047]

将权重向量di与输入特征点积加和后,再经过sigmoid函数进行非线性激活,获得该模块最终输出m(x):

[0048]

m(x)=sigmoid(∑d

ifi

)

[0049]

其中,fi代表输入的第i个通道的特征。

[0050]

3.1.3)建立度量模块c,用于计算输出给定查询图像q到类c之间的相似性其实现如下:

[0051]

对每个描述子xi,先在类c中找到它的k个最近邻再计算xi与每个之间的相似度;

[0052]

利用注意力图对描述子的相似度进行加权求和,得到给定查询图像q到类c之间的相似性

[0053][0054][0055]

其中,m(xi)表示注意力特征图在xi位置处的响应值,xi代表q的第i个描述子,m表示描述子的总数,表示xi在类c中的第j个最近邻,cos(

·

)表示两个向量之间的余弦相似度,这里也可以使用其他距离函数;

[0056]

3.1.4)将类别相关注意力模块b的输入端与注意力深度嵌入模块a的第二卷积块输出端相连,再将类别相关注意力模块b的输出端和注意力深度嵌入模块a的最后一个1

×

1卷积层输出端同时连接到度量模块c,度量模块c的输出即为全局流网络的输出。

[0057]

3.2)选用现有的原型网络作为局部流网络,输入查询图像与支持图像的关键区域,得到查询图像关键区域所属类别的概率,实现如下:

[0058]

3.2.1)将输入的支持集图像关键区域与查询集图像关键区域送入resnet18网络进行特征提取,分别得到支持样本特征f

φ

(xi)和查询样本特征f

φ

(xq),利用支持样本特征f

φ

(xi)计算支持集中类别为k的特征的原形表示ck:

[0059][0060]

其中sk代表支持集中类别为k的数据集合,x表示sk中的样本,y为其对应的类别,ck即类别k的原形表示,是该类别的支持集中的所有嵌入特征的平均值;

[0061]

3.2.2)计算查询图像的嵌入特征f

φ

(xq)与类别k原型表示ck之间的距离,得到查询图像xq属于类别k的概率为:

[0062][0063]

其中d(

·

)表示距离函数,ck′

表示类别k

′

的原型表示。

[0064]

3.3)建立关键区域定位模块,得到注意力特征图m的关键区域坐标b=[xa,xb,ya,yb],参照图3,该关键区域定位模块构建如下:

[0065]

3.3.1)进行向量构建操作,即沿着空间的高度和宽度方向,将注意力特征图聚合为两个一维结构能量向量:

[0066][0067]

其中,是沿着宽度方向聚合得到的能量向量,是沿着高度方向聚合得到的能量向量,m代表得到的注意力特征图,m(i,w)表示特征图m位于(i,w)位置处的值,m(h,j)表示特征图m位于(h,j)位置处的值,h表示总高度,w表示总宽度;

[0068]

3.3.2)将一维能量向量进行贪婪边界搜索定位到最重要的一维区域,得到关键区域边界框的坐标点b=[xa,xb,ya,yb]:

[0069]

以计算关键区域的宽度边界[xa,xb]为例,贪婪式边界搜索的实现步骤为:

[0070]

首先,初始化特征图的宽度坐标x1和x2,并定义关键区域为占据面积最小且包含的能量不小于总能量比例为e

tr

的区域,即e

[x1,x2]

/e

[0:w]

>e

tr

,其中e

tr

表示能量占比的超参数,表示宽度向量vw中所有元素的能量之和,表示从空间宽度x1到x2的区域的能量之和;

[0071]

接着,迭代调整[x1,x2]的边界,使其能量收敛到e

tr

附近:当比值高于e

tr

时,[x1,x2]区域需要沿着能量下降最慢的方向收缩,直到比值不高于e

tr

为止;当比值低于e

tr

时,区域需要沿着能量上升最快的方向扩大,直到不低于e

tr

为止;

[0072]

然后,将边界坐标从特征图映射到输入图片,得到映射后的输入图片关键区域的宽度边界坐标[xa,xb]:

[0073]

xa=iwx1/w

[0074]

xb=iwx2/w

[0075]

其中,iw为输入图片宽度大小,w表示特征图的宽度大小;

[0076]

最后,采用与获取宽度边界坐标[xa,xb]相同的计算方法,得到输入图片关键区域的高度边界坐标[ya,yb]。

[0077]

3.4)将全局流网络的类别相关注意力模块b的输出端通过关键区域定位模块与局部流网络连接,得到整体双流网络。

[0078]

步骤4,利用训练支持集s1与训练查询集t1,通过小样本情景训练方法对整体双流网络进行训练,得到训练后的双流网络。

[0079]

4.1)设最大训练迭代次数为300000,初始学习率为0.0001,每隔100000代对学习率进行衰减;

[0080]

4.2)在现有的余弦损失函数的空间中增加额外的边距,构建改进的余弦损失函数ls:

[0081][0082]

其中,n代表查询集中样本总数,代表全局流网络计算的查询图像q到类之间的相似性,代表全局流网络计算的查询图像q到类cj之间的相似性,m为添加的额外边距超参数,k为最近邻的个数,m为查询图像q的描述子个数;

[0083]

4.3)将改进的余弦损失函数ls与现有的中心损失函数lc相加作为全局流网络的损失函数lg:

[0084]

lg=ls lc[0085]

其中,式中,表示支持样本si的全局特征的类中心;m是每个情景集的大小,在每一集中,类中心是通过平均相应支持类的全局特征来计算的;

[0086]

4.4)根据图像的真实标签以及预测的概率分布计算负对数概率损失函数l

l

,将其设为局部流网络损失函数:

[0087][0088]

其中,n表示查询集中样本总数,c表示查询集中类别总数。

[0089]

4.5)将训练支持集s1中的图像和训练查询集t1中的图像分批次输入到双流网络中,根据全局流网络与局部流网络输出的图像预测类别的概率计算其损失函数的值;

[0090]

4.6)采用adam算法对损失值进行反向传播,调整网络参数;

[0091]

4.7)重复步骤4.5)-4.6)直到达到预设的最大训练迭代次数,得到训练后的双流网络。

[0092]

步骤5,对双流网络进行验证:

[0093]

将输入验证支持集s2与验证查询集t2输入到训练后的双流网络进行网络参数微调,保存指标最高的网络作为最优双流网络模型,重复600次。

[0094]

步骤6,对双流网络进行测试:

[0095]

将测试支持集s3与测试查询集t3输入到最优双流网络模型,输出测试样本属于不同类别的概率,将概率最高的类别作为场景分类的最终结果,完成分类任务。

[0096]

下面结合仿真实验对本发明的效果做进一步的说明:

[0097]

一、仿真实验条件:

[0098]

1.运行平台配置

[0099]

本实验的仿真平台为intel(r)core(tm)i7-7800x cpu和内存32gb的台式电脑,操作系统为ubuntu 18.04,使用python 3.6,pytorch 1.4构建神经网络,使用nvidia rtx 2080ti和cuda 10.0进行加速。

[0100]

2.仿真数据集

[0101]

nwpu-resisc45数据集包含45个场景类别,每个类别有700张256

×

256的rgb图像;

[0102]

whu-rs19数据集包含19个场景类别,共1005张600

×

600的rgb图像;

[0103]

uc-merced数据集包含21个场景类别,每类100张256

×

256的rgb图像。

[0104]

3.仿真参数设置

[0105]

仿真实验采用adam优化器,初始学习率为0.0001,训练迭代次数为300000,每隔100000代对学习率进行衰减,度量模块中搜索的最近邻个数k设置为3,改进的余弦损失函数中超参数m设置为0.01,关键区域定位模块超参数e

tr

设置为70%。

[0106]

小样本场景通常根据选择支持集和查询集的类别数与样本数表示为c-way k-shot问题,本实施例选用最常见的n=15的5-way 1-shot小样本场景和n=10的5-way 5-shot小样本场景。

[0107]

二、仿真内容

[0108]

仿真1,分别在大规模遥感图像公开数据集nwpu-resisc45、whu-rs19和uc merced的5-way 1-shot小样本场景下上采用本发明方法和现有的matchingnet,dla-matchnet以及dn4方法进行场景分类,得出各方法的分类结果;计算各自的分类准确率,结果如表1所示。

[0109]

表1本发明和现有方法在三个数据集的5-way 1-shot小样本场景下分类精度比较

[0110]

方法nwpu-resisc45uc mercedwhu-rs19现有matchingnet54.46%

±

0.77%46.16%

±

0.71%60.60%

±

0.68%现有dla68.80%

±

0.70%53.76%

±

0.62%68.27%

±

1.83%现有dn466.39%

±

0.86%57.25%

±

1.01%82.14%

±

0.80%本发明方法73.84%

±

0.80%68.12%

±

0.81%87.34%

±

0.62%

[0111]

仿真2,分别在大规模遥感图像公开数据集nwpu-resisc45、whu-rs19和uc merced的5-way 5-shot小样本场景下上采用本发明方法和现有的matchingnet,dla-matchnet以及dn4方法进行场景分类,得出各方法的分类结果;计算各自的分类准确率,结果如表2所示。

[0112]

表2本发明和现有方法在三个数据集的5-way 5-shot小样本场景下分类精度比较

[0113]

方法nwpu-resisc45uc mercedwhu-rs19现有matchingnet67.87%

±

0.59%66.73%

±

0.56%82.99%

±

0.40%现有dla81.63%

±

0.46%63.01%

±

0.51%79.89%

±

0.33%现有dn483.24%

±

0.87%79.74%

±

0.78%96.02%

±

0.33%本发明方法87.86%

±

0.51%88.57%

±

0.52%98.25%

±

0.15%

[0114]

从表1和表2的实验结果可以看出,无论是5-way 1-shot还是5-way5-shot任务,本发明方法在三个数据集上的准确率都是最高的,这表明本发明的分类性能最好,可以减少图像判别信息的丢失,避免复杂背景和物体尺度剧烈变化对场景分类的影响,能够有效提高小样本场景下的遥感图像场景分类精度,在分类样本较少的现实场景下有十分重要的实际应用价值。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。