1.本发明涉及深度学习技术领域,尤其涉及一种轻量级注意力机制的图像超分辨率重构方法。

背景技术:

2.近年来,图像超分辨率技术已经被广泛的应用在军事侦察、压缩图像、图像处理、医学图像、人脸识别、监控、社交等多个领域,基于深度学习的图像超分辨率技术更是不断刷新过去传统算法取得的成绩。然而,因为基于深度学习的超分网络往往构造复杂,网络较深,需要大量的计算资源,所以它们往往不能很容易的应用到实际应用中。

3.目前,为了解决这个问题得到一个轻量级的超分网络并且使得这个网络的性能不输于那种较深、规模较大的网络,一类主流的方法是引入注意力机制。注意力机制包括通道注意力机制和空间注意力机制,引入注意力机制可以是使得网络自动抑制不重要的特征,更加关注图像中难以恢复的信息部分,例如高频细节信息,倾斜更多的计算资源到这些部分当中,提高计算资源的利用率,在网络的内部嵌入注意力模块来校正网络提取到的特征,使得网络更加高效且有效,从而保证即使网络规模即使较小也能重建出高质量较高的高分辨率图像。

技术实现要素:

4.发明目的:为了解决基于深度学习的超分网络规模太大,计算消耗过大问题,同时让网络更加高效且有效,本发明提出了基于深度学习的轻量级注意力的超分辨率方法,在网络模型较小的情况下,可以很好的从低分辨率图像中恢复出高分辨率图像,由于模型较小,需要的内存以及计算资源较少,可以很好的应用到实际情况中,该方法被简计为rdan(residual densed attention network)。

5.本发明包括如下步骤:

6.步骤1,对训练集中的图片进行预处理;

7.步骤2,搭建一个超分网络,利用网络来提取特征,并且利用提取到的特征进行重构,得到相应的高分辨率图片;

8.步骤3,训练步骤2所述模型,包括:定义实验相关设置,对网络模型中的模型参数进行优化,得到超分模型;

9.步骤4,利用步骤3得到的超分模型对待测试的低分辨率图片进行处理,得到高分辨率图片;

10.本发明中,步骤1所述图片数据集为已有的公开的图片数据集,例如: div2k,urban100,manga109等等.

11.本发明中,步骤1包括:训练集中的图片都是成对出现的,每一对图片中包括一张低分辨率图片以及其对应的高分辨率图片,对图像数据集中的训练图片进行如下数据增强:首先从训练图像上随机裁剪出固定大小(一般是64像素

×

640像素)的样例,然后水平翻

转,随机旋转(90

°

,180

°

,270

°

)得到最终的训练图像。上述描述的过程是同时作用在低分辨率图像以及相应的高分辨率图像中,得到最终的训练图片对。

12.本发明中,步骤2中,所述超分网络包括一个浅层特征提取模块,一个深层特征提取模块,以及一个重构模块。

13.本发明中,步骤2包括以下步骤:

14.步骤2-1,搭建一个超分网络,所述超分网络包括浅层特征提取模块,深层特征提取模块,以及重构模块;

15.所述浅层网络由两个卷积层堆积而成,第一个卷积层负责从步骤1得到的训练图片对中的低分辨率图像中提取特征f

lr

:

16.f

lr

=h

fe1

(i

sr

)

17.h

fe1

表示第一个卷积层,第二个卷积h

fe2

进一步对f

lr

进行变换得到深层网络部分的输入特征f0:

18.f0=h

fe2

(f

lr

)

19.步骤2-2,深层特征提取模块由一系列残差注意力块(residual attention block,rab) 构成,为了更好的保留浅层所提取到的特征信息以及实现特征复用,前i-1个rab的输出特征和步骤2-1的输出f0会一起作为第i个rab的输入,对于第i个rab(i≥2),由于其接收多个特征图作为输入,因此先将多个输入特征按照通道维度拼接再使用1

×ꢀ

1的卷积对拼接后特征进行融合。而对第一个rab,由于其只接受f0作为输入,因此第一个rab不需要引入该1

×

1卷积,形式化来说,第i个rab中第一个残差注意力单元(residual attention units,rau)的输入特征f

i,0

通过下式生成:

[0020][0021]

表示第i(i>1)个rab中第一个1

×

1卷积。第i个rab的输出fi可以形式化表示为:

[0022][0023]

其中表示第i个rab,在各个rab提取到不同的层次化特征后,网络通过特征融合(feature fusion,ff)操作将多个rab的输出特征f1,...,fn融合,ff操作即将所有的特征按通道拼接并使用1

×

1卷积压缩通道数,最后使用3

×

3卷积进一步交换特征,从而能够更充分的利用多个特征中的不同类型消息,此外,网络引入全局残差学习将低层次特征f

lr

直接与融合后的特征相加得到最终重构网络reconnet部分的输入特征f

main

:

[0024]fmain

=h

ff

([f1,f2,...,fn]) f

lr

[0025]hff

即表示特征融合操作,中括号表示按通道维度拼接特征;

[0026]

步骤2-2-1,所有rab均包含三个残差注意力单元rau,一个3

×

3卷积以及一个尾注意力机制tam。其首先通过3个卷积层和lrelu激活函数从输入x生成特征 m

x

∈rh×w×c(h,w,c分别表示特征图的空间尺寸和通道数),m

x

传入残差注意力机制 (residual attention mechanism,ram)中,首先对m

x

进行全局池化操作,即特征图每个通道各自计算其h

×

w个神经元的均值,得到特征m

pool

∈r1×1×c,在通道注意力 (channel attention,ca)部分,直接将m

pool

通过两层1

×

1卷积和相应的激活函数,得到通道注意力图m

ca

∈r1×1×c,该过程可以形式

化表示为:

[0027]mca

=h

ca

(h

gp

(m

x

))

[0028]

其中,h

ca

表示ca分支的操作,h

gp

表示全局池化操作,m

ca

中所有值在区间[0,1] 内,反映了对不同通道的关注程度。在空间注意力(spatial attention,sa)部分,先将全局池化后的特征m

pool

进行膨胀操作,即在空间位置上将m

pool

复制到和池化前的尺寸一致,得到特征m

expand

∈rh×w×c,之后再将m

expand

与m

x

按照通道维度拼接,由于拼接后特征在每个空间位置上均包含原始特征图的信息和全局池化得到的全局信息,首先使

[0029]msa

=h

sa

([expand(h

gp

(m

x

)),m

x

])

[0030]

其中h

sa

表示sa分支卷积部分的操作,expand表示特征图的膨胀操作,m

sa

中所有值均属于区间[0,1],反映了对不同空间位置的关注程度,两种注意力机制通过融合操作 fuse施加到原始特征图m

x

得到施加注意力后的特征mf,融合方式如下

[0031][0032]

其中,是元素乘,(在相乘之前m

ca

和m

sa

分别沿着空间位置和通道复制使得形状均为rh×w×c),为了保留浅层特征并且降低训练难度,rau中也引入了局部残差学习,因为rau的输出为:

[0033]

y=mf x

[0034]

步骤2-2-2,然后上述步骤中得到的进入到尾注意力机制(tail attention mechanism, tam)模块,该模块包含了通道注意力和空间注意力两部分。首先对输入的特征进行全局平均池化,再通过1

×

1卷积和相应的激活函数得到尾通道注意力图

[0035][0036]

表示为主以中ca的卷积部分,由于ram中的空间注意力考虑了全局信息,尾注意力中则考虑空间上的局部信息从而对特征校准,且为了充分利用rab内部多个 rau提取到的不同信息,先将其输出f

i,1

,f

i,2

,f

i,3

和未校准特征分别基于通道平均池化,即在输出特征图的每个空间位置计算c(通道数)个神经元的均值,再按照通道拼接在一起得到特征最终通过两层卷积和relu函数得到尾注意力图

[0037][0038]

其中h

cap

表示基于通道的平均池化操作,表示sa的卷积部分

[0039]

步骤2-2-3,再得到了和后,我们将空间注意力和通道注意力进行融合综合考虑了f

i,1

,f

i,2

,f

i,3

和特征在空间上的局部信息,若采用乘法的方式施加空间注意力,则会对不同空间位置神经元的值有较大调整(均匀分布下,sigmoid激活函数的期望值为0.5),而由于局部信息的有限性,其只是作为ram中空间注意力的补充,因此在尾注意力中使用加法将空间注意力施加到特征图上,基于以上考虑,tam中的注意力融合方式如下:

[0040][0041]

在该融合过程中,首先需要将和分别沿着空间位置和通道方向复制使得形状均为rh×w×c,此外,rab中同样引入了残差学习以帮助保留特征和传递梯度信息,从而

第i个rab的最终输出特征fi为:

[0042][0043]

步骤2-3,超分网络的最后一部分为重构网络reconnet,最终重建的高分辨率图像 i

sr

可以形式化表示为:

[0044]isr

=h

re

(f

main

;scale) bi(i

lr

;scale)

[0045]hre

(.,scale)表示重构网络reconnet对应缩放因子scale的重建操作,bi(i

lr

;scale) 表示对输入的lr图像进行缩放因子为scale的bilinear插值上采样,步骤2-2中得到的 f

main

首先需要进行上采样操作,亚像素卷积是目前最常用的上采样方法,假设要利用亚像素卷积进行缩放因子为s的上采样操作,记上采样之前的特征图形状为h

×w×

c,首先通过卷积操作使得输出特征图形状为h

×w×

s2c,然后进行像素洗牌操作将特征图形状调整为sh

×

sw

×

c,从而实现从尺寸h

×

w到sh

×

sw的扩充。

[0046]

上述各个子模块详细结构以及整体的网络结构详见说明书附图。

[0047]

本发明中,步骤3是训练步骤2所构造的超分网络,包括如下步骤:

[0048]

步骤3-1,定义实验相关配置,训练模型之前,首先定义损失函数和用于更新模型参数的模型优化器,具体的,使用adam优化器来记载步骤2中构造的模型参数,然后设置学习率调度器,具体的,使用多步学习率调度器multisteplr,当训练达到预定的迭代次数点时,学习率就降为原来的gamma倍,实验时gamma设置为0.5,每隔400 轮迭代设置一个迭代次数点。为了提高网络的实用性且更公平地进行比较,本章控制了 rdan的模型规模,使其更加的合理。rdan由8个rab组成,且每个rab包含3 个rau,网络除了在注意力机制部分使用relu和sigmoid激活函数外,其余部分均使用lrelu激活函数,且lrelu的参数α设置为0.1;

[0049]

步骤3-2,对模型进行监督训练,步骤2得到重构的图片i

sr

后,利用训练图片集中对用的高分辨率图片i

hr

,引入l2损失函数进行监督训练,超分网络的损失函数l为:

[0050][0051]

通过adam优化器进行优化,得到训练好的超分模型。

[0052]

最后是测试我们得到的网络模型的性能。

[0053]

本发明中,步骤4包括:直接利用步骤3中训练好的网络,对输入的低分辨率图像进行处理,直接得到对应的高分辨率图像。

[0054]

有益效果:

[0055]

相比以往的超分辨率方法,本发明的优势在于:网络模型规模以及需要的计算量都较小,可以在实际生活中存储计算资源有限的设备上进行应用,另外,本发明中所使用的注意力模块是精心设计的,而且比较轻量级,可以更好的校准网络从低分辨率图像中提取到的特征,从而使得更多的计算资源倾斜在哪些难以恢复的信息成分,从而更加有效且高效的从低分辨率图片中重构出对应的高分辨率图片。

附图说明

[0056]

下面结合附图和具体实施方式对本发明做更进一步的具体说明,本发明的上述和/ 或其他方面的优点将会变得更加清楚。

[0057]

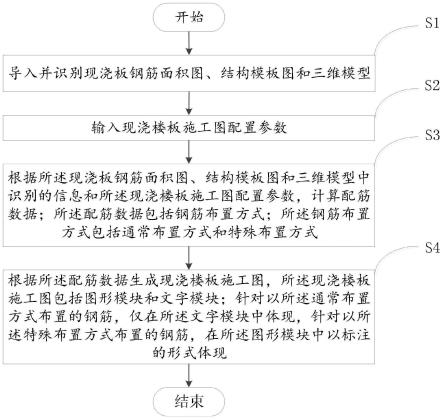

图1为本发明涉及到的模型的框架结构。

[0058]

图2为本发明模型中的rab网络结构示意图。

[0059]

图3为本发明模型中的rau网络结构示意图。

[0060]

图4为urban数据集上缩放因子为2的测试结果。

[0061]

图5为urban数据集上缩放因子为3的测试结果。

[0062]

图6为urban数据集上缩放因子为4的测试结果。

[0063]

图7为本发明流程图。

具体实施方式

[0064]

本发明为一种轻量级注意力机制的图像超分辨率重构方法,包括如下步骤:

[0065]

步骤1:对公开的标准数据集div2k中的图像进行预处理,对训练数据进行数据增强:(1)随机裁剪出固定大小(一般是64像素

×

640像素)的样例;(2)将样例以0.5 的概率水平翻转,随机旋转(90

°

,180

°

,270

°

);(4)图像使用通道均值和标准差归一化。

[0066]

步骤2:搭建rdan(residual dense attention network)网络结构如图1所示,包含一个浅层特征提取模块,一个深层特征提取模块,一个重构模块,具体包括如下步骤:

[0067]

步骤2-1:浅层特征提取模块由两个卷积层堆积而成,第一个卷积层负责从步骤1 得到的训练图片对中的低分辨率图像中提取特征f

lr

:

[0068]flr

=h

fe1

(i

sr

)

[0069]hfe1

表示第一个卷积层,第二个卷积h

fe2

进一步对f

lr

进行变换得到深层网络部分的输入特征f0:

[0070]

f0=h

fe2

(f

lr

)

[0071]

步骤2-2:深层特征提取模块由一系列残差注意力块rab构成,,前i-1个rab的输出特征和步骤2-1的输出f0会一起作为第i个rab的输入,对于第i个rab(i≥2),由于其接收多个特征图作为输入,因此先将多个输入特征按照通道维度拼接再使用1

×

1的卷积对拼接后特征进行融合。而对第一个rab,由于其只接受f0作为输入,因此第一个rab不需要引入该1

×

1卷积,形式化来说,第i个rab中第一个rau的输入特征f

i,0

通过下式生成:

[0072][0073]

表示第i(i>1)个rab中第一个1

×

1卷积。第i个rab的输出fi可以形式化表示为:

[0074][0075]

其中表示第i个rab,在各个rab提取到不同的层次化特征后,网络通过特征融合(feature fusion,ff)操作将多个rab的输出特征f1,...,fn融合,ff操作即将所有的特征按通道拼接并使用1

×

1卷积压缩通道数,最后使用3

×

3卷积进一步交换特征,此外,网络引入全局残差学习将低层次特征f

lr

直接与融合后的特征相加得到最终重构网络reconnet部分的输入特征f

main

[0076]fmain

=h

ff

([f1,f2,...,fn]) f

lr

[0077]hff

即表示特征融合操作,中括号表示按通道维度拼接特征;

[0078]

步骤2-2-1:所有rab均包含三个残差注意力单元rau,一个3

×

3卷积以及一个尾注意力机制tam。其首先通过3个卷积层和lrelu激活函数从输入x生成特征 m

x

∈rh×w×c(h,w,c分别表示特征图的空间尺寸和通道数),m

x

传入残差注意力机制 ram中,首先对m

x

进行全局池化操作,即特征图每个通道各自计算其h

×

w个神经元的均值,得到特征m

pool

∈r1×1×c,在通道注意力ca部分,直接将m

pool

通过两层1

×

1 卷积和相应的激活函数,得到通道注意力图m

ca

∈r1×1×c,该过程可以形式化表示为

[0079]mca

=h

ca

(h

gp

(m

x

))

[0080]

其中,h

ca

表示ca分支的操作,h

gp

表示全局池化操作,m

ca

中所有值在区间[0,1]内,反映了对不同通道的关注程度。在空间注意力sa部分,先将全局池化后的特征m

pool

进行膨胀操作,即在空间位置上将m

pool

复制到和池化前的尺寸一致i,得到特征 m

expand

∈rh×w×c,之后再将m

expand

与m

x

按照通道维度拼接,由于拼接后特征在每个空间位置上均包含原始特征图的信息和全局池化得到的全局信息,首先使用1

×

1卷积对拼接后特征图进行融合,使得融合后特征的每个空间位置均考虑了全局的信息,最后在通过一层卷积和激活函数得到空间注意力图m

sa

∈rh×w×1[0081]msa

=h

sa

([expand(h

gp

(m

x

)),m

x

])

[0082]

其中h

sa

表示sa分支卷积部分的操作,expand表示特征图的膨胀操作,m

sa

中所有值均属于区间[0,1],反映了对不同空间位置的关注程度,两种注意力机制通过融合操作fuse 施加到原始特征图m

x

得到施加注意力后的特征mf,融合方式如下:

[0083][0084]

其中,是元素乘,(在相乘之前m

ca

和m

sa

分别沿着空间位置和通道复制使得形状均为 rh×w×c),为了保留浅层特征并且降低训练难度,rau中也引入了局部残差学习,因为 rau的输出为:

[0085]

y=mf x

[0086]

步骤2-2-2:然后上述步骤中得到的进入到尾注意力机制tam模块,该模块包含了通道注意力和空间注意力两部分。首先对输入的特征进行全局平均池化,再通过1

×

1卷积和相应的激活函数得到尾通道注意力图

[0087][0088]

表示为主以中ca的卷积部分,由于ram中的空间注意力考虑了全局信息,尾注意力中则考虑空间上的局部信息从而对特征校准,且为了充分利用rab内部多个rau 提取到的不同信息,先将其输出f

i,1

,f

i,2

,f

i,3

和未校准特征分别基于通道平均池化,即在输出特征图的每个空间位置计算c(通道数)个神经元的均值,再按照通道拼接在一起得到特征最终通过两层卷积和relu函数得到尾注意力图

[0089][0090]

其中h

cap

表示基于通道的平均池化操作,表示sa的卷积部分

[0091]

步骤2-2-3:再得到了和后,我们将空间注意力和通道注意力进行融合综合考虑了f

i,1

,f

i,2

,f

i,3

和特征在空间上的局部信息,若采用乘法的方式施加空间

注意力,则会对不同空间位置神经元的值有较大调整(均匀分布下,sigmoid激活函数的期望值为0.5),而由于局部信息的有限性,其只是作为ram中空间注意力的补充,因此在尾注意力中使用加法将空间注意力施加到特征图上,基于以上考虑,tam中的注意力融合方式如下:

[0092][0093]

在该融合过程中,首先需要将和分别沿着空间位置和通道方向复制使得形状均为rh×w×c,此外,rab中同样引入了残差学习以帮助保留特征和传递梯度信息,从而第i个rab的最终输出特征fi为:

[0094][0095]

步骤2-3:超分网络的最后一部分为重构网络reconnet,最终重建的高分辨率图像 i

sr

可以形式化表示为:

[0096]isr

=h

re

(f

main

;scale) bi(i

lr

;scale)

[0097]hre

(.,scale)表示重构网络reconnet对应缩放因子scale的重建操作,bi(i

lr

;scale) 表示对输入的lr图像进行缩放因子为scale的bilinear插值上采样,步骤2-2中得到的 f

main

首先需要进行上采样操作,亚像素卷积是目前最常用的上采样方法,假设要利用亚像素卷积进行缩放因子为s的上采样操作,记上采样之前的特征图形状为h

×w×

c,首先通过卷积操作使得输出特征图形状为h

×w×

s2c,然后进行像素洗牌操作将特征图形状调整为sh

×

sw

×

c,从而实现从尺寸h

×

w到sh

×

sw的扩充。

[0098]

步骤3:训练步骤2所述的超分网络:

[0099]

步骤3-1:定义实验相关配置,训练模型之前,首先定义损失函数和用于更新模型参数的模型优化器,具体的,使用adam优化器来记载步骤2中构造的模型参数,然后设置学习率调度器,具体的,使用多步学习率调度器multisteplr,当训练达到预定的迭代次数点时,学习率就降为原来的gamma倍,实验时gamma设置为0.5,每隔400 轮迭代设置一个迭代次数点。为了提高网络的实用性且更公平地进行比较,本章控制了 rdan的模型规模,使其更加的合理。rdan由8个rab组成,且每个rab包含3 个rau,网络除了在注意力机制部分使用relu和sigmoid激活函数外,其余部分均使用lrelu激活函数,且lrelu的参数α设置为0.1;

[0100]

步骤3-2:对模型进行监督训练,步骤2得到重构的图片i

sr

后,利用训练图片集中对用的高分辨率图片i

hr

,引入l2损失函数进行监督训练,超分网络的损失函数l为:

[0101][0102]

通过adam优化器进行优化,得到训练好的超分模型。

[0103]

步骤4:用步骤3得到的超分模型对待测试的低分辨率图片进行处理,得到高分辨率图片。

[0104]

本实施例在标准数据集urban100上的实验结果如表1所示,本发明与主流方法oisr-lf-s[人工智能顶级会议cvpr2019提出的方法]和carn(人工智能顶级会议eccv 2018)提出的方法作比较:

[0105]

表1

[0106][0107][0108]

可以看出,对于不同的scale,本发明在模型大小,计算复杂度上都相对更小,而且从psnr(峰值信噪比)和ssim(结构相似性)指标来看,重建效果好于其对比方法,有效的证明了本发明轻量级注意力的特性,可以很好的恢复出高分辨率图像。

[0109]

本发明提供了一种轻量级注意力机制的图像超分辨率重构方法,具体实现该技术方案的方法和途径很多,以上所述仅是本发明的优选实施方式,应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干改进和润饰,这些改进和润饰也应视为本发明的保护范围。本实施例中未明确的各组成部分均可用现有技术加以实现。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。