一种基于adaboost集成思想的神经网络拷贝数变异检测方法与系统

技术领域

1.本发明属于生物信息学的领域,具体涉及了一种基于adaboost集成思想的神经网络拷贝数变异检测方法与系统。

技术背景

2.近年来,我国的癌症新发率和死亡率都在逐年升高,关于癌症的防治已经是各界关注的重要问题。而癌症的发生与拷贝数变异(cnv)有着密切的关系,cnv是一种重要的基因组结构性变异,主要是指染色体的畸变,包括基因组中片段中的拷贝数缺失,重复,倒位等拷贝数变化。

3.cnv的检测与测序技术直接相关,目前为止,测序技术已经经历了三代的发展,然而由于第三代测序技术的错误率较高,而第二代测序技术(next-generation sequencing,ngs)具有高性能且消耗较少的特点,因此目前普遍应用的还是ngs测序技术。以ngs测试技术为基础,逐步发展出了检测cnv的4种基本策略:基于读深(read depth,rd),基于读对(paired-read based),基于分裂读段(split-read based),基于序列组装(sequence assembly based),其中基于读深的方法是一种综合考虑较好,受广大研究人员喜欢的cnv检测方式。

4.在此之前,研究人员对于基于读深的cnv检测方式以及进行了很多的研究,目前对于cnv的研究可以按照检测方法分为基于概率统计模型的方法和机器学习的方法两大类。对于基于概率统计模型的方法,有baggmm,cnvem,codex,condex2,condel,devicnv,pencnn等,其中cnvem是一种概率模型算法,考虑到测序短序列匹配中固有的不确定性,使用了一种最大似然估计的方法来估计核苷酸上的拷贝数变异。同时通过一种期望最大化(em)算法来寻求最优的可行解集,提高了检测cnv边界的准确性。对于基于机器学习的方法也是今年来研究的热点方法。有cnv_iftv,rkdoscnv,cnv_lof,circnv,cony等方法。其中cnv_lof通过cbs算法对基因组进行分段操作,并通过局部离群点检测算法来给每个基因段分配局部离群值,利用箱线图来检测cnv。

5.在机器学习方法上发展出的深度学习的思想也在被研究人员尝试加入cnv的检测中。cnncnv,dl-cnv等方法与模型都融入了深度学习的思想,其中cnncnv提出了一种基于卷积神经网络的cnv检测框架。合并了现有的多种cnv检测工具的输出,利用多种检测理论从读段数据中生成候选区域的图像,通过模型训练来判断候选区域的真假。

6.基于上述方法,我们提出了一种基于adaboost集成思想的神经网络拷贝数变异检测方法与系统,该方法的主要贡献如下:1)对于cnv预测的类别进行了详细的划分,主要包含了扩增,正常,半缺失和缺失4种类别。预测更加具有现实意义;2)结合了集成学习思想,以adaboost为框架,通过将bp神经网络作为弱分类,组合成强分类器进行cnv的预测,提高了算法性能和稳定性;3)利用神经网络进行cnv的预测,同时又通过强分类中的投票机制进行二次cnv预测。两次cnv预测提高了算法整体的精确程度。

技术实现要素:

7.本发明的目的在于解决上述现有技术中存在的难题,提供一种基于adaboost集成思想的神经网络拷贝数变异检测方法与系统,提高cnv的检测效率。本发明是通过以下技术方案实现的:

8.一种基于adaboost集成思想的神经网络拷贝数变异检测方法与系统,包括:

9.s1:研究了基于下一代测序数据(ngs)的cnv检测问题;

10.s2:测序数据的预先处理;

11.s3:4种特征值的提取与归一化处理;

12.s4:adaboost框架下,基于神经网络的分类器训练迭代;

13.s5:弱分类器组合成强分类器,预测cnv检测的结果;

14.s6:对所提出方法的实验验证;

15.所述s1中基于下一代测序技术(ngs)检测拷贝数变异(cnv),ngs较第一代和第三代测序技术来说,测序的成本和精准率相对适中,同时测序速度快、数据吞吐量高,对目前的基因组数据分析具有普适性。

16.所述s2中数据的预处理,主要是处理利用ngs技术得到的fastq文件格式的测序数据文件,通过经典的对比软件bwa,输入fastq格式的测序文件以及用于参照的参考序列文件(fasta格式),输出一个对齐的序列文件(bam文件格式);接着使用samtools软件对bam格式的序列文件进行处理。其中参考序列文件正常是由

‘

a,c,g,t’四种碱基组成的。但是存在一部分未确定的碱基,表示为

‘

n’,为了避免影响后续对数据的分析,需要对参考序列文件中对应位置

‘

n’的区域进行删除。

17.所述s3是这样实现的:

18.一共提取了4种特征值(ri,gi,ci,qi),通过s2的预处理过程将测序数据通过bwa软件进行比对,并通过samtools提取出对应的readcount(rc)文件,通过rc来计算数据的读深(rd)作为第一个特征ri。本发明使用窗口的方式计算rd信号,即将基因片段划分为连续的大小相等,且不重叠的区域作为窗口。此外g和c碱基的含量反映了测序的随机程度,也是检测cnv的重要指标,序列的覆盖度受gc含量的影响。因此提取读段中的gc含量作为第二个特征值gi,由公式1表示:

19.gi=niꢀꢀ

(1)

20.其中gi代表第i个位置的gc含量,ni表示第i个位置的g和c的碱基总数,每个位置表示为一个窗口。

21.同时,序列的对比质量,和相邻位置之间的关系也是不可忽视的因素,提取出对比质量,相邻位置间参考关系作为另外两个特征。对比质量qi的提取也是基于滑动窗口方法,与gc含量类似,此处不在赘述。相邻位置之间的关系主要考虑的是相邻的窗口之间的关系,计算方法如公式2所示:

[0022][0023]

其中ci代表第i个位置的量化的相邻位置相关性,ri代表第i个位置的rd值,wl代表从当前i位置左边的相邻位置数目,wr代表从当前i位置右边的相邻位置数目。通过计算当

前位置与每个相邻位置的的rd的差,来量化位置之间的关联性。为了保证算法的精确度,我们对特征值数据进行归一化操作,归一化过程如公式3所示:

[0024][0025]

其中y代表归一化后的数值,y

max

和y

min

表示归一化后的目标数据的最大和最小值,通常为1和-1;x代表归一化之前的数据,x

max

和x

min

分别代表需要归一化的数据的最大值和最小值。

[0026]

所述s4是这样实现的:

[0027]

以adaboost算法为主框架,构建神经网络作为弱分类器,同时迭代生成下一个弱分类器。基于神经网络的adaboost分类器的训练迭代过程主要分为两个部分:构建神经网络作为弱分类的过程和基于adaboost算法训练迭代的过程;

[0028]

(1)构建bp神经网络作为弱分类器。基于神经网络的adaboost的分类器的训练迭代首先需要构建弱分类器,即构建神经网络,处理s3中提取出的4种特征值。神经网络由输入层,隐含层,输出层组成,基于本场景,定义bp神经网络的输入为4个神经元,隐含层为7层,输出为4个神经元。4个输入神经元对应了s3中提取的4个特征值,4个输出神经元代表拷贝数预测的4种状态:扩增,正常,半缺失,全缺失。神经网络是全连接的方式,输入层与隐含层采取的激活函数为sigmod,激活函数可以描述为如下公式4所示:

[0029][0030]

n=wx b

ꢀꢀ

(5)

[0031]

其中,公式4中n代表了从神经网络输入中得到的数值,可以用公式5来描述,公式5中x代表了当前神经元的输入,w代表了当前输入的神经元之间的权值,b代表了相应神经元的偏差参数。

[0032]

(2)基于adaboost算法的训练迭代。在(1)中构建了神经网络作为弱分类器后,每个弱分类器串行处理样本数据。每个弱分类器之间存在依赖关系,下个弱分类器通过上个弱分类器的预测结果,对样本数据更新权值,使得下个弱分类器着重考虑上个弱分类器判断错误的数据。具体步骤如下:

[0033]

步骤1,数据的初始化

[0034]

步骤2,弱分类器进行cnv预测

[0035]

步骤3,参数调整

[0036]

步骤4,生成下一弱分类器

[0037]

所述步骤1是这样实现的:

[0038]

数据初始化主要是对权值的初始化。adaboost算法一共涉及两个权值:一个是弱分类器组合为强分类时所占的权重ak,另一个是样本权值d。初始化d的过程如公式6所示:

[0039]dk

(i)={(1/m)|i=1,2,3...m}

ꢀꢀ

(6)

[0040]

其中k代表了弱分类器的数目,本算法使用的弱分类器为3个,m表示样本的总数量;

[0041]

所述步骤2是这样实现的:

[0042]

在构建完神经网络作为弱分类器后,将样本的特征值数据代入弱分类器中进行预

测,即通过神经网络进行cnv类别的预测,同时利用预测的结果评估预测误差。误差的计算如公式(7)所示:

[0043][0044]

其中k代表了弱分类器的数目,xk代表了第k个弱分类器预测分类的结果,y代表了样本的期望分类的结果。计算期望与预测不匹配的样本权值之和,作为当前弱分类器的误差。

[0045]

所述步骤3是这样实现的:

[0046]

根据步骤2得到的弱分类器误差,计算当前弱分类器组合为强分类器所占的组合权重,组合权重的计算公式如公式8所示:

[0047][0048]

其中class代表了数据的类别总数,拷贝数的数据类别有扩增,半缺失,全缺失,正常四类,因此class=4。当ek较大时,ak越小,这也意味着弱分类器的误差越大,组合强分类器所占的权重越小。

[0049]

所述步骤4是这样实现的:

[0050]

利用上一个弱分类器的组合权重ak,对下一个弱分类器的样本权值d进行优化,优化的公式如公式9所示:

[0051][0052]

其中bk是归一化因子,主要的作用是将弱分类器更新后的样本权值进行归一化操作。xk代表了第k个弱分类器预测分类的结果,y代表了样本的期望分类的结果。弱分类器对于分类错误的样本,会赋予较大的样本权值,在下次分类时着重考虑这些错误的样本。若弱分类器的数量达到了上限,则会开始组合强分类器,反之回到步骤2用下一个弱分类器预测数据。直至所有的弱分类都预测完毕。

[0053]

所述s5是这样实现的:

[0054]

对所有的弱分类器按组合权值组成强分类器。强分类器的构建基于投票机制,对于每个样本来说,投票机制主要体现在分别计算四种类别在所有弱分类中所占的组合权值之和,并进行比较,最大的值对应的类别表现为最终强分类器对样本的分类类别。本发明使用的3弱分类器组合过程可以由公式10所示:

[0055][0056]

其中s(x)代表强分类器对每个样本的分类结果,对于样本的每种可能的类别,都要按组合权值,计算在所有弱分类器中所占的值之和,最终,选取组合权值之和最大的类别作为样本的强分类器结果。

[0057]

所述s6是这样实现的:

[0058]

对所提方法进行了实验验证,分别使用了仿真数据样本和真实人类数据样本,综合性的评价算法在仿真情况和真实临床场景下的性能,同时利用cnv_nator,frreec,grom_

rd,cnvnorm,readdepth,mfcnv方法进行了对比分析,并结合6类指标(准确率,敏感度,f1-score分数,真阳性率(tpr),假阳性率(fpr),稳定性)分析了所提方法的优势。

附图说明

[0059]

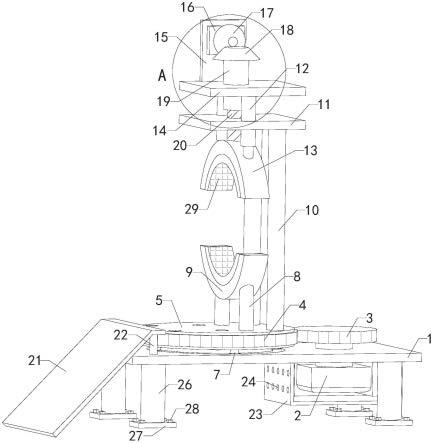

图1所提方法与系统(cnv_adabp)流程图;

[0060]

图2神经网络结构图;

[0061]

图3基于adaboost算法的训练迭代过程图;

[0062]

图4仿真样本中cnv_adabp与其他算法的性能比较图;

[0063]

图5仿真样本中cnv_adabp与其他算法的roc曲线图;

[0064]

图6仿真样本中cnv_adabp与mfcnv的边界偏差图;

[0065]

图7仿真样本中cnv_adabp与mfcnv的稳定性分析图;

[0066]

图8真实样本中cnv_adabp与其他算法的性能比较图。

具体实施方式

[0067]

下面结合附图对本发明做进一步详细描述:

[0068]

拷贝数变异(cnv)是一种十分重要的基因组结构变异,主要是指染色体的畸变,包括基因组中片段中的拷贝数缺失,重复,倒位等拷贝数变化。第二代测序技术(ngs)具有高性能且消耗较少的特点,因此目前被普遍用于基因组的测序,是测序数据的主要来源。现有的cnv检测算法对于低纯度,低覆盖的测序数据检测能力相对不足,同时单一算法模型的不稳定性会导致cnv的检测出现偶然性。基于上述考虑,我们提出了一种基于集成学习的cnv检测方法与系统:cnv_adabp,该方法的主要贡献如下:1)对于cnv预测的类别进行了详细的划分,主要包含了扩增,正常,半缺失和缺失4种类别。预测更加具有现实意义;2)结合了集成学习思想,以adaboost为框架,通过将bp神经网络作为弱分类,组合成强分类器进行cnv的预测,提高了算法性能和稳定性;3)利用bp神经网络进行cnv的预测,同时又通过强分类中的投票机制进行二次cnv预测。两次cnv预测提高了算法整体的精确程度。

[0069]

1.cnv_adabp的工作流程

[0070]

cnv_adabp的总体工作流程可以用图1表示,首先对参考序列和输入数据进行预处理操作,其次通过cnv_adabp算法分4个步骤实现cnv的预测:(1)特征提取,(2)基于bp神经网络的adaboost分类器的训练迭代,(3)弱分类器组合成强分类器,(4)输出cnv检测的结果。

[0071]

2.数据的预处理

[0072]

通过ngs测序得到的待分类数据一般是以fastq格式进行存储,fastq文件中保存的是读段的“a”,“c”,“g”,“t”四种碱基的排列组合,文件的预处理需要对比到参考序列(正常情况的人类基因组序列)来对ngs测序过程中产生的无序基因组进行排序,在这个过程中,往往会发现参考序列中会存在上述四种碱基之外的字母“n”,这代表了此位置的碱基无法识别,或者是无效的,本发明采取的策略是对这类位置进行剔除操作,增加cnv检测过程中的真实性。

[0073]

3.特征值的提取

[0074]

利用预处理过的测序数据,一共提取了4种特征值(ri,gi,ci,qi),通过预处理过程

将测序数据通过bwa软件进行比对,并通过samtools提取出对应的readcount(rc)文件,通过rc来计算数据的读深(rd)作为第一个特征ri。本发明使用窗口的方式计算rd信号,即将基因片段划分为连续的大小相等,且不重叠的区域作为窗口,本发明中设置窗口大小为100kb。此外g和c碱基的含量反映了测序的随机程度,也是检测cnv的重要指标,序列的覆盖度受gc含量的影响。因此提取读段中的gc含量作为第二个特征值gi,由公式1表示:

[0075]gi

=niꢀꢀ

(1)

[0076]

其中gi代表第i个位置的gc含量,ni表示第i个位置的g和c的碱基总数,每个位置表示为一个窗口。

[0077]

同时,序列的对比质量,和相邻位置之间的关系也是不可忽视的因素,提取出对比质量,相邻位置间参考关系作为另外两个特征。对比质量qi的提取也是基于窗口的方法,与gc含量类似,此处不在赘述。相邻位置之间的关系主要是指相邻窗口的关系,计算方法如公式2所示:

[0078][0079]

其中ci代表第i个位置的量化的相邻位置相关性,ri代表第i个位置的rd值,wl代表从当前i位置左边的相邻位置数目,wr代表从当前i位置右边的相邻位置数目。通过计算当前位置与每个相邻位置的的rd的差,来量化位置之间的关联性。为了保证算法的精确度,我们对特征值数据进行归一化操作,归一化过程如公式3所示:

[0080][0081]

其中y代表归一化后的数值,y

max

和y

min

表示归一化后的目标数据的最大和最小值,通常为1和-1;x代表归一化之前的数据,x

max

和x

min

分别代表需要归一化的数据的最大值和最小值。

[0082]

4.基于bp神经网络的adaboost分类器训练迭代

[0083]

以adaboost算法为主框架,构建神经网络作为弱分类器,同时迭代生成下一个弱分类器。基于神经网络的adaboost分类器的训练迭代过程主要分为两个部分:构建神经网络作为弱分类的过程和基于adaboost算法训练迭代的过程;

[0084]

(1)构建bp神经网络作为弱分类器。基于神经网络的adaboost的分类器的训练迭代首先需要构建弱分类器,即构建神经网络,处理提取出的4种特征值。神经网络由输入层,隐含层,输出层组成,基于本场景,定义bp神经网络的输入为4个神经元,隐含层为7层,输出为4个神经元。神经网络结构图可以由图2表示。4个输入神经元对应了提取的4个特征值,4个输出神经元代表拷贝数预测的4种状态:扩增,正常,半缺失,全缺失。神经网络是全连接的方式,输入层与隐含层采取的激活函数为sigmod,激活函数可以描述为如下公式4所示:

[0085][0086]

n=wx b

ꢀꢀ

(5)

[0087]

其中,公式4中n代表了从神经网络输入中得到的数值,可以用公式5来描述,公式5中x代表了当前神经元的输入,w代表了当前输入的神经元之间的权值,b代表了相应神经元

的偏差参数。

[0088]

(2)基于adaboost算法的训练迭代。在(1)中构建了神经网络作为弱分类器后,每个弱分类器串行运行样本数据。每个弱分类器之间存在依赖关系,下个弱分类器通过上个弱分类器的预测结果,对样本数据更新权值,使得下个弱分类器着重考虑上个弱分类器判断错误的数据。迭代的过程可以用图3表示,具体步骤如下:

[0089]

步骤1,数据的初始化

[0090]

数据初始化主要是对相关权值的初始化。adaboost算法一共涉及两个权值:一个是弱分类器组合为强分类时所占的权重ak,另一个是样本权值d。初始化d的过程如公式(6)所示:

[0091]dk

(i)={(1/m)|i=1,2,3...m}

ꢀꢀ

(6)

[0092]

其中k代表了弱分类器的数目,本算法使用的弱分类器为3个;m表示样本的总数量;

[0093]

步骤2,弱分类器进行cnv预测

[0094]

在构建完神经网络作为弱分类器后,将样本的特征值数据代入弱分类器中进行预测,即通过神经网络进行cnv类别的预测,同时利用预测的结果评估预测误差。误差的计算如公式7所示:

[0095][0096]

其中k代表了弱分类器的数目,xk代表了第k个弱分类器预测分类的结果,y代表了样本的期望分类的结果。计算期望与预测不匹配的样本权值之和,作为当前弱分类器的误差。

[0097]

步骤3,参数调整

[0098]

根据步骤2得到的弱分类器误差,计算当前弱分类器组合为强分类器所占的组合权重,组合权重的计算公式如公式8所示:

[0099][0100]

其中class代表了数据的类别总数,拷贝数的数据类别有扩增,半缺失,全缺失,正常四类,因此class=4。当ek较大时,ak越小,这也意味着弱分类器的误差越大,组合强分类器所占的权重越小。

[0101]

步骤4,生成下一弱分类器

[0102]

利用上一个弱分类器的组合权重ak,对下一个弱分类器的样本权值d进行优化,对于上次判断错误的样本着重考虑,即分配较大的权值。优化的公式如公式9所示:

[0103][0104]

其中bk是归一化因子,主要的作用是将弱分类器更新后的样本权值进行归一化操作。xk代表了第k个弱分类器预测分类的结果,y代表了样本的期望分类的结果。弱分类器对于分类错误的样本,会赋予较大的样本权值,在下次分类时着重考虑这些错误的样本。若弱分类器的数量达到了上限,则会开始组合强分类器,反之回到步骤2用下一个弱分类器预测

数据。直至所有的弱分类都预测完毕。

[0105]

5.强分类器的组合

[0106]

对所有的弱分类器按组合权值组成强分类器。强分类器的构建基于投票机制,对于每个样本来说,投票机制主要体现在分别计算四种类别在所有弱分类中所占的组合权值之和,并进行比较,最大的值对应的类别表现为最终强分类器的分类类别。例如对于其中一个样本来说,分别计算扩增,正常,半缺失,全缺失,四种可能的类别在结合了所有弱分类器之后得到权值之和:a,b,c,d,且满足a>b>c>d,假设a代表拷贝数扩增,b代表拷贝数正常,c代表拷贝数半缺失,d代表拷贝数全缺失,则此样本通过强分类器预测的结果为拷贝数扩增。本发明使用的3弱分类组合过程可以由公式10所示:

[0107][0108]

其中s(x)代表强分类器对每个样本的分类结果,对于样本的每种可能的类别,都要按组合权值,计算在所有弱分类器中所占的值之和,最终,选取组合权值之和最大的类别作为样本的强分类器结果。

[0109]

6.cnv的预测

[0110]

cnv_adabp对cnv的类别进行了两次预测:1)通过神经网络进行cnv预测;2)通过强分类器中的投票机制进行二次cnv预测。

[0111]

神经网络预测cnv主要体现在神经网络的输出。神经网络的4个输出节点分别对应了cnv的四种类别:扩增,正常,半缺失,全缺失。神经网络作为弱分类器,输出四种类别的预测值,预测值误差最小的类别为神经网络预测的cnv类别。神经网络预测cnv作为第一次预测,目的在于通过预测误差调整下一弱分类器,以便于得到更加精确的强分类器预测结果。

[0112]

强分类器预测cnv主要通过投票机制对弱分类中的结果进行二次预测。(关于投票机制的说明在

‘

5.组合强分类器’中已经进行了相关描述)经过投票机制对第一次的cnv预测进行多分类器的权衡,从而达到预测的公平性和综合性。

[0113]

本发明通过adaboost算法对bp神经网络进行组合,加强了普通bp神经网络的分类效果,同时多分类器的投票机制也减小了单一分类器误判所带来的影响。下面我们通过仿真实验来验证算法的有效性。

[0114]

7.实验仿真

[0115]

为了进一步验证cnv_adabp的有效性,我们从模仿真数据和真实数据两方面对所提方法进行验证,并结合了cnv_nator,frreec,grom_rd,cnvnorm,readdepth,mfcnv方法进行了对比,下面是实验的具体说明。

[0116]

7.1仿真实验

[0117]

本发明用于仿真实验的数据来自intsim软件。以21号染色体供intsim参照,生成低纯度数据。仿真数据包含肿瘤的纯度为0.2,0.3,0.4,覆盖度为x4和x6,共计6种不同组合的样本仿真数据。对于每种组合,生成50个样本仿真数据,本发明的仿真实验共生成了300个仿真样本数据。同时我们对比了cnvnator,freec,grom-rd,mfcnv,cnvnorm,分析了cnv_adabp的准确率,敏感度,f1-score,边界精度,roc曲线,稳定性。其中,准确率,敏感度,f1-score的定义公式可以表述为公式11-13:

[0118][0119][0120][0121]

图4比较了cnv_adabp与其他方法的cnv仿真数据性能。图像中每隔0.1画曲线,每条曲线上的f1-score是相等的,横坐标代表了准确率,纵坐标代表了敏感度,越接近图像右上角,说明算法的性能越好。

[0122]

如图4所示,在三种不同纯度的样本性能图中,cnv_adabp并不一直是最好,左侧的三幅图片mfcnv与cnv_adabp几乎重叠,说明在此时mfcnv分类器取得了较好的分类结果,而在右侧图片所示的情况下,mfcnv的准确率和敏感度不如cnv_adabp,这是因为adaboost算法的多分类投票机制减小了错误分类结果对整体的影响。其他算法在一些场景下也表现了不错的检索性能,如purity=0.2,cover=4的情况下,cnvnator的准确率要稍高于cnv_adabp,差不多0.92,但是敏感度却只有0.6,根据公式(13)得出的f1-score差不多为0.72,而cnv_adabp的f1-score差不多可以达到0.9。其他的算法也是类似的情况,在purity=0.2,covery=6的情况下,freec的准确率很高,但是敏感度却不到0.4;在purity=0.4,cover=6的情况下,grom_rd的准确率基本可以达到百分比,但是敏感度却不足0.4。对于上述算法来说,本发明提出的cnv_adabp的f1-score更高,对cnv的检测力度更强。

[0123]

roc曲线也是是检测分类算法性能的重要工具,主要是对检验算法的真阳性率(tpr)和假阳性率(tpr)进行对比分析,图5是cnv_adabp与cnvnator,freec,grom-rd,mfcnv四种cnv检测算法的roc分析曲线。

[0124]

对于roc曲线来说,具有较高的tpr,同时具有较低的fpr,则意味着检测算法具有较好的性能,即越靠近图5左上角的位置,算法性能越好,越靠近右下角的位置,代表算法性能越差。通过分析纯度分别为0.2,0.3,0.4的情况下,几种算法的tpr和fpr值,可以发现cnv_adabp最靠近右上角。首先分析在三种纯度下各种算法的tpr,cnv_adabp具有最高的tpr,其次是mfcnv,其余的检测算法tpr普遍低于0.8;接着分析不同算法的fpr。grom_rm在纯度为0.2时具有较小的fpr,但是在纯度为0.3和0.4的情况下,cnv_adabp要更好。由此可见,cnv_adabp在低纯度的肿瘤数据下具有较好的检测性能。

[0125]

由于cnv_adabp是以bp网络为弱分类器,所以下面针对算法的cnv边界精度和稳定性,与mfcnv进行对比分析,验证cnv_adabp组合过程的优势。cnv边界精度定义为每个样本中预测的cnv与实际cnv边界偏差的平均值,也是评价算法好坏的重要指标。cnv的边界精度可以用如下公式(14)进行表述:

[0126][0127]

其中m为总样本数,b(x)代表了每个样本的预测cnv与实际cnv的偏差。图6为cnv_adabp与mfcnv的边界进度比较。

[0128]

从图6可以看见,六种情况下cnv_adabp的边界精度都优于mfcnv,此外,cnv_adabp出现的异常值都比mfcnv小,说明了集成学习思想有利于算法对错误的纠正,提高整体的正

确率。此外我们验证了提出的cnv_adabp和单一cnv检测方法的稳定性分析,对于cnv_adabp和mfcnv,在肿瘤纯度为0.2,0.3,0.4且网络结构相同的情况下,以第一个样本的f1-score为参照,比较了50次样本中的f1-score误差,测试结果如图7所示。

[0129]

由图7所示,图像的横坐标代表了测试的次数,也是样本的个数;纵坐标是f1-score的误差范围。在三种肿瘤纯度下连续的50次测试中,顺序使用了50个样本,扩大了测试的范围,同时每次使用不同样本也保证了测试的随机性,使得测试的结果具有说服力。两种算法的误差曲线具有重合部分,代表了在这些情况下,两个算法的稳定性是不相上下的,比如在肿瘤纯度为0.3时,前20次的测试中,两种算法误差相差不大;但是在20-30次测试时,mfcnv出现了一些较大的误差,而cnv_adabp的误差明显小于mfcnv,同样的,在纯度为0.2的测试图像中,第5次,30-50次中也都出现了cnv_adabp误差值明显小于mfcnv的情况,cnv_adabp的误差曲线基本都处于mfcnv下方,证明了cnv_adabp的稳定性要好于mfcnv,在三种纯度图像下都有体现,证明结论的非偶然性。对于某些特征不明显的样本,两种算法的误差都较大,但是cnv_adabp也能保证和mfcnv的误差接近,例如在纯度为0.2下的第10-20次测试情况。上述关于图7的分析表明,cnv_adabp的稳定性更强,这是因为基于集成学习思想检测算法相较于单一的检测算法,具有更高的容错率和纠错的能力,从而保证整体预判的正确性。

[0130]

7.2真实实验

[0131]

为了验证本算法对真实数据也有一定的普适性,本发明从1000基因项目(http://www.internationalgome.org/)上获取了na19238、na19239和na19240家庭三人组的真实样本数据进行测试,每组样本包含了三万多条数据,下图8比较了cnv_adabp与cnvnator,freec,grom-rd,mfcnv,read depth五种算法在三组真实样本下的准确率和敏感度。

[0132]

由图8可见,mfcnv在三个样本中的准确率最高,但是敏感度不高;而本发明提出的cnv_adabp在三个样本中敏感度最高,且准确率仅此于mcnv,综合f1-score可知,cnv_adabp位于图像的右上角,具有最高的f1-score。其他算法的准确率和敏感度都集中在0.6左右的位置。cnv_adabp在敏感度和准确率上取得了很好的均衡效果,具有很强的实用价值,同时我们评价了在三种真实样本下,cnv_adabp与其他方法所检测到的具体cnv数目,具体的数据统计如表1所示。

[0133]

表1:cnv_adabp与其他短发的cnv检测数目

[0134][0135]

其中cnv_adabp在三组真实样本中都取得了最高的效果,这是因为adaboost算法中每个弱分类器都具有依赖性,着重考虑错误数据的权值,以至于每次的弱分类训练都处于优化中。同时强分类器的投票机制可以有效的对误判数据进行纠正,从而使得算法整体的准确率和敏感度有较好的提升。综上所述,cnv_adabp算法对于真实数据也有较好的适应性。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。