基于mpu的车载辅助沟通系统

技术领域

1.本技术涉及手语翻译领域,尤其涉及一种基于mpu的车载辅助沟通系统。

背景技术:

2.听障人群在日常生活中只能通过手语或者文字与其他人进行交流,然而掌握手语的人毕竟是少数,常常限制了听障人群的社交,也阻碍了听障人群与外界的沟通。

3.目前,听障人群通常通过手写或者在手机上输入文字等方式与其他人进行交流,或者使用翻译设备与其他用户进行沟通。

4.但是,在听障人群外出特别是开车时采用手写或者在手机上输入文字等方式使得沟通效率较低,不能很好地与其他用户沟通。

技术实现要素:

5.本技术提供一种基于mpu的车载辅助沟通系统,用以解决听障人群在开车时不能有效地与其他用户进行无障碍沟通的问题。

6.第一方面,本技术提供一种基于mpu的车载辅助沟通系统,包括:获取单元,识别单元,微处理器mpu及输出单元;所述mpu分别与所述获取单元、所述识别单元及所述输出单元连接;

7.所述获取单元,用于获取车辆监测数据,并根据所述车辆监测数据确定是否满足预设翻译条件;

8.所述识别单元,用于若满足预设翻译条件,则采集包含身体动作的视频数据,并根据所述包含身体动作的视频数据确定对应的动作图像序列,将所述对应的动作图像序列发送至所述mpu,所述身体动作包括手部动作和/或唇语动作;

9.所述mpu,用于接收所述对应的动作图像序列,将所述对应的动作图像序列输入至训练的语义识别模型中,输出对应的语义识别结果,将所述语义识别结果发送至所述输出单元;

10.所述输出单元,用于接收所述语义识别结果,播放和/或显示所述语义识别结果。

11.可选地,所述系统还包括:生理数据采集单元,所述生理数据采集单元与所述mpu连接;

12.所述生理数据采集单元,用于获取用户当前生理特征数据,将所述当前生理特征数据发送至所述mpu;

13.所述mpu,还用于接收所述当前生理特征数据,根据所述当前生理特征数据确定用户当前情绪状态,并根据所述用户当前情绪状态确定是否需要对所述语义识别结果进行调整;

14.所述mpu,还用于若是,则对所述语义识别结果进行情绪维度的调整,将调整后的语义识别结果发送至所述输出单元;

15.所述输出单元,用于接收所述调整后的语义识别结果,播放所述所述调整后的语

义识别结果。

16.可选地,所述mpu,在根据所述用户当前情绪状态确定是否需要对所述语义识别结果进行调整时,具体用于:

17.获取预设情绪状态,所述预设情绪状态包括:伤心、生气、厌恶、惊讶、紧张及愉快中的至少一种;

18.若所述用户当前情绪状态为预设情绪状态,则确定所述语义识别结果是否包含预设情绪关键词;

19.若所述语义识别结果包含预设情绪关键词,则将所述语义识别结果中的预设情绪关键词进行删除、增加和/或替换,和/或根据用户当前情绪状态在所述语义识别结果中添加对应的表情符号,和/或对所述语义识别结果的语序进行调整。

20.可选地,所述车辆监测数据包括:车辆行驶速度及车窗位置;

21.所述获取单元,在根据所述车辆监测数据确定是否满足预设翻译条件时,具体用于:

22.若所述车辆行驶速度小于等于预设正常行驶车速和/或车窗位置位于预设位置,则确定满足预设翻译条件,所述预设位置为车辆内驾驶用户与车辆外用户之间能实现沟通的位置;

23.若所述车辆行驶速度大于预设正常行驶车速和/或车窗位置未位于预设位置,则确定不满足预设翻译条件。

24.可选地,所述识别单元,在根据所述包含身体动作的视频数据确定对应的动作图像序列时,具体用于:

25.基于时间戳信息对所述包含身体动作的视频数据进行分割,获得携带时间戳信息的动作图像序列;

26.对携带时间戳信息的动作图像序列按照时间顺序进行排序,获取排序的动作图像序列,将所述排序的动作图像序列确定为对应的动作图像序列。

27.可选地,所述语义识别模型为长短时记忆神经网络模型;

28.所述mpu,在将所述对应的动作图像序列输入至训练的语义识别模型中,输出对应的语义识别结果时,具体用于:

29.将所述对应的动作图像序列依次输入至训练的长短时记忆神经网络模型中进行特征提取,得到所述动作图像的全局特征;

30.根据所述动作图像的全局特征对所述动作图像中的身体动作进行文本预测,获得对应的文本信息,输出包含所述文本信息的语义识别结果。

31.可选地,所述mpu,还用于构建初始长短时记忆神经网络模型;

32.所述mpu,还用于将预设数据库中的样本图像输入初始长短时记忆神经网络模型进行训练,以获取训练的长短时记忆神经网络模型。

33.可选地,所述识别单元,还用于采集非沟通障碍用户的语音信息,将所述语音信息发送至所述mpu;

34.所述mpu,还用于接收所述语音信息,将所述语音信息进行转换,获取语音信息对应的文本信息和/或语音信息对应的动作图像,将所述文本信息和/或语音信息对应的动作图像发送至所述输出单元;

35.所述输出单元,还用于显示所述对应的文本信息和/或所述对应的动作图像。

36.可选地,所述mpu,在将所述语音信息进行转换,获取对应的动作图像时,具体用于:

37.对所述对应的文本信息进行分词处理,获得待处理的词语;

38.获取预设词语与预设动作图像对应的映射关系,并根据所述待处理的词语及所述映射关系确定与所述待处理的词语匹配的预设词语;

39.获取与所述待处理的词语匹配的预设词语对应的预设动作图像,将所述对应的预设动作图像确定为对应的动作图像,获取对应的动作图像。

40.可选地,所述系统还包括:输入单元,所述输入单元与所述mpu连接,所述输入单元,用于响应用户触发的翻译请求,发送翻译请求至所述mpu;

41.所述mpu,还用于接收所述翻译请求,发送翻译指令至所述识别单元;

42.所述识别单元,还用于接收所述翻译指令,采集包含身体动作的视频数据,并根据所述包含身体动作的视频数据确定对应的动作图像序列,将所述对应的动作图像序列发送至所述mpu;

43.所述mpu,还用于接收所述对应的动作图像序列,将所述对应的动作图像序列输入至训练的语义识别模型中,输出对应的语义识别结果,将所述语义识别结果发送至所述输出单元;

44.所述输出单元,还用于接收所述语义识别结果,播放和/或显示所述语义识别结果。

45.本技术提供的基于mpu的车载辅助沟通系统,所述系统包括:获取单元,识别单元,微处理器mpu及输出单元;所述mpu分别与所述获取单元、所述识别单元及所述输出单元连接;所述获取单元,用于获取车辆监测数据,并根据所述车辆监测数据确定是否满足预设翻译条件;所述识别单元,用于若满足预设翻译条件,则采集包含身体动作的视频数据,并根据所述包含身体动作的视频数据确定对应的动作图像序列,将所述对应的动作图像序列发送至所述mpu,所述身体动作包括手部动作和/或唇语动作;所述mpu,用于接收所述对应的动作图像序列,将所述对应的动作图像序列输入至训练的语义识别模型中,输出对应的语义识别结果,将所述语义识别结果发送至所述输出单元;所述输出单元,用于接收所述语义识别结果,播放和/或显示所述语义识别结果,车载辅助沟通系统能够识别用户的手语或唇语,辅助用户进行翻译,输出翻译结果,不仅能够提高翻译效率,而且能够实现在驾车过程中的无障碍沟通。

附图说明

46.此处的附图被并入说明书中并构成本说明书的一部分,示出了符合本技术的实施例,并与说明书一起用于解释本技术的原理。

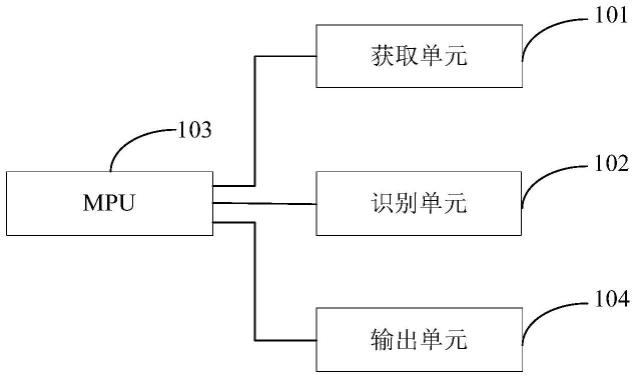

47.图1为本发明一实施例提供的基于mpu的车载辅助沟通系统的结构示意图;

48.图2为本发明又一实施例提供的基于mpu的车载辅助沟通系统的结构示意图;

49.图3为本发明又一实施例提供的基于mpu的车载辅助沟通系统的结构示意图。

50.符号说明:

51.101-获取单元

ꢀꢀꢀꢀꢀꢀꢀꢀꢀ

102-识别单元

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

103-mpu

52.104-输出单元

ꢀꢀꢀꢀꢀꢀꢀ

105-车载电子标签

ꢀꢀꢀꢀꢀ

105-生理数据采集单元

53.106-输入单元

54.通过上述附图,已示出本技术明确的实施例,后文中将有更详细的描述。这些附图和文字描述并不是为了通过任何方式限制本技术构思的范围,而是通过参考特定实施例为本领域技术人员说明本技术的概念。

具体实施方式

55.这里将详细地对示例性实施例进行说明,其示例表示在附图中。下面的描述涉及附图时,除非另有表示,不同附图中的相同数字表示相同或相似的要素。以下示例性实施例中所描述的实施方式并不代表与本技术相一致的所有实施方式。相反,它们仅是与如所附权利要求书中所详述的、本技术的一些方面相一致的装置和方法的例子。

56.为了清楚理解本技术的技术方案,首先对现有技术的方案进行详细介绍。

57.听障人群在日常生活中只能通过手语或者借助文字与其他人进行交流,手语作为一种视觉语言,可协助聋哑人表达自身想法,在聋哑人与他人之间构建起沟通途径,帮助聋哑人融入社会。然而掌握手语的人毕竟是少数,常常限制了听障人群的社交,也阻碍了听障人群与外界的沟通。目前,听障人群通常通过手写或者在手机上输入文字等方式与其他人进行交流,或者使用翻译设备与其他用户进行沟通。

58.但是,在听障人群外出特别是开车时采用手写或者在手机上输入文字等方式使得沟通效率较低,特别是其他用户无法直观地理解听障人群所表达的含义,不能有效地与其他用户沟通。

59.所以针对现有听障人群在开车时不能有效地与其他用户进行沟通的问题,发明人在研究中发现,基于mpu的车载辅助沟通系统包括获取单元,识别单元,微处理器mpu及输出单元;mpu分别与获取单元、识别单元及输出单元连接;获取单元,用于获取车辆监测数据,并根据车辆监测数据确定是否满足预设翻译条件;识别单元,用于若满足预设翻译条件,则采集包含身体动作的视频数据,并根据包含身体动作的视频数据确定对应的动作图像序列,将对应的动作图像序列发送至mpu,身体动作包括手部动作和/或唇语动作;mpu,用于接收对应的动作图像序列,将对应的动作图像序列输入至训练的语义识别模型中,输出对应的语义识别结果,将语义识别结果发送至输出单元;输出单元,用于接收语义识别结果,播放和/或显示语义识别结果。车载辅助沟通系统能够识别用户的手语或唇语,辅助用户进行翻译,输出翻译结果,不仅能够提高翻译效率,而且能够实现在驾车过程中的无障碍沟通。

60.以下将参照附图来具体描述本发明的实施例。

61.图1为本发明一实施例提供的基于mpu的车载辅助沟通系统的结构示意图。

62.本发明提供的基于mpu的车载辅助沟通系统中,包括:获取单元101,识别单元102,微处理器mpu103及输出单元104;mpu103分别与获取单元101、识别单元102及输出单元104连接;获取单元101,用于获取车辆监测数据,并根据车辆监测数据确定是否满足预设翻译条件;识别单元102,用于若满足预设翻译条件,则采集包含身体动作的视频数据,并根据包含身体动作的视频数据确定对应的动作图像序列,将对应的动作图像序列发送至mpu103,身体动作包括手部动作和/或唇语动作;mpu103,用于接收对应的动作图像序列,将对应的动作图像序列输入至训练的语义识别模型中,输出对应的语义识别结果,将语义识别结果

发送至输出单元104;输出单元104,用于接收语义识别结果,播放和/或显示语义识别结果。

63.本实施例中,基于mpu103的车载辅助沟通系统中,包括获取单元101,识别单元102,mpu103及输出单元104,其中,mpu103分别与获取单元101,识别单元102及输出单元104连接。

64.其中,获取单元101获取车辆监测数据,其中,车辆监测数据包括车辆行驶速度及车窗位置,获取单元101根据车辆监测数据确定是否满足预设翻译条件;如果满足预设翻译条件,说明此时用户需要与其他用户沟通。

65.其中,识别单元102采集包含身体动作的视频数据,并根据包含身体动作的视频数据确定对应的动作图像序列,身体动作包括手部动作和/或唇语动作,识别单元102将对应的动作图像序列发送至mpu103。

66.其中,mpu103接收识别单元102发送的对应的动作图像序列,将对应的动作图像序列输入至训练的语义识别模型中,输出对应的语义识别结果,获得手语翻译结果。预先对语义识别模型进行训练,采用训练的语义识别模型进行语义识别。mpu103将语义识别结果发送至输出单元104。

67.其中,输出单元104接收mpu103发送的语义识别结果,输出单元104播放和/显示语义识别结果,从而实现与其他用户的沟通。

68.此外,身体动作还可以包括点头等简单的非手部动作的肢体动作,并不限于手部动作及唇语动作。

69.本实施例中,车载辅助沟通系统通过识别用户的手语、唇语,辅助用户进行翻译,输出翻译结果,不仅能够提高翻译效率,而且能够实现在驾车过程中的无障碍沟通。

70.图2为本发明又一实施例提供的基于mpu的车载辅助沟通系统的结构示意图。

71.基于mpu的车载辅助沟通系统还包括:生理数据采集单元105,生理数据采集单元105与mpu103连接;生理数据采集单元105,用于获取用户当前生理特征数据,将当前生理特征数据发送至mpu103;mpu103,还用于接收当前生理特征数据,根据当前生理特征数据确定用户当前情绪状态,并根据用户当前情绪状态确定是否需要对语义识别结果进行调整;mpu103,还用于若是,则对语义识别结果进行情绪维度的调整,将调整后的语义识别结果发送至输出单元104;输出单元104,用于接收调整后的语义识别结果,播放调整后的语义识别结果。

72.参见图2,车载辅助沟通系统还包括生理数据采集单元105,生理数据采集单元105与mpu103连接,生理数据采集单元105获取用户当前生理特征数据,生理数据采集单元105为可穿戴设备,如智能手表、智能手环,用户佩戴可穿戴设备,车载辅助沟通系统通过可穿戴设备获取用户的生理数据。其中,生理特征数据包括心率,血压。进一步根据生理特征数据确定用户当前情绪状态。生理数据采集单元105将用户当前生理特征数据发送至mpu103。

73.其中,mpu103接收生理数据采集单元105采集的用户当前生理特征数据,mpu103根据用户当前生理确定用户当前情绪状态,mpu103根据用户当前情绪状态确定是否需要对语义识别结果进行调整,当用户停车与其他用户沟通时,可能是因为道路规则或是出现了突发事件所以需要与其他用户沟通,此时用户的心情可能是紧张或者是生气,语义识别结果由是基于用户的手语识别得到的,语义识别结果缺少感情色彩,为了能够更好地表达用户的心情,在播放的时可以对语义识别结果进行适当调整。若需要对语义识别结果进行调整,

mpu103对语义识别结果进行情绪纬度的调整,将调整后的语义识别结果发送至输出单元104。

74.其中,输出单元104接收mpu103发送的调整后的语义识别结果,播放调整后的语义识别结果。

75.本实施例中,车载辅助沟通系统根据生理特征数据确定用户当前情绪状态,根据当前情绪状态确定是否对语义识别结果进行调整,若是,则对语义识别结果进行情绪纬度的调整,从而播放经过调整的语义识别结果,有效地结合用户情绪,赋予语义识别结果感情色彩,能够更好的辅助用户表达。

76.进一步地,在一实施例的基础上,mpu,在根据用户当前情绪状态确定是否需要对语义识别结果进行调整时,具体用于:获取预设情绪状态,预设情绪状态包括:伤心、生气、厌恶、惊讶、紧张及愉快中的至少一种;若用户当前情绪状态为预设情绪状态,则确定语义识别结果是否包含预设情绪关键词;若语义识别结果包含预设情绪关键词,则将语义识别结果中的预设情绪关键词进行删除、增加和/或替换,和/或根据用户当前情绪状态在语义识别结果中添加对应的表情符号,和/或对语义识别结果的语序进行调整。

77.本实施例中,mpu获取预设情绪状态,其中,预设情绪状态包括伤心、生气、厌恶、惊讶、紧张及愉快中的至少一种。若确定用户当前情绪状态为预设情绪状态,如说明用户当前的情绪可能是伤心或者是生气,为了更好地辅助用户表达,mpu确定语义识别结果是否包含预设情绪关键词。若语义识别结果包含预设情绪关键词,将语义识别结果中的预设情绪关键词进行删除、增加和/替换,紧张/着急的时候语义为“给我拿一根笔!”表示比较急切;高兴或平静时可以调整为“请给我拿一根笔。”会更加平和,因此,如识别到情绪关键词“给我”,且对应的情绪为高兴时,增加关键词“请”;如识别到用户的当前情绪状态为生气,若语义识别结果为“你不知道吗”,识别到预设关键词为不知道,结合用户的当前的情绪,对“你不知道吗”进行替换调整,在映射关系库中预设情绪为生气对应的预设情绪关键词“不知道”的映射关键词为“你难度不知道吗”,将不知道替换为难道不知道,调整为“你难度不知道吗”;另一个实施例中,高兴或平静时语义为“给我拿一根笔”,紧张/着急的时候语义为“拿一根笔”因此,如识别到情绪关键词“给我”,且对应的情绪为紧张/着急的时候,删除该关键词;通过删除、增加和/或替换,以调整语义识别结果。和/或根据用户当前状态在语音识别结果中添加对应的表情符号,如,用户当前状态为高兴,在语音识别结果中添加对应的微笑的表情符号。和/或对语义识别结果的语序进行调整,语序是指语言里语素、词组合的次序,包括主语、谓语和宾语的排列顺序、修饰语与中心语的排列顺序、修饰语之间的排列顺序,通过调整语序实现对语义识别结果的调整。

78.本实施例中,对于语音播报,听者的感受也是不一样的。好比“你这个傻子”凶一点就是骂人的,而温和一点就是不一样的,可以代表调侃。因此可以根据用户情绪调整语音播报的语音语气。

79.本实施例中,有效地结合用户情绪,赋予语义识别结果感情色彩,通过车载辅助沟通系统能够更好的辅助用户表达,也能使对方更好地了解用户的状态。

80.进一步地,在一实施例的基础上,车辆监测数据包括:车辆行驶速度及车窗位置;获取单元,在根据车辆监测数据确定是否满足预设翻译条件时,具体用于:若车辆行驶速度小于等于预设正常行驶车速和/或车窗位置位于预设位置,则确定满足预设翻译条件,预设

位置为车辆内驾驶用户与车辆外用户之间能实现沟通的位置;若车辆行驶速度大于预设正常行驶车速和/或车窗位置未位于预设位置,则确定不满足预设翻译条件。

81.本实施例中,车辆监测数据包括车辆行驶速度及车窗位置。若车辆行驶速度小于等于预设正常行驶车速和/或车窗位置位于预设位置,车辆行驶速度小于等于预设正常行驶车速说明车速下降,车窗位置位于预设位置说明车窗已打开,其中,预设位置为车辆内驾驶用户与车辆外用户之间能实现沟通的位置,用户需要与其他用户沟通,获取单元确定满足预设翻译条件。

82.进一步,若车辆行驶速度大于预设正常行驶车速和/或车窗位置未位于预设位置,车辆行驶速度大于预设正常行驶车速说明车速未下降,车窗位置未位于预设位置说明车窗开启的位置比较小,用户不需要与其他用户沟通,获取单元确定不满足预设翻译条件。

83.本实施例中,通过车速和/车窗能能够准备判断用户是否要与外界用户沟通。

84.进一步地,在一实施例的基础上,识别单元,在根据包含身体动作的视频数据确定对应的动作图像序列时,具体用于:基于时间戳信息对包含身体动作的视频数据进行分割,获得携带时间戳信息的动作图像序列;对携带时间戳信息的动作图像序列按照时间顺序进行排序,获取排序的动作图像序列,将排序的动作图像序列确定为对应的动作图像序列。

85.本实施例中,时间戳(timestamp)是一种标准的时间表示方式,通常是一个字符序列,用以唯一的标识某一时刻的时间。识别单元基于时间戳信息将包含身体动作的视频数据进行分割,得到携带时间戳信息的动作图像序列。为了能够得到词语顺序与动作图像顺序一致的语义识别结果,识别单元对携带时间戳信息的动作图像序列按照时间顺序进行排序,获取排序的动作图像序列,识别单元将排序后的动作图像序列确定为对应的动作图像序列。

86.本实施例中,车载辅助沟通系统能够对动作图像的排序,能够使语义识别结果中的词语顺序与动作图像顺序保持一致,更好地辅助用户表达。

87.进一步地,在一实施例的基础上,语义识别模型为长短时记忆神经网络模型;mpu,在将对应的动作图像序列输入至训练的语义识别模型中,输出对应的语义识别结果时,具体用于:将对应的动作图像序列依次输入至训练的长短时记忆神经网络模型中进行特征提取,得到动作图像的全局特征;根据动作图像的全局特征对动作图像中的身体动作进行文本预测,获得对应的文本信息,输出包含文本信息的语义识别结果。

88.本实施例中,语义识别模型为长短时记忆神经网络模型,其中,长短期记忆(long-short term memory,lstm)是一种时间递归神经网络(rnn)。mpu将对应的动作图像序列依次输入到训练的长短时记忆神经网络模型中进行特征提取,得到动作图像的全局特征,具体地,mpu将动作图像序列依次输入至lstm的卷积层进行局部特征提取,得到多个动作图像的多个局部特征,每一个局部特征对应一个动作图像,通过lstm的全连接层对动作图像的多个局部特征进行全连接,得到动作图像的全局特征。

89.需要说明的是,语义识别模型还可以是多层卷积神经网络(cnn)、循环神经网络(rnn)、深度神经网络(dnn)、双向长短期记忆循环神经网络(bi-lstm)等,不仅限于lstm。

90.进一步地,mpu根据动作图像的全局特征对动作图像中的身体动作进行文本预测,具体地,确定动作图像的全局特征对应的概率值,概率值为动作图像的全局特征属于数据库中预设文本信息的各概率值,概率最大值的动作图像的全局特征所属文本信息即为身体

动作对应的文本信息,输出包含文本信息的语义识别结果。

91.本实施例中,车载辅助沟通系统采用神经网络模型进行语义识别,能够提高车载辅助沟通系统手语识别的准确度,得到较为准确的语义识别结果,从而更好地辅助用户沟通。

92.进一步的,在一实施例的基础上,mpu,还用于构建初始长短时记忆神经网络模型;mpu,还用于将预设数据库中的样本图像输入初始长短时记忆神经网络模型进行训练,以获取训练的长短时记忆神经网络模型。

93.本实施例中,mpu构建初始长短时记忆神经网络模型,预先构建数据库,数据库中包含多个样本图像,样本图像用于训练,样本图像可以是预先经过幂律转换处理、形态学处理及降噪处理的样本图像。mpu将预设数据库中的样本图像输入至初始长短时记忆神经网络模型进行训练,设置最大期望函数或余弦损失函数,从而根据最大期望函数或余弦损失函数判断模型是否为最优。如果未达到最优,更新长短时记忆神经网络模型的模型参数。如果达到最优或者迭代次数达到预设迭代次数达,可停止迭代。其中,预设迭代次数达可以根据实际进行设定。若迭代次数达到预设迭代次数达,说明长短时记忆神经网络模型收敛,训练完成,获得训练的长短时记忆神经网络模型。

94.本实施例中,车载辅助沟通系统通过对长短时记忆神经网络模型进行训练,能够得到较为准确的语义识别结果。

95.进一步地,在上述实施例的基础上,识别单元,还用于采集非沟通障碍用户的语音信息,将语音信息发送至mpu;mpu,还用于接收语音信息,将语音信息进行转换,获取语音信息对应的文本信息和/或语音信息对应的动作图像,将文本信息和/或语音信息对应的动作图像发送至输出单元;输出单元,还用于显示对应的文本信息和/或对应的动作图像。

96.本实施例中,听障用户虽然能够通过用户的唇语了解表达的内容,但是有些词语的发音是一样的,可能会产生歧义,识别单元采集非沟通障碍用户的语音信息,识别单元将语音信息发送至mpu。

97.其中,mpu接收识别单元发送的语音信息,mpu将语音信息进行转换,获取语音信息对应的文本信息和/或动作图像,将文本信息和/或动作图像发送至输出单元。输出单元接收文本信息和/或动作图像,输出单元显示对应的文本信息和/或对应的动作图像。

98.本实施例中,将非沟通障碍用户语音信息转换为文本信息和/或动作图像,车载辅助沟通系统能够帮助很好地帮助用户与外界沟通,有效提供沟通效率。进一步地,在一实施例的基础上,mpu,在将语音信息进行转换,获取对应的动作图像时,具体用于:对对应的文本信息进行分词处理,获得待处理的词语;获取预设词语与预设动作图像对应的映射关系,并根据待处理的词语及映射关系确定与待处理的词语匹配的预设词语;获取与待处理的词语匹配的预设词语对应的预设动作图像,将对应的预设动作图像确定为对应的动作图像,获取对应的动作图像。

99.本实施例中,mpu对转换后的文本信息进行分词处理,获得转换后的文本信息对应的多个词语,将多个词语确定为待处理的词语。预先构建预设词语与预设动作图像对应的映射关系,mpu获取预设词语与预设动作图像对应的映射关系,mpu根据待处理的词语与映射关系确定与待处理的词语匹配的预设词语,具体地,mpu将待处理的词语与映射关系中的预设词语进行匹配,从而确定与待处理的词语匹配的预设词语。mpu获取与待处理的词语匹

配的预设词语对应的预设动作图像,该动作图像即为其他用户所表达的含义,mpu将对应的预设动作图像确定为对应的动作图像。

100.本实施例中,车载辅助沟通对非沟通障碍用户语音信息进行转换,便于听障用户更好地与非沟通障碍用户语音信息进行沟通,以实现无障碍沟通。

101.图3为本发明又一实施例提供的基于mpu的车载辅助沟通系统的结构示意图。

102.基于mpu的车载辅助沟通系统还包括:输入单元106,输入单元106与mpu103连接,输入单元106,用于响应用户触发的翻译请求,发送翻译请求至mpu103;mpu103,还用于接收翻译请求,发送翻译指令至识别单元102;识别单元102,还用于接收翻译指令,采集包含身体动作的视频数据,并根据包含身体动作的视频数据确定对应的动作图像序列,将对应的动作图像序列发送至mpu103;mpu103,还用于接收对应的动作图像序列,将对应的动作图像序列输入至训练的语义识别模型中,输出对应的语义识别结果,将语义识别结果发送至输出单元104;输出单元104,还用于接收语义识别结果,播放和/或显示语义识别结果。

103.参见图3,载辅助沟通系统还包括输入单元106,输入单元106与mpu103连接,输入单元106可以是翻译按键,若用户点击翻译按键,由此触发翻译请求,从而实现手动触发翻译。输入单元106响应于用户触发的翻译请求,发送翻译请求至mpu103。

104.其中,mpu103接收翻译请求,mpu103向识别单元102发送翻译指令,识别单元102接收翻译指令,采集包含身体动作的视频数据,并根据包含身体动作的视频数据确定对应的动作图像序列,识别单元102将对应的动作图像序列发送至mpu103。

105.其中,mpu103接收识别单元102发送的对应的动作图像序列,将对应的动作图像序列输入至训练的语义识别模型中,输出对应的语义识别结果,获得手语翻译结果。预先对语义识别模型进行训练,采用训练的语义识别模型进行语义识别。mpu103将语义识别结果发送至输出单元104。

106.其中,输出单元104接收mpu103发送的语义识别结果,输出单元104播放和/显示语义识别结果,从而实现与其他用户的沟通。

107.本实施例中,车载辅助沟通系统能够响应于用户触发的翻译请求从而进行翻译,输出翻译结果,不仅能够提高翻译效率,而且能够实现无障碍沟通。

108.本领域技术人员在考虑说明书及实践这里公开的发明后,将容易想到本发明的其它实施方案。本发明旨在涵盖本发明的任何变型、用途或者适应性变化,这些变型、用途或者适应性变化遵循本发明的一般性原理并包括本发明未公开的本技术领域中的公知常识或惯用技术手段。说明书和实施例仅被视为示例性的,本发明的真正范围和精神由下面的权利要求书指出。

109.应当理解的是,本发明并不局限于上面已经描述并在附图中示出的精确结构,并且可以在不脱离其范围进行各种修改和改变。本发明的范围仅由所附的权利要求书来限制。

再多了解一些

本文用于创业者技术爱好者查询,仅供学习研究,如用于商业用途,请联系技术所有人。