1.本发明涉及检测装置、追踪装置、检测程序以及追踪程序,例如,涉及追踪行人的检测装置、追踪装置、检测程序以及追踪程序。

背景技术:

2.近年来,酒店的引导机器人、扫除机器人等在生活环境中活用的机器人的开发正积极地进行。特别期待这些机器人在伴随着将来的人口减少的人手不足的消除、生活辅助等、例如商业设施、工厂、护理事业等中发挥积极作用。

3.为了在人的生活环境内动作,需要把握作为追踪对象的人、应该避开的障碍物这样的周边环境。

4.关于这样的技术,有专利文献1的“自主移动机器人、自主移动机器人的控制方法以及控制程序”。

5.在该技术中,预测作为追踪对象的人的移动目的地,并且预测遮挡拍摄人的相机的视野的障碍物的移动目的地,变更相机的视野以使得在障碍物遮蔽人的情况下所拍摄的人的面积变大。

6.然而,在像这样由机器人识别并追踪步行的人的情况下,人在机器人的近距离处频繁地随意进行方向转换、速度变更,所以如何不丢失而稳健地追踪成为课题。

7.专利文献1:日本特开2018-147337号公报。

技术实现要素:

8.本发明将可靠地检测对象作为第一目的。

9.另外,将稳健地追踪对象作为第二目的。

10.(1)本发明提供一种检测装置,设置于行驶体、建筑物等,检测规定的对象,上述检测装置的特征在于,具备:拍摄单元,通过配设于比规定的水平面靠上侧的上相机和配设于比上述水平面靠下侧的下相机来以广角拍摄上述对象;以及检测单元,通过在上述上相机的上相机图像和上述下相机的下相机图像中分别进行图像识别来检测所拍摄的上述对象。

11.(2)另外,在本发明中,提供一种追踪装置,其具备粒子产生单元、上述技术方案1所述的检测装置、似然度获取单元以及追踪单元,上述粒子产生单元基于对象存在的位置的概率分布在三维空间内产生粒子滤波器所使用的粒子,上述追踪装置的特征在于,上述检测装置的上述拍摄单元通过使用了配设于比规定的水平面靠上侧的上相机和配设于比上述水平面靠下侧的下相机的会聚立体相机来拍摄上述对象,上述检测装置的上述检测单元具备:映射单元,将所产生的上述粒子建立对应关系地映射到由上述上相机和上述下相机分别拍摄到的上相机图像和下相机图像;以及图像识别单元,基于所映射的上述粒子在上述上相机图像和上述下相机图像中的各自的位置来在上述上相机图像和上述下相机图像中设定检测区域,并且在上述上相机图像和下相机图像中分别对所拍摄的上述对象进行图像识别,上述似然度获取单元使用基于上述上相机图像的图像识别的第一似然度和基于

上述下相机图像的图像识别的第二似然度中的至少一方,获取所产生的上述粒子的似然度,上述追踪单元通过基于获取到的上述似然度更新上述概率分布,来追踪上述对象存在的位置,上述粒子产生单元依次基于更新后的上述概率分布来产生粒子。

12.(3)另外,在本发明中,提供一种检测程序,使计算机作为设置于行驶体、建筑物等并检测规定的对象的检测装置发挥作用,上述检测程序的特征在于,使计算机实现以下功能:拍摄功能,通过配设于比规定的水平面靠上侧的上相机和配设于比上述水平面靠下侧的下相机来以广角拍摄上述对象;以及检测功能,通过在上述上相机的上相机图像和上述下相机的下相机图像中分别进行图像识别来检测所拍摄的上述对象。

13.(4)另外,在本发明中,提供一种追踪程序,由计算机实现以下功能:粒子产生功能,基于对象存在的位置的概率分布在三维空间内产生粒子滤波器所使用的粒子;拍摄功能,通过使用了配设于比规定的水平面靠上侧的上相机和配设于比上述水平面靠下侧的下相机的会聚立体相机来拍摄上述对象;映射功能,将所产生的上述粒子建立对应关系地映射到由上述上相机和上述下相机分别拍摄到的上相机图像和下相机图像;图像识别功能,基于所映射的上述粒子在上述上相机图像和上述下相机图像中的各自的位置来在上述上相机图像和上述下相机图像中设定检测区域,并且在上述上相机图像和上述下相机图像中分别对所拍摄的上述对象进行图像识别;似然度获取功能,使用基于上述上相机图像的图像识别的第一似然度和基于上述下相机图像的图像识别的第二似然度中的至少一方,获取所产生的上述粒子的似然度;以及追踪功能,通过基于获取到的上述似然度更新上述概率分布,来追踪上述对象存在的位置,上述粒子产生功能依次基于更新后的上述概率分布来产生粒子。

14.根据技术方案1所述的检测装置,利用配设于比规定的水平面靠上侧的上相机和配设于比水平面靠下侧的下相机,分别进行图像识别,由此来检测所拍摄的对象,所以能够可靠地检测对象。

15.根据技术方案2所述的追踪装置,通过在对象存在的三维空间产生粒子,并更新追踪对象的位置的概率分布,由此能够稳健地追踪追踪对象。

附图说明

16.图1是表示第一实施方式的追踪机器人的外观例的图。

17.图2是表示追踪装置的硬件结构的图。

18.图3是用于对拍摄立体图像的虚拟相机进行说明的图。

19.图4是用于对到对象的距离和方位的计测方法进行说明的图。

20.图5是用于对会聚立体方式的优势进行说明的图。

21.图6是用于对粒子的产生方法进行说明的图。

22.图7是用于对粒子向相机图像的映射进行说明的图。

23.图8是用于对利用虚拟相机追踪对象者的位置的方法进行说明的图。

24.图9是用于对似然度的计算方法进行说明的图。

25.图10是用于对追踪处理进行说明的流程图。

26.图11是表示第二实施方式的追踪机器人的外观例的图。

27.图12是用于对第二实施方式中的测量方法进行说明的图。

具体实施方式

28.(1)实施方式的概要

29.追踪装置1(图2)具备配设于追踪机器人的左右的全天球相机9a、9b。

30.追踪装置1将由全天球相机9a拍摄到的左全天球相机图像粘贴到球形物体30a(图3的(a)),在球形物体30a(图3的(a))的内部设置虚拟相机31a。

31.虚拟相机31a能够在形成于球形物体30a的内部的虚拟的拍摄空间自由旋转,获取外界的左相机图像。

32.追踪装置1也设置同样地从由全天球相机9b拍摄到的右全天球相机图像获取右相机图像的虚拟相机31b,通过虚拟相机31a、31b构成会聚立体相机。

33.追踪装置1使用这样构成的会聚立体相机,通过粒子滤波器追踪对象者8的位置。

34.追踪装置1使粒子在对象者8存在的空间三维地产生,但对象者8假设为行人,并与步行面平行地移动,所以在对象者8的躯干程度的高度的与步行面平行的平面,在以对象者8为中心的圆形区域32附近产生许多粒子。

35.而且,追踪装置1利用虚拟相机31a、31b获取左相机图像和右相机图像,将在对象者8步行的实际空间产生的粒子建立对应关系地分别映射到左右的相机图像。

36.即,将产生的粒子分别投影到左右的相机图像,将映射到左相机图像和右相机图像的粒子建立对应关系,从而能够识别这些粒子在三维空间是同一粒子。

37.接下来,追踪装置1基于映射的对应的粒子在左相机图像和右相机图像中分别设定检测区域,在左相机图像和右相机图像的各个中对对象者8进行图像识别。

38.追踪装置1根据图像识别的结果,基于左相机图像中的似然度和右相机图像中的似然度,设为在对象者8存在的实际空间产生的粒子的似然度。例如,追踪装置1对左相机图像中的似然度和右相机图像中的似然度进行平均,来设为在对象者8存在的实际空间产生的粒子的似然度。

39.这样,追踪装置1计算在实际空间中在对象者8的周围产生的各个粒子的似然度,基于似然度进行各粒子的加权。通过该加权的分布,能够得到对象者8存在的位置的概率分布。

40.根据该概率分布,能够推断在三维实际空间中,对象者8以何种程度的概率存在于哪一部分的空间(这里,由于粒子散布在躯干的高度程度,所以为躯干存在的空间)。

41.由此,能够得到对象者8的位置(概率密度高的场所)。

42.而且,追踪装置1通过对于权重较大的粒子,使其成为重采样的对象,而权重较小的粒子被删除,来重采样对象者8以更新概率分布。

43.即,在权重较大的粒子的周围,随机地产生许多粒子,对于权重较小的粒子,不产生粒子(或者,较少地产生)。

44.由此,能够得到与当前的对象者8的概率分布对应的粒子的密度(浓淡)的分布。

45.追踪装置1新获取左右的图像,计算这些新产生的粒子的似然度,更新权重。由此,概率分布被更新。

46.该追踪装置1通过反复进行该处理,能够追踪对象者8的当前位置(即,最新的概率分布)。

47.像这样,追踪装置1通过反复进行粒子的产生、似然度的观测、粒子的加权、重采样

的粒子滤波器,追踪对象者8存在的概率较高的位置。

48.而且,追踪装置1通过利用虚拟相机31a、31b会聚观察对象者8存在的概率较高的场所并进行测量,来计算到对象者8的距离d、对象者8存在的角度θ,并基于此控制追踪机器人的移动。

49.此外,对象者8的位置由(d,θ,高度z)的圆筒坐标系表示,但由于认为行人的高度z恒定,所以通过(d,θ)表示对象者8的位置。

50.在第二实施方式中,在上下方向上配设全天球相机9a、9b,在上下方向上配设虚拟相机31a、31b。

51.通过上下设置虚拟相机31a、31b,能够360度无死角地拍摄/测量对象者8的步行环境。

52.(2)实施方式的详细

53.(第一实施方式)

54.图1的各图是表示第一实施方式的追踪机器人12的外观例子的图。

55.追踪机器人12是识别追踪对象并从后方追踪追踪对象的自主移动型的追踪机器人。

56.以下,主要将追踪对象设为行人。这是一个例子,能够将追踪对象设为车辆、无人机这样的飞行体等其他的移动体。

57.图1的(a)示出将追踪本身作为主要目的,由三轮车紧凑地构成追踪机器人12a的例子。

58.例如,能够看护散步的儿童、老年人、或跟随担当者进入作业现场、灾害现场等收集信息、或追踪并监视/观察家畜等动物、或进行追踪/监视以免对象者侵入限制区域等。

59.追踪机器人12a具备圆柱状的壳体15,该圆柱状的壳体15具备构成驱动轮的一对后轮16、进行方向转换并引导追踪方向的一个前轮17。

60.此外,这些车轮也可以为在推土机等中利用的环形轨道、昆虫的节肢部那样的腿构造。

61.在壳体15的上表面的中央附近,高度大约为行人的躯干的高度程度的柱状部件竖立在垂直上方,在其前端设置有拍摄部11。

62.拍摄部11具有在水平方向上分离30cm左右地设置的2个全天球相机9a、9b。以下,在不特别区别它们的情况下仅省略记载为全天球相机9,其他的结构要素也相同。

63.全天球相机9a、9b分别通过组合鱼眼镜头而构成,能够得到360度的视野。供追踪机器人12a搭载的追踪装置1(图2)通过从全天球相机9a、9b拍摄到的各个全天球相机图像切出平面图像的虚拟的虚拟相机31a、31b对追踪对象进行立体观察,通过三角测量来测量追踪对象的距离和方位(角度、方向)。

64.追踪机器人12a基于该测量结果在追踪对象的后方移动,并对其进行跟踪。

65.在壳体15的内部收纳有构成追踪装置1的计算机、用于与服务器、移动终端等进行通信的通信装置、供给电力的电池、以及驱动车轮的驱动装置等。

66.图1的(b)示出在追踪机器人12b具备积载功能的例子。

67.追踪机器人12b具备将行进方向作为长边方向的壳体20。壳体20除了收纳计算机、通信装置、电池、驱动装置等之外,还例如能够装备装载平台、收纳盒、鞍型的座椅。

68.在壳体20的上表面前端部分设置有与追踪机器人12a相同的拍摄部11。

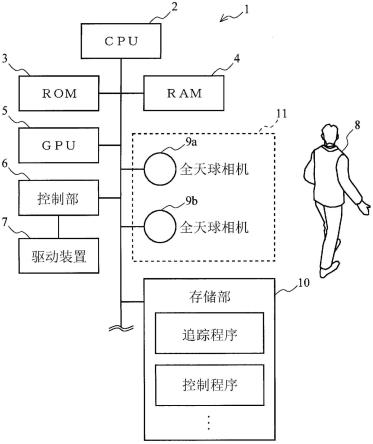

69.并且,追踪机器人12b具备构成驱动轮的一对后轮21、和进行方向转换并引导追踪方向的一对前轮22。这些车轮也可以为环形轨道、腿结构。

70.追踪机器人12b例如能够进行货物的搬运辅助、或人坐在座椅上来搬运。另外,对于多个追踪机器人12b,设定为开头的追踪机器人12b对追踪对象进行追踪,其他的追踪机器人12b跟踪之前的追踪机器人12b,由此,也能够构成为多个追踪机器人12b通过软件连结并纵列行驶。由此,一名引导者能够搬运较多的货物。

71.图1的(c)示出将追踪机器人12c搭载于无人机的例子。

72.在壳体25的上表面设置有使追踪装置1漂浮的多个螺旋桨26,在底面之下悬挂拍摄部11。追踪机器人12c在空中漂浮/飞行并且追踪目标。

73.例如,能够在感冒流行时,追踪不戴口罩的人,从搭载的扩声器提醒“请戴上口罩”等。

74.图2是表示追踪装置1的硬件结构的图。

75.追踪装置1通过利用总线连接cpu(central processing unit:中央处理单元)2、rom(read only memory:只读存储器)3、ram(randomaccess memory:随机存取存储器)4、gpu(graphics processing unit:图形处理单元)5、拍摄部11、存储部10、控制部6、驱动装置7等而构成。

76.追踪装置1通过使用了立体相机图像的图形识别来三维地追踪对象者8的位置。这里,假设行人作为对象者8。

77.cpu2根据存储部10存储的追踪程序对对象者8进行图像识别,测量其位置,或根据控制程序使控制部6发出用于追踪机器人12移动的指令。

78.rom3是存储有用于cpu2使追踪装置1动作的基本程序、参数等的只读存储器。

79.ram4是提供用于cpu2进行上述处理的工作存储器的可读写存储器。

80.拍摄部11拍摄到的图像在ram4展开并由cpu2利用。

81.gpu5是具有同时并行地进行多个计算的功能的运算装置,在本实施方式中,用于高速地并行处理基于大量产生的粒子的每个粒子的图像处理。

82.拍摄部11使用能够一次获取周围360度的彩色图像的全天球相机9a、9b来构成。

83.全天球相机9a、9b设置为在水平方向上分离规定的距离(这里为30cm左右),获取立体观察对象者8而得到的图像。

84.在对象者8位于追踪装置1的正面的情况下,全天球相机9a位于对象者8的左侧,全天球相机9b位于右侧。在对象者8转到追踪装置1的背后的情况下,左右反转。

85.全天球相机9a、9b是视野为360度的广角相机,所以像这样,追踪装置1具备从左广角相机和右广角相机分别获取左广角图像和右广角图像的广角图像获取单元,这些左广角相机和右广角相机分别由左全天球相机(在对象者8位于追踪机器人12的正面的情况下为全天球相机9a)和右全天球相机(全天球相机9b)构成。此外,即使这些广角相机的视野为360度以下,追踪范围被限制,但仍能够构成追踪装置1。

86.以下,对对象者8位于追踪装置1的正面的情况进行说明,全天球相机9a从左侧拍摄对象者8,全天球相机9b从右侧拍摄对象者8。

87.在对象者8位于追踪装置1的背面侧的情况下,替换说明的左右即可。

88.驱动装置7由驱动车轮的马达等构成,控制部6基于来自cpu2的信号控制驱动装置7来调节行驶速度、旋转方向等。

89.图3的各图是用于对拍摄对象者8的立体图像的虚拟相机进行说明的图。

90.全天球相机9a通过组合2个鱼眼镜头而构成,将由它们拍摄到的左全天球相机图像粘贴到图3的(a)所示的球形物体30a的表面,从而由一个球体构建2个鱼眼相机图像。

91.由此,能够形成表面为全天球相机9a的周围360度的景色的地球仪这样的物体。

92.而且,在球形物体30a的内侧设置由虚拟的针孔相机构成的虚拟相机31a,通过利用软件虚拟地使虚拟相机31a旋转,从而对于在虚拟相机31a的拍摄方向上观察到的周围的景色,能够获取与由单眼相机拍摄时相同的形变较小的左相机图像。

93.虚拟相机31a能够在球形物体30a中自由且连续地或者离散地旋转以选择拍摄方向。

94.由此,能够如箭头线所示那样,在球形物体30a内将虚拟相机31a向任意方向摇动或者倾斜任意的量。

95.这样,球形物体30a的内部成为虚拟相机31a的虚拟的拍摄空间。

96.虚拟相机31a由软件形成,所以不受惯性定律的影响,另外,能够不经由机械机构而控制拍摄方向。因此,能够在瞬间连续地/离散地切换拍摄方向。

97.此外,也能够在球形物体30a中设置多个虚拟相机31a,使这些虚拟相机独立地旋转,以同时获取多个拍摄方向的左相机图像。

98.例如,以下,对追踪单个对象者8的情况进行说明,但也能够形成对象者8的人数份的虚拟相机31a、31a、

……

,同时独立地追踪多人。

99.以上,对全天球相机9a进行了说明,但全天球相机9b也相同。

100.虽然未图示,但能够由全天球相机9b获取右全天球相机图像并粘贴到球形物体30b,通过虚拟相机31b在虚拟的拍摄空间拍摄周围的景色。

101.左全天球相机图像由鱼眼镜头图像构成,在图3的(b)的例子所示的桌子的图像中,桌子的直线部分弯曲。例如,左全天球相机图像由距画面的中心的距离和角度成比例的等距离射影方式等的鱼眼镜头图像构成。

102.若利用虚拟相机31a对其进行拍摄,则如图3的(c)所示,得到形变较少的桌子的左相机图像。像这样,若使用虚拟相机31a,则能够得到一般的图像识别中使用的二维相机图像,所以能够应用通常的图像识别技术。

103.右全天球相机图像也相同,若使用虚拟相机31b,则能够获取通常的图像识别所使用的二维相机图像。

104.在本实施方式中,由虚拟的针孔相机构成虚拟相机31a、31b,但这是一个例子,也可以使用将鱼眼镜头图像转换为平面图像的其他方法。

105.这里,虚拟相机31a、31b作为拍摄对象的拍摄单元发挥作用。

106.图4的各图是用于对使用了相机的到对象的距离和方位的计测方法进行说明的图。

107.追踪装置1为了追踪对象者8,需要使用相机计测对象者8在三维空间(步行空间)中的位置。

108.这样的计测方法主要有以下3个方法。

109.图4的(a)是表示基于几何修正的计测方法的图。

110.在基于单眼方式的几何修正中,根据单眼的相机的设置位置和相机图像中的对象33的几何状态(对象的拍摄方法)求出距离。

111.例如,根据对象33相对于相机图像的底边的站立位置可知到对象33的距离,在图的例子中,由横线表示到对象33的距离为1m、2m、3m的情况下的站立位置。

112.另外,能够根据相机图像的上述横线上的左右位置得到对象33存在的方位。

113.图4的(b)是表示基于视差立体(复眼)的计测方法的图。

114.在视差立体方式中,将面向正面的一对相机35a(左相机)和相机35b(右相机)固定在左右的规定距离,根据针对对象33的来自相机35a、35b的视差,对对象33进行立体观察/三角测量。

115.如图示那样,在视差立体方式中,根据由对象33和基线构成的粗线所示的较大的三角形与由形成于拍摄面的基于视差的底边和镜头的中心构成的粗线所示的较小的三角形的相似关系,求出对象33的距离和方位。

116.例如,若将到对象的距离设为z,将基线长度设为b,将焦距设为f,将视差长度设为d,则z由式(1)表示。方位也能够根据相似关系来求出。

117.图4的(c)是表示基于会聚立体方式的计测方法的图。

118.会聚是指进行所谓的对眼的动作,通过利用配置在左右的规定距离的一对相机36a(左相机)、相机36b(右相机)会聚观察对象33,来立体观察/测量对象33。

119.如图示那样,在会聚立体方式中,使右相机和左相机的拍摄方向分别朝向对象33,若将基线长度设为b,将从左相机到对象33的距离设为dl,将左相机镜头的光轴与前方的角度设为θl,将右相机镜头的光轴与前方的角度设为θr,将相对于会聚立体相机的对象33的方位设为θ,将从会聚立体相机到对象33的距离设为d,则根据几何关系,dl由式(2)表示,由此,d能够用式(3)求出。相当于方位的角度θ也同样地能够根据几何关系求出。

120.此外,为了防止字符代码的误转换(所谓的乱码),而用通常的字符表示图中示出的下标字符、上标字符。以下说明的其他的公式也相同。

121.以上,能够利用3种计测方法中的任意一种,但如以下所述那样,这些计测方法中的会聚立体方式在行人追踪中具有优势,发挥卓越的能力,所以在本实施方式中,采用会聚立体方式。

122.图5是用于对会聚立体方式的优势进行说明的图。

123.视差立体方式和会聚立体方式显然优异于单眼方式,所以针对单眼方式,省略说明。

124.如图5的(a)所示,在视差立体方式中,相机35a、35b的拍摄方向固定于前方。因此,也固定相机35a的拍摄区域37a和相机35b的拍摄区域37b,其共用的拍摄区域37c为能够测量的区域。

125.另一方面,在会聚立体方式中,能够通过使相机36a、36b独立旋转来分别独立地自由地设定左右相机的拍摄方向,所以针对共用的拍摄区域37c以外的广泛的区域,也能够进行立体观察/测量。

126.例如,如图5的(b)所示,即使是对象33位于相机正面的近距离且存在于拍摄区域37c之外的情况,也能够通过如箭头线所示那样利用左右的虚拟相机31会聚观察对象33来

测量位置和方位。

127.另外,如图5的(c)所示,即使是对象33位于偏左侧的场所而包含于拍摄区域37a但不包含于拍摄区域37b的情况,也能够如箭头线所示,通过会聚观察进行测量。对象33位于右侧的情况也相同。

128.如图5的(d)所示,即使是对象33位于进一步偏左的场所而也不包含于拍摄区域37a的情况,也能够如箭头线所示,通过会聚观察进行测量。对象33位于右侧的情况也相同。

129.这样,会聚立体方式与视差立体方式相比能够测量的区域较广,适合从近距离追踪自由走动而步行状态频繁地变化的行人。

130.因此,在本实施方式中,对全天球相机9a、9b形成虚拟相机31a、31b,由此,会聚观察对象者8。

131.这样,追踪装置1具备的拍摄单元通过使用了左相机和右相机的会聚立体相机拍摄对象。

132.而且,该拍摄单元利用从左广角图像(左全天球相机图像)获取任意方向的左相机图像的虚拟的相机(虚拟相机31a)构成左相机,并且,利用从右广角图像(右全天球相机图像)获取任意方向的右相机图像的虚拟的相机(虚拟相机31b)构成右相机。

133.并且,追踪装置1的左相机和右相机能够在从左广角图像和右广角图像分别获取左相机图像和右相机图像的虚拟的拍摄空间(基于球形物体30a、30b的拍摄空间)中移动拍摄方向。

134.追踪装置1使用粒子(颗粒)滤波器追踪对象者8存在的场所,但这里,对一般的粒子滤波的概要进行说明。

135.首先,在粒子滤波中,在有可能存在观测对象的场所产生许多粒子。

136.而且,针对各粒子利用某种方法观测似然度,并根据观测到的似然度对各粒子进行加权。似然度相当于在基于该粒子进行观测的情况下,观测到的为哪种程度的观测对象的可能性。

137.而且,在对各粒子观测似然度后,以似然度越大权重越大的方式对各粒子进行加权。由此,越是观测对象存在的程度高的场所,粒子的加权越大,所以加权后的粒子的分布对应于表示观测对象的存在的概率分布。

138.并且,为了追踪伴随着追踪对象的移动的概率分布的时间序列变化,进行重采样。

139.在重采样中,例如,间除加权小的粒子,留下加权大的粒子,在残留的粒子的附近产生新的粒子,针对产生的各粒子,观测当前时刻的似然度并进行加权。由此,概率分布被更新,能够更新概率密度大的场所,即,观测对象存在的可能性高的场所。

140.以后,反复进行重采样,能够追踪观测对象的位置的时间序列变化。

141.图6的各图是用于对粒子的产生方法进行说明的图。

142.追踪装置1使用粒子滤波器推测对象者8存在的位置的概率分布。

143.在通常进行的使用粒子滤波器的图像识别中,在二维相机图像中产生粒子,但与此相对,追踪装置1在对象者8存在的三维空间内产生粒子,将这些三维粒子映射并投影到左右的相机图像,由此包含立体信息地对对象者8进行图像识别。

144.在不包含立体信息进行图像识别的情况下,需要在右相机图像和左相机图像中独立地产生粒子,该情况下,会导致利用左右的相机观测不同的位置,这有可能对测量精度造

成影响而产生误追踪。

145.另一方面,追踪装置1进行基于使左右的相机朝向三维空间的相同的粒子而拍摄到的左相机图像和右相机图像的图像识别,所以能够利用左右的相机观测相同的区域,由此,能够有效地进行对象者8的搜索。

146.这样,追踪装置1在对象者8的周围产生粒子,但在本实施方式中,追踪对象是在追踪装置1的前方步行的行人,与地面平行地二维移动,所以使粒子散布在与步行面平行的平面。

147.此外,在无人机、鸟类等追踪对象也在高度方向上移动,进行三维动作的情况下,若将粒子三维地散布,则能够对其进行追踪。

148.图6的(a)示出对象者8在将追踪装置1设定为原点的xyz空间中步行的情况。

149.在对象者8步行的平面(步行面)设定xy坐标系,将高度方向作为z轴。拍摄部11位于对象者8的躯干附近的高度(1m左右)。

150.如图示那样,追踪装置1以对象者8为中心产生噪声,以便粒子大体散布在躯干附近的高度且与xy平面平行的圆形区域32,由此,产生规定个数的以对象者8为中心的粒子。

151.在本实施方式中,产生500个粒子。根据实验,能够从粒子的个数为50左右开始追踪。

152.此外,这里,在包含圆形区域32的平面上产生粒子,但也能够构成为在在高度方向(z轴方向)上具有宽度的带厚度的空间中分布。

153.关于躯干的位置,位于对象者8存在的概率密度较大的场所,另外,在粒子的加权后根据权重(根据概率分布)进行重采样,所以追踪装置1具备基于对象存在的位置的概率分布在三维空间内产生粒子滤波器所使用的粒子的粒子产生单元。

154.另外,该粒子产生单元沿着与对象移动的平面平行的平面产生粒子。

155.并且,通过重采样,跟踪伴随着对象者8的移动的概率分布的时间序列的变化,所以粒子产生单元依次基于前一次更新后的概率分布产生这次的粒子。

156.这里,产生的噪声是以对象者8为中心遵循高斯分布的白噪声(正常白噪声),通过遵循该噪声,能够在对象者8的周围根据正态分布来产生粒子。图的圆形区域32为产生的粒子的例如3σ程度的范围。

157.此外,也可以采用在圆形区域32均匀地产生粒子等其他的产生方法。

158.另外,如后述那样,追踪装置1在追踪开始时,利用通常的图像识别测量对象者8的位置,基于此产生以对象者8为中心的粒子,但在对象者8的位置不清楚的情况下,对象者8存在的概率分布在空间中均匀,所以在包含圆形区域32的xy平面均匀地产生粒子即可。

159.由于对象者8存在的场所的粒子的似然度较高,所以通过对其进行重采样,能够得到与对象者8的位置对应的概率分布。

160.追踪装置1通过如以上那样对产生的粒子进行重采样,来追踪对象者8。

161.图6的(b)是示意性表示从上方观察圆形区域32的图。

162.如图的黑点所示那样,在以对象者8为中心的圆形区域32产生粒子,但这些粒子的z坐标值恒定,所以追踪装置1为了方便,用基于(d,θ)坐标的极坐标表示这些粒子、对象者8的位置。此外,也可以用xy坐标表示。

163.另外,在已知对象者8正在步行的方向的情况下,如图6的(c)所示,也能够产生为

粒子的分布成为将步行方向作为长边方向的圆形区域32a。通使粒子沿着步行方向产生,能够抑制在对象者8存在的概率较低的地方产生粒子而进行不必要的计算。

164.并且,由于也在作为拍摄方向的相机图像的纵深方向散布粒子,所以例如在追踪装置1在建筑物内的走廊移动的情况下,能够从建筑物内部的平面图获取房间布置的布局,参照该布局,以不在墙壁中、禁止进入的房间等对象者8不可能存在的地方产生粒子。

165.这样,追踪装置1也在对象者8移动的三维空间中在拍摄的纵深方向产生粒子,所以能够以考虑了追踪对象的运动状态、周围的环境的任意的分布来产生粒子。

166.图7是用于对粒子向相机图像的映射进行说明的图。

167.追踪装置1如图7的(a)所示那样使用函数g(d,θ)、f(d,θ)将所产生的上述粒子映射到相机图像71a(左相机图像)和相机图像71b(右相机图像)的相机图像坐标系。

168.相机图像坐标系例如是将图像的左上角作为原点,将水平右方向作为x轴,将垂直下方向作为y轴的二维坐标系。

169.这样,追踪装置1具备将在对象者8存在的实际空间中产生的粒子映射到拍摄到的图像的映射单元。

170.而且,该映射单元利用规定的映射函数计算并获取产生的粒子在左相机图像以及右相机图像中的位置。

171.由此,例如,散布于空间的粒子41通过函数g(d,θ)映射至相机图像71a上的粒子51a,通过函数f(d,θ)映射至相机图像71b上的粒子51b。

172.此外,这些映射函数能够通过计算会聚立体观察的关系式和由虚拟相机31获取到的相机图像的每个像素的角度来导出。

173.这样,映射单元将在实际空间中产生的粒子建立对应关系地映射到由左相机和右相机分别拍摄到的左相机图像和右相机图像。

174.另外,在粒子41附带有用于进行图像识别的检测区域的位置、检测区域的尺寸等用于在相机图像设定检测区域的参数亦即状态参数,追踪装置1基于此在相机图像71a和相机图像71b分别设定检测区域61a和检测区域61b。

175.这样,粒子41、42、43、

……

由分量中具有状态参数的状态向量表示。

176.检测区域61a、61b具有矩形形状,检测区域61a、61b内的图像为进行图像识别的对象的部分区域图像。追踪装置1利用由检测区域61a、61b划分出的各个部分区域图像进行对象者8的图像识别。

177.这里,将检测区域61a、61b设定为映射后的粒子51a、51b成为矩形的重心。这是一个例子,也能够构成为通过固定值、函数使检测区域61的位置偏离粒子51的位置。

178.这样,追踪装置1具备基于映射后的粒子在相机图像内的位置设定检测区域,并对拍摄的对象进行图像识别的图像识别单元。

179.另外,追踪装置1以规定距离追踪行人,所以检测区域61a、61b的大小很少较大地变化。

180.因此,在追踪装置1中,在追踪前根据对象者8的身高设定检测区域61的尺寸,使用固定的尺寸的检测区域61a、61b。

181.此外,这是一个例子,也能够将检测区域61的尺寸作为参数,设为粒子滤波的对象。

182.该情况下,在(x坐标值,y坐标值,尺寸)这样的状态向量空间产生粒子。

183.即,即使xy坐标值相同,若尺寸不同,则也为不同的粒子,对于各个粒子观测似然度。由此,尺寸适合于图像识别的粒子的似然度变大,由此,也能够决定检测区域61的最佳尺寸。

184.这样,若不限定于实际空间,而在规定粒子41的状态向量空间中产生粒子,则能够实现进一步扩展的运用。在有n个参数的情况下,在n维空间产生粒子。

185.例如,在有通过第一方法计算似然度的似然度1和通过第二方法计算的似然度2,并且想要以前者为α后者为(α-1)的比例进行组合(例如,设为0<α<1)计算合成两者后的似然度的情况下,将状态向量设为(x坐标值,y坐标值,尺寸,α)。

186.若在这样的状态向量空间产生粒子41,则也能够根据粒子滤波对不同的α计算似然度,能够求出最适于对对象者8进行图像识别的最佳的(x坐标值,y坐标值,尺寸,α)和该情况下的似然度。

187.关于使用了α的似然度的合成,将在后面描述组合基于hog特征量的似然度和基于颜色分布特征的似然度的例子。

188.追踪装置1根据这样的顺序产生粒子,如图7的(b)所示,将未图示的粒子41、42、

……

映射到相机图像71a的粒子51a、52a、

……

,并基于此设定检测区域61a、62a、

……

。

189.对于相机图像71b,也将粒子41、42、

……

映射到粒子51b、52b、

……

,并基于此设定检测区域61b、62b、

……

。

190.而且,追踪装置1通过在相机图像71a的检测区域61a对对象者8进行图像识别来计算粒子51a的似然度(是映射后的粒子在左相机图像中的似然度,以下,记载为左似然度),通过在相机图像71b的检测区域61b对对象者8进行图像识别来计算粒子51b的似然度(是映射后的粒子在右相机图像中的似然度,以下,记载为右似然度),并且通过对左似然度和右似然度进行平均,来计算映射源的粒子41的似然度。

191.追踪装置1同样地计算在三维空间产生的粒子42、43、

……

的似然度。

192.像这样,追踪装置1将在对象者8正在步行的立体空间产生的粒子映射到左右一对的立体相机图像,经由映射到二维的相机图像的粒子的左似然度和右似然度,计算映射源的粒子的似然度。

193.追踪装置1通过对左似然度和右似然度进行平均来综合观测三维空间中的映射源的粒子的似然度,但这是一个例子,也可以通过其他的计算方法来综合。

194.另外,将右似然度和左似然度中似然度较高的一方作为映射源的似然度等,使用左似然度和右似然度中的至少一方求出综合后的似然度即可。

195.像这样,追踪装置1具有的图像识别单元分别在左相机图像和右相机图像中进行图像识别。

196.而且,追踪装置1具备基于图像识别的结果获取产生的粒子的似然度的似然度获取单元,该似然度获取单元使用基于左相机图像的图像识别的第一似然度(左似然度)、和基于右相机图像的图像识别的第二似然度(右似然度)中的至少一方获取似然度。

197.在以上的例子中,通过利用函数g(d,θ)、f(d,θ)进行运算,将粒子41、42、43、

……

映射到左右一组的立体相机图像,但也能够通过驱使虚拟相机31a、31b的虚拟性,使虚拟相机31a和虚拟相机31b朝向产生的粒子41、42、

……

来获取每个粒子的左右相机图像,来针对

每个左右相机图像的集合,将粒子41、42、

……

映射到图像的中心。

198.该变形例的情况下,使虚拟相机31a、31b的拍摄方向朝向粒子41,获取如图7的(c)所示那样的相机图像81a(左相机图像)和相机图像81b(右相机图像),接下来,使虚拟相机31a、31b的拍摄方向朝向粒子42获取相机图像82a(左相机图像)和相机图像82b(右相机图像)

……

,这样一来,对每个粒子获取使拍摄方向朝向该粒子的立体相机图像。其中,在图中仅示出左相机图像,省略右相机图像。

199.构成虚拟相机31的针孔相机是单一焦点,即使在球形物体30内使虚拟相机31朝向粒子41、42、

……

进行拍摄,对象者8的图像也能够在焦点对准的状态下获取。

200.另外,虚拟相机31通过软件形成,所以不需要机械式驱动,能够高速地切换拍摄方向来拍摄粒子41、42、

……

。

201.或者,也能够构成为设定多个虚拟相机31、31、

……

,并行地驱动这些虚拟相机,一次获取多个立体相机图像。

202.如图7的(c)所示,若使虚拟相机31a朝向粒子41进行拍摄,则能得到粒子41映射到图像的中心的粒子51a的相机图像81a。

203.虽然未图示,但相同地,若使虚拟相机31b朝向粒子41进行拍摄,则能得到粒子41映射到图像的中心的粒子51b的相机图像81b。

204.追踪装置1在相机图像81a、81b中进行图像识别,求出基于粒子51a、51b的左似然度和右似然度,对它们进行平均来求出粒子41的似然度。

205.以下,同样地使虚拟相机31a、31b朝向粒子42进行拍摄,获取相机图像82a、82b(相机图像82b未图示),由此,根据映射到图像中心的粒子52a、52b的左似然度、右似然度计算粒子42的似然度。

206.追踪装置1反复进行该处理,计算粒子41、42、43、

……

的似然度。

207.这样,该例子的拍摄单元使左相机和右相机朝向所产生的每个粒子进行拍摄,映射单元获取左相机图像和右相机图像的与拍摄方向对应的位置(例如,图像的中心)作为粒子的位置。

208.以上,对将在对象者8步行的三维空间产生的粒子映射到左右的相机图像的2个方法进行了说明,但以下,对利用前者的方法进行映射的情况进行说明。此外,也可以使用后者的方法进行映射。

209.图8的各图是用于对利用虚拟相机31追踪对象者8的位置的方法进行说明的图。

210.如以上说明的那样,追踪装置1如图8的(a)所示,在相机图像71a中,进行基于检测区域61a的图像识别,由此,计算粒子51a的左似然度。而且,在未图示的相机图像71b中,进行基于检测区域61b的图像识别,由此,计算粒子51b的右似然度。

211.并且,追踪装置1通过该左似然度与右似然度的平均,计算作为粒子51a、51b的映射源的粒子41的似然度。

212.追踪装置1反复进行该计算,计算三维地散布于对象者8的周围的粒子42、43、

……

的似然度。

213.而且,追踪装置1根据计算出的似然度,以似然度越大,权重越大的方式对在三维空间产生的各粒子进行加权。

214.图8的(b)示出进行了加权后的粒子41、42、43、

……

,表示为加权越大,黑点的大小

越大。

215.在图的例子中,粒子41的权重最大,其周边的粒子的权重也较大。

216.这样,能够得到实际空间中的进行了加权的粒子的分布,但该权重的分布对应于对象者8存在的位置的概率分布。因此,在图的例子中,能够推测为对象者8在粒子41附近。

217.推断方法能够各种各样,例如,推测为追踪对象在权重的峰值的位置,或者推测为追踪对象存在于权重的前5%的范围内。

218.通过重采样更新这样的概率分布的更新,从而能够追踪对象者8存在的位置。

219.这样,追踪装置1具备通过基于获取到的似然度更新概率分布来追踪对象存在的位置的追踪单元。

220.而且,追踪装置1通过使虚拟相机31a、31b朝向概率分布较大的场所(即,对象者8所在的可能性较高的场所),能够使虚拟相机31a、31b的拍摄方向朝向对象者8。

221.在图8的(c)的例子中,使虚拟相机31a、31b朝向似然度最大的粒子41。

222.这样,追踪装置1具备基于更新后的概率分布将左相机和右相机的拍摄方向移动至对象的方向的拍摄方向移动单元。

223.这里,使虚拟相机31朝向似然度最高的粒子,但这是一个例子,可以根据某种算法使虚拟相机31朝向概率分布高的场所。

224.这样,通过使虚拟相机31a、31b朝向概率密度高的场所,能够在相机的正面捕捉对象者8。

225.并且,能够从虚拟相机31a、31b进行会聚观察的角度测量对象者8的位置(d,θ),从而能够基于位置(d,θ)的输出值,对控制部6发出指令,进行控制以将追踪装置1移动到对象者8的后方的规定位置。

226.这样,追踪装置1具备:测量单元,基于根据概率分布移动后的左相机和右相机的拍摄方向测量对象存在的位置;以及输出单元,输出该测量的测量结果,并且,还具备基于该输出的测量结果驱动驱动装置7,由此与对象一起移动的移动单元。

227.另外,在如图8的(b)那样对粒子进行加权后,进行重采样,以便根据对象者8的移动更新概率分布,但这通过如下方式来进行:关于粒子41等似然度较高的粒子,根据白噪声在其附近产生下一个粒子(或者较多地产生),关于似然度较低的粒子,不产生其附近的下一个粒子(或者较少地产生),关于这样产生的新的粒子,计算使用了新的左右相机图像的似然度,以及进行加权。

228.这样,通过依次反复进行重采样似然度高的粒子并减少似然度低的粒子的处理,来更新概率分布,从而能够依次追踪对象者8存在的概率高的场所。

229.在本实施方式中,作为一个例子,基于考虑了对象者8的速度信息的图8的(d)的式(4),使状态迁移(产生用于重采样的粒子)。

230.这里,xt表示时刻t时的粒子的位置,xt-1表示时刻t-1时的粒子的位置。

231.vt-1是对象者8的速度信息,如式(6)所示,通过从时刻t时的位置减去时刻t-1时的位置来得到。

232.n(0,σ2)是噪声项,表示粒子的位置处的方差σ2的正态分布。

233.如式(5)所示那样,速度越大,对象者8的移动量越大,所以σ2设定为方差与此对应地增加。

234.图9是用于对似然度的计算方法进行说明的图。

235.似然度的计算能够使用任意的方法,但这里,作为一个例子,对使用hog特征量的例子进行说明。能够将该计算方法利用于右似然度和左似然度的计算。

236.hog特征量是使用亮度梯度分布的图像特征量,是检测对象的边缘的技术。例如,通过基于边缘的轮廓来识别对象。

237.通过如下步骤从图像提取hog特征量。

238.图9的(a)的左图所示的图像101示出根据检测区域从相机图像提取出的图像。

239.首先,将图像101分割为矩形的单元格102a、102b、

……

。

240.接下来,如图9的(a)的右图所示,针对每个单元格102,将各像素(像素)的亮度梯度方向(从低亮度朝向高亮度的方向)例如量化为8个方向。

241.接下来,如图9的(b)所示那样,生成将量化后的亮度梯度的方向作为分类,将出现次数作为频率的直方图,从而针对每个单元格102创建单元格102所包含的亮度梯度的直方图106。

242.而且,进行标准化,以使以集中了几个单元格102的块为单位而直方图106的总频率为1。

243.在图9的(a)的左图的例子中,由单元格102a、102b、102c、102d形成1个块。

244.将像这样标准化后的直方图106a、106b、

……

(未图示)如图9的(c)那样排列成一列而得到的直方图107是图像101的hog特征量。

245.使用了hog特征量的图像的类似程度的判断如以下那样进行。

246.首先,考虑以hog特征量的频率(设有m个)作为分量的向量φ(x)。这里,x是表示图像101的向量,x=(第一个像素的亮度,第二个像素的亮度,

……

)。

247.此外,向量由粗体字等表示,为了防止字符代码的误转换,在以下,由通常的字符表示。

248.图9的(d)表示hog特征量空间,图像101的hog特征量被映射到m维空间的向量φ(x)。

249.此外,在图中,为了简化而用二维空间表示hog特征量空间。

250.另一方面,f是通过人物图像的学习而得到的权重向量,是对许多的人物图像的hog特征量进行平均后的向量。

251.在图像101与学习到的图像类似的情况下,φ(x)如向量109那样分布于f的周边,在不类似的情况下,如向量110、111那样分布于与f不同的方向。

252.f和φ(x)被标准化,对于由f与φ(x)的内积定义的相关系数而言,图像101越与学习图像类似,越接近1,类似程度越低,越接近-1。

253.这样,通过将成为类似判断的对象的图像映射到hog特征量空间,能够通过亮度梯度分布分离与学习图像类似的图像和不类似的图像。

254.能够使用该相关系数作为似然度。

255.另外,也能够进行使用了颜色分布特征的似然度的评价。

256.例如,图像101由具有各种颜色分量(颜色1、颜色2、

……

)的像素构成。

257.若根据这些颜色分量的出现频率创建直方图,则能得到将该频率作为分量的向量q。

258.另一方面,针对使用对象者8预先准备的追踪对象模型,也创建相同的直方图,创建将其频率作为分量的向量p。

259.在图像101的图像与追踪对象模型类似的情况下,q分布于p的周边,不类似的情况下,分布在与p不同的方向。

260.q和p被标准化,对于由q与p的内积定义的相关系数而言,图像101越与追踪对象模型类似,越接近1,类似程度越低,越接近-1。

261.这样,通将成为类似判断的对象的图像映射到颜色特征量空间,能够通过颜色特征向量分布分离与追踪对象模型类似的图像和不类似的图像。

262.也能够使用该相关系数作为似然度。

263.另外,例如,也能够组合基于hog特征量的类似度和基于颜色分布特征的类似度。

264.hog特征量和颜色分布特征有擅长识别的场景(场面)和不擅长的场景,通过组合他们,能够提高图像识别的稳健性。

265.该情况下,通过使用之前说明的参数α(通过实验,设为0.25<α<0.75),用α

×

(基于hog特征量的类似度) (1-α)

×

(基于颜色分布特征的类似度)定义似然度,在包含α的状态向量空间产生粒子,从而也能够求出将似然度最大化的α。

266.根据该式,α越大,hog特征量的贡献越大,α越小,颜色分布特征量的贡献越大。

267.因此,通过适当地选择α,能够得到适合场景的值,稳健性提高。

268.图10是用于对追踪装置1进行的追踪处理进行说明的流程图。

269.以下的处理由cpu2根据存储部10存储的追踪程序来进行。

270.首先,cpu2请用户输入对象者8的身高等,基于此设定左右的检测区域的尺寸,将其存储于ram4。

271.接下来,请对象者8站在追踪装置1之前的规定位置,cpu2利用虚拟相机31a、31b对对象者8进行拍摄,获取左相机图像和右相机图像并存储于ram4(步骤5)。

272.更详细而言,cpu2将全天球相机9a、9b拍摄到的左全天球相机图像和右全天球相机图像存储于ram4,通过计算将这些图像分别粘贴到球形物体30a、30b。

273.然后,通过计算获取分别利用虚拟相机31a、31b从内侧对其进行拍摄而得到的左相机图像和右相机图像并存储于ram4。

274.接下来,cpu2在左右的相机图像中对对象者8进行图像识别(步骤10)。

275.该图像识别例如使用在左右的相机图像中分别对存储于ram4的尺寸的检测区域进行扫描来搜索对象者8等通常进行的方法。

276.然后,cpu2使虚拟相机31a、31b分别朝向图像识别出的对象者8的方向。

277.接下来,cpu2通过从虚拟相机31a、31b的角度测量对象者8的位置,来利用到对象者8的距离d和角度θ获取对象者8存在的场所,并存储于ram4。

278.然后,cpu2根据获取到的对象者8的位置(d,θ)、追踪机器人12的正面方向和相对于虚拟相机31a、31b的角度,计算对象者8相对于追踪机器人12的位置和方向,对控制部6发出指令并使追踪机器人12移动,以使对象者8位于追踪机器人12的正面的规定位置。此时,cpu2调节虚拟相机31a、31b的角度,以便在相机的正面捕捉对象者8。

279.接下来,cpu2在对象者8存在的场所的规定高度(躯干附近)的水平面上产生白噪声,基于此产生规定的数量的粒子(步骤15)。然后,cpu2将各粒子的位置(d,θ)存储于ram4。

280.在以下的步骤20、25中针对各粒子的处理由gpu5并行处理,但这里,为了简化说明,而由cpu2进行。

281.接下来,cpu2选择产生的粒子之一,将其分别通过函数g(d,θ)、f(d,θ)映射到左相机图像和右相机图像,并将这些映射后的粒子的图像坐标值存储于ram4(步骤20)。

282.接下来,cpu2针对左相机图像和右相机图像分别计算基于所映射的粒子的左相机图像似然度和右相机图像似然度,通过它们的平均计算映射源的粒子的似然度并存储于ram4(步骤25)。

283.接下来,cpu2判断是否对于所产生的映射源的全部的粒子计算出似然度(步骤30)。

284.在有仍未计算的粒子的情况下(步骤30;否),返回至步骤20,计算下一个粒子的似然度。

285.另一方面,在计算出全部的粒子的似然度的情况下(步骤30;是),cpu2基于粒子的似然度对各粒子进行加权,并将每个粒子的权重存储于ram4。

286.接下来,cpu2基于粒子的权重的分布推断对象者8相对于拍摄部11的位置,使虚拟相机31a、31b朝向推断出的对象者8的位置。

287.然后,cpu2根据虚拟相机31a、31b的角度对对象者8的位置进行测量计算,将计算出的对象者8的坐标(d,θ)存储于ram4(步骤35)。

288.并且,cpu2根据在步骤35中存储于ram4的对象者8的坐标(d,θ)、以及追踪机器人12的正面方向与虚拟相机31a、31b的拍摄方向所成的角度,计算对象者8相对于追踪机器人12的位置的坐标,使用该坐标,使控制部6发出指令并进行移动控制,以使追踪机器人12移动至对象者8的后方的规定的追踪位置(步骤40)。

289.与此对应,控制部6驱动驱动装置7使追踪机器人12移动,从而在对象者8后方跟踪对象者8。

290.接下来,cpu2判断是否结束追踪处理(步骤45)。在判断为继续处理的情况下(步骤45;否),cpu2返回至步骤15,产生下一个粒子,在判断为结束处理的情况下(步骤45;是),结束处理。

291.该判断例如通过在对象者8到达目的地的情况下,请发出声音“到达”等,对其进行声音识别来进行,或者请做出特定的手势来进行。

292.以上,对本实施方式的追踪装置1进行了说明,但能够进行各种变形。

293.例如,也能够通过在追踪机器人12搭载拍摄部11、控制部6以及驱动装置7,在服务器具有其他的结构要素和追踪装置1,利用通信线路连结追踪机器人12和服务器,来对追踪机器人12进行远程操作。

294.另外,也能够构成为除了虚拟相机31a、31b之外,还在拍摄部11具备外部观察用的虚拟相机,将由该相机拍摄到的图像发送至服务器。

295.并且,也能够在追踪装置1具备麦克风和扬声器,第三者经由移动终端等,在观察外部观察用的虚拟相机的图像的同时与追踪对象者对话。

296.该情况下,例如,能够使追踪机器人12与老年人的散步同行,看护者在从移动终端观察追踪机器人12的周围的同时,对老年人呼叫“请小心,车来了”等。

297.(第二实施方式)

298.在第一实施方式的追踪装置1具备的拍摄部11中,在左右方向上配设全天球相机9a、9b,但在第二实施方式的追踪装置1b具备的拍摄部11b中,在上下方向上配设全天球相机9a、9b。

299.虽然未图示,但追踪装置1b的结构除了在上下方向上配设全天球相机9a、9b之外,与图2所示的追踪装置1相同。

300.图11是表示第二实施方式的追踪机器人12的外观示例的图。

301.图11的(a)所示的追踪机器人12d是在追踪机器人12a(图1的(a))中在上下方向上设置全天球相机9a、9b。

302.拍摄部11b配置于柱状部件的前端,全天球相机9a配设于垂直方向上侧,全天球相机9b配设于垂直方向下侧。

303.像这样,在第一实施方式中,设置为拍摄部11的长边方向为水平方向,但在第二实施方式中,设置为拍摄部11b的长边方向为垂直方向。

304.此外,也能够配设为全天球相机9a位于全天球相机9b的斜上方向,配设为全天球相机9a位于某水平面的上侧,全天球相机9b位于下侧即可。

305.这样,追踪装置1b具备拍摄单元,该拍摄单元通过使用了配设于比规定的水平面靠上侧的上相机和配设于下侧的下相机的会聚立体相机来拍摄对象。

306.在拍摄部11的情况下,全天球相机9a、9b沿水平方向(横向)设置,所以该横向成为死角,但在拍摄部11b中,将全天球相机9a、9b沿垂直方向(纵向)设置,所以遍及360度的整周没有死角,对象者8存在于追踪机器人12的周围的任意位置,均能够获取对象者8的图像。

307.图11的(b)、(c)的追踪机器人12e、12f分别与图1的(b)、(c)的追踪机器人12b、12c对应,分别通过拍摄部11b将全天球相机9a、9b上下配设。

308.图11的(d)是在路面竖立柱子,在其前端安装拍摄部11b的例子。能够追踪在路上步行的通行者。

309.图11的(e)是在路面竖立有高低差的2根柱子,在较低的柱子的前端安装全天球相机9b,在较高的柱子的前端安装全天球相机9a来构成拍摄部11b的例子。

310.这样,也可以将全天球相机9a、9b安装于其它的支承部件,并且,也可以在斜上下方向上设置。

311.图11的(f)是以悬吊于房屋、高楼等建筑物的屋檐下的形式设置拍摄部11b的例子。

312.图11的(g)是在团体旅行的领队举起的旗子的前端设置拍摄部11b的例子。能够通过对团体客人的面部进行面部认证,来追踪各个参加者的位置。

313.图11的(h)是在车辆的车顶设置拍摄部11b的例子。能够获取前方车辆的位置等周围的环境物的位置。

314.图11的(i)是在三脚架上设置拍摄部11b的例子。能够在土木领域等中利用。

315.图12是用于对第二实施方式中的测量方法进行说明的图。

316.粒子的产生方法与第一实施方式相同。

317.如图12的(a)所示,追踪装置1b使设置于全天球相机9a、9b的未图示的虚拟相机31a、31b在包含z轴和对象者8的平面内进行会聚观察,并且绕z轴旋转(将旋转角度设为φ),以使拍摄方向朝向对象者8。

318.如图12的(b)所示,追踪装置1b能够通过由对象者8的距离d和虚拟相机31a、31b的绕z轴的旋转角度φ构成的坐标(d,φ)测量对象者8的位置。

319.关于拍摄单元以外的追踪装置1b具有的各单元,产生粒子的粒子产生单元、追踪对象存在的位置的追踪单元、输出测量结果的输出单元、以及基于测量结果移动的移动单元与追踪装置1相同。

320.另外,追踪装置1b具有的、映射粒子的映射单元、进行图像识别的图像识别单元、获取粒子的似然度的似然度获取单元、移动拍摄方向的拍摄方向移动单元、测量对象存在的位置的测量单元、以及获取广角图像的广角图像获取单元能够为使左右与上下对应,而使左相机、右相机、左相机图像、右相机图像、左广角相机、右广角相机、左广角图像、右广角图像、左全天球相机、右全天球相机分别与上相机、下相机、上相机图像、下相机图像、上广角相机、下广角相机、上广角图像、下广角图像、上全天球相机、下全天球相机对应的结构。

321.通过以上,在第一实施方式以及第二实施方式中,能够得到以下结构。

322.(1)第一实施方式的结构

323.(第101结构)一种追踪装置,其特征在于,具备:粒子产生单元,基于对象存在的位置的概率分布在三维空间内产生粒子滤波器所使用的粒子;拍摄单元,拍摄上述对象;映射单元,将所产生的上述粒子映射到拍摄到的上述图像;图像识别单元,基于所映射的上述粒子在上述图像内的位置设定检测区域,并且对所拍摄的上述对象进行图像识别;似然度获取单元,基于上述图像识别的结果获取所产生的上述粒子的似然度;追踪单元,通过基于获取到的上述似然度更新上述概率分布,来追踪上述对象存在的位置,上述粒子产生单元依次基于更新后的上述概率分布来产生粒子。

324.(第102结构)根据第101结构所述的追踪装置,其特征在于,上述粒子产生单元沿着与上述对象移动的平面平行的平面产生上述粒子。

325.(第103结构)根据第101结构或者第102结构所述的追踪装置,其特征在于,上述拍摄单元通过使用了左相机和右相机的会聚立体相机来拍摄上述对象,上述映射单元将所产生的上述粒子建立对应关系地映射到由上述左相机和上述右相机分别拍摄到的左相机图像和右相机图像,上述图像识别单元在上述左相机图像和上述右相机图像中分别进行图像识别,上述似然度获取单元使用基于上述左相机图像的图像识别的第一似然度和基于上述右相机图像的图像识别的第二似然度中的至少一方,来获取上述似然度,并且,上述追踪装置还具备拍摄方向移动单元,上述拍摄方向移动单元基于更新后的上述概率分布将上述左相机和上述右相机的拍摄方向移动至上述对象的方向。

326.(第104结构)根据第103结构所述的追踪装置,其特征在于,具备:测量单元,基于移动后的上述左相机和右相机的拍摄方向测量上述对象存在的位置;以及输出单元,输出测量出的上述测量结果。

327.(第105结构)根据第104结构所述的追踪装置,其特征在于,具备广角图像获取单元,上述广角图像获取单元分别从左广角相机和右广角相机获取左广角图像和右广角图像,上述拍摄单元利用从获取到的上述左广角图像获取任意方向的左相机图像的虚拟的相机构成上述左相机,并且,利用从获取到的上述右广角图像获取任意方向的右相机图像的虚拟的相机构成上述右相机,上述拍摄方向移动单元在上述左广角相机和上述右广角相机分别从上述左广角图像和上述右广角图像获取左相机图像和右相机图像的虚拟的拍摄空

间中移动上述拍摄方向。

328.(第106结构)根据第105结构所述的追踪装置,其特征在于,上述左广角相机和上述右广角相机分别是左全天球相机和右全天球相机。

329.(第107结构)根据第103结构至第106结构中的任一结构所述的追踪装置,其特征在于,上述映射单元利用规定的映射函数计算并获取所产生的上述粒子在上述左相机图像以及上述右相机图像中的位置。

330.(第108结构)根据第103结构至第106结构中的任一结构所述的追踪装置,其特征在于,上述拍摄单元使上述左相机和上述右相机朝向所产生的每个上述粒子并进行拍摄,上述映射单元获取上述左相机图像和上述右相机图像的与上述拍摄方向对应的位置作为上述粒子的位置。

331.(第109结构)根据第104结构所述的追踪装置,其特征在于,具备移动单元,上述移动单元基于输出的上述测量结果与上述对象一起移动。

332.(第110结构)一种追踪程序,由计算机实现以下功能:粒子产生功能,基于对象存在的位置的概率分布在三维空间内产生粒子滤波器所使用的粒子;拍摄功能,拍摄上述对象;映射功能,将所产生的上述粒子映射到拍摄到的上述图像;图像识别功能,基于所映射的上述粒子在上述图像内的位置设定检测区域,并且对所拍摄的上述对象进行图像识别;似然度获取功能,基于上述图像识别的结果获取所产生的上述粒子的似然度;追踪功能,通过基于获取到的上述似然度更新上述概率分布,来追踪上述对象存在的位置,上述粒子产生功能依次基于更新后的上述概率分布来产生粒子。

333.(2)第二实施方式的结构

334.(第201结构)一种检测装置,设置于行驶体、建筑物等,检测规定的对象,上述检测装置的特征在于,具备:拍摄单元,通过配设于比规定的水平面靠上侧的上相机和配设于比上述水平面靠下侧的下相机来以广角拍摄上述对象;以及检测单元,通过在上述上相机的上相机图像和上述下相机的下相机图像中分别进行图像识别来检测所拍摄的上述对象。

335.(第202结构)一种追踪装置,具备粒子产生单元、上述技术方案1所述的检测装置、似然度获取单元以及追踪单元,上述粒子产生单元基于对象存在的位置的概率分布在三维空间内产生粒子滤波器所使用的粒子,上述追踪装置的特征在于,上述检测装置的上述拍摄单元通过使用了配设于比规定的水平面靠上侧的上相机和配设于比上述水平面靠下侧的下相机的会聚立体相机来拍摄上述对象,上述检测装置的上述检测单元具备:映射单元,将所产生的上述粒子建立对应关系地映射到由上述上相机和上述下相机分别拍摄到的上相机图像和下相机图像;以及图像识别单元,基于所映射的上述粒子在上述上相机图像和上述下相机图像中的各自的位置来在上述上相机图像和上述下相机图像中设定检测区域,并且在上述上相机图像和下相机图像中分别对所拍摄的上述对象进行图像识别,上述似然度获取单元使用基于上述上相机图像的图像识别的第一似然度和基于上述下相机图像的图像识别的第二似然度中的至少一方,获取所产生的上述粒子的似然度,上述追踪单元通过基于获取到的上述似然度更新上述概率分布,来追踪上述对象存在的位置,上述粒子产生单元依次基于更新后的上述概率分布来产生粒子。

336.(第203结构)根据技术方案2所述的追踪装置,其特征在于,上述粒子产生单元沿着与上述对象移动的平面平行的平面产生上述粒子。

337.(第204结构)根据技术方案2或者3所述的追踪装置,其特征在于,上述追踪装置具备拍摄方向移动单元,上述拍摄方向移动单元基于更新后的上述概率分布将上述上相机和上述下相机的拍摄方向移动至上述对象的方向。

338.(第205结构)根据技术方案4所述的追踪装置,其特征在于,具备:测量单元,基于移动后的上述上相机和下相机的拍摄方向测量上述对象存在的位置;以及输出单元,输出测量出的上述测量结果。

339.(第206结构)根据技术方案2至5中的任一技术方案所述的追踪装置,其特征在于,上述追踪装置具备广角图像获取单元,上述广角图像获取单元分别从配设于比规定的水平面靠上侧的上广角相机和配设于比上述水平面靠下侧的下广角相机获取上广角图像和下广角图像,上述拍摄单元利用从获取到的上述上广角图像获取任意方向的上相机图像的虚拟的相机构成上述上相机,并且利用从获取到的上述下广角图像获取任意方向的下相机图像的虚拟的相机构成上述下相机,上述拍摄方向移动单元在上述上相机和上述下相机分别从上述上广角图像和上述下广角图像获取上相机图像和下相机图像的虚拟的拍摄空间中移动上述拍摄方向。

340.(第207结构)根据技术方案6所述的追踪装置,其特征在于,上述上广角相机和上述下广角相机分别是上全天球相机和下全天球相机。

341.(第208结构)根据技术方案2至7中的任一技术方案所述的追踪装置,其特征在于,上述映射单元利用规定的映射函数计算并获取所产生的上述粒子在上述上相机图像以及上述下相机图像中的位置。

342.(第209结构)根据技术方案2至7中的任一技术方案所述的追踪装置,其特征在于,上述拍摄单元使上述上相机和上述下相机朝向所产生的每个上述粒子并进行拍摄,上述映射单元获取上述上相机图像和上述下相机图像的与上述拍摄方向对应的位置作为上述粒子的位置。

343.(第210结构)根据技术方案2至9中的任一技术方案所述的追踪装置,其特征在于,具备移动单元,上述移动单元基于输出的上述测量结果与上述对象一起移动。

344.(第211结构)根据技术方案2至10中的任一技术方案所述的追踪装置,其特征在于,上述上相机和上述下相机配设于垂直线上。

345.(第212结构)一种检测程序,使计算机作为设置于行驶体、建筑物等并检测规定的对象的检测装置发挥作用,上述检测程序的特征在于,使计算机实现以下功能:拍摄功能,通过配设于比规定的水平面靠上侧的上相机和配设于比上述水平面靠下侧的下相机来以广角拍摄上述对象;以及检测功能,通过在上述上相机的上相机图像和上述下相机的下相机图像中分别进行图像识别来检测所拍摄的上述对象。

346.(第213结构)一种追踪程序,由计算机实现以下功能:粒子产生功能,基于对象存在的位置的概率分布在三维空间内产生粒子滤波器所使用的粒子;拍摄功能,通过使用了配设于比规定的水平面靠上侧的上相机和配设于比上述水平面靠下侧的下相机的会聚立体相机来拍摄上述对象;映射功能,将所产生的上述粒子建立对应关系地映射到由上述上相机和上述下相机分别拍摄到的上相机图像和下相机图像;图像识别功能,基于所映射的上述粒子在上述上相机图像和上述下相机图像中的各自的位置来在上述上相机图像和上述下相机图像中设定检测区域,并且在上述上相机图像和上述下相机图像中分别对所拍摄

的上述对象进行图像识别;似然度获取功能,使用基于上述上相机图像的图像识别的第一似然度和基于上述下相机图像的图像识别的第二似然度中的至少一方,获取所产生的上述粒子的似然度;以及追踪功能,通过基于获取到的上述似然度更新上述概率分布,来追踪上述对象存在的位置,上述粒子产生功能依次基于更新后的上述概率分布来产生粒子。

347.附图标记说明:1...追踪装置;2...cpu;3...rom;4...ram;5...gpu;6...控制部;7...驱动装置;8...对象者;9...全天球相机;10...存储部;11...拍摄部;12...追踪机器人;15...壳体;16...后轮;17...前轮;20...壳体;21...后轮;22...前轮;25...壳体;26...螺旋桨;30...球形物体;31...虚拟相机;32...圆形区域;33...对象;35、36...相机;37...拍摄区域;41、42、43...粒子;51、52...粒子;61、62...检测区域;71、81、82...相机图像;101...图像;102...单元格;106、107...直方图;109、110、111...向量。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。