1.本发明涉及烟雾检测技术领域,特别是涉及一种烟雾检测模型构建方法、装置、设备、介质及检测方法。

背景技术:

2.近年来,我国山火事故频发,造成较大的人员伤亡和森林资源损失。森林火灾有突发性、随机性、高危害性和快速扩散性的特点,一旦发生火情,火势会迅速蔓延。因此,能否及时的发现火情、并采取合理手段将其扑灭成为森林防火的核心。

3.目前,森林火情检测通常采用传感器监测的方式。但是,传统传感器类监测方法的适用范围小,其更适合于家庭房屋,工厂厂房等场景。而我国森林区域广袤,布置传感器代价过大,不具有可行性;同时传感器在野外的供电、防水、枯枝遮挡问题也比较严重。此外与传感器监测的相似技术中,包括使用固定点位的摄像机进行监视并检测,其观测距离较短,还包括无人机巡检,但其成本高,且无人机在山区内的续航问题不容忽视,而且如何寻迹飞回等问题在实践中还要进一步完善。

4.为解决传感器类监测系统的适用范围小及硬件布置成本高等问题,现有技术中,已出现基于远程采集的图像进行烟雾监测的方式,其使用超远距离摄像机对森林场景进行监视,再对其成像进行目标检测,由此实现对森林火情的检测。但是,在使用现有技术过程中,发明人发现现有技术中至少存在如下问题:

5.1)基于传统方法设计的特征难以表征大部分烟雾。烟雾特征与其他物体特征差别较大,一般物体通过对现有数据集的特征进行统计分析,能够得到较好的特征,从而表征对象。但是烟雾是流体,形态轮廓极其多样,颜色也随着燃烧物的材质、燃烧的充分程度的变化而变化,传统方法手动设计的特征难以表征全部烟雾,从而导致检测的召回率与准确率不能满足要求。

6.2)引入时间信息的三维卷积类模型难以训练。将多帧图像进行二维卷积的模型引入的时间信息较少,而光流法由于远距离图像较为模糊且烟雾变化缓慢,所以效果很差。如完全使用三维卷积的结构,则面临着参数巨大、梯度更新缓慢、难以训练的问题,并且实际使用中三维卷积的效果无法达到预期。

技术实现要素:

7.本发明旨在至少在一定程度上解决上述技术问题,本发明提供了一种烟雾检测模型构建方法、装置、设备、介质及检测方法。

8.本发明采用的技术方案是:

9.第一方面,本发明提供了一种烟雾检测模型构建方法,包括:

10.获取faster r-cnn网络模型,并基于所述faster r-cnn网络模型搭建烟雾基础检测模型;

11.获取mr(2 1)d网络模型,并基于所述mr(2 1)d网络模型搭建烟雾去误检模型;

12.获取模型融合模块,并将所述烟雾基础检测模型通过所述模型融合模块与所述烟雾去误检模型进行融合,得到初始烟雾检测模型;

13.获取数据集,所述数据集中包括多个合成烟雾数据以及分别与多个合成烟雾数据对应的烟雾标签信息;

14.根据所述数据集对所述初始烟雾检测模型进行训练,得到最终烟雾检测模型。

15.本发明的有益效果如下:

16.1)进行烟雾检测的召回率及准确率高。具体地,本发明在实施过程中,通过基于faster r-cnn网络模型搭建而成的烟雾基础检测模型对待检测数据进行常规目标检测,以便于提高对烟雾图像检测的召回率,然而由于待检测数据的真实场景干扰较多,召回率的提高易导致误报率的增加,因而本发明基于时空可分离卷积的mr(2 1)d网络模型搭建烟雾去误检模型,以进一步对烟雾基础检测模型输出的检测框进行检测,由此便于在高召回率的前提下进一步降低误报率;在此过程中,由于faster r-cnn网络模型及mr(2 1)d网络模型的特性差异,使得烟雾基础检测模型输出的检测框与烟雾去误检模型需输入的检测框存在大小不一致的问题,因而本发明通过模型融合模块对烟雾基础检测模型与烟雾去误检模型进行融合,以实现烟雾基础检测模型与烟雾去误检模型在时间与空间上的融合,减小时间复杂度。

17.2)烟雾检测模型的空间复杂度较低,运行速度快。具体地,由于本发明最终烟雾检测模型中的烟雾基础检测模型基于faster r-cnn网络模型搭建,烟雾去误检模型基于mr(2 1)d网络模型搭建,使得通过最终烟雾检测模型进行烟雾检测时,可先将待检测数据通过烟雾基础检测模型进行二维卷积相关的处理,然后将烟雾基础检测模型输出的检测框通过模型融合模块融合为与烟雾去误检模型的输入检测框要求相匹配的融合后检测框,以便于烟雾去误检模型对融合后检测框进行三维卷积相关的处理,最终得到待检测数据是否存在烟雾的结果,由此使得本发明的最终烟雾检测模型整体的空间复杂度相对完全使用三维卷积的网络结构较低,运行速度得以提升。

18.在一个可能的设计中,所述烟雾基础检测模型包括resnet50卷积层、fpn特征融合层、rpn层、roi池化层和全连接层,其中resnet50卷积层、fpn特征融合层、roi池化层和全连接层依次连接,fpn特征融合层还通过rpn层与roi池化层连接。

19.在一个可能的设计中,获取mr(2 1)d网络模型,包括:

20.获取r(2 1)d模块,并将所述r(2 1)d模块作为mr(2 1)d网络模型的基础模块;

21.获取mcx模块;

22.将所述r(2 1)d模块和所述mcx模块进行融合,得到mr(2 1)d网络模型。

23.在一个可能的设计中,所述模型融合模块采用mergebox候选框融合模块。

24.在一个可能的设计中,获取数据集中的任一合成烟雾数据时,包括:

25.获取背景图片;

26.基于c4d软件生成模拟烟雾图像;

27.根据所述背景图片的成像参数,对所述模拟烟雾图像进行处理,得到处理后模拟烟雾图像;

28.将所述处理后模拟烟雾图像插入所述背景图片的指定位置,以便将所述处理后模拟烟雾图像与所述背景图片进行合成处理,得到合成烟雾数据;

29.获取所述合成烟雾数据中所述处理后模拟烟雾图像的位置信息,并根据所述位置信息生成烟雾标签信息。

30.在一个可能的设计中,所述背景图片的成像参数包括亮度参数和透明度参数,对所述模拟烟雾图像进行处理时,基于python实现。

31.第二方面,本发明提供了一种烟雾检测模型构建装置,用于实现如上述任一项所述的烟雾检测模型构建方法;所述烟雾检测模型构建装置包括:

32.第一模型搭建单元,用于获取faster r-cnn网络模型,并基于所述faster r-cnn网络模型搭建烟雾基础检测模型;

33.第二模型搭建单元,用于获取mr(2 1)d网络模型,并基于所述mr(2 1)d网络模型搭建烟雾去误检模型;

34.关联单元,分别与所述第一模型搭建单元和所述第二模型搭建单元通信连接,用于获取模型融合模块,并将所述烟雾基础检测模型通过所述模型融合模块与所述烟雾去误检模型进行融合,得到初始烟雾检测模型;

35.模型训练单元,与所述关联单元通信连接,用于获取数据集,所述数据集中包括多个合成烟雾数据以及分别与多个合成烟雾数据对应的烟雾标签信息;还用于根据所述数据集对所述初始烟雾检测模型进行训练,得到最终烟雾检测模型。

36.第三方面,本发明提供了一种电子设备,包括:

37.存储器,用于存储计算机程序指令;以及,

38.处理器,用于执行所述计算机程序指令从而完成如上述任一项所述的烟雾检测模型构建方法的操作。

39.第四方面,本发明提供了一种计算机可读存储介质,用于存储计算机可读取的计算机程序指令,所述计算机程序指令被配置为运行时执行如上述任一项所述的烟雾检测模型构建方法的操作。

40.第五方面,本发明提供了一种烟雾检测方法,包括:

41.获取待检测数据;

42.将所述待检测数据输入根据权利要求1至6任一项所述烟雾检测模型构建方法生成的最终烟雾检测模型中进行处理,得到烟雾检测结果。

43.第六方面,本发明提供了一种烟雾检测系统,包括:

44.数据采集单元,用于获取待检测数据;

45.数据检测单元,与所述数据采集单元通信连接,用于接收所述待检测数据,并对所述待检测数据进行检测,得到烟雾检测结果;

46.烟雾报警单元,与所述数据检测单元通信连接,用于根据所述烟雾检测结果进行烟雾报警。

附图说明

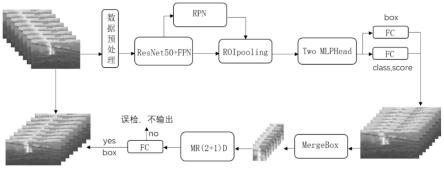

47.图1是本发明中烟雾基础检测模型的结构示意图;

48.图2是本发明中获取mr(2 1)d网络模型的示意图;

49.图3是本发明中mr(2 1)d网络模型的时空可分离卷积的原理示意图;

50.图4是本发明中基于最终烟雾检测模型对待检测数据进行处理的示意图;

51.图5是本发明中烟雾检测模型构建装置的结构示意图;

52.图6是本发明中烟雾检测方法的流程图;

53.图7是本发明中烟雾检测系统的模块框图。

具体实施方式

54.下面结合附图及具体实施例来对本发明作进一步阐述。

55.应当理解,还应当注意到在一些备选实施例中,所出现的功能/动作可能与附图出现的顺序不同。例如,取决于所涉及的功能/动作,实际上可以实质上并发地执行,或者有时可以以相反的顺序来执行连续示出的两个图。

56.实施例1:

57.本实施例第一方面提供了一种烟雾检测模型构建方法,可以但不限于由具有一定计算资源的计算机设备或虚拟机执行,例如由个人计算机、智能手机、个人数字助理或可穿戴设备等电子设备执行,或者由虚拟机执行,以便提高烟雾检测模型进行烟雾检测的召回率、准确率及运行速度,同时降低烟雾检测模型的空间复杂度。

58.一种烟雾检测模型构建方法,可以但不限于包括有如下步骤:

59.s1.获取faster r-cnn网络模型,并基于所述faster r-cnn网络模型搭建烟雾基础检测模型;需要说明的是,也可采用yolo(you only look once,一种目标检测模型)等能够进行目标检测的网络模型搭建烟雾基础检测模型。

60.具体地,如图1所示,所述烟雾基础检测模型包括resnet50卷积层(其中,resnet的全拼为residual network,指残差网络)、fpn(feature pyramid networks,特征图金字塔网络)特征融合层、rpn(region proposal network,卷积神经网络)层、roi(region of interest,感兴趣区域)池化层和全连接层,其中resnet50卷积层、fpn特征融合层、roi池化层和全连接层依次连接,fpn特征融合层还通过rpn层与roi池化层连接。需要说明的是,现有技术中的faster r-cnn网络模型采用vgg16(visual geometry group,超分辨率测试序列)模型为骨干网络,其时间复杂度较大。作为改进,本实施例中,所述烟雾基础检测模型采用resnet50 fpn作为骨干网络,其中的resnet50模型的时间复杂度小于vgg16模型,同时由于resnet50模型采用特殊的bottleneck(瓶颈)残差模块,相较于现有的vgg16模型,其具有网络深、速度快、精度好等优势;同时,为避免resnet50卷积层对小目标检测效果不佳的问题,本实施例中,采用fpn模型对由resnet50卷积层输出的数据进行多尺度特征融合,以便增强烟雾基础检测模型对小目标的检测能力,使得可最终烟雾检测模型可更好地检测到不同大小的烟雾。

61.s2.获取mr(2 1)d网络模型,并基于所述mr(2 1)d网络模型搭建烟雾去误检模型;需要说明的是,也可采用c3d(convolutional 3d,卷积3d)网络模型、r(2 1)d(一种时空卷积模块)网络模型或i3d(interactive three dimensions,交互式3d)网络模型等视频检测模型搭建烟雾去误检模型。

62.本实施例中,获取mr(2 1)d网络模型,如图2所示,包括:

63.s201.获取r(2 1)d模块,并将所述r(2 1)d模块作为mr(2 1)d网络模型的基础模块;具体地,r(2 1)d模块是将三维卷积拆分成空间卷积与时间卷积的时空分离卷积结构;

64.s202.获取mcx模块(其中,mx全拼为mixed convolution,指混合卷积);具体地,

mcx模块是先三维卷积再二维卷积的网络模型;

65.s203.将所述r(2 1)d模块和所述mcx模块进行融合,得到mr(2 1)d网络模型。具体地,mr(2 1)d网络模型是将r(2 1)d模块和mcx模块融合的结构,先进行时空分离卷积,再进行二维卷积实现。在本实施例中,为保证mr(2 1)d网络模型能够加载resnet50卷积层的训练权重,以便其在烟雾基础检测模型的基础上进一步进行训练,还可将mr(2 1)d网络模型与resnet50卷积层的bottleneck模块结合,将bottleneck模块中的二维卷积扩展到三维卷积,以便可得到与烟雾基础检测模型中resnet50卷积层的网络层数一致的最终的mr(2 1)d网络模型。

66.需要说明的是,mr(2 1)d兼具mcx网络模型与r(2 1)d网络模型的优点。具体地,将所述r(2 1)d模块与所述resnet50卷积层的bottleneck模块结合,即通过resnet50卷积层的预训练权重对r(2 1)d模块的权重进行膨胀处理,进而得到mr(2 1)d的初始权重,并以此确定mr(2 1)d网络模型的具体参数及实现结构。

67.需要说明的是,所述resnet50卷积层的bottleneck模块中有两个1

×

1的卷积核,作用分别是降维与升维,在此基础上加上时间维度即可形成时空可分离卷积的mr(2 1)d网络模型。mr(2 1)d网络模型的时空可分离卷积的原理如图3所示,其可仍使用三维卷积核,以将三维卷积的卷积核时空分离,还可以通过将三维卷积核中的时间t设置为1,此时卷积核在时间上的大小为1,那么此时的三维卷积可以认为是二维卷积,之后再将卷积核中的尺寸d设置为1,可以得到只对时间进行卷积的卷积核。将所述r(2 1)d模块与所述resnet50卷积层的bottleneck模块进行拼接,可以大幅度减少参数量,且使得基于mr(2 1)d网络模型搭建的烟雾去误检模型更好训练。

68.具体地,本实施例中,mr(2 1)d网络模型的结构参数如下表1所示:

[0069][0070]

表1

[0071]

s3.获取模型融合模块,并将所述烟雾基础检测模型通过所述模型融合模块与所述烟雾去误检模型进行融合,得到初始烟雾检测模型;具体地,基于faster r-cnn网络模型搭建而成的烟雾基础检测模型的输出是每帧图像上的若干检测框,而基于mr(2 1)d网络模型搭建而成的烟雾去误检模型的输入是8帧相同大小的图像,如将烟雾基础检测模型直接与烟雾去误检模型组合,则会出现烟雾基础检测模型输出的检测框过多与前后帧检测框大小不一致的问题,因而需要采用模型融合模块在时间与空间上融合检测框,从而减小时间复杂度。

[0072]

本实施例中,所述模型融合模块采用mergebox(一种归并排序算法)候选框融合模块。具体地,本实施例中,mergebox候选框融合模块可在时间上将同一帧图片中重叠的检测框做融合操作,可在由烟雾基础检测模型输出的任意两个检测框有重合时,使用一个包含这两个检测框的更大检测框来取代这两个检测框;可在时间上融合不同帧位置有重合的检测框。由于烟雾去误检模型需要8张大小相同的图片作为输入,应在烟雾基础检测模型输出的8帧图像中针对每个烟雾截取出8帧烟雾,一个烟雾在8张图像中的大小位置应当一致,mergebox候选框融合模块可对8帧图像的检测框计算iou(intersection overunion,交并比),如果不同帧的烟雾检测框的iou大于预设的阈值k(本实施例中,在时间上融合不同帧位置有重合的检测框时,k取0.8),则认为这些检测框是同一个烟雾的检测框,并取这些检测框的融合框作为烟雾去误检模型的输入图像。具体地,首先计算第一帧图像与第二帧图像对应的烟雾检测框之间的iou,如该iou>k,则认为第二帧图像对应的烟雾检测框与第一

帧图像对应的烟雾检测框是同一个烟雾的检测框,并将第一帧图像与第二帧图像对应的烟雾检测框进行融合,得到对应的融合框;然后,计算第二帧图像与第三帧图像对应的烟雾检测框之间的iou,如该iou>k,则将第二帧图像与第三帧图像对应的烟雾检测框进行融合,得到对应的融合框,以此类推,直到最后一帧图像计算完成,或任一帧图像与后续帧图像对应的烟雾检测框之间的iou≤k时,将此前得到的融合框作为烟雾去误检模型的输入图像。还需要说明的是,如需在空间上将同一帧图片中重叠的检测框做融合操作,则将k取0。

[0073]

s4.获取数据集,所述数据集中包括多个合成烟雾数据以及分别与多个合成烟雾数据对应的烟雾标签信息,所述烟雾标签信息用于标注所述合成烟雾数据中的模拟烟雾图像;

[0074]

现有技术中,深度学习相关方法面临着缺少数据集的问题。由于现有山火烟雾资料较少,并且大部分是火灾后期近距离拍摄,形态清晰,不能应用在远距离摄像头的实际检测中。另外由于山火烟雾形态上与云、水汽、雾气等相近,所以干扰物较多,单帧图像中目标识别误报数目较多。为解决该技术问题,本实施例进一步作出以下改进:获取数据集中的任一合成烟雾数据时,包括:

[0075]

s401.获取背景图片;具体地,本实施例中,可基于长焦可变焦摄像机拍摄指定区域的视频作为背景视频,然后对背景视频进行剪裁,得到多张背景图片。

[0076]

s402.基于c4d软件(cinema 4d,为maxon公司开发的三维制作软件)生成模拟烟雾图像;

[0077]

s403.根据所述背景图片的成像参数,对所述模拟烟雾图像进行处理,得到处理后模拟烟雾图像;

[0078]

本实施例中,所述背景图片的成像参数包括亮度参数和透明度参数,对所述模拟烟雾图像进行处理时,基于python(一种计算机编程语言)实现,以便于提高模拟烟雾图像与背景图片的融合度。在生成数据集的过程中,本实施例可通过调整烟雾位置、尺寸信息、亮度参数及透明度参数等数据,形成更真实的合成烟雾数据。

[0079]

s404.将所述处理后模拟烟雾图像插入所述背景图片的指定位置,以便将所述处理后模拟烟雾图像与所述背景图片进行合成处理,得到合成烟雾数据;

[0080]

s405.获取所述合成烟雾数据中所述处理后模拟烟雾图像的位置信息,并根据所述位置信息生成烟雾标签信息。本实施例中,所述烟雾标签信息为在所述合成烟雾数据中绘制的包含所述处理后模拟烟雾图像的最小矩形框,所述位置信息为对应最小矩形框的左上角坐标信息和右下角坐标信息。

[0081]

本实施例中的数据集包括图片数据集和/或视频数据集,当获取视频数据集时,可基于c4d软件生成多帧连续的模拟烟雾图像,以便将多帧连续的模拟烟雾图像分别插入对应的多个相同背景图片中,进而生成视频格式的合成烟雾数据,其中视频格式的合成烟雾数据的组织格式可采用现有的ucf101视频数据集(一个现实动作视频的动作识别数据集)的组织格式。

[0082]

本实施例在实施过程中,首先采用c4d流体仿真软件生成若干模拟烟雾图像,然后融合模拟烟雾图像与背景图片,从而构建图片数据集与视频数据集,在此过程中,由于数据集基于仿真软件合成得到,可便于对数据集进行标签标注,解决了数据集收集困难及标注困难的问题。

[0083]

s5.根据所述数据集对所述初始烟雾检测模型进行训练,得到最终烟雾检测模型。

[0084]

本实施例中,基于最终烟雾检测模型对待检测数据进行处理的示意图如图4所示。

[0085]

本实施例的有益效果如下:

[0086]

1)进行烟雾检测的召回率及准确率高。具体地,本实施例在实施过程中,通过基于faster r-cnn网络模型搭建而成的烟雾基础检测模型对待检测数据进行常规目标检测,以便于提高对烟雾图像检测的召回率,然而由于待检测数据的真实场景干扰较多,召回率的提高易导致误报率的增加,因而本实施例基于时空可分离卷积的mr(2 1)d网络模型搭建烟雾去误检模型,以进一步对烟雾基础检测模型输出的检测框进行检测,由此便于在高召回率的前提下进一步降低误报率;在此过程中,由于faster r-cnn网络模型及mr(2 1)d网络模型的特性差异,使得烟雾基础检测模型输出的检测框与烟雾去误检模型需输入的检测框存在大小不一致的问题,因而本实施例通过模型融合模块对烟雾基础检测模型与烟雾去误检模型进行融合,以实现烟雾基础检测模型与烟雾去误检模型在时间与空间上的融合,减小时间复杂度。

[0087]

2)烟雾检测模型的空间复杂度较低,运行速度快。具体地,由于本实施例最终烟雾检测模型中的烟雾基础检测模型基于faster r-cnn网络模型搭建,烟雾去误检模型基于mr(2 1)d网络模型搭建,使得通过最终烟雾检测模型进行烟雾检测时,可先将待检测数据通过烟雾基础检测模型进行二维卷积相关的处理,然后将烟雾基础检测模型输出的检测框通过模型融合模块融合为与烟雾去误检模型的输入检测框要求相匹配的融合后检测框,以便于烟雾去误检模型对融合后检测框进行三维卷积相关的处理,最终得到待检测数据是否存在烟雾的结果,由此使得本实施例的最终烟雾检测模型整体的空间复杂度相对完全使用三维卷积的网络结构较低,运行速度得以提升。

[0088]

实施例2:

[0089]

本实施例提供一种烟雾检测模型构建装置,用于实现实施例1中烟雾检测模型构建方法;如图5所示,所述烟雾检测模型构建装置包括:

[0090]

第一模型搭建单元,用于获取faster r-cnn网络模型,并基于所述faster r-cnn网络模型搭建烟雾基础检测模型;

[0091]

第二模型搭建单元,用于获取mr(2 1)d网络模型,并基于所述mr(2 1)d网络模型搭建烟雾去误检模型;

[0092]

关联单元,分别与所述第一模型搭建单元和所述第二模型搭建单元通信连接,用于获取模型融合模块,并将所述烟雾基础检测模型通过所述模型融合模块与所述烟雾去误检模型进行融合,得到初始烟雾检测模型;

[0093]

模型训练单元,与所述关联单元通信连接,用于获取数据集,所述数据集中包括多个合成烟雾数据以及分别与多个合成烟雾数据对应的烟雾标签信息;还用于根据所述数据集对所述初始烟雾检测模型进行训练,得到最终烟雾检测模型。

[0094]

实施例3:

[0095]

在实施例1或2的基础上,本实施例公开了一种电子设备,该设备可以是智能手机、平板电脑、笔记本电脑或者台式电脑等。电子设备可能被称为用于终端、便携式终端、台式终端等,电子设备包括:

[0096]

存储器,用于存储计算机程序指令;以及,

[0097]

处理器,用于执行所述计算机程序指令从而完成如实施例1中任一所述的烟雾检测模型构建方法的操作。

[0098]

实施例4:

[0099]

在实施例1至3任一项实施例的基础上,本实施例公开了一种计算机可读存储介质,用于存储计算机可读取的计算机程序指令,所述计算机程序指令被配置为运行时执行如实施例1所述的烟雾检测模型构建方法的操作。

[0100]

需要说明的是,所述功能如果以软件功能单元的形式实现并作为独立的产品销售或使用时,可以存储在一个处理器可执行的非易失的计算机可读取存储介质中。基于这样的理解,本发明的技术方案本质上或者说对现有技术做出贡献的部分或者该技术方案的部分可以以软件产品的形式体现出来,该计算机软件产品存储在一个存储介质中,包括若干指令用以使得一台计算机设备(可以是个人计算机,服务器,或者网络设备等)执行本发明各个实施例所述方法的全部或部分步骤。而前述的存储介质包括:u盘、移动硬盘、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)、磁碟或者光盘等各种可以存储程序代码的介质。

[0101]

实施例5:

[0102]

在实施例1的基础上,本实施例公开了一种烟雾检测方法,如图6所示,包括:

[0103]

获取待检测数据;

[0104]

将所述待检测数据输入根据权利要求1至6任一项所述烟雾检测模型构建方法生成的最终烟雾检测模型中进行处理,得到烟雾检测结果,以便于根据烟雾检测结果进行烟雾报警。

[0105]

具体地,本实施例中,待检测数据基于摄像机获取,最终烟雾检测模型中,基于faster r-cnn网络模型搭建而成的烟雾基础检测模型可对摄像机捕获的视频帧进行逐帧检测,摄像机每秒捕捉24帧图像,本实施例将2s的背景视频作为一个片段,一个片段共有48帧,每间隔6帧取一张,即每2s的片段取得8帧图像,检测结果可经过模型融合模块进行融合,使每帧相连的检测框进行融合,再将将各帧之间iou》0.8的检测框进行融合,每个烟雾都取得最大框;随后利用最大框的尺寸信息与位置信息,将烟雾从图像中截取出来8帧烟雾,送入基于mr(2 1)d网络模型搭建而成的烟雾去误检模型中进行去误检,烟雾去误检模型的输出只有两类:是烟雾或不是烟雾。如果烟雾去误检模型检测认为8帧图像是烟雾,则将最大框信息输出,如果烟雾去误检模型检测认为8帧图像不是烟雾,则认为是误检,不予输出。

[0106]

实施例6:

[0107]

在实施例5的基础上,本实施例公开了一种烟雾检测系统,如图7所示,包括:

[0108]

数据采集单元,用于获取待检测数据;

[0109]

数据检测单元,与所述数据采集单元通信连接,用于接收所述待检测数据,并对所述待检测数据进行检测,得到烟雾检测结果;

[0110]

烟雾报警单元,与所述数据检测单元通信连接,用于根据所述烟雾检测结果进行烟雾报警。

[0111]

显然,本领域的技术人员应该明白,上述的本发明的各模块或各步骤可以用通用的计算装置来实现,它们可以集中在单个的计算装置上,或者分布在多个计算装置所组成

的网络上,可选地,它们可以用计算装置可执行的程序代码来实现,从而,可以将它们存储在存储装置中由计算装置来执行,或者将它们分别制作成各个集成电路模块,或者将它们中的多个模块或步骤制作成单个集成电路模块来实现。这样,本发明不限制于任何特定的硬件和软件结合。

[0112]

以上实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换。而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的精神和范围。

[0113]

最后应说明的是,本发明不局限于上述可选的实施方式,任何人在本发明的启示下都可得出其他各种形式的产品。上述具体实施方式不应理解成对本发明的保护范围的限制,本发明的保护范围应当以权利要求书中界定的为准,并且说明书可以用于解释权利要求书。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。