1.本发明属于无人驾驶领域,具体涉及基于相机图像驱动的激光雷达点云目标检测方法及系统。

背景技术:

2.自动驾驶车辆在道路上自主行驶时需要对周围三维场景进行检测,获取物体在三维空间中的类别(例如,汽车,行人和骑自行车的人等),并返回其几何空间位置、方向、及语义实例标签,对后续的风险评估、路径规划、决策控制具有重要指导作用。场景数据可以通过相机或激光雷达等传感器获得,根据传感器类型,三维目标检测方法主要分为三种:基于激光点云的三维目标检测、基于视图的三维目标检测和基于多传感器融合的三维目标检测;基于激光点云的方案可直接从点云中检测三维目标,但很难在大规模、稀疏和非结构化的点云中准确高效地搜索对象。基于视图的方案将三维点云转换为二维视图,并利用成熟的图像检测器来检测目标。但是,从三维空间到二维视图的投影可能会丢失三维空间中一些与几何相关的空间信息,多传感器融合方案基于激光点云和基于视图的方法的优势,能显著提高三维目标检测性能。

3.现有的方法先假定图像中二维候选框的可用性,这些候选框可以从现成的目标探测器中获得。然后将检测的二维候选框反投影到三维空间得到三维视锥体点云区域。通过沿视锥体轴滑动为每个区域建议生成一系列(可能重叠的)视锥体。这些获取的视锥体定义局部点云集合。给定视锥体和点关联的序列,利用pointnet将点向特征聚合为视锥体级特征矢量。

4.然后,在其早期阶段,这些特征向量作为二维特征映射,并使用后续的全卷积网络(fcn)来下采样和上采样视锥体,以便其特征以更高的视锥体分辨率在视锥体轴上完全融合。与最终检测头一起,该方法支持定向三维框的端到端连续估计,同时还提出了提取多分辨率视锥体特征的全卷积网络变体。

5.现有技术的缺点:无法从有背景和杂波干扰的视锥体点准确地检测到目标物,且在检测过程中没有利用物体的背景信息,导致检测效果不是最优;不准确的二维候选框导致检测结果不够准确,在反向投影中容易丢失目标边界信息。

技术实现要素:

6.本发明所为了解决背景技术中存在的技术问题,目的在于提供了基于相机图像驱动的激光雷达点云目标检测方法及系统。

7.为了解决技术问题,本发明的技术方案是:

8.基于相机图像驱动的激光雷达点云目标检测方法,所述方法包括:

9.对相机图像数据与激光雷达点云数据,进行预处理,得到视锥体点云数据;

10.构建一阶段检测框预测网络,并设计损失函数对该网络进行优化,利用优化后的一阶段检测框预测网络对视锥体点云数据进行处理,得到目标三维检测框;

11.构建二阶段检测框优化网络,并设计损失函数对二阶段检测框优化网络进行优化,利用优化后的二阶段检测框优化网络对放大的所述目标三维检测框内点云数据进行处理,得到精确目标三维检测框,即实现了对自动驾驶车辆行驶场景的目标检测。

12.进一步,所述预处理,具体包括:

13.获取相机图像数据与激光雷达点云数据;

14.对所述图像数据进行目标检测处理,得到目标物的二维检测框;

15.基于目标物的二维检测框,利用相机坐标系与激光雷达坐标系的投影关系,从激光雷达点云数据中截取视锥体点云数据。

16.进一步,采用装在无人驾驶车辆上的相机和激光雷达分别采集得到相机图像数据与激光雷达点云数据。

17.进一步,所述对视锥体点云数据进行处理,具体包括:

18.利用上下文前景点分割网络处理视锥体点云数据,得到目标上下文前景点;

19.利用目标中心点及边界框预测网络处理目标上下文前景点,得到目标三维检测框。

20.进一步,利用上下文前景点分割网络处理视锥体点云数据,具体包括:

21.利用点云分割网络处理视锥体点云数据,得到目标前景点和背景点;

22.利用相邻搜索算法从背景点中收集目标上下文点,并将目标前景点与收集的目标上下文点融合,得到目标上下文前景点。

23.进一步,利用目标中心点及边界框预测网络处理目标上下文前景点,具体包括:

24.利用目标中心点预测网络对目标上下文前景点进行处理,得到目标预估中心点坐标;

25.基于该目标预估中心点坐标,将所述目标上下文前景点转换至目标坐标系;

26.利用边界框预测网络对转换坐标后的上下文前景点进行处理,得到目标三维检测框。

27.进一步,所述对目标三维检测框进行处理,具体包括:

28.把放大的所述目标三维检测框内的点云数据作为二阶段检测框优化网络的输入;

29.经过与一阶段相同的点云分割网络、目标中心点预测网络及边界框预测网络处理,得到精确目标三维检测框。

30.进一步,构建一阶段检测框预测网络,设计包含点云分割、中心点预测、检测框预测及目标分类的多任务损失函数,具体为:

31.l

multi-task

=l

seg

l

objectness

l

center-reg

l

box

;

32.其中,l

seg

为语义分割损失,l

center-reg

为检测框中心点的回归损失,l

obiectness

为目标分数损失;

33.l

box

=l

center-reg_box

l

ang-cls

20l

angle-reg

l

size-cls

20l

size-reg

10l

corner

;

34.其中,l

center-reg-box

为预测中心点的残差损失,l

ang-cls

和l

angle-reg

分别代表角度分类损失和回归损失,l

size-cls

和l

size-reg

分别代表检测框的分类损失和回归损失,角点损失l

corner

为有预测框角点与真值框的角点最小距离。

35.进一步,构建二阶段检测框优化网络,设计与一阶段相同的包含点云分割、中心点预测、检测框预测及目标分类的多任务损失函数,具体为:

36.l

multi-task

=l

seg

l

objectness

l

center-reg

l

box

;

37.其中,l

seg

为语义分割损失,l

center-reg

为检测框中心点的回归损失,以及l

obiectness

为目标分数损失;

38.l

box

=l

center-reg_box

l

ang-cls

20l

angle-reg

l

size-cls

20l

size-reg

10l

corner

;

39.其中,l

center-reg-box

为预测中心点的残差损失,l

ang-cls

和l

angle-reg

分别代表角度分类损失和回归损失,l

size-cls

和l

size-reg

分别代表检测框的分类损失和回归损失,角点损失l

corner

为预测框角点与真值框的角点最小距离。

40.基于相机图像驱动的激光雷达点云目标检测系统,所述系统包括:

41.一个或多个处理器;

42.存储器,用于存储一个或多个程序;

43.当所述一个或多个程序被所述一个或多个处理器执行时,使得所述一个或多个处理器执行如上述任一所述的基于相机图像驱动的激光雷达点云目标检测方法。

44.与现有技术相比,本发明的优点在于:

45.所提出的两阶段三维目标检测网络能够高效、准确地从室内外场景获取的图像与激光点云数据中检测三维目标。阶段一网络能够对基于图像检测结果反投影得到的视锥体点云中定位三维目标,阶段二网络则基于阶段一网络的结果优化检测框,提升对被遮挡或远距离物体的检测效果。

46.提出的上下文前景点提取模块通过考虑目标上下文信息来增强检测结果,通过提取前景点一定范围内的背景点作为上下文前景点,显著提升目标检测结果。

47.通过融合从二维图像中学习到的语义特征以及三维空间中基于目标和目标上下文的信息,可以实现提升三维边界框预测的精度。

附图说明

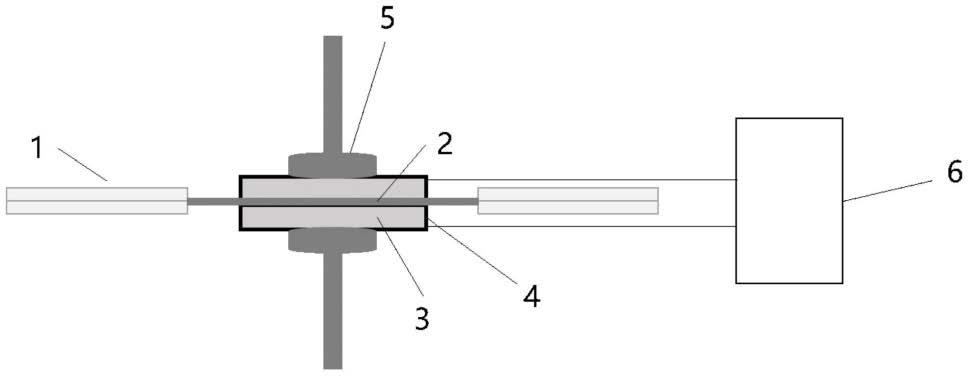

48.图1、基于相机图像驱动的激光雷达点云目标检测框架;

49.图2、上下文前景点提取;

50.图3、在kitti数据集上前视图目标检测及激光雷达点云目标检测结果。

具体实施方式

51.下面结合实施例描述本发明具体实施方式:

52.需要说明的是,本说明书所示意的结构、比例、大小等,均仅用以配合说明书所揭示的内容,以供熟悉此技术的人士了解与阅读,并非用以限定本发明可实施的限定条件,任何结构的修饰、比例关系的改变或大小的调整,在不影响本发明所能产生的功效及所能达成的目的下,均应仍落在本发明所揭示的技术内容能涵盖的范围内。

53.同时,本说明书中所引用的如“上”、“下”、“左”、“右”、“中间”及“一”等的用语,亦仅为便于叙述的明了,而非用以限定本发明可实施的范围,其相对关系的改变或调整,在无实质变更技术内容下,当亦视为本发明可实施的范畴。

54.实施例1:

55.基于相机图像驱动的激光雷达点云目标检测方法,所述方法包括:

56.对相机图像数据与激光雷达点云数据,进行预处理,得到视锥体点云数据;

57.构建一阶段检测框预测网络,并设计损失函数对该网络进行优化,利用优化后的一阶段检测框预测网络对视锥体点云数据进行处理,得到目标三维检测框;

58.构建二阶段检测框优化网络,并设计损失函数对二阶段检测框优化网络进行优化,利用优化后的二阶段检测框优化网络对放大的所述目标三维检测框内点云数据进行处理,得到精确目标三维检测框,即实现了对自动驾驶车辆行驶场景的目标检测。

59.可以理解:所提出的两阶段三维目标检测网络能够高效、准确地从室内外场景获取的图像与激光点云数据中检测三维目标。阶段一网络能够对基于图像检测结果反投影得到的视锥体点云中定位三维目标,阶段二网络则基于阶段一网络的结果优化检测框,提升对被遮挡或远距离物体的检测效果。

60.提出的上下文前景点提取模块通过考虑目标上下文信息来增强检测结果,通过提取前景点一定范围内的背景点作为上下文前景点,显著提升目标检测结果。

61.通过融合从二维图像中学习到的语义特征以及三维空间中基于目标和目标上下文的信息,可以实现提升三维边界框预测的精度。

62.进一步,所述预处理,具体包括:

63.获取相机图像数据与激光雷达点云数据;

64.对所述图像数据进行目标检测处理,得到目标物的二维检测框;

65.基于目标物的二维检测框,利用相机坐标系与激光雷达坐标系的投影关系,从激光雷达点云数据中截取视锥体点云数据。

66.进一步,采用装在无人驾驶车辆上的相机和激光雷达分别采集得到相机图像数据与激光雷达点云数据。

67.进一步,所述对视锥体点云数据进行处理,具体包括:

68.利用上下文前景点分割网络处理视锥体点云数据,得到目标上下文前景点;

69.利用目标中心点及边界框预测网络处理目标上下文前景点,得到目标三维检测框。

70.进一步,利用上下文前景点分割网络处理视锥体点云数据,具体包括:

71.利用点云分割网络处理视锥体点云数据,得到目标前景点和背景点;

72.利用相邻搜索算法从背景点中收集目标上下文点,并将目标前景点与收集的目标上下文点融合,得到目标上下文前景点。

73.进一步,利用目标中心点及边界框预测网络处理目标上下文前景点,具体包括:

74.利用目标中心点预测网络对目标上下文前景点进行处理,得到目标预估中心点坐标;

75.基于该目标预估中心点坐标,将所述目标上下文前景点转换至目标坐标系;

76.利用边界框预测网络对转换坐标后的上下文前景点进行处理,得到目标三维检测框。

77.进一步,所述对目标三维检测框进行处理,具体包括:

78.把放大的所述目标三维检测框内的点云数据作为二阶段检测框优化网络的输入;

79.经过与一阶段相同的点云分割网络、目标中心点预测网络及边界框预测网络处理,得到精确目标三维检测框。

80.进一步,构建一阶段检测框预测网络,设计包含点云分割、中心点预测、检测框预

测及目标分类的多任务损失函数,具体为:

81.l

multi-task

=l

seg

l

objectness

l

center-reg

l

box

;

82.其中,l

seg

为语义分割损失,l

center-reg

为检测框中心点的回归损失,l

objectness

为目标分数损失;

83.l

box

=l

center-reg_box

l

ang-cls

20l

angle-reg

l

size-cls

20l

size-reg

10l

corner

;

84.其中,l

center-reg_box

为预测中心点的残差损失,l

ang-cls

和l

angle-reg

分别代表角度分类损失和回归损失,l

size-cls

和l

size-reg

分别代表检测框的分类损失和回归损失,角点损失l

corner

为有预测框角点与真值框的角点最小距离。

85.进一步,构建二阶段检测框优化网络,设计与一阶段相同的包含点云分割、中心点预测、检测框预测及目标分类的多任务损失函数,具体为:

86.l

multi-task

=l

seg

l

objectness

l

center-reg

l

box

;

87.其中,l

seg

为语义分割损失,l

center-reg

为检测框中心点的回归损失,以及l

obiectness

为目标分数损失;

88.l

box

=l

center-reg_box

l

ang-cls

20l

angle-reg

l

size-cls

20l

size-reg

10l

corner

;

89.其中,l

center-reg_box

为预测中心点的残差损失,l

ang-cls

和l

angle-reg

分别代表角度分类损失和回归损失,l

size-cls

和l

size-reg

分别代表检测框的分类损失和回归损失,角点损失l

corner

为预测框角点与真值框的角点最小距离。

90.基于相机图像驱动的激光雷达点云目标检测系统,所述系统包括:

91.一个或多个处理器;

92.存储器,用于存储一个或多个程序;

93.当所述一个或多个程序被所述一个或多个处理器执行时,使得所述一个或多个处理器执行如上述任一所述的基于相机图像驱动的激光雷达点云目标检测方法。

94.实施例2:

95.如图1所示,所提出的方法由两个阶段组成:第一阶段用于边界框预测网络,第二阶段用于边界框优化网络。两个网络都包含点云分割、中心预测和边界框预测模块。图1显示了本文提出的物体检测方法的框架。

96.在我们的方法中,首先使用二维目标检测器检测二维边界框,然后使用已知的相机投影矩阵将这些边界框投影成三维视锥体。这种视锥体定义了点云中目标检测的三维搜索区域。收集相机坐标中的点以形成视锥体点云。这种机制可以利用成熟的二维检测器并大大降低基于点的三维目标检测框架的计算成本。为了提高所提出方法的旋转不变性,这些视锥被归一化以使视锥的中心轴与图像平面正交。在提出的两阶段基于点的检测框架中,阶段一网络预测视锥体点云内的边界框作为输入,而阶段二网络使用放大的预测边界框中的点来优化预测结果,以补偿不正确的二维检测结果。

97.a.边界框预测

98.1)上下文前景点分割

99.在归一化的视锥点内,有两条方法来检测物体:(1)直接从点云中检测物体;(2)首先提取前景点,然后使用这些点预测边界框。尽管视锥体点减少了最不相关的背景和杂波,但剩余的点和重叠目标仍然会干扰目标的精确定位。

100.前景点分割可以根据前景上下文准确定位关联目标。为了利用每个前景点的几何

特征,我们将具有编码器-解码器结构的多尺度geoconv[2]应用于输入视锥体点。由于geoconv只能提取目标内特征,随着下采样规模的增加,pointnet[3]被用于我们的主干中来提取目标间特征。从二维图像中学习到的语义线索也可用于分割。此类信息被编码为独热编码类向量并与学习到的全局特征连接,然后反向传播到逐点类标签的特征。这个分割网络是一个二元分类,它分割背景和前景点。图2显示了所提出的上下文前景点收集方法的过程。

[0101]

目标周围的上下文信息可以提高边界框推理的准确性[4]。

[0102]

因此,本文提出了一种上下文前景点收集方法,用于从背景点中收集上下文点(见图2)。对于每个背景点,我们收集其16个最邻近点。如果至少有1个前景点,则将此背景点标记为上下文点。查询球搜索和最邻近搜索通常用作相邻搜索方法。最邻近搜索在不考虑距离的情况下搜索最近的点。因此,远离前景点的背景点有可能被选为上下文点。这些点对物体检测的贡献有限。为了避免这种污染,实验选择半径为0.9m的查询球搜索作为相邻搜索方法。该方法不仅选择了附近的背景点,而且还保持了目标的几何属性。将所有上下文点和前景点组合为用于边界框预测的上下文前景点。实验结果证明了该方法的有效性。

[0103]

2)残差中心估计和边界框预测

[0104]

坐标变换在提高物体检测性能方面至关重要。这些转换可以对齐一组受约束和规范框架中的点。具体来说,面向目标中心的变换可以帮助三维检测器利用目标几何属性,例如对称性和平面性。在获得的上下文前景点中,我们通过减去它们的平均坐标来将这些点归一化为局部坐标,以提高平移不变性。然后将这些点输入到t-net网络中以预测残差框中心。计算时不考虑上下文点以使预测中心更接近目标部分。然后将归一化点转换为预测目标中心,用于具有规范坐标的边界框预测。

[0105]

为了预测准确的边界框,边界框预测网络应该考虑目标的基于上下文和基于目标的特征。基于目标的特征编码目标信息,而基于上下文的特征提供目标的周围信息。因此,从上下文前景点中提取的特征代表了基于目标的属性。从视锥点学习的特征更适合表示基于上下文的特征。在本文中,将从前景分割网络中提取的基于上下文的特征与从规范上下文前景点中学习的基于目标的特征连接起来,以预测边界框参数。pointnet被选为边界框预测网络。此外,每个点的反射属性和从二维检测框中学习的语义特征也被编码用于边界框预测。实验结果证明了该网络的有效性。

[0106]

在该算法中,每个三维边界框的参数化为(x,y,z,h,w,l,θ,score),其中(x,y,z)代表目标中心点,(h,w,l)代表目标尺寸(长,宽,高),θ代表目标的方向,score代表目标分数.对于角度预测,我们预先定义na和ns并作为等分的角度和尺寸柱,并将角度和大小分类到不同的箱中。残差相对于柱值进行回归。na设置为12,ns设置为8。边界框预测网络输出3 4

×ns

2

×

na 2。

[0107]

b.边界框优化

[0108]

尽管现有成熟的二维测器检测到的二维区域足够精确,但它们不能准确地框住目标实例。较大的二维框包含整个目标实例但也包含更多不相关的背景和杂波,而较小的二维框包含较少的背景噪声但不能提供完整的三维目标实例。为了弥补这一点,在优化阶段,我们收集放大的预测边界框中的点作为输入。具体来说,我们将每个预测框放大了一个选定的因子,在这项工作中设置为1.2。

[0109]

这个放大框中的点进行归一化处理。为了进一步提高三维检测性能,考虑了逐点、基于目标和基于上下文的特征来提取细粒度的框信息。输入点包含目标和有限的上下文点,我们可以将这些点视为上下文前景点。因此,在此阶段移除上下文前景点提取模块,其他模块与一阶段网络相同。所有输入点都用于学习边界框信息。在分割网络中学习到的逐点特征与在残差中心预测网络和边界框预测网络中学习到的点精确特征相连接,分别生成基于目标的特征。类似地,在分割阶段获得的基于上下文的特征分别与单热语义二维线索和基于目标的特征连接,分别用于残差中心预测和边界框预测。这个阶段的边界框预测网络也输出3 4

×ns

2

×

na 2。

[0110]

目标检测损失和语义分割损失都是两类交叉熵损失。我们采用类似的基于柱的分类和回归损失进行边界框优化。

[0111]

边界框损失使用huber损失的进行中心回归、航向估计和尺寸估计等子损失组成:

[0112][0113]

其中l

center-reg_box

预测中心点的残差损失,l

ang-cls

和l

angle-reg

分别代表角度分类损失和回归损失.l

size-cls

和l

size-reg

分别代表检测框的分类损失和回归损失.角点损失l

corner

是有预测框角点与真值框(包括旋转90

°

)的角点最小距离。

[0114]

目标分数的真值可利用预测框中心到真值框中心的距离进行标注,如果距离大于0.3米,真值标记为1,反之为0。这样使得预测分数与预测框之间存在几何关联。因此整个网络的损失可以定义为:

[0115]

l

multi-task

=l

seg

l

objectness

l

center-reg

l

box

ꢀꢀꢀꢀ

(2)

[0116]

其中,l

seg

是语义分割损失,l

center-reg

检测框中心点的回归损失,以及l

obiectness

是目标分数损失。

[0117]

文献引用:

[0118]

[1]z.wang,and k.jia,“frustum convnet:sliding frustums to aggregate local point-wise features for amodal 3d object detection,”ieee/rsj iros,pp.1742-1749,2019.

[0119]

[2]c.r.qi,w.liu,c.wu,h.su,and l.j.guibas,

″

frustum pointnets for 3dobject detection from rgb-d data,

″

in proc.ieee cvpr,p.918-927,2018.

[0120]

[3]y.li,l.ma,w.tan,c.sun,d.cao,and j.li,“grnet:geometric relation network for 3d object detection from point clouds,

″

isprs j.photogramm.remote sens.,vol.165,pp.43-53,2020.

[0121]

[4]c.r.qi,h.su,k.mo,and l.j.guibas,"pointnet:deep learning on point sets for 3d classification and segmentation,"in proc.ieee cvpr,pp.652-660,2017.

[0122]

实施例3:

[0123]

在实施例中,基于图像的深度学习目标检测方法可以替换成其他基于规则的目标检测算法或者是其他的深度学习算法。此外,本实施例中的三维目标检测方法也可以换成基于体素或图卷积的目标检测算法,最终输出的结果都是目标的三维包围框的尺寸与中心位置及目标的类别。

[0124]

如图3所示,图3为在kitti数据集上前视图目标检测及激光雷达点云目标检测结果。

[0125]

如表1所示,在kitti数据集上激光雷达点云目标检测、鸟瞰图目标检测及前视图目标检测的ap值对比。

[0126]

表1

[0127][0128]

如表2所示,在kitti数据集上模型大小、训练时间及模型训练参数;

[0129]

表2

[0130][0131][0132]

上面对本发明优选实施方式作了详细说明,但是本发明不限于上述实施方式,在本领域普通技术人员所具备的知识范围内,还可以在不脱离本发明宗旨的前提下做出各种变化。

[0133]

不脱离本发明的构思和范围可以做出许多其他改变和改型。应当理解,本发明不限于特定的实施方式,本发明的范围由所附权利要求限定。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。