1.本发明涉及文本情感分析技术,特别涉及基于图卷积网络的中文情感分析技术。

背景技术:

2.自然语言处理nlp就是一个对人们平时所使用的语言进行处理使得计算机能够理解的一项工作,情感分析是nlp领域中一个非常重要的组成部分,是通过对文本内容进行深入分析,挖掘出背后所隐藏的主客观情感,判断其情感倾向。通常会从粒度大小进行区分,从三个方面来对文本情感分析进行研究,分别是:方面级、句子级、篇章级。

3.方面级情感分析absa是目前细粒度最小的一种分析方式,它目的是分析在文本可能存在的各个方面实体的情感倾向。人们所表达的各种文本中所体现的情感并不是只有正面和负面两种而是更加复杂多样的,体现在文本情感分析中,对文本的情感分类标签不止有二分类,还涌现出了包含正面,中性,负面的三分类标签和包含非常正面,一般正面,中性,一般负面,非常负面的五分类。

4.向量空间模型最初使用一种独热编码(one-hot)对文本信息进行向量化表示便于计算机处理,是种非常简洁直观且常用的文本表示方法,独热编码得到的向量是由0和1表示,向量中唯一一个1所处的位置就是该单词在词典中所处的绝对位置,所以以独热编码方法得到的向量表示的维数取决于词典中总计拥有的单词个数。这样能够保证文本中的每一个词语的向量化表示是唯一的不会产生冲突。我们通过一个例子来阐释独热码的原理,比如文本为“我爱吃苹果”,词典中的单词有“苹果、爱、我、吃”,根据独热编码方式,可以得到例句的编码表为:[0,0,1,0]、[0,1,0,0]、[0,0,0,1]、[1,0,0,0]。我们最终通过将在这几个向量相拼接就能够将“我爱吃苹果”这句话通过一个矩阵进行表示。对于独热编码中存在的一些缺点,一种优化方法就是为文本中的每个单词赋予一个权重,自然而然地就能想到使用单词出现的频次作为每一个单词的权重是最简单的方法,但是单词的频次越高并不能代表这个单词对句子的含义影响就越大,例如英文中的“the”,中文中的“啊”、“的”等,在日常使用中出现的频率极高,但是对句意额影响极低。

[0005]

词频-逆文档频率tf-idf是一种更加有效地计算频率权重的方式,其中tf(term frequency)代表的是某个单词在某篇文档中被使用到的的频率。而idf(inverse document frequency)指的是该单词的普遍程度,含有该单词的文档数目越少则idf就越大,则代表该利用该单词能够很好的对不同的文档进行辨别。bengio首次将神经网络应用到词向量的训练任务中,提出了自然网络语言模型(neural network language model,nnlm),在输入时使用独热码编码,然后通过三层神经网络将其映射为低维度向量。伴随神经网络在理论上的不断创新发展与计算机硬件的不断成熟和低廉,许多研究者们也将神经网络用于对文本进行处理,利用神经网络获得更好的文本向量表示,由tomas mikolov发布的word2vec模型就是一种经典的词嵌入工具,是一种对nnlm的改良,精简掉了nnlm中的非线性隐藏层,word2vec的主要工作就是进行预训练将稀疏的词特征向量变成稠密的特征向量,得到了学术界和工业界的广泛应用。

[0006]

word2vec主要根据不同的任务设计了两个不同的模型,分别为连续词袋模型cbow与skip-gram模型。

[0007]

图神经网络transformer

[0008]

transformer的核心就是注意力机制,是一种完全由自注意力机制与前馈神经网络所组成的结构。transformer并且有使用传统神经网络如cnn,rnn等,而是完全只使用自注意力机制(self-attention)机制对输入进行特征提取和建模。由于其不再依赖输入序列的顺序,能够对输入序列进行并行计算,且有着高效的捕捉长距离单词之间联系的能力。bert预训练模型在当下红极一时,在许多任务中都取得了sota的好成绩,bert的核心就在于堆叠多层的transformer结构。

[0009]

transformer主要由编码器encoder与解码器decoder构成,由于在本文的情感分类任务中主要使用transformer中的编码器部分,我们将对编码器做出详细介绍。在文本表示向量被送入transforer的encoder结构之前会进行位置编码,给每一个词向量一个位置向量。

[0010]

transformer结构的输入是由文本的词向量表示加上上一步中得到的位置向量所构成的。编码器中含有许多个结构相同的子结构,每个子结构中都含有一个多头自注意力层与全连接前馈网络层,每层都包含有归一化与残差连接操作。

[0011]

图卷积网络gcn

[0012]

gcn利用了图谱理论在谱空间定义了图的卷积,图卷积神经网络开始走进大家的视野,成为了众多gnn网络结构中最被大家所接受的一种网络框架,目前被广泛应用的一种gcn结构是kipf等人提出的一个图谱卷积的局部一阶近似。图卷积网络通过将每一个节点及其邻近节点生成为该节点的一种嵌入向量表示形式,这种表示形式能够将该节点与其邻近节点的依赖特征关系包含其中,在对一些包含丰富依赖和连接关系的信息进行处理时有着很高的效率,在实际工程中都会为每一个节点加入一个自环。

[0013]

图卷积网络也被广泛应用于推荐系统,动作识别和流量预测领域。在自然语言处理领域,图卷积网络也被证实在事件检测,语义角色标记,文本分类等领域有着不错的性能表现。这些研究表明了图卷积网络能够高效地捕捉节点之间的依赖连接关系,对于图结构的数据有着传统卷积神经网络无法比拟的优势。

[0014]

中文互联网正在经历蓬勃发展,中文也是世界上使用人数最多的语言之一,对中文文本进行情感分析就成为了一项重要的任务。现如今对于句子级情感分析主要集中在对英文文本进行分析,许多模型在中文数据集上进行情感分析时没有对中文句法与词性信息进行充分利用。

技术实现要素:

[0015]

本发明所要解决的技术问题是,提供一种能对文本中中文句法与词性信息进行充分利用的中文情感分析方法。

[0016]

本发明为解决上述技术问题所采用的技术方案是,基于图卷积网络融合句法依存与词性的中文情感分析方法,包括以下步骤:

[0017]

1)词嵌入步骤:采用词向量模型对上下文文本和方面词进行向量化表示;词向量模型将每个待分析的中文文本矩阵与文本中单词的词性标注矩阵进行拼接操作,得到既融

合了语义特征信息又融合了文本词性特征的上下文文本向量;

[0018]

2)特征提取步骤:将图卷积网络中的编码部分与长短期记忆网络lstm进行融合,利用图卷积网络中的编码部分分别对上下文文本向量与方面词向量进行编码得到具有句法依存关系的上下文文本编码与方面词编码,分别将上下文文本编码与方面词编码输出至lstm,lstm的隐藏层输出具有上下文特征的隐藏层向量hc和具有语义信息的隐藏层向量ht至交互多头注意网络;

[0019]

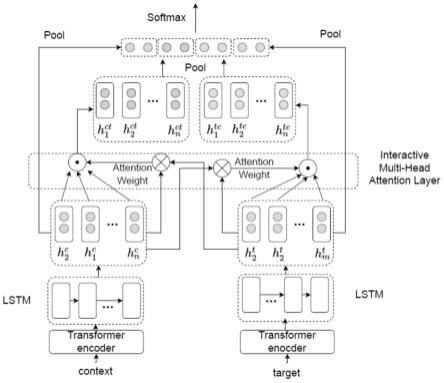

3)交互多头注意步骤:多头交互注意力网络对具有上下文特征的隐藏层向量hc和具有语义信息的隐藏层向量ht分别通过多头注意力得到经过注意力值加权之后的向量矩阵hct、htc;

[0020]

4)向量表示融合与情感极性分类步骤:将隐层向量矩阵hc、ht与交互多头注意力机制输出的两个矩阵hct、htc进行均值池化,然后将这4个矩阵池化结果进行拼接,得到融合后的文本表示,最后将融合之后的文本表示通过softmax进行概率计算确定情感极性。

[0021]

本发明的有益效果是,将中文中的词性标记与向量表示相融合,再利用图卷积网络对句法依存关系进行特征提取,特征提取时将图卷积网络中的编码部分与lstm网相结合,使用图卷积网络的强大的特征学习能力学习上下文中单词之间的特征关系,与目标方面词中单词之间的特征关系,使用lstm学习二者的序列相对位置特征,通过取长补短让特征提取模块既拥有强大特征提取能力,又能够不丢失相对位置信息,本发明方法的在中文数据集的情感分析上有良好的表现。

附图说明

[0022]

图1为实施例lstm融合transformer-encoder的特征提取模块结构图;

[0023]

图2为“今天天气很好。”的依存分析树;

[0024]

图3为对句子的词性标注示意图;

[0025]

图4为实施例融合transformer-encoder与lstm结构的多头交互注意力方面级情感分析模型示意图。

具体实施方式

[0026]

实施例提出的融合transformer-encoder与lstm的多头交互注意力机制方面级情感分析模型中特征提取模块是由transformer的encoder层与长短期记忆lstm网络所组成,也就是说使用lstm模型取代了transformer的decoder层。通常来说transformer结构与lstm结构都可以用来在序列信息中提取特征,lstm通过引入三个门结构,获得了能够捕捉长距离特征信息的能力,并且由于其是按照一定顺序输入的,天然适合处理有序的序列,但是其仍然有速度慢,不能并行计算,没有完全解决梯度消失问题的缺点。

[0027]

transformer结构通过堆叠注意力的方式能够获得强大的学习能力,一次性输入所有词句,让其获得了并行计算的能力,但是同时由于其使用函数式绝对位置编码方式,为每一个词通过三角函数的方式计算一个位置向量,这样的方式导致其失去了词语词之间的相对位置关系。例如句子“我喜欢你”与句子“你喜欢我”,词与词之间的相对位置发生了改变会导致句子的意思发生天翻地覆的变化。所以我们将transformer的encoder结构与lstm网络相结合,使用transformer的强大的特征学习能力学习上下文中单词之间的特征关系,

与目标方面词中单词之间的特征关系,使用lstm学习二者的序列相对位置特征,通过取长补短让特征提取模块既拥有强大特征提取能力,又能够不丢失相对位置信息。

[0028]

实施例模型中的lstm融合transformer-encoder的特征提取模块结构如图1,包括transformer的encoder接收输入input,其输出与lstm相连,lstm的输出即为特征提取模块的输出;

[0029]

transformer的encoder包括多头注意力机制multi-head attention、残差相加与归一化模块add&norm和前馈层feed forward layer,

[0030]

multi-head attention通过不同的线性变化将输入的q、k、v三个矩阵映射到不同的维度的空间,针对不同的维度空间上存在不同的特征,多头注意力能够提取多种注意力信息,多种注意力信息与输入数据通过进行拼接add&norm,拼接得到的特征再与其自身经过feed forward layer的结果进行拼接add&norm得到最终输出。

[0031]

以往的方面级情感分析模型,往往忽略了对目标方面词的关注的建模,而只关注于目标上下文。实施例提出的交互多头注意力机制由两部分组成,一个部分是上下文文本矩阵作为注意力函数中的查询query,目标方面词矩阵作为键key的多头注意力部分,另一个部分是将上下文文本矩阵作为key,而将目标方面词作为query的多头注意力部分。这两个部分分别代表了对于上下文文本来说目标方面词的哪些内容对自己比较重要,和对于目标方面词来说上下文文本中哪些方面对自己比较重要这两方面的信息。经过这样交互注意的方式可以充分获取文本与目标方面词相互之间的特征关系。同时采用多头注意力机制也能大大增加模型的并行计算能力,从而提升模型的性能,在不同的特征空间内提取更加多样的特征信息。

[0032]

基于图卷积网络的词性与句法依存关系的中文文本情感分析模型:

[0033]

中文有与英文不一样的句法依存关系,英文通常以单个单词作为一个词,而中文则是许多字构成一个词,每个中文词有自己不同的词性。针对这些特点实施例提出将中文中的词性标记与向量表示相融合,再利用图卷积网络对句法依存关系进行特征提取,在中文数据集上有良好的表现。中文与英文的语法不同,相比较有着更复杂的句法结构,可能会导致同样的模型在中文语料下就会存在性能的降低的情况。为了更有效的分析一个句子的句法结构,可以引入句法依存分析树,根据对主谓,动宾等句法关系的提取来表示句子中不同主体之间的依存关系。图2展示了一个中文句子“今天天气很好。”的依存分析树。“今天”为核心词root,“今天”和“好”之间存在依存关系中的核心关系hed,“天气”与“好”之间存在依存关系中主谓关系sbv,“今天”与“天气”之间存在依存关系中的定中关系att,“今天”与“的”之间存在依存关系的右附加关系,“好”与“很”之间存在依存关系中的状中关系adv。对于该句子的词性标注如图3,“今天”为机构团体nt、“的”为组词u、“天气”为名词n、“很”为副词d,“好”为形容词a。

[0034]

一个单词的词性对其所表示的含义也有着巨大的影响,一个词的词性代表了其在一个句子中所发挥的作用,对一个词的词性进行标记也是目前文本处理领域的一个重难点,因为词语往往具有一次多义的情况,有时候既可以作为名词也可以作为形容词。语言技术平台ltp工具中也提供了对于中文词语的词性标注功能,我们也将使用ltp来对我们的数据进行词性标注工作。

[0035]

实现实施例方面级情感分析方法的融合transformer-encoder与lstm结构的多头

交互注意力方面级情感分析模型,其结构如图2所示,包括词嵌入模块、特征提取模块、交互多头注意模块和向量表示融合与情感极性分类模块,分别实现以下步骤:

[0036]

(1)词嵌入步骤:在我们的模型中,我们采用预训练好的词向量模型glove对上下文文本c和方面词t进行向量化表示为wc与wt。

[0037]

(2)特征提取步骤:将transformer结构中的encoder部分与lstm网络进行融合,分别对n个上下文文本与m个方面词进行编码,最后将lstm网络的隐藏层输出作为结果,得到具有上下文特征和语义信息的隐藏层向量具有上下文特征和语义信息的隐藏层向量与

[0038]

(3)交互多头注意步骤:这一层中将使用多头交互注意力网络interactive multi-head attention layer,对上下文与目标方面词通过多头注意力得到经过注意力值attention weight加权之后的两个不同的向量矩阵与

[0039]

(4)向量表示融合与情感极性分类步骤:将隐层向量矩阵hc、ht与交互多头注意力机制输出的两个矩阵hct、htc进行均值池化pool,然后将这4个矩阵池化结果进行拼接,得到融合后的文本表示。在这个模块中我们还将融合之后的文本表示通过softmax进行概率计算以及确定情感极性。

[0040]

对于基于图卷积网络融合句法依存与词性的中文情感分析模型通过ltp分析得到的句法依存信息可以构建出一个图结构g=(v,e),其中v代表图中的节点的集合,在实施例任务中,每一个节点就代表了中文句子中的每一个单词,e代表了图中每条边的集合,eij=(vi,vj)属于e代表的含义是在节点vi与vj之间存在一条vi指向vj的边,也表示节点vi与vj所表示的单词之间存在句法上的依存关系。根据kipf在他们的研究中为每个节点加入一个自环且为每一条有向边添加一条反向的有向边能够提升gcn网络的泛化能力。

[0041]

得到了其句法依存之后,并且根据其句法依存构造了其邻接矩阵根据这些信息我们就能够构造出一个图结构,句法分析过后句子中的每一个词语都会成为图结构中的一个节点。

[0042]

我们采用中文维基百科来训练word2vec模型,中文维基百科拥有非常高质量的中文文本语料,但中文维基百科中存在不少的繁体字和英文,在训练之前也需要进行预处理,去除这些干扰因素,然后进行分词训练模型,通过在更好的语料中训练得到词向量可以有更好的表达能力有更丰富的特征,为后续的额任务带来巨大帮助,我们将word2vec得到的向量维度指定为200维。我们可以通过训练好的word2vec模型得到每个中文文本的向量表示矩阵为x={x1,x2,...,xk},k指的是文本中单词的个数。与我们得到的词性标注矩阵p的向量个数一致,我们将这两个矩阵进行拼接操作,得到既融合了语义特征信息又融合了文本词性特征的特征向量矩阵v={v1,v2,...,vk},其中vi=[xi;pi],v∈rd

×

k,d为向量维度,d的值为228,k为单词个数。

[0043]

为了能够获取文本的序列顺序信息,同时模拟人类在阅读时候的特点,即会同时关注当前文本的上下文信息,在本文中我们将采取双向循环门控单元bi-gru来对输入的文本编码进行特征提取和捕捉当前文本的前后文信息。bi-gru通过应用两个方向相反的gru网络,高效且全面地捕捉文本的上下文信息,由于gru在结构上比lstm少了一个门结构,所以相比较于bi-lstm,bi-gru的结构更加简单,需要训练的参数更小,同时又保持了不逊色

于lstm的性能。

[0044]

我们会将临接矩阵设置为一个m

×

m大小的矩阵,其中m指的是数据集中的最大文本长度,对于没有达到m长度的句子,我们在空白区域使用0进行填充。每一个gcn层中,一个节点只能够捕获其邻近节点的信息然后自我迭代更新,通过对gcn层的堆叠每一个节点就有能力捕获到更远节点的信息。而在我们的任务中,每一个节点之间的关系由句法依存构成的邻接矩阵决定,在本模型中使用relu函数进行非线性变换,则在图结构中信息的传递可以用以下公式计算:

[0045][0046]

wi第i层权重矩阵,hi为第i层的输入,d为一个对角矩阵,每个对角上的元素都是该节点的度数,包括出度和入度。

[0047]

在训练过程中,实施例使用带有l2正则化项的交叉熵损失函数loss来计算在训练过程中预测出的结果与真实标签之间的误差,其计算方式为:

[0048][0049]

其中,qk为真实标签分布,pk为预测标签分布,k为标签总数,λ为正则化系数,θ为整个模型需要训练更新的参数集合,θ为当前模型参数。通过在训练过程中不断进行反向传播这种方式不断对模型的各种权重参数进行更新和迭代,让损失函数值逐渐趋于最小值,从而得到最优的模型。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。