1.本发明涉及语音识别技术领域,特别涉及一种人名纠错模型的构建方法和计算机设备。

背景技术:

2.近年来,随着深度学习技术的快速发展,深度学习在图像处理、自然语言处理和强化学习等领域扮演着越来越重要的角色。深度学习的训练过程就是基于海量数据自动进行特征提取,不断拟合数据的过程,隶属于机器学习。深度学习模型因为是自动进行特征提取,所以对于数据处理或特征工程的要求较低。但是该方法需要海量的数据,并且十分依赖数据的质量。

3.早期的文本纠错算法多基于规则、n-gram语言模型和统计机器翻译(statistical machine translation,smt)。上述方法在一定程度可以实现文本纠错,但仍具有很大的局限性。其中,基于规则的方法是最早的实用自动审查方法,通过解析源语言句子,分析句子结构,将它们转换为目标语言。基于规则的方法需要构建海量的规则库,在不间断添加硬性规则的同时,规则之间会引发互相冲突的问题,大幅度降低纠错的准确性;基于n-gram语言模型的方法没有办法兼顾远距离相依赖问题和数据稀疏问题,当语句中的成分间距超过n-gram长度时,该算法就失去了纠正能力,当n-gram长度足够长时,虽然能缓解远距离问题,但是会出现数据稀疏问题;统计机器翻译将文本纠错任务视做转换错误文本为正确文本的单语翻译任务,该方法需要海量的平行文本进行训练,系统会自动学习句子之间的统计相关性。但是统计方法需要相似的庞大训练数据,并且无法考虑上下文的语言环境,导致语言质量不高。

4.现有技术中的文本纠错方法对于句子中实体词语进行纠错的方案较少,且均需要海量的数据,在语音转写的文本中,人名出现错误的概率很大,这为后续数据处理带来了不便,此问题急需解决。

技术实现要素:

5.鉴于上述的分析,本发明旨在提供一种人名纠错模型的构建方法和计算机设备;解决现有技术中人名纠错方法依赖于海量数据,且纠错准确性不高的问题。

6.本发明的目的主要是通过以下技术方案实现的:

7.一方面,本发明提供了一种人名纠错模型的构建方法,本发明的人名纠错模型包括中文实体识别模型和人名预测模型;其构建方法包括以下步骤:

8.获取原始语音转写文本及对应的文本纠错后的标准文本,构建训练样本集合;

9.利用所述训练样本集合,对多任务神经网络模型进行训练,并使用损失函数进行梯度更新,得到所述中文实体识别模型和人名预测模型;

10.所述中文实体识别模型用于输出含有错误人名实体标签的文本;

11.基于所述含有错误人名实体标签的文本对所述错误人名实体进行掩码,得到掩码

后的文本;

12.所述人名预测模型用于根据掩码后的所述文本,引入预先构建的人名词表,预测掩码人名及其概率值,并通过将预测的所述人名与预先构建的人名词表进行对比,以得到纠错后的人名。

13.进一步的,中文实体识别模型为bert-bilstm-crf模型,包括:bert文本表示层、bi-lstm层和crf层;

14.bert文本表示层,采用预训练的bert-base模型,用于将输入的所述语音转写文本表示为n*k的矩阵,其中n为所述训练样本中句子的最大长度,k为词向量维度;

15.bi-lstm层,用于根据所述文本表示层输出的文本表示得到文本中每个字符对应的标签的概率;

16.crf层,用于根据所述bi-lstm层的输出,通过初始化转移矩阵预测人名实体标签的最佳路径。

17.进一步的,采用序列标注方法对所述训练样本集合中的原始语音转写文本进行错误标注,得到带有错误标签的语音转写文本;

18.采用命名实体识别标注方法对所述对多任务神经网络模型进行训练,以检测所述带有错误标签的语音转写文本中的人名实体,并标注人名实体标签;

19.判别所述错误标签对应的字是否为人名实体标签对应实体的一部分;若是,则保留错误标签,得到所述含有错误人名实体标签的文本;若不是,则取消错误标签。

20.进一步的,采用序列标注方法对所述原始语音转写文本进行错误标注,包括:将所述原始语音转写文本与所述对应的标准文本做对比,得到所述原始文本中的拼写错误部分、冗余错误部分、缺失错误部分和正确部分,并分别标注对应的标签。

21.进一步的,所述人名预测模型为预训练的bert-mlm模型,包括嵌入层、编码层和输出层;

22.嵌入层,用于将掩码后的所述语音转写文本表示为包括词向量、位置嵌入和文段分割嵌入的隐向量;

23.编码层,用于根据所述嵌入层的输出得到具有上下文表示的隐向量;

24.输出层,用于输出预测得到的人名及所述人名对应的预测概率。

25.进一步的,根据人名预测模型预测出的人名概率值排序和编辑距离得到纠正后的人名;其中,所述编辑距离基于所述人名与预先构建的人名词表进行对比得到;

26.如果所述人名预测模型预测出的人名都不在所述预先构建的人名词表中,计算所述预测概率最大的人名与所述词表中人名的编辑距离,选取编辑距离最小的人名作为纠正后的人名;

27.如果人名预测模型预测出的至少一个人名在人名词表中,选取在词表中的所述预测概率最大的人名作为纠正后的人名。

28.进一步的,预先构建的人名词表为根据所述人名纠错系统应用领域的人名集合构建的人名词表。

29.进一步的,所述获取原始语音转写文本及与所述原始语音转写文本对应的标准文本,包括:

30.获取所述人名纠错方法应用领域的语音转写文本;

31.通过校对,得到与所述语音转写文本对应的标准文本。

32.进一步的,所述中文实体识别模型的损失函数为:

[0033][0034]

其中,x为输入序列,y为人名实体标签,s(x,y)为标签得分函数;

[0035]

所述人名预测模型的损失函数为:

[0036][0037]

其中,f为根据概率值排序预先设置的被选人名数,θ为模型中所有参数的符号表示,|v|为人名词表大小;

[0038]

所述人名纠错模型总损失函数为loss=0.5*loss1 0.5*loss2。

[0039]

另一方面,本发明还提供一种计算机设备,包括至少一个处理器,以及至少一个与所述处理器通信连接的存储器;

[0040]

存储器存储有可被所述处理器执行的指令,所述指令用于被所述处理器执行以实现本发明涉及的人名纠错模型的构建方法。

[0041]

本技术方案的有益效果:

[0042]

1、本发明通过对序列标注命名实体识别的检错模型进行训练,结合序列标注数据进行人名检错;采用bert-mlm掩码模型进行训练,根据上下文信息进行人名纠错;能够使本方案的方法精准的基于人名实体进行纠错,极大提高了人名纠错的准确性和纠错效果。

[0043]

2、提出针对专门领域的人名纠错方法,引入自主构建的专门领域人名词表对纠错结果进行检查,可以有效解决现有方法对海量数据的依赖性,且使用在专门领域获取的训练样本进行模型训练,很大程度上提高了语音转写文本的人名识别率低的问题。

[0044]

3、本发明通过采用一种基于序列标注的多任务中文人名纠错模型结合自主构建领域人名词表的方法进行人名纠错,利用深度学习训练的语言模型来召回文本,采用多任务的方式进行训练,提升了效率。

[0045]

本发明的其他特征和优点将在随后的说明书中阐述,并且,部分的从说明书中变得显而易见,或者通过实施本发明而了解。本发明的目的和其他优点可通过在所写的说明书、权利要求书、以及附图中所特别指出的结构来实现和获得。

附图说明

[0046]

附图仅用于示出具体实施例的目的,而并不认为是对本发明的限制,在整个附图中,相同的参考符号表示相同的部件。

[0047]

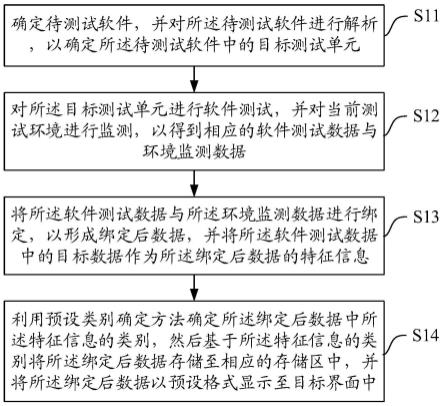

图1为本发明实施例的人名纠错模型的构建方法流程图。

[0048]

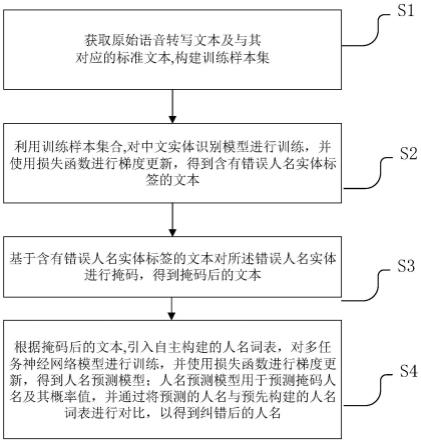

图2为本发明实施例的人名纠错模型纠错方法示意图。

具体实施方式

[0049]

下面结合附图来具体描述本发明的优选实施例,其中,附图构成本技术一部分,并与本发明的实施例一起用于阐释本发明的原理,并非用于限定本发明的范围。

[0050]

语音转写文本中的人名错误主要包含以下三类:拼写错误、冗余错误和缺失错误。本发明针对专门领域语音转写文本中出现的人名错误,提供一种人名纠错模型的构建方法,以解决目前语音转写文本中人名识别准确性差的问题。

[0051]

本实施例中的一种语音转写文本的人名纠错方法,如图1所示,包括以下步骤:

[0052]

步骤s1、获取原始语音转写文本及与所述原始语音转写文本对应的标准文本,构建训练样本集;

[0053]

具体的,根据所述人名纠错方法所应用的专门领域获取语音转写文本;

[0054]

通过校对,得到与所述语音转写文本对应的标准文本。

[0055]

步骤s2、利用训练样本集合,对中文实体识别模型进行训练,并使用损失函数进行梯度更新,得到含有错误人名实体标签的文本。

[0056]

具体的,采用序列标注方法对所述训练样本集合中的原始语音转写文本进行错误标注,得到带有错误标签的语音转写文本;

[0057]

判别所述错误标签对应的字是否为人名实体标签对应实体的一部分,若不是,则取消错误标签;若是,则保留错误标签,得到所述含有错误人名实体标签的文本。

[0058]

作为一个具体的实施例,以标签“r”、“d”、“i”和“e”对原始的语音转写文本进行错误标注,标签“r”表示拼写错误(代表replace),标签“d”表示冗余错误(代表delete),标签“i”表示缺失错误(代表insert),标签“e”表示正确部分(代表equal)。

[0059]

将原始语音转写文本与标准文本做对比,采用序列标注方法对训练样本集中的原始语音转写文本使用错误标签进行标注。例如,原始语音转写文本“马啊芸是阿里巴的董事长”,标准文本为“马云是阿里巴巴的董事长”,则错误标注标签为“e,d,r,e,e,e,e,i,e,e,e,e”。

[0060]

在进行错误标注后,还可以对文本进行特殊字符和表情符号的过滤,并构成字表,将每个句子中的字进行数值化表示。

[0061]

将字符和错误标注对应的数据以batch(批次)的方式读取,并tokenize每个句子,将《eos》加在句子的末尾,以表示序列结束。

[0062]

另外,将字符和错误标注对应的数据以batch(批次)的方式读取,并tokenize每个句子,将《bos》加在句子开头,表示序列开始;将《eos》加在句子的末尾,表示序列结束。

[0063]

为了避免在训练和预测阶段,纠错后的标准文本z与原始语音转写文本x的不同长度影响预测句的完整性,对纠错后的标准文本和原始文本做对齐处理。

[0064]

作为一个具体的实施例,假设纠错后的标准文本z的长度为t0,原始语音转写文本x的长度为t,假设x=(《bos》,x1,x2,x3,《eos》);

[0065]

(1)当t=t0时,即z=(《bos》,z1,z2,z3,《eos》),则不做任何操作;

[0066]

(2)当t》t0时,在纠错过程中会删除x中的一些token,设z=(《bos》,z1,z2,《eos》),在训练阶段,在z的尾部填充特殊符号,使t=t0,得到z=(《bos》,z1,z2,《eos》,《pad》)。

[0067]

(3)当t《t0,在纠错过程中会在原始语音转写文本x中插入文本信息,设z=(《bos》,z1,z2,z3,z4,z5,《eos》),在训练阶段,填充特殊符号《mask》到x的尾部来表示这些位置可能生成新的token,得到x=(《bos》,x1,x2,x3,《eos》,《mask》,《mask》)。

[0068]

进一步的,采用命名实体识别标注方法对所述对多任务神经网络模型进行训练,以检测所述带有错误标签的语音转写文本中的人名实体,并标注人名实体标签。

[0069]

命名实体识别的标注方法有三种模式,分别为bio、bioe和bioes;作为一个具体的实施例,本发明使用bio标注方法,标注名称及意义如表1所示,b代表实体开始部分,i代表实体内部,o代表非实体部分。

[0070]

表1 bio命名实体标签体系

[0071]

标签类别标签说明b-per人名实体开头i-per人名实体内部b-loc地名实体开头i-loc地名实体内部b-org组织名实体开头i-org组织名实体内部o非命名实体

[0072]

具体的,利用训练样本集合,采用命名实体识别标注方法对多任务神经网络模型进行训练,并使用损失函数进行梯度更新,得到中文实体识别模型。

[0073]

中文实体识别模型包括:bert文本表示层、bi-lstm层、全连接层和crf层;其中,

[0074]

(1)bert文本表示层,用于通过bert-base预训练模型对待检测的语音转写文本进行文本表示,将语音转写文本表示为n*k的矩阵,其中n为训练中文实体识别模型的训练样本集中句子的最大长度,k为词向量维度;

[0075]

对于一个待检测的中文文本序列,将其表示为w={w1,w2,w3,..,wn},这个输入序列对应到bert模型中可分别生成词向量(token embedding)、位置嵌入矩阵(positional embedding)和文段分割嵌入矩阵(segment embedding)。将这三个词嵌入组合即为bert的输入序x={x1,x2,x3,...,xn},这个输入序列包含每个token的字符信息、句子信息以及它们的位置信息。

[0076]

与其他的语言模型相比较,bert预训练语言模型可以对词前后两侧的信息进行充分的利用,以此得到更佳的词分布表征式。

[0077]

bert层在训练时,直接使用预训练好的bert-base模型,layer=12,hidden=768,attention=12,总参数=110m,参数通过预训练初始化。用bert-base预训练模型进行文本表示,文本表示为[batch_size,sequence_length,embedding_size]的矩阵。bert层的输出为[batch_size,sequence_length,768]的矩阵。

[0078]

(2)bi-lstm层,用于通过长短期记忆网络实现句子基于上下文表示的隐藏层输出,并通过数学结构保持长距离的字的信息,bi-lstm层的输出矩阵为n*2*h,其中h为文本表示层的维度;

[0079]

具体的,中文文本纠错的结果在一定程度上受到上下文信息的影响,因此需要模型在序列中加入上下文信息。对于bert的输入序列x={x1,x2,x3,

…

,xn},将它分别加入到两个lstm模型中。第一个lstm是正向流动的,每一token的隐藏状态与上一个token的隐藏状态和本token的值有关,也就是得到的隐层序列h={h1,h2,h3,

…

,hn}中,hi的值由h

i-1的值和xi的值计算得到,隐层序列h包含了前向token的信息;第二个lstm与第一个lstm形式相同,只是从前向变成了后向输入,因此隐层序列h'={h'1,h'2,h'3,

…

,h'n}中,h'i的值由h'i 1的值和xi的值计算得到,隐层序列h'包含了后向token的信息。将前向隐层序列h和后

向的隐层序列h'直接拼接在一起,得到同时包含前向信息和后向信息的序列l={l1,l2,l3,

…

,ln},其中li=[hi,h'i]。bi-lstm层最终的输出由包含过去时刻的信息和包含将来时刻的信息两部分共同组成。

[0080]

bi-lstm层的输入是大小为[batch_size,sequence_length,768]的矩阵,输出是大小为[batch_size,sequence_length,2*hidden_size]的矩阵。参数h_0、c_0是大小为[batch_size,2*num_layers,hidden_size]的矩阵,h_0、c_0随机初始化。

[0081]

(3)全连接层,将bi-lstm的输出结果输入到全连接层,得到大小为[sequence_length,tag_size]的发射矩阵,用于表示bi-lstm将每个字符预测为某个标签的概率。

[0082]

(4)crf层,用于结合bi-lstm层的输出,通过初始化转移矩阵来计算每个句子出现的人名实体标签的最佳路径。

[0083]

具体的,crf层能够合理地考虑到上下文之间的依赖关系。crf层的输入是经过bert层和bi-lstm层训练后得到的序列l={l1,l2,l3,

…

,ln},对于这个输入序列,条件随机场遵从训练模型形成与之相匹配的人名实体标签序列y={y1,y2,y3,...,yn},且每个人名实体标签y均从一个指定的标签集中选取。

[0084]

作为一个具体的实施例,定义输入序列为x={x1,x2,x3,

…

,xn},输出预测人名实体标签序列为y={y1,y2,y3,...,yn};多任务神经网络模型的全连接层的输出矩阵为p,p

ij

代表词xi映射到标签yi的非归一化概率;p的维度为n*r,n为训练样本中句子最大长度,r为标签的类别数;crf层的转移矩阵为a,a

ij

代表标签yi到yj的转移概率,转移矩阵a需要随机初始化;y0和yn是句子的开始和结束标签,所以a的维度为(r 2)*(r 2);

[0085]

定义得分函数为:

[0086]

利用softmax函数,为每一个正确的人名实体标签序列y定义一个概率值:

[0087]

其中,yx为所有可能的人名实体标签序列;

[0088]

在训练中,最大化p(y|x)的对数似然:

[0089][0090]

通过损失函数更新迭代,得到最大化p(y|x),即为预测得到的人名实体标签;

[0091]

人名实体标签预测的loss损失函数定义为:

[0092][0093]

进一步的,对错误标签对应的字与人名实体标签对应的实体进行对比,判别所述错误标签对应的字是否为人名实体标签对应实体的一部分,若是,则保留错误标签,得到错误人名实体标签,若不是,则取消错误标签。

[0094]

例如:原文本为“马芸是阿里巴巴的懂事长”,标准文本为“马云是阿里巴巴的董事长”,对应的实体标签为“b-per,i-per,o,b-org,i-org,i-org,i-org,o,o,o,o”,对应的错误标签为“e,r,e,e,e,e,e,e,r,e,e”,经过对比,则将原文本的错误标签修改为“e,r,e,e,

e,e,e,e,e,e,e”,即错误人名实体标签。

[0095]

步骤s3、基于所述含有错误人名实体标签的文本对所述错误人名实体进行掩码,得到掩码后的文本。

[0096]

具体的,针对冗余类错误,根据错误标注阶段标注出的冗余位置,直接将其删除;

[0097]

针对缺失类错误,在缺失位置打上[mask]的掩码标签,得到掩码后的文本。比如,原文本为“马是阿里巴巴的董事长”,标准文本为“马云是阿里巴巴的董事长”,错误人名实体标签为“e,i,e,e,e,e,e,e,e,e,e”,则把原文本处理为“马[mask]是阿里巴巴的董事长”;

[0098]

针对拼写类错误,在错误位置打上[mask]的掩码标签,得到掩码后的文本。比如,原文本为“麻芸是阿里巴巴的董事长”,标准文本为“马云是阿里巴巴的董事长”,错误人名实体标签为“r,r,e,e,e,e,e,e,e,e,e”,则把原文本处理为“[mask][mask]是阿里巴巴的董事长”。

[0099]

步骤s4:根据掩码后的文本,引入自主构建的人名词表,对多任务神经网络模型进行训练,并使用损失函数进行梯度更新,得到人名预测模型;所述人名预测模型用于预测掩码人名及其概率值,并通过将预测的所述人名与预先构建的人名词表进行对比,以得到纠错后的人名。

[0100]

具体的,基于掩码后的文本,引入自主构建的人名词表,对预训练的bert-mlm掩码模型进行训练得到人名预测模型;

[0101]

预训练的bert-mlm掩码模型包括:

[0102]

(1)嵌入层,在bert模型中嵌入层主要包含三个部分:词向量(token embedding)、位置嵌入矩阵(positional embedding)和文段分割嵌入矩阵(segment embedding)。抽象形式化为h0=tb p s,其中tb为词向量,p为位置嵌入矩阵,s为文段分割嵌入矩阵。

[0103]

(2)编码层,bert的编码层实际是transformer encoder的堆叠,用于获取上下文信息。bert-base模型采用l=12层的transformer encoder堆叠。抽象化形式为h

l

=transformer_block(h

l-1

),l∈[1,l],其中,l为编码层的层数。

[0104]

(3)输出层,在输出层,句子中第i个位置的预测结果wi被替换成wi',即以wi'表示被掩码成[mask]的位置,模型输出预测得到的字wi的预测概率为:

[0105][0106]

其中,为层内的参数,w为神经元的权重,c为偏置。

[0107]

bert-mlm模型在训练时,用于获取上下文信息的bert层直接使用预训练好的bert-base模型,layer=12,hidden=768,attention=12,总参数=110m,参数通过预训练初始化。计算预测概率的线性层的参数则随机初始化。

[0108]

进一步的,通过人名预测模型对[mask]内容进行预测,输出相应预测人名的概率值p(w=wi|θ),θ为模型中所有参数的符号表示。

[0109]

根据概率值排序,设置概率值最大的前f个预测人名为被选人名,如果bert-mlm模型预测出的前f个预测人名均不在预先构建的人名词表中,计算预测概率最大的人名与预先构建的人名词表中人名的编辑距离,从词表中选取编辑距离最小的人名作为纠正后的人名替换[mask]。如果计算得到编辑距离最小的人名有多个,选择其中频率最高的人名作为纠正后的人名替换[mask]。

[0110]

如果神经网络模型预测出的前f个预测人名至少一个在领域人名词表中,选取在词表中的概率最大的预测人名作为纠正后的人名替换[mask]。

[0111]

其中,预先构建的人名词表为根据人名纠错方法应用领域的人名集合构建的人名词表,其中,若有m个人重名为同一人名,则该人名在词表中出现m次;其出现的次数越多代表该名人在词表中出现的频率越高。

[0112]

前述的编辑距离指的是在两个单词《w1,w2》之间,由其中一个单词w1转换为另一个单词w2所需要的最少单字符编辑操作次数。本方法定义的单字符编辑操作仅有三种,分别是插入(insertion)、删除(deletion)和替换(substitution)。

[0113]

将两个字符串a、b的编辑距离(levenshtein distance)表示为lev

a,b

(|a|,|b|),其中|a|和|b|分别对应字符串a和b的长度。那么,在这里两个字符串的levenshtein distance,即可用如下的数学语言描述:

[0114][0115]

定义lev

a,b

(i,j)指的是a中前i个字符和b中前j个字符之间的距离。

[0116]

当min(i,j)=0时,lev

a,b

(i,j)对应着字符串a中前i个字符和字符串b中前j个字符,此时的i,j有一个值为0,表示字符串a和b中有一个为空串,那么从a转换到b只需要进行max(i,j)次单字符编辑操作即可,所以字符串a和b之间的编辑距离为max(i,j),即i,j中的最大者。

[0117]

当min(i,j)≠0的时候,lev

a,b

(|a|,|b|)为如下三种情况的最小值:

[0118]

(1)lev

a,b

(i-1,j) 1表示删除ai;

[0119]

(2)lev

a,b

(i,j-1) 1表示插入bj;

[0120]

(3)表示替换bj;

[0121]

为一个指示函数,表示当ai=bj时候取0;当ai≠bj的时候,其值为1。

[0122]

更具体地,设被mask的词的集合为w,引入专业领域人名词表通过损失函数对bert-mlm纠错模型进行迭代计算,得到纠错后的人名;

[0123]

具体的,损失函数为:wi∈[1,2,3,...,|v|],

[0124]

其中,f为bert-mlm模型预测出的前f个预测人名,θ为模型中所有参数的符号表示,|v|为人名词表大小。

[0125]

本发明提供的基于序列标注的多任务中文人名纠错方法中,中文实体识别模型和人名预测模型串行连接,两个模型的总损失函数为:

[0126]

loss=0.5*loss1 0.5*loss2,

[0127]

即:

[0128]

在训练中需要调控的参数包括句子最大长度max_seq_length、训练批量大小train_batch_size、学习率learning_rate、迭代次数num_epoch、lstm的隐含单元数

hidden_size、lstm的层数num_layers、dropout_rate。其中模型参数max_seq_length=128,train_batch_size=100,learning_rate=1e-5,num_epoch=500,num_layers=5,hidden_size=128,dropout_rate=0.1

[0129]

本发明的一个具体实施例,如图2所示,为本发明实施例的人名纠错模型纠错方法示意图,在检错阶段,对于冗余错误、拼写错误和缺失错误类型,均经过包含bert、bi-lstm和crf层的中文实体识别模型进行人名实体错误标签标注;在纠错阶段,对于冗余错误,直接进行删除;对于拼写错误和缺失错误类型,通过bert-mlm模型结合自主构建的专门领域人名词表进行人名预测,得到纠正后的人名。

[0130]

综上所述,本发明的实施例提供的人名纠错模型的构建方法,即一套人名检错—》人名纠错—》纠错检查的模型,利用深度学习训练的语言模型来召回文本,引入专门领域人名词表进行纠错检查,极大的提高了人名纠错的准确性;且采用多任务的方式进行训练,提升了效率,可以有效解决语音转写文本的人名识别率低的问题。

[0131]

本发明的另一个实施例,提供了一种计算机设备,包括至少一个处理器,以及至少一个与所述处理器通信连接的存储器;存储器存储有可被处理器执行的指令,所述指令用于被处理器执行以实现前述实施例的人名纠错方法。

[0132]

本领域技术人员可以理解,实现上述实施例方法的全部或部分流程,可以通过计算机程序来指令相关的硬件来完成,所述的程序可存储于计算机可读存储介质中。其中,所述计算机可读存储介质为磁盘、光盘、只读存储记忆体或随机存储记忆体等。

[0133]

以上所述,仅为本发明较佳的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,可轻易想到的变化或替换,都应涵盖在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。