1.本发明涉及基于变分自编码的视频引导机器翻译方法,属于自然语言处理技术领域。

背景技术:

2.视频引导机器翻译是多模态机器翻译的一种,其目的是利用视频内容作为辅助信息来解决机器翻译的问题。以往的研究只使用来自于预先训练的动作检测模型的特征作为视频的运动表征来解决动词意义的歧义问题,但还有一些名词意义的歧义问题仍未解决。针对这个问题,提出了一个利用变分自编码的视频引导的机器翻译模型,该模型利用了视频中的空间和运动表征。在空间特征方面,使用提出的空间注意力机制方法,提取出视频中的局部特征,并利用短语和视频的关键局部特征作为一个条件隐变量生成短语,通过信息增强的方式提高模型的翻译质量。

技术实现要素:

3.本发明提供了基于变分自编码的视频引导机器翻译方法,以用于解决名词意义歧义在视频中同时使用运动的空间特征和时间特征,通过对句子解析出的短语与空间中的关键局部特征作为条件输入到变分自编码器中生成短语的方式,作为信息增强输入到transformer中,使源语言和目标语言在额外信息的辅助下有效的对齐。

4.本发明的技术方案是:基于变分自编码的视频引导机器翻译方法,所述方法的具体步骤如下:

5.step1、构建汉越可比语料数据集;通过网络爬虫技术收集并构建汉越数据集,汉越数据集包括视频以及视频对应的汉越平行句对,利用负采样获得非平行数据,通过人工对数据集进行标注得到汉越可比语料数据集;

6.step2、获取视频的局部特征,从源语言句子中选择出短语,利用时空注意力模型从视频的局部特征中选择出关键局部特征;然后将选择出的短语和关键局部特征输入到变分自编码器中生成隐向量;最后将源句子特征和隐向量输入到transformer解码器中通过信息增强的方式将源语言和目标语言的语义对齐。

7.作为本发明的进一步方案,所述step1中,汉越平行数据来源包括汉越新闻网、微博、facebook、tiktok。

8.作为本发明的进一步方案,所述step1的具体步骤如下:

9.step1.1、通过网络爬虫技术获取视频以及视频对应的汉越平行句对数据,利用负采样获得非平行数据,数据来源包括汉越新闻网、微博、facebook、tiktok;

10.step1.2、对爬取的数据进行过滤筛选,过滤筛选的方式如下所示:(1)、去除文本内容中的多余符号、超链接和特殊字符;(2)、去除与视频无关的话语;(3)、去除汉越不平行的句对;

11.step1.3、采用人工标注,获得汉越可比语料数据集;对同一个视频的5局不同的中

文描述打上5局越南语描述的标签,人工对视频与视频描述不符的数据集进行筛选。

12.作为本发明的进一步方案,所述step2的具体步骤如下:

13.step2.1、获取视频的局部特征,从源语言句子中选择出短语,利用时空注意力模型从视频的局部特征中选择出关键局部特征;

14.step2.2、使用隐变量,将短语与视频的关键局部特征的语义信息进行建模;提出了一种条件变分自编码的框架,在短语级视频数据集设置了一个边界,即最大化边界似然对数为:

[0015][0016]

其中,近似后验的均值μ(i)和方差σ

2(i)

为编码的输出,即数据点x(i)是变分参数的非线性函数,然后,从隐向量的z取样,其中其中ε

(l)

~n(0,i),i为正态分布上限,使用sgvb的估计量,其中kl散度能在不需要估计下计算和区分;对于短语级视频数据集,设置了一个最大的边界值:

[0017][0018]

其中d为输入的短语,v为局部特征,p

ω

(z|v)是先验知识概率分布,是近似后验知识概率分布,p

θ

(d|z,v)是解码器,并且,p

ω

是高斯分布模型:

[0019]

p

ω

(z|v)=n(z;μ

p

(v),σ

p

(v)2i)

ꢀꢀꢀ

(3)

[0020]

μ

p

(v)=linear(v),

ꢀꢀꢀ

(4)

[0021]

σ

p

(v)=linear(v),

ꢀꢀꢀ

(5)

[0022]

公式中linear()表示的是线性变换,同样,它也是一个高斯分布模型:

[0023][0024]

μq(d,v)=linear([rnn(d),v])

ꢀꢀꢀ

(7)

[0025]

σa(d,v)=linear([rnn(d),v]),

ꢀꢀꢀ

(8)

[0026]

其中rnn()表示单层循神经网络,并根据rnn的最终隐状态计算均值和方差向量,在反向传播更新参数的时候,使用重参数化技巧,通过对进行抽样,即

[0027]

z=μq σq⊙

ε,ε~n(0,i)

ꢀꢀꢀ

(9)

[0028]

解码器p

θ

(d|z,v)也是单层单项的循环神经网络,解码器rnn的初始隐状态为:

[0029]

s=linear([z,v])

ꢀꢀꢀ

(10)

[0030]

step2.3、通过transformer解码器将源句子特征和隐向量作为输入解码到目标语言;transformer的解码器与编码器相同,由l个相同的堆栈组成,每层包含两个子层,第一个子层为自注意力模块,第二个子层为全连接前馈层,在两个子层进行残差连接,对其进行归一化处理,并且他还包含了一个额外的注意子层,用于计算编码器堆栈h输出的对其权值:

[0031][0032][0033]

[0034]

其中是query,key,value向量,是计算1-1层得到的线性函数,在时间步长j中(1-1)层的转换而来,是从编码器的第l层传来的,解码器的顶层通过一个线性的多层感知函数来生成下一个目标词yi:

[0035][0036]

其中wo和ww是映射矩阵,和源句子一样,目标句也包含短语,因此,首先利用spacy工具从目标参考翻译y中设备出短语b,然后,引入一个附加损失项的测量内容,对参加翻译模型内容的翻译单词设置一个激励,所以目标词的损失函数为:

[0037][0038]

其中m为多头注意力个数。

[0039]

本发明的有益效果是:

[0040]

1、本发明研究了在视频引导机器翻译任务中,引入的变分自编码器这种生成模型,获取到额外的信息,这种信息即包含源语言句子中的短语信息,也包含了视频帧中的局部特征信息;

[0041]

2、本发明通过对一组视频的时空注意力机制方法获取到局部特征,利用句子中的短语与关键局部特征作为输入生成短语,将生成的短语作为额外的信息输入到transformer模型中,从而解决了翻译过程中翻译歧义的问题。

附图说明

[0042]

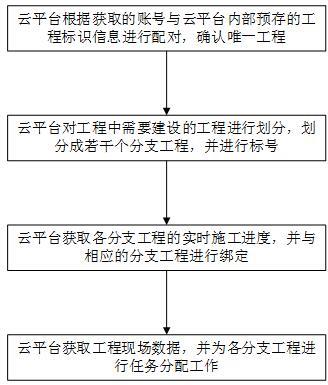

图1为本发明中的流程框图。

具体实施方式

[0043]

实施例1:如图1所示,基于变分自编码的视频引导机器翻译方法,所述方法的具体步骤如下:

[0044]

step1、构建汉越可比语料数据集;通过网络爬虫技术收集并构建汉越数据集,汉越数据集包括视频以及视频对应的汉越平行句对,利用负采样获得非平行数据,通过人工对数据集进行标注得到汉越可比语料数据集;

[0045]

step2、获取视频的局部特征,从源语言句子中选择出短语,利用时空注意力模型从视频的局部特征中选择出关键局部特征;然后将选择出的短语和关键局部特征输入到变分自编码器中生成隐向量;最后将源句子特征和隐向量输入到transformer解码器中通过信息增强的方式将源语言和目标语言的语义对齐。

[0046]

作为本发明的进一步方案,所述step1中,汉越平行数据来源包括汉越新闻网、微博、facebook、tiktok。

[0047]

作为本发明的进一步方案,所述step1的具体步骤如下:

[0048]

step1.1、通过网络爬虫技术获取视频以及视频对应的汉越平行句对数据,利用负采样获得非平行数据,数据来源包括汉越新闻网、微博、facebook、tiktok;

[0049]

step1.2、对爬取的数据进行过滤筛选,过滤筛选的方式如下所示:(1)、去除文本

内容中的多余符号、超链接和特殊字符;(2)、去除与视频无关的话语;(3)、去除汉越不平行的句对;

[0050]

step1.3、采用人工标注,获得汉越可比语料数据集;对同一个视频的5局不同的中文描述打上5局越南语描述的标签,人工对视频与视频描述不符的数据集进行筛选。

[0051]

表1实验数据统计信息

[0052][0053]

作为本发明的进一步方案,所述step2的具体步骤如下:

[0054]

step2.1、获取视频的局部特征,从源语言句子中选择出短语,利用时空注意力模型从视频的局部特征中选择出关键局部特征;

[0055]

step2.2、使用隐变量,将短语与视频的关键局部特征的语义信息进行建模;提出了一种条件变分自编码的框架,在短语级视频数据集设置了一个边界,即最大化边界似然对数为:

[0056][0057]

其中,近似后验的均值μ(i)和方差σ

2(i)

为编码的输出,即数据点x(i)是变分参数的非线性函数,然后,从隐向量的z取样,其中其中ε

(l)

~n(0,i),i为正态分布上限,使用sgvb的估计量,其中kl散度能在不需要估计下计算和区分;对于短语级视频数据集,设置了一个最大的边界值:

[0058][0059]

其中d为输入的短语,v为局部特征,p

ω

(z|v)是先验知识概率分布,是近似后验知识概率分布,p

θ

(d|z,v)是解码器,并且,p

ω

是高斯分布模型:

[0060]

p

ω

(z|v)=n(z;μ

p

(v),σ

p

(v)2i)

ꢀꢀꢀ

(3)

[0061]

μ

p

(v)=linear(v),

ꢀꢀꢀ

(4)

[0062]

σ

p

(v)=linear(v),

ꢀꢀꢀ

(5)

[0063]

公式中linear()表示的是线性变换,同样,它也是一个高斯分布模型:

[0064][0065]

μq(d,v)=linear([rnn(d),v])

ꢀꢀꢀ

(7)

[0066]

σq(d,v)=linear([rnn(d),v]),

ꢀꢀꢀ

(8)

[0067]

其中rnn()表示单层循神经网络,并根据rnn的最终隐状态计算均值和方差向量,在反向传播更新参数的时候,使用重参数化技巧,通过对进行抽样,即

[0068]

z=μq σq⊙

ε,ε~n(0,i)

ꢀꢀꢀ

(9)

[0069]

解码器p

θ

(d|z,v)也是单层单项的循环神经网络,解码器rnn的初始隐状态为:

[0070]

s=linear([z,v])

ꢀꢀꢀ

(10)

[0071]

step2.3、通过transformer解码器将源句子特征和隐向量作为输入解码到目标语言;transformer的解码器与编码器相同,由l个相同的堆栈组成,每层包含两个子层,第一个子层为自注意力模块,第二个子层为全连接前馈层,在两个子层进行残差连接,对其进行归一化处理,并且他还包含了一个额外的注意子层,用于计算编码器堆栈h输出的对其权值:

[0072][0073][0074][0075]

其中是query,key,value向量,是计算l-1层得到的线性函数,在时间步长j中(1-1)层的转换而来,是从编码器的第l层传来的,解码器的顶层通过一个线性的多层感知函数来生成下一个目标词yi:

[0076][0077]

其中wo和ww是映射矩阵,和源句子一样,目标句也包含短语,因此,首先利用spacy工具从目标参考翻译y中设备出短语b,然后,引入一个附加损失项的测量内容,对参加翻译模型内容的翻译单词设置一个激励,所以目标词的损失函数为:

[0078][0079]

其中m为多头注意力个数。

[0080]

作为本发明的进一步方案,所述step2.1的具体步骤如下:

[0081]

通过spacy能解码的词数据包,将句子表示为其中n表示短语个数,faster r-cnn对视频进行目标检测,然后利用空间注意力机制对前top-n个局部特征f

li

={f

li1

,...,f

lin

}得到的每个帧,将每一帧转化为局部特征ψ(vl)={ψ1(vl),ψ2(vl),...,ψk(vl)},ψi(vl)通过空间注意机制对n个局部特征进行动态加权求和:

[0082][0083]

其中,v

lij

表示t时刻第i帧第j个局部特征变量,为t时刻的空间注意力得权重,空间注意力权重它反映了输入视频中第j个局部特征的相关性,因此,设计一个函数,以lstm解码器的前一个隐状态和第j个局部特征作为输入,并返回相关性分数

[0084][0085]

其中we,ue,ze是模型要学习的参数,并且在所有时间步长上,所有局部特征所共享的参数;

[0086]

当通过局部特征计算出所有后(j=1,...,n),用softmax函数对它们进行归一

化,得到

[0087][0088]

为了说明本发明的效果,通过表2是基于变分自编码的视频引导机器翻译模型的对比实验,在vatex的英文-中文的数据集中,本发明通过实验得出vae-vmt模型获得了实验中最高的bleu值。与base nmt相比,本发明方法对应模型获得了大幅度的提高,提高了6.47个bleu值。base nmt与nmt(gru)相比,使用lstm模型的翻译效果比gru有小幅度提高。vmt与base nmt相比较表明,使用视频辅助机器翻译相比于普通的机器翻译有3.43个bleu值的提升,说明利用视频模态最为额外的信息能够帮助机器翻译获得更好的效果。vmt与vmt(transformer)的实验结果进行比较说明,transformer网络模型在此任务中优于lstm网络模型。通过比较vae-vmt(transformer temproal attention global)与vmt(transformer),实验结果有1.61个bleu值提升,说明,使用基于变分自编码这样的生成模型,通过带有视频信息和短语信息的隐变量作为输入,能够增强翻译性能,帮助解决在短语和局部特征不匹配的情况下,使得源语言和目标语言在时空语境下获得更好的对其得到正确的翻译,解决翻译过程中名词歧义的问题。vae-vmt与vae-vmt(transformer average local)比较,证明了视频中使用时间注意力,相比于平均获取每10帧提取一帧的方法,有0.37个bleu值的提高,说明使用时间注意力可以帮助我们在连贯的时空语境下获得更高的翻译质量更高。vae-vmt与vae-vmt(transformer temproal attention global)进行实验结果的比对,获得了0.29个blue值提升。证明了使用局部特征相比于全局特征,在翻译过程中解决前后名词翻译不对称的情况下,局部信息能够更好的将辅助名词短语的空间语义对齐。本实验观察到,基于变分自编码的模型中,使用空间注意力提取局部特征和时间注意力的效果最好。同样在中文翻译到英文的方法中也有所提升,说明本发明的实验在多种语言翻译中都有着不错的效果。

[0089]

表2基于变分自编码的视频引导机器翻译模型对比实验

[0090][0091]

说明:g为googlenet,fc7为faster r-cnn fc7层提取特征,average为每10帧提取一帧的平均策略。

[0092]

表2为本发明在其他条件一致的前提下,对比模型均使用获得最佳性能的参数对比实验,本发明通过大量实验得出了sta算法获得了实验中最高的bleu值,在中越语料中,

得出了在与base nmt模型相比,本发明sta方法有了大幅度提高。与ta-nl相比本发明的方法获得了1.06个bleu值的提升,通过结果表明,本发明将局部特征融入到全局特征中确实提高了视频帧中多个小目标的识别和定位。相比较于nta方法,sta方法获得了0.99个bleu值的提升。通过两组实验结果表明,模型增加局部特征,是可以为结果带来改善。与vmt方法相比,本发明的sta方法获得了0.89个bleu值得提升。与tat的方法相比本发明的方法获得了0.97个bleu值得提升,通过结果表明时间注意力难以区分视频帧上的小对象。因此,空间注意力是视频引导机器翻译方法的重要组成部分。本发明也通过全局时间表征和局部时间表征的两个特征进行求和与拼接的方式进行了实验,发现,拼接后的效果明显好于求和后的效果。本发明观察到,利用空间和时间信息带来得改善是互补的,当空间注意力机制和时间注意力机制同时使用时效果最好。

[0093]

表3为基于变分自编码的视频引导机器翻译模型vatex公共测试集实验

[0094][0095]

表3是基于vatex英语到汉语公共测试集得到的结果,vatex公共测试集包含了6278个视频,模型在本地训练后会产生一个“submission.zip”压缩包,其中会保留模型在本地训练好的参数,在vatex官网上传这个压索包会得到vatex公共测试集的结果,与此同时,也说明了本实验模型结果的真实性和可靠性。

[0096]

表4为基于变分自编码的视频引导机器翻译模型汉语越南语实验

[0097][0098]

表4是基于本文实验室汉-越低资源视频引导机器翻译数据集做的实验,实验表明,基于变分自编码的视频引导机器翻译模型在低资源数据集中也有者明显的效果,在10500个视频,每个视频对应5个汉语-越南语平行句对的训练集下,实验相比vmt模型依然有者1.21个bleu值的提高,说明模型的在低资源数据集的情况下有着良好的泛化性。

[0099]

上面结合附图对本发明的具体实施方式作了详细说明,但是本发明并不限于上述实施方式,在本领域普通技术人员所具备的知识范围内,还可以在不脱离本发明宗旨的前提下作出各种变化。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。