attention多视角注意力机制姿态估计模型)姿态估计模型中,输出3d人体姿态估计的结果;

10.mvp-att姿态估计模型通过以下步骤训练得到:

11.通过编码器对多视角输入的多个目标图像分别进行采样,提取得到多个单视图的2d人体姿态表达的深度特征图;

12.采用特征转换模块,将相机投影矩阵条件作用于每个深度特征图的图像坐标,映射转换为世界坐标,实现多视图的深度特征图中的深度特征进行标准化以及与相机姿态的解耦;

13.使用基于混合注意力机制的多视角特征融合机制模块从解耦后的深度特征中自动选择有效深度特征,按照视角融合成统一的3d人体姿态表征。

14.优选地,mvp-att姿态估计模型的训练步骤,还包括:

15.将3d人体姿态表征输入到使用相机投影矩阵条件作用的特征转换模块,输出特征融合后各个视角的深度特征;

16.将特征融合后各个视角的深度特征输入到解码器中获得关节点二维热图;

17.使用可微直接线性变换方法将多视角的关节点二维热图映射到三维空间,生成表征人体关节点在三维空间位置的三维人体骨架。

18.优选地,自动选择有效深度特征,包括以下步骤:

19.先通过混合注意力机制建模解耦后的深度特征之间的相关性,然后深度学习每个通道的深度特征的注意力得分,自动在不同视角的深度特征集合中选择注意力得分符合要求的深度特征作为有效深度特征。

20.优选地,mvp-att姿态估计模型在训练过程中,通过最小化二维关节点的平均误差来监督模型的训练,损失函数如下:

[0021][0022]

其中,表示第k个视角的第j个关节的真实二维坐标;是模型预测的第k个视角第j个关节的二维坐标。

[0023]

优选地,mvp-att姿态估计模型在训练过程中,再通过以下损失函数公式微调多视角3d人体姿态估计模型:

[0024][0025]

其中,l

3d-mpjpe

是所有关节点的预测位置与地面真值位置的平均欧氏距离,其中是世界坐标系下第j个关节点的真实三维坐标,pj为模型预测的第j个关节点的三维坐标。

[0026]

优选地,基于混合注意力机制的多视角特征融合机制模块包括:级联的通道注意力机制单元和单通道局部注意力机制单元;用于对不同特征通道的注意力加权计算、同一特征通道不同局部的注意力加权计算,并依据计算得到的权值,完成对应的特征通道加权求和、同一特征通道局部加权求和,得到每个通道的深度特征的注意力得分。

[0027]

优选地,单通道局部注意力机制单元,包括:低维嵌入全连接层、relu非线性激活层、维度恢复全连接层三个子结构,三者以级联的方式连接;低维嵌入全连接层的神经元数目小于或等于单通道局部注意力机制子模块输入的特征维度,维度恢复全连接层的神经元数目等于单通道局部注意力机制子模块输入的特征维度。

[0028]

本发明还提供一种计算机系统,包括存储器、处理器以及存储在存储器上并可在处理器上运行的计算机程序,处理器执行计算机程序时实现上述任一方法的步骤。

[0029]

本发明具有以下有益效果:

[0030]

1、本发明的用于3d人体姿态估计的多视角特征融合方法,是一种基于混合注意力机制的多视角特征融合方法,在有效选择各视角2d特征热度图的同时,通过训练学习自动选择有效深度特征,并将其按视角融合成统一的3d人体姿态表征。具有自适应性、高灵活性的特点,能以特征融合的思路解决3d人体姿态估计技术方案中的“局部遮挡”问题,并且能够轻松嵌入到端到端学习的多视角3d人体姿态估计模型,运用到实际的动作捕捉以及姿态识别中,以得到人体相关的三维结构信息和位置信息。

[0031]

2、在优选方案中,本发明用于3d人体姿态估计的多视角特征融合方法,通过神经网络模块学习通道特征图局部空间的相关性,并通过为每个通道特征图元素学习掩模的形式生成权重特征(注意力得分),关注每个特征图的局部相关性,以进一步通过特征图的局部相关性更好的解决“局部遮挡”问题,最终能应用到实际生活场景当中,进行实际场景的人体姿态估计。

[0032]

除了上面所描述的目的、特征和优点之外,本发明还有其它的目的、特征和优点。下面将参照附图,对本发明作进一步详细的说明。

附图说明

[0033]

构成本技术的一部分的附图用来提供对本发明的进一步理解,本发明的示意性实施例及其说明用于解释本发明,并不构成对本发明的不当限定。在附图中:

[0034]

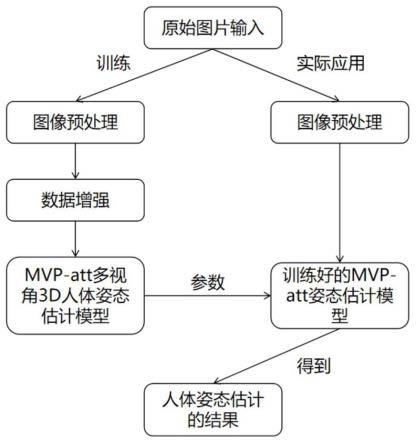

图1是本发明优选实施例的基于mvp-att的多视角3d人体姿态估计方法的学习模型示意图;

[0035]

图2是本发明优选实施例的mvp-att多视角注意力机制模块的结构示意图;

[0036]

图3是本发明优选实施例的基于mvp-att混合注意力机制的多视角特征融合方法的流程图;

[0037]

图4是本发明优选实施例的3d人体姿态的预测结果示意图。

具体实施方式

[0038]

以下结合附图对本发明的实施例进行详细说明,但是本发明可以由权利要求限定和覆盖的多种不同方式实施。

[0039]

实施例一:

[0040]

在本实施例中,公开了一种基于混合注意力机制的多视角特征融合方法,如图1所示。

[0041]

本实施例的主要目标就是获取3d人体姿态在绝对世界坐标下的位置,也就是人体姿态每个关节点的三维坐标集合为每个关节点分配特定编号,将重建的关节点按

照次序连接起来就会构成三维的人体骨架。

[0042]

本实施例的基于混合注意力机制的多视角特征融合方法,步骤如下:

[0043]

s1、获取需要姿态估计的不同视角的目标图像;

[0044]

在具体实施时,可以通过摄像机等装置获取需要姿态估计的目标图像,在不同位置放置摄像机来获取不同视角的图像,本实施例中视角个数为n(n≥2),将输入的多视图记作并且已知每个视角的投影矩阵为pi。

[0045]

s2、将目标图像经过图像预处理后,输入到训练好的mvp-att姿态估计模型中,输出3d人体姿态估计的结果。

[0046]

mvp-att姿态估计模型通过以下步骤训练得到:

[0047]

s201、将需要姿态估计的目标图像进行预处理;

[0048]

本实施例使用每个数据集提供的人体边界框来裁剪目标图像,重新对裁剪图像进行采样来便于虚拟相机指向裁剪中心,然后采用归一化处理,将其转换成256

×

256和384

×

384两种输入尺寸,并且随机旋转30度和标准化颜色来增强训练数据集,在整个实施过程中使用adam优化器,同时将最大迭代次数设置为40。这里给定多个视角的输入图像i表示第i个视角,n表示视角总个数,每张图片的分辨率为384

×

384和256

×

256两种。

[0049]

s202、如图1将上述输出作为输入进入到编码器中;

[0050]

本实施例使用resnet152作为主干网络,并且设置pretrained=true,这样可以使用imagenet的与训练权重,来编码多视角图像的深度特征,将编码网络记为e,所有视角图像的特征编码器共享权重,而编码过程如下表示:

[0051]

xk=e(ik)

[0052]

这里编码后生成的xk是2048

×

12

×

12的特征图,也是单视图的2d人体姿态表达。可以存储到多视图的深度特征集合中。

[0053]

s4、将特征图输入到特征转换模块(ftl)中;

[0054]

这里将图像或人体姿态的隐式表达从一个视图映射到另一个视图,其表示如下:

[0055][0056]

这里pk表示的是第k个相机的投影矩阵,特征变换层可以将相机投影矩阵条件作用于深度特征图,以将多视图深度特征xi映射成统一的标准表达(世界坐标),来实现来实现多视图深度特征的标准化,以及跟相机姿态的解耦。

[0057]

在前一个模块中所得到的多视图的深度特征集合中蕴含了3d人体姿态表示的信息,但需要是从这些不同视图提取深度特征进行转换,达到解耦相机姿态和深度特征的目的,上述得到信息中视点信息跟人体姿态信息还是会结合在一起,而不是与观察视角无关。关节点信息不应该包含在不同视角所提取的深度特征中,后续的多视角特征融合是完全需要解耦相机姿态和深度特征。因此,采用特征转换模块(ftl),相机投影矩阵条件作用与每个特征图的图像坐标,而后将其从图像坐标转换为世界坐标,来实现多视图深度特征的标准化。特征转换模块会将输入的特征图看作点集,通过特定的目标变换之后利用条件概念模型重塑原始维度,上述的特征转换方法可以使学习到的隐式特征空间保留转换前的数据结构,同时在实际应用中将学习到的特征表征和目标变换进行解耦。可使得模型专注于多视角信息融合,简化了多视角3d人体姿态估计模型的共同推理过程。

[0058]

s5、将解耦后的单视图深度特征输入到多视角注意力机制模块中;

[0059]

这一步中输入为:多视角特征集合d={x1,x2,...,xn},xi表示由2d姿态估计器提取到的第i个视角下的2d关节点热度图,n表示视角数,输出为:视角解耦同一的三维人体姿态表征y。

[0060]

在一些实施方式中,基于混合注意力机制的多视角特征融合机制模块可包括:级联的通道注意力机制单元和单通道局部注意力机制单元;用于对不同特征通道的注意力加权计算、同一特征通道不同局部的注意力加权计算,并依据计算得到的权值,完成对应的特征通道加权求和、同一特征通道局部加权求和,得到每个通道的深度特征的注意力得分。优选地,单通道局部注意力机制单元,包括:低维嵌入全连接层、relu非线性激活层、维度恢复全连接层三个子结构,三者以级联的方式连接;低维嵌入全连接层的神经元数目小于或等于单通道局部注意力机制子模块输入的特征维度,维度恢复全连接层的神经元数目等于单通道局部注意力机制子模块输入的特征维度。实际实施时,混合注意力机制以通道注意力机制和单通道局部注意力机制级联的方式进行混合,可以是通道注意力机制、单通道局部注意力机制的顺次级联,也可以是单通道局部注意力机制、通道注意力机制的顺次级联,混合注意力机制的混合方式包含通道注意力机制和单通道局部注意力机制所有级联方式,包括残差学习所提及的残差连接。

[0061]

参见图2,本实施例的基于混合注意力机制的多视角特征融合机制模块(以下简称多视角注意力机制模块)首先将解耦的单视图深度特征通过1

×

1卷积由2048个通道压缩为300个通道,然后将不同视角所提取的深度特征通过特征变换模块转换为共享的标准表达,完成特征转换后将所有视图的特征图连结在一起并且组合成待融合的深度特征集合,也就是上述的输入。然后使用senet通道注意力模块让模型自动学习所有视角深度特征不同通道的相关性,这里处理后的深度特征集合记为此时n=n

×

300,其中d为每个通道特征图拉平后的维度,是取决于编码器所生成的特征图尺寸。而如前所述,一种输入是384

×

384的图像,这种情况下,在经过编码器之后,所生成的特征图尺寸为12

×

12,所以d=144。在进入多视角注意力机制模块之后,各视图的深度特征图通过将特征转换模块后的输出标记为将集合中的所有深度特征连结在一起,而后通过senet自适应的调整各个通道的特征响应值,该通道注意力机制模块训练全连接网络学习每个特征通道的权重,这里权重的主要作用是显式地建模特征通道地相关性,其通过global average polling(全局平均池化)来压缩特征通道图,而后通过两个全连接层来建模通道的相关性,其生成地深度特征集合记作特征集合的每个元素输入共享函数f,其表示如下:

[0062][0063]

该函数的主要作用则是学习通道特征图的空间相关性,其输出是学习到的一组注意力激活利用softmax操作,对所学习到的注意力激活进行归一化,而后计算出一组注意力得分s={s1,s2,

…

,s

n-1

,sn},将第i个特征元素的注意力得分记为},将第i个特征元素的注意力得分记为其中si中的每个元素的计算如下公式表示:

[0064]

[0065]

这里f

id

和f

jd

分别是fi和fj的第d个特征图元素,而后将上述计算的注意力得分和待融合深度特征集合按元素点乘来获得权重特征集合其中mi的计算如下表示:

[0066]

mi=xi×

si[0067]

在获得上述的权重特征集合之后,将其按视角融合,也就是将按照视角进行分组,将相同视角的权重特征分配到一组(学习的注意力得分可以看作掩膜),然后将n组特征图通过元素相加融合到一组特征图中,也就能够得到最终的3d人体姿态表达,其表示如下:

[0068][0069]

这里的表示第k个视图深度特征集合的第i个权重特征,而yi则是y的第i个通道特征图。

[0070]

上述步骤,同时学习了多视图深度特征图通道之间的相关性和通道特征图局部空间的相关性,较目前使用的1

×

1卷积层减少了约76%的参数量。同事,赋予模型自动选择多视图有效深度特征进行融合的能力,能够将任意数量的多视图(视角数大于等于2)深度特征聚合成紧凑的3d人体姿态表征。

[0071]

在一些实施方式中,得到3d人体姿态表达之后,还可以继续按照以下步骤得到三维人体骨架:

[0072]

s6、将得到的y尺寸还原为之后,将其输入到使用相机投影矩阵pk条件作用的特征转换模块,获得特征融合之后的各个视角的深度特征uk,将uk输入到解码器d中获得关节点二维热图hk;

[0073]

本实施例中,解码器d使用了三个反卷积层和一个1

×

1卷积,每个反卷积层包括反卷积操作、批量标准化和relu的非线性激活的操作,而每个反卷积核的尺寸是4

×

4,其步幅为2,最后加入一个1

×

1卷积层来生成所有k个视角的j个二维关节点热图。3d人体姿态隐式表达y的尺寸还原为y∈r

300

×

12

×

12

之后,将其输入到使用相机投影矩阵pk条件作用的特征转换模块,再获得特征融合后各个视角的深度特征这里且将映射回2048个通道后记作射回2048个通道后记作将vk输入到解码器d,获得关节点二位热图hk,并且在获得关节点热图hk之后,通过soft-argmax求解第k个视角的关节点二维坐标,就能够获得所有视图的2d人体姿态,并且为构造从多视图到3d人体姿态的端到端学习模型提供了便利。

[0074]

s7、使用可微直接线性变换方法将多视角二维关节点映射到三维关节点。

[0075]

获取了所有视图的2d人体姿态,就可以利用他们重建3d人体姿态,本发明中使用可微的高效直接线性变换算法来将多视角二维关节点映射到三维关节点,最终构造出一个更加轻量级的端到端多视角3d人体姿态估计模型。

[0076]

s8、在实际应用过程中,训练数据集时为了使得模型在训练早期阶段更加稳定,可以利用损失函数来对模型进一步训练。

[0077]

本实施例,为了使得模型在训练早期阶段更加稳定,使用最小化二维关节点的平

均误差(mpjpe)来监督模型训练,以获得更加稳定的多视角2d人体姿态估计模型,损失函数如下:

[0078][0079]

这里的表示第k个视角的第j个关节的真实二维坐标,然后通过以下损失函数来微调多视角3d人体姿态估计模型:

[0080][0081]

在上述式子中表示世界坐标系的第j个关节点的真实三维坐标

[0082]

以上步骤是构建和训练整个mvp-att姿态估计模型的过程。

[0083]

实施例二:

[0084]

对于构建好的基于混合注意力机制的多视角特征融合模型,在实际应用中的实例过程如图3,过程如下:

[0085]

s1、获得原始图像的数据,然后对原始图像数据进行预处理,得到预处理之后的图像;

[0086]

s2、对预处理之后的图像进行数据增强,获得增强后的图像;

[0087]

s3、将预处理之后的图像作为输入输入到上述构建的模型之中得到预测的3d的人体姿态表征,图4则是该模型的可视化结果;

[0088]

可以在图4中看到本发明预测的2d人体姿态与地面真值(ground truth)的对比效果,还有预测的3d人体姿态;

[0089]

s4、将输出可视化显示在用户的手机或者电脑屏幕中。

[0090]

实施例三:

[0091]

本发明还提供一种计算机系统,包括存储器、处理器以及存储在存储器上并可在处理器上运行的计算机程序,处理器执行计算机程序时实现上述任一实施例的步骤。

[0092]

综上可知,本发明通过senet学习多视图深度特征集合的通道相关性,采用神经网络模块学习通道特征图局部空间的相关性,通过为每个通道特征图元素学习掩模的形式生成权重特征,并将其按视角融合成统一的3d人体姿态表征,具有自适应性、高灵活性的特点。

[0093]

本发明能够以特征融合的思路解决3d人体姿态估计技术方案中的“局部遮挡”问题的新方法,并且能够轻松嵌入到端到端学习的多视角3d人体姿态估计模型,运用到实际的动作捕捉以及姿态识别中,以得到人体相关的三维结构信息和位置信息。

[0094]

以上所述仅为本发明的优选实施例而已,并不用于限制本发明,对于本领域的技术人员来说,本发明可以有各种更改和变化。凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。