1.本发明属于图像处理技术,具体涉及一种基于模态独有和共有特征提取的图像显著目标检测方法。

背景技术:

2.显著目标检测旨在利用算法检测并分割出自然场景图像中人眼感兴趣的的区域或目标,是计算机科学、神经生物学领域的一个交叉型科学问题,可以为目标追踪、行人重识别等多种视觉任务提供有用线索,能大大提升很多视觉任务的效果。

3.早期的显著目标检测方法采用的是传统的方法,即利用手工提取的颜色对比、中心先验以及纹理等特征进行显著性预测,但是这样的方法过度依赖于人工选取的特征,在一些复杂情况下表现很差。近些年来,随着深度学习的普及,基于深度学习的显著目标检测技术取得了飞快地发展,对场景的适应性较强,取得了相较于传统显著性算法更好的性能。

4.目前,单模态图像显著性检测算法已经在已有数据集和简单场景中达到很高检测水平,但在复杂场景和多干扰的环境中,如图像亮度差、颜色对比度低、跨边界及大量噪声等,单模态的显著目标检测的效果有待进一步提高。为了应对这些挑战,近些年来,rgb-t图像显著目标检测已成为视觉领域研究的热点和难点,rgb-t显著目标检测旨在利用可见光和热红外图像两种模态下的信息检测出场景中的显著目标,热红外提供的温度信息有助于对显著检测结果的提升。由于采用不同的模态对显著区域进行预测,所以在rgb-t显著目标检测中,最主要的问题就是研究两种模态的关联性和差异性。

5.可见光相机在光照良好的环境下可以清晰地捕捉到图像中的颜色信息和细节信息,但在类似黑夜等弱光下很难捕捉到有效的信息;而热红外相机对光照变化不敏感,通常可以呈现出图像中目标的轮廓,但会丢失图像的颜色和细节信息。因此,可见光图像和热红外图像所提供的信息是互补的,提取两种模态的特征信息,进行融合处理,便能得到更加丰富的显著目标特征。与此同时,不同模态下的独有信息也有助于算法性能的提升,因此,不仅要实现多模态之间的关联性,也要考虑到模态之间的差异性。

6.现有的一些研究主要集中在信息互补和融合的方式上,基于深度学习的方法通过融合多尺度,多模态和多层次的特征来实现对最终结果的预测,这些算法在多模态互补方面取得了很大的进展,达到了更好的性能。但是,这些方法都只是考虑了多模态之间的互补性,存在以下问题:

7.一方面,由于不同模态的成像条件不同,单纯考虑rgb-t互补性而忽略在各自模态上独有信息这是不合理的;

8.另一方面,研究模态互补是显著性任务的一个固有挑战,建立起模态之间的共有区域特征才能更好的挖掘模态之间的相关性,这不仅用于信息补充,而且将共有特征和模态独有特征区别利用才能更好的挖掘多模态显著目标检测的优势。

技术实现要素:

9.发明目的:本发明的目的在于解决现有技术中存在的不足,提供一种基于模态独有和共有特征提取的图像显著目标检测方法,本发明提炼了rgb-t多模态的共有特征和独有特征并区别利用,充分体现了多模态显著目标检测的优势,获得更高的性能和更加准确的显著图像。

10.技术方案:本发明的一种基于模态独有和共有特征提取的图像显著目标检测方法,包括以下步骤:

11.步骤s1、使用双流特征编码器编码获得可见光图像和热红外图像的多级特征,并将可见光的骨干特征标记为r1~r4,热红外的骨干特征标记为t1~t4;

12.步骤s2、将最深层特征r4和t4经过金字塔池化ppm处理得到具有全局感受野的全局特征g,g=ppm(r4,t4);

13.步骤s3、使用模态共有特征提取模块sfa对r1~r4和t1~t4进行模态关联处理,并基于注意力将高层的语义信息传递到低层特征中,从而得到具有多模态共有信息的共有区域特征f,f包括f1~f4;

14.步骤s4、使用特征擦除模块feb分别对r1~r4和t1~t4进行模态差异性处理,从而得到具有各自模态独有信息的特征r和t,r包括r1~r4和t包括t1~t4;

15.步骤s5、在多模态解码器中,先聚合差异性特征,得到多模态下的差异性特征得到多模态下的差异性特征然后使用注意力机制引导独有信息和共有信息进行相互优化和融合,得到显著图s,s包括s1~s4;s4为最终显著图;通过本发明的多模态解码器来聚合独有信息与共有信息;

16.步骤s6、通过损失函数监督训练网络得到最终预测图。

17.进一步地,所述步骤s1中的双流特征编码器采用swin-transformer结构,特征图开始输入到两层transformer中,这两层transformer的核心一个是普通的window attention,另一个是shift window attention,然后在stage与stage之间使用pooling来降低要处理的数据的尺寸,每一个stage输出的通道数分别为128、256、512和1024。

18.进一步地,所述步骤s3中高层的语义信息传递的具体方法为:

19.首先,将两个模态的骨干特征分别均等化分成四份,利用sigmoid将高层特征生成注意力掩码,分别作用于两种模态的四份特征,以此来传递层级间的语义信息,具体操作为:

[0020][0021][0022]

其中split()为pytorch框架集成的函数,convblock()是卷积、归一化和relu激活函数集成的卷积块,σ代表激活函数,代表高层特征,mask代表由高层信息产生的权重掩码;

[0023]

然后,根据channel-wise乘法将mask分别作用于fr和f

t

;

[0024]

[0025]

最后,将f

′r和f

′

t

进行通道合并,并通过卷积核大小为3

×

3卷积块将对其特征上下文进行细化,最后得到融合有层级信息和上下文信息的fr和f

t

;

[0026][0027]

其中,[*]是通道连接操作。

[0028]

进一步地,步骤s3中模态共有特征提取是指使用fr、f

t

和g提炼共有区域特征,具体方法为,

[0029]

在fr、f

t

上应用两个通道注意力对每个通道的权重进行划分;

[0030]f′r=ca(fr)=fr×

σ(avgpool(fr) maxpool(fr))

[0031]f′

t

=ca(f

t

)=f

t

×

σ(avgpool(f

t

) maxpool(f

t

))

[0032]

其中,ca()为通道注意力函数,avgpooling和maxpooling分别表示平均池化和最大池化;然后利用输出通道为128的卷积块对g进行处理,最后与f

′r和f

′

t

进行融合实现共有区域特征的提取;

[0033]

f=f

′r f

′

t convblock(g)

[0034]

最终得到四个层级的共有区域特征fk,其中k=1,2,3,4。

[0035]

进一步地,在得到共有区域特征f以后,将其作用在编码器提取出来的两个模态特征上执行擦除操作,由此实现模态独有信息的提炼;模态擦除模块的具体操作步骤为:

[0036]

首先,使用余弦相似度在每一层计算各自的共有特征和骨干特征的相关性图;

[0037]m(i,j)

=(f

(i,j)

)

t

(w

t

×

f),(1≤i≤h,1≤j≤w)

[0038]

其中(i,j)代表了每个像素点的位置,f代表了骨干特征r或者t,w反映了f到f的空间映射参数,h是特征f

(i,j)

的长的像素数,w是特征f

(i,j)

的宽的像素数;

[0039]

然后,在相关性图m上采用滑动窗口的方式生成一个二进制掩码用于擦除操作,将其定义为

[0040]

最后,利用二进制掩码对共有特征f进行擦除,得到具有模态独有信息的特征r和t;

[0041]

例如,使用热红外特征t对共有特征f进行擦除,则会得到可见光独有信息特征r。

[0042]

进一步地,所述步骤s5聚合差异性特征的具体操作为:

[0043]

将模态独有信息r和t进行通道合并,并使用输出通道为128的卷积块对聚合后的特有信息进行细化,得到多模态下差异性特征,

[0044]

进一步地,步骤s5中将f中相邻高层的特征生成注意力掩码作为多模态解码的输入;将差异性特征、共有特征以及高层语义特征使用注意力进行聚合;使用注意力机制的具体方法为:

[0045]

对于高层特征首先将低分辨率的高层特征上采样成与该层特征尺寸相同的大小,然后使用输出通道为128的卷积块将差异性特征共有特征f和高层特征修改成相同通道数,随后使用注意力机制自动获取聚合后特征的每个通道数的重要性;

[0046]

[0047][0048]

由于有四层特征,得到四层预测的特征,分别经过一个单通道的卷积层,再利用sigmoid函数将分值约束到0~1之间,分别记为s1~s4,s4为最终显著图

[0049]

进一步地,所述步骤s6的详细内容为:

[0050]

给定显著图s={s(i)|i={1,...,n}和真实数据y={y(i)|i={1,...,n},其中n是该显著图的总像素数;

[0051]

二元交叉熵bce损失函数为:

[0052][0053]

平滑度损失函数为:

[0054][0055][0056]

dice损失函数为:

[0057][0058]

在训练过程中,使用二元交叉熵bce损失函数进行监督,将其应用于最终预测的显著图;

[0059]

l1=l(s4,y);

[0060]

然后对上下文全局特征g进行监督;将其上采样到与y相同的分辨率,经过卷积和激活函数以此计算一个粗略的显著图sg;

[0061]

l2=l(sg,y);

[0062]

最后分别使用平滑度损失和dice损失对最终的预测s进行监督;

[0063]

l3=ls(s4,y)

[0064]

l4=l

dice

(s4,y)

[0065]

所以,最终的损失函数为:

[0066]

l

final

=l1 l2 l3 l4。

[0067]

有益效果:与现有技术相比,本发明具有以下优点:

[0068]

(1)本发明基于模态共有和独有特征提取网络,解决了现有技术中模态间关联性和差异性利用不足的问题。

[0069]

(2)本发明的特征擦除模块feb能够有效实现各自模态信息的提炼,通过所得线索克服了纹理不清晰、定位不准确等问题。

[0070]

(3)本发明多模态解码器模块,能实现从模态关联和差异性的角度出发,充分挖掘多模态的优势,从而得到一个高置信度显著图。

附图说明

[0071]

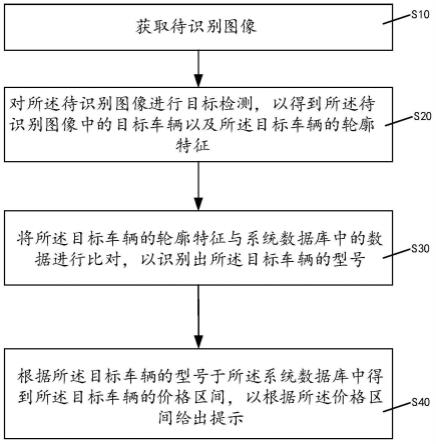

图1为本发明的整体流程示意图;

[0072]

图2为本发明的显著目标检测网络模型示意图;

[0073]

图3为本发明的p-r曲线示意图;

[0074]

图4为本发明与其他技术方案的视觉对比图;

[0075]

图5为本发明差异性特征和共有特征的可视化结果图。

具体实施方式

[0076]

下面对本发明技术方案进行详细说明,但是本发明的保护范围不局限于所述实施例。

[0077]

如图1和图2所示,本发明的基于模态独有和共有特征提取的图像显著目标检测方法,包括以下步骤:

[0078]

步骤s1、使用双流特征编码器编码获得可见光图像和热红外图像的多级特征,并将可见光的骨干特征标记为r1~r4,热红外的骨干特征标记为t1~t4;

[0079]

步骤s2、将最深层特征r4和t4经过金字塔池化ppm处理得到具有全局感受野的全局特征g,g=ppm(r4,t4);

[0080]

步骤s3、使用模态共有特征提取模块sfa对r1~r4和t1~t4进行模态关联处理,并基于注意力将高层的语义信息传递到低层特征中,从而得到具有多模态共有信息的共有区域特征f,f包括f1~f4;

[0081]

步骤s4、使用特征擦除模块feb分别对r1~r4和t1~t4进行模态差异性处理,从而得到具有各自模态独有信息的特征r和t,r包括r1~r4和t包括t1~t4;

[0082]

步骤s5、在多模态解码器中,先聚合差异性特征,得到多模态下的差异性特征得到多模态下的差异性特征然后使用注意力机制引导独有信息和共有信息进行相互优化和融合,得到显著图s,s包括s1~s4;s4为最终显著图;

[0083]

步骤s6、通过损失函数监督训练网络得到最终预测图。

[0084]

本实施例中将骨干特征和全局特征使用共有特征提取模块(sfa)进行关联处理,并结合高层语义信息提炼共有特征的具体过程为:

[0085]

先进行高层的语义信息传递,如下:

[0086]

首先,将两个模态的骨干特征分别均等化分成四份,利用sigmoid将高层特征生成注意力掩码,分别作用于两种模态的四份特征,以此来传递层级间的语义信息,具体操作为:

[0087][0088][0089]

其中split()为pytorch框架集成的函数,convblock()是卷积、归一化和relu激活函数集成的卷积块,σ代表激活函数,代表来自高层的特征,mask代表由高层信息产生的权重掩码;

[0090]

然后,根据channel-wise乘法将mask分别作用于fr和f

t

;

[0091][0092]

最后,将f

′r和f

′

t

进行通道合并,并通过卷积核大小为3

×

3卷积块将对其特征上下文进行细化,最后得到融合有层级信息和上下文信息的fr和f

t

;

[0093][0094]

其中,[*]是通道连接操作。

[0095]

步骤3中提取模态共有特征提取的具体方法为,

[0096]

在fr、f

t

上应用两个通道注意力对每个通道的权重进行划分;

[0097]f′r=ca(fr)=fr×

σ(avgpool(fr) maxpool(fr))

[0098]f′

t

=ca(f

t

)=f

t

×

σ(avgpool(f

t

) maxpool(f

t

))

[0099]

其中,ca()为通道注意力函数,avgpooling和maxpooling分别表示平均池化和最大池化;然后利用输出通道为128的卷积块对g进行处理,最后与f

′r和f

′

t

进行融合实现共有区域特征的提取;

[0100]

f=f

′r f

′

t

convblock(g)

[0101]

最终得到四个层级的共有区域特征fk,其中k=1,2,3,4。

[0102]

本实施例在得到共有区域特征f以后,将其作用在编码器提取出来的两个模态特征上执行擦除操作,由此实现模态独有信息的提炼;模态擦除模块的具体操作步骤为:

[0103]

首先,使用余弦相似度在每一层计算各自的共有特征和骨干特征的相关性图;

[0104]m(i,j)

=(f

(i,j)

)

t

(w

t

×

f),(1≤i≤h,1≤j≤w)

[0105]

其中(i,j)代表了每个像素点的位置,f代表了骨干特征r或者t,w反映了f到f的空间映射参数,h是特征f

(i,j)

的长的像素数,w是特征f

(i,j)

的宽的像素数;

[0106]

然后,在相关性图m上采用滑动窗口的方式生成一个二进制掩码用于擦除操作,将其定义为

[0107]

最后,利用二进制掩码对共有特征f进行擦除,得到具有模态独有信息的特征r和t;

[0108][0109]

本实施例步骤s5聚合差异性特征的具体操作为:

[0110]

将模态独有信息r和t进行通道合并,并使用输出通道为128的卷积块对聚合后的特有信息进行细化,得到多模态下差异性特征,

[0111]

接着,将f中相邻高层的特征生成注意力掩码作为多模态解码的输入;将差异性特征、共有特征以及高层语义特征使用注意力进行聚合;使用注意力机制的具体方法为:

[0112]

对于高层特征首先将低分辨率的高层特征上采样成与该层特征尺寸相同的大小,然后使用输出通道为128的卷积块将差异性特征共有特征f和高层特征修改成相同通道数,随后使用注意力机制自动获取聚合后特征的每个通道数的重要性;

[0113]

[0114][0115]

由于有四层特征,得到四层预测的特征,分别经过一个单通道的卷积层,再利用sigmoid函数将分值约束到0~1之间,分别记为s1~s4,s4为最终显著图

[0116]

本实施例步骤s6得到预测结果的详细内容为:

[0117]

给定显著图s={s(i)|i={1,...,n}和真实数据y={y(i)|i={1,...,n},其中,n是该显著图的总像素数;

[0118]

二元交叉熵bce损失函数为:

[0119][0120]

平滑度损失函数为:

[0121][0122][0123]

dice损失函数为:

[0124][0125]

在训练过程中,使用二元交叉熵bce损失函数进行监督,将其应用于最终预测的显著图;

[0126]

l1=l(s4,y));

[0127]

然后对上下文全局特征g进行监督;将其上采样到与y相同的分辨率,经过卷积和激活函数以此计算一个粗略的显著图sg;

[0128]

l2=l(s4,y);

[0129]

最后分别使用平滑度损失和dice损失对最终的预测s进行监督;

[0130]

l3=ls(s4,y)

[0131]

l4=l

dice

(s4,y)

[0132]

所以,最终的损失函数为:

[0133]

l

final

=l1 l2 l3 l4。

[0134]

实施例1:

[0135]

(1)、本实施例采用三个公开的rgb-t sod数据集,即vt5000、vt1000、vt821。

[0136]

其中,vt5000分为两部分,一部分为训练集。另一部分为测试集,分别包含了2500对可见光和热红外图像以及真值,vt1000包含1000对可见光和热红外图像及真值,vt821包含821对可见光和热红外图像及真值。

[0137]

(2)、本实施例首先对vt5000的训练集进行翻转、裁剪变换,增加训练集的复杂性,再利用处理后的vt5000训练集进行训练。本实施例在nvidia titan xp gpu训练50个epoch,批量设置为3。网络的骨干参数采用swin-b的参数,使用adams优化器优化网络参数,学习率为5e-5

,输入图像尺寸大小为384

×

384。

[0138]

(3)、为便于定量评估,本实施例采用了5种广泛使用的指标。

[0139]

(3.1)、平均绝对误差(mae)。表示预测值和观测值之间绝对误差的平均值,mae定义为:

[0140][0141]

其中t为总像素数量和s为预测显著图,y是真值图。

[0142]

(3.2)、f-measure(fm)。它被定义为精确率和召回率的加权调和平均值。

[0143]

f-measure公式为:

[0144][0145]

其中β2=0.3,表示更关注精确率。

[0146]

(3.3)、s-measure(sm)。sm计算预测图和真值标签之间的目标感知结构相似度(s0)和区域感知结构相似度(sr)。sm如下所示:

[0147]

sm=α

·

s0 (1-α)

·

sr[0148]

其中α设置为0.5。

[0149]

(3.4)、e-measure(em)。该度量是一种增强的对齐度量,可以同时测量全局像素误差和局部像素误差。

[0150]

(3.5)、p-r曲线。是精确率precision和召回率recall曲线,利用真值和预测图计算precision和recall。通过精确率和召回率来绘制p-r曲线。p-r曲线越接近坐标(1,1),网络性能越好。

[0151]

(4)、将本发明技术方案与其他现有技术比较。

[0152]

本实施例将本发明技术方案的网络与其他18种方法进行比较。

[0153]

比较方法包括6个rgb-t sod方法:mtmr、m3s-nir、sgdl、adf、siamdecoder、swinnet,6个单模态下的sod方法:pfa、r3net、basnet、poolnet、cpd、egnet,6中rgbd sod方法:dmra、s2ma、ucnet、bbsnet、hainet、rd3d,为了保持统一性,我们将rgbd sod方法利用vt5000训练集再训练。

[0154]

所有结果均由作者提供的代码生成。

[0155]

定量比较:

[0156]

本实施例在三个数据集上分别使用em、sm、fm、mae和maxf来评估预测图的优劣,具体对比试验结果如下表1所示。在所有的评估指标中,本发明的技术方案相对于其他方法得到了最高的分数。

[0157]

表1

[0158][0159]

如图3所示,本实施例给出了预测图的p-r曲线结果,并于其他技术方案的结果进行的对比。可以观察到,本发明在vt5000、vt1000和vt821三个数据集上取得了与swinnet相当的性能,并相较于其他技术方案取得了明显的提升。这也同样说明了本发明技术方案的优势结果。

[0160]

定性评价:

[0161]

如图4所示,展示了本实施例与其他技术方案可视化的比较结果。本实施选择了8对具有相对挑战性的样本进行展示,可以分为以下几个挑战场景,小目标(第1,第2行),热交叉问题(第3,第4行),多目标问题(第5,第6行)以及热红外图片质量差问题(第7,第8行)。从结果中可以看出,在一些具有挑战性的图像的可视化结果中,本发明的方法优于其他比较方法,分割效果明显提升。

[0162]

对于第一种场景,图像中的小物体通常很难分割,并伴有边界不清晰的问题,在某些情况下,它甚至会导致错误的预测。对于第二种场景,热红外模态成像质量较差,生成的图像与周围环境温度相似,无法区分前景和背景,但是本发明可以通过rgb差异性信息过滤背景和突出显著的目标,通过有效地利用rgb互补信息分割目标。在第三种场景下,一幅图中存在多个显著物体,导致物体丢失,其他技术方案都没有做到完整的预测,结果显示本发明可以有效地捕获多个目标。对于最后一种场景,虽然糟糕的热红外图会带来很大的噪声,但本发明的预测图仍然是准确的。

[0163]

本实施例最终的可见光和热红外独有特征以及共有特征的可视化结果如图5所示,5(a)为热红外特征,图5(b)为共有特征,图5(c)为可见光特征,本实施例的热红外更加倾向于关注环境中温度信息,这样会更好的定位场景中显著目标的位置,而可见光更加倾向于关注目标的一些纹理信息,这些信息可以更好的细化显著目标的边缘部分。

[0164]

本发明技术方案通过结合不同模态的差异性信息以及共有信息给出了具有更好置信度的预测结果。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。