1.本发明涉及语音合成技术领域,尤其涉及一种中英文跨语言语音合成方法、装置、电子设备及存储介质。

背景技术:

2.随着手机、平板、智能家居及可穿戴设备等都开始接入语音功能,人机交互方式逐渐走入语音时代。与传统的人机交互不同的是,语音交互具有便捷性、智能性,可以使得机器具有像人一样听说读写的综合能力。语音合成是智能语音交互系统的最后一环,负责让机器说出特定文本、特定说话人的语音音频,其分为文本分析和声学模型建模两个部分。文本分析主要是对文本进行特征提取,为后端提供发音、韵律等文本相关的信息;后端的工作是基于前端提取的语言学特征来进行声学建模,从而获得自然可懂的语音输出。从18世纪初的机械模拟简单的单词、短语发音,到依赖大型录音片段数据库的拼接合成方式,再到建模语音参数并重建语音的参数合成系统,再到近十几年基于神经网络端到端建模的神经语音合成系统,语音合成经历了长足的发展。模型的构建方式更加简便、需要的专业知识更少、模型的性能更强,尤其是基于神经网络强大的学习能力,语音合成更加多元化,合成音频更加具有表现力,而且合成更加可控。

3.语音合成的发展不仅仅满足于可理解度和自然度两个层面,也诞生出了很多的研究方向,例如个性化语音合成、低资源语音合成,其中如何探索实现跨语言语音合成是非常重要的研究内容。现实生活场景中,夹杂英文词汇的文字和说话表达方式屡见不鲜,尤其是数学等教育场景下,英文字母、希腊字母、三角符号等数学公式的朗读,需要语音合成系统具备跨语言合成的能力,但目前主流的语音合成模型默认仅支持单语种合成。由于熟练掌握多语种的专业录音人员非常稀缺,高质量的中英文混读录音较少,而且混读音频的录制、标注成本高,价格昂贵,增加了跨语言合成任务的难度。幸运的是,大量高质量单语种语音数据的开源,使得跨语言语音合成系统的实现成为可能。因此,探索在单语种录音条件下实现自然流利的跨语言语音合成系统具有非常重要的研究意义。此外,在让机器能说的同时,还要保证机器说的自然,要求语音合成系统具有较高的表现力,因此韵律建模是必不可少的环节。中文的韵律预测以及韵律建模已经有较为成熟的方法,探索如何更好地建模中英文跨语言文本的韵律特征,提高跨语言语音合成系统的自然度和韵律同样是非常重要的研究内容。

技术实现要素:

4.本发明针对上述问题,提供了一种中英文跨语言语音合成方法、装置、电子设备及存储介质,方法基于多种策略融合,构建了两种跨语言声学模型,使本发明的中英文跨语言语音合成方法解决了现有的语音合成方法的不足。

5.本发明的第一方面,一种中英文跨语言语音合成方法,包括以下步骤:

6.利用深度学习中序列到序列任务构建第一跨语言声学模型;

7.将文本数据集处理成包括音素序列、声调序列和语言序列的基础语句;

8.利用第一跨语言声学模型编码器将基础语句编码成高级上下文语义表示,同时在第一跨语言声学模型编码器的多个位置引入语言嵌入和说话人嵌入;

9.利用注意力机制学习高级上下文语义表示和声学特征梅尔谱图的映射关系,得到线性加权后的高级上下文语义表示;

10.利用第一跨语言声学模型解码器将线性加权后的高级上下文语义表示生成原始谱图。

11.进一步的,第一跨语言声学模型基于tacotron模型,包括:基于cbhg的编码器、基于高斯混合分布的gmmv2b注意力机制模块和解码器。

12.进一步的,方法还包括利用基于经验重演的持续学习方法对第一跨语言声学模型进行微调,微调过程中利用基于正则的可塑权重稳固方法,将微调时的第一跨语言声学模型参数固定在微调前第一跨语言声学模型参数的极小误差范围内。

13.进一步的,方法还包括将中文的韵律结构扩展到中英文跨语言文本,具体方法包括:将英文单词或单字母作为中文四级韵律结构中的韵律词,根据文本对应音频中不同长度的停顿来标注韵律短语边界和语调短语边界,将韵律短语边界和语调短语边界作为音素混合到音素序列中。

14.进一步的,方法还包括根据基础语句的层次韵律构造层次韵律图,将图神经网络融入第一跨语言声学模型编码器中形成第二跨语言声学模型,图神经网络根据层次韵律图在空间域进行多次迭代用于在音素节点表示之间传播韵律信息。

15.进一步的,第二跨语言声学模型编码器包括卷积层、高速网络、门控图神经网络以及双向gru,其中,卷积层用于提取输入基础语句的局部上下文表示;高速网络用于提取高维特征以构建鲁棒的输入节点表示;双向gru用于学习输入基础语句的前向和后向文本表示。

16.本发明的第二方面,提供了一种中英文跨语言语音合成装置,所述装置包括:

17.第一跨语言声学模型构建单元,用于利用深度学习中序列到序列任务构建第一跨语言声学模型;

18.文本数据集处理单元:用于将文本数据集处理成包括音素序列、声调序列和语言序列的基础语句;

19.第一跨语言声学模型编码器单元,用于利用第一跨语言声学模型编码器将基础语句编码成高级上下文语义表示,同时在第一跨语言声学模型编码器的多个位置引入语言嵌入和说话人嵌入;

20.注意力机制学习单元,用于利用注意力机制学习高级上下文语义表示和声学特征梅尔谱图的映射关系,得到线性加权后的高级上下文语义表示;

21.第一跨语言声学模型解码器单元,用于利用第一跨语言声学模型解码器将线性加权后的高级上下文语义表示生成原始谱图。

22.进一步的,第一跨语言声学模型编码器单元还用于根据基础语句的层次韵律构造层次韵律图,将图神经网络融入第一跨语言声学模型编码器中形成第二跨语言声学模型,图神经网络根据层次韵律图在空间域进行多次迭代用于在音素节点表示之间传播韵律信息。

23.本发明的第三方面,提供了一种电子设备,包括:处理器;以及存储器,其中,所述存储器中存储有计算机可执行程序,当由所述处理器执行所述计算机可执行程序时,执行上述中英文跨语言语音合成方法。

24.本发明的第四方面,提供了一种计算机可读存储介质,其上存储有指令,所述指令在被处理器执行时,使得所述处理器执行上述中英文跨语言语音合成方法。

25.本发明提供的一种中英文跨语言语音合成方法、装置、电子设备及存储介质,在深入地研究了现有语音合成方法的基础上,设计一种多策略融合的中英文跨语言声学模型和基于图的跨语言声学模型。本发明主要包括多种策略融合的跨语言声学模型和基于图的表现力语音合成方法。为了提高跨语言声学模型的鲁棒性和合成语音的自然度,引入多种优化策略,在tacotron模型的基础上提出了第一跨语言声学模型cs-tacotron:通过将模型输入优化为音素序列、音调序列和语言序列三部分来实现信息解耦并减少音素个数;通过在模型多个位置引入语言嵌入以更好地建模中英文语言切换时的自然度;通过在模型多个位置引入说话人嵌入以提高多说话人建模的音色相似度;引入持续学习方法来改善使用中文单语种录音数据对跨语言模型微调时的合成效果。

26.为了提高中文跨语言语音合成模型合成语音的表现力,对语音合成的韵律停顿建模进行了研究。本发明将中文的层级韵律结构泛化到中英文跨语言文本,以改善跨语言语音合成的效果。层级韵律实现韵律建模的方式通常将不同等级的韵律边界作为音素混合到输入序列中,模型根据训练数据自主学习对应的停顿时长。从输入跨语言文本的层次韵律构造层次韵律图,引入图神经网络进行建模,实现了韵律信息建模的一种替代方式,并探索提出了基于图的第二跨语言声学模型gcs-tacotron。

附图说明

27.图1是本发明实施例的中英文跨语言语音合成方法流程图;

28.图2是本发明实施例第一跨语言声学模型cs-tacotron模型的结构示意图;

29.图3是本发明实施例cs-tacotron模型输入数据示意图;

30.图4是本发明实施例基于持续学习方法的cs-tacotron模型微调示意图;

31.图5是本发明实施例扩展的中英文层级韵律结构示意图;

32.图6是本发明实施例层级韵律在输入文本中的韵律结构表示示意图;

33.图7是本发明实施例提取的层次韵律图;

34.图8是本发明实施例第二跨语言声学模型gcs-tacotron模型的结构示意图;

35.图9是本发明实施例的中英文跨语言语音合成装置结构示意图;

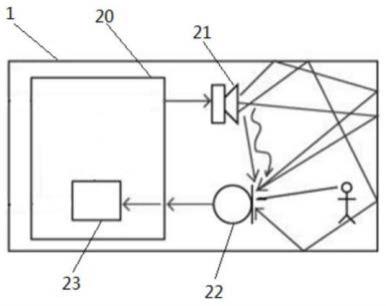

36.图10是本发明实施例中的电子设备的架构图。

具体实施方式

37.为进一步对本发明的技术方案作详细说明,本实施例在以本发明技术方案为前提下进行实施,给出了详细的实施方式和具体的步骤。

38.本发明实施例针对一种中英文跨语言语音合成方法、装置、电子设备及存储介质,提供了如下实施例:

39.基于本发明的实施例1

40.本实施例用于说明本发明解决技术问题的原理和步骤,如图1所示,为本发明实施例1的中英文跨语言语音合成方法流程图,具体步骤为:

41.s1、利用深度学习中序列到序列任务构建第一跨语言声学模型;

42.进一步的,第一跨语言声学模型基于tacotron模型,包括:基于cbhg的编码器、基于高斯混合分布的gmmv2b注意力机制模块和解码器。

43.具体实施过程中,如图2所示,第一跨语言声学模型cs-tacotron包括:编码器,为基于cbhg的编码器,语言嵌入经过不同的线性层和非线性层激活后与卷积网络相加、作为高速网络的门控;基于高斯混合分布的gmmv2b注意力机制模块;解码器输出预测谱图和预测停止符。

44.s2、将文本数据集处理成包括音素序列、声调序列和语言序列的基础语句;

45.具体实施过程中,在进行文本数据集处理之前,需对文本数据集进行预处理,即对数据集进行清洗和韵律标注,为了设计模型文本输入格式,针对中英文跨语言语音合成,中文一般采取注音字符作为输入,如拼音,而英文直接使用字符,本发明将预处理后的文本数据集优化为音素序列、音调序列和语言序列三部分来实现语言信息、声调信息以及音素信息的解耦并减少音素个数,降低编码空间大小。如图3所示,输入由音素序列、音调序列以及语言序列组成,分别经过相应的编码层得到编码表示,旨在降低音素数量、优化模型的输入进而提高模型合成语音的自然度。

46.s3、利用第一跨语言声学模型编码器将基础语句编码成高级上下文语义表示,同时在第一跨语言声学模型编码器的多个位置引入语言嵌入和说话人嵌入;

47.参考图1,cs-tacotron模型编码器将输入基础语句编码成高级上下文语义表示,同时在cs-tacotron模型的多个位置引入语言嵌入以更好地建模中英文语言切换时的局部上下文信息,使建模更有自然度,在cs-tacotron模型的多个位置引入说话人嵌入提高多说话人建模的音色相似度。

48.具体实施过程中,cs-tacotron模型输入为音素嵌入、语调嵌入、语言嵌入的拼接,显式的语言嵌入降低模型建模的难度;语言嵌入经过全连接和softsign函数处理后与编码器卷积网络的输出相加并且作为高速网络的门控,强化语言学信息,更好地建模语言切换时的上下文信息;说话人嵌入经过全连接层和softsign函数处理后作为双向gru的初始状态、与编码器输出相加、与解码器lstm的输入拼接,强化说话人信息,提高多说话人建模的音色相似度。

49.s4、利用注意力机制学习高级上下文语义表示和声学特征梅尔谱图的映射关系,得到线性加权后的高级上下文语义表示;

50.具体实施过程中,采用的是基于高斯混合分布的gmmv2b注意力机制,用注意力机制学习输入高级上下文语义表示序列和输出序列的映射关系,即文本映射和声学特征梅尔谱图的映射关系,此部分完成输入文本到梅尔谱图的语义表示转换,以便后续通过解码端模型解码生成合成原始谱图。通过gmmv2b注意力机制学习高级上下文语义表示和声学特征梅尔谱图的映射关系,对输入的高级上下文语义表示进行线性加权,得到线性加权后的高级上下文语义表示。

51.s5、利用第一跨语言声学模型解码器将线性加权后的高级上下文语义表示生成原始谱图;

52.具体实施过程中,参考图2所示,基于tacotron模型的cs-tacotron模型解码端根据注意力机制学习的映射关系和cs-tacotron模型编码器编码的高级上下文语义输入第一跨语言声学模型解码器rnn网络中生成原始谱图,并将原始谱图合成语音,通过在解码器的多个位置引入说话人嵌入,来提高合成语音的音色相似度,减轻建模难度。

53.最后,通过后处理网络将原始谱图进行平滑处理后生成可合成语音的谱图,然后由声码器将谱图重建为音频波形。

54.基于本发明的实施例2

55.本实施例用于对构建的第一跨语言声学模型cs-tacotron模型进行微调,在使用中文单语数据对跨语言声学模型进行微调时,会导致合成的中英文跨语言语音效果变差,存在中英文跨语言语音合成的灾难性遗忘问题,本发明引入持续学习方法来改善使用中文单语种录音数据对跨语言cs-tacotron模型微调时的合成效果。

56.进一步的,利用基于经验重演的持续学习方法对第一跨语言声学模型进行微调,微调过程中利用基于正则的可塑权重稳固方法,将微调时的第一跨语言声学模型参数固定在微调前第一跨语言声学模型参数的极小误差范围内。通过引入基于可塑权重稳固和经验重演的两种持续学习微调方法,提高单语微调时声学模型合成跨语言语音的效果。具体实施过程中,从零训练新构建的cs-tacotron模型费时费力,因此通常先使用混合数据训练cs-tacotron模型,再通过数据对cs-tacotron模型进行微调,得到相应的音色定制的微调好的cs-tacotron模型。引入基于持续学习的微调方法,来改善使用单语数据对跨语言声学模型进行微调时存在合成语音效果较差的问题,具体包括:引入基于正则的可塑权重稳固(elastic weight consolidation,ewc)方法,将微调模型参数固定在基底跨语言模型参数的极小误差范围内,从而保证单语声学模型合成中英文跨语言语音的效果;引入基于经验重演(experience replay,er)的持续学习方法来保证单语声学模型合成中英文跨语言语音的效果。如图4所示为基于持续学习方法的微调示意图,显示了基于可塑权重稳固和经验重演的方法在微调时的训练轨迹,使模型参数保持在微调前模型参数附近从而保证合成跨语言语音的效果。图中a*为微调前模型低误差参数,虚曲线为不加任何约束的训练轨迹,会导致模型性能较差,实曲线和实点曲线分别为采用可塑权重稳固和经验重演方法的训练轨迹,能更好的找到微调前和微调后的最优参数。

57.基于本发明的实施例3

58.本实施例为了提高cs-tacotron模型合成语音的表现力,对语音合成的韵律停顿建模进行了研究,实施例将中文的层级韵律结构泛化到中英文跨语言文本,以改善跨语言语音合成的效果。层级韵律实现韵律建模的方式通常将不同等级的韵律边界作为音素混合到输入序列中,模型根据训练数据自主学习对应的停顿时长,从输入跨语言文本的层次韵律构造层次韵律图,引入图神经网络进行建模,实现了韵律信息建模的一种替代方式,并提出了基于图的第二跨语言声学模型gcs-tacotron模型。

59.进一步的,将中文的韵律结构扩展到中英文跨语言文本,具体方法包括:将英文单词或单字母作为中文四级韵律结构中的韵律词,根据文本对应音频中不同长度的停顿来标注韵律短语边界和语调短语边界,将韵律短语边界和语调短语边界作为音素混合到音素序列中。

60.具体实施过程中,考虑到中文停顿韵律结构具有层次嵌套性质,本发明将中文的

韵律结构扩展到中英文文本分布场景,以提高中英文跨语言语音合成的表现力。将中文的层次韵律结构扩展到中英文分布场景,并从中构造语调短语和韵律短语边界图,具体包括:

61.中文包含韵律词、韵律短语、语调短语、句子四级韵律结构,本发明将英文单词或单字母视为韵律词,从而将中文的韵律结构扩展到中英文分布场景,如图5所示,是实施例所扩展的中英文层级韵律结构示意图,中英文文本韵律主要分为韵律词,韵律短语、语调短语和句子等四个层次,具有层次嵌套性质,停顿时长逐渐变长的特点;

62.将中文韵律标注的方式扩展到中文和英文跨语言文本的韵律标注中,将英文的单词或单字母视为中文的韵律词,根据文本对应音频中不同长度的停顿来标注韵律短语pph和语调短语iph边界,如图6所示是实施例中层级韵律在输入文本中的韵律结构表示,如图7所示是实施例中所提取的层次韵律图,包括韵律短语pph和语调短语iph两种类型的边,并且边具有唯一性。

63.进一步的,将图神经网络融入第一跨语言声学模型编码器中形成第二跨语言声学模型,图神经网络根据层次韵律图在空间域进行多次迭代用于在音素节点表示之间传播韵律信息。

64.具体实施过程中,将图神经网络融入到cs-tacotron模型中,以根据构造的层次韵律图,建模输入文本的韵律信息。

65.基于本发明的实施例4

66.本发明在实施例3的基础上,对第二跨语言声学模型gcs-tacotron模型进行说明,如图8所示,为了能够更好的将图神经网络融入声学模型并降低模型的计算量,在cs-tacotron模型的基础上进一步提出了基于图神经网络的第二跨语言声学模型gcs-tacotron模型。gcs-tacotron模型编码器由四部分组成:带有可切换归一化(switchable normalization,sn)的卷积层,用以提取输入文本的局部上下文表示;高速网络,用以减缓梯度消失并且提取高维特征,以构建鲁棒的输入节点表示;门控图神经网络,根据构造的层次韵律图,在空间域经过多次迭代以在音素节点表示之间传播韵律信息;双向gru(双向门控循环单元),用以学习输入文本的前向和后向文本表示。gcs-tacotron模型编码器用以建模输入文本的局部上下文信息、韵律信息和前后向序列特征,以得到鲁棒的文本表示。gcs-tacotron模型注意力机制模块与cs-tacotron模型相同,也是基于高斯混合分布的gmmv2b注意力机制,gcs-tacotron模型解码器用于输出预测谱图和停止符。

67.基于本发明的实施例5

68.以下,参照图9来描述根据本公开实施例1至实施例4的与图1至图9所示的方法对应的装置,一种中英文跨语言语音合成装置,所述装置100包括:第一跨语言声学模型构建单元101,用于利用深度学习中序列到序列任务构建第一跨语言声学模型;文本数据集处理单元102,用于将文本数据集处理成包括音素序列、声调序列和语言序列的基础语句;第一跨语言声学模型编码器单元103,用于利用第一跨语言声学模型编码器将基础语句编码成高级上下文语义表示,同时在第一跨语言声学模型编码器的多个位置引入语言嵌入和说话人嵌入;注意力机制学习单元104,用于利用注意力机制学习文本映射和声学特征梅尔谱图的映射关系;第一跨语言声学模型解码器单元105,用于根据映射关系利用第一跨语言声学模型解码器将高级上下文语义表示生成原始谱图,并将原始谱图合成语音。除了上述5个单元以外,装置100还可以包括其他部件,然而,由于这些部件与本公开实施例的内容无关,因

此在这里省略其图示和描述。

69.进一步的,第一跨语言声学模型编码器单元103还用于根据基础语句的层次韵律构造层次韵律图,将图神经网络融入第一跨语言声学模型编码器中形成第二跨语言声学模型,图神经网络根据层次韵律图在空间域进行多次迭代用于在音素节点表示之间传播韵律信息。

70.一种中英文跨语言语音合成装置100的具体工作过程参照上述中英文跨语言语音合成方法实施例1至实施例4的描述,不再赘述。

71.基于本发明的实施例6

72.根据本发明实施例的装置也可以借助于图10所示的电子设备的架构来实现。图10示出了该电子设备的架构。如图10所示,计算机系统201、系统总线203、一个或多个cpu 204、输入/输出202、存储器205。存储器205可以存储计算机处理和/或通信使用的各种数据或文件以及cpu所执行包括实施例1至实施4的中英文跨语言语音合成方法的程序指令。图10所示的架构只是示例性的,在实现不同的设备时,根据实际需要调整图10中的一个或多个组件。

73.基于本发明的实施例7

74.本发明实施例也可以被实现为计算机可读存储介质。根据实施例7的计算机可读存储介质上存储有计算机可读指令。当所述计算机可读指令由处理器运行时,可以执行参照以上附图描述的根据本发明实施例1至实施4的中英文跨语言语音合成方法。

75.综合上述各实施例提供的中英文跨语言语音合成方法、装置、电子设备及存储介质,在深入地研究了现有语音合成方法的基础上,设计一种多策略融合的中英文跨语言声学模型和基于图的跨语言声学模型。本发明主要包括多种策略融合的跨语言声学模型和基于图的表现力语音合成方法。为了提高跨语言声学模型的鲁棒性和合成语音的自然度,引入多种优化策略,在tacotron模型的基础上提出了第一跨语言声学模型cs-tacotron:通过将模型输入优化为音素序列、音调序列和语言序列三部分来实现信息解耦并减少音素个数;通过在模型多个位置引入语言嵌入以更好地建模中英文语言切换时的自然度;通过在模型多个位置引入说话人嵌入以提高多说话人建模的音色相似度;引入持续学习方法来改善使用中文单语种录音数据对跨语言模型微调时的合成效果。为了提高中文跨语言语音合成模型合成语音的表现力,对语音合成的韵律停顿建模进行了研究。本发明将中文的层级韵律结构泛化到中英文跨语言文本,以改善跨语言语音合成的效果。层级韵律实现韵律建模的方式通常将不同等级的韵律边界作为音素混合到输入序列中,模型根据训练数据自主学习对应的停顿时长。从输入跨语言文本的层次韵律构造层次韵律图,引入图神经网络进行建模,实现了韵律信息建模的一种替代方式,并探索提出了基于图的第二跨语言声学模型gcs-tacotron。

76.在本文中,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的步骤、方法不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种步骤、方法所固有的要素。

77.以上内容是结合具体的优选实施方式对本发明所作的进一步详细说明,不能认定本发明的具体实施只局限于这些说明。对于本发明所属技术领域的普通技术人员来说,在不脱离本发明构思的前提下,还可以做出若干简单推演或替换,都应当视为属于本发明的

保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。