1.本发明涉及人脸识别技术领域,尤其涉及基于多特征融合的表情识别方法及装置。

背景技术:

2.本部分旨在为权利要求书中陈述的本发明实施例提供背景或上下文。此处的描述不因为包括在本部分中就承认是现有技术。

3.目前很多方法是直接对人脸整体区域进行表情识别,这导致表情识别精度很低;有些方法虽然取到影响表情的关键部位进行识别,但是该类方法是分别单独进行分类,分别获得其对应的识别准确率后根据识别准确率加权分类,该方法流程麻烦,且单独分类得到的准确率并不能真正得到各个部位的重要性,比如平静的表情对各个部位进行分类,会得到每个部位准确率差不多,就误导实验者对每个位置相同权重,这跟实际情况不符,导致人脸表情识别准确率低。

技术实现要素:

4.本发明实施例提供一种基于多特征融合的表情识别方法,用以解决现有人脸识别方法识别准确率低的技术问题,该方法包括:

5.对人脸图像进行人脸和人脸关键点检测,检测出人脸和人脸关键点;

6.基于所述人脸关键点确定影响人脸表情的多个所述部位图像,并将人脸图像的数据标签赋予给多个所述部位图像,所述数据标签用于表示人脸表情种类;多个所述部位图像包括眼睛区域图像、嘴巴区域图像、鼻子区域图像和下巴区域图像;

7.利用改进的多分支特征提取网络对赋予了数据标签的多个所述部位图像分别进行特征提取,获得多个所述部位图像的特征;

8.将多个所述部位图像的特征进行特征融合,获得总融合特征;

9.对所述总融合特征进行分类,得到表情分类结果。

10.本发明实施例还提供一种基于多特征融合的表情识别装置,用以解决现有人脸识别方法识别准确率低的技术问题,该装置包括:

11.人脸和人脸关键点检测模块,用于对人脸图像进行人脸和人脸关键点检测,检测出人脸和人脸关键点;

12.部位区域确定及标签赋予模块,用于基于所述人脸关键点确定影响人脸表情的多个部位图像,并将人脸图像的数据标签赋予给多个所述部位图像,所述数据标签用于表示人脸表情种类;多个所述部位图像包括眼睛区域图像、嘴巴区域图像、鼻子区域图像和下巴区域图像;

13.特征提取模块,用于利用改进的多分支特征提取网络对赋予了数据标签的多个所述部位图像分别进行特征提取,获得多个所述部位图像的特征;

14.特征融合模块,用于将多个所述部位图像的特征进行特征融合,获得总融合特征;

15.特征分类模块,用于对所述总融合特征进行分类,得到表情分类结果。

16.本发明实施例还提供一种计算机设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现上述基于多特征融合的表情识别方法。

17.本发明实施例还提供一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序被处理器执行时实现上述基于多特征融合的表情识别方法。

18.本发明实施例还提供一种计算机程序产品,所述计算机程序产品包括计算机程序,所述计算机程序被处理器执行时实现上述基于多特征融合的表情识别方法。

19.本发明通过对人脸图像进行人脸和人脸关键点检测,检测出人脸和人脸关键点;基于人脸关键点确定影响人脸表情的多个部位图像,并将数据标签赋予给多个所述部位图像,数据标签用于表示人脸表情种类;多个所述部位图像包括眼睛区域图像、嘴巴区域图像、鼻子区域图像和下巴区域图像;利用改进的多分支特征提取网络对赋予了数据标签的多个所述部位图像分别进行特征提取,获得多个所述部位图像的特征;将多个所述部位图像的特征进行特征融合,获得总融合特征;对总融合特征进行分类,得到表情分类结果。相比直接对人脸整体区域进行表情识别的现有方法,本发明对人脸和人脸关键点均进行检测,然后基于人脸关键点进行表情识别,这样可以提高表情识别精度。另外,相比取到影响表情的关键部位进行单独分类,分别获得其对应的识别准确率后根据精确率加权分类的现有方法,本发明获取不同部位区域,然后将不同部位区域的特征融合后进行表情分类,这样可以更精准的进行表情识别。

附图说明

20.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。在附图中:

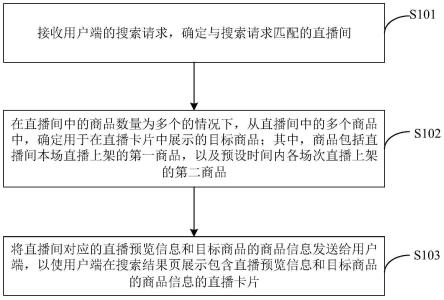

21.图1为本发明实施例中基于多特征融合的表情识别方法流程图一;

22.图2为本发明实施例中基于多特征融合的表情识别方法流程图二;

23.图3为本发明实施例中基于多特征融合的表情识别方法流程图三;

24.图4为本发明实施例中基于多特征融合的表情识别方法流程图四;

25.图5为本发明实施例中基于多特征融合的表情识别方法流程图五;

26.图6为本发明实施例中基于多特征融合的表情识别方法流程图六;

27.图7为本发明实施例中基于多特征融合的表情识别方法流程图七;

28.图8为本发明实施例中基于多特征融合的表情识别方法流程图八;

29.图9为本发明实施例中基于多特征融合的表情识别装置结构框图一;

30.图10为本发明实施例中基于多特征融合的表情识别装置结构框图二。

具体实施方式

31.为使本发明实施例的目的、技术方案和优点更加清楚明白,下面结合附图对本发明实施例做进一步详细说明。在此,本发明的示意性实施例及其说明用于解释本发明,但并

不作为对本发明的限定。

32.本技术技术方案中对数据的获取、存储、使用、处理等均符合国家法律法规的相关规定。

33.针对目前直接对人脸整体区域进行表情识别精度低的情况,本发明提出一种基于多特征融合的表情识别方法,如图1所示,该基于多特征融合的表情识别方法包括:

34.步骤101:对人脸图像进行人脸和人脸关键点检测,检测出人脸和人脸关键点;

35.步骤102:基于所述人脸关键点确定影响人脸表情的多个部位图像,并将人脸图像的数据标签赋予给多个所述部位图像,所述数据标签用于表示人脸表情种类;多个所述部位图像包括眼睛区域图像、嘴巴区域图像、鼻子区域图像和下巴区域图像;

36.步骤103:利用改进的多分支特征提取网络对赋予了数据标签的多个所述部位图像分别进行特征提取,获得多个所述部位图像的特征;

37.步骤104:将多个所述部位图像的特征进行特征融合,获得总融合特征;

38.步骤105:对所述总融合特征进行分类,得到表情分类结果。

39.上述方法是对人脸识别网络的训练过程,即将标注有表情种类的人脸图像作为训练数据,对改进的yolov5算法、改进的多分支特征提取网络等训练过程中涉及到的网络进行训练。

40.在训练之后可以得到优化的人脸识别网络,可以使用优化的人脸识别网络对未确定表情种类的人脸图像进行识别,获得人脸图像中人脸对应的表情种类。

41.在本发明实施例中,如图2所示,步骤101对人脸图像进行人脸和人脸关键点检测,检测出人脸和人脸关键点,包括:

42.步骤201:采用改进的yolov5算法对人脸图像进行人脸和人脸关键点检测,检测出人脸和人脸关键点,其中,改进的yolov5算法为在yolov5算法上增加人脸关键点分支网络。

43.具体的,基于目标检测开源算法yolov5基础上,增加了人脸关键点分支网络,即在原来的人脸检测网络上增加一个人脸关键点分支网络。其中人脸关键点分支网络跟人脸检测网络共享参数(即共用一个特征提取网络),在特征提取网络后,在原来只有smooth l1 loss为损失函数的检测回归层和softmax分类层外,加上一个以欧氏距离为度量的loss函数去衡量人脸关键点训练误差,从而优化训练误差。

44.本发明使用改进的yolov5算法同时检测人脸和5个人脸关键点,5个关键点包括两个眼睛、一个鼻尖、两个嘴角。

45.在本发明实施例中,如图3所示,还包括:

46.步骤301:在检测出人脸和人脸关键点之后,将人脸关键点越界的人脸图像去除。

47.具体的,步骤301包括:

48.将所述人脸关键点的坐标和所述人脸图像中人脸区域的坐标范围进行比较,若所述人脸关键点的坐标不在所述人脸区域的坐标范围之内,表明所述人脸关键点越界,则去除对应的所述人脸图像。

49.具体的,将人脸图像经改进的yolov5算法进行检测,得到所有图片的人脸和5个关键点,同时把关键点越界的人脸图片去除,因为关键点越界到人脸框外说明人脸是比较歪的,此时的人脸部位信息会有较大变化,不适合做表情识别。

50.在本发明实施例中,步骤102中,根据人脸关键点坐标点,分别取出人脸图像上的

眼睛区域图像、鼻子区域图像、嘴巴区域图像和下巴区域图像。其中,眼睛区域图像根据两个眼睛关键点确定,鼻子区域图像根据鼻子关键点确定,嘴巴区域图像根据两个嘴角关键点确定,下巴区域图像根据两个嘴角关键点确定。然后将人脸图像的数据标签赋给各个部位图像,数据标签标示表情种类,表情种类包含平静、高兴、生气、惊恐、悲伤5种,依次分配0、1、2、3、4标签。

51.在本发明实施例中,如图4所示,该方法还包括:

52.步骤401:将多分支特征提取网络通道数乘以权重系数得到所述改进的多分支特征提取网络;其中,所述权重系数为多个所述部位图像的权重,多个所述部位图像的权重不同。

53.可选的,如图5所示,该方法还包括:

54.步骤501:将特征提取网络shufflenetv2由单分支扩展成多个分支,得到所述多分支特征提取网络;

55.步骤401具体包括:

56.将所述多分支特征提取网络中的每个分支的shufflenet网络通道数乘以权重系数;其中,所述眼睛区域图像的权重和所述嘴巴区域图像的权重相同,所述下巴区域图像的权重和所述鼻子区域图像的权重相同,所述眼睛区域图像的权重和所述嘴巴区域图像的权重大于所述下巴区域图像的权重和所述鼻子区域图像的权重。

57.可选的,如图6所示,步骤103利用改进的多分支特征提取网络对赋予了数据标签的多个所述部位图像分别进行特征提取,获得多个所述部位图像的特征,具体包括:

58.步骤601:利用改进的特征提取网络shufflenetv2对赋予了数据标签的多个所述部位图像分别进行特征提取,每个分支特征提取网络分别负责提取所述人脸图像中的所述眼睛区域图像、所述鼻子区域图像、所述嘴巴区域图像以及所述下巴区域的特征,获得多个所述部位图像的特征。

59.具体的,对于做好标签的各个人脸关键部位图像,用改进的shufflenetv2进行特征提取,其中改进的shufflenetv2可以是将单分支扩展成4个分支,并将每个分支的shufflenet网络通道数乘以权重系数,每个分支分别负责提取眼睛区域图像、鼻子区域图像、嘴巴区域图像和下巴区域图像的特征,其中权重系数对应关系为:眼睛区域图像的权重为0.3、嘴巴区域图像的权重为0.3、下巴区域图像的权重和鼻子区域图像的权重均为0.2。其中,权重是影响表情特征的关键部位权重,权重越大影响越大,具体的权重数值可以人为设定,符合权重系数对应关系即可。

60.在本发明实施例中,如图7所示,步骤104将多个所述部位图像的特征进行特征融合,获得总融合特征,具体包括:

61.步骤701:采用concat特征融合方式将多个所述部位图像的特征进行特征融合,获得总融合特征。

62.具体的,特征融合方式为concat,concat是神经网络基本操作层,只需要将眼睛区域图像、鼻子区域图像、嘴巴区域图像和下巴区域图像的特征输入,就会自动融合特征,生成一个新的总的融合特征。

63.在本发明实施例中,如图8所示,步骤105对所述总融合特征进行分类,得到表情分类结果,具体包括:

64.步骤801:采用神经网络分类函数softmax对所述总融合特征进行分类,得到表情分类结果。

65.具体的,将总融合特征输入到softmax分类函数层进行分类,得到表情分类结果,softmax分类函数是神经网络用于分类的基本操作,将特征向量输入到softmax函数,会自动求出属于某个类别的概率,最后将最大的可能概率输出,即可以对目标进行分类。

66.本发明实施例中还提供了一种基于多特征融合的表情识别装置,如下面的实施例所述。由于该装置解决问题的原理与基于多特征融合的表情识别方法相似,因此该装置的实施可以参见基于多特征融合的表情识别方法的实施,重复之处不再赘述。

67.图9为本发明实施例中基于多特征融合的表情识别装置结构框图一,如图9所示,该装置包括:

68.人脸和人脸关键点检测模块02,用于对人脸图像进行人脸和人脸关键点检测,检测出人脸和人脸关键点;

69.部位区域确定及标签赋予模块04,用于基于所述人脸关键点确定影响人脸表情的多个部位图像,并将所述人脸图像的数据标签赋予给多个所述部位图像,所述数据标签用于表示人脸表情种类;多个所述部位图像包括眼睛区域图像、嘴巴区域图像、鼻子区域图像和下巴区域图像;

70.特征提取模块06,用于利用改进的多分支特征提取网络对赋予了所述数据标签的多个所述部位图像分别进行特征提取,获得多个所述部位图像的特征;

71.特征融合模块08,用于将多个所述部位图像的特征进行特征融合,获得总融合特征;

72.特征分类模块10,用于对所述总融合特征进行分类,得到表情分类结果。

73.在本发明实施例中,人脸和人脸关键点检测模块02具体用于:

74.采用改进的yolov5算法对人脸图像进行人脸和人脸关键点检测,检测出人脸和人脸关键点,其中,所述改进的yolov5算法为在yolov5算法上增加人脸关键点分支网络。

75.在本发明实施例中,如图10所示,还包括:

76.越界去除模块12,用于在检测出人脸和人脸关键点之后,将所述人脸关键点越界的人脸图像去除。

77.在本发明实施例中,越界去除模块12具体用于:

78.将所述人脸关键点的坐标和所述人脸图像中人脸区域的坐标范围进行比较,若所述人脸关键点的坐标不在所述人脸区域的坐标范围之内,则去除对应的所述人脸图像。

79.在本发明实施例中,特征提取模块06还用于:

80.将多分支特征提取网络通道数乘以权重系数得到所述改进的多分支特征提取网络;其中,所述权重系数为多个所述部位图像的权重,多个所述部位图像的权重不同。

81.在本发明实施例中,特征提取模块06还用于:

82.将特征提取网络shufflenetv2由单分支扩展成多个分支,得到所述多分支特征提取网络;

83.将所述多分支特征提取网络中的每个分支的shufflenet网络通道数乘以权重系数;其中,所述眼睛区域图像的权重和所述嘴巴区域图像的权重相同,所述下巴区域图像的权重和所述鼻子区域图像的权重相同,所述眼睛区域图像的权重和所述嘴巴区域图像的权

重大于所述下巴区域图像的权重和所述鼻子区域图像的权重。

84.在本发明实施例中,特征提取模块06具体用于:

85.利用改进的特征提取网络shufflenetv2对赋予了数据标签的多个所述部位图像分别进行特征提取,每个分支特征提取网络分别负责提取所述人脸图像中的所述眼睛区域图像、所述鼻子区域图像、所述嘴巴区域图像以及所述下巴区域图像的特征,获得多个所述部位图像的特征。

86.在本发明实施例中,特征融合模块08具体用于:

87.采用concat特征融合方式将多个所述部位图像的特征进行特征融合,获得总融合特征。

88.在本发明实施例中,特征分类模块10具体用于:

89.采用神经网络分类函数softmax对所述总融合特征进行分类,得到表情分类结果。

90.本发明实施例还提供一种计算机设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现上述基于多特征融合的表情识别方法。

91.本发明实施例还提供一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序被处理器执行时实现上述基于多特征融合的表情识别方法。

92.本发明实施例还提供一种计算机程序产品,所述计算机程序产品包括计算机程序,所述计算机程序被处理器执行时实现上述基于多特征融合的表情识别方法。

93.本发明实施例中,本方明通过对人脸图像进行人脸和人脸关键点检测,检测出人脸和人脸关键点;基于人脸关键点确定影响人脸表情的多个所述部位图像,并将数据标签赋予给多个所述部位图像,数据标签用于表示人脸表情种类;多个所述部位图像包括眼睛区域图像、嘴巴区域图像、鼻子区域图像和下巴区域图像;利用多分支特征提取网络对赋予了数据标签的多个所述部位图像分别进行特征提取,获得多个所述部位图像的特征;将多个所述部位图像的特征进行特征融合,获得总融合特征;对总融合特征进行分类,得到表情分类结果。针对于直接对人脸整体区域进行表情识别的现有方法,本发明采用改进的yolov5算法进行人脸检测,可以同时检测出人脸和人脸关键点,然后基于人脸关键点进行表情识别,这样可以提高表情识别精度。相比取到影响表情的关键部位进行单独分类,分别获得其对应的识别准确率后根据精确率加权分类的现有方法,本发明获取不同部位区域,然后将不同部位区域的特征融合后进行表情分类,这样可以更精准的进行表情识别。

94.另外,本发明还具有如下有益效果:

95.1、本发明采用改进的yolov5算法进行人脸检测,可以同时检测出人脸和人脸关键点,而不需要再单独对人脸进行关键点定位,效率提升一倍;

96.2、本发明还可以根据人脸关键点是否越界自动筛选符合要求的样本数据;

97.3、本发明通过大量观察数据,根据影响表情的重要性程度,赋予相应权重,简单且有效。

98.本领域内的技术人员应明白,本发明的实施例可提供为方法、系统、或计算机程序产品。因此,本发明可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本发明可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、cd-rom、光学存储器等)上实施的计算机程序产

品的形式。

99.本发明是参照根据本发明实施例的方法、设备(系统)、和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

100.这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

101.这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的步骤。

102.以上所述的具体实施例,对本发明的目的、技术方案和有益效果进行了进一步详细说明,所应理解的是,以上所述仅为本发明的具体实施例而已,并不用于限定本发明的保护范围,凡在本发明的精神和原则之内,所做的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。