1.本发明涉及卷积神经网络以及图像处理技术领域,特别是涉及一种基于混合注意力机制的单眼注视点估计方法及系统。

背景技术:

2.视觉是人类获取外部信息最主要的方式之一。目前,人眼的注视点估计研究在很多领域都有重要应用,如:显著性检测、人机交互和虚拟现实等。

3.注视点估计方法可分为基于模型的方法和基于外观的方法。基于模型的注视点估计方法一般通过专用设备实现,但由于工作距离短(通常在60cm以内)和野外失败率高,大多局限于实验室环境。基于外观的方法只需要一个网络摄像头来捕捉图像,直接学习从图像到注视点位置的映射关系,并且由于卷积神经网络cnn在学习非常复杂的映射函数方面的优势,其性能显著优于经典方法,因此提出了基于cnn的注视点估计方法,通过脸部图像或眼睛图像,预测出注视点位置,并取得了较好的效果。

4.然而,现有的基于cnn的注视点估计方法,都是估计双眼视线汇聚的注视点坐标,在一些特定应用场景却需要单眼的注视点信息,如:精神疾病诊断、注意力检测等,需要根据两眼各自的视线落点信息,计算两眼的差异性。此外,现有的基于cnn的注视点估计方法只将人脸图像和眼睛图像视为独立或平行特征源输入,模型无法从众多信息中选择出对当前任务目标更关键的信息。

技术实现要素:

5.本发明的目的是提供一种基于混合注意力机制的单眼注视点估计方法及系统,能够准确预测单眼的注视点信息。

6.为实现上述目的,本发明提供了如下方案:

7.第一方面,本发明实施例提供的一种基于混合注意力机制的单眼注视点估计方法,包括:

8.获取目标人脸图像信息;所述目标人脸图像信息包括目标人脸图像、目标单眼图像以及所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息;

9.基于所述目标人脸图像信息和单眼注视点估计模型,确定所述目标人脸图像对应的单眼注视点预测信息;

10.所述单眼注视点估计模型是基于混合注意力机制的卷积神经网络确定的;

11.所述基于混合注意力机制的卷积神经网络包括第一卷积、第二卷积和全连接层;所述全连接层的第一输入端与所述第一卷积的输出端连接;所述全连接层的第二输入端与所述第二卷积的输出端连接;

12.在预测阶段,所述第一卷积的输入端用于输入所述目标单眼图像;所述第二卷积的输入端用于输入所述目标人脸图像;所述全连接层的第三输入端用于输入所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息;所述全连接层的输出端用于输出所述目

标人脸图像对应的单眼注视点预测信息;

13.所述第一卷积的网络结构与所述第二卷积的网络结构相同;所述第一卷积和所述第二卷积均包括多个且依次连接的卷积注意力单元;其中,按照数据流传输方向,所述卷积注意力单元包括依次连接的卷积层、通道注意力子单元和空间注意力子单元。

14.可选地,所述获取目标人脸图像信息,具体包括:

15.对从目标人脸图像中截取的单眼图像进行尺寸调整,得到目标单眼图像;所述目标单眼图像的尺寸与所述目标人脸图像的尺寸相同;

16.基于所述目标单眼图像和所述目标人脸图像,计算所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息。

17.可选地,所述基于所述目标人脸图像信息和单眼注视点估计模型,确定所述目标人脸图像对应的单眼注视点预测信息,具体包括:

18.当所述目标单眼图像为左眼图像时,基于所述目标人脸图像信息和单眼注视点估计模型,确定所述目标人脸图像对应的左眼注视点预测信息;

19.当所述目标单眼图像为右眼图像时,基于所述目标人脸图像信息和单眼注视点估计模型,确定所述目标人脸图像对应的右眼注视点预测信息。

20.可选地,所述单眼注视点估计模型的确定过程为:

21.构建样本数据集;

22.构建基于混合注意力机制的卷积神经网络;

23.基于所述样本数据集以及基于混合注意力机制的卷积神经网络,确定单眼注视点估计模型;

24.所述样本数据集包括多个样本;每一样本包括样本人脸图像、样本单眼图像、所述样本单眼图像在所述样本人脸图像的位置信息、以及所述样本人脸图像对应的单眼注视点标注信息;所述样本单眼图像为对从所述样本人脸图像中截取的单眼图像进行尺寸调整后的图像;所述样本单眼图像的尺寸与所述样本人脸图像的尺寸相同;

25.在训练阶段,所述第一卷积的输入端用于输入所述样本单眼图像;所述第二卷积的输入端用于输入所述样本人脸图像;所述全连接层的第三输入端用于输入所述样本标单眼图像中的眼睛在所述样本人脸图像上的位置信息;所述全连接层的输出端用于输出所述样本人脸图像对应的单眼注视点预测信息;

26.其中,标记样本人脸图像对应的单眼注视点标注信息和所述标记样本人脸图像对应的单眼注视点预测信息用于调节基于混合注意力机制的卷积神经网络的参数;所述标记样本人脸图像为任一所述样本人脸图像。

27.可选地,所述通道注意力子单元包括第一全局最大池化层、第一全局平均池化层、多层共享感知层、加和操作层、第一激活操作层以及第一乘法操作层;其中,所述第一全局最大池化层为基于宽度和高度的全局最大池化层;所述第一全局平均池化层为基于宽度和高度的全局平均池化层;

28.所述第一全局最大池化层用于对所述卷积层输出的特征图进行最大池化操作;

29.所述第一全局平均池化层用于对所述卷积层输出的特征图进行平均池化操作;

30.所述多层共享感知层用于对最大池化操作后的特征图进行处理得到第一特征,以及对平均池化操作后的特征图进行处理得到第二特征;

31.所述加和操作层用于对所述第一特征和所述第二特征进行加和操作,得到综合特征;

32.所述第一激活操作层用于对所述综合特征进行激活操作,得到通道注意特征;

33.所述第一乘法操作层用于对所述通道注意特征和所述卷积层输出的特征图进行乘法操作,得到空间注意力子单元的输入特征。

34.可选地,所述空间注意力子单元包括第二全局最大池化层、第二全局平均池化层、通道拼接层、卷积操作层、第二激活操作层以及第二乘法操作层;其中,所述第二全局最大池化层为基于通道的全局最大池化层;所述第二全局平均池化层为基于通道的全局平均池化层;

35.所述第二全局最大池化层用于对所述通道注意力子单元输出的特征图进行最大池化操作;

36.所述第二全局平均池化层用于对所述通道注意力子单元输出的特征图进行平均池化操作;

37.所述多通道拼接层用于对最大池化操作后的特征图和平均池化操作后的特征图进行通道拼接处理;

38.所述卷积操作层用于对拼接处理后的特征图进行卷积操作,得到第三特征;

39.所述第二激活操作层用于对所述第三特征进行激活操作,得到空间注意特征;

40.所述第二乘法操作层用于对所述空间注意特征和所述通道注意力子单元输出的特征图进行乘法操作,得到空间注意力子单元的输出特征。

41.第二方面,本发明实施例提供了一种基于混合注意力机制的单眼注视点估计系统,包括:

42.数据获取模块,用于获取目标人脸图像信息;所述目标人脸图像信息包括目标人脸图像、目标单眼图像以及所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息;

43.单眼注视点信息预测模块,用于基于所述目标人脸图像信息和单眼注视点估计模型,确定所述目标人脸图像对应的单眼注视点预测信息;

44.所述单眼注视点估计模型是基于混合注意力机制的卷积神经网络确定的;

45.所述基于混合注意力机制的卷积神经网络包括第一卷积、第二卷积和全连接层;所述全连接层的第一输入端与所述第一卷积的输出端连接;所述全连接层的第二输入端与所述第二卷积的输出端连接;

46.在预测阶段,所述第一卷积的输入端用于输入所述目标单眼图像;所述第二卷积的输入端用于输入所述目标人脸图像;所述全连接层的第三输入端用于输入所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息;所述全连接层的输出端用于输出所述目标人脸图像对应的单眼注视点预测信息;

47.所述第一卷积的网络结构与所述第二卷积的网络结构相同;所述第一卷积和所述第二卷积均包括多个且依次连接的卷积注意力单元;其中,按照数据流传输方向,所述卷积注意力单元包括依次连接的卷积层、通道注意力子单元和空间注意力子单元。

48.可选地,所述数据获取模块,具体包括:

49.目标单眼图像确定单元,用于对从目标人脸图像中截取的单眼图像进行尺寸调

整,得到目标单眼图像;所述目标单眼图像的尺寸与所述目标人脸图像的尺寸相同;

50.位置信息确定单元,用于基于所述目标单眼图像和所述目标人脸图像,计算所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息。

51.可选地,所述通道注意力子单元包括第一全局最大池化层、第一全局平均池化层、多层共享感知层、加和操作层、第一激活操作层以及第一乘法操作层;其中,所述第一全局最大池化层为基于宽度和高度的全局最大池化层;所述第一全局平均池化层为基于宽度和高度的全局平均池化层;

52.所述第一全局最大池化层用于对所述卷积层输出的特征图进行最大池化操作;

53.所述第一全局平均池化层用于对所述卷积层输出的特征图进行平均池化操作;

54.所述多层共享感知层用于对最大池化操作后的特征图进行处理得到第一特征,以及对平均池化操作后的特征图进行处理得到第二特征;

55.所述加和操作层用于对所述第一特征和所述第二特征进行加和操作,得到综合特征;

56.所述第一激活操作层用于对所述综合特征进行激活操作,得到通道注意特征;

57.所述第一乘法操作层用于对所述通道注意特征和所述卷积层输出的特征图进行乘法操作,得到空间注意力子单元的输入特征。

58.可选地,所述空间注意力子单元包括第二全局最大池化层、第二全局平均池化层、通道拼接层、卷积操作层、第二激活操作层以及第二乘法操作层;其中,所述第二全局最大池化层为基于通道的全局最大池化层;所述第二全局平均池化层为基于通道的全局平均池化层;

59.所述第二全局最大池化层用于对所述通道注意力子单元输出的特征图进行最大池化操作;

60.所述第二全局平均池化层用于对所述通道注意力子单元输出的特征图进行平均池化操作;

61.所述多通道拼接层用于对最大池化操作后的特征图和平均池化操作后的特征图进行通道拼接处理;

62.所述卷积操作层用于对拼接处理后的特征图进行卷积操作,得到第三特征;

63.所述第二激活操作层用于对所述第三特征进行激活操作,得到空间注意特征;

64.所述第二乘法操作层用于对所述空间注意特征和所述通道注意力子单元输出的特征图进行乘法操作,得到空间注意力子单元的输出特征。

65.根据本发明提供的具体实施例,本发明公开了以下技术效果:

66.1.本发明提供的单眼注视点估计模型是通过目标人脸图像、目标单眼图像以及目标单眼图像在目标人脸图像上的位置信息,估计出目标人脸图像对应的单眼注视点预测信息,以适应需要单眼注视点信息的领域。

67.2.本发明提供的单眼注视点估计模型是基于混合注意力机制的卷积神经网络确定的,通过引入了混合注意力机制,分别在通道和空间的维度上增加模型表现力,关注重要特征并抑制不重要特征,进而提高模型预测准确性。

附图说明

68.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

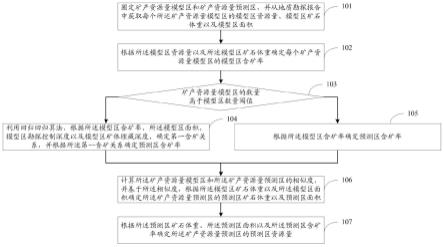

69.图1为本发明一种基于混合注意力机制的单眼注视点估计方法的流程示意图;

70.图2为本发明基于混合注意力机制的卷积神经网络的结构图;

71.图3为本发明通道注意力子单元的结构图;

72.图4为本发明空间注意力子单元的结构图;

73.图5为本发明一种基于混合注意力机制的单眼注视点估计系统的结构示意图。

具体实施方式

74.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

75.为使本发明的上述目的、特征和优点能够更加明显易懂,下面结合附图和具体实施方式对本发明作进一步详细的说明。

76.实施例一

77.如图1所示,本发明实施例提供的一种基于混合注意力机制的单眼注视点估计方法,包括:

78.步骤101:获取目标人脸图像信息;所述目标人脸图像信息包括目标人脸图像、目标单眼图像以及所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息。

79.步骤102:基于所述目标人脸图像信息和单眼注视点估计模型,确定所述目标人脸图像对应的单眼注视点预测信息。

80.所述单眼注视点估计模型是基于混合注意力机制的卷积神经网络确定的;所述基于混合注意力机制的卷积神经网络包括第一卷积、第二卷积和全连接层;所述全连接层的第一输入端与所述第一卷积的输出端连接;所述全连接层的第二输入端与所述第二卷积的输出端连接。所述第一卷积的网络结构与所述第二卷积的网络结构相同;所述第一卷积和所述第二卷积均包括多个且依次连接的卷积注意力单元;其中,按照数据流传输方向,所述卷积注意力单元包括依次连接的卷积层、通道注意力子单元和空间注意力子单元。

81.所述通道注意力子单元包括第一全局最大池化层、第一全局平均池化层、多层共享感知层、加和操作层、第一激活操作层以及第一乘法操作层;其中,所述第一全局最大池化层为基于宽度和高度的全局最大池化层;所述第一全局平均池化层为基于宽度和高度的全局平均池化层。

82.所述第一全局最大池化层用于对所述卷积层输出的特征图进行最大池化操作;所述第一全局平均池化层用于对所述卷积层输出的特征图进行平均池化操作;所述多层共享感知层用于对最大池化操作后的特征图进行处理得到第一特征,以及对平均池化操作后的特征图进行处理得到第二特征;所述加和操作层用于对所述第一特征和所述第二特征进行

加和操作,得到综合特征;所述第一激活操作层用于对所述综合特征进行激活操作,得到通道注意特征;所述第一乘法操作层用于对所述通道注意特征和所述卷积层输出的特征图进行乘法操作,得到空间注意力子单元的输入特征。

83.所述空间注意力子单元包括第二全局最大池化层、第二全局平均池化层、通道拼接层、卷积操作层、第二激活操作层以及第二乘法操作层;其中,所述第二全局最大池化层为基于通道的全局最大池化层;所述第二全局平均池化层为基于通道的全局平均池化层。

84.所述第二全局最大池化层用于对所述通道注意力子单元输出的特征图进行最大池化操作;所述第二全局平均池化层用于对所述通道注意力子单元输出的特征图进行平均池化操作;所述多通道拼接层用于对最大池化操作后的特征图和平均池化操作后的特征图进行通道拼接处理;所述卷积操作层用于对拼接处理后的特征图进行卷积操作,得到第三特征;所述第二激活操作层用于对所述第三特征进行激活操作,得到空间注意特征;所述第二乘法操作层用于对所述空间注意特征和所述通道注意力子单元输出的特征图进行乘法操作,得到空间注意力子单元的输出特征。

85.在预测阶段,所述第一卷积的输入端用于输入所述目标单眼图像;所述第二卷积的输入端用于输入所述目标人脸图像;所述全连接层的第三输入端用于输入所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息;所述全连接层的输出端用于输出所述目标人脸图像对应的单眼注视点预测信息。

86.其中,所述单眼注视点估计模型的确定过程为:

87.步骤a:构建样本数据集。

88.步骤b:构建基于混合注意力机制的卷积神经网络。

89.步骤c:基于所述样本数据集以及基于混合注意力机制的卷积神经网络,确定单眼注视点估计模型。

90.所述样本数据集包括多个样本;每一样本包括样本人脸图像、样本单眼图像、所述样本单眼图像在所述样本人脸图像的位置信息、以及所述样本人脸图像对应的单眼注视点标注信息;所述样本单眼图像为对从所述样本人脸图像中截取的单眼图像进行尺寸调整后的图像;所述样本单眼图像的尺寸与所述样本人脸图像的尺寸相同。

91.在训练阶段,所述第一卷积的输入端用于输入所述样本单眼图像;所述第二卷积的输入端用于输入所述样本人脸图像;所述全连接层的第三输入端用于输入所述样本标单眼图像中的眼睛在所述样本人脸图像上的位置信息;所述全连接层的输出端用于输出所述样本人脸图像对应的单眼注视点预测信息。

92.其中,标记样本人脸图像对应的单眼注视点标注信息和所述标记样本人脸图像对应的单眼注视点预测信息用于调节基于混合注意力机制的卷积神经网络的参数;所述标记样本人脸图像为任一所述样本人脸图像。

93.下面通过一个示例介绍下样本数据集的构建过程。

94.一个示例为:

95.步骤1:使用dlib官方库对gazecapture数据集中的图片进行预处理,裁剪出左右眼图像、人脸图像并得到眼睛图像相对于脸部图像的位置信息,将图像尺寸处理为224*224*3,分别代表图像的长,宽,rgb三通道数,像素值从[0,255]归一化到[0,1]区间内。

[0096]

步骤2:从预处理后的gazecapture数据集的1400多个样本中(共240多万张图片),

按照7:2:1的比例随机划分为训练集、验证集、测试集。训练集用于模型学习图像与注视点之间的映射关系,验证集在训练过程中优化模型,测试集用于评估模型对注视点预测的性能。训练集,验证集与测试集图片均无重合。

[0097]

下面通过一个示例具体介绍下基于混合注意力机制的卷积神经网络。

[0098]

一个示例为:

[0099]

基于混合注意力机制的卷积神经网络的结构如图2所示,纵观设计的卷积神经网络,共有三个输入:从原始图像中截取的左眼图像或者右眼图像、人脸图像(图像大小都为224

×

224)以及眼睛相对于人脸的位置信息(归化为25

×

25的网格图),输出是左眼或者右眼在采集设备屏幕中的注视点坐标。

[0100]

网络结构的第一卷积和第二卷积的参数:(卷积核大小/通道数:conv(卷积层)-e1,conv(卷积层)-f1:11

×

11/96,conv(卷积层)-e2,conv(卷积层)-f2:5

×

5/256,conv(卷积层)-e3,conv(卷积层)-f3:3

×

3/384,conv(卷积层)-e4,conv(卷积层)-f4:1

×

1/64,conv(卷积层)-f5)。全连接层参数:(大小:fc(全连接层)-e1:128,fc(全连接层)-f1:128,fc(全连接层)-f2:64,fc(全连接层)-fg1:256,fc(全连接层)-fg2:128,fc1:128,fc2:2)。

[0101]

在图2所示的基于混合注意力机制的卷积神经网络中,每个卷积层后加入混合注意力模块,从通道维度及空间维度上让模型学习到更有效的特征信息。

[0102]

混合注意力模块共包含两个子单元,通道注意力子单元和空间注意力子单元,两个子单元串联拼接,可接入在任何卷积层后。将图像经过卷积层得到的特征图依次输入到通道注意力子单元和空间注意力子单元,输出得到具有空间信息和加强特征信息的特征图,作为下一个卷积层的输入。

[0103]

通道注意力子单元具体流程如下:

[0104]

将输入的特征图f(h

×w×

c)分别经过基于width(宽度)和height(高度)的globalmaxpooling(全局最大池化)和globalaveragepooling(全局平均池化),得到两个1

×1×

c的特征图,接着,再将它们分别送入一个两层的神经网络(mlp),第一层神经元个数为c/r(r为减少率),激活函数为relu,第二层神经元个数为c,这个两层的神经网络是共享的。而后,将mlp输出的特征进行基于element-wise的加和操作,再经过sigmoid激活操作,生成最终的channelattentionfeature(通道注意特征),即m_c。最后,将m_c和输入特征图f做element-wise乘法操作,生成空间注意力子单元需要的输入特征。其通道注意力子单元的结构如图3所示。

[0105]

空间注意力子单元具体流程如下:

[0106]

将通道注意力子单元输出的特征图f’作为本空间注意力子单元的输入特征图。首先做一个基于channel(通道)的globalmaxpooling(全局最大池化)和globalaveragepooling(全局平均池化),得到两个h

×w×

1的特征图,然后将这2个特征图基于channel(通道)做concat操作(通道拼接)。然后经过一个7

×

7卷积操作,降维为1个channel,即h

×w×

1。再经过sigmoid生成spatial attentionfeature(空间注意特征),即m_s。最后将该feature(特征)和该模块的输入feature(特征)做乘法,得到最终生成的特征。其空间注意力子单元的结构如图4所示。

[0107]

作为一种优选实施方式,本实施例所述的步骤101,具体包括:

[0108]

对从目标人脸图像中截取的单眼图像进行尺寸调整,得到目标单眼图像;所述目

标单眼图像的尺寸与所述目标人脸图像的尺寸相同;基于所述目标单眼图像和所述目标人脸图像,计算所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息。

[0109]

作为一种优选实施方式,本实施例所述的步骤102,具体包括:

[0110]

当所述目标单眼图像为左眼图像时,基于所述目标人脸图像信息和单眼注视点估计模型,确定所述目标人脸图像对应的左眼注视点预测信息。

[0111]

当所述目标单眼图像为右眼图像时,基于所述目标人脸图像信息和单眼注视点估计模型,确定所述目标人脸图像对应的右眼注视点预测信息。

[0112]

下面通过一个实验来说明本实施例提供的技术方案。

[0113]

实验设置:在高性能计算平台上完成实验:系统windows10,cpu amd5800x,gpurtx3080,内存32g。

[0114]

单眼注视点估计

[0115]

基于卷积神经网络设计了单眼注视点估计模型,模型共有三个输入:左眼或右眼图像、人脸图像及眼睛相对于人脸的位置信息,眼部图像和人脸图像经过卷积层、池化层特征提取后与眼部位置信息直接拼接,最后经过全连接层,输出估计的注视点坐标。

[0116]

混合注意力机制对模型估计精确度的提升

[0117]

混合注意力模块共包含两个子单元,通道注意力子单元和空间注意力子单元,连接于卷积层后,分别在通道和空间的维度上筛选重要特征。

[0118]

基于混合注意力机制的单眼注视点估计模型在gazecapture、miipgaze公开数据集上的实验结果如下,误差单位为厘米:

[0119]

表1实验结果表

[0120][0121]

其中,gazecappture:gazecappture数据集;

[0122]

miipgaze:miipgaze数据集;

[0123]

turkergaze:turkergaze模型;

[0124]

noattention:无注意力机制模型;

[0125]

ours:我们设计的模型,即本技术提供的模型。

[0126]

实施例二

[0127]

如图5所示,本实施例提供的一种基于混合注意力机制的单眼注视点估计系统,包括:

[0128]

数据获取模块501,用于获取目标人脸图像信息;所述目标人脸图像信息包括目标人脸图像、目标单眼图像以及所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息。

[0129]

单眼注视点信息预测模块502,用于基于所述目标人脸图像信息和单眼注视点估计模型,确定所述目标人脸图像对应的单眼注视点预测信息。

[0130]

所述单眼注视点估计模型是基于混合注意力机制的卷积神经网络确定的。

[0131]

所述基于混合注意力机制的卷积神经网络包括第一卷积、第二卷积和全连接层;所述全连接层的第一输入端与所述第一卷积的输出端连接;所述全连接层的第二输入端与所述第二卷积的输出端连接。

[0132]

在预测阶段,所述第一卷积的输入端用于输入所述目标单眼图像;所述第二卷积的输入端用于输入所述目标人脸图像;所述全连接层的第三输入端用于输入所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息;所述全连接层的输出端用于输出所述目标人脸图像对应的单眼注视点预测信息。

[0133]

所述第一卷积的网络结构与所述第二卷积的网络结构相同;所述第一卷积和所述第二卷积均包括多个且依次连接的卷积注意力单元;其中,按照数据流传输方向,所述卷积注意力单元包括依次连接的卷积层、通道注意力子单元和空间注意力子单元。

[0134]

其中,所述数据获取模块501,具体包括:

[0135]

目标单眼图像确定单元,用于对从目标人脸图像中截取的单眼图像进行尺寸调整,得到目标单眼图像;所述目标单眼图像的尺寸与所述目标人脸图像的尺寸相同。

[0136]

位置信息确定单元,用于基于所述目标单眼图像和所述目标人脸图像,计算所述目标单眼图像中的眼睛在所述目标人脸图像上的位置信息。

[0137]

所述通道注意力子单元包括第一全局最大池化层、第一全局平均池化层、多层共享感知层、加和操作层、第一激活操作层以及第一乘法操作层;其中,所述第一全局最大池化层为基于宽度和高度的全局最大池化层;所述第一全局平均池化层为基于宽度和高度的全局平均池化层。

[0138]

所述第一全局最大池化层用于对所述卷积层输出的特征图进行最大池化操作;所述第一全局平均池化层用于对所述卷积层输出的特征图进行平均池化操作;所述多层共享感知层用于对最大池化操作后的特征图进行处理得到第一特征,以及对平均池化操作后的特征图进行处理得到第二特征;所述加和操作层用于对所述第一特征和所述第二特征进行加和操作,得到综合特征;所述第一激活操作层用于对所述综合特征进行激活操作,得到通道注意特征;所述第一乘法操作层用于对所述通道注意特征和所述卷积层输出的特征图进行乘法操作,得到空间注意力子单元的输入特征。

[0139]

所述空间注意力子单元包括第二全局最大池化层、第二全局平均池化层、通道拼接层、卷积操作层、第二激活操作层以及第二乘法操作层;其中,所述第二全局最大池化层为基于通道的全局最大池化层;所述第二全局平均池化层为基于通道的全局平均池化层。

[0140]

所述第二全局最大池化层用于对所述通道注意力子单元输出的特征图进行最大池化操作;所述第二全局平均池化层用于对所述通道注意力子单元输出的特征图进行平均池化操作;所述多通道拼接层用于对最大池化操作后的特征图和平均池化操作后的特征图进行通道拼接处理;所述卷积操作层用于对拼接处理后的特征图进行卷积操作,得到第三特征;所述第二激活操作层用于对所述第三特征进行激活操作,得到空间注意特征;所述第二乘法操作层用于对所述空间注意特征和所述通道注意力子单元输出的特征图进行乘法操作,得到空间注意力子单元的输出特征。

[0141]

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的系统

而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

[0142]

本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处。综上所述,本说明书内容不应理解为对本发明的限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。