1.本发明涉及音视频多模态的目标说话人语音增强技术领域,特别涉及一种语音增强方法。

背景技术:

2.目前,视觉信息辅助的目标说话人语音增强技术主要是通过使用目标说话人提供的视觉信息作为一种先验信息,比如说话人的唇部动作信息等,从混合语音中将目标说话人的语音提取出来,进一步地提高语音的质量和可懂度,从而有助于提高下游语音识别等任务的准确率。目前视觉辅助的目标说话人语音增强领域,通过使用唇语阅读网络对说话人唇动图像序列进行处理,从而提取到与目标说话人有关的高维视觉向量,进一步地,通过将视觉向量与音频特征向量做结合得到融合的音视频特征向量,最终对融合后的向量进一步学习得到目标说话人的理想二值掩蔽,实现对目标说话人语音的提取和增强。但是现有技术大多没有考虑到不同时刻目标说话人视觉帧提供的信息量是不同的,比如是正面的无遮挡的面部图像提供的信息和侧面的有遮挡的面部图像提供的信息是不对等的,而只是同等的对待所有时刻视觉帧信息,导致模型没有充分关注并使用目标说话人相对较重要的视觉信息。

技术实现要素:

3.本发明的目的是解决现有技术中存在的上述问题。

4.为实现上述目的,本发明提供了一种语音增强方法,包括:

5.获取目标视频,所述目标视频包括:所述目标视频中所有声音的第一语音信号、目标人物的用作参考的第二语音信号和所述目标人物的图像;

6.基于所述第一语音信号和所述第二语音信号,分别对所述第一语音信号和所述第二语音信号处理以得到第一语音频域信号和第二语音频域信号,并通过计算分别得到所述第一语音频域信号和第二语音频域信号所分别对应的幅度谱以及相位谱;

7.基于所述目标视频,对所述目标人物出现的图像序列帧进行处理以得到包含所述目标人物的待处理图像,并对所述待处理图像进行处理以得到目标图像;

8.将第一语音频域信号的幅度谱输入音频编码器模型中以得到音频特征,将所述目标图像输入到视觉编码器模型中以得到视觉特征;

9.将所述目标图像输入所述视觉编码器模型中学习以得到中间向量值,并将所述中间向量值输入到视觉注意力模块中学习得到所述图像序列帧在时间序列上的加权系数;

10.将所述加权系数应用到所述视觉特征以得到加权视觉特征,通过特征融合模块将所述音频特征与所述加权视觉特征进行融合,得到融合特征向量;

11.将所述融合特征向量输入到预定解码器模型中学习以得到关于所述目标人物的所述第二语音信号的理想幅值掩蔽,并结合所述第一语音频域信号幅度谱得到第二语音频域信号的幅度谱估计值;

12.将第二语音频域信号的幅度值与第二语音频域信号的幅度谱估计值进行误差计算,基于计算结果对所述音频编码器模型、所述视觉编码器模型和所述预定解码器模型的参数进行更新以得到目标语音增强模型;

13.将所述第一语音频域信号的幅度谱通过所述语音增强模型处理后输出所述第二语音频域信号的幅度谱估计值,并结合所述第一语音频域信号的相位值得到第二语音频域信号估计值,经过处理后得到目标人物语音时域信号估计值。

14.本发明的优点在于:通过利用视觉注意力模块对图像序列帧进行建模,获得图像序列帧在不同时刻的加权系数,具体为对不同程度信息的图像序列帧给予不同的加权系数,使得模型可以更加关注信息量大信息重要的图像序列帧,减少对信息量小信息不重要的视觉帧的关注,进而将对应的加权系数应用到视觉编码器模型中提取出来的视觉特征上,提高模型对不同图像序列帧的应对能力,充分挖掘图像序列帧提供的关于目标人物的视觉信息,进一步地提高模型针对不同图像序列帧地鲁棒性和性能。

附图说明

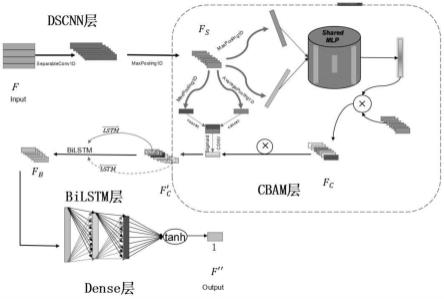

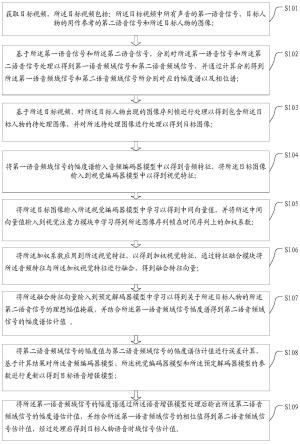

15.图1为本发明实施例图一种语音增强方法的流程图。

具体实施方式

16.下面通过附图和实施例,对本发明实施例的技术方案做进一步的详细描述。

17.图1为本发明实施例本发明实施例图一种语音增强方法的流程图。

18.如图1所示,步骤s101:获取目标视频,目标视频包括:目标视频中所有声音的第一语音信号、目标人物的用作参考的第二语音信号和目标人物的图像。

19.在该步骤中,先获取包含目标人物的视频,该视频中包括第一语音信号、第二语音信号和目标人物的图像。

20.先获取包含目标人物的视频,该视频中包括:含有目标人物语音及噪声的第一语音信号,目标人物的声音信号的第二语音信号,以及目标人物图像。

21.其中,需要说明的是,作为第一语音信号的声音信号,包括了目标视频的所有声音信号,即包括目标人物的声音信号和外部噪声信号,外部噪声即目标人物的声音信号之外的全部声音作为干扰噪音。

22.具体地,第一语音信号是目标人物声音信号和除此外各种噪声信号的总和,是需要进行增强的目标人物的语音信号;第二语音信号是接收到的只包含目标人物声音的信号,可用作参考的语音信号。

23.进一步地,在目标视频中,所有的视频画面在时间线上可以通过一帧一帧的画面进行分隔。即可以将目标视频转换为一帧一帧的图像,而包括目标人物的图像即为需要格外关注的图像,而其它并无目标人物出现的图像可以初步定义为关注度较小的图像。

24.由此可以格外的关注有目标人物出现的图像,防止漏掉目标人物的语音信息,而对于关注度较小的图像,可以有效的降低工作强度,提升工作的效率。

25.s102:基于第一语音信号和第二语音信号,分别对第一语音信号和第二语音信号处理以得到第一语音频域信号和第二语音频域信号,并通过计算分别得到第一语音频域信号和第二语音频域信号所分别对应的幅度谱以及相位谱。

26.在该步骤中,获取的目标视频中的第一语音信号和第二语音信号通过处理转换成可以进行处理的第一语音频域信号和第二语音频域信号,频域信号具有幅度谱和相位谱

27.具体地,单个时刻的频域信号具有幅度值和相位值,随着信号在时间上连续出现,可形成对应的幅度谱和相位谱。。

28.换言之,第一频域信号和第二频域信号均具有幅度谱和相位谱,而单个时刻的信号就具有了对应的幅度值和相位值。

29.其中,对于第一语音信号和第二语音信号的处理以得到第一语音频域信号和第二语音频域信号,通过对第一语音信号进行分帧处理,而对于分帧处理可以取400个采样点作为一帧信号,进而对分帧后的每一帧信号进行加窗处理,窗长可以为512点,继而对分帧和加窗后的每一帧信号进行傅里叶变换,由此可以使第一语音信号转换为第一语音频域信号。

30.相应的,通过对第二语音信号进行分帧处理,而对于分帧处理可以取400个采样点作为一帧信号,进而对分帧后的每一帧信号进行加窗处理,窗长可以为512点,继而对分帧和加窗后的每一帧信号进行傅里叶变换,由此可以使第二语音信号转换为第二语音频域信号。

31.需要注意的是,对于分帧处理的步骤,选取400个采样点作为一帧,若不足400则先补零到400点。

32.s103:基于目标视频,对目标人物出现的图像序列帧进行处理以得到包含目标人物的待处理图像,并对待处理图像进行处理以得到目标图像。

33.在该步骤中,为了提高对于目标人物的语音信号的全面关注,防止漏掉目标人物的语音信号,因此对于目标视频的图像序列帧进行处理,以对图像序列帧中存在目标人物的所有图像帧进行处理得到待处理图像。

34.在本发明的一些实施例中,对于图像序列帧处理得到待处理图像的方式可以为对目标视频进行人脸检测,检测到全部的人物的面部信息,并进行追踪,进而对面部进行对齐,以保证存在目标人物的图像中,目标人物的面部信息全部保留,继而对存在目标人物的图像进行面部的裁剪,即将其他无需关注的人物的面部信息剔除。

35.而对图像的剪裁进一步的可以是对目标人物的面部图像进行剪裁,可以仅保留目标人物的唇部图像,即待处理图像。

36.更近一步地,获取到包括目标人物的唇部图像的待处理图像后,可以进一步对待处理图像进行转换,获得唇部灰度图像即目标图像。

37.由此可以有效的降低目标图像的文件大小,减小存储量,并且图像的文件大小降低,也便于快速的读取和加载。

38.在本发明的一些实施例中,对于目标视频中的人物面部识别检测的方式,使用识别库对目标视频中出现的所有人物进行面部检测和追踪,通过面部对齐并提取检测到的至少部分人物的面部特征点。

39.其中使用的识别库可以为开源的面部识别库mtcnn,而对于人物面部的特征点的检测可以使用开源的面部特征点检测库face-al ignment进行。获取到的人脸的面部特征可以通过为人脸进行标号来区分,即可以通过对人脸进行1-68的标号区分。

40.而如前文所说,对于目标图像是目标人物的唇部图像,因此可以对人物的唇部特

征点采用48-68的特征点来标记。对含有目标人物的面部的待处理图像进行预处理获得待处理图像。

41.将待处理图像处理后得到目标图像,并将所有目标图像转换为压缩文件。

42.具体地,通过rgb转换将待处理图像转换为目标图像,并将转换为目标图像的序列帧存储成python工具下numpy格式的压缩文件,即.npz格式的文件。

43.s104:将第一语音频域信号的幅度谱输入音频编码器模型中以得到音频特征,将目标图像输入到视觉编码器模型中以得到视觉特征。

44.在该步骤中,通过音频编码器模型,可以将第一语音频域信号的幅度谱通过分析,获取到第一语音频域信号的音频特征,同样的,将目标图像输入视觉编码器模型中,可以分析得到视觉特征。

45.其中,此处所得到的音频特征和视觉特征是高维的,而初始阶段,获取到的信息为低层次的。

46.需要说明的是,音频编码器模型与视觉编码器模型均由卷积神经网络组成。

47.音频编码器模型由二维卷积神经网络模型组成,该模型具有7个卷积层,每个卷积层的输出通道数分别为16、32、64、128、128、128、512,卷积核移动步长在频率维度上为2,在时间维度上为1,卷积核大小为3x3,填充为1,每一个卷积层输出使用批归一化处理,然后使用参数化线性修正单元激活函数,激活函数表达式为f(x)=max(0,x) a*min(0,x),其中a为神经网络可学习参数;

48.视觉编码器模型由两部分组成,包括三维卷积层、批归一化层、最大池化层以及残差网络组成的前端和二维时序卷积层组成的后端,其中前端三维卷积层主要用于对输入目标人物的唇部灰度值图像进行处理,卷积核输入通道数为1,输出通道数为64,卷积核大小为(5,7,7),卷积核移动步长为(1,2,2),填充为(2,3,3),使批归一化层对三维卷积输出进行归一化处理,然后使用卷积核大小为(1,3,3),步长为(1,2,2),填充为(0,1,1)的三维最大池化层对批归一化层的输出做池化处理。

49.上述括号内第一个维度是指图像序列的时间维度,后两个维度对应图像的宽和高。使用四层由二维卷积神经网络构成的残差网络对池化结果做进一步处理,提取得到视觉特征的中间向量,其中四层卷积层输出通道数分别为64、128、256、512,卷积核大小为(3,3),卷积核移动步长为(2,2),填充为(1,1)。使用由卷积核大小为(3,3),卷积核移动步长为(1,1),填充为(1,1),输出通道为1024的二维卷积网络对视觉特征中间向量做进一步处理,提取得到视觉特征的高维向量。上述括号对应的是对图像的宽和高维度的操作。

50.s105:将目标图像输入视觉编码器模型中学习以得到中间向量值,并将中间向量值输入到视觉注意力模块中学习得到图像序列帧在时间序列上的加权系数。

51.在该步骤中,视觉编码器模型包括:视觉编码器模型前端和视觉编码器模型后端,而对图像进行学习是通过视觉编码器模型前端通过对目标图像的分析,可以学习到目标图像中的视觉特征,进而获得一个中间向量值,即过渡信息文件,中间向量值在视觉注意力模块中,可以分析得出该目标图像的加权系数,而加权系数即为该图像中,目标人物的语音信号的重要程度。提升对该图像的关注度,从而使该语音增强方法可以有效的针对重要的语音特征进行分析。

52.而如前文所说的获取高维的视觉特征,是通过视觉编码器模型后端实现的。

53.其中,视觉注意力模块由长短时记忆网络和全连接网络组成,长短时记忆神经网络由两层单向长短期记忆网络层串联组成,其隐层节点个数和输出通道数均为1024、1024,的全连接神经网络模型由一层全连接层组成,输出层有1个节点且最后输出的激活函数为s igmoid函数,其表达式为其中,x是一个参数,它可以表示网络层输出值,e是一个自然常数,是一个固定的数字,等于2.718281828459045。通过视觉注意力模块对视觉特征的中间向量进行处理,可以得到各个不同时刻视觉帧的加权系数。

54.s106:将加权系数应用到视觉特征以得到加权视觉特征,通过特征融合模块将音频特征与加权视觉特征进行融合,得到融合特征向量。

55.在该步骤中,将加权系数应用到视觉特征中,可以获得加权后的加权视觉特征,通过融合模块将加权视觉特征与音频特征结合,可以得到一个具有加权系数的融合特征向量。

56.将图像序列帧在每帧所对应的目标图像的视觉特征与加权系数分别通过以下公式计算以得到加权视觉特征,公式为:其中w表示加权注意力系数,f表示不同时刻图像序列帧提取的视觉特征,t表示图像序列帧的每帧所对应的时刻。

57.即可以通过图像序列帧的所指示的时间点,获取该时间点的图像序列帧所显示的目标图像中的视觉特征,进而通过上述公式获得加权视觉特征。

58.对于融合特征向量的获取,通过将音频特征和加权视觉特征的在时间维度上对齐,并将音频特征的特征信息和加权视觉特征的特征信息在特征维度上进行拼接,得到拼接特征向量。将拼接特征向量输入特征融合模块以得到融合特征向量。

59.而将音频特征和加权视觉特征在时间维度上对齐,是通过将加权视觉特征做最近邻上采样插值,使得加权视觉特征的时间维度等于音频特征时间维度。

60.其中,特征融合模块由两层长短时记忆神经网络和一层全连接层组成,长短时记忆神经网络的隐层节点个数分别为1024和512,全连接层神经元个数为2048。

61.s107:将融合特征向量输入到预定解码器模型中学习得到关于目标人物的第二语音信号的理想幅值掩蔽,并结合第一语音频域信号幅度谱得到第二语音频域信号的幅度谱估计值。

62.具体地,对于融合特征向量的学习,可以获得该目标图像所处的图像序列帧中,对于目标人物在第一语音信号中的语音信号比上噪声信号的理想幅值掩蔽估计,本领域技术人员可以了解到,理想幅值掩蔽可以为第一语音信号中区分目标人物语音和噪声的二值掩蔽,由此可以使第一语音信号进行增强,提升语音增强效果。

63.预定解码器模型由转置卷积神经网络组成。预定解码器模型由一个包含七层转置卷积层的卷积神经网络模型组成,每个转置卷积层的输出通道数分别为512、128、128、128、64、32、16,卷积核移动步长在频率维度上均为2,在时间维度上均为1,卷积核大小在频率维度上为4,在时间维度上为3,填充均为1,每一个转置卷积层输出使用批归一化处理,然后使用参数化线性修正单元激活函数。

64.s108:将第二语音频域信号的幅度值与第二语音频域信号的幅度谱估计值进行误差计算,基于计算结果对音频编码器模型、视觉编码器模型和预定解码器模型的参数进行

更新以得到目标语音增强模型。

65.在该步骤中,如前文所说,幅度谱为用作参考的目标人物的第二语音信号的频域信号的幅度谱,幅度谱估计值为第一语音信号频域信号经过模型处理后输出的频域信号的幅度谱,两者之间由于处理的步骤不同,因此存在误差。

66.而对于两者的误差计算,是为了经过处理后有效的减小两者之间的误差。可以理解的是,在初始阶段,两者之间的误差较大,需要通过误差计算不断的更新音频编码器模型、视觉编码器模型和预定解码器模型的参数。

67.具体地,将第一语音频域信号的幅度谱和目标人物的目标图像输入音频编码器模型、视觉编码器模型和预定解码器模型中,得到次级语音增强模型和第二语音频域信号的幅度谱估计值,此处的次级语音增强模型,即为未更新参数后得到的模型,并非最终得到的目标语音增强模型。

68.将第二语音频域信号的幅度值输入次级语音增强模型中以对其训练,并对次级语音增强模型的参数进行更新,通过迭代使第二语音频域信号的幅度谱估计值与第二语音频域信号的幅度值之间的均方误差减小,得到目标语音增强模型。

69.换言之,就是通过数据不断学习优化,优化的明显表示就是误差减少,最后学习得到一个比较好的模型,用它对第一语音信号处理后可以对第二语音信号进行较好的估计,从而提升语音增强的质量和效果。

70.在本发明的一些实施例中,对于误差减小的方法可以采用梯度下降法,使用梯度下降法对模型参数进行更新,通过迭代不断使第二语音频域信号的幅度谱估计值与第二语音频域信号的幅度值之间的均方误差减小。

71.s109:将第一语音频域信号的幅度谱通过语音增强模型处理后输出第二语音频域信号的幅度谱估计值,并结合第一语音频域信号的相位值得到第二语音频域信号估计值,经过处理后得到目标人物语音时域信号估计值。

72.在该步骤中,对于获取到的第二语音频域信号估计值即为经过处理后的实际输出值,通过目标语音增强模型,将第一语音频域信号增强后输出,获得第二语音频域信号估计值。

73.在对第二语音频域信号估计值处理的步骤中,可以使用逆傅里叶变换实现,由此可以获得目标语音信号,即增强后的第二语音信号,也就是目标人物的语音信号。

74.其中,第二语音频域信号的幅度谱估计值经过以下公式计算后得到目标语音信号,公式如下:其中,|x

target

|为第二语音频域信号的幅度谱估计值,p

mix

为第一语音频域信号的相位值。

75.根据本发明实施例的一种语音增强方法,通过利用视觉注意力模块对图像序列帧进行建模,获得图像序列帧在不同时刻的加权系数,具体为对不同程度信息的图像序列帧给予不同的加权系数,使得模型可以更加关注信息量大信息重要的图像序列帧,减少对信息量小信息不重要的视觉帧的关注,进而将对应的加权系数应用到视觉编码器模型提取出来的视觉特征上,提高模型对不同图像序列帧的应对能力,充分挖掘图像序列帧提供的关于目标人物的视觉信息,进一步地提高模型针对不同图像序列帧地鲁棒性和性能。

76.以上所述的具体实施方式,对本发明的目的、技术方案和有益效果进行了进一步

详细说明,所应理解的是,以上所述仅为本发明的具体实施方式而已,并不用于限定本发明的保护范围,凡在本发明的精神和原则之内,所做的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。