一种基于gam跟踪器的社区行人异常行为检测方法和装置

技术领域

1.本发明涉及深度学习及计算机视觉技术领域,尤其涉及一种基于gam跟踪器的社区行人异常行为检测方法和装置。

背景技术:

2.当前社会中常发生偷盗、老人和儿童摔倒等突发的意外情况,如果事发当时周围没有他人目击,对于偷盗的侦察和对摔倒带来的问题的及时解决会有困难,提升了安保人员的工作难度。

3.带有gam的多行人追踪方法是基于检测的多目标跟踪框架,在诸多数据集当中表现出了自己的能力,即使是在密集的人群当中,仍有良好的跟踪效果。带有gam跟踪器的多行人追踪方法的跟踪精度与推理速度都优于其他现存的跟踪框架,且跟踪目标对象的切换次数明显降低。

4.为侦测社区行人的突发情况,并及时地做出警报反馈,提高安保人员的效率,在现有gam的基础上,亟待提供一种新的对社区行人异常行为检测的方法。

技术实现要素:

5.本发明提供一种基于gam跟踪器的社区行人异常行为检测方法和装置,在现有技术中带有gam跟踪器的多行人追踪方法的基础上,增加对行人轨迹进行分析的异常判断逻辑,借助优秀的跟踪效果来实现对行人奔跑异常、跌倒异常与徘徊异常的实时监测。

6.本发明提供的具体技术方案如下:

7.一方面,本发明提供的一种基于gam跟踪器的社区行人异常行为检测方法包括:

8.将待处理的视频图像数据帧输入预先训练好的yolox网络,获取高分辨率特征图,并采用目标检测器进行行人检测;

9.基于yolox网络上增加的用于提取目标差异化特征的平行的输出端及其无锚方法,在gam跟踪器中以所述增加的输出端为输入进行融合分析,用来估算待检测结果和跟踪目标之间匹配度热图,进而进行跟踪目标和检测结果之间的关联匹配;

10.基于目标特征提取结果,根据预设时间段内检测到的目标坐标变化速度,采用正态分布和阈值法,判断待检测目标是否发生奔跑;和/或,

11.基于目标特征提取结果,根据待检测目标的检测结果计算行人高度和宽度的比值,并根据计算的长宽比值判断待检测目标是否发生跌倒;和/或,

12.基于目标特征提取结果,根据待检测目标在视频区域内移动的距离和往复次数与预先设置的徘徊距离阈值之间的关系,采用向量法结合阈值法判断待检测目标是否存在异常徘徊;

13.若待处理的视频图像数据帧中存在待检测目标奔跑、跌倒或异常徘徊中的至少一种,则将所述待处理的视频图像数据帧标记为存在社区行人异常行为数据帧。

14.可选的,所述将待处理的视频图像数据帧输入预先训练好的yolox网络,获取高分

辨率特征图,并采用目标检测器进行行人检测,具体包括:

15.将从yolox网络中输出的差异化特征输入至gam跟踪器,将所述gam跟踪器检测到的目标的图像采集区域扩大至所述图的候选者的宽高度的至少两倍,并根据所述检测到的目标的图像采集区域的中心位置进行定位;

16.将图像采集区域中的图像调整为标准尺寸[hs,ws]后,进行归一化提取;

[0017]

基于稀疏性选择策略确定候选者,并提取与所述图像采集区域中的图像和所述候选者向对应的特征参数,其中,所述候选者宽度和高度分别是所述标准尺寸的1/2;

[0018]

将所述候选者中的至少一个输入至图注意力模型,估计所述目标和候选者之间的相关性;

[0019]

将所有所述候选者的图注意力模型进行融合与合并,通过所述gam跟踪器输出目标检测结果。

[0020]

可选的,基于yolox网络上增加的用于提取目标差异化特征的平行的输出端及其无锚方法,在gam跟踪器中以所述增加的输出端为输入进行融合分析,用来估算待检测结果和跟踪目标之间匹配度热图,进而进行跟踪目标和检测结果之间的关联匹配,具体包括:

[0021]

对所述yolox网络的特征经过3

×

3卷积运算后估算图注意力模型,并通过1

×

1卷积层生成特征图;

[0022]

对所述特征图经过3

×

3卷积运算,估算目标边框尺寸,并通过1

×

1卷积层生成目标类别结果;

[0023]

对所述特征图经过3

×

3卷积运算,获取目标中心偏移,并通过不同的1

×

1卷积层生成标边框尺寸和目标中心偏移量;

[0024]

对所述特征图经过3

×

3卷积运算,估算目标边框尺寸,并通过1

×

1卷积层生成个体差异化特征。

[0025]

可选的,所述对所述yolox网络的特征经过3

×

3卷积运算后估算图注意力模型,并通过1

×

1卷积层生成特征图,具体包括:

[0026]

根据图注意力得分执行非极大值抑制(nms),以提取峰值关键点,保留图注意力得分大于阈值的关键点的坐标;

[0027]

根据所述目标分类、中心偏移量和所述目标边框尺寸生成边界框,以及个体差异化特征,并在估计的目标中心提取身份嵌入。

[0028]

可选的,基于yolox网络上增加的用于提取目标差异化特征的平行的输出端及其无锚方法,在gam跟踪器中以所述增加的输出端为输入进行融合分析,用来估算待检测结果和跟踪目标之间匹配度热图,进而进行跟踪目标和检测结果之间的关联匹配,判断待检测目标是否发生奔跑之前,所述方法还包括:

[0029]

基于所述目标的部位坐标为[h

t

,w

t

]确定所述边框中对应身体重心的坐标为[hd,wd],以及确定候选者中对应身体重心的坐标为[hc,wc],其中,所述目标和所述边框之间对所述身体重心的定位距离始终大于所述目标和所述候选者之间对所述身体重心的定位距离的最小值。

[0030]

可选的,所述基于目标的身体重心坐标为[h

t

,w

t

],确定所述行人边框中对应身体重心的坐标为[hd,wd],以及确定候选者中对应身体重心的坐标为[hc,wc],具体包括:

[0031]

根据所述待处理的视频图像数据帧的第一帧中对所述边框的估计,初始化多个子

轨迹;

[0032]

在所述待处理的视频图像数据帧中第一帧以后的帧中,将检测到的边框与现有的跟踪片段相连接;

[0033]

采用卡尔曼滤波函数预测所述目标在当前帧中的位置;检测到所述目标的坐标与预测位置距离大于预设值,则将相应的成本设置为无穷大。

[0034]

可选的,所述基于目标特征提取结果,根据预设时间段内检测到的目标坐标变化速度,采用正态分布和阈值法,判断待检测目标是否发生奔跑,具体包括:

[0035]

基于所述视频图像数据帧预测目标的位置,最小化所述图像采集区域;

[0036]

针对所述视频图像建立坐标系,记录并保存当前检测到的所有目标的标识和坐标;

[0037]

针对同一目标收集预设数量的坐标信息和速度,对所述速度分布建立高斯分布模型运算,并基于运算结果实时更新所述高斯模型;

[0038]

将所述目标边框内图像进行图像分析以确定目标重心;

[0039]

当所述目标重心偏离量大于预设阈值并保持第一预设时长时,确定所述目标为异常奔跑,则对所述目标边框进行标记。

[0040]

可选的,所述基于目标特征提取结果,根据待检测目标的检测结果计算高度和宽度的比值,并根据计算的长宽比值判断待检测目标是否发生跌倒,具体包括:

[0041]

间隔第一固定的帧数检测目标的边框回归尺寸的宽高信息,计算目标的宽高比值;

[0042]

当第二预设时长内连续检测到宽高比值大于预设宽高阈值时,判定所述目标跌倒异常,则对所述目标边框进行标记。

[0043]

可选的,所述基于目标特征提取结果,根据待检测目标在视频区域内移动的距离和往复次数与预先设置的徘徊距离阈值之间的关系,采用向量法结合阈值法判断待检测目标是否存在异常徘徊,具体包括:

[0044]

记录所述视频图像中的行人的往复运动的次数,间隔第二固定帧数记录所述目标的中心位置作为目标运动轨迹,建立所述目标的运动方向向量;

[0045]

若第t时刻与第t-1时刻的运动方向向量的夹角大于预设值,则确定为一次往复运动;

[0046]

当所述往复次数达到预设阈值时,判定所述目标异常徘徊,则对所述目标边框进行标记。

[0047]

在一方面,本发明还提供一种基于gam跟踪器的社区行人异常行为检测装置包括计算机可读指令,当所述计算机可读指令在计算机上运行时,使得所述计算机执行上述任一项所述的方法。

[0048]

本发明的有益效果如下:

[0049]

本发明提供于一种gam跟踪器的社区行人异常行为检测方法和装置,通过对待处理视频图像的分析处理,采用yolox及其无锚方法检测目标,并将后选择的图注意力模型融合与合并,利用gam跟踪器进行优化,根据候选图注意力图谱的匹配得分确定关键点坐标,使用重心偏移量判断的方法判定目标是否快速奔跑;使用比较边框的长宽比值与变化率的方法判定目标是否跌倒;使用比较移动距离与往复的次数来判定目标是否徘徊。当检测目

标在有奔跑、跌倒和徘徊的情况时,目标的速度、检测框、移动距离,往复运动次数较行人正常运动时有明显的变化,异常行为判断结果稳定,提高了社区中行人异常行为检测的方法,有助于提升突发情况的办事效率。

附图说明

[0050]

为了更清楚地说明本发明实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0051]

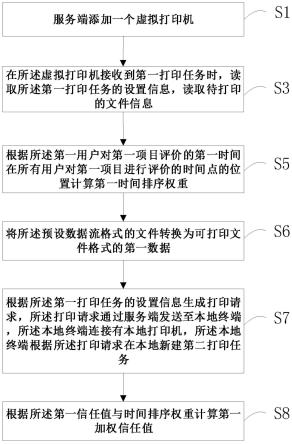

图1为本发明实施例的一种基于gam跟踪器的社区行人异常行为检测方法;

[0052]

图2为本发明实施例的一种将待处理的视频图像数据帧输入预先训练好的yolox网络获取输出结果的流程示意图;

[0053]

图3为本发明实施例的采用的gam跟踪器的工作原理图;

[0054]

图4为本发明实施例中示例性判断待检测目标是否发生奔跑的流程示意图;

[0055]

图5为本发明实施例的示例性判断待检测目标是否发生跌倒的流程示意图;

[0056]

图6为本发明实施例的示例性判断待检测目标是否存在异常徘徊的流程示意图。

具体实施方式

[0057]

为了使本发明的目的、技术方案和优点更加清楚,下面将结合附图对本发明作进一步地详细描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其它实施例,都属于本发明保护的范围。

[0058]

本发明的说明书和权利要求书中的术语“包括”和“具有”以及他们的任何变形,意图在于覆盖不排他的包含,例如,包含了一系列步骤或单元的过程、方法、系统、产品或设备不必限于清楚地列出的那些步骤或单元,而是可包括没有清楚地列出的或对于这些过程、方法、产品或设备固有的其它步骤或单元。

[0059]

下面将结合图1~图6对本发明实施例的一种基于gam跟踪器的社区行人异常行为检测方法和装置进行详细的说明。

[0060]

参考图1所示,本发明实施例提供的基于gam跟踪器的社区行人异常行为检测方法包括:

[0061]

s1:将待处理的视频图像数据帧输入预先训练好的yolox网络,获取高分辨率特征图,并采用目标检测器进行行人检测。

[0062]

本技术实施例中采用的gam跟踪器的工作原理图如图3所示。

[0063]

在获取高分辨率特征图的过程中,采用采用resnet-34(残差神经网络)作为骨干网络,以便在准确性和速度之间取得良好的平衡。通过yolox检测器进行行人检测,为了提高后续计算的效率,只保留了对行人的检测,而对其他类别的预测参数进行了剪裁。

[0064]

具体在,图2示出了一种将待处理的视频图像数据帧输入预先训练好的yolox网络获取输出结果的流程示意图。该步骤具体还包括:

[0065]

s11:将从yolox网络中输出的差异化特征输入至gam跟踪器,将所述gam跟踪器检

测到的目标的图像采集区域扩大至所述图的候选者的宽高度的至少两倍,并根据所述检测到的目标的图像采集区域的中心位置进行定位。

[0066]

s12:将图像采集区域中的图像调整为标准尺寸[hs,ws]后,进行归一化提取。

[0067]

s13:基于稀疏性选择策略确定候选者,并提取与所述图像采集区域中的图像和所述候选者向对应的特征参数,其中,所述候选者宽度和高度分别是所述标准尺寸的1/2。

[0068]

在计算过程中,基于稀疏选择策略,选出几个大小为[hc,wc]=[hs/2,ws/2]的候选者,并从搜索区域上统一提取的特征中抽取相应的特征sc。

[0069]

s14:将所述候选者中的至少一个输入至图注意力模型,估计所述目标和候选者之间的相关性。

[0070]

对于每个有效的第i个跟踪目标,其特征模板结合了当前n帧上检测到的矩形的提取特征si={s

i,1

,s

i,2

,...,s

i,n

}。为了提高计算效率,n被设定为10。为了保持特征大小一致,在特征提取前,检测到的矩形也被调整为[h

t

,w

t

]=[hc,wc]的大小。

[0071]

候选者cj的gam跟踪器被用来估计第t个被跟踪的目标和每个候选者之间的相关性,每个特征通道[hc,wc]的大小相同。图注意力模型的值是由第i个目标和位置上的每个候选cj之间的特征s(h,w,nc)来估计和归一化的:

[0072][0073]

s15:将所有所述候选者的图注意力模型进行融合与合并,通过所述gam跟踪器输出目标检测结果。

[0074]

融合的图注意力模型m

i,j

是基于所有这些候选者的图注意力模型而得到的,计算方法如下:

[0075][0076]

和

[0077][0078]

其中cj∈cj和cj是第j个检测到的行人的候选集,nc∈{1,...,nc}是合并注意力图谱的通道索引,nc是通道数,与提取的特征通道数相同。

[0079]

将合并的图注意力模型m

i,j

作为gam跟踪器的输出图。

[0080]

s2:基于yolox网络上增加的用于提取目标差异化特征的平行的输出端及其无锚方法,在gam跟踪器中以所述增加的输出端为输入进行融合分析,用来估算待检测结果和跟踪目标之间匹配度热图,进而进行跟踪目标和检测结果之间的关联匹配。

[0081]

在此过程中,使用预设的损失函数进行预测的结果和实际真实的结果之间的差异进行求解。具体的,

[0082]

对所述yolox网络的特征经过3

×

3卷积运算后估算图注意力模型,并通过1

×

1卷积层生成特征图。

[0083]

(一)、对所述特征图经过3

×

3卷积运算,估算目标边框尺寸,并通过1

×

1卷积层生成目标类别结果;

[0084]

根据图注意力得分执行非极大值抑制(nms),以提取峰值关键点,保留图注意力得分大于阈值的关键点的坐标,然后,根据所述目标分类、中心偏移量和所述目标边框尺寸生成边界框,以及个体差异化特征,并在估计的目标中心提取身份嵌入。

[0085]

(二)、对所述特征图经过3

×

3卷积运算,获取目标中心偏移,并通过不同的1

×

1卷积层生成目标边框尺寸目标中心偏移量;

[0086]

(三)、对所述特征图经过3

×

3卷积运算,估算目标边框尺寸,并通过1

×

1卷积层生成个体差异化特征。

[0087]

在上述步骤s22和s23中,使用到了l1损失函数,对偏移和大小的损失一同进行了计算。

[0088]

而目标中心偏移量输出的目的是更精确地定位对象。由于输出图的跨度为4,这将引入不可忽略的量化误差。该分支估计每个像素相对于对象中心的连续偏移,以减轻下采样的影响。边框尺寸输出负责估计每个坐标位置上的目标的边界框的高度和宽度。

[0089]

再此之后,基于所述目标的部位坐标为[h

t

,w

t

]确定所述边框中对应身体重心的坐标为[hd,wd],以及确定候选者中对应身体重心的坐标为[hc,wc],其中,所述目标和所述边框之间对所述身体重心的定位距离始终大于所述目标和所述候选者之间对所述身体重心的定位距离的最小值。具体的,

[0090]

假设目标上特定身体重心的位置为[h

t

,w

t

],检测到的矩形上相同的身体重心为[hd,wd]。在选择候选者时,该身体重心在每个候选者上的位置为[hc,wc],其中cj∈cj。目标和检测到的矩形之间该身体重心的定位距离d

ij

始终大于di,cj的最小值,其中一个候选值具有以下关系:

[0091][0092]

具体的,该步骤可以根据如下子步骤执行:

[0093]

根据所述待处理的视频图像数据帧的第一帧中对所述边框的估计,初始化多个子轨迹。

[0094]

在所述待处理的视频图像数据帧中第一帧以后的帧中,将检测到的边框与现有的跟踪片段相连接;

[0095]

采用卡尔曼滤波函数预测所述目标在当前帧中的位置;检测到所述目标的坐标与预测位置距离大于预设值,则将相应的成本设置为无穷大。

[0096]

s3:基于目标特征提取结果,根据预设时间段内检测到的目标坐标变化速度,采用正态分布和阈值法,判断待检测目标是否发生奔跑。

[0097]

如图4示例性示出了判断待检测目标是否发生奔跑的流程示意图,具体的:

[0098]

s31:基于所述视频图像数据帧预测目标的位置,最小化所述图像采集区域。

[0099]

对于每一帧,在目标关联前预测目标的位置,可以最小化搜索区域并提高关联的准确性。本方法利用卡尔曼滤波方法来预测目标位置。首先利用卡尔曼滤波器预测目标当前的位置和速度,并同时用先前收集的信息来更新卡尔曼滤波器的参数。

[0100]

预测步骤通过以下公式进行:

[0101][0102]

其中,包含第i个目标在第t帧上的预测位置和速度,包含第i个目标在第t-1帧上的预测位置和速度,f

t

是状态转换矩阵,u

t

是控制向量,p

t

是预测结果的协方差矩阵,q

t

是预测过程中的噪声协方差矩阵。

[0103]

在当前帧的跟踪过程结束后,更新卡尔曼滤波器的参数来适应实际情况。更新步骤通过以下公式进行:

[0104][0105]

其中,k是卡尔曼增益,z

t

是每个目标的位置,r

t

是观察结果z

t

的不确定性的协方差(即传感器噪声的协方差),p

′

t

、k

′

则是p

t

、k的更新值,并在下一轮预测和更新中被反馈。

[0106]

将卡尔曼滤波预测的目标位置与实际检测到的目标位置进行比较,当二者距离大于设定的阈值k

kal

时认为目标发生了异常奔跑。

[0107]

s32:针对所述视频图像建立坐标系,记录并保存当前检测到的所有目标的标识和坐标。

[0108]

以图像的左上角为坐标原点,以宽所在的方向为x坐标、高所在的方向为y坐标建立直角坐标系。以固定的间隔帧数i不断地记录当前检测到的所有目标及相应中心位置坐标并储存:

[0109]

pos

x

[id][t]=x#(7)

[0110]

posy[id][t]=y#(8)

[0111]

其中下标t在每次存储后自动加1且以上两个公式中的t总是保持同步的,然后再根据以下公式计算目标的速度:

[0112][0113]

其中i为采集坐标位置的间隔帧数,通过该公式利用先前储存的位置信息来计算目标的速度v,并将其储存在v_now[id][t]中同样的下标t在每次储存后自动加1。同时根据公式:

[0114][0115]

计算该目标此时的速度与上一次检测的速度比值k并储存在k[id][t]内每次储存后t自加1。

[0116]

s33:针对同一目标收集预设数量的坐标信息和速度,对所述速度分布建立高斯分布模型运算,并基于运算结果实时更新所述高斯模型。

[0117]

在收集到一定数量的同一目标坐标信息并计算速度后,根据已有的速度信息,对该目标的速度分布建立高斯分布模型:

[0118]

v~n(μ,σ2)#(11)

[0119]

其中μ为平均值、σ2为方差,并在每次计算该目标的速度后对其速度分布高斯模型进行实时更新。

[0120]

s34:将所述目标的边框内图像进行图像分析以确定目标重心。

[0121]

根据目标边框对图像进行裁剪,得到每个目标的单独图像,以裁切图的左上角为原点,向下为y轴正方向、向右为x轴正方向建立坐标系,可以得到每个像素的坐标(x,y),并记录x、y方向的最大值,记作:x

max

与y

max

然后对图片进行cv处理得到目标灰度图,并计算灰度图对应的直方图,根据直方图内数值分布情况筛选出灰度值比较集中的数值范围,并将此范围作为目标的灰度值取值区间d

foreground

(前景),其他数值作为背景d

background

处理,并定义前景mask标识公式:

[0122][0123]

然后对图像灰度图进行逐像素遍历,根据公式:

[0124][0125][0126]

计算出目标重心,其中(x,y)坐标为裁剪后单个图标以左上角原点建立坐标系得到的坐标。

[0127]

s35:当所述目标重心偏离量大于预设阈值并保持第一预设时长时,确定所述目标为异常奔跑,则对所述目标边框进行标记。

[0128]

将人物重心、图像中心、图像宽高根据公式:

[0129][0130]

进行比例计算,当目标重心偏离比例kw大于设定的阈值并保持一定的时间t

thr

时认为目标在在异常奔跑,并对其进行标记。

[0131]

根据预设定的速度比值阈值k

thr

、离散阈值v

thr

与目标的y坐标根据公式:

[0132][0133][0134]

根据目标的y坐标实时计算出对应的自适应阈值,其中posy[id][t]为目标的y坐标,s为预设定的固定参数。若v>vm或k>km则判断目标为奔跑异常,并对其进行标记,在视频中显示出来。

[0135]

s4:基于目标特征提取结果,根据待检测目标的检测结果计算行人高度和宽度的比值,并根据计算的长宽比值判断待检测目标是否发生跌倒。

[0136]

如图5示例性示出了判断待检测目标是否发生跌倒的流程示意图,具体的:

[0137]

s41:间隔第一固定的帧数检测目标的边框回归尺寸的宽高信息,计算目标的宽高比值;

[0138]

s42:当第二预设时长内连续检测到宽高比值大于预设宽高阈值时,判定所述目标跌倒异常,则对所述目标边框进行标记。

[0139]

示例性的,根据检测到目标边框的宽高信息,每间隔固定的帧数i,根据公式:

[0140][0141]

计算目标的宽高比值,当连续多次检测到宽高比值大于设定的宽高阈值并保持一定的时间t

thr

时判定目跌倒异常,并对其进行标记,在视频中显示出来。

[0142]

s5:基于目标特征提取结果,根据待检测目标在视频区域内移动的距离和往复次数与预先设置的徘徊距离阈值之间的关系,采用向量法结合阈值法判断待检测目标是否存在异常徘徊。

[0143]

如图6示例性示出了判断待检测目标是否存在异常徘徊的流程示意图,具体的:

[0144]

s51:间隔第二固定帧数记录所述目标的中心位置作为目标运动轨迹,建立所述目标的运动方向向量。

[0145]

设定目标移动总距离dis_t与目标位移(目标当前位置与初始位置的直线距离)dis_p,初值均为0。每隔固定的间隔帧数i记录每个id所对应目标的中心位置坐标的同时,基于公式(7)(8)储存的坐标位置信息按如下公式:

[0146][0147][0148]

更新在t时刻的移动距离dis_t与位移dis_p的值。

[0149]

对每一个id所对应的目标设定一个往复次数值bf,用来记录该目标在视频中做往复运动的次数。设定bf初始值为0,以公式(7)(8)储存的坐标信息,按如下公式计算时刻t时的斜率:

[0150]

pos

tmp

[id][t]={pos

x

[id][t],posy[id][t]}#(21)

[0151]

每隔固定的间隔帧数i记录每个id所对应的中心位置作为目标步行轨迹。然后以目标的运动轨迹为基础,根据公式:

[0152]

vector[id][t]={pos

tmp

[id][t-1],pos

tmp

[id][t]}#(22)

[0153]

s52:若第t时刻与第t-1时刻的运动方向向量的夹角大于预设值,则确定为一次往复运动。

[0154]

建立目标的运动方向向量,然后对每一个id所对应的目标设定一个往复次数值bf,用来记录该目标在视频中做往复运动的次数。设定bf初始值为0,若第t时刻与第t-1时刻的满足条件:

[0155]

angel(vector[id][t-1],vector[id][t]>angel

th

r#(23)

[0156]

即前后两次运动方向向量的夹角大于设定的阈值angel

thr

则认为目标发生了一次折返,使bf[id]的值加1。,则

[0157]

当dis_t[id]>1.5dis_p[id]或者bf[id]≥3时,则判断目标为徘徊异常,并对其进行标记,在视频中显示出来。

[0158]

s53:当所述往复次数达到预设阈值时,判定所述目标异常徘徊,则对所述目标边框进行标记。

[0159]

s6:若待处理的视频图像数据帧中存在待检测目标奔跑、跌倒或异常徘徊中的至少一种,则将所述待处理的视频图像数据帧标记为存在社区行人异常行为数据帧。

[0160]

本发明提供一种基于gam跟踪器的社区行人异常行为检测方法和装置,通过对待处理视频图像的分析处理,采用yolox及其无锚方法检测目标,并将后选择的图注意力模型融合与合并,利用gam跟踪器进行优化,根据候选图注意力图谱的匹配得分确定关键点坐标,使用重心偏移量判断的方法判定目标是否快速奔跑;使用比较边框的长宽比值与变化率的方法判定目标是否跌倒;使用比较移动距离与往复的次数来判定目标是否徘徊。当检测目标在有奔跑、跌倒和徘徊的情况时,目标的速度、检测框、移动距离,往复运动次数较行人正常运动时有明显的变化,异常行为判断结果稳定,提高了社区中行人异常行为检测的方法,有助于提升突发情况的办事效率。

[0161]

基于相同的发明构思,本发明实施例还提供一种基于gam跟踪器的社区行人异常行为检测装置,其特征在于,包括计算机可读指令,当所述计算机可读指令在计算机上运行时,使得所述计算机执行上述任一项所述的方法。

[0162]

显然,本领域的技术人员可以对本发明实施例进行各种改动和变型而不脱离本发明实施例的精神和范围。这样,倘若本发明实施例的这些修改和变型属于本发明权利要求及其等同技术的范围之内,则本发明也意图包含这些改动和变型在内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。