1.本发明属于自然语言处理领域,更具体的说,是涉及一种文本分类场景下基于对抗训练的数据增强方法。

背景技术:

2.数据增强一般有两种形式,第一是数据扩充,第二是特征增强,无论哪种方式,其本质都是通过借助辅助信息或辅助数据,在原始样本的基础上,产生新的样本,以增加样本的多样性。数据扩充是将新生成的未标记样本或标记样本加入到原始数据集中。特征增强是在原始样本的基础上,放大其数据特征,使得分类模型能够更好的将其识别出来。

3.现有的数据增强方法的研究大多面向于计算视觉(computer vision,简称cv)任务,并已经能够在大规模神经网络模型上起到非常显著的作用,但是在自然语言处理(natural language processing,简称nlp)任务上,却一直被研究者所忽略。一方面,数据增强的关键之处在于标签的保留转换,但是自然语言是离散的,无法像图像数据一样经过简单的操作就能应用于实际任务。另一方面,现有的神经网络模型的规模普遍较大,具有过度参数化的特点,而对于这样的模型来说,如何进行微调也成为了研究者们探索的重点,特别是当某项特定任务中,数据集所包含的标签数据过少时,可能一些细微的变化,就会导致模型的崩溃。

技术实现要素:

4.本发明的目的是为了克服现有技术中的不足,提出一种文本分类场景下基于对抗训练的数据增强方法,通过将对抗训练与回译、随机噪声注入、交叉增强等数据增强技术相组合,得到最高质量、最具多样性的增强样本。

5.本发明的目的是通过以下技术方案实现的。

6.本发明文本分类场景下基于对抗训练的数据增强方法,包括以下过程:

7.第一步:回译

8.假设训练集用参数d={xi,yi}

1...n

表示,其中,xi表示原始样本,yi表示原始样本xi的标签,通过对训练集中的原始样本xi进行回译操作,生成一个样本序列集合,用d

′

={x

′i,y

′i}

1...n

表示,x

′i表示原始样本xi的释义样本,yi表示释义样本x

′i的标签;

9.其中,设回译用公式x

′i=backtrans(xi)表示,参数x

′i是参数xi的释义文本;回译的具体执行流程如下:

10.4)使用机器翻译,将英语表示的原始样本xi翻译成另一种语言;

11.5)将翻译成另一种语言的样本翻译回英语,得到新样本x

′i;

12.6)检查新样本x

′i是否与原始样本xi不同,如果是,那么就使用这个新样本x

′i作为原始样本xi的释义样本;

13.第二步:词嵌入

14.对释义样本x

′i进行词嵌入过程,得到p

θ

(x

′i);

15.第三步:对抗训练

16.对释义样本x

′i进行对抗训练,得到的对抗样本表示为:

[0017][0018]

式中,∈代表扰动参数,||||2表示2-范数,代表任意释义样本x

′i,代表损失;

[0019]

第四步:对比损失

[0020]

原始样本xi经过词嵌入过程,得到p

θ

(xi),对抗样本经过加入扰动的词嵌入过程,得到按以下一致性训练目标的公式计算得到原始样本和对抗样本的对比损失:

[0021][0022]

式中,第一项表示的是交叉熵损失函数,第二项表示的是对抗熵损失函数,参数表示原始样本与对抗样本之间的一致性损失项;

[0023]

第五步:文本分类

[0024]

计算得到的对比损失如果满足预先设定的阈值范围,将生成的对抗样本加入到原始数据集中,一并送到分类模型中进行模拟,得到模拟分类准确率结果;否则,调整阈值范围重复第三步至第五步。

[0025]

与现有技术相比,本发明的技术方案所带来的有益效果是:

[0026]

本发明是对抗训练与回译相结合的数据增强技术,通过先执行回译操作,再将生成的样本送入对抗训练模块,除此之外,为了获取所有样本之间的全局关系,加入动量和记忆库模块。为了更好的评估原始样本与增强样本间的对抗损失,使用一致性正则化和对比正则化的方法。

[0027]

本发明能够对小样本数据集进行数据扩充,提高样本的多样性,使得小样本文本分类场景下,得到更高的准确率。

附图说明

[0028]

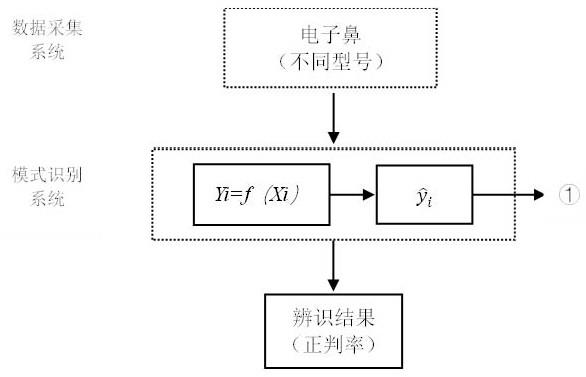

图1是本发明文本分类场景下基于对抗训练的数据增强方法的流程示意图。

具体实施方式

[0029]

下面将结合附图对本发明的具体实施方式做详细说明。

[0030]

如图1所示,本发明文本分类场景下基于对抗训练的数据增强方法,具体实现过程如下:

[0031]

第一步:回译

[0032]

假设训练集可以用参数d={xi,yi}

1...n

表示,其中,xi表示原始样本,yi表示原始样本xi的标签,通过对训练集中的原始样本xi进行回译操作,生成一个样本序列集合,用d

′

=

{x

′i,y

′i}

1...n

表示,x

′i表示原始样本xi的释义样本,yi表示释义样本x

′i的标签。

[0033]

设回译可以用公式x

′i=backtrans(xi)表示,其中,参数x

′i是参数xi的释义文本。回译的具体执行流程如下:

[0034]

7)使用机器翻译,将英语表示的原始样本xi翻译成另一种语言,如德语、法语等;

[0035]

8)将翻译成德语、法语等的样本翻译回英语,得到新样本x

′i;

[0036]

9)检查新样本x

′i是否与原始样本xi不同。如果是,那么就使用这个新样本x

′i作为原始样本xi的释义样本。

[0037]

第二步:词嵌入

[0038]

对释义样本x

′i进行词嵌入过程得到p

θ

(x

′i),即将一个维数为所有词的数量的高维空间嵌入到一个维数低得多的连续向量空间中,每个单词或词组被映射为实数域上的向量。常用的词嵌入方法有word2vec、glove等。

[0039]

第三步:对抗训练

[0040]

常用的两个对抗训练算法,分别是对抗损失和虚拟对抗损失,无论使用以上哪种对抗损失算法,一般情况下,都是以不封闭的形式来获得对抗样本的。于是,本发明拟用目标函数关于x

′i的低阶似然来近似获得对抗样本,用参数表示。因此,对释义样本x

′i进行对抗训练,得到的对抗样本可近似表示为:

[0041][0042]

式中,∈代表扰动参数,||||2表示2-范数,代表任意释义样本xii,代表损失。

[0043]

第四步:对比损失

[0044]

原始样本xi经过词嵌入过程,得到p

θ

(xi)。对抗样本经过加入扰动的词嵌入过程,得到因此,本发明按以下一致性训练目标的公式计算得到原始样本和对抗样本的对比损失:

[0045][0046]

式中,第一项表示的是交叉熵损失函数,第二项表示的是对抗熵损失函数,参数表示原始样本与对抗样本之间的一致性损失项。

[0047]

第五步:文本分类

[0048]

计算得到的对比损失如果满足预先设定的阈值范围,将生成的对抗样本加入到原始数据集中,一并送到分类模型中进行模拟,得到模拟分类准确率结果;否则,调整阈值范围重复第三步至第五步。

[0049]

尽管上面结合附图对本发明的功能及工作过程进行了描述,但本发明并不局限于上述的具体功能和工作过程,上述的具体实施方式仅仅是示意性的,而不是限制性的,本领域的普通技术人员在本发明的启示下,在不脱离本发明宗旨和权利要求所保护的范围情况

下,还可以做出很多形式,这些均属于本发明的保护之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。