1.本技术涉及行人重识别技术领域,特别涉及一种行人重识别网络的模型训练方法及装置、电子设备和可读存储介质。

背景技术:

2.行人重识别是指对摄像头捕捉到的行人图像进行识别,识别行人的id或者识别两个行人图像是否是同一个行人。行人再识别可以实现跨摄像头的行人搜索,在视频监控中具有广泛的应用。目前的神经网络模型中行人再识别的算法准确率较低。

技术实现要素:

3.本技术实施方式提供一种模型训练方法及装置、电子设备和可读存储介质。

4.本技术实施方式提供一种模型训练方法。所述模型应用于行人重识别,所述模型训练方法包括:根据神经网络模型当前训练结果确定多个识别对象的当前权值矩阵;根据所述当前权值矩阵计算多个所述识别对象对应的难度向量;和根据所述难度向量选择下一次训练的多个所述识别对象的下一训练样本。

5.在某些实施方式中,所述神经网络模型通过resnet、mobilenet或shufflenet构建。

6.在某些实施方式中,所述根据所述当前权值矩阵计算多个所述识别对象对应的难度向量包括:根据所述当前权值矩阵的转置矩阵和所述当前权值矩阵计算得到余弦距离矩阵;所述余弦距离矩阵通过下列条件式计算得到:

7.d=w*w

t

8.其中,d为所述余弦距离矩阵,w

t

为所述当前权值矩阵的转置矩阵,w为所述当前权值矩阵。

9.在某些实施方式中,所述根据所述当前权值矩阵计算多个所述识别对象对应的难度向量包括:根据所述余弦距离矩阵按一下条件式计算多个所述识别对象对应的难度向量:

10.ci=max

n≠i

d(i,n);和

11.c={c1,c2,c3,

…

,cn}

12.其中,i表示余弦矩阵d中的行数为第i行,n表示余弦矩阵d中的列数为第n列,c为多个所述识别对象对应的难度向量,ci为第i个识别对象对应的识别难度,n表示识别对象的数量。

13.在某些实施方式中,所述根据所述难度向量选择下一次训练的多个所述识别对象的下一训练样本包括:确定多个所述识别对象对应的难度向量中难度最大的目标识别对象;在训练数据集中选择第一数量的目标识别对象的样本并随机选择第二数量的多个所述识别对象的样本以形成所述下一训练样本。

14.在某些实施方式中,所述根据所述难度向量选择下一次训练的多个所述识别对象

的下一训练样本包括:根据多个所述识别对象对应的难度向量确定每个所述识别对象的识别难度概率;根据所述识别难度概率从训练数据集中选择预定数量的所述下一训练样本。

15.在某些实施方式中,所述根据神经网络模型当前训练结果确定多个识别对象的当前权值矩阵包括:通过所述神经网络模型对当前训练样本进行特征提取以得到所述当前训练样本的特征向量;根据神经网络全连接操作对所述特征向量进行处理,得到多个所述识别对象对应的置信度;将全连接操作的权值矩阵中每个行向量对应每个所述识别对象的特征向量,对每个权值矩阵的所述行向量进行规范化,使得所述权值矩阵每个行向量的二范数为1。

16.在某些实施方式中,所述对每个权值矩阵的所述行向量进行规范化,使得所述权值矩阵每个行向量的二范数为1包括:根据以下条件式对所述权值矩阵的所述行向量进行规范化:

[0017][0018]

其中,w0(i,j)指的是规范化前的所述权值矩阵中第i行j列的元素;s(i)指的是规范化前的所述权值矩阵的均方值;w(i,j)指的是规范化后的所述当前权值矩阵中第i行j列的元素。

[0019]

本技术实施方式提供一种模型训练装置。所述模型训练装置包括:确定模块、计算模块和选择模块。所述确定模块用于根据神经网络模型当前训练结果确定多个识别对象的当前权值矩阵。所述计算模块用于根据所述当前权值矩阵计算多个所述识别对象对应的难度向量。所述选择模块用于根据所述难度向量选择下一次训练的多个所述识别对象的下一训练样本。

[0020]

本技术实施方式还提供一种电子设备。所述电子设备包括处理器和存储器,所述存储器存储有计算机程序,所述计算机程序被所述处理器执行时实现上述任一实施方式所述的模型训练方法。

[0021]

本技术实施方式还提供一种计算机程序的非易失性计算机可读存储介质。当所述计算机程序被一个或多个处理器执行时,实现上述任一实施方式所述的模型训练方法。

[0022]

本技术的模型训练方法及装置、电子设备和可读存储介质通过对行人重识别训练网络中的当前权值矩阵进行规范化,并计算训练样本的难度向量,增大样本加载过程中难样本加载概率,从而提高算法对难样本的区分能力,提升算法准确率。

[0023]

本技术实施方式的附加方面和优点将在下面的描述中部分给出,部分将从下面的描述中变得明显,或通过本技术的实践了解到。

附图说明

[0024]

本技术的上述和/或附加的方面和优点可以从结合下面附图对实施方式的描述中将变得明显和容易理解,其中:

[0025]

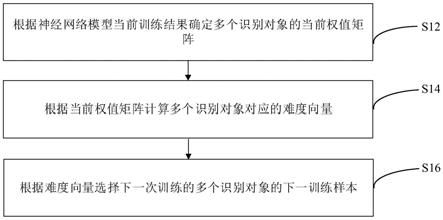

图1是本技术某些实施方式的模型训练方法的流程示意图;

[0026]

图2是本技术某些实施方式的模型训练装置的结构示意图;

[0027]

图3是本技术某些实施方式的训练网络模型的结构示意图;

[0028]

图4是本技术某些实施方式的训练数据集的结构示意图;

[0029]

图5是本技术某些实施方式的电子设备的结构示意图;

[0030]

图6是本技术某些实施方式的计算机可读存储介质的结构示意图;

[0031]

图7是本技术某些实施方式的模型训练方法的结构示意图;

[0032]

图8是本技术某些实施方式的模型训练装置中确定模块的结构示意图;

[0033]

图9是本技术某些实施方式的模型训练方法的流程示意图;

[0034]

图10是本技术某些实施方式的模型训练装置中计算模块的结构示意图;

[0035]

图11是本技术某些实施方式的模型训练方法的流程示意图;

[0036]

图12是本技术某些实施方式的模型训练装置中选择模块的结构示意图;

[0037]

图13是本技术某些实施方式的模型训练方法的流程示意图;

[0038]

图14是本技术某些实施方式的模型训练装置中选择模块的结构示意图。

具体实施方式

[0039]

下面详细描述本技术的实施方式,所述实施方式的示例在附图中示出,其中,相同或类似的标号自始至终表示相同或类似的元件或具有相同或类似功能的元件。下面通过参考附图描述的实施方式是示例性的,仅用于解释本技术的实施方式,而不能理解为对本技术的实施方式的限制。

[0040]

请参阅图1,本技术提供一种模型训练方法。该方法包括:

[0041]

s12:根据神经网络模型当前训练结果确定多个识别对象的当前权值矩阵;

[0042]

s14:根据当前权值矩阵计算多个识别对象对应的难度向量;

[0043]

s16:根据难度向量选择下一次训练的多个识别对象的下一训练样本。

[0044]

请结合图2,本技术还提供一种模型训练装置10。模型训练装置10包括:确定模块12、计算模块14和选择模块16。

[0045]

步骤s12可以由获取模块12实现,步骤s14可以由处理模块14实现,步骤s16可以由确定模块16实现。也即是,确定模块12用于根据神经网络模型当前训练结果确定多个识别对象的当前权值矩阵。计算模块14用于根据当前权值矩阵计算多个识别对象对应的难度向量。选择模块16用于根据难度向量选择下一次训练的多个识别对象的下一训练样本。

[0046]

具体地,神经网络模型即为行人重识别训练网络模型,具体如图3所示,行人重识别训练网络模型包括:样本加载、特征提取、id识别和损失函数计算模块。行人重识别训练网络模型是基于卷积神经网络(convolutional neural networks,cnn)实现的。

[0047]

可以理解地,cnn卷积神经网络具有强大的图像表征能力,被广泛应用于图像识别、目标检测、图像分割等计算机视觉算法中,同样高准确率的行人再识别算法也大部分采用cnn网络。

[0048]

当前训练结果是采用行人再识别数据集作为训练数据集(如图4所示)通过该神经网络模型训练得到的,即,对所有训练数据集而言,传统的神经网络模型训练方法中id识别过程可以提取不同行人(id)的特征,利用神经网络全连接得到识别置信度,并对全连接操作的权值矩阵规范化处理得到本技术的模型训练方法的当前权值矩阵。请参阅图4,训练数据集中包含有多个不同行人的样本数据。为了方便表示,将行人总数记为n,不同的行人使用不同的数字id区分,id取值从1到n。每个行人有若干个样本,不同id的行人样本数可以不一样,例如张三的id是1,采集的训练样本有20幅图片;李四的id是2,采集的训练样本有30

幅图片。训练数据集中不同id的人的样本图片数不一定一样。id为i的行人样本个数记为ki。每个样本数据包含1幅行人图片和对应的id标注。id标注指的是行人对应的真实图片标注的真实id,相当于标注行人样本训练数据的标准答案,即行人(或识别对象)对应的真实id。

[0049]

需要说明的是,下一次样本训练的权值矩阵为前一次得到的当前权值矩阵。

[0050]

样本加载指的是神经网络模型每轮训练过程中,首先要从训练数据集中加载一定数量的训练样本,通常的做法是先将训练数据集打乱,然后顺序读取m个训练样本。顺序读取是指将若干训练样本排成一个队列,从头到尾顺序读取样本。

[0051]

特征提取指的是采用cnn网络进行特征提取,常用的网络包括resnet、mobilenet、shufflenet等,也即是说,神经网络模型可以通过resnet、mobilenet或shufflenet等进行构建。特征提取可以得到训练样本的特征向量。

[0052]

id识别采用全连接操作对特征向量进行处理,得到id分类置信度,即每个样本被识别为各个id的分类得分,某个id对应的得分越高说明样本属于该id的概率越大。具体地,id识别是指用深度学习全连接网络得到该图像被识别为不同id的分数,一般取识别得分最高的id作为识别到的id。

[0053]

损失函数是通过计算识别id和真实id的差异计算得到损失值,如果识别id和真实id相同,计算的损失值就小,反之识别id和真实id不同则损失值大,深度学习的训练过程就是通过最小化损失值实现模型训练。也即是,损失函数具体内容为通过对比id分类和id标注计算训练损失函数,通过最小化训练损失优化模型参数实现模型训练。常用的分类损失函数包括softmax、sphereface、cosface、arcface等。

[0054]

当前权值矩阵可以为矩阵w,矩阵w中的列可以指的是不同行人,矩阵w中的行可以指的是不同行人的特征向量。举例w是一个3*2的矩阵其中第一行可以表示id为1的第一个行人的特征向量,第二行可以表示id为2的第二个行人的特征向量,第三行可以表示id为3的第三个行人的特征向量。

[0055]

根据难度向量选择下一次训练的多个识别对象的下一训练样本,可以理解,每一次训练样本都会发生改变,当前权值矩阵随着训练样本每次训练结果的改变而改变,但每次训练的样本数量不变,例如预先设置的训练样本数量可以为10、15、20、25、30、35、40、45、50幅图等。训练的次数可以是10、20、40、50、100、300、500、600、900、10000次等,训练的次数越多,算法准确率也越高。

[0056]

本技术的模型训练方法通过对行人重识别训练网络中的当前权值矩阵进行规范化,并计算训练样本的难度向量,增大样本加载过程中难样本加载概率,从而提高算法对难样本的区分能力,提升算法准确率。

[0057]

请参阅图5,本技术还提供一种电子设备20。电子设备20包括处理器21和存储器22,存储器22存储有计算机程序23,计算机程序被处理器21执行时实现:根据神经网络模型当前训练结果确定多个识别对象的当前权值矩阵;根据当前权值矩阵计算多个识别对象对应的难度向量;根据所述难度向量选择下一次训练的多个所述识别对象的下一训练样本。电子设备20可以为具有行人画面的设备,例如监控摄像、手机、ipad、平板等其他智能设备,

在此不一一列举。

[0058]

请参阅图6,本技术还提供一种计算机程序的非易失性计算机可读存储介质30,其上存储有计算机程序31。

[0059]

计算机程序31被一个或多个处理器32执行的情况下,实现上述任意一种实施方式的模型训练方法的步骤。

[0060]

例如,程序被处理器32执行的情况下,实现以下仪表识别方法的步骤:

[0061]

s12:根据神经网络模型当前训练结果确定多个识别对象的当前权值矩阵;

[0062]

s14:根据当前权值矩阵计算多个识别对象对应的难度向量;

[0063]

s16:根据所述难度向量选择下一次训练的多个识别对象的下一训练样本。计算机可读存储介质30可设置在处理器32或者数据源读取器内,此时,处理器32或者数据源读取器能够与云端服务器进行通讯来获取到相应的计算机程序31。

[0064]

可以理解,计算机程序31包括计算机程序代码。计算机程序代码可以为源代码形式、对象代码形式、可执行文件或某些中间形式等。计算机可读存储介质可以包括:能够携带计算机程序代码的任何实体或装置、记录介质、u盘、移动硬盘、磁碟、光盘、计算机存储器、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)、以及软件分发介质等。

[0065]

本技术的模型训练方法及装置、电子设备和可读存储介质通过对行人重识别训练网络中的权值矩阵进行规范化,并计算训练样本的难度向量,增大样本加载过程中难样本加载概率,从而提高算法对难样本的区分能力,提升算法准确率。

[0066]

请参阅图7,在某些实施例中,步骤s12包括:

[0067]

s121:通过神经网络模型对当前训练样本进行特征提取以得到当前训练样本的特征向量;

[0068]

s122:根据神经网络全连接操作对特征向量进行处理,得到多个识别对象对应的置信度;

[0069]

s123:将全连接操作的权值矩阵中每个行向量对应每个识别对象的特征向量,对每个权值矩阵的行向量进行规范化,使得权值矩阵每个行向量的二范数为1。

[0070]

请结合图8,确定模块12包括提取单元121、处理单元122和规范单元123。

[0071]

步骤s121可以由提取单元121实现,步骤s122可以由处理单元122实现,步骤s123可以由规范单元123实现。也即是说,提取单元121用于通过卷积神经网络对训练样本进行特征提取以得到训练样本的特征向量。处理单元122用于根据全连接操作对特征向量进行处理,得到多个识别对象对应的置信度。规范单元123用于将全连接操作的权值矩阵中每个行向量对应每个识别对象的特征向量,对每个权值矩阵的行向量进行规范化,使得权值矩阵每个行向量的二范数为1。

[0072]

请结合图5或图6,处理器21或处理器32用于:通过神经网络模型对当前训练样本进行特征提取以得到当前训练样本的特征向量;根据全连接操作对特征向量进行处理,得到多个识别对象对应的置信度;将全连接操作的权值矩阵中每个行向量对应每个识别对象的特征向量,对每个权值矩阵的行向量进行规范化,使得权值矩阵每个行向量的二范数为1。

[0073]

具体地,特征提取得到训练样本的特征向量。卷积神经网络在图像处理过程中,往

往把图像表示为像素的向量,比如一个1000

×

1000像素的图像,可以表示为一个1000000的向量。

[0074]

全连接操作是指深度学习中的全连接层计算,通过全连接计算对特征提取到的特征向量得到不同id对应的置信度得分,得分越高说明该图片是对应id的可能性越大。全连接层(fully connected layers,fc)在整个卷积神经网络中可以起到“分类器”的作用。

[0075]

根据全连接操作对特征向量进行处理,得到多个识别对象对应的置信度,其中,估计值与总体参数在一定允许的误差范围以内,其相应的概率有多大,这个相应的概率称作置信度。全连接层的权值参数矩阵的行数就是训练数据中的id总数,矩阵列数就特征向量的维度。然后,将该权值矩阵进行规范化,使得每个识别对象对应的权值向量的二范数为1。其中,向量的二范数,是指将向量中的每个元素先平方然后求和,最后再开方。规范化是指对矩阵的每个行向量乘上一个常数,使得行向量的二范数等于1。即将权值矩阵的行向量进行规范化后可以得到行向量的二范数为1的当前权值矩阵w,例如当前权值矩阵w可以为

[0076]

更具体地,在某些实施例中,对每个权值矩阵的行向量进行规范化,使得权值矩阵每个行向量的二范数为1包括:

[0077]

根据以下条件式对权值矩阵的行向量进行规范化:

[0078]

其中,w0(i,j)指的是规范化前的权值矩阵中第i行j列的元素;s(i)指的是规范化前的权值矩阵的均方值;w(i,j)指的是规范化后的当前权值矩阵中第i行j列的元素。

[0079]

请结合图8,规范单元123用于:根据以下条件式对权值矩阵的行向量进行规范化:

[0080]

其中,w0(i,j)指的是规范化前的权值矩阵中第i行j列的元素;s(i)指的是规范化前的权值矩阵的均方值;w(i,j)指的是规范化后的当前权值矩阵中第i行j列的元素。

[0081]

请结合图5或图6,处理器21或处理器32用于:根据以下条件式对权值矩阵的行向量进行规范化:

[0082]

其中,w0(i,j)指的是规范化前的权值矩阵中第i行j列的元素;s(i)指的是规范化前的权值矩阵的均方值;w(i,j)指的是规范化后的当前权值矩阵中第i行j列的元素第i行j列的元素。

[0083]

具体地,例如,规范化前的权值矩阵w0为则:w(1,1)=w0(1,1)/s(1)=2/2=1,w(1,2)=w0(1,2)/s(1)=0/2=0;w(2,1)=w0(2,1)/s(2)=0/2=0,w(2,2)w0(2,2)/s(2)=

2/2=0;w(3,1)=w0(3,1)/s(3)=0.4/2=0.2,w(3,2)=w0(3,2)/s(3)=1.96/2=0.98;即,综上得到规范后的权值矩阵w为

[0084]

请参阅图9,在某些实施例中,步骤s14包括:

[0085]

s141:根据当前权值矩阵的转置矩阵和当前权值矩阵计算得到余弦距离矩阵;余弦距离矩阵通过下列条件式计算得到:d=w*w

t

,其中,d为余弦距离矩阵,w

t

为当前权值矩阵的转置矩阵,w为当前权值矩阵。

[0086]

请参阅图10,处理模块14包括第一计算单元141。

[0087]

步骤s141可以由第一计算单元141实现。也即是说,第一计算单元141用于根据当前权值矩阵的转置矩阵和所述当前权值矩阵计算得到余弦距离矩阵;余弦距离矩阵通过下列条件式计算得到:d=w*w

t

,其中,d为余弦距离矩阵,w

t

为当前权值矩阵的转置矩阵,w为当前权值矩阵。

[0088]

请结合图5或图6,处理器21或处理器32用于:根据当前权值矩阵的转置矩阵和所述当前权值矩阵计算得到余弦距离矩阵;余弦距离矩阵通过下列条件式计算得到:d=w*w

t

,其中,d为余弦距离矩阵,w

t

为当前权值矩阵的转置矩阵,w为当前权值矩阵。

[0089]

具体地,例如w是一个2*3的矩阵w

t

是转置矩阵根据上述公式计算如下所示:

[0090]

余弦距离矩阵

[0091]

请再次参阅图9,在某些实施例中,步骤s14包括:

[0092]

s142:根据余弦距离矩阵按以下条件式计算多个识别对象对应的难度向量:

[0093]ci

=max

n≠i

d(i,n);和

[0094]

c={c1,c2,c3,

…

,cn}

[0095]

其中,i表示余弦矩阵d中的行数为第i行或第i列,n表示余弦矩阵d中的列数为第n行或第n列,c为多个所述识别对象对应的难度向量,c

_i

为区分所述识别对象对应的难度,n表示识别对象的数量。

[0096]

请再次参阅图10,处理模块14还包括第二计算单元142。

[0097]

步骤s142可以由第二计算单元142实现。也即是说,第二计算单元142用于根据余弦距离矩阵按以下条件式计算多个识别对象对应的难度向量:ci=max

n≠i

d(i,n);和c={c1,c2,c3,...,cn}。其中,i表示余弦矩阵d中的行数为第i行,n表示余弦矩阵d中的列数为第n列,c为多个识别对象对应的难度向量,ci为区分识别对象对应的难度,n表示识别对象的数量。

[0098]

请结合图5或图6,处理器21或处理器32用于:根据余弦距离矩阵按一下条件式计算多个识别对象对应的难度向量:ci=max

n≠i

d(i,n);和c={c1,c2,c3,...,cn},其中,i表示余弦矩阵d中的行数为第i行,n表示余弦矩阵d中的列数为第n列,c为多个所述识别对象对

应的难度向量,ci为第i个识别对象对应的识别难度,n表示识别对象的数量。

[0099]

具体地,假设则根据ci=max

n≠i

d(i,n),式子中当i表示为第i行时,则n表示为第n列,因此,当i表示第1行时,n不能与i相等,即c1=max

n≠1

d(1,n)=max

n≠1

d(0,0.2)=0.2,c2=max

n≠2

d(2,n)=max

n≠1

d(0,0.98)=0.98,c3=max

n≠3

d(3,n)=max

n≠3

d(0.2,0.98)=0.98,得到:c1=0.2,c2=0.98,c3=0.98,即难度向量c={0.2,0.98,0.98},其中c1=0.2表示区分第1个识别对象的识别难度,c2=0.98表示区分第2个识别对象的识别难度,c3=0.98表示区分第3个识别对象的识别难度。因此,可以得出第2个识别对象和第3个识别对象的识别难度比第1个识别对象的识别难度更高,第2个识别对象和第3个识别对象更容易识别出错。

[0100]

请参阅图11,在某些实施例中,步骤s16包括:

[0101]

s161:确定多个识别对象对应的难度向量中难度最大的目标识别对象;

[0102]

s162:在训练数据集中选择第一数量的目标识别对象的样本并随机选择第二数量的多个识别对象的样本以形成下一训练样本。

[0103]

请结合图12,选择模块16包括:第一确定单元161和第一选择单元162。

[0104]

步骤s161可以由第一确定单元161实现,步骤s162可以由第一选择单元162实现。也即是说,第一确定单元161用于确定多个识别对象对应的难度向量中难度最大的目标识别对象;第一选择单元162用于在训练数据集中选择第一数量的目标识别对象的样本并随机选择第二数量的多个识别对象的样本以形成下一训练样本。

[0105]

请结合图5或图6,处理器21或处理器32用于:确定多个识别对象对应的难度向量中难度最大的目标识别对象;在训练数据集中选择第一数量的目标识别对象的样本并随机选择第二数量的多个识别对象的样本以形成下一训练样本。

[0106]

具体地,例如当有3个识别对象id1、id2和id3,且3个识别对象对应的难度向量c={0.2,0.98,0.92},则根据第一确定单元161可以确定第二个识别对象id2的难度最大,因此,将第二个识别对象确定为目标识别对象,第一选择单元162在第二个识别对象的训练样本中选择第一数量的样本,假设第二个识别对象(id2)对应的样本总数为100幅图,则第一数量例如可以为从100幅图中选择10、15、20、25、30、40、50、60、70、80等幅图,与此同时,第一选择单元162还可以从其余识别对象(id1和id3)的样本例如300幅图中选择第二数量的样本数量,第二数量可以为10、15、20、25、35、40、55、60、75、80等幅图。最后,每次形成的训练样本的数量为第一数量的样本与第二数量的样本的总和,例如,当第一数量的样本为10幅图,第二数量的样本为10幅图,则形成的训练样本总和为20幅图。

[0107]

请参阅图13,在某些实施例中,s16步骤还包括:

[0108]

s163:根据多个识别对象对应的难度向量确定每个识别对象的识别难度概率;

[0109]

s164:根据识别难度概率从训练数据集中选择预定数量的下一训练样本。

[0110]

请结合图14,选择模块16包括第二确定单元163和第二选择单元164。

[0111]

步骤s163可以由第二确定单元163实现,步骤s164可以由第二选择单元164实现。也即是说,第二确定单元163用于根据多个识别对象对应的难度向量确定每个识别对象的识别难度概率;第二选择单元164用于根据识别难度概率从训练数据集中选择预定数量的

下一训练样本。

[0112]

请结合图5或图6,处理器21或处理器32用于:根据多个识别对象对应的难度向量确定每个识别对象的识别难度概率;根据识别难度概率从训练数据集中选择预定数量的下一训练样本。

[0113]

具体地,例如多个识别对象可以为2个或2个以上,以5个识别对象为例,5个识别对象分别为id1、id2、id3、id4和id5,假设5个识别对象形成对应的难度向量d={0.98,0.96,0.9,0.5,0.46},难度总和p=0.98 0.96 0.9 0.5 0.4=3.8,则根据多个识别对象对应的难度向量确定每个识别对象的识别难度概率分别为p={p1,p2,p3,p4,p5},其中,p1=0.98/3.8=0.258,p2=0.96/3.8=0.253,p3=0.9/3.8=0.236,p4=0.5/3.8=0.132,p5=0.46/3.8=0.121。即,p={0.258,0.253,0.236,0.132,0.121}。其中,识别难度概率数值从大到小依次排序为p1>p2>p3>p4>p5,即在第1个识别对象id1中选择预定数量的训练样本的概率最大,其次是在第2个识别对象id2选择预定数量的训练样本的概率较大,依次排序,选择样本的概率最小的是第5个识别对象id5。

[0114]

预定数量可以为100幅图,指的是可以从10000副图(样本总数)中选择100幅图作为训练样本,预定数量为预先设置的训练样本数量,还可以是其他数值,在此不一一赘述。

[0115]

本技术的模型训练方法及装置、电子设备和可读存储介质通过对行人重识别训练网络中的权值矩阵进行规范化,并计算训练样本的难度向量,并根据难度向量选择难度较大的样本与随机的其他样本组合成训练样本进行算法训练,或根据难样本加载概率选择预定数量的训练样本进行算法训练,便于引导模型识别和区分难样本,提高算法对难样本的区分能力,即提高通过图片识别行人id的能力,提升算法准确率。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。