1.本发明涉及数据摘要提取技术领域,特别是涉及一种视频摘要提取方法及系统。

背景技术:

2.语音转文本技术和自动文本摘要技术都经过了长足的发展,有了广泛的应用。语音识别技术从模板匹配识别单个词到隐马科夫模型识别语音片段,再到神经网络端到端的识别语音片段,技术不断进步,已经被应用于语音助手、智能家居、自动驾驶等诸多领域。自动文本摘要从利用关键词从文本中提取出关键句的抽取式摘要,到使用神经网络提取文本特征,根据文本内容生成新的摘要,文本摘要的技术也在不断进步。目前已经被用于信息检索、图书自动标记索引、新闻信息服务等领域。

3.尽管语音转文本技术和文本摘要技术已经比较成熟,但两种技术都只被广泛应用于各自的领域。随着5g技术的发展,网络传输的容量和速度有了新的发展,视频成为网络中的主要多媒体内容。海量视频的涌现,使得如何快速选取合适的视频进行观看成为一个新的需求。

4.现有基于文本的视频摘要技术,主要是使用动态时序匹配算法匹配字幕和剧本,然后通过对剧本的分析,来衡量视频帧的重要性,最后根据得到的重要程度剪辑视频作为摘要。但是这种摘要技术只能用于有字幕和剧本的特殊视频,应用的范围比较局限。

技术实现要素:

5.本发明的目的是提供一种视频摘要提取方法,能够对没有字幕和剧本的视频进行摘要提取,提高了摘要提取的精度。

6.为实现上述目的,本发明提供了如下方案:

7.一种视频摘要提取方法,包括:

8.获取待提取视频;

9.提取所述待提取视频的音频文件,并将所述待提取视频划分为多张待提取视频帧;每张待提取视频帧均对应一个视频帧时间戳;所述视频帧时间戳用于描述对应待提取视频帧在所述待提取视频中的开始时间、结束时间和持续时长;

10.将所述音频文件输入到语音转文本模型中,得到待提取视频的时序文本文件;所述语音转文本模型是利用音频文件训练集,对第一深度神经网络进行训练得到的;所述时序文本文件中每一句文本均对应一个文本时间戳;所述文本时间戳用于描述对应句子在所述待提取视频中的开始时间、结束时间和持续时长;

11.根据所述时序文本文件确定非时序文本文件和文本时间戳-文本映射关系;

12.将所述非时序文本文件输入到文本摘要提取模型中,得到所述待提取视频的文本摘要;所述文本摘要提取模型是利用文本文件训练集,对第二深度神经网络进行训练得到的;

13.根据物体识别模型和多张所述待提取视频帧,确定所述待提取视频的图片摘要;

所述物体识别模型是利用视频帧训练集,对第三深度神经网络进行训练得到的;

14.根据所述文本摘要、所述图片摘要和所述文本时间戳-文本映射关系,确定所述待提取视频的视频摘要。

15.可选的,在所述获取待提取视频之前,还包括:

16.获取音频文件训练集;所述音频文件训练集包括多个历史音频文件及多个历史音频文件对应的历史文本文件;

17.以所述历史音频文件为输入,以历史音频文件对应的历史文本文件为输出,对第一深度神经网络进行训练,得到语音转文本模型。

18.可选的,在所述获取待提取视频之前,还包括:

19.获取文本文件训练集;所述文本文件训练集包括历史文本文件和历史文本文件对应的文本摘要;

20.以所述历史文本文件为输入,以历史文本文件对应的文本摘要为输出,对第二深度神经网络进行训练,得到文本摘要提取模型。

21.可选的,在所述获取待提取视频之前,还包括:

22.获取视频帧训练集;所述视频帧训练集

23.利用矩形标注框对所述视频帧训练集中的物体进行标注,得到多张标注视频帧;

24.以多张所述标注视频帧为输入,以所述矩形标注框为输出,对第三深度神经网络进行训练,得到物体识别模型。

25.可选的,所述根据物体识别模型和多张所述待提取视频帧,确定所述待提取视频的图片摘要,具体包括:

26.将多张所述待提取视频帧输入到物体识别模型,得到多张标注待提取视频帧;

27.确定任一张标注待提取视频帧为当前标注待提取视频帧;

28.根据所述当前标注待提取视频帧包含的物体及种类,利用公式确定当前标注待提取视频帧中每个物体的物体权重;其中,wi为标注待提取视频帧中第i个物体的物体权重;w

cls

为物体的类别权重;其中n为标注待提取视频帧的总量,n

cls

为含有类别为cls的物体的标注待提取视频帧的总量;xi,yi表示矩形标注框中心点的坐标,wi,hi分别为矩形标注框的宽和高,w,h分别为标注待提取视频帧的宽和高;

29.根据标注待提取视频帧中每个物体的物体权重,利用公式w

img

=α

×wi1

β

×wi2

确定当前标注待提取视频帧的图片权重;其中w

img

表示当前标注待提取视频帧的图片权重;w

i1

,w

i2

分别表示当前标注待提取视频帧中权重较大的两个物体的物体权重;α,β均为超参数;

30.根据物体权重对多张所述待提取视频帧进行降序排列,得到待提取视频帧序列;

31.确定所述待提取视频帧序列中首个元素为摘要图片;

32.更新所述待提取视频帧序列并返回步骤“确定所述待提取视频帧序列中首个元素为摘要图片”,直至所述待提取视频帧序列中元素个数为0,得到多张摘要图片作为所述待提取视频的图片摘要。

33.可选的,所述更新所述待提取视频帧序列,具体包括:

34.确定待提取视频帧序列中除首个元素之外的每个元素与所述首个元素的相似度;

35.删除所述待提取视频帧序列中的首个元素,以及相似度大于相似度阈值的元素,得到更新后的待提取视频帧序列。

36.可选的,所述根据所述文本摘要、所述图片摘要和所述文本时间戳-文本映射关系,确定所述待提取视频的视频摘要,具体包括:

37.将所述文本摘要拆分为多个摘要句向量;

38.根据所述文本时间戳-文本映射关系确定多个所述摘要句向量与所述时序文本文件中对应的文本时间戳为文本时间戳集;

39.确定所述图片摘要对应的视频帧时间戳为视频帧时间戳集;

40.根据所述文本时间戳集和所述视频帧时间戳集的交集在所述待提取视频中截取多段初始摘要视频;

41.利用ffmpeg工具将多段所述初始摘要视频进行拼接,得到所述待提取视频的视频摘要。

42.一种视频摘要提取系统,包括:

43.待提取视频获取模块,用于获取待提取视频;

44.音频文件提取模块,用于提取所述待提取视频的音频文件,并将所述待提取视频划分为多张待提取视频帧;每张待提取视频帧均对应一个视频帧时间戳;所述视频帧时间戳用于描述对应待提取视频帧在所述待提取视频中的开始时间、结束时间和持续时长;

45.时序文本文件确定模块,用于将所述音频文件输入到语音转文本模型中,得到待提取视频的时序文本文件;所述语音转文本模型是利用音频文件训练集,对第一深度神经网络进行训练得到的;所述时序文本文件中每一句文本均对应一个文本时间戳;所述文本时间戳用于描述对应句子在所述待提取视频中的开始时间、结束时间和持续时长;

46.文本时间戳-文本映射关系确定模块,用于根据所述时序文本文件确定非时序文本文件和文本时间戳-文本映射关系;

47.文本摘要确定模块,用于将所述非时序文本文件输入到文本摘要提取模型中,得到所述待提取视频的文本摘要;所述文本摘要提取模型是利用文本文件训练集,对第二深度神经网络进行训练得到的;

48.图片摘要确定模块,用于根据物体识别模型和多张所述待提取视频帧,确定所述待提取视频的图片摘要;所述物体识别模型是利用视频帧训练集,对第三深度神经网络进行训练得到的;

49.视频摘要确定模块,用于根据所述文本摘要、所述图片摘要和所述文本时间戳-文本映射关系,确定所述待提取视频的视频摘要。

50.可选的,所述系统还包括:

51.音频文件训练集获取模块,用于获取音频文件训练集;所述音频文件训练集包括多个历史音频文件及多个历史音频文件对应的历史文本文件;

52.语音转文本模型确定模块,用于以所述历史音频文件为输入,以历史音频文件对应的历史文本文件为输出,对第一深度神经网络进行训练,得到语音转文本模型。

53.可选的,所述系统还包括:

54.文本文件训练集获取模块,用于获取文本文件训练集;所述文本文件训练集包括历史文本文件和历史文本文件对应的文本摘要;

55.文本摘要提取模型确定模块,用于以所述历史文本文件为输入,以历史文本文件对应的文本摘要为输出,对第二深度神经网络进行训练,得到文本摘要提取模型。

56.根据本发明提供的具体实施例,本发明公开了以下技术效果:

57.本发明的目的是提供一种视频摘要提取方法,通过构建语音转文本模型将音频文件转化为文本文件,利用文本摘要提取模型提取文本摘要,构建物体识别模型以提取图片摘要,并将文本摘要和图片摘要融合得到待提取视频的视频摘要;能够对没有字幕和剧本的视频进行摘要提取,提高了摘要提取的精度,此外,本发明对文本格式、音频格式和视频格式的数据均能够进行摘要提取,扩展了摘要提取应用范围。

附图说明

58.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

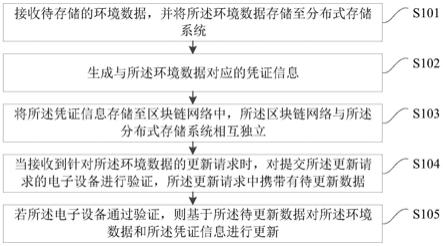

59.图1为本发明实施例中视频摘要提取方法流程图;

60.图2为本发明实施例中视频摘要提取方法第一原理图;

61.图3为本发明实施例中视频摘要提取方法第二原理图。

具体实施方式

62.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

63.本发明的目的是提供一种视频摘要提取方法,能够对没有字幕和剧本的视频进行摘要提取,提高了摘要提取的精度。

64.为使本发明的上述目的、特征和优点能够更加明显易懂,下面结合附图和具体实施方式对本发明作进一步详细的说明。

65.如图1,本发明提供了一种视频摘要提取方法,包括:

66.步骤101:获取待提取视频;

67.步骤102:提取待提取视频的音频文件,并将待提取视频划分为多张待提取视频帧;每张待提取视频帧均对应一个视频帧时间戳;视频帧时间戳用于描述对应待提取视频帧在待提取视频中的开始时间、结束时间和持续时长;

68.步骤103:将音频文件输入到语音转文本模型中,得到待提取视频的时序文本文件;语音转文本模型是利用音频文件训练集,对第一深度神经网络进行训练得到的;时序文本文件中每一句文本均对应一个文本时间戳;文本时间戳用于描述对应句子在待提取视频中的开始时间、结束时间和持续时长;

69.步骤104:根据时序文本文件确定非时序文本文件和文本时间戳-文本映射关系;

70.步骤105:将非时序文本文件输入到文本摘要提取模型中,得到待提取视频的文本摘要;文本摘要提取模型是利用文本文件训练集,对第二深度神经网络进行训练得到的;

71.步骤106:根据物体识别模型和多张待提取视频帧,确定待提取视频的图片摘要;物体识别模型是利用视频帧训练集,对第三深度神经网络进行训练得到的;

72.步骤107:根据文本摘要、图片摘要和文本时间戳-文本映射关系,确定待提取视频的视频摘要。

73.在步骤101之前,还包括:

74.获取音频文件训练集;音频文件训练集包括多个历史音频文件及多个历史音频文件对应的历史文本文件;

75.以历史音频文件为输入,以历史音频文件对应的历史文本文件为输出,对第一深度神经网络进行训练,得到语音转文本模型。

76.在步骤101之前,还包括:

77.获取文本文件训练集;文本文件训练集包括历史文本文件和历史文本文件对应的文本摘要;

78.以历史文本文件为输入,以历史文本文件对应的文本摘要为输出,对第二深度神经网络进行训练,得到文本摘要提取模型。

79.在步骤101之前,还包括:

80.获取视频帧训练集;视频帧训练集

81.利用矩形标注框对视频帧训练集中的物体进行标注,得到多张标注视频帧;

82.以多张标注视频帧为输入,以矩形标注框为输出,对第三深度神经网络进行训练,得到物体识别模型。

83.步骤106,具体包括:

84.将多张待提取视频帧输入到物体识别模型,得到多张标注待提取视频帧;

85.确定任一张标注待提取视频帧为当前标注待提取视频帧;

86.根据当前标注待提取视频帧包含的物体及种类,利用公式确定当前标注待提取视频帧中每个物体的物体权重;其中,wi为标注待提取视频帧中第i个物体的物体权重;w

cls

为物体的类别权重;其中n为标注待提取视频帧的总量,n

cls

为含有类别为cls的物体的标注待提取视频帧的总量;xi,yi表示矩形标注框中心点的坐标,wi,hi分别为矩形标注框的宽和高,w,h分别为标注待提取视频帧的宽和高;

87.根据标注待提取视频帧中每个物体的物体权重,利用公式w

img

=α

×wi1

β

×wi2

确定当前标注待提取视频帧的图片权重;其中w

img

表示当前标注待提取视频帧的图片权重;w

i1

,w

i2

分别表示当前标注待提取视频帧中权重较大的两个物体的物体权重;α,β均为超参数;

88.根据物体权重对多张待提取视频帧进行降序排列,得到待提取视频帧序列;

89.确定待提取视频帧序列中首个元素为摘要图片;

90.更新待提取视频帧序列并返回步骤“确定待提取视频帧序列中首个元素为摘要图

片”,直至待提取视频帧序列中元素个数为0,得到多张摘要图片作为待提取视频的图片摘要。

91.具体的,更新待提取视频帧序列,具体包括:

92.确定待提取视频帧序列中除首个元素之外的每个元素与首个元素的相似度;

93.删除待提取视频帧序列中的首个元素,以及相似度大于相似度阈值的元素,得到更新后的待提取视频帧序列。

94.步骤107,具体包括:

95.将文本摘要拆分为多个摘要句向量;

96.根据文本时间戳-文本映射关系确定多个摘要句向量与时序文本文件中对应的文本时间戳为文本时间戳集;

97.确定图片摘要对应的视频帧时间戳为视频帧时间戳集;

98.根据文本时间戳集和所述视频帧时间戳集的交集在待提取视频中截取多段初始摘要视频;

99.利用ffmpeg工具将多段初始摘要视频进行拼接,得到待提取视频的视频摘要。

100.具体的,如图2-3本发明提供的关键信息摘要提取方法,包括:

101.第一,总体流程:

102.1、输入互联网多通道数据文件名;

103.2、判定互联网多通道数据的具体类型:

104.2.1判断数据类型是否为文本,若是则跳转至6,若不是则跳转至2.2;

105.2.2判断数据类型是否为图片,若是则跳转至7,若不是则跳转至2.3;

106.2.3判断数据类型是否为视频,若是则跳转至3,若不是则结束程序。

107.3、使用音视频分离工具,分离出音频,并截取视频帧。

108.4、判断3的输出结果是否为音频,若是则跳转至5,若不是则跳转至7。

109.5、将音频输入到语音转文本模型中,得到带有时间戳的文本内容,保存时间戳与文本的映射关系后,将时间戳去除,得到纯文本内容。

110.6、将文本输入到自动文本摘要模型,得到文本摘要。

111.7、将图片输入到图片摘要模型,得到图片摘要,并将文本按照主要物体的类别进行分类。

112.8、将得到的文本内容和图片摘要,输入到基于文本摘要和图片摘要的视频摘要模型中,得到视频摘要。

113.其中,文本摘要模型,是使用公开数据集,预训练的抽取式摘要模型。摘要模型可以是传统的基于词频、位置等信息的模型,也可是端到端的深度学习模型。将文本按照{

‘

。’、

‘

!’、

‘

?’}等标志句子结束的标点拆分成句,并采用开源的分词工具,将句子进行分词,去除常用词后构造词典,把词向量化。根据词出现的频率、位置、词性等信息,筛选出k个关键词。将向量化的文本,作为摘要模型的输入;把关键词作为辅助信息,也添加到模型的输入中。摘要模型输出文本摘要。

114.具体的,图片摘要模型是使用公开数据集,训练的目标检测模型:将图片输入到预训练好的模型中,模型给出物体的位置、分类类别。根据物体的类别、物体在图片中的占比,给图片中的每一个物体赋予一个权重,图片的权重为图片上所有或部分物体的权重。选取

权重高且重复率低的图片作为图片摘要。

115.第二,具体实施:

116.1、训练文本摘要模型、目标检测模型和语音识别模型。

117.1.1训练文本摘要模型。首先在通用预训练数据集如common crawl上,预训练自动文本摘要模型。common crawl(通用网页内容数据集)是从2008年以来爬取网页得到的公开数据集,数据集中有40多种语言的语料,可以直接从官网进行数据下载。实施时,将common crawl中的中文语料检索出来,作为预训练的数据集。预训练时以15%的几率替换掉一部分词(被替换的词80%的概率替换成掩码[mask],15%的概率保留原词,15%的概率替换为随机词)。预训练时训练模型预测被替换掉的词。预训练完毕后,把预训练得到的参数权重作为自动文本摘要模型初始参数权重,然后使用中文自动文本摘要数据集进行微调,中文摘要数据集有thucnews(清华中文新闻数据集),nlpcc2017摘要数据集(2017年自然语言处理和中文计算会议摘要任务数据集)等。thucnews数据集,用新浪新闻rss订阅频道2005~2011年间的数据整理筛选生成的,数据有正文和标题,标题可以看成是摘要。nlpcc2017是2017年nlpcc比赛摘要任务的数据集,有正文和摘要。预训练完毕之后进行微调时,把文章作为输入,摘要作为预测目标,一起输入到模型当中,迭代更新预训练得到的模型参数。微调好的模型输入是文章(篇幅比较长的文本),输出的是模型生成的摘要(篇幅较短包含重要信息的文本)。

[0118]

1.2训练目标检测模型。先在较大的数据集如imagenet(图像网数据集,)上预训练模型,使得模型能够较好的提取图片特征。预训练任务是图片分类任务,输入是一张图片,输出是图片的类别。预训练完毕后丢弃输入层和输出层,只保留中间用来提取图片特征的网络层用于后面目标检测模型的训练。imagenet是一个大型图片数据库,有1400多万张带标注的数据,由于版权问题,imagenet提供图片的下载链接和缩略图。由于常用的图片分类数据集每张图片只有一个物体,很难进行有多个物体的图片分类,因此实施时没有直接采用图片分类模型,而是采用目标检测模型,得到图片的主要物体,然后根据主要物体给出图片的类别。预训练好之后,根据目标检测的专用数据集的数据格式搭建新的输入层、输出层,并随机初始化这两个神经网络层的参数。目标检测的专用数据集有coco-2017(common objects in context,常见物体识别数据集2017年版本),openimagedata(开放图像数据集)等,从官网下载专用的数据集后,将这些数据输入到由新的输入层、预训练好的中间层、新的输出层组成的目标检测模型当中,迭代优化参数。训练完毕后,将一张图片输入到模型中,模型会给出图片中每一个物体的位置和每一个物体最可能的类别。

[0119]

1.3训练语音识别模型。在中文语音识别训练集,如thchs-30(清华大学30小时中文语音库),aishell(希尔贝壳公司语音识别数据集)等,训练端到端的语音识别模型。thchs-30是清华大学语音与语言技术中心发布的开源中文语音数据集。语音数据是在在安静的办公室环境下,通过单个碳粒麦克风录取的,总时长超过30个小时,采样频率16khz,采样精度为16比特。aishell是北京希尔贝壳科技有限责任公司发布的一系列语音识别数据集,如今已经发布到aishell-3,aishell-3录音总时长为85小时,录音语句共88035句,录制频率为44.1khz,录制精度为16比特。把语音数据和文本数据,输入到端到端语音识别模型中,进行训练,得到训练好的语音识别模型。训练完毕后,输入一段音频到模型中,模型会给出带有时间戳的文本内容。

[0120]

2、用户输入多媒体内容文件名到整体控制模块,整体控制模块判断输入多媒体内容的类型。可以根据用户输入的文件后缀名判定数据类型。若用户输入的文件名,不是文字、图片、视频,则输出错误信息,并终止运行。若输入的是文本文件,则跳转5,若输入的图片文件则跳转6。若输入的是视频文件,则跳转到3继续执行。

[0121]

3、使用音视频分离开源工具将视频文件中的音频分离出来,保存为单独的音频文件;并且使用开源视频剪切工具将视频按照设定好的时间间隔(5-10ms)截取视频帧,保存为图片,图片名为截取的时间戳。执行完毕后跳转到4继续执行。

[0122]

4、将3得到的音频文件输入预训练好的语音识别模型中,得到语音数据对应的文本数据。每一句文本有一个时间戳(开始时间,结束时间,持续时间)。使用hashset保存文本和时间戳的对应关系,然后去掉时间戳,得到纯文本内容。

[0123]

5、使用开源分词工具将纯文本内容分词,分词就是把完整的句子按照词为单位进行拆分。使用分词的结果构建词典,给每一个不同的词赋予一个唯一的序号(序号从1开始),用序号表示词。然后把分词后的句子向量化,向量化就是用词的序号代替词表示句子,由于句子长度不一致,因此设置一个最大句子长度,长度小于最大长度的句子,用0填充。向量化后的文本作为训练好的文本摘要模型的输入。自动文本摘要模型根据输入的内容,给出一个最可能的文本序列作为文本摘要,摘要的长度可以人为设定。文本摘要模型采用的是抽取式文本摘要,使用原文中的句子组成摘要,方便后面摘要文档与视频的对齐。

[0124]

6、将图片输入到训练好的目标检测模型中,模型给出图片中物体的位置(xi,yi,wi,hi)和物体在所有物体类别上的概率分布,最大的概率ci。其中xi,yi表示框住当前物体的矩形中心点的坐标,wi,hi表示该框的宽和高。

[0125]

6.1根据物体的类别,将图片进行分类.将每张图片输入到步骤1.2训练好的目标检测模型当中,模型会给出图片上每一个物体的位置和每一个物体的类别,然后根据每个物体的wi和hi计算面积。用面积最大的物体的类别ci作为图片类别。

[0126]

6.2选取权重较高的图片作为图片摘要。图片权重的计算如下:

[0127]

(a)给不同类别的物体赋予不同的权重w

cls

,比如类别person的权重设置为0.8,类别car的权重设置为0.5等。每个类别权重的根据频率赋予,其中n为所有图片的数目,n

cls

为含有类别为cls的物体的图片数目。

[0128]

(b)计算图片中每个物体的权重wi。图片中每个物体的重要性由图片的类别和图片的面积和位置决定,每个物体的重要性其中xi,yi,wi,hi的定义与前面一致。w,h为图片的宽和高,w

cls

由上一步得到。

[0129]

(c)计算图片的权重并进行排序。根据物体的重要性wi,对图片中的所有物体进行排序,选取前2个的权重和作为图片的权重w

img

,w

img

=α

×wi1

β

×wi2

,其中w

i1

,w

i2

分别为当前图片img中权重最大的两个物体。α,β为超参数,可以根据具体的输入数据选取不同的取值,然后选择效果最好的一个组合;或者按照两个物体的权重加权,如:然后选择效果最好的一个组合;或者按照两个物体的权重加权,如:得到图片权重后,根据w

img

对图片进行降序排序.

[0130]

(d)获取图片摘要。开始时,图片摘要列表为空,对已经按照权重降序排列的图片,先把排名第一的图片加入到摘要中,然后拿出排名第一的图片,和后面的每一张图片都计算相似度,如果得到的相似度大于阈值,说明当前图片和第一张图片相似度较高并且权重低于第一张图片,由于第一张图片已经加到摘要中了,所以将当前图片从列表中删除。然后将第一张图片从排好序的图片列表中删除,对列表中剩下的图片,重复之前的操作,直到列表中没有图片,然后返回图片摘要列表即可。

[0131]

计算任意两张图片的相似度方法。

[0132]

图片相似度的计算使用ssimi(结构相似性度量),从亮度、对比度和结构三个方面计算图片的相似程度。根据ssim相似度,按照(d)的方法,得到图片摘要。ssim算法计算图片相似的步骤如下:

[0133]

将待计算相似度的两张图片大小修改为相同的大小(人为指定),并且转换为灰度图。

[0134]

使用滑动窗口的方式计算每一个窗口内的ssim值(窗口大小人为指定),使用标准差为1.5的高斯加权函数给图片上的每一个窗口加权。

[0135]

对于任意两张输入图片x和y,落在当前窗口内的图片部分记为x和y,则x和y之间的ssim的计算公式如下:

[0136]

亮度相似度:其中c1为常数,防止分母为0,为x的平均灰度值,xi为x的第i个像素的灰度值,n

p

为x总的像素数目。表示y的平均灰度值,yi为y的第i个像素的灰度值,nq为y的总像素数目。

[0137]

对比度相似度:其中c2为常数,为x的灰度标准差,为y的灰度标准差。

[0138]

结构相似度:其中c3为常数。

[0139]

ssim:

[0140]

使用所有窗口ssim的加权平均值作为两张图片的相似度。若一共有k个滑动窗口,则图片x和图片y的相似度:其中k表示在第k个窗口计算ssim值,xk,yk分别表示图片x和图片y落在第k个窗口的部分。wk表示第k个窗口的权重,通过一个标准差为1.5的高斯函数得到。

[0141]

7.根据文本摘要和图片摘要生成视频摘要。

[0142]

7.1在视频转音频得到的纯文本上使用聚类方法,得到c个类别。聚类使用k-means聚类方法,用句子中的词构造句子的向量表示,两个句子之间的距离为对应向量的余弦相

似度,根据每一个句子与最近的聚类中心的距离,决定句子属于哪一个类别。初始时,聚类中心为随机指定的c个句子向量,通过不断迭代,用同一类中所有向量的平均值作为新的聚类中心,迭代指定轮数或者类别之间的最小距离大于指定的阈值后,停止迭代。

[0143]

7.2若视频有简要的文字介绍,则把7.1中得到每一个类别,分别与文字介绍计算相似度,保留相似度最高的g

top

个类别;若没有文字介绍,保留包含文本最多的c

top

个类别。计算文字介绍和c

top

类别中每一个类别文本的相似度采用jaccard相似度。jaccard相似度使用两个集合之间的交集和并集来表示两个集合的相似度。其中a表示文字介绍的分词结果,bi表示第i个类别的文本包含的词。

[0144]

7.3把文本摘要得到的摘要内容拆分成句,用每一句与c

top

个类别分别计算余弦相似度。对于当前的摘要句子,将其向量化之后,与c

top

个类别中每一个句子的向量化结果计算余弦相似度,向量化方法与步骤5中的向量化一致。若其与c

top

中的某个类别中的某一句的余弦相似度大于阈值(人为设定),则说明摘要句子包含有该类别的信息,保留该句子。若当前句子与c

top

个类别的余弦相似度均小于阈值,则丢弃该句子。

[0145]

7.4根据文本与时间戳的映射关系,获取每一个文本摘要句在视频中的时间戳。在步骤4通过语音识别模型得到的结果中,每一句文本都有一个时间戳(开始时间,结束时间,持续时间),用hashset的方式存储文本与其相应时间戳的映射关系,每一句文本都映射到自己的时间戳,因此,可以通过文本句找到时间戳;此外,用另一个hashset存储开始时间与文本的对应关系,每一句文本的开始时间映射到文本自身。

[0146]

7.5对于每一个文本摘要句的时间戳,检查其对应的视频帧是否在由视频帧得到的图片摘要中,若是,则保留当前时间戳。步骤3中由视频帧得到的图片,图片名为时间戳,根据7.4得到的时间戳,查找图片摘要中是否有对应时间戳命名的图片,若有,则保留当前摘要句对应的时间戳;若没有,则丢弃。

[0147]

7.6对于7.5保留的时间戳,查找其开始时间与文本映射的hashset可以获取对应的文本句子。然后根据步骤3中得到的纯文本内容,找到往前数的n个文本句和往后数的n个文本句。对于这2n个文本句,若和c

top

个类别的余弦相似度大于阈值或者对应的视频帧在图片摘要中,则保留文本句对应的时间戳(开始时间,结束时间,持续时间)。

[0148]

7.7根据7.6得到的时间戳,使用ffmpeg工具,从开始时间截取长度为持续时间的视频片段,最后拼接为视频摘要。具体的过程如下:

[0149]

(a)在命令行中输入命令ffmpeg-ss{start_time}-i{inputvideo}-t{duration}-c:vcopy-c:a copy{output_video},其中start_time表示截取的视频片段的开始时间,这里是文本句对应时间戳的开始时间。input_video是输入视频,这里是用户输入到整体控制模块的文件名。duration表示截取的片段时长,可以是文本句对应的持续时间或者是人为指定一个时间。output_video表示当前视频片段保存的文件名。

[0150]

(b)然后新建一个patch.txt文件,保存每一个片段的文件名。patch.txt文件中的每一行为:file video_patch_path。其中video_patch_path为每一个片段的存储路径加文件名。

[0151]

(c)最后在命令行中输入命令ffmpeg-f concat-i patch.txt-c copy{video_sum}。其中video_sum为视频摘要的文件名,表示视频摘要的存储位置和名字。

[0152]

此外,本发明还提供了一种视频摘要提取系统,包括:

[0153]

待提取视频获取模块,用于获取待提取视频;

[0154]

音频文件提取模块,用于提取待提取视频的音频文件,并将待提取视频划分为多张待提取视频帧;每张待提取视频帧均对应一个视频帧时间戳;视频帧时间戳用于描述对应待提取视频帧在待提取视频中的开始时间、结束时间和持续时长;

[0155]

时序文本文件确定模块,用于将音频文件输入到语音转文本模型中,得到待提取视频的时序文本文件;语音转文本模型是利用音频文件训练集,对第一深度神经网络进行训练得到的;时序文本文件中每一句文本均对应一个文本时间戳;文本时间戳用于描述对应句子在待提取视频中的开始时间、结束时间和持续时长;

[0156]

文本时间戳-文本映射关系确定模块,用于根据时序文本文件确定非时序文本文件和文本时间戳-文本映射关系;

[0157]

文本摘要确定模块,用于将非时序文本文件输入到文本摘要提取模型中,得到待提取视频的文本摘要;文本摘要提取模型是利用文本文件训练集,对第二深度神经网络进行训练得到的;

[0158]

图片摘要确定模块,用于根据物体识别模型和多张待提取视频帧,确定待提取视频的图片摘要;物体识别模型是利用视频帧训练集,对第三深度神经网络进行训练得到的;

[0159]

视频摘要确定模块,用于根据文本摘要、图片摘要和文本时间戳-文本映射关系,确定待提取视频的视频摘要。

[0160]

音频文件训练集获取模块,用于获取音频文件训练集;音频文件训练集包括多个历史音频文件及多个历史音频文件对应的历史文本文件;

[0161]

语音转文本模型确定模块,用于以历史音频文件为输入,以历史音频文件对应的历史文本文件为输出,对第一深度神经网络进行训练,得到语音转文本模型。

[0162]

文本文件训练集获取模块,用于获取文本文件训练集;文本文件训练集包括历史文本文件和历史文本文件对应的文本摘要;

[0163]

文本摘要提取模型确定模块,用于以历史文本文件为输入,以历史文本文件对应的文本摘要为输出,对第二深度神经网络进行训练,得到文本摘要提取模型。

[0164]

对应的,本发明提供的互联网多通道数据关键信息摘要系统,其包括:一个整体控制模块,判断输入的多通道数据的数据类型,确定每一个模块的输入和输入。一个音视频转换模块,用于分离音频和视频,截取视频帧。一个语音识别模块,将音频转为文字。一个文本摘要模块,自动生成长文本的摘要。一个图片摘要模块,自动生成图片摘要。一个视频摘要模块,自动生成视频摘要。

[0165]

综上所述,本发明提供的互联网多通道数据关键信息摘要技术和系统,根据用户输入的文件名,判断输入的文件类型,根据文件类型进行文本、图片、视频摘要,能够实现互联网多通道数据的关键信息摘要。其中,文本摘要通过抽取式文本摘要模型实现,图片摘要通过目标检测模型实现,视频摘要通过分离音频、截取视频帧,结合文本摘要和图片摘要实现。

[0166]

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的系统而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说

明即可。

[0167]

本文中应用了具体个例对本发明的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本发明的方法及其核心思想;同时,对于本领域的一般技术人员,依据本发明的思想,在具体实施方式及应用范围上均会有改变之处。综上所述,本说明书内容不应理解为对本发明的限制。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。