用于更新人工神经网络的方法

1.相关申请的交叉引用

2.本技术要求于2020年11月24日提交的法国专利申请no.2012081的优先权,该申请在此通过整体引用并入本文中。

技术领域

3.本公开总体上涉及人工神经网络,并且在特定的实施例,涉及更新人工神经网络的层中的权重。

背景技术:

4.人工神经网络在其运行时用于执行给定的功能。例如,神经网络的一个功能可以是分类。另一个功能可以主要在于根据接收的输入信号生成信号。

5.人工神经网络通常包括神经元层的连续。每个层在其输入处接收被施加权重的数据,并且在由层的神经元激活功能处理后输出数据。输出数据继而被传递到神经网络中的下一层。

6.权重是能够被配置为获得正确输出数据的参数。

7.神经网络可以例如由硬件平台(诸如被集成到互联对象的微控制器)实现。

8.神经网络通常在在被集成到最终硬件平台之前的学习阶段期间被训练。学习阶段可以被监督。学习阶段允许神经网络的权重被调整以从神经网络获得正确的输出数据,其中神经网络可以通过输入来自参考数据库的已经分类的数据运行。权重适于根据来自相对于预期数据的神经网络的输出数据而变化。

9.此外,在被集成到硬件平台之前,神经网络可以被量化以加速其运行以及减少存储器需求。特别地,神经网络的量化可以包括神经网络数据格式(诸如权重)的改变,可以是浮点格式的权重被改变为整数格式。

10.量化神经网络获得较轻的神经网络,诸如可以由大量硬件平台执行的(例如,由微控制器运行)神经网络。

11.此外,在一些实施例中,在神经网络已经被嵌入最后的硬件平台中之后,更新层的权重可以是有利的。

12.更具体地,例如神经网络可以使用如下数据进行训练,该数据不是代表其中神经网络在已经被嵌入在硬件平台之后被实现的环境。

13.因此,在学习阶段执行的权重的适配对于实现神经网络的环境可以是非优选的。更新神经网络的权重因此允许神经网络被适配于其使用的环境。

14.权重可以由梯度反向传播方法更新,该方法对本领域技术人员是众所周知的。该方法使用浮点权重格式。特别地,神经网络的以整数表示的权重被转换以获得浮点权重格式。使用浮点权重执行梯度反向传播可能要求大量的存储器资源。

15.当最终硬件平台不具有充足的资源以执行该更新时,神经网络的权重因此可以使用远程服务器更新。经更新的神经网络继而被量化以获得整数权重格式。经更新的经量化

的神经网络继而经由互联网使用无线传输被传送到最终硬件平台。

16.因此,所需的存储器资源不总是允许最终硬件平台来更新自身。此外,将经更新的经量化的神经网络传送到硬件平台被消耗的功率相比硬件平台是高的。然而,硬件平台通常具有受限功率量。

17.此外,将权重转换到浮点格式以执行梯度反向传播是存储器密集的。因此,具有用于允许神经网络由最终硬件平台直接更新的方法是有利的。

技术实现要素:

18.根据一方面,本公开提出一种用于更新人工神经网络的方法,该人工神经网络包括至少以整形格式存储在存储器中的初始权重,该方法包括:处理单元确定在神经网络的层的输出处的误差梯度;处理单元从存储器取回初始权重;处理单元更新初始权重,包括:对于每个初始权重,以该初始权重的整数格式,根据下述公式对经校正的权重进行第一计算:其中是经校正的权重的值,是初始权重的值,λ是学习速率,scale(n)是权重的量化步长,是相对于权重的误差梯度的和,以及round()函数是到最接近的整数的向上舍入或向下舍入;处理单元利用经校正的权重的值代替存储在存储器中的初始权重的值。

19.因此,每个权重通过如下操作而被更新:向该权重增加由学习速率λ与用于表示初始权重的量化步长之间的比率乘以相对于权重的误差梯度的和的舍入结果。计算被执行以更新权重直接给出以整数格式的权重。这样的更新方法因此避免涉及浮点权重格式的需要。结果,被需求以执行更新的存储器资源被最小化。

20.用于更新权重的方法因此可以通过使用神经网络的最终硬件平台被直接实现。例如,这种用于更新权重的方法可以由微控制器直接实现。因此,在远程服务器更新权重可以被避免。用于更新权重的方法因此使限制功耗成为可能,特别是当由最终硬件平台实现时。此外,由于计算在整数格式的权重上直接实现,这种更新方法的实现是快速的。

21.最终硬件平台因此可以常规地根据最终硬件平台所位于的环境中获取的新数据来适配神经网络。优选地,根据被本领域技术人员熟知的所谓“批(batch)”方法计算相对于权重相关的误差梯度的和。

22.在一个有利的实现中,初始权重对于从神经网络的最后一层到第一层的每个神经网络层被更新。

23.在一个有利的实现中,用于确定经校正的权重的值的舍入方法是随机舍入。

24.此外,经校正的权重的值在若干权重更新后可以改变,以及因此可以开始不同于在第一更新之前的神经网络的权重的值。经校正的权重有利地被重新量化以避免权重的饱和或低值权重的准确性的损失。因此,在一个有利的实现中,更新权重还包括经校正的权重的量化。

25.经校正的权重的量化允许关于神经网络的运行保持良好的性能水平。

26.在一个有利的实现中,神经网络层的经校正的权重的量化包括:确定来自层的经校正的权重的集合中的最小权重以及最大权重,该集合包括将被量化的经校正的权重。

27.当层被均匀量化时,该集合可以是层的权重的集合;或当层在被逐通道量化时,该集合可以是层的相同通道的权重的集合。

28.在一个有利的实现中,经校正的权重的量化还包括:处理单元取回与存储在存储器中的初始权重相关联的零点值,处理单元使用下面的公式更新与经校正的权重相关联的零点值:

29.其中zp(n 1)是经更新的零点值,minq和maxq分别是权重根据权重格式能够采取的最小值以及最大值,min(n)=scale(n).minq(n)-zp(n),并且max(n)=scale(n).maxa(n)-zp(n),zp(n)是存储在存储器中的零值点,minq(n)是权重的集合的经校正的权重的最小值,以及maxq(n)为权重的集合的经校正的权重的最大值;处理单元利用经更新的零值点代替存储在存储器中的零点值。

30.clip()函数被配置为将表达式的值保持在范围[minq;maxq]内。

[0031]

int()函数返回等于表达式的结果的整数。

[0032]

例如,当权重是非对称的8位无符号格式时,最小值minq等于0,并且最大值maxq等于255。当权重是对称的8位有符号格式时,最小值minq等于-127,并且最大值maxq等于127。

[0033]

在一个有利的实现中,经校正的权重的量化还包括:处理单元取回存储在存储器中的初始权重的量化步长的值,处理单元根据公式更新量化步长的值,其中scale(n 1)是经更新的量化步长的值,minq(n)是权重的集合中的经校正的权重的最小值,maxq(n)是经校正的权重的集合中的经校正的权重的最大值,scale(n)是存储在存储器中的量化步长的值,minq和maxq分别是权重可以采取的最小值以及最大值,

[0034]-处理单元通过经更新的量化步长的值代替存储在存储器中的量化步长的值

[0035]

在一个有利的实现中,经校正的权重的量化包括计算经校正的权重的量化值。

[0036]

特别地,经校正的权重的量化值可以使用下面的公式计算:其中是经校正的权重的量化值,是根据第一计算获得的经校正的权重的值,minq(n)是权重的集合中的经校正的权重的最小值,maxq(n)是权重的集合中的经校正的权重的最大值,minq和maxq分别是权重根据权重格式可以采取的最大值以及最小值,scale(n)是存储器中存储的步长的量化的前一值,zp(n 1)是经更新的零点至,以及zp(n)是存储在存储器中的前一零点值。

[0037]

尽管如此,当量化是对称的时,经校正的权重的量化值可以使用下面的公式计算:

其中是经校正的权重的量化值,是根据第一计算获得的经校正的权重的值,minq(n)是权重的集合的经校正的权重的最小值,maxq(n)是权重的集合的经校正的权重的最大值,以及n是权重格式的位的数目(例如8位)。

[0038]

优选地,针对表达式max(|maxq(n)|,|minq(n)|)的每个可能值,通过表达式可以采取的值被记录在存储在存储器中的查找表中。

[0039]

此外,神经网络的每个层可以被均匀量化,被称为逐层量化(per-layer quantization);神经网络或者可以对于层的每个通道被不同地量化,称作逐通道量化(per-channel quantization)。

[0040]

然而,当更新权重时,神经网络的层的量化的类型(逐层量化或逐通道量化)可以被有利地被修改以改善神经网络的运行。

[0041]

特别地,在学习阶段期间,神经网络根据学习结果被逐层量化或逐通道量化。

[0042]

通常,在神经网络的运行时间的轻微增加中,逐通道量化获取对于神经网络的更高准确性。更具体地,逐通道量化的层通常运行比均匀量化的层更大数目的时钟周期。

[0043]

然而,在一些情况下,逐通道量化以及逐层量化可以获得等效的准确性。因此,在该情况下,逐层量化可以有利地用于减少神经网络运行时间。

[0044]

因此,在一种有利的实现中,该方法还包括对于每个层执行由处理单元实现的下面的步骤:计算决策制定标准,继而将决策制定标准与阈值相比较,继而根据比较的结果,对层的每个经校正的权重均匀地量化经校正的权重,或对层的逐通道独立地地量化经校正的权重。

[0045]

在一个有利的实现中,决策制定标准按照下面的公式计算:其中scale

l

(n 1)是可以对于整个层被定义的量化步长,以及min(scalec(n 1))是从可以针对层的每个通道被定义的量化步长中的最小量化步长。

[0046]

在一个有利的实现中,对于初始地均匀地量化的层,如果决策制定标准大于或等于包括在六和十之间的阈值,继而经校正的权重的量化通过逐通道量化来实施。

[0047]

在一个有利的实现中,对于初始被逐通道量化的层,如果决策制定标准小于或等于大于一且小于或等于四的阈值,继而经校正的权重的量化通过对于层的每个经校正的权重均匀量化来实施。

[0048]

根据另一方面,本公开提出了一种微控制器,包括:存储器,被配置为根据至少一个给定的整数格式,存储神经网络的层的初始权重;处理单元,被配置为:确定在神经网络的层的输出处的误差梯度;从存储器取回初始权重;更新初始权重,包括:对于每个初始权重,以该初始权重的整数格式,根据下述公式对经校正的权重进行第一计算:其中是经校正的权重的

值,是初始权重的值,λ是学习速率,scale(n)是权重的量化步长,是相对于权重的误差梯度的和,以及round()函数是到最接近的整数的向上舍入或向下舍入;利用经校正的权重的值代替存储在存储器中的初始权重的值。

[0049]

有利地,微控制器因此包括存储器以及被配置为实现上文描述的方法的处理单元,该存储器被配置为根据被至少一个给定的整数格式存储神经网络的层的初始权重。

[0050]

根据另一方面,本公开提出了包括指令的计算机程序产品,当程序由处理单元运行时,指令使得处理单元实现上文描述的方法。

附图说明

[0051]

其他优点以及特征在检验非限定性实施例以及实现详细描述时,并且在参考附图中是显然的,其中:

[0052]

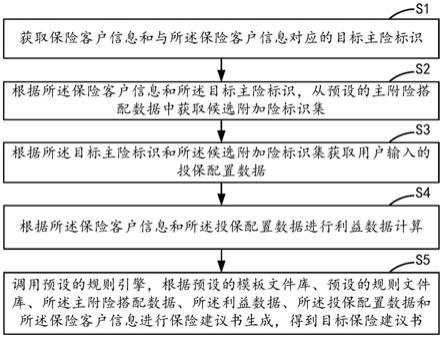

图1示出了用作在最终的硬件平台集成神经网络中实现的微控制器的实施例;以及

[0053]

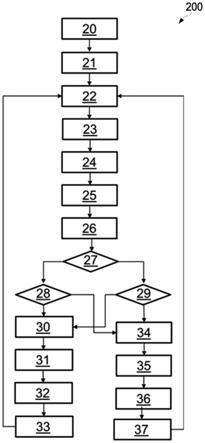

图2示出了操作方法的实施例的流程图。

具体实施方式

[0054]

神经网络由本领域技术人员熟知的参数(诸如权重)定义。神经网络包括输入层、输出层以及在输入层以及输出层之间的至少一个隐藏层。每个层可以包括至少一个通道,每个通道包括至少一个权重。

[0055]

每个层的权重是根据一个或多个格式定义的整数。特别地,每个权重可以根据其量化值、量化步长、以及零点定义。特别地,权重可以根据下面的公式描述:sw×

(q

w-zpw),其中sw是量化步长,qw是权重的经量化的值,以及zpw是经量化的零点。

[0056]

每个层可以被均匀地或逐通道地量化。当层被均匀量化时,所有权重具有相同的格式。当层被逐通道量化时,相同通道的权重具有相同的格式。然而,不同的通道的权重格式不必是相同的。每个通道因此独立于层的其他通道被量化。

[0057]

神经网络的权重的值及其量化可以在学习阶段被执行后被定义,该学习阶段在神经网络被集成到微控制器中之前被执行。学习阶段可以被监督或以其他方式进行。学习阶段允许神经网络的权重被调整。出于此目的,神经网络例如可以通过从参考数据库输入已经分类的数据来运行。

[0058]

图1示出了微控制器102的实施例的示图100。如图所示,微控制器102包括存储器104和处理单元106。可以理解,微控制器102可以包括未示出的附加部件。

[0059]

特别地,微控制器102包括在其中存储神经网络的参数的存储器104。在实施例中,神经网络的层的权重(即,权重的量化值)、其量化步长以及其零点。在实施例中,存储器104是非易失性存储器类型。

[0060]

微控制器102可以进一步包括处理单元106。处理单元106可以是处理器等。处理单元106可以被配置为根据在神经网络的输入处接收的数据,运行神经网络。例如,运行神经网络允许数据作为在神经网络的输入处接收的数据的函数被输出。例如,神经网络可以输出接收的输入数据的分类,或根据在神经网络的输入处接收的信号生成输出信号。

[0061]

神经网络可以在微控制器102被放置在其中的环境中实现。环境可以不同于神经网络被训练的环境。处理单元106可以进一步被配置为更新神经网络的权重以使神经网络适配于环境,在该环境中神经网络通过实现参考图2描述下面的方法被实现。

[0062]

在实施例中,微控制器102在存储器中具有包括指令的计算机程序产品,该指令当由处理单元106运行时,使得后者实现下面所述的方法。

[0063]

图2示出了可以在微控制器102中实现的实施例方法的流程图200。方法包括步骤20,其中处理单元106使用不同的数据多次实现神经网络。处理单元106计算根据对本领域技术人员公知的所谓“批处理”方法按照其各种实现从神经网络的输出结果计算总误差。

[0064]

方法继而包括步骤21,其中处理单元106在神经网络的层的输出处计算误差梯度。在实施例中,处理单元106使用梯度反向传播方法计算误差梯度。

[0065]

方法继而包括步骤22到步骤37的一系列步骤,该一系列步骤从神经网络的输出层的每个层到神经网络的输入层被实施。在步骤22,处理单元106取回层的被称作初始权重的权重,该权重被存储在存储器104中。

[0066]

然后,在步骤23,处理单元106更新层的权重。在实施例中,对于层的每个权重,处理单元106以存储在存储器104中的初始权重的整数格式执行经校正的权重的初始计算。

[0067]

在实施例中,处理单元106使用下面的公式计算每个经校正的权重:其中是经校正的权重的值,是初始权重的值,λ是学习速率,scale(n)是权重的量化步长,是相对于权重的误差梯度的和,以及round()函数是到最接近的整数的向上舍入或向下舍入。

[0068]

因此,每个权重通过如下操作而被更新:向该权重增加由学习速率入与用于表示权重的量化步长之间的比率乘以相对于权重的误差梯度的和的舍入结果。优选地,用于确定权重的值的方法是随机舍入。

[0069]

方法继而包括步骤24至36,用于将层的经校正的权重的量化适配于这些经校正的权重的值。在步骤24,处理单元106从层的经校正的权重的至少一个集合确定最小权重以及最大权重。在实施例中,处理单元106确定层的经校正的权重的集合的最小权重以及最大权重。此外,在实施例中,处理单元106确定层的每个通道的经校正的权重的最小权重以及最大权重。

[0070]

在步骤25,处理单元106计算层的经校正的权重的量化步长。在实施例中,处理单元106使用层的经校正的权重的集合中的最小权重以及最大权重计算层的经校正的权重的集合的量化步长。出于该目的,处理单元106应用下面的公式:其中min

ql

(n)是层的经校正的权重的最小值,max

ql

(n)是层的经校正的权重的最大值,scale(n)是层的初始权重的量化步长的值,以及minq和maxq分别是权重根据权重格式可以采取的最小值以及最大值。在实施例中,scale(n)值由处理单元106从存储器104中取回。

[0071]

例如,当权重是非对称8位无符号格式时,权重的最小值minq等于o,并且权重的最大值maxq等于255。当权重是对称的8位有符号格式时,权重的最小值minq等于-127,并且权

重的最大值maxq等于127。

[0072]

此外,在实施例中,对于层的每个通道,处理单元106使用该通道的最小权重以及最大权重计算对于该通道的权重的量化步长。出于此目的,处理单元106使用如下公式:其中min

qc

(n)是通道的经校正的权重的最小值,max

qc

(n)是通道的经校正的权重的最大值,scale(n)是通道的初始权重的量化步长的值,以及minq和maxq分别是权重可以采取的最小值以及最大值。

[0073]

在步骤26,处理单元106计算决策制定标准以确定均匀地量化层还是逐通道量化层是优选的。决策制定标准可以按照下面的公式计算:其中scale

l

(n 1)是用于整个层计算的量化步长,并且min(scalec(n 1))是对于不同通道计算的量化步长中的最小量化步长。

[0074]

在步骤27,处理单元106确定该层当前被均匀量化还是被逐通道量化。如果该层被初始均匀量化,继而处理单元106在步骤28执行测试。在该测试中,处理单元106将决策制定标准的值与在范围[6;10]中包括的整数值x比较。如果决策制定标准大于或等于值x,那么处理单元106确定对于新的经校正的权重,逐通道量化层是优选的。否则,处理单元106认为保持层的均匀量化是优选的。

[0075]

在实施例中,如果层被初始地逐通道量化,处理单元106执行步骤29中的测试。在该测试中,处理单元106将决策制定标准的值与在范围[1;4]中包括的整数值y比较。如果决策制定标准小于或等于值y,那么处理单元106确定对于新的经校正的权重,均匀地量化层是优选的。否则,处理单元106认为保持逐通道量化是优选的。在实施例中,对于整数值x以及y选择的间隔在实验的基础上被定义。

[0076]

如果层将被均匀量化,继而处理单元106根据步骤30至33执行层的权重的均匀量化。在步骤30,处理单元106更新存储在存储器104中的零点值。在实施例中,零点值zp(n)通过处理单元106从存储器104中被取回。继而,处理单元106可以使用下面的公式计算新零点:

[0077][0078]

其中zp(n 1)是经更新的零点值,minq和maxq分别是权重可以采取的最小值以及最大值,min(n)=scale(n).min

ql

(n)-zp(n)以及max(n)=scale(n).max

ql

(n)-zp(n),zp(n)是存储在存储器104中的零点值,min

ql

(n)是层的经校正的权重的最小值,以及max

ql

(n)是层的经校正的权重的最大值。

[0079]

在步骤31,处理单元根据下面的公式更新量化步长的值:其中scale(n 1)是层的权重的经更新的量化步长的值,min

ql

(n)是层的经校正的权重的最小值,max

ql

(n)是层的经校正的权重的最大值,scale(n)是层的初始权重的量化步长的值,以及minq和maxq分别是权重可以采取的最小值以及最大值。

[0080]

应该注意到,该量化步长scale

l

(n 1)已经在步骤25中被计算。因此,在实施例中,

如果值scale

l

(n 1)先前存储在存储器104中,处理单元106不必须执行计算。

[0081]

在步骤32,处理单元106重新量化经校正的权重的值。在实施例中,经校正的权重的经量化的值使用下面的公式被计算:其中是经校正的权重的经量化的值,是根据第一计算所获得的经校正的权重的值,minq(n)是权重的集合中的经校正的权重的最小值,maxq(n)是权重的集合中的经校正的权重的最大值,minq以及maxq分别是权重根据权重格式可以采取的最小值以及最大值,scale(n)是在存储器中存储的量化步长的前一值,zp(n 1)是经更新的零点值,以及zp(n)是在存储器中存储的前一零点值。

[0082]

然而,当量化是对称的时,处理单元106可以使用公式:其中是经校正的权重的量化值,是根据第一计算获得的经校正的权重的值,min

ql

(n)是层的集合中的经校正的权重的最小值,max

ql

(n)是层的集合中的经校正的权重的最大值,以及n是权重格式的位数(例如8位)。

[0083]

优选地,针对表达式max(|max

ql

(n)|,|min

ql

(n)|)的每个可能值,通过表达式可以采取的值被记录在存储在存储器104中的查找表中。

[0084]

例如,当权重的值使用8位对称量化来表示时,可以由表达式max(|max

ql

(n)|,|min

ql

(n)|)采用的值通常接近127。更具体地,权重的经校正的值通常在它们被更新前接近权重值。对于这些值,可以由表达式采用的值因此被预先计算,继而被存储在查找表中。

[0085]

随后,量化步长的权重的值以及存储在存储器104中的零点的权重的值在步骤33由新计算的值代替。此外,如果层将被逐通道量化,继而在步骤34以及37中,处理单元106执行对每个通道的权重的量化。

[0086]

在步骤34,处理单元106更新存储在存储器104中的零点值。出于该目的,零点值zp(n)通过处理单元106从存储器104中被取回。在实施例中,处理单元10使用下面的公式计算新零点:其中zp(n 1)是经更新的零点值,minq和maxq分别是权重可以采取的最小值以及最大值,min(n)=scale(n).min

qc

(n)-zp(n),并且max(n)=scale(n).maxqc(n)-zp(n),zp(n)是存储在存储器104中的零点值,min

qc

(n)是通道的经校正的权重的最小值,max

qc

(n)是通道的权重的最大值。

[0087]

在步骤35,处理单元106根据下面的公式更新量化步长的值:其中scalec(n 1)是通道的权重的经更

新的量化步长的值,min

qc

(n)是通道的经校正的权重的最小值,max

qc

(n)是通道的权重的最大值,scale(n)是通道的初始权重的量化步长的值,以及minq和maxq分别是权重可以采取的最小值以最大值。

[0088]

在实施例中,该量化步长scalec(n 1)在步骤25已经被计算。因此,如果值scalec(n 1)先前被存储在存储器104中,处理单元106不是必须地执行计算。

[0089]

在步骤36,处理单元106重新量化经校正的权重的值。在实施例中,经校正的权重的经量化的值可以使用下面的公式计算:其中是经校正的权重的经量化的值,是根据第一计算获得的经校正的权重的值,minq(n)是权重的集合中的经校正的权重的最小值,maxq(n)是权重的集合中的经校正的权重的最大值,minq和maxq分别是根据权重格式权重可以采取的最小值以及最大值,zp(n 1)是经更新的零点值,以及zp(n)是存储在存储器中的前一零点值。

[0090]

然而,当量化是对称的时,处理单元106可以使用公式:其中是经校正的权重的经量化的值,是根据第一计算获得的经校正的权重的值,minq(n)是权重的集合中的经校正的权重的最小值,maxq(n)是权重的集合中的经校正的权重的最大值,以及n是权重格式的位数(例如8位)。

[0091]

如前文所述,针对表达式max(|max

qc

(n)|,|min

qc

(n))的每个可能值,通过表达式可以采取的值被记录在存储在存储器104中的查找表中。然后在步骤37,量化步长的权重的值以及存储在存储器104中的零点的权重的值被新计算的值代替。

[0092]

在对神经网络的给定的层执行步骤22到37之后,处理单元106对在神经网络中的给定层之前的层直接地重复这些步骤。被执行以更新权重的计算直接地以整数格式给出权重。这样的更新方法因此避免了涉及浮点权重格式的需要。结果,执行更新所需的存储器资源被最小化。

[0093]

用于更新权重的方法因此可以由使用神经网络的最终硬件平台被直接地实现。例如,用于更新权重的这种方法可以由微控制器102直接实现。因此可以避免在远程服务器上更新权重。用于更新权重的方法因此使得限制功耗成为可能,特别是当其由最终的硬件平台实现时。此外,由于计算在以整数格式的权重上直接实现,这种更新方法的实现是快速的。

[0094]

最终的硬件平台因此可以常规地根据最终硬件平台所位于的环境中获取的新数据来适配神经网络。经校正的权重的量化的适配允许关于神经网络的运行的良好性能水平被保持。

[0095]

尽管已经详细描述了说明书,但是应当理解,在不脱离由所附权利要求限定的本公开的精神和范围的情况下,可以进行各种改变,替换和变更。在各个附图中,相同的元件用相同的附图标记表示。此外,本公开的范围不旨在被限于本文描述的特定实施例,本领域

技术人员易于从该公开中理解,当前存在的或稍后将被开发的过程、机器、制造、物质的组成、部件、方法或步骤,可以如本文描述的相应的实施例执行基本相同的功能或实现基本相同的结果。因此,所附权利要求书旨在在其范围内包括这样的过程、机器、制造、物质的组成、部件、方法或步骤。

[0096]

应当理解,本公开的实施例不限于本文公开的涉及在辅助约束系统中的储备电容器的电压降的测量。各种实施例也可以应用于从在具有未知的基线电压的电子电路的终端处的电压降中获益的其他应用。

[0097]

因此,说明书和附图仅被认为是对由所附权利要求限定的本公开的说明,并且被认为覆盖落入本公开的范围内的任何和所有修改、变化、组合或等同物。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。