1.本发明属于人工智能技术领域,具体涉及一种基于多尺度语义网络的视听视频解析装置及方法。

背景技术:

2.在当今的网络环境下,存在着海量的图片、视频、音频等媒体信息,而在人工智能领域中,如何让机器学习并理解上述媒体信息,一直是广受学者研究的重要课题,如计算机视觉领域致力于研究图片和视频的内容理解,自然语言处理领域试图让机器理解人类语言,而语音检测领域主要对声音进行研究和处理。用基于人工智能的方式对媒体信息进行处理,可以高效的从海量数据中提炼有效的信息内容,并加以分析和利用,从而给人们的日常生活带来更大的便利。

3.在上文诸多媒体信息中,视频是一种广泛的媒介形式,它是将一系列静态影像以电信号的方式加以捕捉、记录、处理、储存、传送与重现的各种技术。网络中存在大量的视频可供用户观看,是否能够理解视频的内容,是网络视频供应商进行精准化视频定制、视频推荐的决定性因素。除此之外,视频理解在视频监控,自动驾驶等领域亦有广泛的应用,因此视频理解是一项意义重大而又富有挑战性的研究领域。

4.当下,学者们提出了多种视频理解的任务,例如动作识别,该任务要求机器识别出视频中主要动作所属的类别,对视频进行分类并生成标签;以及时序动作检测,该任务要求对视频中的事件进行分类和定位,即预测出事件所属的类别,并给出其起始的时间段;还有动作分割任务,该任务要求对视频中的每一帧进行分类,将一段视频分为若干个事件的集合,该任务要求对视频有帧级别的时序分割,因此需要对视频有更深入、细节的理解。针对上述任务,学者们也给出了多种优秀的解决方式,然而这些任务和方法共有的局限性在于,它们只研究了视频的视觉信息,即只对视频当中的画面进行了分析,而忽略了视频中所天然隐含的声学信息。在视频当中,画面和音频存在天然的时序对应关系,视频的音频部分也隐含了若干有助于视频理解的重要信息。而能否将视频当中的音频和视频信息结合起来,便成为了一个重要而富有前景的新难题。

5.视听视频解析任务便是一项跨模态的视频理解任务。该任务要求辨别一段视频中的所有单模态和多模态事件,即给出所有事件的类别,以及它们的起始时刻。在该任务中,有些事件只存在于音频中,而有些事件只存在于视频中,也有一些同时存在于音频和视频中的多模态任务,因此该任务需要对多模态信息进行充分的理解和捕获。

6.现有的视听视频解析方法一般通过时序注意力机制来探究上下文之间的单模态和跨模态关系。然而,现有的方法均是在整个视频长度内进行上下文信息融合。这种方式更倾向于去寻找那些时长较长,在视频中体现较明显的事件。在视听视频解析任务中,视频当中的事件是不定长的,那么有些长度很短的事件就无法很好的检测得出。因此,如何获取多尺度的单模态和跨模态信息,以及如何将获取的多尺度信息有效融合,是完成该任务需要解决的重要难题。

技术实现要素:

7.为解决上述问题,提供一种获取多尺度模态信息的视听视频解析方法,本发明采用了如下技术方案:

8.本发明提供了一种基于多尺度语义网络的视听视频解析方法,用于对目标音视频的所有单模态和多模态事件进行识别和定位,其特征在于,包括以下步骤:步骤s1,对目标音视频进行预处理获取视觉特征和音频特征;步骤s2,构建基于多尺度语义网络的神经网络模型;步骤s3,采用弱监督训练方法对基于多尺度语义网络的神经网络模型进行训练得到视听视频解析模型;步骤s4,将视觉特征和音频特征输入至视听视频解析模型中得到目标音视频的所有单模态事件类别、多模态事件类别以及起始时刻,其中,基于多尺度语义网络的神经网络模型具有跨模态时序卷积注意力网络、自适应语义融合模块、分类模块以及多模态多实例学习池化层。

9.本发明提供的一种基于多尺度语义网络的视听视频解析方法,还可以具有这样的技术特征,其中,预处理包括图像预处理,该图像预处理为从目标音视频中抽取8个图像帧,对8个图像帧进行大小归一化。

10.本发明提供的一种基于多尺度语义网络的视听视频解析方法,还可以具有这样的技术特征,其中,预处理还包括音频预处理,该音频预处理的过程如下:对目标音视频中包含的音频重采样为16khz的单声道音频,使用25ms的hann时窗以及10ms的帧移对单声道音频进行短时傅里叶变换得到对应的频谱图,并使用64阶的梅尔滤波器组中计算梅尔声谱,使用0.01的偏置对梅尔声谱取对数,得到稳定的梅尔声谱,以0.96s的时长进行组帧,每一帧包含64个梅尔频带,不含帧的重叠。

11.本发明提供的一种基于多尺度语义网络的视听视频解析方法,还可以具有这样的技术特征,其中,跨模态时序卷积注意力网络由若干个级联的时序卷积层和定尺寸跨模态注意力层组成,根据输入的视觉特征以及音频特征生成对应的多尺度语义特征,自适应语义融合模块将多尺度语义特征的语义信息进行融合得到语义融合结果,分类模块对音频模态和视觉模态进行分类和预测生成模态预测结果,多模态多实例学习池化层根据模态预测结果生成视频级别标签,该视频级别标签用于弱监督训练。

12.本发明提供的一种基于多尺度语义网络的视听视频解析方法,还可以具有这样的技术特征,其中,步骤s3包括以下子步骤:步骤s3-1,构建弱监督的训练数据集;步骤s3-2,将训练数据集中的训练数据依次输入至基于多尺度语义网络的神经网络模型对模型参数进行迭代;步骤s3-3,在每次迭代后,根据最后一层的模型参数计算损失误差,利用损失误差进行反向传播从而更新模型参数;步骤s3-4,重复步骤s3-2至步骤s3-3直至达到训练完成条件,得到视听视频解析模型。

13.本发明还提供一种基于多尺度语义网络的视听视频解析装置,用于对目标音视频的所有单模态和多模态事件进行识别和定位,其特征在于,包括:预处理部,使用预定的预处理方法对目标音视频进行预处理得到视觉特征以及音频特征;以及视听视频解析部,利用预先训练得到的视听视频解析模型对视觉特征以及音频特征进行识别和定位,从而得出目标音视频的所有单模态和多模态事件的类别和起始时刻,其中,视听视频解析模型基于多尺度语义网络构建,包括跨模态时序卷积注意力网络,自适应语义融合模块,分类模块以及基于注意力的多模态多实例学习池化模块。

14.本发明提供的一种基于多尺度语义网络的视听视频解析装置,还可以具有这样的技术特征,其中,跨模态时序卷积注意力网络具有交叉级联的时序卷积层和定尺寸跨模态注意力层,分别用于捕捉单模态的多尺度语义信息和跨模态的多尺度语义信息,并进行信息融合从而得到多模态的多尺度语义特征,自适应语义融合模块通过尺度方向上的自注意力得到不同尺度之间的关联性,根据不同尺度语义特征之间的关联性和相似度来自适应的得到最终的语义融合结果,分类模块包括全连接层和softmax函数,该分类模块基于视觉特征以及音频特征进行分类,从而得出目标音视频中音频模态每一个事件的类别和起始时刻,以及目标音视频中视频模块每一个事件的类别和起始时刻,基于注意力的多模态多实例学习池化模块通过模态间注意力和时序注意力分别获得模态间和时序片段间的信息交互,生成多模态的事件级别标签。

15.发明作用与效果

16.根据本发明的基于多尺度语义网络的视听视频解析方法,通过对目标音视频进行了预处理得到的视觉特征和音频特征,然后由基于多尺度语义网络构建的视听视频解析模型对视觉特征和音频特征进行识别和定位从而生成目标音视频的所有单模态事件类别、多模态事件类别以及起始时刻。由于视听视频解析模型具有跨模态时序卷积注意力网络,该网络多层级联的时序卷积和定尺寸跨模态注意力层的来分别获取单模态和跨模态的多尺度语义,从而能从不同的时间尺度进行视频理解,因此能更为精确的定位多个不同长度的事件。还由于视听视频解析模型还具有自适应语义融合模块,能实现多个尺寸不同的语义可以进行语义维度上的特征交流和融合,使得模型能够自适应的选择更为恰当的融合结果,将不同的注意力权重分配到不同尺度的语义特征上,从而得到更为丰富和高效的综合语义。除此之外,还由于视听视频解析模型通过多模态多实例学习池化层能够以弱监督的方式进行训练,因此在模型的训练过程中,不需要对每个事件的起始时刻进行标注,只需要标注所有事件的类别即可进行训练,显著降低了训练数据标注的负担,并使得该方法和装置能够便捷的泛化到各个应用场景下。

附图说明

17.图1是本发明实施例中基于多尺度语义网络的视听视频解析方法的流程图;

18.图2是本发明实施例中多尺度语义网络的神经网络模型的结构示意图;

19.图3是本发明实施例中的时序卷积层的结构示意图;

20.图4是本发明实施例中的定尺寸跨模态注意力层的结构示意图;

21.图5是本发明实施例中的基于多尺度语义网络的视听视频解析装置的结构示意图;

22.图6是本发明实施例中的实验结果对比图。

具体实施方式

23.为了使本发明实现的技术手段、创作特征、达成目的与功效易于明白了解,以下结合实施例及附图对本发明的一种基于多尺度语义网络的视听视频解析方法及装置作具体阐述。

24.《实施例》

25.本实施例的一种基于多尺度语义网络的视听视频解析方法及装置在一张nvidia tesla p40显卡的辅助下实现相应训练与预测功能。

26.图1是本发明实施例中基于多尺度语义网络的视听视频解析方法的流程图。

27.如图1所示,基于多尺度语义网络的视听视频解析方法包括以下步骤:

28.步骤s1,对目标音视频进行预处理获取视觉特征和音频特征。

29.本实施例中,预处理分为图像预处理和音频预处理两部分。图像预处理过程为:首先,将待测视频序列(即视频的各个图像帧的时间顺序)按照1s分割成若干片段,然后从每个片段中抽取8个帧,得到该视频的图像帧集合,因为帧间差距不大,这样处理可以显著减轻计算复杂度。然后使用在imagenet数据集上预训练的resnet-152卷积神经网络和在kinetics数据集上预训练的3d-resnet卷积神经网络提取2d和3d的视觉特征。最后2d和3d的视觉特征经过相加融合后得到最终的视觉特征。

30.音频预处理过程为:首先将音频重采样为16khz的单声道音频,然后使用25ms的hann时窗,10ms的帧移进行短时傅里叶变换得到频谱图,并使用64阶的梅尔滤波器组中计算梅尔声谱。然后使用0.01 的偏置对梅尔声谱取对数,得到稳定的梅尔声谱,并以0.96s的时长进行组帧,每一帧包含64个梅尔频带,不含帧的重叠。最后使用在 audioset上预训练的vggish网络对音频序列进行特征提取,得到该视频序列的音频特征。

31.步骤s2,构建基于多尺度语义网络的神经网络模型。

32.图2是本发明实施例中多尺度语义网络的神经网络模型的结构示意图。

33.本实施例中,利用现有的深度学习框架pytorch,构建基于多尺度语义网络的神经网络模型。如图2所示,该神经网络模型包括跨模态时序卷积注意力网络,自适应语义融合模块,分类模块以及多模态多实例学习池化层。

34.其中,跨模态时序卷积注意力网络用于生成多尺度语义特征,该网络由若干个级联的时序卷积层和定尺寸跨模态注意力层组成,时序卷积层用于捕捉单模态多尺度语义信息,定尺寸跨模态注意力层用于捕捉跨模态多尺度语义信息,多个时序卷积层和定尺寸跨模态注意力层级联,生成若干个尺度不同的语义特征,用于后续的事件分类和定位。

35.图3是本发明实施例中的时序卷积层的结构示意图。

36.如图3所示,在跨模态时序卷积注意力网络中,有多个膨胀卷积尺寸不同的时序卷积层堆叠,卷积层的感受野根据膨胀卷积的尺寸变化而变化,膨胀尺寸较小的卷积层只能考虑到当前时序片段附近片段的信息,而膨胀尺寸较大的卷积层可以考虑到时序上离当前时序片段距离很远的信息,将所有卷积层的输出全部保留下来,即可得到多尺度的单模态语义信息。

37.由于时序卷积层只能捕获多尺度的单模态信息,需要额外使用跨模态的注意力机制来捕获多模态信息。常规的跨模态注意力机制一般使用放缩点积注意力(scaled dot-product attention)操作,经过softmax 和dropout函数处理后,得到注意力值。在跨模态注意力中,q矩阵为当前模态的时序片段特征,k和v为另一模态的时序片段特征,从而探究不同模态之间的特征关联。由于时序卷积层的每一层尺寸都不同,得到的语义尺度也不相同,因此每一层时序卷积层后的跨模态注意力层也应当有不同的尺寸。

38.图4是本发明实施例中的定尺寸跨模态注意力层的结构示意图。

39.如图4所示,本实施例提出了定尺寸跨模态注意力层,对于每一个时序片段t生成

的向量q,k和v是视频中时序片段[t-s,t s]组成的矩阵,从而使得当前模态的片段t只和另一模态中一定范围内的片段进行特征交互和融合,从而完成跨模态的多尺度特征语义生成。

[0040]

自适应语义融合模块用于融合多个尺度不同的语义信息,由于每个尺度的语义特征所含的信息各不相同,简单的在语义维度上进行平均池化无法获取更充分的语义信息,因此,本实施例使用一个基于自注意力的语义融合模块来探究不同尺度的特征之间的关联,并根据数据自身特征的不同选择更为适合的注意力权重,分配到不同尺度的语义信息中,从而自适应的得到表现更佳的语义融合结果。

[0041]

分类模块分为音频模态和视觉模态两部分,这两个模态各由一个全连接层和一个sigmoid函数组成。该分类模块根据语义融合结果得到最终的单模态预测结果。由于多模态事件必须同时是视觉事件和听觉事件,因此多模态预测结果可以由单模态预测结果相乘得到。

[0042]

多模态多实例学习池化层用于生成视频级别标签,进行弱监督训练,公式如下所示:

[0043][0044]wtp

[:,m,c]=softmax(f

tp

[:,m,c]),

[0045]wav

[t,:,c]=softmax(f

av

[t,:,c]),

[0046]

式中,m代表模态维度,c代表通道维度,p代表单模态音频预测结果和视频预测结果的堆叠,w

tp

代表时序卷积机制权重矩阵,w

av

代表模态注意力机制权重矩阵,f

tp

和f

av

是两个张量,分别由分类模块中全连接层的音频输入特征和视频输入特征堆叠而成。

[0047]

经过该多模态多实例学习池化层处理后,模型根据时序和模态之间的信息关联,生成了视频级别的标签用于弱监督学习,有效的降低了弱监督标签带来的性能损失。

[0048]

步骤s3,采用弱监督训练方法对基于多尺度语义网络的神经网络模型进行训练得到视听视频解析模型。

[0049]

该步骤s3包括以下子步骤:

[0050]

步骤s3-1,构建弱监督的训练数据集,该训练数据集中只提供视频中所有的事件类别标签,不提供事件的起始时刻标签。

[0051]

本实施例中,采用的训练数据集为avvp dataset。avvp dataset 是audioset数据集的一个子集,共含有25个类别的11849个视频,每一个视频平均含有1.64个事件。整个数据集含有多个领域的多个事件,能够评价相关模型在各个领域事件的识别表现。其中10000个视频作为训练集,1849个视频作为验证集。

[0052]

步骤s3-2,将训练数据集中的训练数据分批次依次输入至基于多尺度语义网络的神经网络模型进行训练以对模型参数进行迭代。

[0053]

本实施例中,构建的基于多尺度语义网络的神经网络模型的各层包含不同的模型参数,这些模型参数构建时为随机设置。

[0054]

步骤s3-3,在每次迭代后,根据最后一层的模型参数计算损失误差,采用交叉熵作为损失函数,利用损失误差进行反向传播从而更新模型参数。

[0055]

步骤s3-4,重复步骤s3-2至步骤s3-3直至模型各层的模型参数收敛后完成训练,得到视听视频解析模型。

[0056]

本实施例中,模型训练过程中的学习率设置为0.0001,使用adam 优化方法进行优化,每训练整个训练集10次,学习率就会除以10,从而使算法更为细致和准确的进行学习。

[0057]

经过上述迭代训练并在迭代过程中进行误差计算和反向传播,即可获得训练完成的基于跨模态注意力机制的视听视频解析模型。

[0058]

步骤s4,将视觉特征和音频特征输入至视听视频解析模型中得到目标音视频的所有单模态事件类别、多模态事件类别以及起始时刻。

[0059]

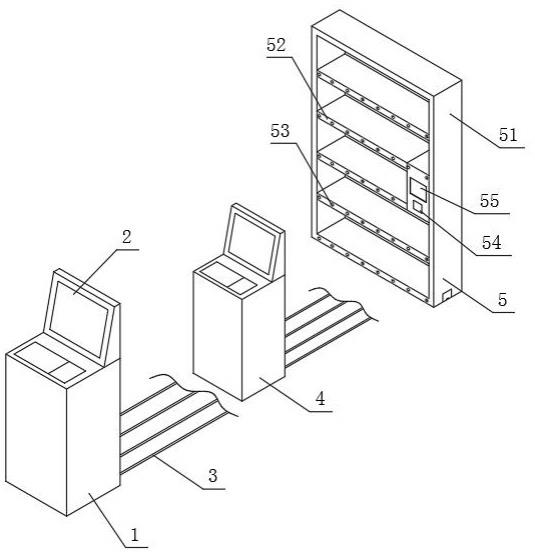

图5是本发明实施例中的基于多尺度语义网络的视听视频解析装置的结构示意图。

[0060]

本实施例还提供一种基于多尺度语义网络的视听视频解析装置,如图5所示,该视听视频解析装置10具有预处理部1以及视听视频解析部2。

[0061]

其中,预处理部1使用上述预处理方法对目标音视频进行预处理得到视觉特征以及音频特征。

[0062]

视听视频解析部2利用经训练得到的视听视频解析模型对视觉特征以及音频特征进行识别和定位,从而得出目标音视频的所有单模态和多模态事件的类别和起始时刻。

[0063]

进一步地,视听视频解析模型基于多尺度语义网络构建,包括跨模态时序卷积注意力网络,自适应语义融合模块,分类模块以及基于注意力的多模态多实例学习池化模块。具体地:

[0064]

跨模态时序卷积注意力网络具有交叉级联的时序卷积层和定尺寸跨模态注意力层,分别用于捕捉单模态的多尺度语义信息和跨模态的多尺度语义信息,并进行信息融合从而得到多模态的多尺度语义特征。

[0065]

自适应语义融合模块通过尺度方向上的自注意力得到不同尺度之间的关联性,根据不同尺度语义特征之间的关联性和相似度来自适应的得到最终的语义融合结果。

[0066]

分类模块包括全连接层和softmax函数,该分类模块基于视觉特征以及音频特征进行分类,从而得出目标音视频中音频模态每一个事件的类别和起始时刻,以及目标音视频中视频模块每一个事件的类别和起始时刻。

[0067]

基于注意力的多模态多实例学习池化模块通过模态间注意力和时序注意力分别获得模态间和时序片段间的信息交互,生成多模态的事件级别标签。

[0068]

图6是本发明实施例中的实验结果对比图。

[0069]

为验证基于多尺度语义网络的视听视频解析方法的效果,将本实施例的视听视频解析方法与现有的单模态音频事件检测方法kong etal.2018、talnet、单模态时序动作检测方法stpn、cmcs、多模态视听事件定位方法ave、avdsn、多模态视听视频解析方法avvp 在avvp测试集上进行实验对比。

[0070]

该实验的评价指标为f-score,越高表示性能越好。图6中,eventtype一栏指评估的模态,audio表示音频单模态,visual表示视觉单模态,audio-visual表示音视频多模态,type@av表示将三个模态的结果融合,event@av表示在计算f-scores的时候考虑所有模态的事件,得到复合的f-scores。此外,segment-level表示计算每个时序片段的准确率,而event-level表示以事件为单位计算准确率。

[0071]

由图6可知,本发明的基于多尺度语义网络的视听视频解析方法的定位准确率在各个指标上均高于其他方法,从而证明本发明的视听视频解析方法有效。

[0072]

实施例作用与效果

[0073]

根据本实施例提供的基于多尺度语义网络的视听视频解析方法及装置,首先对目标音视频进行了预处理得到的视觉特征和音频特征,通过视听视频解析模型对视觉特征和音频特征进行识别和定位从而生成目标音视频的所有单模态事件类别、多模态事件类别以及起始时刻。由于视听视频解析模型基于多尺度语义网络构建,该多尺度语义网络能够通过多层级联的时序卷积网络和定尺寸跨模态注意力层来分别获取单模态和跨模态的多尺度语义,从而能从不同的时间尺度进行视频理解,因此能更为精确的定位多个不同长度的事件。

[0074]

另外,由于视听视频解析模型还具有自适应语义融合模块,能实现多个尺寸不同的语义可以进行语义维度上的特征交流和融合,使得模型能够自适应的选择更为恰当的融合结果,将不同的注意力权重分配到不同尺度的语义特征上,从而得到更为丰富和高效的综合语义。

[0075]

除此之外,还由于视听视频解析模型通过多模态多实例学习池化层能够以弱监督的方式进行训练,因此在模型的训练过程中,不需要对每个事件的起始时刻进行标注,只需要标注所有事件的类别即可进行训练,显著降低了训练数据标注的负担,并使得该方法和装置能够便捷的泛化到各个应用场景下。

[0076]

实施例中,由于预处理时将视频按照1s时间间隔分隔,得到多个视频片段,从每个视频序列中抽取8帧的图像帧,从而构成图像序列,减少了后续神经网络模型的计算量,降低了复杂度。

[0077]

实施例中,由于同时使用2d和3d的resnet进行视觉信息的提取,既捕捉了帧内部的视觉特征,也捕捉了帧间的视频序列特征,将 2d和3d的视觉特征进行融合,能够得到表现力更强的视觉信息。

[0078]

上述实施例仅用于举例说明本发明的具体实施方式,而本发明不限于上述实施例的描述范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。