1.本发明涉及机器人视觉技术领域,更具体地说,涉及一种基于机器视觉的室内目标物识别和测距方法。

背景技术:

2.随着社会的发展,各种类型的机器人已逐渐应用到社会的各行各业.尤其是近些年来计算机视觉技术带来的巨大变化,视觉技术在机器人行业的应用也越来越普遍.服务机器人在室内场景中完成对给定目标的识别和测距,进而达到机器人对场景理解的目的是服务机器人应用中的重要环节之一。

3.如果仅仅用于避障目的,目前主要使用的方法有超声波测距、红外测距、激光测距和双目立体视觉测距法等。

4.但是,现有技术中没有解决物体识别和测距同时实时进行,使用单目摄像头测距精度较差。

5.前面的叙述在于提供一般的背景信息,并不一定构成现有技术。

技术实现要素:

6.本发明的目的在于提供一种基于机器视觉的室内目标物识别和测距方法,不仅能得到识别对象的位置,还可得出被识别对象的具体名称,有助于改善机器人的场景理解能力。

7.本发明提供一种基于机器视觉的室内目标物识别和测距方法,包括以下步骤:

8.s1:利用相机获取深度图和点云图,并进入s2步骤;

9.s2:yolo算法识别物体,并进入s3步骤;

10.s3:yolo算法生成的物体边界框,并进入s4步骤;

11.s4:对应生成深度图中的边界框,并进入s5步骤;

12.s5:对深度图中的深度值进行去重并得到坐标,并进入s6步骤;

13.s6:匹配边界框中点云与深度坐标,并进入s7步骤;

14.s7:通过几何测距得到机器人与目标物体的距离。

15.进一步地,步骤s1中的相机为rgb-d相机。

16.进一步地,步骤s2中的物体识别采用yolov4模块。

17.进一步地,步骤s2中的物体识别还包括在主机端搭建darknet框架。

18.进一步地,所述主机端搭建darknet框架包括以下步骤:对具体物体数据集进行标注后进行kmeans聚类;使用yolov4模型对特定物体数据集进行训练,损失值降到最低时结束;将训练好的yolov4权重文件替换进行目标识。

19.进一步地,步骤s3中yolo算法生成的物体边界框,包括将rgb-d相机获取的图像作为物体识别模块的输入图像,得到被识别的物体的名称和物体在输入图像中所占据的边界框的坐标。

20.进一步地,步骤s4中对应生成深度图中的边界框,包括在深度图中框选一个与识别模块中一样的边界框,将步骤3获得的边界框坐标对应到深度图中,在剪切深度图中框选的区域。

21.进一步地,步骤s5中对深度图中的深度值进行去重并得到坐标,包括对框选的深度图中的灰度图进行去重操作,剩下的作为其灰度值;灰度值的深度计算如下:

22.q[x y d 1]

t

=[x y z w]

t

。

[0023]

进一步地,步骤s6中匹配边界框中点云与深度坐标,包括根据获得的灰度值,通过该灰度值在深度图中的一系列坐标。

[0024]

进一步地,步骤s7中通过几何测距得到机器人与目标物体的距离,包括把步骤s6中得到的坐标对应到点云图中,即可获得输入图像中被框选物体与相机的距离;测距计算如下:

[0025][0026]

本发明提供的基于机器视觉的室内目标物识别和测距方法,使用机器学习中的物体识别和rgb-d视觉相结合的测距方法,在相机捕获的物体能够被识别的情况下,即可达到测距的目的.该方法不仅能得到识别对象的位置,还可得出被识别对象的具体名称,有助于改善机器人的场景理解能力。

附图说明

[0027]

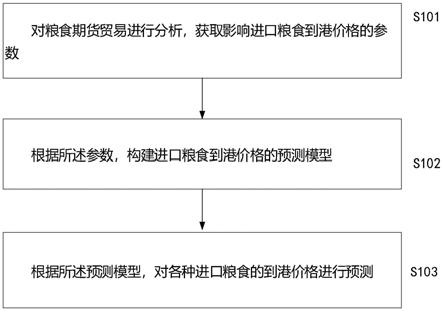

图1为本发明实施例提供的基于机器视觉的室内目标物识别和测距方法的流程图。

具体实施方式

[0028]

下面结合附图和实施例,对本发明的具体实施方式作进一步详细描述。以下实施例用于说明本发明,但不用来限制本发明的范围。

[0029]

本发明的说明书和权利要求书中的术语“第一”、“第二”、“第三”、“第四”等是用于区别类似的对象,而不必用于描述特定的顺序或先后次序。

[0030]

实施例1

[0031]

图1为本发明实施例提供的基于机器视觉的室内目标物识别和测距方法的流程图。请参照图1,本发明实施例提供的一种基于机器视觉的室内目标物识别和测距方法,其特征在于,包括以下步骤:

[0032]

s1:利用相机获取深度图和点云图,并进入s2步骤;

[0033]

s2:yolo算法识别物体,并进入s3步骤;

[0034]

s3:yolo算法生成的物体边界框,并进入s4步骤;

[0035]

s4:对应生成深度图中的边界框,并进入s5步骤;

[0036]

s5:对深度图中的深度值进行去重并得到坐标,并进入s6步骤;

[0037]

s6:匹配边界框中点云与深度坐标,并进入s7步骤;

[0038]

s7:通过几何测距得到机器人与目标物体的距离。

[0039]

本发明提供的基于机器视觉的室内目标物识别和测距方法,使用机器学习中的物体识别和rgb-d视觉相结合的测距方法,在相机捕获的物体能够被识别的情况下,即可达到测距的目的.该方法不仅能得到识别对象的位置,还可得出被识别对象的具体名称,有助于改善机器人的场景理解能力。

[0040]

具体地,步骤s1中的相机为rgb-d相机。

[0041]

进一步地,步骤s2中的物体识别采用yolov4模块,可以直接在网络下载使用;当需要识别特定物体时,可在主机端搭建darknet框架;

[0042]

搭建darknet框架包括以下步骤:

[0043]

对具体物体数据集进行标注后进行kmeans(k均值聚类算法)聚类;使用yolov4模型对特定物体数据集进行训练,损失值降到最低时结束;将训练好的yolov4权重文件替换进行目标识。

[0044]

需要说明的是,darknet框架是一个较为轻型的完全基于c与cuda的开源深度学习框架,其主要特点就是容易安装,没有任何依赖项(opencv都可以不用),移植性非常好,支持cpu与gpu两种计算方式。

[0045]

进一步地,步骤s3中yolo算法生成的物体边界框,包括将rgb-d相机获取的图像作为物体识别模块的输入图像,得到被识别的物体的名称和物体在输入图像中所占据的边界框的坐标。

[0046]

进一步地,步骤s4中对应生成深度图中的边界框,包括在深度图中框选一个与识别模块中一样的边界框,将步骤3获得的边界框坐标对应到深度图中,在剪切深度图中框选的区域。

[0047]

进一步地,步骤s5中对深度图中的深度值进行去重并得到坐标,包括对框选的深度图中的灰度图进行去重操作,剩下的作为其灰度值;灰度值的深度计算如下:

[0048]

q[x y d 1]

t

=[x y z w]

t

。

[0049]

需要说明的是,设图像中某一点的坐标为(x,y),可以使用公式q[x y d 1]

t

=[x y z w]

t

计算物体的深度d。

[0050]

进一步地,步骤s6中匹配边界框中点云与深度坐标,包括根据获得的灰度值,通过该灰度值在深度图中的一系列坐标。步骤s7中通过几何测距得到

×

机器人与目标物体的距离,包括把步骤s6中得到的坐标对应到点云图中,即可获得输入图像中被框选物体与相机的距离;测距计算如下:

[0051][0052]

需要说明的是,设点p为框图物体中的任意一点,oz与or为左右目相机的位置,pz和pr为左右相机成像点位置,f表示为焦距,t为oz与or中心点位置(其中f,t值通过相机标定可得),k表示相机到物体的距离,设pz到pr的距离为d则有公式为d=t-(xz-xr);

[0053]

进一步,根据三角形相似原理得到公式从而可得k=(f

×

t)/(xz-xr),求得上述式子中的xz和xr值,即可求得深度信息。

[0054]

需要说明的是,在本发明方案中,相机摄像头受到外界因素的干扰较大,在户外可能会影响图像识别和测距精度,所以本方案是假定在室内的环境下进行,本技术方案通过深度图与点云图的匹配提升了测距的精度,通过机器视觉的图像识别方案与单目测距结合达到了物体识别与测距同时进行的效果。

[0055]

基于上文的描述可知,本发明优点在于:

[0056]

1、本发明提供的基于机器视觉的室内目标物识别和测距方法,使用机器学习中的物体识别和rgb-d视觉相结合的测距方法,在相机捕获的物体能够被识别的情况下,即可达到测距的目的.该方法不仅能得到识别对象的位置,还可得出被识别对象的具体名称,有助于改善机器人的场景理解能力。

[0057]

2、本发明提供的基于机器视觉的室内目标物识别和测距方法,涉及机器视觉中的物体识别和测距,快速、准确地识别物体并确定机器人与物体的距离;通过机器视觉的方法实时识别物体,其提供的边界框可为深度图与点云图的匹配提供视图基准;将深度图与点云图匹配提高了测距精度;在相机捕获的物体能够被识别的情况下,即可达到测距的目的;将测距与目标识别同时进行。

[0058]

以上所述,仅为本发明的具体实施方式,但本发明的保护范围并不局限于此,任何熟悉本技术领域的技术人员在本发明揭露的技术范围内,可轻易想到变化或替换,都应涵盖在本发明的保护范围之内。因此,本发明的保护范围应以所述权利要求的保护范围为准。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。