1.本发明属于视觉与语言的交叉领域,应用于图像和文本间的跨模态检索任务,更具体地,涉及一种基于自注意力推理的跨模态图文互索方法。

背景技术:

2.随着网络技术的迅猛发展,尤其是新兴社交平台以及移动设备的应用,互联网世界充斥着大量多模态信息(文本、图像、视频、音频等)。正是因此,用户对于人机间的兴趣交互

‑‑

搜索功能的需求也发生了新的变化,许多平台不再局限于单一模态间的匹配而是实现了跨模态的匹配功能。当用户通过提交任何模态的查询来搜索信息,他们可以获得各种形式的搜索结果,鉴于数据的不同模态,可提供更为全面的补充信息。图文匹配作为多模态匹配其中一个重要的分支,应用在了非常多的领域之中,例如图文检索,图像标题生成,图像问答系统,图像知识推理等。

3.图文检索算法的研究意义与价值体现在以下几个方面。其具有实际应用价值,首先最常见的就是应用于搜索引擎和推荐系统中,各大电商平台和社交网站都进行了大量的研究工作和实际落地项目。图文检索算法使得用户可以获取更多感兴趣的信息,比如当你购物时,用一些简单的文字描述就可以获得相应的服饰图片推荐;或是使用随手拍下的一张食物图片就能够获取其具体的菜谱信息,那么生活将更加便捷。其次,图文检索算法也可应用于监控、安防方面。比如使用了图片搜索功能实现了对行人的重识别,它表面上只是应用了单向的文本到图片的搜索过程但本质上也还是图文检索,在追捕情景下可以帮助执法者快速锁定初始目标人物加速破案过程。除此之外,图文检索也可以帮助新媒体的发展,比如为文学创作或是媒体创意搭配上合适的插画图片。

4.依赖于如今互联网信息量的几何级增长、大数据与计算能力的发展,深度学习拥有了大量的前期支持,运用深度学习的图文检索算法开始了迅猛发展。但也因此增加了挑战,如何从海量的拥有干扰与噪声的数据中实现较快速的图文检索,提高图片、文本特征的提取与度量能力,使得模型能有良好的匹配效果,都是图文检索将面临的关键性问题。

技术实现要素:

5.本发明的目的是设计一种基于自注意力推理的跨模态图文互索方法,旨在跨过图像视觉与自然语言间的“语义鸿沟”,实现更好的语义理解。能基于深度学习的方法提升图文间跨模态检索的精度与速度,能够在实际场景中有所应用。

6.为实现上述目的,本发明提供了一种基于自注意力推理的跨模态图文互索方法,包括:

7.获取数据集,得到成对的原始图像数据与文本标注数据,并将其划分为训练数据集、验证数据集与测试数据集;

8.对于训练集中的每组数据对,分别提取图像经过预训练模型输出的初始特征以及文本编码后的特征嵌入;

9.自注意力推理,将两个模态特征映射到同一潜在公共空间,对图像分支进行其内部耦合关系的推理,利用自注意力机制计算各个局部边界框对于整体图像的贡献值融合为新的图像表征;

10.设计交叉注意力层得到两种模态语义在对方语义空间中的表示,计算相似度,利用三元组损失函数进行训练,最终实现跨模态的语义对齐;

11.模型验证,使用验证集对训练好的模型进行校验选择出最优的模型;

12.模型评估,使用测试集对最优模型进行评估,得到其检索精度;

13.图文互索,利用最终的最优模型实现图像和文本之间两个方向上的检索。

14.进一步地,利用在visual genomes数据集上预训练的resnet-101作为骨干网络的faster r-cnn,进行一种自下而上的检测提取图像特征。

15.进一步地,通过图像分支内部的注意力推理模块得到各个边界框即局部图像特征对全局特征而言的重要性以及它们之间的内在联系,对不相干语义进行筛除,推理出相应的权重系数融合得到最终图像的嵌入表示。

16.进一步地,使用词嵌入的方法考虑各个单词间的联系,通过嵌入矩阵将每个单词嵌入到一个同维向量中,利用双向门控循环单元对文本特征进行最终编码,映射到与图像相同的公共子空间中。

17.进一步地,通过交叉注意力层计算每个局部图像与单词之间交互注意力矩阵,获取视觉语义在文本语义空间的特征表示和文本在视觉语义空间的特征表示,利用余弦函数计算两个模态间的相关性。

18.进一步地,采用最大铰链和损失训练所述跨模态匹配模型,计算公式为:

19.loss=[λ-s(i,t) s(i,t

′

)]

[λ-s(i,t) s(i

′

,t)]

[0020]

式中,λ代表裕度,[x]

=max(x,0)。s(i,t)代表相匹配图像与文本之间的相似度s(i,t'),s(i',t)则代表难例样本对之间的相似度t'=argmax

p≠t

s(i,p),i'=argmax

q≠i

s(q,t)。

[0021]

将待查询的图片或文本分别进行特征提取后输入到最优模型中,得到该图片与所有文本或该文本与所有图片之间的匹配度分数矩阵,再对该矩阵进行分数从大到小的排序即可得到检索结果。

[0022]

具体训练阶段,使用硬件nvidia gtx 2080ti gpu和intel core i7-9700k cpu,adam训练策略,在pytorch框架下训练模型。

[0023]

经由上述的技术方案可知,与现有技术相比,本发明通过自注意力推理可以剔除不相干信息带来的负面影响,以获取视觉分支更加精确的特征表达,在此基础上,为了使模态之间的对应关系更加显著,通过两个模态间的交叉注意力层进行进一步匹配,获取视觉语义在文本语义空间的特征表示和文本在视觉语义空间的特征表示,最终得到具有足够通用语义和准确性的多模态特征,从而有效地提高跨模态检索模型的方法的精确度和稳定性。

附图说明

[0024]

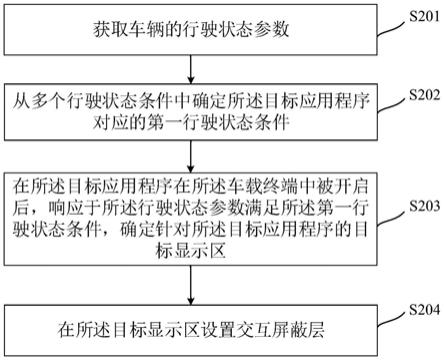

图1为本发明提供的一种基于自注意力推理的跨模态图文互索方法的实现流程示意图;

[0025]

图2为本发明实施例中整体网络结构示意图;

[0026]

图3为本发明实施例中自注意力推理网络结构示意图;

[0027]

图4为本发明实施例中交叉注意力结构示意图。

具体实施方式

[0028]

结合附图和具体实施例,对本发明作进一步说明。应理解,这些实施例仅用于说明本发明而不用于限制本发明的范围。此外应理解,在阅读了本发明讲授的内容之后,本领域技术人员可以对本发明作各种改动或修改,这些等价形式同样落于本技术所限定的范围。

[0029]

参见附图1、2,本发明设计的一种基于自注意力推理的跨模态图文互索方法,具体实现过程如下:

[0030]

步骤1:获取数据集,得到成对的原始图像数据与文本标注数据,并将其划分为训练数据集、验证数据集与测试数据集。

[0031]

用于训练、评估和测试的多模态数据集包含成对的图像和文本,一张图片对应于五个相关的文本项。本实施例将数据集划分为训练集、验证集和测试集三部分。

[0032]

步骤2:对于训练集中的每组数据对,分别提取图像经过预训练模型输出的初始特征以及文本编码后的特征嵌入。

[0033]

图像特征提取这里关注于物体及实例级别的区域。使用在visual genomes数据集上预训练的resnet-101作为骨干网络的faster r-cnn,进行一种自下而上的检测。该网络可以预测属性类和实例类,提取原始图像特征的显著区域,并获取置信度排名前36的边界框作为图像嵌入。对于每个边界框i,fi被定义为该区域的平均池化特征并且其维数为2048。通过全连接层,将fi映射到潜在的公共空间以表示最终的k维向量。

[0034]

vi=w

vfi

bv[0035]

式中wv、bv是全连接层的参数。v={v1,v2,

…

,vn},vi∈rk是变换的结果表示公共空间中的图像特征,n代表每张图像有n个边界框,每个边界框为k维。

[0036]

为了连接视觉和语言领域,希望将文本映射到与图像区域相同的k维语义矢量空间。给定一个句子,最简单的方法是分别映射其中的每个单词。但此时每个单词为独热向量,表示字典中单词的索引,彼此独立没有相关性。因此这里使用词嵌入的方法考虑各单词间的联系。通过嵌入矩阵we将每个单词嵌入到一个300维向量中,xi=wewi,i∈[1,m]。然后,没有使用简单的线性映射,因为它不能有效地描述单词的上下文连接,而是使用了双向gru对文本特征进行编码,映射到与图像相同的联合子空间。

[0037][0038]

式中gruf代表前向gru,grub代表反向gru。最终的文本特征是对句子两个方向的信息进行平均得到的。

[0039]

步骤3:参见附图3自注意力推理,将两个模态特征映射到同一潜在公共空间,对图像分支进行其内部耦合关系的推理,利用自注意力机制计算各个局部边界框对于整体图像的贡献值融合为新的图像表征。

[0040]

该网络能够根据每个边界框对于整体图像所要表达“语义”的贡献,训练参数分配权重;其次各个边界框之间也可能存在“语义粘合”,不同区域可能最终指向一个意思,因此

要对它们进行特征再融合或是剔除其中不相关的部分。首先,将前面特征提取网络输出平坦化后的图像表征输入到两个串联的注意力模块s1、s2中。其次,对于计算一个序列里某个位置的响应,考虑取其之外所有位置在嵌入空间中的加权平均值来表示。然后,运用一个残差网络的捷径连接,避免层数增加带来的不利影响。最后增加一个全连接层将图像特征再次映射到联合子空间中。

[0041]

步骤4:设计交叉注意力层得到两种模态语义在对方语义空间中的表示,计算相似度,利用三元组损失函数进行训练,最终实现跨模态的语义对齐。

[0042]

采用跨模态交叉注意力机制对文本图像间的聚焦程度进行学习,实现局部特征间的对齐。计算原始区域vi及经过自注意力表征的与每个单词tj之间的注意力分数α

ij

、这决定了当前区域对所有单词的关注程度。参见附图4,演示了v1与对整个句子中每个单词计算一个权重,然后得到拥有区域关注的句子整体语义的表示用来度量其相似度。以此类推可以得到所有图像区域与句子间的相似度矩阵。

[0043][0044][0045]

式中,α

ij

、表示第i个区域和第j个单词之间的注意力分数。然后利用门控机制对两个注意力权重进行融合,得到当前区域所对应的句子语义,定义为单词与注意力权重的加权组合:

[0046][0047][0048][0049]

其中concat代表向量拼接操作,w1、w2代表全连接层参数,β

ij

是融合后的注意力分数。基于上述方法,得到最终的图像嵌入和文本嵌入t。对于图像i与文本t之间的语义相关性度量,取图像嵌入中所有区域特征与对应句子语义向量之间相关性的平均值:

[0050][0051]

其中r(.,.)代表余弦相似函数。

[0052]

在损失函数训练中重点是处理“困难”负样本。为了提高计算效率,通常只考虑随机梯度下降的小批量中的“困难”负样本,而不对所有负样本求和。这里使用最大铰链和损失来实现跨模态的图像-文本对齐。在一个小批量中,可以从图像到文本以及文本到图像两个方向进行查询。

[0053]

loss=[λ-s(i,t) s(i,t

′

)]

[λ-s(i,t) s(i',t)]

[0054]

式中,λ代表裕度,[x]

=max(x,0)。s(i,t)代表相匹配图像与文本之间的相似度s

(i,t'),s(i',t)则代表难例样本对之间的相似度t'=argmax

p≠t

s(i,p),i'=argmax

q≠i

s(q,t)。

[0055]

步骤5:模型验证,使用验证集对训练好的模型进行校验选择出最优的模型。迭代进行步骤2至步骤4,每隔1000步迭代在验证集上进行一次评估,并保留表现最好的模型。

[0056]

步骤6:模型评估,使用测试集对最优模型进行评估,得到其检索精度。

[0057]

具体地,将预处理好的测试集输入训练得到的最优模型,测试同时评估文本到图片和图片到文本两个方向的检索精度。比较查询得到的结果和真实标注的结果的差异,并计算召回率作为模型的评估指标。

[0058]

步骤7:图文互索,利用最终的最优模型实现图像和文本之间两个方向上的检索。

[0059]

将待查询的图片或文本分别进行特征提取后输入到最优模型中,得到该图片与所有文本或该文本与所有图片之间的匹配度分数矩阵,再对该矩阵进行分数从大到小的排序即可得到检索结果。

[0060]

本发明所提供的方法,在流行数据集flickr 30k和mscoco数据集上进行了验证。flickr 30k和mscoco数据集广泛用于图文匹配、图像检索以及图像字幕任务中。flickr30k包含31000张图片,每一张图片有五个对应的句子项。本发明使用1000张图片作为验证集,1000张图片作为测试集,其余用于训练。mscoco包含123287个图像,每个图像也对应着五个文本描述,其中113287张图像用作训练集,5000张图像用作验证集,5000个图像用作测试集。实验证明,本发明的方法相比于传统方法具有一定的优越性。

[0061]

综上所述,本发明通过自注意力推理可以剔除不相干信息带来的负面影响,以获取视觉分支更加精确的特征表达,在此基础上,为了使模态之间的对应关系更加显著,通过两个模态间的交叉注意力层进行进一步匹配,获取视觉语义在文本语义空间的特征表示和文本在视觉语义空间的特征表示,最终得到具有足够通用语义和准确性的多模态特征,从而有效地提高跨模态检索模型的方法的精确度和稳定性。

[0062]

对所公开的实施例的上述说明,使本领域专业技术人员能够实现或使用本发明。对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。