1.本发明涉及一种动作评判方法,具体涉及一种基于头部姿态捕捉与方位计算的匍匐战术动作评判方法。

背景技术:

2.头部姿态即头部的位置信息和方向信息。现有针对训练的头部姿态评价没有一套客观的通行标准,比如,匍匐前进训练时学员观察前方是否符合标准,目前评判手段主要是依靠作训主官通过先前经验进行人为判断。人为评判就会导致结果主观化较多、无法量化且无法大规模复制经验也导致评判效率较低。

技术实现要素:

3.本发明目的是解决现有针对训练的头部姿态评判没有一套客观量化的通行标准,往往靠作训主官通过先前经验判断,人为评判易导致评判结果主观化、结论无法量化且无法大规模复制经验使评判效率较低的技术问题,而提供一种基于人体头部姿态捕捉与方位计算的评判系统及方法。本发明是在一个全局坐标系统内通过图像识别的方法判断头部姿态的参数,通过人体头部姿态捕捉与方位计算技术,先采集得到学员头部姿态信息,然后对该姿态下所呈现的角度进行水平切面与垂直切面的分析,并计算得到偏航角度,最后通过设置阈值范围来限定或者判断学员头部姿态的偏航角是否符合训练大纲要求。本发明可以对训练者头部姿态进行客观评判且量化学员考核标准。

4.本发明的技术解决方案为:

5.一种基于头部姿态捕捉与方位计算的匍匐战术动作评判方法,其特殊之处在于,包括以下步骤:

6.1)构建第一主干网络,实时采集学员头部图像并识别学员头部图像;

7.2)计算头部方位角

8.2.1)构建第二主干网络,所述第二主干网络为resnet50主干网络;所述resnet50主干网络包括三个全连接层,所述三个全连接层分别对应头部方位角的偏航角、滚转角和俯仰角;所述resnet50主干网络的映射区间范围为[-99, 99];每个全连接层在所述映射区间范围内单独做预测,且单独做预测的全连接数均为二进制数;

[0009]

2.2)对构建的resnet50主干网络进行训练,得到训练后的resnet50主干网络,并获取实际标注数据;

[0010]

2.3)将步骤1)中识别的学员头部图像,输送至步骤2.2)训练后的resnet50主干网络进行头部方位角计算;

[0011]

2.3.1)将学员头部图像中头部方位角的偏航角、滚转角或俯仰角分别映射到[-99, 99]区间内,并分别将映射区间范围中-99到 99共199个数值依次进行分类,三个为一组,中间间隔作为离散类别;

[0012]

2.3.2)将步骤2.3.1)得到的离散类别通过softmax函数操作后归一化为概率值,

全连接层中所有离散类别数据的概率值相加为1;

[0013]

2.3.3)将步骤2.3.2)得到的概率值和对应的离散类别相乘并求和,得到期望值;通过期望值和实际标注数据的角度计算均方差,最终通过端到端训练输出头部方位角;

[0014]

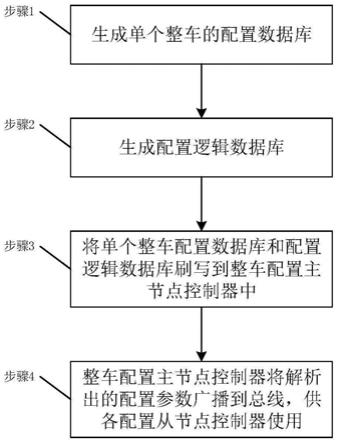

3)判断当前时刻头部方位角的偏航角、滚转角或俯仰角是否落入相应的设定范围内;若否,则按照扣分规则进行相应的扣分操作,并给出得分;若是,则直接给出得分。

[0015]

进一步地,所述步骤1具体为:

[0016]

1.1)构建第一主干网络,所述第一主干网络为darknet-53主干网络;所述darknet-53主干网络包括自输入端到输出端依次连接的多个卷积块和全连接层;每个卷积块包括依次连接的卷积层、并行设置的批归一化层和激活层;所述卷积层由1x1和3x3的卷积核组成;当卷积的步长默认为1时,填充默认为一致;当卷积步长为2时,填充为有效;

[0017]

1.2)将darknet-53主干网络进行下采样,每次采样步长为1或2;然后将darknet-53主干网络的中间层和倒数第二层的上采样进行拼接,形成新的优化网络,用于不断迭代新的样本训练学习,得到头部模型;

[0018]

1.3)通过损失函数优化训练头部模型;所述损失函数为目标定位偏移量损失、目标置信度损失以及目标分类损失中的一种或多种;

[0019]

1.4)采集待考核学员头部图像信息,输送至头部模型,识别学员头部图像。

[0020]

进一步地,步骤1.2)中,所述darknet-53主干网络进行了5次下采样,每次采样步长为2,将输出特征图缩小到原图的1/32。

[0021]

进一步地,步骤2.1)中,所述resnet50主干网络的输出先被映射到0~99这个区间范围内,然后再将映射值乘以3后再减去99,使区间范围被映射到[-99, 99]这个区间范围。

[0022]

进一步地,步骤2.3.1)中所述将映射区间范围中-99到 99共199个数值依次进行分类具体为,包含起点-99度,终点设为102度且不包含102度,每3个数为一个间隔,共66个间隔。

[0023]

本发明的有益效果:

[0024]

1、本发明可实时抓取被测试者在匍匐前进中头部的位置信息和方向信息,比如头部偏航、俯仰和滚转姿态,同时可量化考核信息并快速分析评判被测试者匍匐前进动作是否违规。

[0025]

2、本发明结合采用darknet-53主干网络和resnet50主干网络,得到人体头部姿态检测与识别主干网络模型以及头部方位角计算模型,很好的平衡了计算量和准确率,可在不增加额外的计算开销的同时,保证准确率且提高网络模型的效率,在此基础上,本发明方法计算速率比传统方法快2~3倍。

[0026]

3、本发明通过采集头部姿态信息,并通过人工智能进行数据分析从而对士兵训练进行客观、准确的评判。

[0027]

4、本发明智能高效,可以快速且准确的实现多任务的头部姿态估计。

附图说明

[0028]

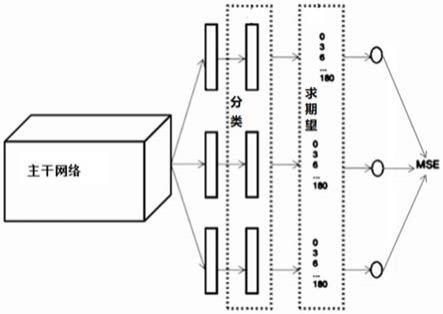

图1是resnet50主干网络的网络结构示意图,图中mse为均方差。

具体实施方式

[0029]

下面通过结合附图和实施例对本发明做详细的说明。

[0030]

本发明一种基于头部姿态捕捉与方位计算的匍匐战术动作评判方法,包括以下步骤:

[0031]

1)构建第一主干网络,实时采集学员头部图像并识别学员头部图像;

[0032]

1.1)构建第一主干网络,第一主干网络为darknet-53主干网络;;

[0033]

darknet-53主干网络包括自输入端到输出端依次连接的多个卷积块和全连接层;每个卷积块包括依次连接的卷积层、并行设置的批归一化层和激活层;卷积层由1x1和3x3的卷积核组成;当卷积的步长默认为1时,填充(padding)默认为一致;当卷积步长为2时,填充(padding)为有效。darknet-53主干网络结构中有52个卷积层,最后一个是全连接层,一共53层,具体如表1所示。

[0034]

表1 darknet-53主干网络结构

[0035][0036]

1.2)将darknet-53主干网络进行5次下采样,每次采样步长为2,将输出特征图缩小到原图的1/32,使特征图既不会太大,也不会太小,有利于模型训练的开展;然后将darknet-53主干网络的中间层和倒数第二层的上采样进行拼接,形成新的优化网络,用于不断迭代新的样本训练学习,得到头部模型;

[0037]

1.3)通过损失函数优化训练头部模型;损失函数为目标定位偏移量损失、目标置信度损失以及目标分类损失中的一种或多种。

[0038]

当有目标中心落入网格时,实际是计算目标分类损失,目标置信度损失,预测框与

实际标注数据的iou(图像分割指标)较大的那个预测框坐标信息的损失。当没有物体中心落入网格时,只需要计算置信度损失。当置信度较大时,则说明物体中心存在改网格中,则再计算目标定位损失和目标分类损失才有意义。

[0039]

1.4)采集待考核学员头部图像信息,输送至头部模型,识别学员头部图像;

[0040]

2)计算头部方位角;

[0041]

2.1)构建第二主干网络,第二主干网络为resnet50主干网络;

[0042]

如图1所示,resnet50主干网络包括三个全连接层,三个全连接层分别对应头部方位角的偏航角、滚转角和俯仰角;resnet50主干网络的映射区间范围为[-99, 99];每个全连接层在所述映射区间范围内单独做预测,且单独做预测的全连接数均为bin数(二进制数);resnet50主干网络的输出先被映射到0~99这个区间范围内,然后再将映射值乘以3后再减去99,使区间范围被映射到[-99, 99]这个区间范围。

[0043]

2.2)对构建的resnet50主干网络进行训练,得到训练后的resnet50主干网络,并获取实际标注数据;

[0044]

2.3)将步骤1.4中识别的学员头部图像,输送至步骤2.2)训练后的resnet50主干网络进行头部方位角计算;

[0045]

2.3.1)将学员头部图像中偏航角、滚转角或俯仰角分别映射到[-99, 99]区间内,并分别将映射区间范围中-99到 99共199个数值依次进行分类,三个为一组,中间间隔作为离散类别;分类时,包含起点-99度,终点设为102度且不包含102度,每3个数为一个间隔,共66个间隔。

[0046]

2.3.2)将步骤2.3.1)得到的离散类别通过softmax函数后归一化为概率值,全连接层中所有离散类别数据的概率值相加为1;

[0047]

2.3.3)将步骤2.3.2)得到的概率值和对应的离散类别相乘并求和,得到期望值;通过期望值和实际标注数据的角度计算均方差,同时使用交叉损失熵对步骤2.3.1)得到的离散类别计算损失;最终通过端到端训练输出头部方位角;

[0048]

3)判断当前时刻头部方位角的偏航角、滚转角或俯仰角是否落入相应的设定范围内;若否,则按照扣分规则进行相应的扣分操作,并给出得分;若是,则直接给出得分。相应的设定范围根据经验给定。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。