1.本发明涉及自然语言处理技术领域,尤其涉及基于时序交互图神经网络的文本分类方法、装置及介质。

背景技术:

2.在如今这样一个信息爆炸的大环境下,如何快速高效地从缤纷繁杂的文本信息中辨别其分类类别,这是一个兼具实用价值以及挑战性的技术问题。文本分类方法可以用于解决上述问题,而文本分类的核心在于如何获得一个更高质量的文本表示。对于此类问题,可以使用机器学习算法进行解决,比如:逻辑回归、支持向量机以及决策树等,但机器学习算法提取文本特征的能力有待增强。深度学习算法也可以应用于文本分类任务中,比如:textcnn、fast以及bert等,但深度学习方法的局限性在于文本表示能力不够完善以及模型训练成本较高。图神经网络是一种用于处理非欧式空间数据的一种端到端的学习范式,在处理复杂结构和保存全局信息等方面表现出良好的性能,能有效地改善上述算法的不足。对于文本数据,其内部结构可看作是复杂的语法树结构的组合,而树结构又是图结构的一种特殊形式,因此可以将图神经网络应用于文本分类任务中。

3.但现有的用于解决文本分类任务的图神经网络存在一些局限性,比如:将文本数据构建为图结构数据时对节点与边的关系建立方法较为简化、图神经网络在提取文本特征时存在过度平滑问题、图读出器函数的文本表达能力不足等问题。在构建图结构数据时,通常会考虑一个滑动窗口之内的单词的关系,但单词之间的先后关系以及相对位置距离也很重要;在使用迭代式的图神经网络提取文本特征时,随着网络层数量的增加,虽然能获得更多局部邻近节点的信息,但却容易出现过度平滑问题;在获取高层次文本表示时,图读出器函数可以利用注意力机制进行增强。

技术实现要素:

4.本发明的主要目的在于提出一种基于时序交互图神经网络的文本分类方法、装置及介质,旨在增强图神经网络的特征提取能力,改善图读出器函数对文本数据的表达以及分类,降低图神经网络出现过度平滑问题出现的概率。

5.为实现上述目的,本发明提供一种基于时序交互图神经网络的文本分类方法,所述基于时序交互图神经网络的文本分类方法包括如下步骤:

6.获取文本数据以及所述文本数据对应的标签值,并将所述文本数据构建为自适应图结构数据,其中所述自适应图结构数据包括图节点集合和图有向边集合;

7.基于所述自适应距离权重算法对所述图节点集合和所述图有向边集合进行处理,得到输入特征矩阵;

8.将所述输入特征矩阵和所述标签值输入到时序交互图神经网络模型中,得到所述文本数据的总损失值;

9.基于所述总损失值、交叉熵损失函数和梯度下降算法对所述时序交互图神经网络

模型的模型参数进行更新优化,得到训练文本分类模型;

10.获取待分类文本数据;

11.将所述待分类文本数据输入所述训练文本分类模型,得到文本分类结果。

12.可选地,所述将所述文本数据构建为自适应图结构数据的步骤,包括:

13.将所述文本数据中的每个单词作为图节点集合;

14.将所述单词之间的共现关系作为图有向边集合。

15.可选地,所述基于所述自适应距离权重算法对所述图节点集合和所述图有向边集合进行处理,得到输入特征矩阵的步骤,包括:

16.根据所述图节点集合和所述图有向边集合,得到邻接矩阵和节点距离矩阵;

17.根据所述邻接矩阵得到单位矩阵;

18.基于自适应距离权重算法对所述节点距离矩阵进行处理,得到自适应距离权重矩阵;

19.根据第一可学习参数矩阵、第一可学习偏置项以及所述单位矩阵、所述自适应距离权重矩阵,得到输入特征矩阵;

20.可选地,其中,自适应距离权重矩阵由公式得到的;w

i,j

是自适应距离权重矩阵中的第i行第j列元素,表示第i个单词与第j个单词的权重;d

i,j

是节点距离矩阵中的第i行第j列元素,表示文本中第i个单词与第j个单词之间含有单词的数量加一;i表示邻接矩阵中的行号,n表示节点集中单词的数量;

21.其中,输入特征矩阵x=wko hi bh;

22.其中,o为第一可学习参数矩阵,i为单位矩阵,h为第一可学习参数项,bh为第一课学习偏置项,wk为相邻节点的自适应距离权重矩阵。

23.可选地,所述将所述输入特征矩阵和所述标签值输入到时序交互图神经网络模型中,得到所述文本数据的总损失值的步骤,包括:

24.将所述输入特征矩阵输入时序交互图卷积网络,并根据所述邻接矩阵、所述单位矩阵和所述节点距离矩阵得到时序交互卷积状态矩阵;

25.将所述输入特征矩阵输入时序交互门控图神经网络,并根据所述邻接矩阵、所述单位矩阵和所述节点距离矩阵得到时序交互门控状态矩阵;

26.根据所述时序交互卷积状态矩阵和所述时序交互门控状态矩阵,得到增强特征矩阵;

27.根据所述增强特征矩阵、所述时序交互卷积状态矩阵和所述时序交互门控状态矩阵得到交互注意力;

28.根据所述交互注意力和所述标签值得到所述文本数据的总损失值。

29.可选地,所述将所述输入特征矩阵输入时序交互图卷积网络,并根据所述邻接矩阵、所述单位矩阵和所述节点距离矩阵得到时序交互卷积状态矩阵的步骤,包括:

30.31.c

l

=φ(αcac

l-1

wc βcs

cl

wg γc);

32.其中,为时序交互卷积缓存,ci为历史网络层隐藏状态,l为时序交互图卷积网络迭代的次数;c

l

为时序交互卷积状态矩阵,φ为tanh激活函数,a为对称归一化邻接矩阵,其中,d为节点距离矩阵,a为所述邻接矩阵,i为单位矩阵;αc为第一可学习参数项,βc为第二可学习参数项,λi为第三可学习参数项,wc为第二可学习参数矩阵,wg为第三可学习参数矩阵,γc为第二可学习偏置项;

33.所述将所述输入特征矩阵输入时序交互门控图神经网络,并根据所述邻接矩阵、所述单位矩阵和所述节点距离矩阵得到时序交互门控状态矩阵的步骤,包括:

34.ak=at

k-1

wa;

35.zk=σ(w

zak

uzt

k-1

bz);

36.rk=σ(w

rak

urt

k-1

br);

[0037][0038][0039][0040][0041]

其中,ak为借助对称归一化邻接矩阵得到的图特征聚合变量,σ表示sigmoid函数,wa为第四可学习参数矩阵,wz为第五可学习参数矩阵,uz为第六可学习参数矩阵,wr为第七可学习参数矩阵,ur为第八可学习参数矩阵,w

t

为第九可学习参数矩阵,u

t

为第十可学习参数矩阵,bz为第三可学习偏置项,br为第四可学习偏置项,b

t

第五可学习偏置项,

⊙

为两个矩阵对应位置的元素相乘;α

t

为第四可学习参数项,β

t

为第五可学习参数项,ωj为第六可学习参数项,wr为第十一可学习参数矩阵,θ

t

第六可学习偏置项,tk为内部状态,zk为更新门,rk为重置门,为候选状态,为时序交互门控缓存,tk为时序交互门控图神经网络内部状态,tk为时序交互门控状态矩阵;

[0042]

所述根据所述时序交互卷积状态矩阵和所述时序交互门控状态矩阵,得到增强特征矩阵的步骤,包括:

[0043][0044]va

=wah ba;

[0045]

其中,表示通过时序交互图卷积网络额网络层提取到的时序交互卷积状态矩阵的第i个特征向量,表示通过时序交互门控图神经网络的网络层提取到的时序交互门控状态矩阵tk的第i个特征向量,||表示向量的拼接;

为拼接得的特征矩阵;wa为第十二可学习参数矩阵,ba为第七可学习偏置项,va为增强特征矩阵;

[0046]

其中,交互注意力

[0047]

δ表示softmax函数,n为节点集中单词的数量,sa为交互注意力。

[0048]

可选地,所述根据所述交互注意力和所述标签值得到所述文本数据的总损失值的步骤,包括:

[0049]

根据所述交互注意力得到全连接层隐藏特征;

[0050]

根据所述全连接层隐藏特征计算得到分类概率;

[0051]

根据所述分类概率和所述标签值得到所述文本数据的总损失值。

[0052]

可选地,所述全连接层隐藏特征p=φ(sa)wm;

[0053]

φ为激活函数,wm为第十三可学习参数矩阵,sa为交互注意力;

[0054]

所述根据所述全连接层隐藏特征计算得到分类概率的步骤,包括:

[0055][0056]

f=δ(wfg bf);

[0057]

其中,g为图节点使用均值聚合后的图层次表示,v表示图节点集合中的某一具体节点,f为分类概率,δ为softmax函数;bf为第七可学习偏置项、wf为第十四可学习参数矩阵;

[0058]

其中,所述总损失值

[0059]

其中,y为所述文本数据的标签值。

[0060]

此外,为实现上述目的,本发明还提供一种文本分类装置,所述文本分类装置包括:存储器、处理器及存储在所述存储器上并可在所述处理器上运行的文本分类程序,所述文本分类程序被所述处理器执行时实现如上所述的文本分类方法的步骤。

[0061]

此外,为实现上述目的,本发明还提供一种介质,所述介质上存储有文本分类程序,所述文本分类程序被处理器执行时实现如上所述的文本分类方法的步骤。

[0062]

本发明提供了一种基于时序交互图神经网络的文本分类方法、装置及介质。获取文本数据以及所述文本数据对应的标签值,并将所述文本数据构建为自适应图结构数据,其中所述自适应图结构数据包括图节点集合和图有向边集合;基于所述自适应距离权重算法对所述图节点集合和所述图有向边集合进行处理,得到输入特征矩阵;将所述输入特征矩阵和所述标签值输入到时序交互图神经网络模型中,得到所述文本数据的总损失值;基于所述总损失值、交叉熵损失函数和梯度下降算法对所述时序交互图神经网络模型的模型参数进行更新优化,得到训练文本分类模型。通过上述方式,本发明能够实现了增强图神经网络的特征提取能力,改善了图读出器函数对文本数据的表达以及分类,降低了图神经网络出现过度平滑问题出现的概率。

[0063]

本发明在构建图结构数据时,不仅考虑了一个滑动窗口中单词的关系,还引入了

单词间的词序关系以及相对位置距离,丰富了单词之间的结构信息,完善了图中节点与边的关系。

[0064]

本发明可以在增强图神经网络的特征提取能力的同时,缓解过度平滑问题。对图卷积网络和门控图神经网络进行改进,引入多个历史状态的信息,结合参数矩阵来缓解过度平滑问题。另外,结合两种改进的图神经网络来提取不同层次的文本特征,以提高特征的区分度。

[0065]

本发明设计了根据两种不同的图神经网络设计了一种交互注意力机制,用于从多个角度提升文本中关键词的重要度,使得图读出器函数输出更高质量的文本表示。

附图说明

[0066]

图1是本发明实施例方案涉及的硬件运行环境的终端结构示意图;

[0067]

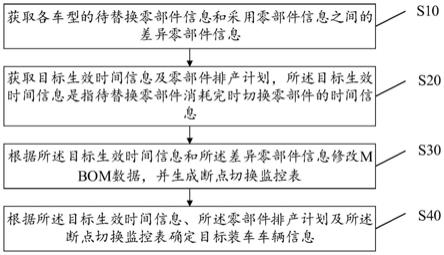

图2为本发明基于时序交互图神经网络的文本分类方法第一实施例的流程示意图;

[0068]

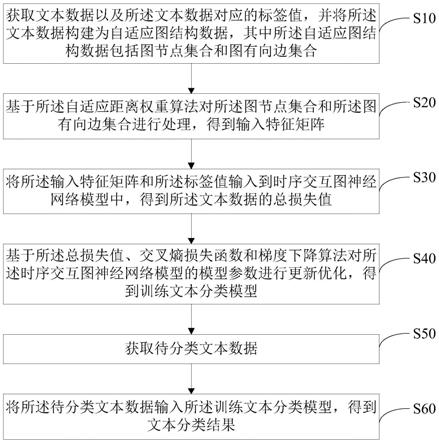

图3为本发明训练文本分类模型的结构示意图。

[0069]

本发明目的的实现、功能特点及优点将结合实施例,参照附图做进一步说明。

具体实施方式

[0070]

如图1所示,图1是本发明实施例方案涉及的硬件运行环境的终端结构示意图。

[0071]

本发明实施例终端可以是pc,也可以是智能手机、平板电脑等具有显示功能的可移动式终端设备。

[0072]

如图1所示,该终端可以包括:处理器1001,例如cpu,网络接口1004,用户接口1003,存储器1005,通信总线1002。其中,通信总线1002用于实现这些组件之间的连接通信。用户接口1003可以包括显示屏(display)、输入单元比如键盘(keyboard),可选用户接口1003还可以包括标准的有线接口、无线接口。网络接口1004可选的可以包括标准的有线接口、无线接口(如wi-fi接口)。存储器1005可以是高速ram存储器,也可以是稳定的存储器(non-volatile memory),例如磁盘存储器。存储器1005可选的还可以是独立于前述处理器1001的存储装置。

[0073]

优选地,终端还可以包括摄像头、rf(radio frequency,射频)电路,传感器、音频电路、wifi模块等等。其中,传感器比如光传感器、运动传感器以及其他传感器。具体地,光传感器可包括环境光传感器及接近传感器,其中,环境光传感器可根据环境光线的明暗来调节显示屏的亮度,接近传感器可在移动终端移动到耳边时,关闭显示屏和/或背光。作为运动传感器的一种,重力加速度传感器可检测各个方向上(一般为三轴)加速度的大小,静止时可检测出重力的大小及方向,可用于识别移动终端姿态的应用(比如横竖屏切换、相关游戏、磁力计姿态校准)、振动识别相关功能(比如计步器、敲击)等;当然,移动终端还可配置陀螺仪、气压计、湿度计、温度计、红外线传感器等其他传感器,在此不再赘述。

[0074]

本领域技术人员可以理解,图1中示出的终端结构并不构成对终端的限定,可以包括比图示更多或更少的部件,或者组合某些部件,或者不同的部件布置。

[0075]

如图1所示,作为一种计算机存储介质的存储器1005中可以包括操作系统、网络通信模块、用户接口模块以及文本分类程序。

[0076]

在图1所示的终端中,网络接口1004主要用于连接后台服务器,与后台服务器进行数据通信;用户接口1003主要用于连接客户端(用户端),与客户端进行数据通信;而处理器1001可以用于调用存储器1005中存储的文本分类程序,并执行以下操作:

[0077]

获取文本数据以及所述文本数据对应的标签值,并将所述文本数据构建为自适应图结构数据,其中所述自适应图结构数据包括图节点集合和图有向边集合;

[0078]

基于所述自适应距离权重算法对所述图节点集合和所述图有向边集合进行处理,得到输入特征矩阵;

[0079]

将所述输入特征矩阵和所述标签值输入到时序交互图神经网络模型中,得到所述文本数据的总损失值;

[0080]

基于所述总损失值、交叉熵损失函数和梯度下降算法对所述时序交互图神经网络模型的模型参数进行更新优化,得到训练文本分类模型;

[0081]

获取待分类文本数据;

[0082]

将所述待分类文本数据输入所述训练文本分类模型,得到文本分类结果。

[0083]

进一步地,处理器1001可以调用存储器1005中存储的文本分类程序,在执行将文本数据构建为自适应图结构数据操作时,具体执行如下操作:

[0084]

将所述文本数据中的每个单词作为图节点集合;

[0085]

将所述单词之间的共现关系作为图有向边集合。

[0086]

进一步地,处理器1001可以调用存储器1005中存储的文本分类程序,在执行基于所述自适应距离权重算法对所述图节点集合和所述图有向边集合进行处理,得到输入特征矩阵操作时,具体执行如下操作:

[0087]

根据所述图节点集合和所述图有向边集合,得到邻接矩阵和节点距离矩阵;

[0088]

根据所述邻接矩阵得到单位矩阵;

[0089]

基于自适应距离权重算法对所述节点距离矩阵进行处理,得到自适应距离权重矩阵;

[0090]

根据第一可学习参数矩阵、第一可学习偏置项以及所述单位矩阵、所述自适应距离权重矩阵,得到输入特征矩阵;

[0091]

进一步地,其中,自适应距离权重矩阵由公式得到的;w

i,j

是自适应距离权重矩阵中的第i行第j列元素,表示第i个单词与第j个单词的权重;d

i,j

是节点距离矩阵中的第i行第j列元素,表示文本中第i个单词与第j个单词之间含有单词的数量加一;i表示邻接矩阵中的行号,n表示节点集中单词的数量;

[0092]

其中,输入特征矩阵x=wko hi bh;

[0093]

其中,o为第一可学习参数矩阵,i为单位矩阵,h为第一可学习参数项,bh为第一课学习偏置项,wk为相邻节点的自适应距离权重矩阵。

[0094]

进一步地,处理器1001可以调用存储器1005中存储的文本分类程序,在执行将所述输入特征矩阵和所述标签值输入到时序交互图神经网络模型中,得到所述文本数据的总损失值操作时,具体执行如下操作:

[0095]

将所述输入特征矩阵输入时序交互图卷积网络,并根据所述邻接矩阵、所述单位

矩阵和所述节点距离矩阵得到时序交互卷积状态矩阵;

[0096]

将所述输入特征矩阵输入时序交互门控图神经网络,并根据所述邻接矩阵、所述单位矩阵和所述节点距离矩阵得到时序交互门控状态矩阵;

[0097]

根据所述时序交互卷积状态矩阵和所述时序交互门控状态矩阵,得到增强特征矩阵;

[0098]

根据所述增强特征矩阵、所述时序交互卷积状态矩阵和所述时序交互门控状态矩阵得到交互注意力;

[0099]

根据所述交互注意力和所述标签值得到所述文本数据的总损失值。

[0100]

进一步地,

[0101]cl

=φ(αcac

l-1

wc βcs

cl

wg γc);

[0102]

其中,为时序交互卷积缓存,ci为历史网络层隐藏状态,l为时序交互图卷积网络迭代的次数;c

l

为时序交互卷积状态矩阵,φ为tanh激活函数,a为对称归一化邻接矩阵,其中,d为节点距离矩阵,a为所述邻接矩阵,i为单位矩阵;αc为第一可学习参数项,βc为第二可学习参数项,λi为第三可学习参数项,wc为第二可学习参数矩阵,wg为第三可学习参数矩阵,γc为第二可学习偏置项;

[0103]

进一步地,ak=at

k-1

wa;

[0104]

zk=σ(w

zak

uzt

k-1

bz);

[0105]rk

=σ(w

rak

urt

k-1

br);

[0106][0107][0108][0109][0110]

其中,ak为借助对称归一化邻接矩阵得到的图特征聚合变量,σ表示sigmoid函数,wa为第四可学习参数矩阵,wz为第五可学习参数矩阵,uz为第六可学习参数矩阵,wr为第七可学习参数矩阵,ur为第八可学习参数矩阵,w

t

为第九可学习参数矩阵,u

t

为第十可学习参数矩阵,bz为第三可学习偏置项,br为第四可学习偏置项,b

t

第五可学习偏置项,

⊙

为两个矩阵对应位置的元素相乘;α

t

为第四可学习参数项,β

t

为第五可学习参数项,ωj为第六可学习参数项,wr为第十一可学习参数矩阵,θ

t

第六可学习偏置项,tk为内部状态,zk为更新门,rk为重置门,为候选状态,为时序交互门控缓存,tk为时序交互门控图神经网络内部状态,tk为时序交互门控状态矩阵;

[0111]

进一步地,

[0112]va

=wah ba;

[0113]

其中,表示通过时序交互图卷积网络额网络层提取到的时序交互卷积状态矩阵的第i个特征向量,表示通过时序交互门控图神经网络的网络层提取到的时序交互门控状态矩阵tk的第i个特征向量,||表示向量的拼接;为拼接得的特征矩阵;wa为第十二可学习参数矩阵,ba为第七可学习偏置项,va为增强特征矩阵;

[0114]

进一步地,其中,交互注意力

[0115]

δ表示softmax函数,n为节点集中单词的数量,sa为交互注意力。

[0116]

进一步地,处理器1001可以调用存储器1005中存储的文本分类程序,在执行根据所述交互注意力和所述标签值得到所述文本数据的总损失值操作时,具体执行如下操作:

[0117]

根据所述交互注意力得到全连接层隐藏特征;

[0118]

根据所述全连接层隐藏特征计算得到分类概率;

[0119]

根据所述分类概率和所述标签值得到所述文本数据的总损失值。

[0120]

进一步地,其中,所述全连接层隐藏特征p=φ(sa)wm;

[0121]

φ为激活函数,wm为第十三可学习参数矩阵,sa为交互注意力;

[0122]

所述根据所述全连接层隐藏特征计算得到分类概率的步骤,包括:

[0123][0124]

f=δ(wfg bf);

[0125]

其中,g为图节点使用均值聚合后的图层次表示,v表示图节点集合中的某一具体节点,f为分类概率,δ为softmax函数;bf为第七可学习偏置项、wf为第十四可学习参数矩阵;

[0126]

其中,所述总损失值

[0127]

其中,y为所述文本数据的标签值。

[0128]

基于上述硬件结构,提出本发明基于时序交互图神经网络的文本分类方法实施例。

[0129]

参照图2,图2为本发明基于时序交互图神经网络的文本分类方法第一实施例的流程示意图。

[0130]

本发明实施例中,该基于时序交互图神经网络的文本分类方法应用于文本分类装置,所述基于时序交互图神经网络的文本分类方法包括:

[0131]

步骤s10,获取文本数据以及所述文本数据对应的标签值,并将所述文本数据构建为自适应图结构数据,其中所述自适应图结构数据包括图节点集合和图有向边集合;

[0132]

在本实施例中,为了增强图神经网络的特征提取能力,改善图读出器函数对文本数据的表达以及分类,降低图神经网络出现过度平滑问题出现的概率;文本分类装置首先获取文本数据以及所述文本数据对应的标签值,并将所述文本数据构建为自适应图结构数据。其中所述自适应图结构数据包括图节点集合v和图有向边集合e。标签值可以为科技、人文等,也即是文本数据的分类可以为科技类、或者人文类等。

[0133]

步骤s10将所述文本数据构建为自适应图结构数据,可以包括:

[0134]

步骤s11,将所述文本数据中的每个单词作为图节点集合;

[0135]

在本实施例中,文本分类装置在获取了文本数据以及所述文本数据对应的标签值之后,将所述文本数据中的每个单词作为图节点集合v;

[0136]

步骤s12,将所述单词之间的共现关系作为图有向边集合;

[0137]

在本实施例中,文本分类装置在获取了文本数据以及所述文本数据对应的标签值之后,将所述单词之间的共现关系作为图有向边集合e;其中,所述共现关系为在一个长度动态变化的滑动窗口中所同时存在的所述单词之间的关系;其中,所述滑动窗口的长度为所述文本数据中含有的节点数量的三分之一。(滑动窗口的长度至少为1)。其中,节点是由句子分词并去重后得到的单词构成;一个节点表示去重后的一个单词。由此根据图节点集合v和图有向边集合e构建出一个自适应的有向图结构(即自适应图结构数据)。滑动窗口的长度根据图的一个节点数来变化,比如说这句文本数据里面,它有三个单词(节点),它有五个单词(节点)和有十个单词(节点),然后滑动窗口的长度是不一样的,(在确定滑动窗口的长度之前,先对这句文本进行分词,然后去除里面的重复单词,得到的是若干个不重复的单词,也即是得到的是若干个节点)。滑动窗口的长度只是会根据节点文本的单词的数量来变化。假如节点文本中有十个单词,滑动窗口的长度就为10乘以三分之一。在构建图结构数据时,不仅考虑了一个滑动窗口中单词的关系,还引入了单词间的词序关系以及相对位置距离,丰富了单词之间的结构信息,完善了图中节点与边的关系。

[0138]

步骤s20,基于所述自适应距离权重算法对所述图节点集合和所述图有向边集合进行处理,得到输入特征矩阵;

[0139]

在本实施例中,文本分类装置在得到了图节点集合v和图有向边集合e之后,基于所述自适应距离权重算法对所述图节点集合和所述图有向边集合进行处理,得到输入特征矩阵。

[0140]

步骤s20基于所述自适应距离权重算法对所述图节点集合和所述图有向边集合进行处理,得到输入特征矩阵,可以包括:

[0141]

步骤s21,根据所述图节点集合和所述图有向边集合,得到邻接矩阵a和节点距离矩阵d;

[0142]

在本实施例中,文本分类装置在得到了图节点集合v和图有向边集合e之后,根据所述图节点集合v和所述图有向边集合e,得到邻接矩阵a和节点距离矩阵d;其中,节点距离矩阵d是与单词相关的节点距离矩阵d,与单词相关的节点距离矩阵d是根据滑动窗口内单词之间的共现关系计算出的,也即是节点距离矩阵d是通过单词之间的位置关系计算得到的。

[0143]

步骤s22,根据所述邻接矩阵得到单位矩阵;

[0144]

在本实施例中,文本分类装置在得到了邻接矩阵a之后,根据所述邻接矩阵a得到单位矩阵;其中,单位矩阵i与邻接矩阵a相对应。

[0145]

步骤s23,基于自适应距离权重算法对所述节点距离矩阵进行处理,得到自适应距离权重矩阵;

[0146]

在本实施例中,文本分类装置在得到了节点距离矩阵d之后,根据自适应距离权重算法对所述节点距离矩阵d进行处理,得到相邻节点的自适应距离权重矩阵wk;

[0147]

其中,自适应距离权重矩阵wk由公式得到的;w

i,j

是wk中的第i行第j列元素,表示第i个单词与第j个单词的权重;d

i,j

是节点距离矩阵d中的第i行第j列元素,表示文本中第i个单词与第j个单词之间含有单词的数量加一;i表示邻接矩阵中的行号,n表示节点集中单词的数量。

[0148]

步骤s24,根据第一可学习参数矩阵、第一可学习偏置项以及所述单位矩阵、所述自适应距离权重矩阵,得到输入特征矩阵。

[0149]

在本实施例中,文本分类装置在得到了单位矩阵i和节点距离矩阵d之后,根据第一可学习参数矩阵o、第一可学习偏置项bh以及所述单位矩阵i、所述自适应距离权重矩阵wk,得到输入特征矩阵x。

[0150]

其中,输入特征矩阵x=wko hi bh;

[0151]

其中,o为第一可学习参数矩阵,i为单位矩阵,h为第一可学习参数项,bh为第一课学习偏置项,wk为相邻节点的自适应距离权重矩阵。

[0152]

步骤s30,将所述输入特征矩阵和所述标签值输入到时序交互图神经网络模型中,得到所述文本数据的总损失值;

[0153]

在本实施例中,文本分类装置在得到了输入特征矩阵、邻接矩阵、单位矩阵、节点距离矩阵和标签值之后,将所述输入特征矩阵、所述邻接矩阵、所述单位矩阵、所述节点距离矩阵和所述标签值输入到时序交互图神经网络模型中,得到所述文本数据的总损失值。本实施例可以在增强图神经网络的特征提取能力的同时,缓解过度平滑问题。对图卷积网络和门控图神经网络进行改进,引入多个历史状态的信息,结合参数矩阵来缓解过度平滑问题。另外,结合两种改进的图神经网络来提取不同层次的文本特征,以提高特征的区分度。其中,如图3所示,训练文本分类模型为时序交互图神经网络模型。其中,时序交互图神经网络模型包括依次顺序连接自适应图结构数据构建层、自适应距离权重计算层、以及两个并列的时序交互图卷积网络和时序交互门控图神经网络、交互注意力计算层以及总损失值计算层。时序交互图神经网络模型的具体结构示意图还可以参考步骤s30和步骤s40的所有细化步骤。时序交互图神经网络模型训练时执行步骤s30和步骤s40的所有细化步骤。时序交互图神经网络模型测试和预测时(即执行步骤s60时)都执行步骤s31、步骤s32、步骤s33、步骤s34、步骤s351、步骤s352的所有细化步骤,得到分类概率,即概率最大的文本数据的类别作为预测结果。

[0154]

步骤s30将所述输入特征矩阵和所述标签值输入到时序交互图神经网络模型中,得到所述文本数据的总损失值,可以包括:

[0155]

步骤s31,将所述输入特征矩阵输入时序交互图卷积网络,并根据所述邻接矩阵、所述单位矩阵和所述节点距离矩阵得到时序交互卷积状态矩阵;

[0156]

在本实施例中,文本分类装置在得到了输入特征矩阵、邻接矩阵、单位矩阵和节点距离矩阵之后,将所述输入特征矩阵x输入时序交互图卷积网络sigcn,并根据所述邻接矩阵、所述单位矩阵和所述节点距离矩阵得到时序交互卷积状态矩阵c

l

;在图卷积网络gcn中,随着网络层层数的增加,网络迭代时会使得中心节点的信息损失越多,导致包含中心节点的连通分量存在局部的过度平滑问题。为了在接收高阶邻居节点信息的同时,突显中心节点本身的信息,因此使用时序交互图卷积网络sigcn来缓解上述问题。时序交互卷积缓存是显式地给当前网络层添加前面若干网络层的历史隐藏状态,来增强当前网络层。时序交互卷积状态矩阵c

l

是将gcn的多层参数矩阵替换为参数共享的单层参数矩阵,以减少网络出现过拟合问题的风险。

[0157]

步骤s31将所述输入特征矩阵输入时序交互图卷积网络,并根据所述邻接矩阵、所述单位矩阵和所述节点距离矩阵得到时序交互卷积状态矩阵,可以包括:

[0158][0159]cl

=φ(αcac

l-1

wc βcs

cl

wg γc);

[0160]

其中,为时序交互卷积缓存,ci为历史网络层隐藏状态,l为时序交互图卷积网络迭代的次数;初始迭代时有c0=x,l表示网络最多的迭代次数,l≥1。c

l

为时序交互卷积状态矩阵,φ为tanh激活函数,a为对称归一化邻接矩阵,其中,d为节点距离矩阵,a为所述邻接矩阵,i为所述邻接矩阵a对应的单位矩阵;αc为时序交互图卷积网络sigcn可学习的第一可学习参数项,βc为第二可学习参数项,λi为第三可学习参数项,λi每个网络隐藏层的权重,是可学习的参数项,wc为第二可学习参数矩阵,wg为第三可学习参数矩阵,γc为第二可学习偏置项;

[0161]

步骤s32,将所述输入特征矩阵输入时序交互门控图神经网络,并根据所述邻接矩阵、所述单位矩阵和所述节点距离矩阵得到时序交互门控状态矩阵;

[0162]

在本实施例中,文本分类装置在得到了输入特征矩阵、邻接矩阵、单位矩阵和节点距离矩阵之后,将所述输入特征矩阵输入时序交互门控图神经网络siggnn,并根据所述邻接矩阵、所述单位矩阵和所述节点距离矩阵得到时序交互门控状态矩阵tk。门控图神经网络ggnn的优势在于能有效捕捉文本中的上下文依赖关系,但迭代式的训练方法使得其在提取隐藏特征时也存在连通分量的局部过度平滑问题。为了增强中心节点的信息,同样引入了多步历史状态来增强当前网络层状态并缓解过度平滑问题。不同的是,根据ggnn网络层特性,siggnn将网络层的历史隐藏状态引入在使用更新门单元和重置门单元对隐藏特征提取完成之后,以保证在增强本网络层隐藏特征的同时,避免对节点间的正常信息传递与更新造成影响。

[0163]

步骤s32将所述输入特征矩阵输入时序交互门控图神经网络,并根据所述邻接矩阵、所述单位矩阵和所述节点距离矩阵得到时序交互门控状态矩阵,可以包括:

[0164]ak

=at

k-1

wa;

[0165]

zk=σ(w

zak

uzt

k-1

bz);

[0166]rk

=σ(w

rak

urt

k-1

br);

[0167][0168][0169][0170][0171]

其中,ak为借助对称归一化邻接矩阵得到的图特征聚合变量,a为对称归一化邻接矩阵,其中,d为节点距离矩阵,a为所述邻接矩阵,i为所述邻接矩阵a对应的单位矩阵;σ表示sigmoid函数,wa为第四可学习参数矩阵,wz为第五可学习参数矩阵,uz为第六可学习参数矩阵,wr为第七可学习参数矩阵,ur为第八可学习参数矩阵,w

t

为第九可学习参数矩阵,u

t

为第十可学习参数矩阵,bz为第三可学习偏置项,br为第四可学习偏置项,b

t

第五可学习偏置项。

⊙

为两个矩阵对应位置的元素相乘;两个矩阵对应位置的元素相乘的乘法例如,第一个矩阵的第一行第一列和第二个矩阵的第一行第一列相乘,第一个矩阵的第一行第二列和第二个矩阵的第一行第二列相乘,将两个矩阵对应位置全部相乘之后,得到两个矩阵相乘的结果矩阵。初始迭代时有t0=x,k表示网络最多的迭代次数,k≥1。

[0172]

其中,α

t

为第四可学习参数项,β

t

为第五可学习参数项,ωj为第六可学习参数项,wr为第十一可学习参数矩阵,θ

t

第六可学习偏置项,tk为内部状态,zk为更新门,rk为重置门,为候选状态,为时序交互门控缓存,tk为时序交互门控图神经网络内部状态,tk为时序交互门控状态矩阵。

[0173]

步骤s33,根据所述时序交互卷积状态矩阵和所述时序交互门控状态矩阵,得到增强特征矩阵;

[0174]

在本实施例中,文本分类装置在得到了时序交互卷积状态矩阵c

l

和时序交互门控状态矩阵tk之后,根据所述时序交互卷积状态矩阵c

l

和所述时序交互门控状态矩阵tk,得到增强特征矩阵va。

[0175]

步骤s33根据所述时序交互卷积状态矩阵和所述时序交互门控状态矩阵,得到增强特征矩阵,可以包括:

[0176][0177]va

=wah ba;

[0178]

其中,表示通过时序交互图卷积网络额网络层提取到的时序交互卷积状态矩阵的第i个特征向量,表示通过时序交互门控图神经网络的网络层提取到的时

序交互门控状态矩阵tk的第i个特征向量,||表示向量的拼接,其中,表示一个m维的实数值向量,r表示实数集合;为拼接得到的拼接特征矩阵;wa为第十二可学习参数矩阵,ba为第七可学习偏置项,va为增强特征矩阵;

[0179]

步骤s34,根据所述增强特征矩阵、所述时序交互卷积状态矩阵和所述时序交互门控状态矩阵得到交互注意力;

[0180]

在本实施例中,文本分类装置在得到了增强特征矩阵va、时序交互卷积状态矩阵c

l

和所述时序交互门控状态矩阵tk之后,根据所述增强特征矩阵、时序交互卷积状态矩阵c

l

和所述时序交互门控状态矩阵tk得到交互注意力sa。

[0181]

其中,交互注意力

[0182]

δ表示softmax函数,n为节点集合v中单词的数量,sa为交互注意力;va为增强特征矩阵,c

l

为时序交互卷积状态矩阵,tk为时序交互门控状态矩阵。c

lclt

为时序交互卷积状态矩阵使用矩阵乘法分别计算的重要度矩阵;tkt

kt

为时序交互门控状态矩阵使用矩阵乘法分别计算的重要度矩阵;然后将时序交互卷积状态矩阵c

l

和所述时序交互门控状态矩阵tk拼接在一起得到拼接特征矩阵h;v

avat

为增强特征矩阵va使用矩阵乘法分别计算的重要度矩阵;最后把这三个重要度矩阵(也即是c

lclt

、tkt

kt

和v

avat

)累加在一起,计算出交互注意力权重,并应用于图读出器函数中,得到文本类别的概率分布。本方案设计了根据两种不同的图神经网络(两种神经网络分别为时序交互门控图神经网络siggnn和时序交互图卷积网络sigcn)设计了一种交互注意力机制,用于从多个角度提升文本中关键词的重要度,使得图读出器函数输出更高质量的文本表示。

[0183]

步骤s35,根据所述交互注意力和所述标签值得到所述文本数据的总损失值。

[0184]

在本实施例中,文本分类装置在得到了交互注意力sa和文本数据的标签值之后,根据所述交互注意力和所述标签值得到所述文本数据的总损失值。

[0185]

步骤s35根据所述交互注意力和所述标签值得到所述文本数据的总损失值,可以包括:

[0186]

步骤s351,根据所述交互注意力得到全连接层隐藏特征;

[0187]

在本实施例中,文本分类装置在得到了交互注意力sa之后,根据所述交互注意力得到全连接层隐藏特征。

[0188]

其中,全连接层隐藏特征p=φ(sa)wm;

[0189]

p即为通过全连接层的隐藏特征,φ为激活函数,wm为第十三可学习参数矩阵,sa为交互注意力;

[0190]

步骤s352,根据所述全连接层隐藏特征计算得到分类概率;

[0191]

在本实施例中,文本分类装置在得到了全连接层隐藏特征p之后,根据所述全连接层隐藏特征p计算得到分类概率f。

[0192]

步骤s352根据所述全连接层隐藏特征计算得到分类概率,可以包括:

[0193][0194]

f=δ(wfg bf);

[0195]

其中,g为图节点使用均值聚合后的图层次表示,v表示图节点集合v中的某一具体节点,f为通过全连接层与softmax函数后所得到的预测概率(即为文本数据的分类概率),δ为softmax函数;bf为第七可学习偏置项、wf为第十四可学习参数矩阵;

[0196]

步骤s353,根据所述分类概率和所述标签值得到所述文本数据的总损失值。

[0197]

其中,所述总损失值

[0198]

其中,即为当前批次文本数据的总损失值,y为所述文本数据的标签值。

[0199]

步骤s40,基于所述总损失值、交叉熵损失函数和梯度下降算法对所述时序交互图神经网络模型的模型参数进行更新优化,得到训练文本分类模型;

[0200]

在本实施例中,文本分类装置在得到了总损失值之后,基于所述总损失值、交叉熵损失函数和梯度下降算法对所述时序交互图神经网络模型的模型参数进行更新优化,得到训练文本分类模型。在模型训练期间,根据所得到的文本数据的分类概率f,结合文本数据对应的标签值y,使用交叉熵损失函数计算得到当前文本的损失值,将每条文本的损失值相加得到总的损失再使用梯度下降算法对时序交互图神经网络模型的模型参数进行更新优化,得到第一次优化后的时序交互图神经网络模型,当第一次优化后的时序交互图神经网络模型的模型参数收敛,将第一次优化后的时序交互图神经网络模型作为训练文本分类模型。当第一次优化后的时序交互图神经网络模型的模型参数未收敛,可以根据步骤s10获取文本数据中的第二文本数据以及第二文本数据对应的第二标签值,将所述第二文本数据构建为第二自适应图结构数据,其中第二自适应图结构数据包括第二图节点集合和第二图有向边集合;然后,根据步骤s20基于所述自适应距离权重算法对所述第二图节点集合和所述第二图有向边集合进行处理,得到第二输入特征矩阵;然后,再根据步骤s30将所述第二输入特征矩阵和所述第二标签值输入到第一次优化后的时序交互图神经网络模型中,得到所第二文本数据的第二总损失值;然后,再根据步骤s40基于所述第二总损失值、交叉熵损失函数和梯度下降算法对所述第一次优化后的时序交互图神经网络模型的模型参数进行更新优化,得到第二次优化后的时序交互图神经网络模型。依次类推,当第n次优化后的时序交互图神经网络模型的模型参数收敛,将第n次优化后的时序交互图神经网络模型作为训练文本分类模型。

[0201]

步骤s50,获取待分类文本数据;

[0202]

在本实施例中,文本分类装置在训练得到了训练文本分类模型之后,获取待分类文本数据。

[0203]

步骤s60,将所述待分类文本数据输入所述训练文本分类模型,得到文本分类结果。

[0204]

在本实施例中,文本分类装置在获取待分类文本数据之后,将所述待分类文本数据输入所述训练文本分类模型,得到文本分类结果。在模型预测期间,直接根据网络输出的

文本类别概率分布,选择概率最大的文本类别作为预测结果。比如文本数据的类别为科技或人文等。

[0205]

本实施例通过上述方案,获取文本数据以及所述文本数据对应的标签值,并将所述文本数据构建为自适应图结构数据,其中所述自适应图结构数据包括图节点集合和图有向边集合;基于所述自适应距离权重算法对所述图节点集合和所述图有向边集合进行处理,得到输入特征矩阵;将所述输入特征矩阵和所述标签值输入到时序交互图神经网络模型中,得到所述文本数据的总损失值;基于所述总损失值、交叉熵损失函数和梯度下降算法对所述文本分类模型的模型参数进行更新优化,得到训练文本分类模型。由此,实现了增强图神经网络的特征提取能力,改善了图读出器函数对文本数据的表达以及分类,降低了图神经网络出现过度平滑问题出现的概率。实现了对待分类文本数据进行分类,提高了待分类文本数据的准确率。

[0206]

本发明还提供一种文本分类装置。

[0207]

本发明文本分类装置包括:存储器、处理器及存储在所述存储器上并可在所述处理器上运行的文本分类程序,所述文本分类程序被所述处理器执行时实现如上所述的文本分类方法的步骤。

[0208]

其中,在所述处理器上运行的文本分类程序被执行时所实现的方法可参照本发明文本分类方法各个实施例,此处不再赘述。

[0209]

本发明还提供一种介质。

[0210]

本发明介质上存储有文本分类程序,所述文本分类程序被处理器执行时实现如上所述的文本分类方法的步骤。

[0211]

其中,在所述处理器上运行的文本分类程序被执行时所实现的方法可参照本发明文本分类方法各个实施例,此处不再赘述。

[0212]

需要说明的是,在本文中,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者系统不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者系统所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括该要素的过程、方法、物品或者系统中还存在另外的相同要素。

[0213]

上述本发明实施例序号仅为了描述,不代表实施例的优劣。

[0214]

通过以上的实施方式的描述,本领域的技术人员可以清楚地了解到上述实施例方法可借助软件加必需的通用硬件平台的方式来实现,当然也可以通过硬件,但很多情况下前者是更佳的实施方式。基于这样的理解,本发明的技术方案本质上或者说对现有技术做出贡献的部分可以以软件产品的形式体现出来,该计算机软件产品存储在如上所述的一个存储介质(如rom/ram、磁碟、光盘)中,包括若干指令用以使得一台终端设备(可以是手机,计算机,服务器,空调器,或者网络设备等)执行本发明各个实施例所述的方法。

[0215]

以上仅为本发明的优选实施例,并非因此限制本发明的专利范围,凡是利用本发明说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其他相关的技术领域,均同理包括在本发明的专利保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。