1.本发明提出了一种新的基于迁移的黑盒攻击方法,具体涉及深度学习、图像分类、对抗攻击等领域。该方法可以用于评价神经网络的鲁棒性,检测各种防御模型和防御机制的有效性。

背景技术:

2.对抗攻击是在神经网络的输入中,添加恶意的、难以察觉到的干扰形成对抗样本,达到欺骗神经网络的输出结果。依据是否可以获取受害者模型的先验知识,对抗攻击可以分为白盒攻击和黑盒攻击,白盒攻击可以充分利用模型的架构或者参数等来制作对抗样本,但是在现实世界这是不可取的,所以研究黑盒攻击更具实际价值。

3.黑盒攻击的一大分支就是基于迁移的攻击。它利用白盒攻击方法,在一个替代模型上来制作对抗样本,然后将其应用到黑盒环境的受害者模型去。由于不同模型的结构和参数之间存在着巨大的差异,传统的白盒攻击方法会很容易地过拟合于替代模型,导致迁移率(黑盒攻击成功率)比较低。虽然有一系列方法提出来提升对抗样本的迁移性,但是在防御机制下,他们的迁移性遭受到了严重的限制。

4.利用对抗训练得到的模型是主流的防御模型之一,它在训练网络时,在训练集中添加了一定比例的对抗样本来增强模型的鲁棒性。研究发现,相比较于正常训练的得到的模型,这种防御模型的卷积核参数要更平滑一些。这些平滑的卷积核有消除对抗扰动的作用,但是对抗训练是十分耗时的,特别是对于较大的数据集。因此,有一些系列防御机制被提出来,其主要思想就是在对抗样本输入到模型之前,将其对抗扰动进行净化掉,使得输入到模型中的样本尽可能纯净,从而达到防御对抗样本的效果。

技术实现要素:

5.本发明提出了一种新的基于图像分类任务的攻击方法(sam)。它旨在生成更“鲁棒”的对抗扰动,使更多的对抗样本逃避防御模型和防御机制,提高对抗样本在防御下的黑盒迁移性。该发明原理简单,容易实现,并可以和其他基于梯度的攻击方法结合,并进一步提升对抗样本在防御机制下的黑盒迁移性。

6.为达到上述目的,本发明采用的技术方案是使用预定义的卷积核在正常模型(替代模型)上模拟防御模型的平滑卷积核。由于防御模型通过更平滑的卷积核来减轻对抗性干扰的影响,通过在白盒环境中模拟它们来实施攻击,我们产生了防御模型无法消除的更“鲁棒”的对抗性扰动,从而产生更多的对抗性例子逃避防御机制。在imagenet数据集上的实验结果表明,本发明提出的方法和其他方法结合时,可以在10种先进防御机制下达到91.7%的迁移率,这表明目前这些防御方法还不能达到抵抗对抗样本的作用。

7.具体步骤可以如下:

8.(1)将待分类的图片按照(b,c,w,h)这个维度进行重组,其中b为同时处理的图片数(batch),c为图片的通道数(channel),w和h分别表示图片的宽(width)和高(high),并规

格化到(0,1)之间得到x

clean

。

9.(2)根据待分类的图片的数据集的均值和方差,将步骤(1)规格化后的张量正则化到标准分布得到x。

10.(3)将步骤(2)的张量(x)与预定义的平滑的卷积核(w)进行卷积,卷积时应对输入进行相应的填充,以确保卷积后的张量的size与卷积前的size保持一致。预定义的卷积核w可以表示为:

[0011][0012]

其中k表示该卷积核的尺寸,一般为奇数,卷积后的张量(x')可以表示为:x'=x*w

[0013]

(4)将x'输入到预训练好的分类模型(model)中,得到模型得输出结果。

[0014]

(5)根据待分类的真实标签和模型的输出,计算交叉熵损失(loss)。

[0015]

(6)根据loss进行反向传播,得到x

clean

的梯度grad。

[0016]

(7)计算累计的梯度:t_grad=t_grad grad,初始化时t_grad为0。

[0017]

(8)利用梯度下降的方式求得对抗噪声,初步得到对抗样本adv:

[0018][0019]

其中表示步长。

[0020]

(9)将adv裁剪到(x

clean-ε,x

clean

ε),再裁剪到(0,1)得到x

adv

,其中ε表示添加噪声的最大限制。

[0021]

(10)将步骤(2)中的输入更换为步骤(9)中的x

adv

,重复步骤(2)到步骤(9)t次,最后得到的x

adv

再规格化到(0,255),即是本方法最后要得到的对抗样本。

附图说明

[0022]

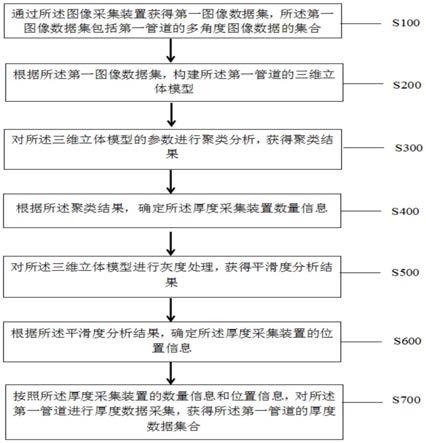

图1是本发明提出的新的攻击方法的流程图。

[0023]

图中,1、一批待分类的图片 2、预定义的卷积核 3、分类模型 4、模型的输出结果 5、反向传播得到的梯度 6、输出得到的对抗样本

具体实施方式

[0024]

下面结合附图和实施例对本发明方案进一步描述。

[0025]

参见图1,将待一批带攻击的样本(图中1)按照模型(图中3)的格式进行预处理后,将预处理后的图片和我们定义的平滑的卷积核(图中2)进行卷积,再将其输入到图片分类模型(图中3)中去,得到分类模型的输出结果(图中4)后,将输出结果和这批图片的真实标签计算交叉熵损失函数,然后再通过反向传播计算其梯度(图中5),通过梯度下降的方式,在输入图片(图中1)上按照梯度的方向添加扰动,并将溢出的部分裁剪到指定范围(0到1)内,重复上述步骤t次,得到对抗样本(图中6),使得图片在真实标签上的置信度下降,从而达到使分类模型的结果出错。最后将得到的对抗样本迁移输入到其他的黑盒防御模型,也能达到欺骗黑盒环境下的防御模型的目的。

[0026]

如果将本方法和其他方法进行进一步结合时,只需将原本输入到分类模型中的张量,替换为该张量与步骤(3)中定义的卷积核进行卷积后的张量即可。

技术特征:

1.一种提高对抗样本在防御机制上迁移率的方案,其特征在于如下步骤:(1)将预处理后的图片和预定义的平滑后的卷积核进行同尺度卷积,使卷积后的尺寸和卷积之前的尺寸相同。(2)将卷积后的图片输入到模型,计算输出结果,并利用其真实标签计算交叉熵损失。(3)对交叉熵损失进行反向传播,计算图片的梯度,并将该梯度累加到总梯度中。(4)将图片在总梯度的方向上进行梯度下降,即将总梯度通过sign函数后,再乘以一定的步长,添加到图片上,然后将溢出的部分裁剪掉。(5)重复上述步骤t次,并返回最终的对抗样本。2.根据权利要求1所诉的一种提高对抗样本在防御机制上迁移率的方案,其特征在于,在输入到模型中的图片,更换为该图片与预定义的平滑的卷积核卷积后的图片,并且卷积后的尺寸需要保持和卷积之前的相同。3.根据权利要求1所诉的一种提高对抗样本在防御机制上转移率的方案,其特征在于,用一个平滑的卷积核平滑图片,该卷积核不是唯一的,但需要满足平滑的特征,即其每个值和其相邻位置的值都是相近的,比如线性卷积核、高斯卷积核、均值卷积核等等。4.根据权利要求1所诉的一种提高对抗样本在防御机制上转移率的方案,其特征在于,所使用的平滑卷积核的尺寸是可变的,不是固定的,不同尺寸的卷积核对应生成的对抗样本,在普通模型和防御模型上的迁移率不同。5.根据权利要求1所诉的一种提高对抗样本在防御机制上转移率的方案,其特征在于,在图片上添加的扰动,是基于使用平滑卷积核后的图片的梯度,该方向上的梯度生成的对抗扰动对防御机制更加鲁棒。6.根据权利要求1所诉的一种提高对抗样本在防御机制上转移率的方案,其特征在于,该方案可以和其他基于梯度的攻击相结合,并进一步提升在防御机制上的黑盒迁移率。

技术总结

本发明提出了一种新的基于迁移的黑盒攻击方法,具体涉及深度学习、图像分类、对抗攻击等领域。该方法可以用于评价神经网络的鲁棒性,检测各种防御模型和防御机制的有效性。为达到上述目的,本发明采用的技术方案是使用预定义核在正常模型(替代模型)上模拟防御模型的平滑卷积核,将输入到模型之前的图片利用预定义的平滑卷积核进行卷积平滑。由于防御模型通过更平滑的卷积核来减轻对抗性干扰的影响,通过在白盒环境中模拟它们来实施攻击,我们产生了防御模型无法消除的更“鲁棒”的对抗性扰动,从而产生更多的对抗性例子逃避防御机制。在ImageNet数据集上的实验结果表明,本发明提出的方法和其他方法结合时,可以在10种先进防御机制下达到91.7%的迁移率,这表明目前这些防御方法还不能达到抵抗对抗样本的作用。防御方法还不能达到抵抗对抗样本的作用。防御方法还不能达到抵抗对抗样本的作用。

技术研发人员:王秀婷 张健 何松华

受保护的技术使用者:湖南大学

技术研发日:2022.01.17

技术公布日:2022/4/22

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。