1.本发明涉及图像处理技术领域,具体涉及一种应对神经网络对抗性攻击的图像处理方法及系统。

背景技术:

2.深度学习受神经科学启发而来,在计算机视觉领域有很高的分类效果,但是有人发现,深度模型很容易受到细微扰动的攻击。这些细小的扰动对于人类视觉系统来说是几乎无法察觉的,但却可以使得深度模型分类错误,甚至对错误的分类结果表现出很高的置信度。

3.抗性示例包含由攻击者专门设计的微小的、可感知的扰动,以愚弄(欺骗)学习模型。这些对抗示例对安全关键应用程序构成严重威胁,例如:自动驾驶汽车、生物特征识别和监控系统。

4.为了减轻对抗性攻击给神经网络造成的影响,最近有研究人员提出了各种防御方法。这些可以大致分为两类:

5.(1)在测试期间修改输入的被动防御,使用图像变换来对抗对抗性扰动的影响。

6.(2)改变底层体系结构或学习过程的主动防御。通过增加更多的层,集成/对抗训练或改变损失/激活函数。

7.主动防御通常更有价值,因为它们对白盒攻击提供了相对更好的鲁棒性。然而,主动防御和被动防御都很容易被反复迭代的白盒攻击绕过。

技术实现要素:

8.本发明针对现有技术中存在的技术问题,提供了一种应对神经网络对抗性攻击的图像处理方法及系统。

9.本发明解决上述技术问题的技术方案如下:

10.第一方面,本发明提出了一种应对神经网络对抗性攻击的图像处理方法,包括以下步骤:

11.获取训练样本图像和经过对抗攻击的样本图像;

12.利用训练样本图像训练对抗攻击防御神经网络模型,并采用交叉熵损失函数使模型分类器学习从神经网络隐藏层特征空间到神经网络输出层类别空间的映射;

13.利用训练后的对抗攻击防御神经网络模型对经过对抗攻击的样本图像进行分类识别。

14.进一步地,所述交叉熵损失函数具体为:

[0015][0016]

式中,l

ce

(x,y)表示交叉熵损失函数,m表示样本图像数量,表示图像标签yi的

权重向量,fi表示神经网络卷积层提取的第i个样本图像的特征向量,表示图像标签yi的偏置向量,k表示模型分类器的类别数量,wj表示模型分类器的第j个类别的权重向量,bj表示模型分类器的第j个类别的偏置向量,t表示转置操作。

[0017]

进一步地,所述利用训练样本图像训练对抗攻击防御神经网络模型具体包括以下分步骤:

[0018]

初始化对抗攻击防御神经网络模型参数,并设定迭代总次数;其中模型参数包括模型分类器各个类别的权重向量和偏置向量;

[0019]

判断当前迭代次数是否达到迭代总次数;

[0020]

若当前迭代次数未达到迭代总次数,则收敛交叉熵损失函数,得到模型参数;

[0021]

若当前迭代次数已达到迭代总次数,则收敛交叉熵损失函数和神经网络各层卷积层损失函数的总损失函数,得到模型参数。

[0022]

进一步地,所述收敛交叉熵损失函数具体为:

[0023][0024]

式中,θ表示模型参数。

[0025]

进一步地,所述收敛交叉熵损失函数和神经网络各层卷积层损失函数的总损失函数具体为:

[0026][0027]

式中,θ表示模型参数,l表示神经网络卷积层数量,l

pc

(x,y)表示神经网络卷积层损失函数。

[0028]

第二方面,本发明还提出了一种应对神经网络对抗性攻击的图像处理系统,包括:

[0029]

图像获取单元,用于获取训练样本图像和经过对抗攻击的样本图像;

[0030]

模型训练单元,用于利用训练样本图像训练对抗攻击防御神经网络模型,并采用交叉熵损失函数使模型分类器学习从神经网络隐藏层特征空间到神经网络输出层类别空间的映射;

[0031]

图像识别单元,用于利用训练后的对抗攻击防御神经网络模型对经过对抗攻击的样本图像进行分类识别。

[0032]

第三方面,本发明还提出了一种电子设备,包括:

[0033]

存储器,用于存储计算机软件程序;

[0034]

处理器,用于读取并执行所述计算机软件程序,进而实现上述的应对神经网络对抗性攻击的图像处理方法。

[0035]

第四方面,本发明还提出了一种非暂态计算机可读存储介质,所述存储介质中存储有用于实现上述的应对神经网络对抗性攻击的图像处理方法的计算机软件程序。

[0036]

本发明的有益效果是:通过训练对抗攻击防御神经网络模型,并采用交叉熵损失函数使模型分类器学习从神经网络隐藏层特征空间到神经网络输出层类别空间的映射,从而使得神经网络学习到的特征表示分离在深度模型的多个深度级别上,最大化类间差距,能有效对抗攻击,在自动驾驶、生物特征识别和监控系统等图像处理领域中有广泛用途。

附图说明

[0037]

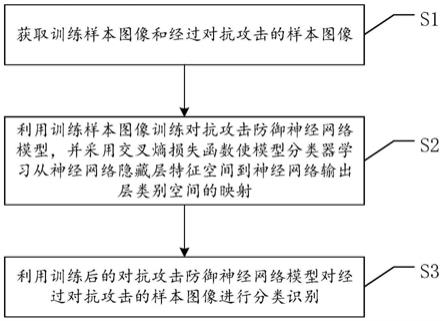

图1为本发明实施例1中应对神经网络对抗性攻击的图像处理方法流程示意图;

[0038]

图2为本发明实施例2中应对神经网络对抗性攻击的图像处理系统结构示意图;

[0039]

图3为本发明实施例提供的电子设备的实施例示意图;

[0040]

图4为本发明实施例提供的一种计算机可读存储介质的实施例示意图。

[0041]

附图中,各标号所代表的部件列表如下:

[0042]

500、电子设备,510、存储器,511、计算机程序,520、处理器,600、计算机可读存储介质,611、计算机程序。

具体实施方式

[0043]

以下结合附图对本发明的原理和特征进行描述,所举实例只用于解释本发明,并非用于限定本发明的范围。

[0044]

实施例1

[0045]

如图1所示,本发明实施例提供了一种应对神经网络对抗性攻击的图像处理方法,包括以下步骤s1至s3:

[0046]

s1、获取训练样本图像和经过对抗攻击的样本图像;

[0047]

在本步骤中,本发明首先获取正常的样本图像来进行后续的模型训练,其中正常的样本图像包括车牌图像、人脸图像等图像处理领域中常用的对象样本。

[0048]

同时还获取经过对抗攻击的样本图像,本发明采用fgsm(fast gradient sign method)攻击和/或pgd(project gradient descent)攻击对正常的样本图像进行对抗攻击,从而生成经过对抗攻击的样本图像。

[0049]

s2、利用训练样本图像训练对抗攻击防御神经网络模型,并采用交叉熵损失函数使模型分类器学习从神经网络隐藏层特征空间到神经网络输出层类别空间的映射;

[0050]

在本步骤中,本发明利用包括多层卷积层的深度卷积网络构建对抗攻击防御神经网络模型,因此可以利用训练样本图像来训练对抗攻击防御神经网络模型,通过多层卷积层提取样本图像中的特性向量。

[0051]

现有的对抗攻击算法的目标就是找到深度神经网络(dnn)的建模函数,从而导致网络产生错误的输出。攻击算法试图在最小的扰动预算内实现此目标。攻击者的目标可以表示为:

[0052][0053]

式中,y表示样本图像x的真实标签,σ表示对样本图像进行对抗攻击添加的对抗扰动,l(g)表示深度卷积网络识别错误的程度,||σ||

p

表示p范数,表示有效扰动的范围。

[0054]

为了创建一个健壮的防御模型,学习算法必须考虑输入域中允许的扰动,并学习将扰动的图像映射到正确类别的函数,这可以通过以下最小(类内间距)-最大(类间间距)目标实现,在出现扰动的情况下将经验风险降至最低:

[0055][0056]

式中,d表示数据分布。

[0057]

因此本发明通过使目标中不同类别的特征最大限度的分离开(通过深度学习,将

学习到的特征表示分离在深度模型的多个级别上),决策任意两个类空间中的重叠最小,类内特征更加紧密,达到防御对抗样本攻击扰动的效果。

[0058]

假设样本图像经过层层卷积提取出的特征向量为fi,该样本图像在神经网络中的真正表示为wy,通过最大化fi和wy的点积,即通过交叉熵损失函数迫使分类器学习从神经网络隐藏层特征空间到神经网络输出层类别空间的映射,从而最大化对正确类向量的投影。

[0059]

本发明采用的交叉熵损失函数具体为:

[0060][0061]

式中,l

ce

(x,y)表示交叉熵损失函数,m表示样本图像数量,表示图像标签yi的权重向量,fi表示神经网络卷积层提取的第i个样本图像的特征向量,表示图像标签yi的偏置向量,k表示模型分类器的类别数量,wj表示模型分类器的第j个类别的权重向量,bj表示模型分类器的第j个类别的偏置向量,t表示转置操作。

[0062]

本发明利用训练样本图像训练对抗攻击防御神经网络模型具体包括以下分步骤s201至s204:

[0063]

s201、初始化对抗攻击防御神经网络模型参数,并设定迭代总次数;其中模型参数包括模型分类器各个类别的权重向量和偏置向量;

[0064]

s202、判断当前迭代次数是否达到迭代总次数;

[0065]

若当前迭代次数未达到迭代总次数,则执行步骤s203;

[0066]

若当前迭代次数已达到迭代总次数,则执行步骤s204;

[0067]

s203、收敛交叉熵损失函数,得到模型参数,具体为:

[0068][0069]

式中,θ表示模型参数。

[0070]

s204、收敛交叉熵损失函数和神经网络各层卷积层损失函数的总损失函数,得到模型参数,具体为:

[0071][0072]

式中,θ表示模型参数,l表示神经网络卷积层数量,l

pc

(x,y)表示神经网络卷积层损失函数。

[0073]

s3、利用训练后的对抗攻击防御神经网络模型对经过对抗攻击的样本图像进行分类识别。

[0074]

实施例2

[0075]

如图2所示,本发明实施例提出了一种应对神经网络对抗性攻击的图像处理系统,包括:

[0076]

图像获取单元,用于获取训练样本图像和经过对抗攻击的样本图像;

[0077]

模型训练单元,用于利用训练样本图像训练对抗攻击防御神经网络模型,并采用交叉熵损失函数使模型分类器学习从神经网络隐藏层特征空间到神经网络输出层类别空间的映射;

[0078]

图像识别单元,用于利用训练后的对抗攻击防御神经网络模型对经过对抗攻击的样本图像进行分类识别。

[0079]

请参阅图3,图3为本发明实施例提供的电子设备的实施例示意图。如图3所示,本发明实施例提了一种电子设备500,包括存储器510、处理器520及存储在存储器520上并可在处理器520上运行的计算机程序511,处理器520执行计算机程序511时实现如实施例1所描述的应对神经网络对抗性攻击的图像处理方法步骤。

[0080]

请参阅图4,图4为本发明实施例提供的一种计算机可读存储介质的实施例示意图。如图4所示,本实施例提供了一种计算机可读存储介质600,其上存储有计算机程序611,该计算机程序611被处理器执行时实现如实施例1所描述的应对神经网络对抗性攻击的图像处理方法步骤。

[0081]

本发明通过使目标中不同类别的特征最大限度的分离开(通过深度学习,将学习到的特征表示分离在深度模型的多个级别上),决策任意两个类空间中的重叠最小,类内特征更加紧密,达到防御对抗样本攻击扰动的效果,将他们在隐藏层的特征表示很好的分离开来,通过改进类内近似和增强类间差异(简单说就是缩小类内差距,扩大类间差异),沿着深度模型的多个层次来实现。

[0082]

利用本发明在车牌和人脸的样本图像上进行训练,其中,在攻击样本数为10000时,车牌识别的防御成功率达到96.38%;在攻击样本数为1500时,人脸识别的防御成功率96.22%。在已经训练的两种识别运用中都体现了很好的效果,防御成功率均在95%以上。因此,本发明针对深度学习领域的对抗样本攻击展现了优秀的防御能力。

[0083]

需要说明的是,在上述实施例中,对各个实施例的描述都各有侧重,某个实施例中没有详细描述的部分,可以参见其它实施例的相关描述。

[0084]

本领域内的技术人员应明白,本发明的实施例可提供为方法、系统、或计算机程序产品。因此,本发明可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本发明可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、cd-rom、光学存储器等)上实施的计算机程序产品的形式。

[0085]

本发明是参照根据本发明实施例的方法、设备(系统)、和计算机程序产品的流程图和/或方框图来描述。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序指令到通用计算机、专用计算机、嵌入式计算机或者其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

[0086]

这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

[0087]

这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一

个方框或多个方框中指定的功能的步骤。

[0088]

尽管已描述了本发明的优选实施例,但本领域内的技术人员一旦得知了基本创造概念,则可对这些实施例作出另外的变更和修改。所以,所附权利要求意欲解释为包括优选实施例以及落入本发明范围的所有变更和修改。

[0089]

显然,本领域的技术人员可以对本发明进行各种改动和变型而不脱离本发明的精神和范围。这样,倘若本发明的这些修改和变型属于本发明权利要求及其等同技术的范围之内,则本发明也意图包括这些改动和变型在内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。