1.本发明涉及一种针对图像分类的神经网络结构低成本自动搜索方法,属于图像分类技术领域。

背景技术:

2.深度学习已经在各类计算机视觉任务上取得了极大的进展。其中手工设计的神经网络结构是深度学习发展过程中的重要驱动力之一,比如vggnet、resnet、inception、densenet。虽然手工设计的神经网络结构可以实现出色的分类性能,但结构的设计需要专业领域知识,而该类知识只有少数专家拥有。同时由于手工设计方法中需要进行重复的优化实验,会导致消耗大量的时间和计算资源。这也促使近年来对神经网络结构搜索(nas)这一领域展开了大量的研究,用于开发神经网络结构的自动设计。

3.nas算法通过自动设计网络结构,可以使得对不熟悉专业领域知识的个人来说也能使用,极大地降低了网络设计的门槛。通过nas算法的自动化可以减少人力和成本,同时 nas算法搜索到的网络结构可以胜过手工设计的算法。然而,nas算法寻找最佳网络结构的搜索时间和计算资源的成本通常都很昂贵。现有的大多数nas算法主要依靠验证数据集来优化网络结构,这需要大量的时间和密集的计算资源,例如nasnet使用500个gpu,耗时4天才搜索到最佳网络。

4.网络结构搜索问题通常被定义为单目标优化问题,即同一时间只考虑单个目标而不是多个。大多数现实世界中的网络部署不仅需要极高的分类性能,而且还需要较低的计算资源,比如更少的网络参数量和更少的网络计算复杂度。为此近年来发展了一些手工设计的网络结构,在减少计算消耗的同时,网络仍然可以具有高精度的性能,例如mobilenet和 mobilenetv2。同时,近年来一些基于多目标优化的nas算法也相继出现,用于使网络结构更易于计算和部署。例如,nsga-net考虑了网络的分类精度和计算复杂度之间的权衡。 lemonade同时考虑了网络的分类性能和网络参数的数量。

5.然而,这些方法仍然需要大量的计算资源并需要很长的搜索时间,但是很多计算机视觉任务存在时间上的要求,比如很多场景下的图像分类任务具有实时性的要求。因此如何使用较少的计算资源来快速搜索出综合性能优越的网路结构以适用现实世界中的实际问题仍需进一步研究。

技术实现要素:

6.为了解决目前针对图像分类技术中的神经网络结构自动搜索方法成本高的问题,本发明提供了一种针对图像分类的神经网络结构低成本自动搜索方法,所述方法包括:

7.步骤一:针对图像分类任务,确定神经网络结构的主体框架,随机生成x个网络结构作为种群p,种群中每个个体代表一个随机生成的网络结构;其中神经网络结构的主体框架包括一个标准卷积层、unit num个reg unit模块和一个全局平均池化层,每个reg unit模块包括block num个组卷积reg block;且每个reg unit模块以50%的概率包含senet模

块, senet模块通过squeeze-and-excitation来模拟注意力机制;

8.reg unit模块的个数unit num、组卷积reg block的个数block num以及组卷积reg block中每个分支中第二层卷积层的宽度width随机生成;

9.步骤二:设定后续种群进化阶段三阶段分隔点s1,s2和进化的最大代数max_gen;

10.步骤三:计算种群p中每个个体的网络结构的ntk的条件数kn作为个体的适应度;

11.步骤四:种群进入进化,使用锦标赛选择选择个体变异操作生成新的网络结构个体,根据当前进化的代数g所属阶段选择不同的指标进行环境选择来淘汰个体;

12.步骤五:达到进化的最大代数max_gen后选择个体的适应度kn值最小的网络结构作为搜索出的用于图像分类任务的神经网络结构。

13.可选的,每个网络结构中的组卷积reg block包含group个分支,每个分支由三个卷积层和一个池化层组成,其中池化层处于第三层;第一层和第四层卷积层使用1

×

1核来调整特征图的数量,第二层卷积层使用3

×

3核来提取特征图,所有卷积层都遵循卷积操作、 relu激活函数和批量归一化层的顺序;第三层的池化层用于将输入数据的大小减半;所述输入数据为图像数据。

14.可选的,对于m

×

m的输入数据,组卷积reg block每个分支中第三层的池化层数量不能大于

15.可选的,所述步骤四中根据当前进化的代数g所属阶段选择不同的指标进行环境选择来淘汰个体,包括:

16.在第一阶段和第三阶段,即当0《g≤s1和s2《g≤max_gen时,选择个体的适应度 kn作为标准来淘汰个体;

17.在第二阶段,即当s1《g≤s2时,选择个体的寿命作为标准来淘汰个体,个体的寿命为个体经历的进化代次。

18.可选的,种群进化过程包括:

19.从种群中随机选择k个个体;从这k个个体中,根据每个个体的适应度kn值的大小,选择前t个最佳适应度的个体作为父代个体;

20.t个父代个体通过一组变异算子来生成t个后代个体;后代个体生成后进行评估并添加到现有种群中;

21.根据当前进化代数所属的阶段,在环境选择中使用相应的标准淘汰个体;根据当前的标准淘汰t个最差的个体,使得种群保持规模不变,剩余的个体构建新的种群,进入下一代进化。

22.可选的,所述t个父代个体通过一组变异算子来生成t个后代个体;后代个体生成后进行评估并添加到现有种群中,包括:

23.在父代个体的长度内随机选择一个变异位置pos

ij

,它代表第i个reg unit中第j个reg block的位置,位置由reg unit在网络结构中的顺序和reg block在reg unit中的位置顺序决定;

24.随机选择一种变异算子来执行父代个体的变异,所述变异算子包括添加算子、移除算子和改变算子;

25.添加算子:在变异位置pos

ij

添加一个随机参数设置的reg block;

26.移除算子:移除在变异位置pos

ij

上的reg block;

27.改变算子:随机改变变异位置pos

ij

上的reg block的参数。

28.可选的,在实现添加算子时,若父代个体的长度达到上限,则无法实现添加算子,只能选择移除算子或改变算子;

29.在实现移除算子时,当父代个体的长度达到下限时,则无法进行移除算子的操作,只能选择添加算子或改变算子。

30.本技术还提供一种图像分类方法,所述方法采用上述方法搜索出的神经网络结构进行图像分类。

31.可选的,所述方法包括:

32.将待分类的图像输入神经网络结构中,通过标准卷积层提取待分类的图像的特征;

33.通过unit num个reg unit模块进行进一步的特征提取,其中每个reg unit模块中的每个组卷积reg block的输出由每个分支的输出特征和残差连接进行联结,再以50%的概率通过senet模块得到特征图,进而通过全局平均池化层将reg units输出的特征图展平为特征向量,最后通过设置一个带有softmax层的全连接层作为分类器,将特征向量转化为最终的分类结果。

34.本发明有益效果是:

35.通过设计一种基于分组卷积的网络block,以该block作为基础单元构建一种可扩展的网络结构,block的可控参数化设置使得构建的网络结构的搜索空间可扩展。再结合一个改进的遗传算法,通过一个三阶段的自然选择策略,更好地激发搜索空间的探索性和开发性。同时引入非训练指标ntk的条件数量作为个体适应度,以极快速度地搜索到高精度且低参数量的网络结构,从而在解决实际问题时实现了使用较少的计算资源来快速搜索出综合性能优越的网路结构,针对图像分类任务,通过实验证明采用所搜索出的综合性能优越的网路结构进行分类的精度较高。

附图说明

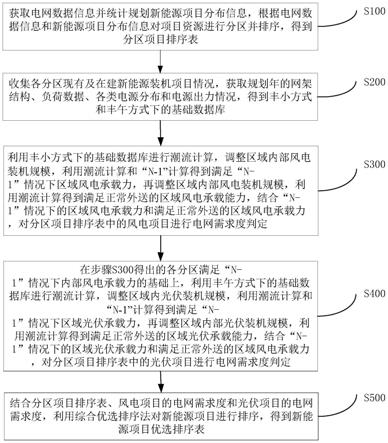

36.为了更清楚地说明本发明实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

37.图1是本发明一个实施例中公开的基于三阶段进化算法的低成本神经网络结构搜索方法中设计的网络整体结构与所提出的新型网络块reg block的结构示意图。

38.图2是本发明一个实施例中公开的基于三阶段进化算法的低成本神经网络结构搜索方法搜索出的针对图像分类问题的网络结构的参数的选择值示意图。

39.图3是本发明一个实施例中公开的灵活的编码策略示意图。

40.图4是本发明一个实施例中公开的本技术提出的组卷积与现有技术中标准卷积的参数量对比图。

41.图5a是本发明一个实施例中公开的原始网络结构与没有senet模块的网络架构之间的测试精度对比图。

42.图5b是本发明一个实施例中公开的原始网络结构与没有senet模块的网络架构之

间的参数量的对比图。

43.图6是本发明一个实施例中公开的cifar-10数据集上lonas搜索空间中kn与网络结构测试准确率的负相关示意图。

44.图7是在进化长度相同(进化代数设置为50)的前提下,第二阶段的长度对测试精度的影响示意图。

45.图8是本发明一个实施例中公开的进化过程中添加算子和移除算子的示意图。

具体实施方式

46.为使本发明的目的、技术方案和优点更加清楚,下面将结合附图对本发明实施方式作进一步地详细描述。

47.实施例一:

48.本实施例提供一种基于三阶段进化算法的低成本神经网络结构搜索方法,所述方法包括:

49.步骤1.给定关于reg block的特定参数集合对网络结构进行灵活的编码;同时给定三阶段的分隔点s1,s2和进化的最大代数max_gen;所述reg block包含组卷积和senet模块,其中包含senet模块的概率为50%;

50.所述reg block包含group个分支,每个分支由三个卷积层和一个池化层组成,其中池化层处于第三层;第一层和第四层卷积层使用1

×

1核来调整特征图的数量,第二层卷积层使用3

×

3核来提取特征图,所有卷积层都遵循卷积操作、relu激活函数和批量归一化层的顺序;第三层池化层用于将输入数据的大小减半。

51.reg block的输出由每个分支的输出特征和残差连接进行联结,以50%的概率外加上一个senet模块组成;senet模块通过squeeze-and-excitation来模拟注意力机制。

52.步骤2.按照步骤1中的编码方式,初始化包含50个网络结构个体的种群p;

53.每个个体的网络结构主体包括一个标准卷积层conv unit、unit num个reg units和一个全局平均池化层,如图1(a)所示。reg units中每个reg block结构如图1(b)所示。

54.步骤3.使用cifar-10和cifar-100数据集计算每个网络结构的ntk的条件数kn作为个体的适应度;

55.步骤4.种群进入进化;

56.步骤5.使用锦标赛选择选择个体变异操作生成新的网络结构个体;

57.步骤6.根据当前进化的代数g选择不同的指标进行环境选择来淘汰个体;

58.具体的:

59.当0《g≤s1时,选择个体的适应度kn作为标准来淘汰个体;

60.当s2《g≤max_gen时,选择个体的寿命作为标准来淘汰个体,个体的寿命为个体经历的进化代次;

61.步骤7.回到步骤5,直到到达最大进化代数。

62.在图像分类数据集cifar-10和cifar-100上进行实验可以证明,本发明可以仅消耗极少的计算资源情况下,使用极短的搜索时间就可以搜索到兼顾分类精度和参数量的网络结构。

63.实施例二

64.本实施例提供一种基于三阶段进化算法的低成本神经网络结构搜索方法,以针对图像分类任务进行低成本神经网络结构搜索为例进行举例进行说明,所述方法包括:

65.步骤1.给定关于reg block的特定参数集合对网络结构进行灵活的编码;同时给定三阶段的分隔点s1,s2和进化的最大代数max_gen;所述reg block包含组卷积和senet模块,其中包含senet模块的概率为50%;

66.所述reg block包含group个分支,每个分支由三个卷积层和一个池化层组成,其中池化层处于第三层;第一层和第四层卷积层使用1

×

1核来调整特征图的数量,第二层卷积层使用3

×

3核来提取特征图,所有卷积层都遵循卷积操作、relu激活函数和批量归一化层的顺序;第三层池化层用于将输入数据的大小减半。

67.reg block的输出由每个分支的输出特征和残差连接进行联结,以50%的概率外加上一个senet模块组成;senet模块通过squeeze-and-excitation来模拟注意力机制。

68.传统的标准卷积可以实现良好的分类性能,但同时需要的参数也较多,不利于设计参数量较少的高精度网络结构。因此本技术在resnet block的基础上设计了一种称为reg block 的新型网络块。reg block由组卷积和senet模块组成,分别可以用于减少参数数量和提高分类性能。

69.reg block的拓扑如图1(b)所示。在reg block中,输入特征会被划分为一定数量的组,这使得标准卷积操作被分解为多个独立的卷积分支。

70.与标准卷积操作相比,组卷积的优点是在不显着降低分类性能的情况下,可以大大降低了网络的计算量和参数数量。reg block中第三层的池化层用于将输入数据的大小减半,其数量不能任意指定,需要遵循计算约束。比如,对于一个m

×

m的输入数据,用于将输入特征大小减半的池化层数量不能大于否则输入数据的大小会减少到小于1从而产生错误。因此,在reg block中只有一部分的池化层的步幅可以设置为2用来减半特征图的数量,另一部分的步幅设置为1。

71.reg block的输出由每个分支的输出特征和残差连接进行联结,外加上一个senet模块组成。senet模块通过squeeze-and-excitation来模拟注意力机制,可以使网络结构更加关注特征中信息量最大的部分,从而提高网络结构的表征能力。

72.对于本技术设计的reg block包含组卷积和senet模块的有效性,本技术在cifar-10 上进行了两次消融实验,第一个是验证组卷积的有效性,第二个是调查senet模块的有效性。实验结果如图4所示;从一个最终种群中随机选择10个个体进行这两个消融实验,这些个体都包含组卷积和若干数量的senet模块。

73.在第一个消融实验中,验证了组卷积对网络结构参数数量的影响。首先记录每个个体的参数数量。然后,在保持其他拓扑结构不变的情况下,将每个个体的组卷积转化为标准卷积,并记录相应的参数数量。对比结果如图4所示,黑色代表组卷积,灰色代表标准卷积。从图 4可以清楚地看出,群卷积比标准卷积拥有的参数少得多,每个包含群卷积的个体可以减少大约一半的参数数量。因此,组卷积可以有效减少网络结构中参数量。

74.在第二个消融实验中,验证了senet模块对于网络测试精度和参数数量的有效性。对于每个个体,通过10次独立试验获得个体和去除所有senet模块的个体的测试精度和参数数量。测试精度和参数个数的比较结果分别如图5a和图5b所示。虚线和黑条代表原始网络结构,实线和灰条代表移除了所有senet模块的网络结构。图5a清楚地显示了与原始网络

结构相比,移除了senet模块的网络结构精度性能大幅降低,表明senet模块可以提升网络结构的测试精度。图5b表明,与网络结构中的整体参数量相比,senet模块的添加仅带来了参数数量的小幅增加,对网络参数量的影响很小。这些结果表明,senet模块可以在仅增加少量参数量的前提下显着提高网络结构的分类性能。

75.步骤2.按照步骤1中的编码方式,初始化包含50个网络结构个体的种群p;

76.如图1(a)所示,50个网络结构每个个体的网络结构主体包括一个标准卷积层convunit、unit num个reg units和一个全局平均池化层。

77.其中,标准卷积层conv unit使用3

×

3核提取初始输入数据的特征,用于图像分类任务时,初始输入数据即为待分类图像。

78.reg units的个数unit num随机生成;每个reg unit由block num个reg blocks组成。 reg block是基于一组可以自动搜索的参数以随机的方式生成的,即reg blocks的个数blocknum随机生成。而每个reg unit中包含reg block的个数也是随机生成,每个reg block中分支数group随机生成,每个分支中第二个卷积层的宽度width随机生成。

79.由此得到一个随机个体初始化的群体p,其中包含50个个体,每个个体表示一个随机生成的网络结构,所有个体的网络结构主体均包含一个标准卷积层conv unit、unit num个regunits和一个全局平均池化层。

80.每个个体的网络结构的末端放置一个全局平均池化层,用于将reg units输出的特征图展平为特征向量。最后通过设置一个带有softmax层的全连接层作为分类器,将特征向量转化为最终的预测结果。

81.步骤3.使用cifar-10和cifar-100数据集计算每个网络结构的ntk的条件数kn作为个体的适应度;

82.为了加速搜索过程,本发明引入ntk来表征网络结构的可训练性。更高的可训练性代表网络架构的更高分类准确度性能。ntk可用于表征无限宽或有限宽深度网络架构的梯度下降训练动态。参考w.chen,x.gong,and z.wang,“neural architecture search on imagenet in four gpu hours:a theoretically inspired perspective,”in international conference on learning representations,2020中的记载,利用cifar-10和cifar-100数据集计算每个网络结构的 ntk的条件数kn;

83.具体的,根据cifar-10和cifar-100数据集中的每组训练图像及对应的标签得到训练集之间ntk的特征值λk,根据各特征值λk得到该网络结构的ntk的条件数kn,计算公式如下:

[0084][0085]

其中,λ0表示特征值λk的最大值,λm表示特征值λk的最小值。

[0086]

本技术通过随机生成200网络结构个体,测试他们的kn与网络结构测试准确率之间的相关性,结果如图6所示。从图6可以看出,kn与网络结构的精度性能呈负相关。

[0087]

因此,本技术利用kn来评估个体的适应度。在进化过程中,最小化kn有助于找到具有高精度性能的网络结构。kn非训练的特性可以直接节省大量的搜索时间和计算资源。

[0088]

计算得到每个初始个体的kn值。

[0089]

步骤4.种群进入进化,使用锦标赛选择选择个体变异操作生成新的网络结构个

体,根据当前进化的代数g选择不同的指标进行环境选择来淘汰个体;

[0090]

进化过程中,首先,从种群中随机选择k个个体。从这k个个体中,根据每个个体的适应度kn值的大小,选择前t个最佳适应度的个体作为父代个体。

[0091]

然后,这t个父代个体通过一组变异算子来生成t个后代个体。后代个体生成后进行评估并添加到现有种群中。

[0092]

然后,根据当前进化代数所属的阶段,在环境选择中使用相应的标准淘汰个体。根据当前的标准淘汰t个最差的个体,使得种群保持规模不变,剩余的个体构建新的种群,进入下一代进化。

[0093]

具体的:

[0094]

在第一阶段(0《g≤g1)和第三阶段(g2《g≤max_gen)中,环境选择的标准都是基于kn的,这分别有助于保留潜在的最优解和提升算法的开发性。在第二阶段(g1《 g≤g2),以个体的寿命作为环境选择的标准,保证了充分的探索性。

[0095]

即:

[0096]

当0《g≤s1时,选择个体的适应度kn作为标准来淘汰个体;

[0097]

当s2《g≤max_gen时,选择个体的寿命作为标准来淘汰个体,个体的寿命为个体经历的进化代次;

[0098]

步骤5.回到步骤4,直到到达最大进化代数,选取kn最小的个体作为搜索到的最佳网络结构。

[0099]

在传统的基于进化算法的整个进化过程中通常使用固定标准进行环境选择。大多数选择的标准都是可以直接反映网络结构的性能,例如网络的测试精度和参数数量。使用这样的方法,当种群进入进化过程时,适应度较好的个体能够通过环境选择被保存在种群中。但在后续的进化过程中,将会在这些个体之间进行变异,这将导致大多数后代在进化过程中都是由这部分个体继承而来。久而久之算法只会关注这少部分优秀的个体,容易导致陷入局部最优,算法的探索能力大大降低。

[0100]

因此,(e.real,a.aggarwal,y.huang,and q.v.le,“regularized evolution for imageclassifier architecture search,”in proceedings of the aaai conference on artificial intelligence, vol.33,no.01,2019,pp.4780

–

4789.)中提出了一个基于个体寿命的进化算法来解决这个问题,它以种群中个体的寿命作为环境选择的标准。在进化过程中,每次环境选择都会丢弃最老的个体,从而淘汰种群中适应度较好、生存时间较长的个体,增加其他个体进入后续进化过程的概率,使得算法可以搜索更多的空间。

[0101]

但是发明人通过深入研究发现,这种基于个体寿命的进化可能存在收敛不稳定的问题。在进化初期,种群中不同个体的寿命都较为相近。如果一开始种群中存在很多适应度好的个体,那么随着个体寿命的增长,这些个体在后期的进化过程中都会被相继淘汰。这些个体在搜索空间中作为潜在的最优解被去除,会减慢种群的收敛速度,从而影响种群收敛的效果。

[0102]

因此,本发明综合考虑传统进化和基于个体寿命进化,提出了一种具备多标准环境选择的新进化算法。在进化的第一阶段和第三阶段,选择与网络结构的分类性能相关的kn作为环境选择的标准,在选择过程中每次保留具有较小kn的个体。在第二阶段,以个体的寿命为标准,选择寿命较短的个体保存在种群中。

[0103]

在第一阶段,保证种群中的优秀个体可以进入到后期的进化过程,使变异产生的后代可以从他们那里继承下来,提高种群的整体性能,保证种群中有足够多的潜在最优解。然后在第二阶段,频繁更新种群,探索更多的搜索空间,增加个体的多样性。最后,在第三阶段,在每次环境选择时都保存优秀的个体,引导种群收敛到最佳最优解,有助于确保算法的开发性。

[0104]

为了验证本技术采用三阶段进化的有效性,本实施例进行五个拥有不同第二阶段长度的独立实验。每个实验种群进化的最大代数相同,记录最终种群的分类性能。通过改变第二阶段的长度,第一阶段和第三阶段的长度也相应改变,这有助于研究每个阶段的不同长度对最终种群验证精度的影响。第二阶段的长度从[0-30]改变,图7展示了不同种群的整体准确率表现。在图7中,每个矩形框代表一个种群的整体验证准确率,框的长度代表个体之间准确率的偏差,框内的点和虚线代表准确率的平均值和中位数。框两端的延长线代表种群中最大和最小精度。当第二阶段的长度设置为0时,进化算法退化为包含固定标准环境选择的传统进化算法。从图7中可以明显看出,与其他的三阶段进化算法相比,传统进化算法的平均验证精度最低。这表明由于第二阶段有助于探索更多的搜索空间,帮助种群收敛到具有更好分类性能的网络结构。当第二阶段的长度增加时,种群的平均准确率呈现先增加后降低的趋势。这可以说明较长的第二阶段导致种群在整个进化过程中花费过多时间来探索搜索空间,从而导致种群无法及时收敛到更好的解。同时,第三个矩形框及其延长线的长度最短,说明个体间的差异最小。这可以证明具有足够长度的第三阶段可以改进探索,这有助于淘汰适应度较差的个体,增加最优解的数量。这进而提高了进化算法在搜索过程中的稳定性。因此,根据上述实验结果,每个阶段的适当长度有助于有效平衡算法的探索性和开发性,从而更好地搜索最优解。

[0105]

进化过程中,种群中的后代个体都是由现有个体的变异产生,以探索更多的搜索空间,增加个体的多样性。在本技术中,变异算子只在reg unit中进行,conv unit由于其特定的功能并不会涉及变异。对于变异算子,首先在父代个体的长度内随机选择一个变异位置 pos

ij

,它代表第i个reg unit中第j个reg block的位置,位置由reg unit在网络结构中的顺序和reg block在reg unit中的位置顺序决定。然后,随机选择一种变异算子来执行父代个体的变异。根据基于块的网络结构,设计的变异算子如下:

[0106]

·

添加(添加一个随机参数设置的reg block);

[0107]

·

移除(移除选定位置上的reg block);

[0108]

·

改变(随机改变选定位置上的reg block的参数)。更具体地说,在添加算子中,生成一个带有随机参数的reg block并插入到位置pos

ij

之后。在移除算子中,位置pos

ij

上的reg block直接被删除。

[0109]

在改变算子中,随机生成一组新参数来替换位置pos

ij

上reg block的旧参数。如图8 所示,展示了添加算子和移除算子的示例,以便更好地理解变异算子。在图8(a)中,随机生成一个新的reg block,并且在reg block 11之后插入。在图8(b)中,reg block 23从 reg unit 2中移除。

[0110]

需要注意的是,在实现添加算子和移除算子时需要考虑原始父代个体的长度。如果长度达到上限,则无法实现添加算子,只能选择其他两种算子。当原始个体的长度达到下限时,同样无法进行移除算子的操作。

computervisionandpatternrecognition,pages770

–

778,2016.”中的介绍;

[0123]

fractalnet方法可参考“g.larsson,m.maire,andg.shakhnarovich.fractalnet:ultra-deepneuralnetworkswithoutresiduals.arxivpreprintarxiv:1605.07648,2016.”中的介绍;

[0124]

densenet(k=24)方法和densenet-b(k=40)可参考“g.huang,z.liu,l.vandermaaten,andk.q.weinberger.denselyconnectedconvolutionalnetworks.inproceedingsoftheieeeconferenceoncomputervisionandpatternrecognition,pages4700

–

4708,2017.”中的介绍;

[0125]

wideresnet方法可参考“s.zagoruykoandn.komodakis.wideresidualnetworks.arxivpreprintarxiv:1605.07146,2016.”中的介绍;

[0126]

resnext-29(8x64d)方法可参考“s.xie,r.girshick,p.doll

′

ar,z.tu,andk.he.aggregatedresidualtransformationsfordeepneuralnetworks.inproceedingsoftheieeeconferenceoncomputervisionandpatternrecognition,pages1492

–

1500,2017.”中的介绍;

[0127]

hierarchicalevolution方法可参考“h.liu,k.simonyan,o.vinyals,c.fernando,andk.kavukcuoglu.hierarchicalrepresentationsforefficientarchitecturesearch.ininternationalconferenceonlearningrepresentations,2018.”中的介绍;

[0128]

amoebanet-a方法可参考“e.real,a.aggarwal,y.huang,andq.v.le.regularizedevolutionforimageclassifierarchitecturesearch.inproceedingsoftheaaaiconferenceonartificialintelligence,volume33,pages4780

–

4789,2019.”中的介绍;

[0129]

nasnet-a方法可参考“b.zoph,v.vasudevan,j.shlens,andq.v.le.learningtransferablearchitecturesforscalableimagerecognition.inproceedingsoftheieeeconferenceoncomputervisionandpatternrecognition,pages8697

–

8710,2018.”中的介绍;

[0130]

darts方法可参考“h.liu,k.simonyan,andy.yang.darts:differentiablearchitecturesearch.ininternationalconferenceonlearningrepresentations,2018.”中的介绍;

[0131]

enas(macro)方法和enas(micro)方法可参考“h.pham,m.guan,b.zoph,q.le,andj.dean.efficientneuralarchitecturesearchviaparameterssharing.ininternationalconferenceonmachinelearning,pages4095

–

4104.pmlr,2018.”中的介绍;

[0132]

block-qnn-s方法可参考“z.zhong,j.yan,w.wu,j.shao,andc.-l.liu.practicalblock-wiseneuralnetworkarchitecturegeneration.inproceedingsoftheieeeconferenceoncomputervisionandpatternrecognition,pages2423

–

2432,2018.”中的介绍;

[0133]

te-nas方法可参考“w.chen,x.gong,andz.wang.neuralarchitecturesearchonimagenetinfourgpuhours:atheoreticallyinspiredperspective.in

internationalconferenceonlearningrepresentations,2020.”中的介绍;

[0134]

large-scaleevolution方法可参考“e.real,s.moore,a.selle,s.saxena,y.l.suematsu,j.tan,q.v.le,anda.kurakin.large-scaleevolutionofimageclassifiers.ininternationalconferenceonmachinelearning,pages2902

–

2911.pmlr,2017.”中的介绍;

[0135]

ae-cnn方法可参考“y.sun,b.xue,m.zhang,andg.g.yen.completelyautomatedcnnarchitecturedesignbasedonblocks.ieeetransactionsonneuralnetworksandlearningsystems,31(4):1242

–

1254,2019.”中的介绍;

[0136]

cnn-ga方法可参考“y.sun,b.xue,m.zhang,g.g.yen,andj.lv.automaticallydesigningcnnarchitecturesusingthegeneticalgorithmforimageclassification.ieeetransactionsoncybernetics,50(9):3840

–

3854,2020.”中的介绍;

[0137]

nas方法可参考“b.zophandq.v.le.neuralarchitecturesearchwithreinforcementlearning.arxivpreprintarxiv:1611.01578,2016.”中的介绍;

[0138]

nsga-net方法可参考“z.lu,i.whalen,v.boddeti,y.dhebar,k.deb,e.goodman,andw.banzhaf.nsga-net:neuralarchitecturesearchusingmulti-objectivegeneticalgorithm.inproceedingsofthegeneticandevolutionarycomputationconference,pages419

–

427,2019.”中的介绍。

[0139]

表1中采用本发明提出的方法搜索到的最佳网络结构表示为ex-net。

[0140]

表1:本技术方法与其他算法在cifar-10和cifar-100数据集上的比较结果,分别从测试准确率(%)、参数数量、搜索gpu天数以及使用的gpu数量方面进行比较

[0141][0142]

分析如下:

[0143]

1)与手工设计的网络的比较结果

[0144]

从表1可以看出,与手动设计的最先进网络结构相比,本技术方法搜索得到的网络结构 ex-net在cifar-10和cifar-100的测试精度和参数数量远优于fractalnet和wideresnet。对于densenet(k=24),ex-net在cifar-10和cifar-100上表现出更好的测试精度,而ex-net在cifar-10和cifar-100上获得的参数量仅为densenet(k=24)的 6.9%和15.8%。ex-net中的参数数量略高于resnet-100,但ex-net在两个数据集上的测试准确率都有很大的提升,分别提升了3.5%和8.9%。与densenet-b(k=40)和 resnext-29(8x64d)相比,ex-net在cifar-10上的测试精度性能更好。在cifar-100 上,虽然ex-net的准确率稍逊他们,但ex-net的参数数量仅为densenet-b(k=40)和resnext-29(8x64d)参数数量的16.8%和12.5%,参数量大大减少。与resnext-29(8x64d) 相比,ex-net仅使用1/8的gpu资源。

[0145]

因此,与手动设计的最先进的网络结构相比,本技术方法搜索得到的网络结构ex-net 可以实现更高的精度性能。同时ex-net的参数比大多数手工设计的网络结构少得多。

[0146]

2)与半自动的nas算法的比较结果

[0147]

从表1可以看出,对比半自动nas算法,与hierarchical evolution、block-qnn-s和 enas(macro)相比,本技术方法搜索得到的网络结构ex-net在测试精度和参数数量方面完全优于它们,同时大大减少了搜索时间成本(减少16~4500倍)。与nasnet-a相比, ex-net在测试精度方面略差于它,但ex-net的参数量比nasnet-a少得多。此外,ex

‑ꢀ

net搜索速度比nasnet-a快100000倍,并且消耗的gpu资源仅为nasnet-a消耗的 1/500。ex-net比amoebanet-a具有更好的测试精度和更少的参数。所需的gpu daysex-net仅为0.02,仅为amoebanet-a的1/157500,gpu所需的计算资源仅为amoebanet

‑ꢀ

a的1/450。darts和enas(micro)在cifar-10上的精度性能略好于ex-net,但是 ex-net的参数要少得多。在gpu资源消耗相同的情况下,ex-net的搜索时间分别比它们少75倍和25倍。另外,虽然ex-ne的精度性能不如te-nas,但ex-net的参数数量和 ex-net消耗的gpu天数都只有te-nas的一半。

[0148]

因此,与半自动的nas算法相比,本技术方法搜索得到的网络结构ex-net在测试精度上具有竞争力,同时在参数数量上表现出更好的优势。此外,ex-net在搜索时间成本和所需的计算资源消耗方面也展示出极大的优势。

[0149]

3)与全自动nas算法的比较结果

[0150]

对比全自动nas算法,本技术方法搜索得到的网络结构ex-net在精度性能和参数数量方面都表现出优于large-scale evolution和nas的优势。此外,ex-net仅消耗0.02 gpu days,远低于large-scale evolution和nas。同时ex-net所需的gpu资源比nas 少800倍。ex-net在cifar-10和cifar-100上的测试精度和参数数量方面都优于 ae-cnn。ex-net在搜索时间成本和所需的gpu资源消耗方面获得更好的提升。与 cnn-ga相比,ex-net在cifar-10上的测试精度更高,参数更少。此外,ex-net在更复杂的cifar-100上有更好的准确率表现,同时参数数量接近cnn-ga。ex-net的搜索时间仅为cnn-ga消耗的大约1/1750。nsga-net在cifar-10上的准确率表现略好于 ex-net(97.5%对96.83%),但ex-net的参数数量仅为nsga-net的1/13(1.9m对 26.8m)。在使用相同的计算资源时,ex-net的搜索时间比nsga-net少200倍。

[0151]

因此,在全自动的nas算法的比较中,本技术方法搜索得到的网络结构ex-net在所有目标上都表现出很大的优势。

[0152]

结论

[0153]

总而言之,本技术方法搜索得到的网络结构ex-net在测试精度上超过了大多数手工设计的网络结构,同时参数更少。ex-net在测试精度和参数数量方面也比大多数自动nas 算法显示出很大的优势。同时它需要的gpu资源更少,并将搜索时间减少了200倍到 1120000倍。与半自动nas算法相比,考虑到搜索空间的差异和人工设计的参与,ex-net 在测试精度性能上的优势并不明显,但ex-net的参数量要少得多,并且大大降低了搜索时间成本和计算资源消耗。

[0154]

本发明实施例中的部分步骤,可以利用软件实现,相应的软件程序可以存储在可读取的存储介质中,如光盘或硬盘等。

[0155]

以上所述仅为本发明的较佳实施例,并不用以限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。