1.本技术实施例涉及人工智能技术领域,特别涉及一种人工智能对象控制方法、装置、设备及存储介质。

背景技术:

2.随着ai(artificial intelligence,人工智能)技术的发展,在游戏、医疗等领域中逐渐出现了人工智能对象。人工智能对象是基于神经网络模型操控的对象,而不是由用户基于终端操控的对象。目前的人工智能对象能够基于当前所处场景的状态数据自主预测所需执行的动作,但其功能仍然存在局限。

技术实现要素:

3.本技术实施例提供了一种人工智能对象控制方法、装置、设备及存储介质,扩展了人工智能对象的功能,提供了一种操作可控的人工智能对象。所述技术方案如下:

4.一方面,提供了一种人工智能对象控制方法,所述方法包括:

5.显示虚拟场景界面,所述虚拟场景界面显示有本端的被控虚拟对象;

6.通过所述虚拟场景界面检测控制指令,所述控制指令用于指示所述被控虚拟对象的本方阵营中的人工智能对象执行目标操作;

7.基于所述控制指令,控制所述人工智能对象执行所述目标操作。

8.另一方面,提供了一种人工智能对象控制方法,所述方法包括:

9.接收终端发送的控制指令,所述控制指令用于指示人工智能对象执行目标操作;

10.基于所述控制指令,控制所述人工智能对象执行所述目标操作;

11.其中,所述人工智能对象属于所述终端的被控虚拟对象的本方阵营。

12.可选地,所述控制指令包括所述被控虚拟对象的第一对象标识和目标虚拟对象的第二对象标识,所述目标操作为向所述目标虚拟对象移动的操作;

13.所述方法还包括:

14.将所述多个虚拟对象的编码特征构成编码矩阵;

15.基于所述编码矩阵与所述编码矩阵的转置矩阵相乘得到的矩阵,确定第一权重特征;

16.将所述第一权重特征中的非关联虚拟对象的权重参数设置为负无穷,得到第二权重特征,所述非关联虚拟对象与所述被控虚拟对象之间的距离,以及所述非关联虚拟对象与所述目标虚拟对象之间的距离均不小于距离阈值;

17.对所述第二权重特征进行归一化处理,将归一化处理后的权重特征确定为所述融合网络中的权重特征。

18.可选地,所述基于所述控制指令,控制所述人工智能对象执行所述目标操作,包括:

19.调用意图预测模型,对所述控制指令进行验证;

20.在所述控制指令验证通过的情况下,基于所述控制指令,控制所述人工智能对象执行所述目标操作。

21.可选地,所述调用意图预测模型,对所述控制指令进行验证,包括:

22.基于当前的状态数据,调用所述意图预测模型,确定在虚拟场景中所述人工智能对象在下一时刻将要到达的第一位置;

23.根据所述第一位置以及所述控制指令所指示的第二位置,确定是否响应所述控制指令。

24.可选地,所述调用意图预测模型,对所述控制指令进行验证,包括:

25.基于当前的状态数据,调用所述意图预测模型,确定所述人工智能对象的预测位置信息,所述状态数据包含所述人工智能对象当前的位置,所述预测位置信息包括地图中每个网格对应的概率,所述概率表示在下一时刻所述人工智能对象到达所述网格的概率;

26.将所述预测位置信息中概率最大的前k个网格构成集合,k为正整数;

27.在所述控制指令所指示的第二位置属于所述集合的情况下,所述控制指令验证通过;

28.在所述第二位置不属于所述集合的情况下,所述控制指令验证未通过。

29.可选地,所述意图预测模型包括编码网络、融合网络和位置预测网络,所述基于当前的状态数据,调用所述意图预测模型,确定所述人工智能对象的预测位置信息,包括:

30.调用所述编码网络,对多个虚拟对象的状态数据进行编码,得到所述多个虚拟对象的编码特征;

31.调用所述融合网络,基于权重特征,对所述多个虚拟对象的编码特征进行加权融合,得到融合特征,所述权重特征包括虚拟场景中的多个虚拟对象的权重参数;

32.调用所述位置预测网络,对所述融合特征进行位置预测,得到所述预测位置信息。

33.可选地,训练所述意图预测模型的过程包括:

34.获取样本数据,所述样本数据包括在样本时刻多个虚拟对象的状态数据以及对应的位置标签,所述状态数据至少包括在所述样本时刻的图像帧,所述位置标签为在所述样本时刻的下一个时刻发生目标事件的网格的编号;

35.基于所述样本数据对所述意图预测模型进行训练。

36.可选地,预测模型包括编码网络、融合网络和预测网络,所述预测网络包括操作预测网络和位置预测网络;训练所述预测模型的过程包括:

37.获取样本数据,所述样本数据包括在任一样本时刻的样本状态数据和样本操作信息,以及位置标签,所述样本状态数据包括在所述样本时刻下,多个虚拟对象的状态数据,所述样本操作信息包括在所述样本时刻下,所述人工智能对象应当执行的操作,所述位置标签为在所述样本时刻的下一个时刻发生目标事件的网格的编号;

38.基于所述预测模型对所述样本状态数据进行处理,得到预测操作信息和预测位置标签,所述预测操作信息包括由预测模型预测的、在所述样本时刻下所述人工智能对象应执行的操作,所述预测位置信息包括人工智能对象在下一时刻要到达的位置;

39.根据所述样本操作信息与所述预测操作信息,以及所述位置标签和所述预测位置信息,对所述预测模型进行训练。

40.另一方面,提供了一种人工智能对象控制装置,所述装置包括:

41.显示模块,用于显示虚拟场景界面,所述虚拟场景界面显示有本端的被控虚拟对象;

42.检测模块,用于通过所述虚拟场景界面检测控制指令,所述控制指令用于指示所述被控虚拟对象的本方阵营中的人工智能对象执行目标操作;

43.第一控制模块,用于基于所述控制指令,控制所述人工智能对象执行所述目标操作。

44.可选地,所述检测模块,包括:

45.第一检测单元,用于通过所述虚拟场景界面,检测攻击指令,所述攻击指令用于指示所述人工智能对象攻击非本方阵营的第一目标虚拟对象;或者,

46.第二检测单元,用于通过所述虚拟场景界面,检测撤退指令,所述撤退指令用于指示所述人工智能对象撤退至安全位置;或者,

47.第三检测单元,用于通过所述虚拟场景界面,检测集合指令,所述集合指令用于指示所述人工智能对象向所述被控虚拟对象或本方阵营的第二目标虚拟对象的位置移动。

48.可选地,所述第一检测单元,用于:

49.通过所述虚拟场景界面检测对攻击控件的触发操作,生成所述攻击指令,所述第一目标虚拟对象为非本方阵营中与所述被控虚拟对象距离最近的虚拟对象;或者,

50.通过所述虚拟场景界面检测将所述攻击控件拖动至所述第一目标虚拟对象的对象标识的操作,生成所述攻击指令;或者,

51.通过所述虚拟场景界面检测对所述第一目标虚拟对象的对象标识的选中操作,生成所述攻击指令。

52.可选地,所述第二检测单元,用于:

53.通过所述虚拟场景界面检测对撤退控件的触发操作,生成所述撤退指令,所述撤退指令用于指示所述人工智能对象撤退至安全位置;或者,

54.通过所述虚拟场景界面检测将所述撤退控件拖动至本方阵营的第三目标虚拟对象的对象标识的操作,生成所述撤退指令,所述撤退指令用于指示所述人工智能对象撤退至所述第三目标虚拟对象的位置;或者,

55.通过所述虚拟场景界面检测对所述第三目标虚拟对象的对象标识的选中操作,生成所述撤退指令,所述撤退指令用于指示所述人工智能对象撤退至所述第三目标虚拟对象的位置。

56.可选地,所述第三检测单元,用于:

57.通过所述虚拟场景界面检测对集合控件的触发操作,生成所述集合指令,所述集合指令用于指示所述人工智能对象向所述被控虚拟对象的位置移动;或者,

58.通过所述虚拟场景界面检测将所述集合控件拖动至本方阵营的第二目标虚拟对象的对象标识的操作,生成所述集合指令,所述集合指令用于指示所述人工智能对象向所述第二目标虚拟对象的位置移动;或者,

59.通过所述虚拟场景界面检测对所述第三目标虚拟对象的对象标识的选中操作,生成所述集合指令,所述集合指令用于指示所述人工智能对象向所述第二目标虚拟对象的位置移动。

60.可选地,所述控制指令携带目标虚拟对象的对象标识,所述目标操作为向所述目

标虚拟对象移动的操作;

61.所述控制模块,包括:

62.第一控制单元,用于基于所述控制指令,控制所述人工智能对象执行向所述目标虚拟对象移动的操作。

63.可选地,所述控制模块,包括:

64.第二控制单元,用于向服务器发送所述控制指令,所述服务器用于基于所述控制指令,调用神经网络模型确定用于完成所述目标操作的至少一个子操作,控制所述人工智能对象执行所述至少一个子操作。

65.另一方面,提供了一种人工智能对象控制装置,所述装置包括:

66.接收模块,用于接收终端发送的控制指令,所述控制指令用于指示人工智能对象执行目标操作;

67.控制模块,用于基于所述控制指令,控制所述人工智能对象执行所述目标操作;

68.其中,所述人工智能对象属于所述终端的被控虚拟对象的本方阵营。

69.可选地,所述控制模块,包括:

70.第一控制单元,用于基于所述控制指令,调用神经网络模型确定用于完成所述目标操作的至少一个子操作,控制所述人工智能对象执行所述至少一个子操作。

71.可选地,所述神经网络模型包括编码网络、融合网络和操作预测网络,所述第一控制单元,包括:

72.编码子单元,用于调用所述编码网络,对所述多个虚拟对象的状态数据进行编码,得到所述多个虚拟对象的编码特征;

73.融合子单元,用于调用所述融合网络,基于权重特征,对所述多个虚拟对象的编码特征进行加权融合,得到融合特征,所述权重特征包括虚拟场景中的多个虚拟对象的权重参数,且所述权重特征基于所述控制指令确定;

74.预测子单元,用于调用所述操作预测网络,对所述融合特征进行操作预测,得到操作信息,所述操作信息至少包括所述人工智能对象所需执行的子操作。

75.可选地,所述控制指令包括所述被控虚拟对象的第一对象标识和目标虚拟对象的第二对象标识,所述目标操作为向所述目标虚拟对象移动的操作;

76.所述第一控制单元,还包括:

77.确定子单元,用于:

78.将所述多个虚拟对象的编码特征构成编码矩阵;

79.基于所述编码矩阵与所述编码矩阵的转置矩阵相乘得到的矩阵,确定第一权重特征;

80.将所述第一权重特征中的非关联虚拟对象的权重参数设置为负无穷,得到第二权重特征,所述非关联虚拟对象与所述被控虚拟对象之间的距离,以及所述非关联虚拟对象与所述目标虚拟对象之间的距离均不小于距离阈值;

81.对所述第二权重特征进行归一化处理,将归一化处理后的权重特征确定为所述融合网络中的权重特征。

82.可选地,所述控制模块,包括:

83.验证单元,用于调用意图预测模型,对所述控制指令进行验证;

84.第二控制单元,用于在所述控制指令验证通过的情况下,基于所述控制指令,控制所述人工智能对象执行所述目标操作。

85.另一方面,提供了一种终端,所述终端包括处理器和存储器,所述存储器中存储有至少一条计算机程序,所述至少一条计算机程序由所述处理器加载并执行以实现如上述方面所述的人工智能对象控制方法中所执行的操作。

86.另一方面,提供了一种服务器,所述服务器包括处理器和存储器,所述存储器中存储有至少一条计算机程序,所述至少一条计算机程序由所述处理器加载并执行以实现如上述方面所述的人工智能对象控制方法中所执行的操作。

87.另一方面,提供了一种计算机可读存储介质,所述计算机可读存储介质中存储有至少一条计算机程序,所述至少一条计算机程序由处理器加载并执行以实现如上述方面所述的人工智能对象控制方法中所执行的操作。

88.另一方面,提供了一种计算机程序产品或计算机程序,所述计算机程序产品或计算机程序包括计算机程序代码,所述计算机程序代码存储在计算机可读存储介质中,计算机设备的处理器从计算机可读存储介质读取所述计算机程序代码,处理器执行所述计算机程序代码,使得所述计算机设备实现如上述方面所述的人工智能对象控制方法中所执行的操作。

89.本技术实施例扩展了人工智能对象的功能,提供了一种操作可控的人工智能对象,用户只需发出控制指令,即可控制与被控虚拟对象属于同一阵营的人工智能对象执行目标操作,实现了对人工智能对象的控制,从而实现了人与人工智能对象之间的协同配合。

附图说明

90.为了更清楚地说明本技术实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本技术实施例的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

91.图1是本技术实施例提供的一种实施环境的示意图。

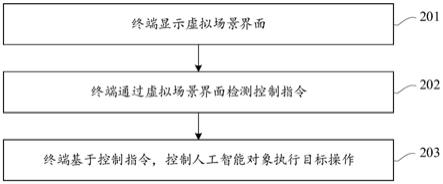

92.图2是本技术实施例提供的一种人工智能对象控制方法的流程图。

93.图3是本技术实施例提供的一种虚拟场景界面的示意图。

94.图4是本技术实施例提供的另一种虚拟场景界面的示意图。

95.图5是本技术实施例提供的另一种虚拟场景界面的示意图。

96.图6是本技术实施例提供的另一种虚拟场景界面的示意图。

97.图7是本技术实施例提供的另一种虚拟场景界面的示意图。

98.图8是本技术实施例提供的另一种虚拟场景界面的示意图。

99.图9是本技术实施例提供的另一种虚拟场景界面的示意图。

100.图10是本技术实施例提供的另一种虚拟场景界面的示意图。

101.图11是本技术实施例提供的一种人工智能对象控制方法的流程图。

102.图12是本技术实施例提供的另一种人工智能对象控制方法的流程图。

103.图13是本技术实施例提供的一种深度隐变量神经网络模型的示意图。

104.图14是本技术实施例提供的一种终端与服务器的交互示意图。

105.图15是本技术实施例提供的一种验证控制指令的方法的流程图。

106.图16是本技术实施例提供的一种地图网格化示意图。

107.图17是本技术实施例提供的一种多个时刻的网格的示意图。

108.图18是本技术实施例提供的一种预测模型的示意图。

109.图19是本技术实施例提供的另一种深度隐变量神经网络模型的示意图。

110.图20是本技术实施例提供的一种意图预测模型的示意图。

111.图21是本技术实施例提供的一种神经网络模型的示意图。

112.图22是本技术实施例提供的一种共享编码网络的示意图。

113.图23是本技术实施例提供的一种人工智能对象控制装置的结构示意图。

114.图24是本技术实施例提供的另一种人工智能对象控制装置的结构示意图。

115.图25是本技术实施例提供的一种终端的结构示意图。

116.图26是本技术实施例提供的一种服务器的结构示意图。

具体实施方式

117.为使本技术实施例的目的、技术方案和优点更加清楚,下面将结合附图对本技术实施方式作进一步地详细描述。

118.可以理解,本技术所使用的术语“第一”、“第二”等可在本文中用于描述各种概念,但除非特别说明,这些概念不受这些术语限制。这些术语仅用于将一个概念与另一个概念区分。举例来说,在不脱离本技术的范围的情况下,可以将第一目标虚拟对象称为第二目标虚拟对象,且类似地,可将第二目标虚拟对象称为第一目标虚拟对象。

119.本技术所使用的术语“至少一个”、“多个”、“每个”、“任一”,至少一个包括一个、两个或两个以上,多个包括两个或两个以上,而每个是指对应的多个中的每一个,任一是指多个中的任意一个。举例来说,多个虚拟对象包括3个虚拟对象,而每个是指这3个虚拟对象中的每一个虚拟对象,任一是指这3个虚拟对象中的任意一个虚拟对象,可以是第一个虚拟对象,可以是第二个虚拟对象、也可以是第三个虚拟对象。

120.本技术涉及到的虚拟场景可以用于模拟一个三维虚拟空间,该三维虚拟空间可以是一个开放空间,该虚拟场景可以用于模拟现实中的真实环境,例如,该虚拟场景中可以包括天空、陆地、海洋等,该陆地可以包括沙漠、城市等环境元素。当然,在该虚拟场景中还可以包括虚拟物品,例如,建筑物、载具、虚拟场景中的虚拟对象用于武装自己或与其他虚拟对象进行战斗所需的兵器等道具。该虚拟场景还可以用于模拟不同天气下的真实环境,例如,晴天、雨天、雾天或黑夜等天气。

121.用户可以控制虚拟对象在该虚拟场景中进行移动,该虚拟对象可以是该虚拟场景中的一个虚拟的用于代表用户的虚拟形象,该虚拟形象可以是任一种形态,例如,人、动物等,本技术对此不限定。以射击类游戏为例,用户可以控制虚拟对象在该虚拟场景的天空中自由下落、滑翔或者打开降落伞进行下落等,在陆地上中跑动、跳动、爬行、弯腰前行等,也可以控制虚拟对象在海洋中游泳、漂浮或者下潜等,当然,用户也可以控制虚拟对象乘坐载具在该虚拟场景中进行移动。用户还可以控制虚拟对象在该虚拟场景中进出建筑物,发现并拾取该虚拟场景中的虚拟物品(例如,兵器等道具),从而通过拾取的虚拟物品与其他虚拟对象进行战斗,例如,该虚拟物品可以是衣物、头盔、防弹衣、医疗品、冷兵器或热兵器等,

也可以是其他虚拟对象被淘汰后遗留的虚拟物品。在此仅以上述场景进行举例说明,本技术实施例对此不作具体限定。

122.本技术实施例以电子游戏场景为例,用户可以提前在该终端上进行操作,该终端检测到用户的操作后,可以下载电子游戏的游戏配置文件,该游戏配置文件可以包括该电子游戏的应用程序、界面显示数据或虚拟场景数据等,以使得该用户在该终端上登录电子游戏时可以调用该游戏配置文件,对电子游戏界面进行渲染显示。用户可以在终端上进行触控操作,该终端检测到触控操作后,可以确定该触控操作所对应的游戏数据,并对该游戏数据进行渲染显示,该游戏数据可以包括虚拟场景数据、该虚拟场景中虚拟对象的行为数据等。

123.终端在对虚拟场景进行渲染显示时,可以全屏显示该虚拟场景,终端还可以在当前显示界面显示虚拟场景的同时,在该当前显示界面的第一预设区域独立显示全局地图,实际应用中,终端也可以在检测到对预设按钮的点击操作时,才对该全局地图进行显示。其中,该全局地图用于显示该虚拟场景的缩略图,该缩略图用于描述该虚拟场景对应的地形、地貌、地理位置等地理特征。当然,终端还可以在当前显示界面显示当前虚拟对象周边一定距离内的虚拟场景的缩略图,在检测到对该全局地图的点击操作时,在终端当前显示界面的第二预设区域显示整体虚拟场景的缩略图,以便于用户不仅可以查看其周围的虚拟场景,也可以查看整体虚拟场景。终端在检测到对该完整缩略图的缩放操作时,也可以对完整缩略图进行缩放显示。该第一预设区域和第二预设区域的具体显示位置和形状可以根据用户操作习惯来设定。例如,为了不对虚拟场景造成过多的遮挡,该第一预设区域可以为该当前显示界面右上角、右下角、左上角或左下角的矩形区域等,该第二预设区域可以为当前显示界面的右边或者左边的正方形区域,当然,该第一预设区域和第二预设区域也可以是圆形区域或其他形状的区域,本技术实施例对该预设区域的具体显示位置和形状不作限定。

124.人工智能(artificial intelligence,ai)是利用数字计算机或者数字计算机控制的机器模拟、延伸和扩展人的智能,感知环境、获取知识并使用知识获得最佳结果的理论、方法、技术及应用系统。换句话说,人工智能是计算机科学的一个综合技术,它企图了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器。人工智能也就是研究各种智能机器的设计原理与实现方法,使机器具有感知、推理与决策的功能。

125.人工智能技术是一门综合学科,涉及领域广泛,既有硬件层面的技术也有软件层面的技术。人工智能基础技术一般包括如传感器、专用人工智能芯片、云计算、分布式存储、大数据处理技术、操作/交互系统、机电一体化等技术。人工智能软件技术包括计算机视觉技术和机器学习/深度学习。

126.计算机视觉技术(computer vision,cv)计算机视觉是一门研究如何使机器“看”的科学,更进一步的说,就是指用摄影机和电脑代替人眼对目标进行识别、跟踪和测量等机器视觉,并进一步做图形处理,使电脑处理成为更适合人眼观察或传送给仪器检测的图像。作为一个科学学科,计算机视觉研究相关的理论和技术,试图建立能够从图像或者多维数据中获取信息的人工智能系统。计算机视觉技术通常包括图像处理、图像识别、图像语义理解、图像检索、视频处理、视频语义理解、视频内容/行为识别、三维物体重建、3d技术、虚拟现实、增强现实、同步定位与地图构建等技术,还包括常见的人脸识别、指纹识别等生物特征识别技术。

127.机器学习(machine learning,ml)是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。机器学习是人工智能的核心,是使计算机具有智能的根本途径,其应用遍及人工智能的各个领域。机器学习和深度学习包括人工神经网络、置信网络、强化学习、迁移学习、归纳学习、示教学习等技术。

128.以下将基于人工智能技术和深度学习技术,对本技术实施例提供的人工智能对象控制方法进行说明。

129.为了便于理解本技术实施例,先对本技术实施例涉及到的关键词进行解释:

130.moba(multiplayer online battle arena,多人在线战术竞技)游戏:是一种在虚拟场景中提供若干个据点,处于不同阵营的用户控制虚拟对象在虚拟场景中对战,占领据点或摧毁敌对阵营据点的游戏。例如,moba游戏可将用户分成至少两个敌对阵营,分属至少两个敌对阵营的不同虚拟队伍分别占据各自的地图区域,以某一种胜利条件作为目标进行竞技。该胜利条件包括但不限于:占领据点或摧毁敌对阵营据点、击杀敌对阵营的虚拟对象、在指定场景和时间内保证自身的存活、抢夺到某种资源、在指定时间内互动比分超过对方中的至少一种。例如,手机moba游戏可将用户分成两个敌对阵营,将用户控制的虚拟对象分散在虚拟场景中互相竞争,以摧毁或占领敌方的全部据点作为胜利条件。

131.在moba游戏中,用户可以控制虚拟对象释放技能从而与其他虚拟对象进行战斗,例如,该技能的技能类型可以包括攻击技能、防御技能、治疗技能、辅助技能、斩杀技能等,每个虚拟对象都可以具有各自固定的一个或多个技能,而不同的虚拟对象通常具有不同的技能,不同的技能可以产生不同的作用效果。比如,若虚拟对象释放攻击技能击中了敌对虚拟对象,那么会对敌对虚拟对象造成一定的伤害,通常表现为扣除敌对虚拟对象的一部分虚拟生命值,又比如,若虚拟对象释放治疗技能命中了友方虚拟对象,那么会对友方虚拟对象产生一定的治疗,通常表现为回复友方虚拟对象的一部分虚拟生命值,其他各类技能均可以产生相应的作用效果,这里不再一一枚举。

132.人ai协作:人类和ai在同一个环境中进行协作(共同合作完成某个任务)和交互(互相传递信号比如文字等)。这类ai通常称作协作ai,相对于传统ai智能体的自动化属性,协作ai也强调ai智能体的协作性和交互性。

133.动作可控制ai智能体:动作策略可以被控制指令改变的ai智能体。有些ai智能体通常只具备自动化属性,即智能体可以自主决策自主行动;但是它的动作不可被控制,即外界发起的控制指令无法改变ai智能体的动作。在人ai协作的场景中,ai智能体除了自动化属性外,也要具备协作性和交互性,即智能体要能够跟其它智能体进行协作交互。动作可控制ai智能体就能够满足这种协作交互的需求,它的动作可以被外部控制指令改变,从而可以完成协作交互。

134.图1是本技术实施例提供的一种实施环境的结构示意图,如图1所示,该实施环境包括终端101和服务器102。可选地,该终端101是智能手机、平板电脑、笔记本电脑、台式计算机、智能音箱、智能电视、智能手表等,但并不局限于此。可选地,该服务器102是独立的物理服务器,或者,该服务器102是多个物理服务器构成的服务器集群或者分布式系统,或者,该服务器102是提供云服务、云数据库、云计算、云函数、云存储、网络服务、云通信、中间件

服务、域名服务、安全服务、cdn(content delivery network,内容分发网络)、以及大数据和人工智能平台等基础云计算服务的云服务器。终端101以及服务器102通过有线或无线通信方式进行直接或间接地连接,本技术在此不做限制。

135.服务器102为终端101提供虚拟场景,终端101通过服务器102提供的虚拟场景,能够显示虚拟对象、虚拟道具等,并且终端101为用户提供操作环境,来检测用户执行的操作。服务器102能够针对终端检测到的操作,进行后台处理,为终端101提供后台支持。

136.可选地,终端101安装由服务器102提供服务的游戏应用,通过该游戏应用,终端101与服务器102能够进行交互。终端101运行该游戏应用,为用户提供针对该游戏应用的操作环境,能够检测用户对游戏应用的操作,并向服务器102发送操作指令,由服务器102根据操作指令进行响应,并将响应结果返回给终端101,由终端101进行展示,从而实现人机交互。

137.本技术实施例提供的方法,可用于多种场景。

138.例如,竞技游戏场景下:

139.终端运行竞技游戏,该游戏分为我方阵营和敌方阵营,其中,我方阵营包括终端的被控虚拟对象和人工智能对象。在玩家对我方阵营中的人工智能对象发出控制指令的情况下,终端能够检测到该控制指令,并基于该控制指令控制我方阵营中的人工智能对象执行该控制指令对应的目标操作。例如,该控制指令为集合指令,终端将控制我方阵营的人工智能对象向该终端的被控虚拟对象靠拢,直到完成全员集合,实现了对人工智能对象的控制。

140.又如,在实战模拟场景下:

141.玩家在购买新英雄之后,需要进行多局游戏才能熟悉该英雄,而实战模拟很好地满足了玩家训练新英雄的需求。在实战模拟中,将2个人类玩家的英雄搭配3个人工智能对象,组成一队,将5个人工智能对象组成敌方队,由这两个队伍进行对战。则采用本技术实施例提供的方法,玩家不仅可以控制自己的英雄,而且还可以控制同队中的人工智能对象。

142.图2是本技术实施例提供的一种人工智能对象控制方法的流程图,该方法由终端执行,如图2所示,该方法包括:

143.201、终端显示虚拟场景界面。

144.本技术实施例的虚拟场景包括至少两个敌对阵营的虚拟对象,其中每个阵营中既可以包括由终端操控的虚拟对象,也可以包括人工智能对象,另外还可以包括防御塔等对象。其中,人工智能对象是指基于神经网络模型操控的对象,人工智能对象也可称为ai智能体。

145.而终端显示虚拟场景界面,该虚拟场景界面显示有该终端的被控虚拟对象,另外还可以显示除该被控虚拟对象之外的其他对象,例如该被控虚拟对象的本方阵营中的对象,或者该被控虚拟对象的非本方阵营中的对象。其中,该被控虚拟对象的非本方阵营中的对象包括:该被控虚拟对象的敌方阵营中的对象,以及中立对象,如野怪等。

146.在一种可能实现方式中,虚拟场景界面以终端的被控虚拟对象的第一人称视角显示虚拟场景,则在虚拟场景界面显示该被控虚拟对象的视角范围内的部分虚拟场景,及位于该部分虚拟场景中的其他对象。

147.在另一种可能实现方式中,虚拟场景界面以第三人称视角显示虚拟场景,则在虚拟场景界面显示第三人称视角的视角范围内的部分虚拟场景,及位于该部分虚拟场景中的

该被控虚拟对象和其他对象。

148.202、终端通过虚拟场景界面检测控制指令。

149.本技术实施例提供了一种人与人工智能对象之间交互的方案,用户在虚拟场景界面中触发控制指令,该控制指令用于指示被控虚拟对象的本方阵营中的人工智能对象执行目标操作,后续基于该控制指令,即可控制该人工智能对象执行该目标操作,从而模拟了该人工智能对象按照用户的指示来执行操作的效果,也即是实现了用户与人工智能对象之间的协同配合,也在虚拟场景中营造出了一种被控虚拟对象与人工智能对象之间协同配合的效果。

150.其中,该控制指令可以通过用户在虚拟场景界面中的至少一种操作触发,如点击某个控件的操作、拖动某个控件的操作、滑动操作或选中某个对象的操作等。

151.可选地,该控制指令为攻击指令,或者为撤退指令,或者为集合指令,或者是其他控制指令。

152.以下将对该控制指令进行举例说明:

153.可选地,该控制指令为攻击指令,该终端通过虚拟场景界面检测攻击指令,该攻击指令用于指示人工智能对象攻击非本方阵营的第一目标虚拟对象。

154.在一些实施例中,通过虚拟场景界面,检测攻击指令,包括以下方式:

155.第一种,通过虚拟场景界面检测对攻击控件的触发操作,生成攻击指令,该攻击指令用于指示人工智能对象攻击非本方阵营中与终端的被控虚拟对象距离最近的虚拟对象。

156.其中,该虚拟场景界面显示有攻击控件,用户触发该攻击控件,即可发起该攻击指令,此时默认本次需攻击的第一目标虚拟对象为:非本方阵营中与终端的被控虚拟对象距离最近的虚拟对象。

157.另外,该攻击指令还用于指示该被控虚拟对象的本方阵营中的其他虚拟对象,也攻击非本方阵营中与该被控虚拟对象距离最近的虚拟对象。

158.另外,对攻击控件的触发操作可以为对该攻击控件的点击操作、对该攻击控件的长按操作,或者拖动该攻击控件的操作,或者为对该攻击控件的其他操作。

159.第二种,通过虚拟场景界面检测将攻击控件拖动至第一目标虚拟对象的对象标识的操作,生成攻击指令,该攻击指令用于指示人工智能对象攻击该对象标识对应的虚拟对象。

160.其中,该虚拟场景界面显示有攻击控件和虚拟场景中的至少一个对象的对象标识,其中,该对象标识用于确定唯一的对象,可以为虚拟对象的图标或者名称等。

161.用户将该攻击控件拖动至第一目标虚拟对象的对象标识,即可发起该攻击指令,则本次需攻击的对象即为该对象标识所对应的第一目标虚拟对象。其中,该第一目标虚拟对象可以为非本方阵营中的任一对象,如,第一目标虚拟对象为敌方阵营中的虚拟对象,或者为敌方阵营中的人工智能对象,或者为敌方阵营中的防御塔,或者为野怪,或者为其他虚拟对象。用户将该攻击控件拖动至不同的对象标识,即可指示攻击不同的虚拟对象。

162.另外,该攻击指令还用于指示该被控虚拟对象的本方阵营中的其他虚拟对象,也攻击该对象标识所对应的第一目标虚拟对象。

163.如图3所示,该虚拟场景界面显示有虚拟场景的缩略地图,用户点击该缩略地图,将该缩略地图放大,即在该虚拟场景界面中显示虚拟场景的地图以及攻击控件301,并且该

地图中显示有各个对象的图标。其中,对象标识302为敌方阵营中的某个英雄的图标。用户将该攻击控件301拖动至对象标识302处,即可生成攻击指令,该攻击指令用于指示本方阵营中的人工智能对象攻击对象标识302对应的英雄。

164.如图4所示,该虚拟场景界面显示有虚拟场景的缩略地图,用户点击该缩略地图,将该缩略地图放大,即在该虚拟场景界面中显示虚拟场景的地图以及攻击控件401,并且该地图中显示有各个对象的图标。其中,对象标识402为某只野怪的图标。用户将该攻击控件401拖动至对象标识402处,即可生成攻击指令,该攻击指令用于指示本方阵营中的人工智能对象攻击对象标识402对应的野怪。

165.第三种,通过虚拟场景界面检测对第一目标虚拟对象的对象标识的选中操作,生成攻击指令,该攻击指令用于指示人工智能对象攻击该对象标识对应的虚拟对象。

166.其中,该虚拟场景界面显示有虚拟场景中的至少一个对象的对象标识,其中,该对象标识用于确定唯一的对象,可以为虚拟对象的图标或者名称等。

167.用户触发对第一目标虚拟对象的对象标识的选中操作,即可发起该攻击指令,则本次需攻击的对象即为该对象标识所对应的第一目标虚拟对象。其中,该第一目标虚拟对象可以为非本方阵营中的任一对象,如,第一目标虚拟对象为敌方阵营中的虚拟对象,或者为敌方阵营中的人工智能对象,或者为敌方阵营中的防御塔,或者为野怪,或者为其他虚拟对象。用户选中不同的对象标识,即可指示攻击不同的虚拟对象。

168.另外,该攻击指令还用于指示该被控虚拟对象的本方阵营中的其他虚拟对象,也攻击该对象标识所对应的虚拟对象。

169.如图5所示,该虚拟场景界面显示有虚拟场景的地图及各个对象的图标,其中对象标识501为敌方阵营中的某个英雄的图标。用户触发对该对象标识501的选中操作,即可生成攻击指令,该攻击指令用于指示人工智能对象攻击该对象标识501对应的英雄。

170.如图6所示,该虚拟场景界面显示有虚拟场景的地图及各个对象的图标,其中对象标识601为某只野怪的图标。用户触发对该对象标识601的选中操作,即可生成攻击指令,该攻击指令用于指示人工智能对象攻击该对象标识601对应的野怪。

171.如图7所示,该虚拟场景界面显示有虚拟场景的地图及各个对象的图标,其中对象标识701为敌方阵营中的小兵的图标。用户触发对该对象标识701的选中操作,即可生成攻击指令,该攻击指令用于指示人工智能对象攻击该对象标识701对应的小兵。

172.在本技术实施例中,用户只需触发攻击指令,即可指示本方阵营中的人工智能对象进行攻击,实现了用户与人工智能对象之间的交互,从而提高了本方阵营的操作效率,增强了本方阵营的团队作战能力,从而有助于本方阵营更好地完成团队任务。

173.可选地,该控制指令为撤退指令,该终端通过虚拟场景界面检测撤退指令,该撤退指令用于指示人工智能对象撤退至安全位置。

174.在一些实施例中,通过虚拟场景界面,检测撤退指令,包括以下方式:

175.第一种,通过虚拟场景界面检测对撤退控件的触发操作,生成撤退指令,该撤退指令用于指示人工智能对象撤退至安全位置。

176.其中,该虚拟场景界面显示有撤退控件,用户触发该撤退控件,即可发起该撤退指令,指示人工智能对象撤退至安全位置。此时默认该安全位置为距离各个人工智能对象最近的安全位置,或者为本方阵营中距离各个人工智能对象最近的防御塔所在的位置,或者

为其他位置等。

177.另外,该撤退指令还用于指示该被控虚拟对象的本方阵营中的其他虚拟对象,也撤退至安全位置。

178.另外,对撤退控件的触发操作可以为对该撤退控件的点击操作、对该撤退控件的长按操作,或者拖动该撤退控件的操作,或者为对该撤退控件的其他操作。

179.第二种,通过虚拟场景界面检测将撤退控件拖动至本方阵营的第三目标虚拟对象的对象标识的操作,生成撤退指令,该撤退指令用于指示人工智能对象撤退至第三目标虚拟对象的位置。

180.其中,该虚拟场景界面显示有撤退控件和虚拟场景中的至少一个对象的对象标识,其中,该对象标识用于确定唯一的对象,可以为虚拟对象的图标或者名称等。

181.用户将该撤退控件拖动至第三目标虚拟对象的对象标识,即可发起该撤退指令,则本次人工智能对象需撤退至第三目标虚拟对象所在的位置。其中,该第一目标虚拟对象可以为本方阵营中的任一对象,如,第三目标虚拟对象为本方阵营中的虚拟对象,或者为本方阵营中的人工智能对象,或者为本方阵营中的防御塔。用户将该撤退控件拖动至不同的对象标识,即可指示人工智能对象撤退至不同虚拟对象所在的位置。

182.另外,该撤退指令还用于指示该被控虚拟对象的本方阵营中的其他虚拟对象,也撤退至该第三目标虚拟对象所在的位置。

183.如图8所示,该虚拟场景界面显示有虚拟场景的缩略地图,用户点击该缩略地图,将该缩略地图放大,即在该虚拟场景界面中显示虚拟场景的地图以及撤退控件801,并且该地图中显示有各个对象的图标。其中,对象标识802为本方阵营中的某个防御塔的图标。用户将该攻击控件801拖动至对象标识802处,即可生成撤退指令,该撤退指令用于指示人工智能对象撤退至对象标识802所对应的防御塔所在的位置。

184.第三种,通过虚拟场景界面检测对第三目标虚拟对象的对象标识的选中操作,生成撤退指令,该撤退指令用于指示人工智能对象撤退至第三目标虚拟对象的位置。

185.其中,该虚拟场景界面显示有虚拟场景中的至少一个对象的对象标识,其中,该对象标识用于确定唯一的对象,可以为虚拟对象的图标或者名称等。

186.用户触发对第三目标虚拟对象的对象标识的选中操作,即可发起该撤退指令,则本次人工智能对象需撤退至第三目标虚拟对象所在的位置。其中,该第一目标虚拟对象可以为本方阵营中的任一对象,如,第三目标虚拟对象为本方阵营中的虚拟对象,或者为本方阵营中的人工智能对象,或者为本方阵营中的防御塔。用户选中不同的对象标识,即可指示人工智能对象撤退至不同虚拟对象所在的位置。

187.另外,该撤退指令还用于指示该被控虚拟对象的本方阵营中的其他虚拟对象,也撤退至该第三目标虚拟对象所在的位置。

188.如图9所示,该虚拟场景界面显示有虚拟场景的地图及各个对象的图标,其中对象标识901为本方阵营中的某个防御塔的图标。用户触发对该对象标识901的选中操作,即可生成撤退指令,该撤退指令用于指示人工智能对象撤退至对象标识901对应的防御塔所在的位置。

189.可选地,该控制指令为集合指令,该终端通过虚拟场景界面检测集合指令,该集合指令用于指示人工智能对象向被控虚拟对象或本方阵营的第二目标虚拟对象的位置移动。

190.在本技术实施例中,用户只需触发撤退指令,即可指示本方阵营中的人工智能对象撤退至安全位置,实现了用户与人工智能对象之间的交互,从而提高了本方阵营的操作效率,增强了本方阵营的团队作战能力,从而有助于保护本方阵营中的人工智能对象。

191.在一些实施例中,通过虚拟场景界面,检测集合指令,包括以下方式:

192.第一种,通过虚拟场景界面检测对集合控件的触发操作,生成集合指令,该集合指令用于指示人工智能对象向被控虚拟对象的位置移动。

193.其中,该虚拟场景界面显示有集合控件,用户触发该集合控件,即可发起该集合指令,此时默认人工智能对象需到达被控虚拟对象所在位置,从而与本方阵营中的虚拟对象集合,也即是人工智能对象需向该被控虚拟对象所在位置移动。

194.另外,该集合指令还用于指示该被控虚拟对象的本方阵营中的其他虚拟对象,也向该被控虚拟对象所在位置移动。

195.另外,对集合控件的触发操作可以为对该集合控件的点击操作、对该集合控件的长按操作,或者拖动该集合控件的操作,或者为对该集合控件的其他操作。

196.第二种,通过虚拟场景界面检测将集合控件拖动至本方阵营的第二目标虚拟对象的对象标识的操作,生成集合指令,该集合指令用于指示人工智能对象向第二目标虚拟对象的位置移动。

197.其中,该虚拟场景界面显示有集合控件和虚拟场景中的至少一个对象的对象标识,其中,该对象标识用于确定唯一的对象,可以为虚拟对象的图标或者名称等。

198.用户将该集合控件拖动至第二目标虚拟对象的对象标识,即可发起该集合指令,指示人工智能对象需前往第二目标虚拟对象所在的位置。其中,该第一目标虚拟对象可以为本方阵营中的任一对象,如,第二目标虚拟对象为本方阵营中的虚拟对象,或者为本方阵营中的人工智能对象,或者为本方阵营中的防御塔。用户将该集合控件拖动至不同虚拟对象的对象标识,即可指示人工智能对象撤退至不同虚拟对象所在的位置。

199.另外,该集合指令还用于指示该被控虚拟对象的本方阵营中的其他虚拟对象,也向该对象标识对应的第二目标虚拟对象所在的位置移动。

200.如图10所示,该虚拟场景界面显示有虚拟场景的缩略地图,用户点击该缩略地图,将该缩略地图放大,即在该虚拟场景界面中显示虚拟场景的地图以及集合控件1001,并且该地图中显示有各个对象的图标。其中,对象标识1002为本方阵营中的某个英雄的图标。用户将该集合控件1001拖动至对象标识1002处,即可生成集合指令,该集合指令用于指示人工智能对象向对象标识1002对应的英雄所在位置移动。

201.第三种,通过虚拟场景界面检测对第三目标虚拟对象的对象标识的选中操作,生成集合指令,该集合指令用于指示人工智能对象向第二目标虚拟对象的位置移动。

202.其中,该虚拟场景界面显示有虚拟场景中的至少一个对象的对象标识,其中,该对象标识用于确定唯一的对象,可以为虚拟对象的图标或者名称等。

203.用户触发对第二目标虚拟对象的对象标识的选中操作,即可发起该集合指令,指示人工智能对象需向该第二目标虚拟对象所在的位置移动。其中,该第二目标虚拟对象可以为本方阵营中的任一对象,如,第二目标虚拟对象为本方阵营中的虚拟对象,或者为本方阵营中的人工智能对象,或者为本方阵营中的防御塔。

204.另外,该集合指令还用于指示该被控虚拟对象的本方阵营中的其他虚拟对象,也

向该对象标识对应的第二目标虚拟对象所在的位置移动。

205.在本技术实施例中,用户只需触发集合指令,即可指示本方阵营中的人工智能对象集合,实现了用户与人工智能对象之间的交互,从而提高了本方阵营的操作效率,增强了本方阵营的团队作战能力,从而有助于本方阵营更好地完成团队任务。

206.203、终端基于控制指令,控制人工智能对象执行目标操作。

207.终端检测到控制指令之后,即可基于该控制指令,控制人工智能对象执行目标操作。例如,该控制指令为攻击指令,则基于该控制指令,控制人工智能对象攻击非本方阵营的第一目标虚拟对象。或者,该控制指令为撤退指令,则基于该撤退指令,控制人工智能对象撤退至安全位置。或者,该控制指令为集合指令,则基于该集合指令,控制人工智能对象集合。

208.可选地,该控制指令携带目标虚拟对象的对象标识,该目标操作为向目标虚拟对象移动的操作,则基于该控制指令,终端即可控制人工智能对象执行向目标虚拟对象移动的操作。例如,上述攻击指令、撤退指令或者集合指令,均可看做是指示人工智能对象向目标虚拟对象移动的操作,因此基于这些指令,即可控制人工智能对象移动。

209.需要说明的是,在本技术实施例中,基于控制指令控制人工智能对象执行目标操作,是指控制人工智能对象开始执行该目标操作,而不限定人工智能对象是否一定要将该目标操作执行完成。例如,在控制人工智能对象移动的过程中,如果该人工智能对象与非本方阵营中的其他虚拟对象相遇,则该人工智能对象与该其他虚拟对象进行对战操作,此时将不再继续按照控制指令的指示进行移动。待对战完成后,该人工智能对象可以继续按照控制指令的指示进行移动,也可以不再响应该控制指令。

210.另外,本技术实施例仅是以执行主体为终端为例进行说明,而在另一实施例中,终端与服务器连接,终端上的人工智能对象其实是由服务器基于神经网络模型进行控制,则若要实现对人工智能对象的控制,需要终端与服务器之间进行交互。

211.可选地,终端检测到控制指令之后,向服务器发送该控制指令,服务器用于基于控制指令,调用神经网络模型确定用于完成目标操作的至少一个子操作,控制人工智能对象执行至少一个子操作。

212.服务器中设置有神经网络模型,该神经网络模型用于对人工智能对象所需执行的操作进行预测。在每个时刻,服务器获取当前时刻的状态数据,调用该神经网络对该状态数据进行处理,从而预测出人工智能对象所需执行的操作,向人工智能对象对应的终端发送该操作,以使该终端显示该人工智能对象执行该操作的场景,从而实现了控制该人工智能对象执行该操作的效果。

213.而在本技术实施例中,为了响应控制指令,需要人工智能对象执行目标操作,因此,在每个时刻,服务器会调用神经网络模型确定用于完成该目标操作的子操作,从而控制人工智能对象执行该子操作。其中,任两个相邻的时刻之间的间隔可以为预先设置的目标时长,则服务器每隔该目标时长控制该人工智能对象执行一次子操作,则在至少一次控制之后,该人工智能对象会执行至少一个子操作,以满足该控制指令的要求。因此,子操作可以看做是目标操作的分解操作。

214.需要说明的是,服务器响应控制指令的详细过程可参见下述图11所示的实施例,在此暂不赘述。

215.本技术实施例扩展了人工智能对象的功能,提供了一种操作可控的人工智能对象,用户只需发出控制指令,即可控制与被控虚拟对象属于同一阵营的人工智能对象执行目标操作,实现了对人工智能对象的控制,从而实现了人与人工智能对象之间的协同配合。

216.并且,控制指令包括攻击指令、撤退指令、集合指令等多种指令,增强了控制指令的多样性,实现了对人工智能对象的不同类型的控制。

217.并且,提供了各个控制指令的多种触发方式,为用户提供了多种选择,便于用户的操作。

218.在上述实施例的基础上,该人工智能对象可以由服务器调用神经网络模型进行控制。以下将结合图11对控制该人工智能对象的过程进行详细说明。

219.图11是本技术实施例提供的一种人工智能对象控制方法的流程图,该方法由服务器执行,如图11所示,该方法包括:

220.1101、服务器接收终端发送的控制指令。

221.在本技术实施例中,服务器与终端连接,终端具有对应的被控虚拟对象,而服务器创建有虚拟场景以及人工智能对象,并且会设置神经网络模型,基于神经网络模型控制人工智能对象执行操作。在虚拟场景中,终端的被控虚拟对象与人工智能对象属于同一阵营,可以配合执行操作。

222.为了便于与人工智能对象协同配合,用户在终端上触发控制指令,终端向服务器发送该控制指令,该控制指令用于指示人工智能对象执行目标操作。其中,终端获取该控制指令的过程详见上述图2所示的实施例,在此不再赘述。

223.1102、服务器基于控制指令,控制人工智能对象执行目标操作。

224.其中,该人工智能对象属于终端的被控虚拟对象的本方阵营。

225.例如,该控制指令为攻击指令,则基于该控制指令,控制人工智能对象攻击非本方阵营的第一目标虚拟对象。或者,该控制指令为撤退指令,则基于该撤退指令,控制人工智能对象撤退至安全位置。或者,该控制指令为集合指令,则基于该集合指令,控制人工智能对象集合。

226.可选地,该控制指令携带目标虚拟对象的对象标识,该目标操作为向目标虚拟对象移动的操作,则基于该控制指令,即可控制人工智能对象执行向目标虚拟对象移动的操作。例如,上述攻击指令、撤退指令或者集合指令,均可看作是指示人工智能对象向目标虚拟对象移动的操作,因此基于这些指令,即可控制人工智能对象移动。

227.本技术实施例扩展了人工智能对象的功能,提供了一种操作可控的人工智能对象,用户只需发出控制指令,即可控制与被控虚拟对象属于同一阵营的人工智能对象执行目标操作,实现了对人工智能对象的控制,从而实现了人与人工智能对象之间的协同配合。

228.图12是本技术实施例提供的一种人工智能对象控制方法的流程图,该方法由服务器执行,该方法对服务器控制人工智能对象执行某一子操作的过程进行详细说明。如图12所示,该方法包括:

229.1201、服务器接收终端发送的控制指令。

230.其中,控制指令用于指示人工智能对象执行目标操作。

231.该步骤1201与上述图2和图11所示实施例同理,在此不再赘述。

232.服务器在接收到控制指令后,需要调用神经网络模型,控制人工智能对象执行与

该控制指令对应的目标操作。但是考虑到虚拟场景中各个对象的情况复杂多变,直接控制该人工智能对象执行目标操作,很可能会与当前的虚拟场景的状态不符,因此,为了保证虚拟场景的真实性,以及保证人工智能对象所执行操作的连续性,该服务器会基于控制指令,调用神经网络模型,确定用于完成目标操作的至少一个子操作,控制人工智能对象执行至少一个子操作,以便满足该控制指令的要求。

233.例如,在每个时刻,服务器基于该控制指令,调用神经网络模型确定一个子操作,向终端下发该子操作,终端即可控制该人工智能对象执行该子操作,并在显示界面中显示该人工智能对象执行该子操作。之后在下一个时刻,服务器基于该控制指令,调用神经网络模型确定下一个子操作,向终端下发下一个子操作,终端即可控制该人工智能对象执行该下一个子操作。以此类推,即可按照该控制指令的指示,控制人工智能对象执行多个子操作。其中,任两个相邻时刻之间的间隔为预先设置的目标时长,则服务器每隔该目标时长控制该人工智能对象执行一次子操作。

234.并且,本技术实施例以神经网络模型包括编码网络、融合网络和操作预测网络为例进行说明,调用神经网络模型进行处理的过程详见下述步骤1202-1204。

235.1202、服务器调用编码网络,对多个虚拟对象的状态数据进行编码,得到多个虚拟对象的编码特征。

236.其中,该虚拟对象的状态数据用于表示该虚拟对象当前的状态,例如,该虚拟对象的状态数据包括虚拟对象的名称、类型、血量、技能类型等。该编码网络用于对虚拟对象的状态数据进行编码,得到编码特征。则该编码特征也能够反映出该虚拟对象当前的状态,后续对该编码特征进行处理,即可考虑该虚拟对象当前的状态,来确定人工智能对象可以执行的操作。

237.1203、服务器调用融合网络,基于权重特征,对多个虚拟对象的编码特征进行加权融合,得到融合特征,权重特征包括虚拟场景中的多个虚拟对象的权重参数,且权重特征基于控制指令确定。

238.该融合网络中包括权重特征,权重特征包括虚拟场景中的多个虚拟对象的权重参数,用于表示在预测人工智能对象需执行的操作时该多个虚拟对象的影响程度,基于权重特征对多个虚拟对象的编码特征进行加权融合,能够考虑到不同虚拟对象的不同影响程度,以保证为人工智能对象确定的操作是与虚拟场景中该多个虚拟对象的当前状态是匹配的,所确定的操作是准确的。而为了控制人工智能对象所执行的操作是与控制指令对应的操作,服务器在预测操作之前,首先基于控制指令来确定融合网络中的权重特征。

239.在一种可能实现方式中,控制指令包括被控虚拟对象的第一对象标识和目标虚拟对象的第二对象标识,目标操作为向目标虚拟对象移动的操作,也即是控制指令用于指示人工智能对象向目标虚拟对象移动。相应地,基于控制指令,确定融合网络中的权重特征,包括:将多个虚拟对象的编码特征构成编码矩阵,基于编码矩阵与编码矩阵的转置矩阵相乘得到的矩阵,确定第一权重特征,将第一权重特征中的非关联虚拟对象的权重参数设置为负无穷,得到第二权重特征。对第二权重特征进行归一化处理,将归一化处理后的权重特征确定为融合网络中的权重特征。其中,非关联虚拟对象与被控虚拟对象之间的距离,以及非关联虚拟对象与目标虚拟对象之间的距离均不小于距离阈值。

240.可选地,以下提供一种确定权重特征的操作流程,包括如下步骤:

241.1、输入f=[f1;f2;...;fn];

[0242]

其中,w_logit表示权重特征,f表示编码矩阵,fi表示第i个虚拟对象的编码特征,i和n为正整数,n表示虚拟对象的数量,i小于或等于n,为缩放因子,[

·

]1表示矩阵的第一行向量。

[0243]

由上述公式可知,输入的权重特征的过程包括:从编码矩阵与编码矩阵的转置矩阵相乘得到的矩阵中提取第一行向量,将此向量与缩放因子的乘积确定为该权重特征。

[0244]

2、获取选择性注意力集合s,将终端的被控虚拟对象和目标虚拟对象加入到选择性注意力集合s中。

[0245]

3、如果第i个虚拟对象的编码特征与终端的被控虚拟对象的编码特征之间的距离小于距离阈值,代表第i个虚拟对象为被控虚拟对象的非关联虚拟对象,则将第i个虚拟对象加入到选择性注意力集合s中。

[0246]

4、如果第i个虚拟对象的编码特征与目标虚拟对象的编码特征之间的距离小于距离阈值,代表第i个虚拟对象为目标虚拟对象的非关联虚拟对象,则将第i个虚拟对象加入到选择性注意力集合s中。由此,可以确定选择性注意力集合s中都包括哪些对象。

[0247]

5、针对选择性注意力集合s中不包含的对象,将这些对象的权重参数设置为负无穷,保留选择性注意力集合s中包含的对象的权重参数,从而得到更新后的权重特征w_logit’。之后对该权重特征进行归一化处理,即可得到归一化处理后的权重特征softmax(w_logit’)。

[0248]

采用上述方式确定权重特征,相当于对多个虚拟对象的编码特征采用注意力机制进行处理,能够考虑到重要虚拟对象对目标虚拟对象需执行的操作的影响,而弱化无关虚拟对象对目标虚拟对象需执行的操作的影响,这样确定的操作才更为准确,更符合虚拟场景的当前状态。

[0249]

在确定该权重特征之后,即可基于该权重特征,对该多个虚拟对象的编码特征进行加权融合,得到融合特征。可选地,基于该权重特征中的每个虚拟对象的权重参数,对该多个虚拟对象的编码特征进行加权求和,得到融合特征。或者,基于该权重特征中的每个虚拟对象的权重参数,对该多个虚拟对象的编码特征进行加权平均,得到融合特征。

[0250]

1204、服务器调用操作预测网络,对融合特征进行操作预测,得到操作信息。

[0251]

其中,该操作信息至少包括人工智能对象所需执行的子操作,也即是实现了为人工智能对象预测其要执行的子操作。另外该操作信息还可以包括人工智能对象预计执行该子操作的持续时长,或者还包括提示信息,该提示信息用于展示在终端上,以提示人工智能对象正在执行该子操作,或者还可以包括其他信息。

[0252]

由于该融合特征能够考虑到该控制指令的指示,也能考虑到多个虚拟对象当前的状态以及影响程度,因此根据该融合特征预测出的操作信息更为准确。

[0253]

1205、服务器向终端下发该操作信息。

[0254]

1206、终端接收该操作信息,控制人工智能对象执行该子操作。

[0255]

本技术实施例仅是以控制一次人工智能对象的过程为例,实际上,在接收到该控制指令之后,可以多次执行本技术实施例中的步骤,从而多次控制人工智能对象执行所确定的子操作。

[0256]

以下将结合图13和图14,对游戏过程中控制ai智能体的过程进行举例说明,图13提供了一种深度隐变量神经网络模型的示意图,图14提供了一种终端与服务器的交互示意图。

[0257]

如图13和图14所示,首先,玩家向队友发送控制指令,则玩家所在的终端将控制指令传回服务器,服务器调用深度隐变量神经网络模型,基于控制指令,预测此玩家的ai智能体队友的动作策略(即上述操作信息)。之后服务器将动作策略回传给终端,在终端上ai智能体队友即可根据动作策略执行相应的操作。

[0258]

并且,该深度隐变量神经网络模型的输入为当前的游戏状态数据,包括当前终端所显示的游戏图像,各个虚拟对象的状态数据,用于表示虚拟场景全局状态的全局信息,以及终端的被控虚拟对象的可用技能等。其中,各个虚拟对象可以包括终端的主英雄、其他英雄、兵线、防御塔、野怪等。

[0259]

该深度隐变量神经网络模型包括卷积网络、编码网络、融合网络和操作预测网络。其中,卷积网络对图像进行卷积运算,得到图像特征,编码网络对各个虚拟对象的状态数据进行编码,得到多个虚拟对象的编码特征,而融合网络可以看作是一个隐对齐模块,该隐对齐模块对多个虚拟对象的编码特征进行加权融合之后,再将加权融合得到的特征与该图像特征进行融合,得到融合特征,例如采用concat算子(联结合并多个字符串的算子)将加权融合得到的特征与该图像特征进行融合,得到融合特征。而操作预测网络包括至少一个全连接层和至少一个融合层,从而能够对输入的特征进行全连接或者融合。

[0260]

该隐对齐模块具有权重特征,该权重特征即为隐对齐模块的隐变量,该权重特征包括多个虚拟对象的权重参数,用来对该多个虚拟对象的编码特征进行加权。本质上,隐对齐模块是一个线性加权求和的算子,且权重向量被限制在一个特殊的隐空间内。隐对齐算子的数学表达式如下所示:

[0261][0262][0263]

在以上算子中,是虚拟对象的编码特征,f

fusion

∈rd是融合后的特征向量,是第i个虚拟对象的权重参数,是第i个虚拟对象的权重参数,是概率单纯形,||||0是向量的l0范数即非零元素个数。权重特征w∈rn是一个隐随机变量,计算公式如下:

[0264][0265]

其中,i和n为正整数,n表示虚拟对象的数量,i小于或等于n,为缩放因子,[

·

]1表示矩阵的第一行向量。

[0266]

而该权重特征基于玩家发出的控制指令确定,具体确定方式与上述确定权重特征的操作流程类似,在此不再赘述。

[0267]

隐对齐成功的关键在于:权重特征w∈rn是一个隶属于概率单纯形δ

n-1

内的稀疏向量。权重特征的稀疏性可以理解为是在做虚拟对象的特征选择,即只保留权重参数不为

零的虚拟对象的编码特征参与到预测动作策略的过程中,这实际上是在对齐虚拟对象的编码特征与预测的动作策略,所以权重特征w∈rn也被称作隐对齐变量。这种隐含的特征选择机制是与人类玩家打游戏的直觉相符的:玩家做出的决策只是由少数被重点关注的虚拟对象所决定,这其实是一种选择性注意力机制。如果需要改变预测的动作策略,我们只需要根据接收到的控制指令从概率单纯形δ

n-1

内采样一个权重特征用于预测相应的动作策略即可。

[0268]

该操作预测网络的输出为游戏按键,该游戏按键包括移动键和技能键,该移动键用于指示控制ai智能体队友进行移动,该技能键用于指示控制ai智能体队友释放某种技能,如召唤技能、位置型技能、方向型技能、目标型技能等。

[0269]

本技术实施例提出了一种解决moba游戏中人ai协作的深度隐变量神经网络,其原理是基于隐对齐的方法,控制动作可控制的ai智能体。具体地,可以通过改变神经网络中的隐变量(权重特征)来改变预测的动作策略。在人类玩家与动作可控制的ai智能体队友搭配的游戏中,人类玩家可以通过发送具有某种目的性的控制指令给ai智能体队友,并让ai智能体队友执行指令从而能够主动配合玩家的意图,进而提升游戏的趣味和玩家的体验。

[0270]

需要说明的是,上述图12所示的实施例对调用神经网络模型的过程进行了说明,而为了保证神经网络模型的准确性,需要先训练该神经网络模型。

[0271]

在一种可能实现方式中,该神经网络模型的训练过程包括:获取样本数据,该样本数据包括在任一样本时刻的样本状态数据和样本操作信息,该样本状态数据包括在该样本时刻下,多个虚拟对象的状态数据,该样本操作信息包括在该样本时刻下,该人工智能对象应当执行的操作,则基于该样本数据训练该神经网络模型,也即是基于该神经网络模型对该样本状态数据进行处理,得到预测操作信息,该预测操作信息包括由神经网络模型预测的、在该样本时刻下该人工智能对象应执行的操作,则根据该样本操作信息与该预测操作信息,对该神经网络模型进行训练,以提高该神经网络模型的准确度。在经过一次或多次训练之后,即可得到准确度满足要求的神经网络模型,从而调用训练完成的神经网络模型来预测人工智能对象应执行的操作。

[0272]

其中,该样本状态数据的具体内容与上述步骤1202中的状态数据类似,该样本操作信息和该预测操作信息的具体内容与上述步骤1204中的操作信息类似。息,而得到该预测操作信息的具体处理过程与上述步骤1202-1204类似,在此不再赘述。

[0273]

在另一种可能实现方式中,还可以采用强化学习的方式训练该神经网络模型,在训练过程中,如果人工智能对象响应控制指令成功,则会获得奖励,在经过一次或多次训练后,即可使神经网络模型学习到响应控制指令的能力,从而得到更为准确的神经网络模型。

[0274]

需要说明的另一点是,除该神经网络模型之外,还可以采用其他方式控制人工智能对象。在一个实施例中,该服务器设置有行为树模型,该行为树模型中定义了人工智能对象的操作规则,则该服务器接收到控制指令时,基于该行为树模型的指示,控制该人工智能对象执行目标操作。例如,该控制指令为集合指令,行为树模型中的规则是:一直向集合目标移动,直至到达集合目标附近为止。则基于该行为树模型的指示,即可控制该人工智能模型一直向集合目标移动,直至到达集合目标附近为止。

[0275]

在上述实施例的基础上,为了便于判断是否控制人工智能对象对该控制指令进行响应,本技术实施例还提供了一种验证控制指令的方法,能够先验证控制指令,判断是否允

许响应该控制指令,在允许响应该控制指令的情况下,再基于该控制指令控制人工智能对象。如图15所示,该方法包括:

[0276]

1501、服务器接收终端发送的控制指令,并将该控制指令解析为服务器支持的格式。

[0277]

1502、服务器对该控制指令进行验证。

[0278]

解析该控制指令之后,对解析的控制指令进行验证,判断当前是否需要响应该控制指令,从而筛选出合理的控制指令,以及不合理的控制指令。

[0279]

可选地,服务器预先确定目标规则,该目标规则可以是人工确定的。该控制指令满足该目标规则,则验证通过,即可执行后续步骤1503,而该控制指令不满足该目标规则,则验证不通过,不再执行后续步骤1504。

[0280]

可选地,还可以调用意图预测模型来进行验证,筛选出需要响应的控制指令,过滤掉不需要响应的控制指令。其中,该意图预测模型用于基于当前的状态数据,在虚拟场景中,预测人工智能对象在下一时刻将要到达的第一位置,从而根据该第一位置以及该控制指令所指示的第二位置(指示人工智能对象需要到达的位置),确定是否要响应该控制指令。

[0281]

可选地,将虚拟场景的地图划分为多个网格,如将地图划分为12*12的网格。根据当前的状态数据,确定该人工智能对象的预测位置信息,该状态数据包含该人工智能对象当前的位置,该预测位置信息包括地图中每个网格对应的概率,该概率表示在下一时刻该人工智能对象到达该网格的概率。则该预测位置信息中网格的概率越大,在下一时刻该人工智能对象越有可能到达该网格。那么,将该预测位置信息中概率最大的前k个网格构成集合,该集合即可表示下一时刻该人工智能对象最有可能到达的k个位置,k为正整数。

[0282]

之后将该集合与该控制指令所指示的第二位置进行对比,在该第二位置属于该集合的情况下,该控制指令验证通过,表示允许响应该控制指令。而在该第二位置不属于该集合的情况下,该控制指令验证未通过,表示不允许响应该控制指令。

[0283]

举例来说,如图16所示,为地图中的每个网格按照顺序依次编号,人工智能对象当前在网格121,控制指令要求人工智能对象到达的目标位置在网格89,如果意图预测模型预测的集合p={26,27,89,116,117},该集合中包括网格89,那么人工智能对象可以执行当前的控制指令,从而前往网格89。如果意图预测模型预测的集合p={26,27,80,116,117},该集合中不包括网格89,那么需要拒绝执行当前的控制指令。

[0284]

1503、在控制指令验证通过的情况下,基于该控制指令预测人工智能对象的动作策略。

[0285]

1504、服务器将动作策略回传给终端,以便终端接收服务器回传的动作策略,按照该动作策略控制人工智能对象。

[0286]

可选地,意图预测模型包括编码网络、融合网络和位置预测网络,调用意图预测模型确定人工智能对象的预测位置信息的过程,包括:服务器调用编码网络,对多个虚拟对象的状态数据进行编码,得到多个虚拟对象的编码特征,调用融合网络,基于权重特征,对多个虚拟对象的编码特征进行加权融合,得到融合特征,权重特征包括虚拟场景中的多个虚拟对象的权重参数,服务器调用位置预测网络,对融合特征进行位置预测,得到预测位置信息。

[0287]

其中,调用编码网络、融合网络和位置预测网络的过程与上述步骤1202-1204的过程类似,区别在于,上述步骤1203中,神经网络模型中的融合网络的权重特征是基于所接收到的控制指令确定的,接收到的控制指令不同,该权重特征可能会发生变化。而在本实施例中,意图预测模型训练完成之后,意图预测模型中的融合网络的权重特征是不变的。

[0288]

而在调用该意图预测模型,预测控制指令的意图之前,还需要先训练上述意图预测模型。训练意图预测模型的过程包括:获取样本数据,该样本数据包括在样本时刻多个虚拟对象的状态数据以及对应的位置标签,该状态数据至少包括在该样本时刻的图像帧,该状态数据与上述实施例中的状态数据类似,而该位置标签为在该样本时刻的下一个时刻发生进攻、集合、撤退等目标事件的网格的编号。之后即可基于该样本数据对意图预测模型进行训练,从而得到训练完成的意图预测模型。其中,上述事件定义为以下几种类型:1.发生了攻击行为;2.发生了集合行为;3.发生了撤退行为(从危险之处撤退到安全位置),当然还可以包括其他的事件类型。并且,为了保证训练的准确性,该样本数据可以包括多个样本时刻的状态数据以及对应的位置标签,从而根据连续的多个时刻的状态数据和位置标签训练该意图预测模型。

[0289]

可选地,可以基于人类玩家的数据训练意图预测模型,也即是,在训练意图预测模型的过程中获取到的样本数据是属于人类玩家的,即样本数据中包括人类玩家的被控虚拟对象的状态数据以及对应的位置标签,这样能够保证意图预测模型能够学习到人类玩家的事件,进而在调用意图预测模型预测控制指令的意图时,能够保证该意图是符合人类玩家的行为的。

[0290]

如图17所示,某一英雄从t

s-1

时刻出发,之后在ts时刻发生了攻击行为,所以将[t

s-1

,ts)时间段内的图像帧的位置标签标定为ts时刻的网格编号;同理,该英雄在t

s 1

时刻发生了撤退行为,则将[ts,t

s 1

)时间段内的图像帧的位置标签标定为t

s 1

时刻的网格编号,从而得到了各个时刻的样本数据。

[0291]

而综合上述神经网络模型和上述意图预测模型,本技术实施例还提供了一种同时训练神经网络模型和意图预测模型的方式,也即是,如图18所示,服务器预先创建一种预测模型,该预测模型包括编码网络1801、融合网络1802和预测网络1803,而预测网络1803包括操作预测网络1831和位置预测网络1832,该操作预测网络1831用于预测人工智能对象的操作信息,以确定人工智能对象要执行的操作,而该位置预测网络1832用于预测人工智能对象的预测位置信息,以确定人工智能对象下一时刻要到达的位置。

[0292]

在训练该预测模型时,获取样本数据,该样本数据包括在任一样本时刻的样本状态数据和样本操作信息,以及位置标签,该样本状态数据包括在该样本时刻下,多个虚拟对象的状态数据,该样本操作信息包括在该样本时刻下,该人工智能对象应当执行的操作,而该位置标签为在该样本时刻的下一个时刻发生进攻、集合、撤退等事件的网格的编号。则基于该样本数据训练该预测模型,也即是基于该预测模型对该样本状态数据进行处理,得到预测操作信息和预测位置标签,该预测操作信息包括由预测模型预测的、在该样本时刻下该人工智能对象应执行的操作,该预测位置信息包括人工智能对象在下一时刻要到达的位置,则根据该样本操作信息与该预测操作信息,以及该位置标签和该预测位置信息,对该预测模型进行训练,以提高该预测模型的准确度。在经过一次或多次训练之后,即可得到准确度满足要求的预测模型,从而调用训练完成的预测模型来进行预测。

[0293]

举例来说,从图13和图19可以看出,在图13所示的深度隐变量神经网络模型中增添另一个全连接层,用于预测人工智能对象下一时刻要到达的位置,从而得到图19所示的深度隐变量神经网络模型,训练图19所示的深度隐变量神经网络模型即可。

[0294]

这种综合训练的方式,能够同时训练出具备操作预测和位置预测功能的预测模型,提高了训练速度,节省了训练时间。

[0295]

在一种可能实现方式中,在训练完成之后,为了分别实现操作预测功能和位置预测功能,基于已训练好的网络分别构建如图20所示的意图预测模型和如图21所示的神经网络模型。意图预测模型包括编码网络2001、融合网络2002和位置预测网络2003,神经网络模型包括编码网络2101、融合网络2102和操作预测网络2103。其中,编码网络2001和编码网络2101是由图18中的编码网络1801训练得到的,融合网络2002和融合网络2102是由图18中的融合网络1802训练得到的,位置预测网络2003是由图18中的位置预测网络1832训练得到的,操作预测网络2103是由图18中的操作预测网络1831训练得到的。

[0296]

相应的,在服务器接收到控制指令之后,先调用意图预测模型,基于多个虚拟对象的状态数据确定人工智能对象的预测位置信息,该预测位置信息包括人工智能对象下一时刻可能到达的位置组成的集合,控制指令指示人工智能对象需到达的位置属于该集合的情况下,表示控制指令验证通过。则服务器基于该控制指令,确定融合网络2102中的权重特征,之后调用神经网络模型确定人工智能对象的操作信息。

[0297]

并且,虽然在调用意图预测模型时,已经基于多个虚拟对象的状态数据确定多个虚拟对象的编码特征,但是后续在调用神经网络模型时,服务器还可以重新基于多个虚拟对象的状态数据确定多个虚拟对象的编码特征,以预测人工智能对象的操作信息。而且服务器可以对该多个虚拟对象的状态数据进行更改,例如,控制指令包括目标虚拟对象的第二对象标识,目标操作为向目标虚拟对象移动的操作,也即是控制指令指示人工智能对象到达该目标虚拟对象所在的位置。但是如果该目标虚拟对象不是该人工智能对象的攻击对象,神经网络模型是不会控制该人工智能对象移动至该目标虚拟对象所在的位置的,因此为了使神经网络模型能够控制该人工智能对象移动至该目标虚拟对象所在的位置,首先将该多个虚拟对象的状态数据中,人工智能对象的攻击对象的位置信息更改为该目标虚拟对象附近的位置信息,例如将该人工智能对象的攻击对象的坐标更改,以使更改后的坐标与该目标虚拟对象的坐标之间的距离小于预设距离,则人工智能对象会误以为攻击对象在该目标虚拟对象附近,因此会向该攻击对象移动,从而实现了向该目标虚拟对象移动的效果。

[0298]

在另一种可能实现方式中,为了节省处理流程,意图预测模型和神经网络模型可以共享相同的编码网络,如图22所示,编码网络2001和编码网络2101是同一个编码网络,服务器调用编码网络2001,基于多个虚拟对象的状态数据确定多个虚拟对象的编码特征,之后调用融合网络2002和位置预测网络2003确定人工智能对象的预测位置信息,该预测位置信息包括人工智能对象下一时刻可能到达的位置组成的集合,控制指令指示人工智能对象需到达的位置属于该集合的情况下,表示控制指令验证通过。则服务器基于该控制指令,确定融合网络2102中的权重特征,之后调用融合网络2102和操作预测网络2103,对编码网络2001得到的编码特征进行预测,从而确定人工智能对象的操作信息。

[0299]

图23是本技术实施例提供的一种人工智能对象控制装置的结构示意图。参见图23,该装置包括:

[0300]

显示模块2301,用于显示虚拟场景界面,虚拟场景界面显示有本端的被控虚拟对象;

[0301]

检测模块2302,用于通过虚拟场景界面检测控制指令,控制指令用于指示被控虚拟对象的本方阵营中的人工智能对象执行目标操作;

[0302]

控制模块2303,用于基于控制指令,控制人工智能对象执行目标操作。

[0303]

本技术实施例提供的人工智能对象控制装置,实现了人与人工智能对象之间的交互,该人工智能对象的操作是可控的,用户只需发出控制指令,即可控制与被控虚拟对象属于同一阵营的人工智能对象执行目标操作,实现了对人工智能对象的控制,从而实现了人与人工智能对象之间的协同配合,扩展了人工智能对象的功能。

[0304]

可选地,检测模块2302,包括:

[0305]

第一检测单元,用于通过虚拟场景界面,检测攻击指令,攻击指令用于指示人工智能对象攻击非本方阵营的第一目标虚拟对象;或者,

[0306]

第二检测单元,用于通过虚拟场景界面,检测撤退指令,撤退指令用于指示人工智能对象撤退至安全位置;或者,

[0307]

第三检测单元,用于通过虚拟场景界面,检测集合指令,集合指令用于指示人工智能对象向被控虚拟对象或本方阵营的第二目标虚拟对象的位置移动。

[0308]

可选地,第一检测单元,用于:

[0309]

通过虚拟场景界面检测对攻击控件的触发操作,生成攻击指令,第一目标虚拟对象为非本方阵营中与被控虚拟对象距离最近的虚拟对象;或者,

[0310]

通过虚拟场景界面检测将攻击控件拖动至第一目标虚拟对象的对象标识的操作,生成攻击指令;或者,

[0311]

通过虚拟场景界面检测对第一目标虚拟对象的对象标识的选中操作,生成攻击指令。

[0312]

可选地,第二检测单元,用于:

[0313]

通过虚拟场景界面检测对撤退控件的触发操作,生成撤退指令,撤退指令用于指示人工智能对象撤退至安全位置;或者,

[0314]

通过虚拟场景界面检测将撤退控件拖动至本方阵营的第三目标虚拟对象的对象标识的操作,生成撤退指令,撤退指令用于指示人工智能对象撤退至第三目标虚拟对象的位置;或者,

[0315]

通过虚拟场景界面检测对第三目标虚拟对象的对象标识的选中操作,生成撤退指令,撤退指令用于指示人工智能对象撤退至第三目标虚拟对象的位置。

[0316]

可选地,第三检测单元,用于:

[0317]

通过虚拟场景界面检测对集合控件的触发操作,生成集合指令,集合指令用于指示人工智能对象向被控虚拟对象的位置移动;或者,

[0318]

通过虚拟场景界面检测将集合控件拖动至本方阵营的第二目标虚拟对象的对象标识的操作,生成集合指令,集合指令用于指示人工智能对象向第二目标虚拟对象的位置移动;或者,

[0319]

通过虚拟场景界面检测对第三目标虚拟对象的对象标识的选中操作,生成集合指令,集合指令用于指示人工智能对象向第二目标虚拟对象的位置移动。

[0320]

可选地,控制指令携带目标虚拟对象的对象标识,目标操作为向目标虚拟对象移动的操作;

[0321]

控制模块2303,包括:

[0322]

第一控制单元,用于基于控制指令,控制人工智能对象执行向目标虚拟对象移动的操作。

[0323]

可选地,控制模块2303,包括:

[0324]

第二控制单元,用于向服务器发送控制指令,服务器用于基于控制指令,调用神经网络模型确定用于完成目标操作的至少一个子操作,控制人工智能对象执行至少一个子操作。

[0325]

上述所有可选技术方案,可以采用任意结合形成本技术的可选实施例,在此不再一一赘述。

[0326]

图24是本技术实施例提供的一种人工智能对象控制装置的结构示意图。参见图24,该装置包括:

[0327]

接收模块2401,用于接收终端发送的控制指令,该控制指令用于指示人工智能对象执行目标操作;

[0328]

控制模块2402,用于基于控制指令,控制人工智能对象执行目标操作;

[0329]

其中,人工智能对象属于终端的被控虚拟对象的本方阵营。

[0330]

本技术实施例提供的人工智能对象控制装置,实现了终端与服务器之间的交互,服务器在接收到控制指令的情况下,能够控制与终端属于同一阵营的人工智能对象执行相应的目标操作,实现了对人工智能对象的控制,从而实现了人与人工智能对象之间的协同配合,扩展了人工智能对象的功能。

[0331]

可选地,控制模块2402,包括:

[0332]

第一控制单元,用于基于控制指令,调用神经网络模型确定用于完成目标操作的至少一个子操作,控制人工智能对象执行至少一个子操作。

[0333]

可选地,神经网络模型包括编码网络、融合网络和操作预测网络,第一控制单元,包括:

[0334]

编码子单元,用于调用编码网络,对多个虚拟对象的状态数据进行编码,得到多个虚拟对象的编码特征;

[0335]

融合子单元,用于调用融合网络,基于权重特征,对多个虚拟对象的编码特征进行加权融合,得到融合特征,权重特征包括虚拟场景中的多个虚拟对象的权重参数,且权重特征基于控制指令确定;

[0336]

预测子单元,用于调用操作预测网络,对融合特征进行操作预测,得到操作信息,操作信息至少包括人工智能对象所需执行的子操作。

[0337]

可选地,控制指令包括被控虚拟对象的第一对象标识和目标虚拟对象的第二对象标识,目标操作为向目标虚拟对象移动的操作;

[0338]

第一控制单元,还包括:

[0339]

确定子单元,用于:

[0340]

将多个虚拟对象的编码特征构成编码矩阵;

[0341]

基于编码矩阵与编码矩阵的转置矩阵相乘得到的矩阵,确定第一权重特征;

[0342]

将第一权重特征中的非关联虚拟对象的权重参数设置为负无穷,得到第二权重特征,非关联虚拟对象与被控虚拟对象之间的距离,以及非关联虚拟对象与目标虚拟对象之间的距离均不小于距离阈值;

[0343]

对第二权重特征进行归一化处理,将归一化处理后的权重特征确定为融合网络中的权重特征。

[0344]

可选地,控制模块2402,包括:

[0345]

验证单元,用于调用意图预测模型,对控制指令进行验证;

[0346]

第二控制单元,用于在控制指令验证通过的情况下,基于控制指令,控制人工智能对象执行目标操作。

[0347]

上述所有可选技术方案,可以采用任意结合形成本技术的可选实施例,在此不再一一赘述。

[0348]

需要说明的是:上述实施例提供的人工智能对象控制装置在控制人工智能对象执行目标操作时,仅以上述各功能模块的划分进行举例说明,实际应用中,可以根据需要而将上述功能分配由不同的功能模块完成,即将设备的内部结构划分成不同的功能模块,以完成以上描述的全部或者部分功能。另外,上述实施例提供的人工智能对象控制装置与人工智能对象控制方法实施例属于同一构思,其具体实现过程详见方法实施例,这里不再赘述。

[0349]

图25示出了本技术一个示例性实施例提供的终端2500的结构示意图。终端2500包括有:处理器2501和存储器2502。

[0350]

处理器2501可以包括一个或多个处理核心,比如4核心处理器、8核心处理器等。处理器2501可以采用dsp(digital signal processing,数字信号处理)、fpga(field programmable gate array,现场可编程门阵列)、pla(programmable logic array,可编程逻辑阵列)中的至少一种硬件形式来实现。一些实施例中,处理器2501可以包括ai(artificial intelligence,人工智能)处理器,该ai处理器用于处理有关机器学习的计算操作。

[0351]

存储器2502可以包括一个或多个计算机可读存储介质,该计算机可读存储介质可以是非暂态的。存储器2502还可包括高速随机存取存储器,以及非易失性存储器,比如一个或多个磁盘存储设备、闪存存储设备。在一些实施例中,存储器2502中的非暂态的计算机可读存储介质用于存储至少一条计算机程序,该至少一条计算机程序用于被处理器2501所具有以实现本技术中方法实施例提供的人工智能对象控制方法。

[0352]

在一些实施例中,终端2500还可选包括有:外围设备接口2503和至少一个外围设备。处理器2501、存储器2502和外围设备接口2503之间可以通过总线或信号线相连。各个外围设备可以通过总线、信号线或电路板与外围设备接口2503相连。可选地,外围设备包括:射频电路2504或显示屏2505中的至少一种。另外还可以包括其他组件。

[0353]

外围设备接口2503可被用于将i/o(input/output,输入/输出)相关的至少一个外围设备连接到处理器2501和存储器2502。在一些实施例中,处理器2501、存储器2502和外围设备接口2503被集成在同一芯片或电路板上;在一些其他实施例中,处理器2501、存储器2502和外围设备接口2503中的任意一个或两个可以在单独的芯片或电路板上实现,本实施例对此不加以限定。

[0354]

射频电路2504用于接收和发射rf(radio frequency,射频)信号,也称电磁信号。

射频电路2504通过电磁信号与通信网络以及其他通信设备进行通信。射频电路2504将电信号转换为电磁信号进行发送,或者,将接收到的电磁信号转换为电信号。可选地,射频电路2504包括:天线系统、rf收发器、一个或多个放大器、调谐器、振荡器、数字信号处理器、编解码芯片组、用户身份模块卡等等。射频电路2504可以通过至少一种无线通信协议来与其它设备进行通信。该无线通信协议包括但不限于:城域网、各代移动通信网络(2g、3g、4g及5g)、无线局域网和/或wifi(wireless fidelity,无线保真)网络。在一些实施例中,射频电路2504还可以包括nfc(near field communication,近距离无线通信)有关的电路,本技术对此不加以限定。

[0355]

显示屏2505用于显示ui(user interface,用户界面)。该ui可以包括图形、文本、图标、视频及其它们的任意组合。当显示屏2505是触摸显示屏时,显示屏2505还具有采集在显示屏2505的表面或表面上方的触摸信号的能力。该触摸信号可以作为控制信号输入至处理器2501进行处理。此时,显示屏2505还可以用于提供虚拟按钮和/或虚拟键盘,也称软按钮和/或软键盘。在一些实施例中,显示屏2505可以为一个,设置在终端2500的前面板;在另一些实施例中,显示屏2505可以为至少两个,分别设置在终端2500的不同表面或呈折叠设计;在另一些实施例中,显示屏2505可以是柔性显示屏,设置在终端2500的弯曲表面上或折叠面上。甚至,显示屏2505还可以设置成非矩形的不规则图形,也即异形屏。显示屏2505可以采用lcd(liquid crystal display,液晶显示屏)、oled(organic light-emitting diode,有机发光二极管)等材质制备。

[0356]

本领域技术人员可以理解,图25中示出的结构并不构成对终端2500的限定,可以包括比图示更多或更少的组件,或者组合某些组件,或者采用不同的组件布置。

[0357]

图26是本技术实施例提供的一种服务器的结构示意图,该服务器2600可因配置或性能不同而产生比较大的差异,可以包括一个或一个以上处理器(central processing units,cpu)2601和一个或一个以上的存储器2602,其中,所述存储器2602中存储有至少一条计算机程序,所述至少一条计算机程序由所述处理器2601加载并执行以实现上述各个方法实施例提供的方法。当然,该服务器还可以具有有线或无线网络接口、键盘以及输入输出接口等部件,以便进行输入输出,该服务器还可以包括其他用于实现设备功能的部件,在此不做赘述。

[0358]

本技术实施例还提供了一种计算机可读存储介质,该计算机可读存储介质中存储有至少一条计算机程序,该至少一条计算机程序由处理器加载并执行,以实现上述实施例的人工智能对象控制方法中所执行的操作。

[0359]

本技术实施例还提供了一种计算机程序产品或计算机程序,计算机程序产品或计算机程序包括计算机程序代码,计算机程序代码存储在计算机可读存储介质中,计算机设备的处理器从计算机可读存储介质读取计算机程序代码,处理器执行计算机程序代码,使得计算机设备实现如上述实施例的人工智能对象控制方法中所执行的操作。在一些实施例中,本技术实施例所涉及的计算机程序可被部署在一个计算机设备上执行,或者在位于一个地点的多个计算机设备上执行,又或者,在分布在多个地点且通过通信网络互连的多个计算机设备上执行,分布在多个地点且通过通信网络互连的多个计算机设备可以组成区块链系统。

[0360]

本领域普通技术人员可以理解实现上述实施例的全部或部分步骤可以通过硬件

来完成,也可以通过程序来指令相关的硬件完成,所述的程序可以存储于一种计算机可读存储介质中,上述提到的存储介质可以是只读存储器,磁盘或光盘等。

[0361]

以上所述仅为本技术实施例的可选实施例,并不用以限制本技术实施例,凡在本技术实施例的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本技术的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。