1.本技术涉及语音合成技术领域,特别是涉及一种语音合成方法及装置、电子设备和存储介质。

背景技术:

2.语音合成技术是实现人机交互的核心技术之一。随着语音合成技术的不断发展和完善,目前语音合成已经广泛应用到社会生活的方方面面,包括公共服务(信息播报、智能客服等)、智能硬件(智能音箱、智能机器人等)、智慧交通(语音导航、智能车载设备等)、教育(智慧课堂、外语学习等)、泛娱乐(有声阅读、影视配音、虚拟形象等)等领域。

3.目前,语音合成技术已经能够达到接近真人发声水平,而提升合成语音的自由度以及降低合成系统构建代价成为当前语音合成技术的研究热点之一。通过让同一个发音人录制不同情感、不同风格的语音数据进行建模,虽然可以解决该问题,但是这种方式对发音人的能力要求很高,发音人寻找和音频录制的难度都比较大。有鉴于此,如何在提升语音合成自由度的同时,降低其成本成为亟待解决的问题。

技术实现要素:

4.本技术主要解决的技术问题是提供一种语音合成方法及装置、电子设备和存储介质,能够在提升语音合成自由度的同时,降低其成本。

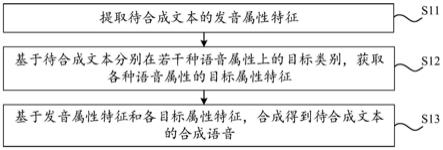

5.为了解决上述技术问题,本技术第一方面提供了一种语音合成方法,包括:提取待合成文本的发音属性特征;且基于待合成文本分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征;再基于发音属性特征和各目标属性特征,合成得到待合成文本的合成语音。

6.为了解决上述技术问题,本技术第二方面提供了一种语音合成方法,包括:提取待处理语音的发音属性特征;基于待处理语音分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征;再基于发音属性特征和各目标属性特征,合成得到待处理语音的合成语音。

7.为了解决上述技术问题,本技术第三方面提供了一种语音合成装置,包括提取模块、获取模块和合成模块,提取模块用于提取待合成文本的发音属性特征;获取模块用于基于待合成文本分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征;合成模块用于基于发音属性特征和各目标属性特征,合成得到待合成文本的合成语音。

8.为了解决上述技术问题,本技术第四方面提供了一种语音合成装置,包括提取模块、获取模块和合成模块,提取模块用于提取待合成文本的发音属性特征;获取模块用于基于待合成文本分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征;合成模块用于基于发音属性特征和各目标属性特征,合成得到待合成文本的合成语音。

9.为了解决上述技术问题,本技术第五方面提供了一种电子设备,包括相互耦接的存储器和处理器,存储器中存储有程序指令,处理器用于执行程序指令以实现上述第一方

面或第二方面中的语音合成方法。

10.为了解决上述技术问题,本技术第六方面提供了一种计算机可读存储介质,存储有能够被处理器运行的程序指令,所述程序指令用于实现上述第一方面或第二方面中的语音合成方法。

11.上述方案,通过提取待合成文本的发音属性特征,再基于待合成文本分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征;最后基于发音属性特征和各目标属性特征,合成得到待合成文本的合成语音。一方面由于无需人为进行大量的语音录制,节省了时间,有助于降低语音合成的成本,另一方面由于在语音合成过程中,通过获取待合成文本分别在若干语音属性上的目标类别,获取各种语音属性的目标属性特征,在此基础上再进行语音合成,能够合成具有任意类别语音属性的语音数据,提升了语音合成的自由度。故此,能够在提升语音合成自由度的同时,降低其成本。

附图说明

12.图1是本技术语音合成方法一实施例的流程示意图;

13.图2是图1中步骤s12一实施例的属性特征提取示意图;

14.图3是图1中步骤s13一实施例的属性特征合成示意图;

15.图4是本技术语音合成方法另一实施例的流程示意图;

16.图5是本技术语音合成装置一实施例的框架示意图;

17.图6是本技术语音合成装置另一实施例的框架示意图;

18.图7是本技术电子设备一实施例的框架示意图;

19.图8是本技术计算机可读存储介质一实施例的框架示意图。

具体实施方式

20.下面结合说明书附图,对本技术实施例的方案进行详细说明。

21.以下描述中,为了说明而不是为了限定,提出了诸如特定系统结构、接口、技术之类的具体细节,以便透彻理解本技术。

22.本文中术语“系统”和“网络”在本文中常被可互换使用。本文中术语“和/或”,仅仅是一种描述关联对象的关联关系,表示可以存在三种关系,例如,a和/或b,可以表示:单独存在a,同时存在a和b,单独存在b这三种情况。另外,本文中字符“/”,一般表示前后关联对象是一种“或”的关系。此外,本文中的“多”表示两个或者多于两个。

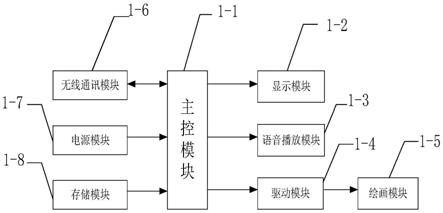

23.请参阅图1,图1是本技术语音合成方法一实施例的流程示意图。

24.具体而言,可以包括如下步骤:

25.步骤s11:提取待合成文本的发音属性特征。

26.在一个实施场景中,发音属性可以包括但不限于发音内容信息等,在此不做限定。具体而言,可以先提取待合成文本的发音序列,且发音序列中包含若干发音标记,再分别对各个发音标记进行特征编码,从而得到待合成文本的发音属性特征。示例性地,可以采用国际音标(international phonetic alphabet,ipa)对待合成文本其发音内容信息进行标记,得到发音序列;此外,可以采用独热编码(one-hot)对各个发音标记进行特征编码。具体过程,可以参阅诸如ipa、one-hot等技术细节,在此不再赘述。

27.步骤s12:基于待合成文本分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征。

28.在一个实施场景中,若干种语音属性包括信道属性、方言属性、音色属性、情感属性、风格属性中至少一种。上述方式,通过将语音属性进行区分,即将耦合在一起的语音信息通过解耦合的方式区分为多种语音属性,有助于在语音合成过程中提高语音合成的多样性,并且提高了语音合成的效率。

29.在一个实施场景中,语音属性可控的难点在于语音中包含了许多信息耦合,为了实现对语音中包含的属性信息进行自由组合并且控制合成,需要对语音属性进行区分,并且将耦合的信息进行解耦合,进而实现自由组合控制语音合成的内容。语音中包括了丰富的属性信息,为实现对实行信息的控制,首先需要确定语音属性的类别,语音属性的具体类别可以根据具体的应用场景进行设置,在此不做具体限制。本技术以语音属性中的信道属性、方言属性、音色属性、情感属性、风格属性为例,对语音合成过程进行说明。

30.在一个具体实施场景中,信道属性是指语音所处的环境,例如录音棚、会议室、车载等,不同的录音环境,语音的信道属性不同,听感也会不同,可以通过控制语音信道属性进行语音生成,可以使合成的语音听感与场景更加相符、合成语音更加真实;方言属性是指一个语种下的不同方言,例如中文下的普通话、东北话等或者英语下的英式英语、美式英语等。根据使用的语种场景确定方言类别;音色属性是指语音中包含的用以区分说话人身份的人声音色信息;情感属性是指语音中包含的情感类别,例如:中立、高兴、悲伤、生气等等;风格属性是指语音的讲话风格,例如:新闻、交互、客服、小说等不同场景下的讲话风格。在语音属性确定之后,还可以对若干种语音属性进行细分类别,例如:对于音色属性,可以每个说话人作为一个类别,也可以以性别作为一个类别,还可以以年龄区间作为一个类别,音色属性的具体分类可以根据实际情况进行设置,在此不做具体限定。对于情感等有成熟类别划分的属性,依据应用需求确定。对于情感等有成熟类别划分的属性,可以依据应用需求确定。

31.在一个实施场景中,语音属性包括多种类别,为确保语音合成的准确性需要收集语音数据,依据语音属性的多种类别进行语音数据收集,以覆盖这些语音属性类别。为确保不同类别之间的语音属性在进行解耦合时的正确率,应确保若干个语音属性中的各个属性类别至少收集两人以上的语音数据。在此过程中,语音数据可以通过发音人进行录制;语音数据也可以通过搜集等途径获取得到;语音数据还可以通过公告场所的录音设备中的录音数据经过处理得到。具体语音数据的收集方法可以根据实际应用中场景进行选择,在此不做具体限制。

32.在一个实施场景中,根据待合成文本分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征,至少包括:基于与各种语音属性的属性类别相关的语音数据进行特征建模,得到各种语音属性的属性空间概率分布模型;再基于待合成文本在语音属性上的目标类别,在对应语音属性的属性空间概率分布模型进行采样,得到对应语音属性的目标属性特征。上述方式,通过对语音属性的属性类别相关的语音数据进行特征建模,可以得到语音属性的属性空间概率分布模型,空间概率分布模型中可以对不同属性类别进行区域划分,得到相同语音属性下的不同属性类别的分布空间,有助于语音合成过程中对数据的采样,提高了语音合成的效率。

33.在一个实施场景中,每种语音属性具有至少一种属性类别;再基于与各种语音属性的属性类别相关的语音数据进行特征建模,得到各种语音属性的属性空间概率分布模型,包括:对于语音属性下各种属性类别,提取与属性类别相关的语音数据关于语音属性的样本属性特征;再基于关于语音属性下各种属性类别的样本属性特征,构建得到语音属性的属性空间概率分布模型。上述方式,通过构建语音属性的属性空间概率分布模型,在语音合成过程中可以在分布模型中直接采样得到对应属性特征,提高了语音合成的效率。

34.在一个实施场景中,在获取各种语音属性的目标属性特征的过程中,可以通过人工标注的方式对目标属性进行提取,还可以通过对各个语音属性类别相关的语音数据进行特征建模,得到各种语音属性的属性空间概率分布模型,通过对目标语音属性的属性空间概率分布采样得到目标属性特征,目标属性特征的具体获取方式可以根据实际应用场景进行选择,在此不做具体限定。

35.在一个具体实施场景中,在对各种语音属性的属性类别相关的语音数据进行特征建模之前,需要对语音数据中的各个属性类别特征进行提取,再对属性特征进行建模,得到各种语音属性的属性空间概率分布模型。对目标属性进行提取的过程中,可以通过建立特征提取模型对目标属性进行提取,还可以通过人工标注的方式对目标属性进行提取,对目标属性进行提取的具体方式可以根据实际情况进行设置,在此不做具体限定。

36.在一个具体实施场景中,通过人工标注的方式对目标属性类别特征进行提取,人工标注方法是指人在听语音后标注对应的属性特征,然后通过一定的编码方式对该标注信息进行编码,将编码后的特征作为该属性信息的表征特征。例如:语音属性中若包括发音属性,发音属性可以采用国际音标(international phonetic alphabet,ipa)对语音中的发音内容进行标注,获得语音的发音序列标注,然后采用独热编码对发音序列中的每个发音进行编码得到编码表征序列。或者,对于情感属性进行人工标注,情感属性包括中立、高兴、悲伤、生气等等类别,对于情感属性可以通过独热编码进行标注,中立可以标注为1000,高兴可以标注为0100,悲伤可以标注为0010,生气可以标注为0001;对于情感属性还可以通过阿拉伯数字进行编码,中立可以标注为1,高兴可以标注为2,悲伤可以标注为3,生气可以标注为4。在对目标属性进行人工标注的过程中,可以根据实际情况选择不同的编码方式进行标注,在此不做具体限定。

37.在一个具体实施场景中,通过建立特征进而采用模型训练方式提取模型对目标属性类别特征进行提取,模型训练的方法可以包括但不限于有监督学习、自监督学习、建模方法等等。其中,有监督学习方法的学习方式中,首先利用已有的属性标注数据作为训练数据,训练情感分类模型。例如:以情感属性为例,情感属性的训练数据可以是录制得到的语音数据也可以是额外收集的带情感标注的语音数据。可以利用情感分类模型对语音数据进行情感预测,得到语音数据的预测情感类别,并基于语音数据标注的样本情感类别与预测情感类别之间的差异,调整情感分类模型的网络参数,以此来实现对情感分类模型的训练。需要说明的是,情感分类模型可以采用深度神经网络、卷积神经网络等,在此不做限定。此外,可以通过最小化交叉熵损失函数对模型不断更新优化,以得到训练收敛的情感分类模型。在此情况下,可以将情感分类模型的最后一层隐层特征作为当前语音的情感属性特征。此外,为了使得提取得到的情感属性特征不包含其他属性的特征信息,在情感分类模型的训练过程中,可以额外设计信息约束准则,例如最小化与音色的互信息等准则,约束提取的

信息表征不受其他属性特征的影响。其他语音属性可以以此类推,在此不再一一举例。

38.请参阅图2,图2是图1中步骤s12一实施例的属性特征提取示意图,如图2所示,语音数据20是通过多种方式收集的音频信息,且若干属性模块可以包括信道属性模块21、方言属性模块22、音色属性模块23、情感属性模块24和风格属性模块25,并且各个属性模块可以是基于人工标注或者模型学习的方法获得的。当然,若干属性模块还可以包括发音属性模块(未图示),通过发音属性模块可以提取发音属性特征,发音属性模块的具体提取过程,可以参阅前述关于提取发音属性特征的相关描述,在此不再赘述。与各个属性模块对应地,属性特征可以包括信道属性特征210、方言属性特征220、音色属性特征230、情感属性特征240和风格属性特征250,并且属性特征是根据对应属性模块获得的。经过大量语音数据对应的属性特征提取,可以得到各个属性中不同属性类别对应的不同属性类别特征。根据语音属性下各种属性类别的样本属性特征,构建得到语音属性的属性空间概率分布模型。根据语音属性的属性空间概率分布模型,可以获取不同属性类别的对应属性特征。

39.在一个实施场景中,根据与各种语音属性的属性类别相关的语音数据进行特征建模,得到各种语音属性的属性空间概率分布模型。对语音属性进行属性空间概率分布模型进行建模的方法可以包括但不限于最大似然准则的建模方法等等,其中,采用的模型结构包括但不限于高斯混合模型、流模型等。在语音属性的属性空间概率分布模型建立之后,进行语音合成的过程中,可以利用概率分布进行不同属性类别的采样,得到目标属性类别特征。此外,为了对属性空间概率分布实现有控制的采样,在建模时输入其他精细的控制信息对属性特征空间的条件概率分布进行建模。例如对于情感空间,在建模时,将情感类别信息输入模型中进行建模。由此,在生成阶段,可以采样得到指定的情感属性类别特征,从而可以实现更加精细的采样预测。

40.在一个具体实施场景中,进行语音属性的属性空间概率分布模型的属性特征是需要从模型学习方法中从语音中获取的,且在对语音属性的属性空间概率分布建立模型时,可以有选择的对语音属性建立模型,具体选择方式可以根据具体情况进行选择。

41.步骤s13:基于发音属性特征和各目标属性特征,合成得到待合成文本的合成语音。

42.在一个实施场景中,发音属性特征即为待合成文本的发音属性特征,各目标属性特征为在各种语音属性的属性空间概率分布模型中采样得到的目标属性特征,将所有获取的属性特征进行合成得到合成语音。

43.在一个实施场景中,如前所述,语音属性包括音色属性,则在基于发音属性特征和各目标属性特征,合成得到待合成文本的合成语音之前,还可以基于待合成文本在音色属性上的目标类别,获取音色属性的参考属性特征;且音色属性的参考属性特征基于与音色属性的目标类别相关的语音数据而提取得到;再基于音色属性的参考属性特征进行调整处理,得到音色属性的目标属性特征,从而可以生成区别于训练集内发音人音色,在此基础上,可以再基于发音属性特征和各目标属性特征,合成得到待合成文本的合成语音。上述方式,语音合成的过程中,还可以通过对参考属性进行调整处理,能够生成区别于训练集内发音人音色,有利于快速创造出包含富音色的合成语音。

44.在一个具体的实施场景中,在基于音色属性的参考属性特征进行调整处理过程中,可以将音色属性的多个参考属性特征进行加权处理,得到音色属性的目标属性特征。示

例性地,可以通过对音色空间概率分布进行采样,能够生成不同于训练集内发音人音色的合成语音,从而生成具有新音色的合成语音。对于两个不同的音色属性特征sa和sb,可以通过插值的方式生成新的音色属性特征s

new

,通过加入权重λ,其中λ是两个特征之间的插值权重,取值范围为0《λ《1。将插值后的特征s

new

通过语音合成新的语音数据,可以表示为s

new

=λ*sa (1-λ)*sb。上述方式,采用这种方式构建合成语音,省去发音人寻找和音频录制工作,能够生成不同于训练集内发音人音色的合成语音,从而生成具有新音色的合成语音,并具有避免版权风险的优点。

45.在一个具体的实施场景中,在基于音色属性的参考属性特征进行调整处理过程中,也可以将音色属性的参考属性特征进行尺度调整,得到音色属性的目标属性特征。示例性地,一个音色属性特征sc,可以通过拉伸的方式生成新的音色属性特征s

new

,通过加入权重λ,拉伸后的特征s

new

可以表示为s

new

=λ*sc。上述方式,采用这种方式构建合成语音,能够生成不同于训练集内发音人音色的合成语音,从而生成具有新音色的合成语音,可以降低语音合成的代价。

46.请参阅图3,图3是图1中步骤s13一实施例的属性特征合成示意图,如图3所示,语音属性特征包括发音属性特征30、信道属性特征31、方言属性特征32、音色属性特征33、情感属性特征34和风格属性特征35,可以将发音属性特征和上述各语音属性特征输入语音合成模块36进行合成处理,可以得到合成语音。具体而言,语音合成模块36可以由样本语音训练得到。在此训练过程中,可以获取样本语音的发音属性特征和上述各语音属性特征,并采用语音合成模块36对样本语音的发音属性特征和上述各语音属性特征进行合成处理,得到样本语音对应的合成语音,从而可以基于样本语音及其对应的合成语音之间的差异(如,两者梅尔谱之间的差异),调整语音合成模块36的网络参数,从而可以通过训练语音合成模块36以实现各属性特征对语音的控制生成。需要说明的是,该语音合成模块36的输入可以为前述提取得到的属性特征,输出为合成语音37,隐层网络由深度神经网络模块组成,例如可以是深度神经网络、循环神经网络、卷积神经网络等网络类型中的一种或几种的组合。然后通过设置一定训练准则对网络进行训练。该训练准则包括但不限于最小均方误差准则、最大似然准则等。根据语音合成模块36,可以进行控制语音合成,进而可以更好的控制合成语音37的特征。

47.上述方案,通过提取待合成文本的发音属性特征,再基于待合成文本分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征;最后基于发音属性特征和各目标属性特征,合成得到待合成文本的合成语音。一方面由于无需人为进行大量的语音录制,节省了时间,有助于降低语音合成的成本,另一方面由于在语音合成过程中,通过获取待合成文本分别在若干语音属性上的目标类别,获取各种语音属性的目标属性特征,在此基础上再进行语音合成,能够合成具有任意类别语音属性的语音数据,提升了语音合成的自由度。故此,能够在提升语音合成自由度的同时,降低其成本。

48.请参阅图4,图4是本技术语音合成方法另一实施例的流程示意图。需要说明的是,本公开实施例可以在待处理语音的基础上进行任意属性迁移,从而合成得到与待处理语音具有部分相同属性特征的合成语音。此外,本公开实施例仅重点陈述与前述公开实施例不同之处,相同或相似之处可以参阅前述公开实施例,在此不再赘述。具体而言,本公开实施例具体可以包括如下步骤:

49.步骤s41:提取待处理语音的发音属性特征。

50.在一个实施场景中,如前所述,发音属性可以包括语音中的发音内容信息。与前述提取待合成文本的发音属性特征类似地,对于待处理语音而言,也可以采用国际音标(international phonetic alphabet,ipa)对语音中的发音内容进行标注,获得语音的发音序列标注,然后采用独热编码对发音序列中的每个发音进行编码得到发音属性特征。

51.步骤s42:基于待处理语音分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征。

52.在一个实施场景中,基于待处理语音分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征,可以参阅前述公开实施例中,关于基于待合成文本分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征的相关描述,在此不再赘述。

53.在一个实施场景中,在基于待处理语音分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征之前,可以选择至少一种语音属性作为第一语音属性,并将未选择的语音属性作为第二语音属性;基于待处理语音分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征,可以基于待处理语音分别在各第一语音属性上的目标类别,获取各第一语音属性的目标属性特征;以及,提取待处理语音分别关于各第二语音属性的语音属性特征,作为对应第二语音属性的目标属性特征。上述方式,通过对语音属性特征进行迁移,完成语音的属性特征迁移,可以控制合成属性特征类别不同的多种合成语音。

54.在一个具体的实施场景中,以选择情感属性作为第一语音属性为例,则信道属性、方言属性、音色属性、风格属性可以作为第二语音属性,待处理语音中各个属性具有各自的属性类别,且第一语音属性的目标属性特征为高兴,此时,可以在已有的语音数据中提取情感属性的属性类别为高兴的属性特征,将提取情感属性为高兴的属性特征与剩余各个属性具有的属性特征进行合成,得到最终合成语音。也即是说,对于待处理的语音,只有情感属性特征发生改变,其余属性特征均保持即可得到最终合成语音。

55.在一个具体的实施场景中,以选择风格属性作为第一语音属性为例,则信道属性、方言属性、音色属性、情感属性可以作为第二语音属性,待处理语音中各个属性具有各自的属性类别,且第一语音属性的目标属性特征为交互,此时,可以在已有的语音数据中提取风格属性的属性类别为交互的属性特征,将提取风格属性为交互的属性特征与剩余各个属性具有的属性特征进行合成,得到最终合成语音。

56.需要说明的是,上述仅以情感属性、风格属性为例来说明属性特征迁移的具体过程,在实际应用过程中,可以根据选择前述若干种语音属性中任一者或者至少两者的组合来进行迁移,在此不做限定。

57.此外,示例性地,可以提取待处理语音的发音属性特征,并基于待处理语音分别在信道属性、音色属性、方言属性、情感属性、风格属性上的目标类别,获取上述几种语音属性的目标属性特征,且待处理语音在音色属性上的目标类别为其原音色类别,也就是说,可以从待处理语音提取出音色属性特征作为音色属性的目标属性特征,从而后续可以基于发音属性特征、音色属性特征,以及在信道属性、方言属性、情感属性、风格属性等各语音属性上分别指定的目标类别对应的目标属性特征,进行语音合成,以在保留待处理语音原发音属

性和原音色属性的前提下,自由合成具有不同信道、不同方言、不同情感、不同风格的合成语音。

58.步骤s43:基于发音属性特征和各目标属性特征,合成得到待处理语音的合成语音。

59.在一个实施场景中,根据发音属性特征和各目标属性特征,可以合成得到待处理语音的合成语音,且目标属性特征可以根据实际应用场景进行设置,一方面可以生成多种合成语音,另一方面可以有效控制合成语音的语音属性特征。具体合成过程,可以参阅前述公开实施例中关于基于发音属性特征和各目标属性特征,合成得到待合成文本的合成语音的相关描述,在此不再赘述。

60.上述方案,通过提取待处理语音的发音属性特征,再基于待处理语音分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征;最后基于发音属性特征和各目标属性特征,合成得到待处理语音的合成语音。一方面由于无需人为进行大量的语音录制,节省了时间,有助于降低语音合成的成本,另一方面由于在语音合成过程中,通过获取待合成文本分别在若干语音属性上的目标类别,获取各种语音属性的目标属性特征,在此基础上再进行语音合成,能够合成具有任意类别语音属性的语音数据,提升了语音合成的自由度。故此,能够在提升语音合成自由度的同时,降低其成本。

61.请参阅图5,图5是本技术语音合成装置一实施例的框架示意图。语音合成装置50包括提取模块51、获取模块52和合成模块53。其中,提取模块51用于提取待合成文本的发音属性特征;获取模块52用于基于待合成文本分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征;合成模块53用于基于发音属性特征和各目标属性特征,合成得到待合成文本的合成语音。

62.上述方案,通过提取待合成文本的发音属性特征,再基于待合成文本分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征;最后基于发音属性特征和各目标属性特征,合成得到待合成文本的合成语音。一方面由于无需人为进行大量的语音录制,节省了时间,有助于降低语音合成的成本,另一方面由于在语音合成过程中,通过获取待合成文本分别在若干语音属性上的目标类别,获取各种语音属性的目标属性特征,在此基础上再进行语音合成,能够合成具有任意类别语音属性的语音数据,提升了语音合成的自由度。故此,能够在提升语音合成自由度的同时,降低其成本。

63.在一些公开实施例中,若干种语音属性包括信道属性、方言属性、音色属性、情感属性、风格属性中至少一种。

64.因此,通过将语音属性进行区分,即将耦合在一起的语音信息通过解耦合的方式区分为多种语音属性,有助于在语音合成过程中提高语音合成的多样性,并且提高了语音合成的效率。

65.在一些公开实施例中,获取模块52包括特征建模子模块,用于基于与各种语音属性的属性类别相关的语音数据进行特征建模,得到各种语音属性的属性空间概率分布模型;获取模块52包括模型采样子模块,用于基于待合成文本在语音属性上的目标类别,在对应语音属性的属性空间概率分布模型进行采样,得到对应语音属性的目标属性特征。

66.因此,通过对语音属性的属性类别相关的语音数据进行特征建模,可以得到语音属性的属性空间概率分布模型,空间概率分布模型中可以对不同属性类别进行区域划分,

得到相同语音属性下的不同属性类别的分布空间,有助于语音合成过程中对数据的采样,提高了语音合成的效率。

67.在一些公开实施例中,每种语音属性具有至少一种属性类别;特征建模子模块包括提取单元,用于对于语音属性下各种属性类别,提取与属性类别相关的语音数据关于语音属性的样本属性特征;特征建模子模块包括构建单元,用于基于关于语音属性下各种属性类别的样本属性特征,构建得到语音属性的属性空间概率分布模型。

68.因此,通过构建语音属性的属性空间概率分布模型,在语音合成过程中可以在分布模型中直接采样得到对应属性特征,提高了语音合成的效率。

69.在一些公开实施例中,合成模块53包括获取子模块,用于基于待合成文本在音色属性上的目标类别,获取音色属性的参考属性特征;且音色属性的参考属性特征基于与音色属性的目标类别相关的语音数据而提取得到;合成模块53包括调整子模块,用于基于音色属性的参考属性特征进行调整处理,得到音色属性的目标属性特征。

70.因此,语音合成的过程中,还可以通过对参考属性进行调整处理,得到目标属性特征,能够生成不同于训练集内发音人音色的合成语音,从而生成具有新音色的合成语音,并具有避免版权风险的优点。

71.在一些公开实施例中,调整子模块包括加权处理单元和尺度调整单元中任一者:加权处理单元用于将音色属性的多个参考属性特征进行加权处理,得到音色属性的目标属性特征;尺度调整单元用于将音色属性的参考属性特征进行尺度调整,得到音色属性的目标属性特征。

72.因此,可以通过插值、拉伸等方式对音色属性进行调整处理,可以得到音色属性的目标属性特征,进而在语音合成过程中得到不同于训练集内发音人音色的新音色的语音数据,并具有避免版权风险的优点。

73.请参阅图6,图6是本技术语音合成装置另一实施例的框架示意图。语音合成装置60包括提取模块61、获取模块62和合成模块63。其中,提取模块61用于提取待处理语音的发音属性特征;获取模块62用于基于待处理语音分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征;合成模块63用于基于发音属性特征和各目标属性特征,合成得到待处理语音的合成语音。

74.上述方案,通过提取待处理语音的发音属性特征,再基于待处理语音分别在若干种语音属性上的目标类别,获取各种语音属性的目标属性特征;最后基于发音属性特征和各目标属性特征,合成得到待处理语音的合成语音。一方面由于无需人为进行大量的语音录制,节省了时间,有助于降低语音合成的成本,另一方面由于在语音合成过程中,通过获取待处理语音分别在若干语音属性上的目标类别,获取各种语音属性的目标属性特征,在此基础上再进行语音合成,能够合成具有任意类别语音属性的语音数据,提升了语音合成的自由度。故此,能够在提升语音合成自由度的同时,降低其成本。

75.在一些公开实施例中,语音合成装置60还包括选择模块,用于选择至少一种语音属性作为第一语音属性,并将未选择的语音属性作为第二语音属性;获取模块62包括获取子模块和提取子模块,获取子模块用于基于待处理语音分别在各第一语音属性上的目标类别,获取各第一语音属性的目标属性特征;提取子模块用于提取待处理语音分别关于各第二语音属性的语音属性特征,作为对应第二语音属性的目标属性特征。

76.因此,通过对语音属性特征进行迁移,完成语音的属性特征迁移,可以控制合成属性特征类别不同的多种合成语音。

77.请参阅图7,图7是本技术电子设备一实施例的框架示意图。电子设备70包括相互耦接的存储器71和处理器72,存储器71中存储有程序指令,处理器72用于执行程序指令以实现上述任一语音合成方法实施例中的步骤。具体地,电子设备70可以包括但不限于:台式计算机、笔记本电脑、服务器、手机、平板电脑等等,在此不做限定。

78.具体而言,处理器72用于控制其自身以及存储器71以实现上述任一语音合成方法实施例中的步骤。处理器72还可以称为cpu(central processing unit,中央处理单元)。处理器72可能是一种集成电路芯片,具有信号的处理能力。处理器72还可以是通用处理器、数字信号处理器(digital signal processor,dsp)、专用集成电路(application specific integrated circuit,asic)、现场可编程门阵列(field-programmable gate array,fpga)或者其他可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件。通用处理器可以是微处理器或者该处理器也可以是任何常规的处理器等。另外,处理器72可以由集成电路芯片共同实现。

79.上述方案,一方面由于无需人为进行大量的语音录制,节省了时间,有助于降低语音合成的成本,另一方面由于在语音合成过程中,通过获取待合成文本分别在若干语音属性上的目标类别,获取各种语音属性的目标属性特征,在此基础上再进行语音合成,能够合成具有任意类别语音属性的语音数据,提升了语音合成的自由度。故此,能够在提升语音合成自由度的同时,降低其成本。

80.请参阅图8,图8是本技术计算机可读存储介质一实施例的框架示意图。计算机可读存储介质80存储有能够被处理器运行的程序指令81,程序指令81用于实现上述任一语音合成方法实施例中的步骤。

81.上述方案,一方面由于无需人为进行大量的语音录制,节省了时间,有助于降低语音合成的成本,另一方面由于在语音合成过程中,通过获取待合成文本分别在若干语音属性上的目标类别,获取各种语音属性的目标属性特征,在此基础上再进行语音合成,能够合成具有任意类别语音属性的语音数据,提升了语音合成的自由度。故此,能够在提升语音合成自由度的同时,降低其成本。

82.在一些实施例中,本公开实施例提供的装置具有的功能或包含的模块可以用于执行上文方法实施例描述的方法,其具体实现可以参照上文方法实施例的描述,为了简洁,这里不再赘述。

83.上文对各个实施例的描述倾向于强调各个实施例之间的不同之处,其相同或相似之处可以互相参考,为了简洁,本文不再赘述。

84.在本技术所提供的几个实施例中,应该理解到,所揭露的方法和装置,可以通过其它的方式实现。例如,以上所描述的装置实施方式仅仅是示意性的,例如,模块或单元的划分,仅仅为一种逻辑功能划分,实际实现时可以有另外的划分方式,例如多个单元或组件可以结合或者可以集成到另一个系统,或一些特征可以忽略,或不执行。另一点,所显示或讨论的相互之间的耦合或直接耦合或通信连接可以是通过一些接口,装置或单元的间接耦合或通信连接,可以是电性、机械或其它的形式。

85.作为分离部件说明的单元可以是或者也可以不是物理上分开的,作为单元显示的

部件可以是或者也可以不是物理单元,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部单元来实现本实施方式方案的目的。

86.另外,在本技术各个实施例中的各功能单元可以集成在一个处理单元中,也可以是各个单元单独物理存在,也可以两个或两个以上单元集成在一个单元中。上述集成的单元既可以采用硬件的形式实现,也可以采用软件功能单元的形式实现。

87.集成的单元如果以软件功能单元的形式实现并作为独立的产品销售或使用时,可以存储在一个计算机可读取存储介质中。基于这样的理解,本技术的技术方案本质上或者说对现有技术做出贡献的部分或者该技术方案的全部或部分可以以软件产品的形式体现出来,该计算机软件产品存储在一个存储介质中,包括若干指令用以使得一台计算机设备(可以是个人计算机,服务器,或者网络设备等)或处理器(processor)执行本技术各个实施方式方法的全部或部分步骤。而前述的存储介质包括:u盘、移动硬盘、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)、磁碟或者光盘等各种可以存储程序代码的介质。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。