1.本发明涉及数据处理技术领域,尤其涉及一种基于深度学习的道路交通状态检测方法、装置、介质及设备。

背景技术:

2.交通状态通常用自由流、稳定流、不稳定流、强制流来描述。在不同的国家,交通运行状态的标准都不相同,交通拥堵的判别标准存在一定的差异。道路服务水平被用来描述交通流运行状态。根据美国发行的标准,通常使用速度、运行负荷、车流密度、驾驶自由度和舒适度等条件来衡量道路服务水平。服务水平通常规定为六级。基于美国提出的道路交通服务水平标准,日本也制定了交通服务水平的划分,分为三级。

3.我国根据城市主干路上机动车的平均速度来划分拥堵程度,指标过于单一,并不能完全描述实际道路状况。以往机动车信息的获取往往靠的是感知设备和红外线等装置,成本高且精度低。目前,基于深度卷积神经网络的道路交通状态识别方法,通常是先将交通图片输入到主干网络,提取目标物信息;进一步通过预测模型对其信息进行下一步预测来获取下一个时间段的状态,但存在模型训练慢,提取信息精度和速度不高且判别精度低的问题。

技术实现要素:

4.本发明实施例提供了一种基于深度学习的道路交通状态检测方法、装置、介质及设备,以解决现有技术在检测道路交通状态时存在的指标单一、检测速度慢、信息提取以及检测精度低的问题。

5.一种基于深度学习的道路交通状态检测方法,所述方法包括:

6.获取交通图像训练集,对所述交通图像训练集中的训练样本执行r-mosaic数据增强处理;

7.采用r-mosaic数据增强后的训练样本训练预设的h-fpn深度卷积网络,其中,所述h-fpn深度卷积网络采用三层预测层从输入图像中提取交通流的特征参数;

8.获取待处理的交通图像,通过训练好的h-fpn深度卷积网络提取所述交通图像对应的特征参数;

9.通过预设的判别模型根据所述交通流的特征参数生成并输出交通状态预测值。

10.可选地,所述获取交通图像训练集,对所述交通图像训练集中的训练样本执行r-mosaic数据增强处理包括:

11.获取交通图像训练集,所述交通图像训练集中的每一个训练样本均包括参考框;

12.以两两训练样本为一组,对所述训练样本进行水平翻转、缩放以及色域变化;

13.构建大小为训练样本尺寸两倍的图像框架,将一个训练样本摆放在所述图像框架的左上角,将另一个训练样本摆放在所述图像框架的右上角;

14.截取所述训练样本的部分图像贴到所述图像框架,并垂直拉伸至填满所述图像框

架;

15.重新调整所述图像框架的尺寸和位置,将整合后的图像框架进行平移、缩放、裁剪,得到与训练样本相同尺寸的增强图像。

16.可选地,所述h-fpn深度卷积网络中的h-fpn网络包括三层预测层,分别为第一预测层、第二预测层、第三预测层;

17.所述第一预测层用于通过上采样得到感受野为76*76的特征图,通过预设的第一参考框对上半层感受野中的目标进行预测,输出所述特征图的上半层的预测信息;

18.所述第二预测层用于通过上采样得到感受野为38*38的特征图,通过预设的第二参考框对全层感受野中的目标进行预测,输出所述特征图的全层的预测信息;

19.所述第三预测层用于通过上采样得到感受野为19*19的特征图,通过预设的第三参考框对下半层感受野中的目标进行预测,输出所述特征图的下半层的预测信息;

20.所述h-fpn深度卷积网络还包括检测追踪模块,所述检测追踪模块用于根据所述第一预测层、第二预测层以及第三预测层输出的预测信息得到交通流的特征参数。

21.可选地,所述特征参数包括交通流速度、交通流密度和交通量。

22.可选地,所述h-fpn深度卷积网络的分类损失函数由回归损失函数和分类损失函数构成,其计算公式为:

23.loss=reg_loss pb_loss

24.其中reg_loss表示回归损失,pb_loss表示分类损失;

25.回归损失reg_loss的计算公式为:

[0026][0027]

其中,yi表示实际观测值;表示预测值;

[0028]

分类损失pb_loss的计算公式为:

[0029][0030]

其中pre_label表示预测状态;rel_label表示真实状态。

[0031]

可选地,所述预设的判别模型包括由交通流速度、交通流密度和交通量的判别阈值构成的矩阵;

[0032][0033]

其中,p表示判别矩阵,即由判别阈值构成的矩阵,i≤3,j≤3;p11表示交通流速度所处畅通状态时最小速度;p12表示交通流速度所处拥挤状态时最小速度;p13表示交通流速度所处拥堵状态时最大速度;p21表示交通流密度所处畅通状态时最小密度;p22表示交通流密度所处拥挤状态时最小密度;p23表示交通流密度所处拥堵状态时最大密度;p31表示交通量所处畅通状态时最大数量;p32表示交通量所处拥挤状态时最大数量;p33表示交

通量所处拥堵状态时最小数量。

[0034]

可选地,所述通过预设的判别模型根据所述交通流的特征参数生成并输出交通状态预测值包括:

[0035]

通过所述判别模型将所述交通流速度、交通流密度和交通量分别与所述判别矩阵中的判别阈值进行比较,得到所述交通流速度、交通流密度和交通量对应的交通状态信息。

[0036]

若所述交通流速度、交通流密度和交通量对应的交通状态信息均不相同时,输出交通状态预测值为拥堵。

[0037]

若所述交通流速度、交通流密度和交通量对应的交通状态信息不完全相同时,选取出现次数最多的交通状态信息作为交通状态预测值。

[0038]

一种基于深度学习的道路交通状态检测装置,所述装置包括:

[0039]

预处理模块,用于获取交通图像训练集,对所述交通图像训练集中的训练样本执行r-mosaic数据增强处理;

[0040]

训练模块,用于采用r-mosaic数据增强后的训练样本训练预设的h-fpn深度卷积网络,其中,所述h-fpn深度卷积网络采用三层预测层从输入图像中提取交通流的特征参数;

[0041]

提取模块,用于获取待处理的交通图像,通过训练好的h-fpn深度卷积网络提取所述交通图像对应的特征参数;

[0042]

预测模块,用于通过预设的判别模型根据所述交通流的特征参数生成并输出交通状态预测值。

[0043]

一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序被处理器执行时实现如上所述的基于深度学习的道路交通状态检测方法。

[0044]

一种计算机设备,包括存储器、处理器以及存储在所述存储器中并可在所述处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现如上所述的基于深度学习的道路交通状态检测方法。

[0045]

本发明实施例通过获取交通图像训练集,对所述交通图像训练集中的训练样本执行r-mosaic数据增强处理;采用r-mosaic数据增强后的训练样本训练预设的h-fpn深度卷积网络,其中,所述h-fpn深度卷积网络采用三层预测层从输入图像中提取交通流的特征参数;获取待处理的交通图像,通过训练好的h-fpn深度卷积网络提取所述交通图像对应的特征参数;通过预设的判别模型根据所述交通流的特征参数生成并输出交通状态预测值。本发明基于深度学习的道路交通状态检测方法,通过完善的多指标评价体系、建立深度学习卷积神经网络来加强道路交通状态检测效果的稳健性,并且提高了检测的速度、信息提取以及检测的精度,加强了检测结果的准确性。

附图说明

[0046]

为了更清楚地说明本发明实施例的技术方案,下面将对本发明实施例的描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

[0047]

图1是本发明一实施例提供的基于深度学习的道路交通状态检测方法的流程图;

[0048]

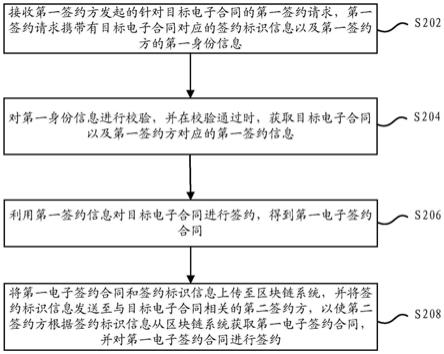

图2是本发明一实施例提供的基于深度学习的道路交通状态检测方法中步骤s101的实现流程图;

[0049]

图3是本发明一实施例提供的r-mosaic数据增强处理的示意图,其中图3(a)为步骤s201对应的示意图,图3(b)为步骤s202和s203对应的示意图,图3(c)为步骤s204和s205对应的示意图;

[0050]

图4是本发明一实施例提供的h-fpn网络操作示意图;

[0051]

图5是本发明一实施例提供的基于深度学习的道路交通状态检测方法中步骤s104中的实现流程图;

[0052]

图6是本发明一实施例提供的基于深度学习的道路交通状态检测装置的结构示意图;

[0053]

图7是本发明一实施例中计算机设备的一示意图。

具体实施方式

[0054]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0055]

本发明实施例通过基于深度学习的道路交通状态检测方法,通过完善的多指标评价体系、建立深度学习卷积神经网络来加强道路交通状态检测效果的稳健性并且提高了检测的速度、加强了检测结果的准确性。

[0056]

以下对本实施例提供的基于深度学习的道路交通状态检测方法进行详细的描述,如图1所示,所述基于深度学习的道路交通状态检测方法包括:

[0057]

在步骤s101中,获取交通图像训练集,对所述交通图像训练集中的训练样本执行r-mosaic数据增强处理。

[0058]

可选地,所述r-mosaic数据增强处理是指半结构马赛克数据增强处理。如图2所示,步骤s101中所述的获取交通图像训练集,对所述交通图像训练集中的训练样本执行r-mosaic数据增强处理包括:

[0059]

在步骤s201中,获取交通图像训练集,所述交通图像训练集中的每一个训练样本均包括参考框。

[0060]

在本发明实施例中,所述交通图像训练集包括若干个训练样本,每一个训练样本中均包括参考框,通过参考框初步框定出目标物体。

[0061]

在步骤s202中,以两两训练样本为一组,对所述训练样本进行水平翻转、缩放以及色域变化。

[0062]

本发明实施例将所述交通图像训练集中的两个训练样本划分为一组,以组为单位进行预处理,对所述两个训练样本分别进行水平翻转、缩放以及色域变化,生成增强图像。

[0063]

在步骤s203中,构建大小为训练样本尺寸两倍的图像框架,将一个训练样本摆放在所述图像框架的左上角,将另一个训练样本摆放在所述图像框架的右上角。

[0064]

在步骤s204中,截取所述训练样本的部分图像贴到所述图像框架,并垂直拉伸至填满所述图像框架。

[0065]

在这里,对于一组中的两个训练样本,在水平翻转、缩放以及色域变化之后,将其中一个训练样本按照第一张图片摆放在一个大小为原训练样本的尺寸宽高两倍的图像框架的左上角,另一个训练样本摆放在该图像框架的右上角;随后从训练样本上截取部分贴到图像框架上并垂直拉伸填满全图。为了便于理解,图3为本发明实施例提供的r-mosaic数据增强处理的示意图,其中图3(a)为步骤s201对应的示意图,图3(b)为步骤s202和s203对应的示意图,图3(c)为步骤s204和s205对应的示意图。

[0066]

在步骤s205中,重新调整所述图像框架的尺寸和位置,将整合后的图像框架进行平移、缩放、裁剪,得到与训练样本相同尺寸的增强图像。

[0067]

最后,重新调整图像框架的尺寸和位置,将整合后的图像框架进行平移、缩放、裁剪并重新,将其大小缩放为训练样本的尺寸大小,从而得到增强图像。所述增强图像用于训练模型所述h-fpn深度卷积网络模型。

[0068]

本发明实施例使用r-msaic数据增强处理方法提升了样本图像的特征,极大丰富了检测物体的背景,用于训练所述h-fpn深度卷积网络模型,有利于提高h-fpn深度卷积网络模型提取信息的精度,得到更加准确的交通流特征参数,从而进一步加强道路交通状态检测的稳健性。

[0069]

在步骤s102中,采用r-mosaic数据增强后的训练样本训练预设的h-fpn深度卷积网络,其中,所述h-fpn深度卷积网络采用三层预测层从输入图像中提取交通流的特征参数。

[0070]

在这里,由于采集交通图像训练集的摄像头大多为固定位置、固定角度,拍摄道路时目标物总是在不断靠近摄像头或是远离摄像头,对于同一目标而言,其距离摄像头越远,在图像中越小;距离摄像头越近则目标越大,但是同一目标无论距离摄像头远近其形状基本维持不别。对于这个特性,本发明实施例在提取到特征图后,对于感受野较小的特征图其主要预测目标为小目标,由于图像下部目标均偏向于大目标,此时特征图下半部分不使用小尺度的参考框anchor,即下半部分不预测小目标;同理,对于感受野较大的特征图,其主要预测目标为大目标,由于图像上半部分的目标均偏向于小目标,此时特征图上半部分不使用大尺度的参考框anchor,即上半部分不预测大目标,以此来减少计算,提升检测速度。

[0071]

可选地,所述h-fpn是指半结构特征金字塔,所述h-fpn深度卷积网络中的h-fpn网络包括三层预测层,分别为第一预测层、第二预测层、第三预测层。每一个预测层输入对应的参考框anchor。在本发明实施例中,尺度最小的一组参考框anchor输入第一预测层,尺度最大的一组参考框anchor输入第三预测层,剩余的一组参考框anchor输入第二预测层。

[0072]

所述第一预测层用于通过上采样得到感受野为76*76的特征图,通过预设的第一参考框对上半层感受野中的目标进行预测,输出所述特征图的上半层的预测信息。在这里,本发明实施例将所述感受野为76*76的特征图切分为上下两层,上半层感受野为76*38,所述第一参考框为尺度最小的一组参考框anchor,仅对上半层特征图进行输入,即所述第一参考框仅作用于感受野为76*38的上半层特征图,对上半层目标进行预测及输出,舍弃下半层特征图,最后输出所述特征图的上半层的预测信息。

[0073]

所述第二预测层用于通过上采样得到感受野为38*38的特征图,通过预设的第二参考框对全层感受野中的目标进行预测,输出所述特征图的全层的预测信息。在这里,所述第二预测层的输入和输出不变,为38*38的感受野,将对应的参考框anchor输入进行预测,

得到所述特征图的全层的预测信息。

[0074]

所述第三预测层用于通过上采样得到感受野为19*19的特征图,通过预设的第三参考框对下半层感受野中的目标进行预测,输出所述特征图的下半层的预测信息。在这里,感受野为19*19,此时感受野最大,执行较大的目标检测。同样将所述感受野为19*19的特征图切分为上下两层,下半层感受野为19*10。所述第三参考框为尺度最大的一组参考框anchor,仅对下半层特征图进行输入,即所述第三参考框仅作用于感受野为19*10的下半层特征图,对下半层目标进行预测及输出,舍弃上半层特征图,最后输出所述特征图的下半层的预测信息。

[0075]

为了便于理解,图4为本发明实施例提供的h-fpn网络操作示意图。在这里,本发明实施例通过修改h-fpn网络结构,减少了所述h-fpn深度卷积网络的参数量和计算量,进一步提高了信息提取的精度。

[0076]

所述h-fpn深度卷积网络还包括检测追踪模块,所述检测追踪模块用于根据所述第一预测层、第二预测层以及第三预测层输出的预测信息得到交通流的特征参数。在这里,所述交通图像对应的特征参数包括但不限于交通流速度v、交通流密度k和交通量n。

[0077]

其中,所述交通量n为单位时间内(1小时)通过指定路段的车辆数目;交通流速度v的计算公式为:

[0078][0079]

其中vi表示观测期间第i辆车的速度;n表示单位时间内观测到的车辆数目;

[0080]

交通流密度k的计算公式为:

[0081][0082]

其中k表示交通流密度;n表示交通量;l表示观测路段长度;

[0083]

某时段内道路平均交通密度为:

[0084][0085]

其中k表示某时间内某一路段的平均交通密度,单位是辆/km;ki表示第i个截取画面中的车辆数;n表示该时间段内的截取画面数;l表示该路段的长度。

[0086]

可选地,本发明实施例在对所述h-fpn深度卷积网络训练的过程中,所述h-fpn深度卷积网络的分类损失函数由回归损失函数和分类损失函数构成,其计算公式为:

[0087]

loss=reg_loss pb_loss

[0088]

其中reg_loss表示回归损失,pb_loss表示分类损失;

[0089]

回归损失reg_loss的计算公式为:

[0090][0091]

其中,yi表示实际观测值;表示预测值;

[0092]

分类损失pb_loss的计算公式为:

[0093][0094]

其中pre_label表示预测状态;rel_label表示真实状态。

[0095]

本发明实施例在h-fpn深度卷积网络的预测阶段加入了分类损失,改进了h-fpn深度卷积网络的损失函数,提升了预测的精度和判别的准确性。相比现有技术仅使用回归损失,损失函数的改进提升了h-fpn深度卷积网络的拟合能力,提升了道路交通状态检测的准确性。

[0096]

在完成对h-fpn深度卷积网络的训练后,对所述h-fpn深度卷积网络进行测试。本发明实施例通过获取交通图像及其对应的真实的交通流的特征参数,即交通量、交通流速度和交通流密度;将所述交通图像输入至所述h-fpn深度卷积网络,得到所述h-fpn深度卷积网络输出的交通流的特征参数的预测值。将所述交通流的特征参数的预测值分别与真实值计算回归误差和分类误差,反向迭代更新参数到所述h-fpn深度卷积网络。

[0097]

在步骤s103中,获取待处理的交通图像,通过训练好的h-fpn深度卷积网络提取所述交通图像对应的特征参数。

[0098]

获取待处理的交通图像,作为输入参数提供至上述步骤s102训练好的h-fpn深度卷积网络,通过上述h-fpn深度卷积网络提取对应的交通流的特征参数,即交通流速度、交通流密度以及交通量。

[0099]

在步骤s104中,通过预设的判别模型根据所述交通流的特征参数生成并输出交通状态预测值。

[0100]

在这里,所述预设的判别模型包括由交通流速度、交通流密度和交通量的判别阈值构成的矩阵;

[0101][0102]

其中,p表示判别矩阵,即由判别阈值构成的矩阵,i≤3,j≤3;p11表示交通流速度所处畅通状态时最小速度;p12表示交通流速度所处拥挤状态时最小速度;p13表示交通流速度所处拥堵状态时最大速度;p21表示交通流密度所处畅通状态时最小密度;p22表示交通流密度所处拥挤状态时最小密度;p23表示交通流密度所处拥堵状态时最大密度;p31表示交通量所处畅通状态时最大数量;p32表示交通量所处拥挤状态时最大数量;p33表示交通量所处拥堵状态时最小数量。

[0103]

可选地,作为本发明的一个优选示例,如图5所示,步骤s104中所述的通过预设的判别模型根据所述交通流的特征参数生成并输出交通状态预测值包括:

[0104]

在步骤s401中,通过所述判别模型将所述交通流速度、交通流密度和交通量分别与所述判别矩阵中的判别阈值进行比较,得到所述交通流速度、交通流密度和交通量对应的交通状态信息。

[0105]

在步骤s402中,若所述交通流速度、交通流密度和交通量对应的交通状态信息均不相同时,输出交通状态预测值为拥堵。

[0106]

在步骤s403中,若所述交通流速度、交通流密度和交通量对应的交通状态信息不完全相同时,选取出现次数最多的交通状态信息作为交通状态预测值。

[0107]

在这里,通过与判别阈值比对,可以得到三个交通状态信息,分别为畅通、拥挤和拥堵。本发明实施例综合考虑所述交通流速度、交通流密度和交通量对应的交通状态信息,转化出交通状态预测值。所述交通流速度、交通流密度和交通量对应的交通状态信息不完全满足同一个状态时,使用少数服从多数原则确定交通状态预测值;若三者均不处于同一状态,则交通状态预测值为拥堵。

[0108]

可选地,为了便于理解,假设存在如下判别模型:

[0109][0110]

若存在交通图像经过h-fpn深度卷积网络后输出的交通流的特征参数为:交通流速度v》p11、交通流密度k《p21和交通量n《p31。

[0111]

可见,与所述判别矩阵中的判别阈值进行比较后,所述交通流速度对应的交通状态信息为畅通、交通流密度对应的交通状态信息为畅通、交通量对应的交通状态信息为拥挤,三者不完全相同,选取出现次数最多的交通状态信息作为交通状态预测值,即以畅通作为交通状态预测值。

[0112]

应理解,上述实施例中各步骤的序号的大小并不意味着执行顺序的先后,各过程的执行顺序应以其功能和内在逻辑确定,而不应对本发明实施例的实施过程构成任何限定。

[0113]

在一实施例中,本发明还提供一种基于深度学习的道路交通状态检测装置,该基于深度学习的道路交通状态检测装置与上述实施例中基于深度学习的道路交通状态检测方法一一对应。如图6所示,该基于深度学习的道路交通状态检测装置包括预处理模块51、训练模块52、提取模块53、预测模块54。各功能模块详细说明如下:

[0114]

预处理模块51,用于获取交通图像训练集,对所述交通图像训练集中的训练样本执行r-mosaic数据增强处理;

[0115]

训练模块52,用于采用r-mosaic数据增强后的训练样本训练预设的h-fpn深度卷积网络,其中,所述h-fpn深度卷积网络采用三层预测层从输入图像中提取交通流的特征参数;

[0116]

提取模块53,用于获取待处理的交通图像,通过训练好的h-fpn深度卷积网络提取所述交通图像对应的特征参数;

[0117]

预测模块54,用于通过预设的判别模型根据所述交通流的特征参数生成并输出交通状态预测值。

[0118]

可选地,所述预处理模块51包括:

[0119]

获取单元,用于获取交通图像训练集,所述交通图像训练集中的每一个训练样本均包括参考框;

[0120]

第一预处理单元,用于以两两训练样本为一组,对所述训练样本进行水平翻转、缩放以及色域变化;

[0121]

构建单元,用于构建大小为训练样本尺寸两倍的图像框架,将一个训练样本摆放在所述图像框架的左上角,将另一个训练样本摆放在所述图像框架的右上角;

[0122]

截取单元,用于截取所述训练样本的部分图像贴到所述图像框架,并垂直拉伸至填满所述图像框架;

[0123]

第二预处理单元,用于重新调整所述图像框架的尺寸和位置,将整合后的图像框架进行平移、缩放、裁剪,得到与训练样本相同尺寸的增强图像。

[0124]

可选地,所述h-fpn深度卷积网络中的h-fpn网络包括三层预测层,分别为第一预测层、第二预测层、第三预测层;

[0125]

所述第一预测层用于通过上采样得到感受野为76*76的特征图,通过预设的第一参考框对上半层感受野中的目标进行预测,输出所述特征图的上半层的预测信息;

[0126]

所述第二预测层用于通过上采样得到感受野为38*38的特征图,通过预设的第二参考框对全层感受野中的目标进行预测,输出所述特征图的全层的预测信息;

[0127]

所述第三预测层用于通过上采样得到感受野为19*19的特征图,通过预设的第三参考框对下半层感受野中的目标进行预测,输出所述特征图的下半层的预测信息;

[0128]

所述h-fpn深度卷积网络还包括检测追踪模块,所述检测追踪模块用于根据所述第一预测层、第二预测层以及第三预测层输出的预测信息得到交通流的特征参数。

[0129]

可选地,所述特征参数包括交通流速度、交通流密度和交通量。

[0130]

可选地,所述h-fpn深度卷积网络的分类损失函数由回归损失函数和分类损失函数构成,其计算公式为:

[0131]

loss=reg_loss pb_loss

[0132]

其中reg_loss表示回归损失,pb_loss表示分类损失;

[0133]

回归损失reg_loss的计算公式为:

[0134][0135]

其中,yi表示实际观测值;表示预测值;

[0136]

分类损失pb_loss的计算公式为:

[0137][0138]

其中pre_label表示预测状态;rel_label表示真实状态。

[0139]

可选地,所述预设的判别模型包括由交通流速度、交通流密度和交通量的判别阈值构成的矩阵;

[0140]

[0141]

其中,p表示判别矩阵,即由判别阈值构成的矩阵,i≤3,j≤3;p11表示交通流速度所处畅通状态时最小速度;p12表示交通流速度所处拥挤状态时最小速度;p13表示交通流速度所处拥堵状态时最大速度;p21表示交通流密度所处畅通状态时最小密度;p22表示交通流密度所处拥挤状态时最小密度;p23表示交通流密度所处拥堵状态时最大密度;p31表示交通量所处畅通状态时最大数量;p32表示交通量所处拥挤状态时最大数量;p33表示交通量所处拥堵状态时最小数量。

[0142]

可选地,所述预测模块54包括:

[0143]

比较单元,用于通过所述判别模型将所述交通流速度、交通流密度和交通量分别与所述判别矩阵中的判别阈值进行比较,得到所述交通流速度、交通流密度和交通量对应的交通状态信息。

[0144]

第一预测单元,用于若所述交通流速度、交通流密度和交通量对应的交通状态信息均不相同时,输出交通状态预测值为拥堵。

[0145]

第二预测单元,用于若所述交通流速度、交通流密度和交通量对应的交通状态信息不完全相同时,选取出现次数最多的交通状态信息作为交通状态预测值。

[0146]

关于基于深度学习的道路交通状态检测装置的具体限定可以参见上文中对于基于深度学习的道路交通状态检测方法的限定,在此不再赘述。上述基于深度学习的道路交通状态检测装置中的各个模块可全部或部分通过软件、硬件及其组合来实现。上述各模块可以硬件形式内嵌于或独立于计算机设备中的处理器中,也可以以软件形式存储于存储器中,以便于处理器调用执行以上各个模块对应的操作。

[0147]

在一个实施例中,提供了一种计算机设备,该计算机设备可以是服务器,其内部结构图可以如图7所示。该计算机设备包括通过系统总线连接的处理器、存储器、网络接口和数据库。其中,该计算机设备的处理器用于提供计算和控制能力。该计算机设备的存储器包括非易失性存储介质、内存储器。该非易失性存储介质存储有操作系统、计算机程序和数据库。该内存储器为非易失性存储介质中的操作系统和计算机程序的运行提供环境。该计算机设备的网络接口用于与外部的终端通过网络连接通信。该计算机程序被处理器执行时以实现一种基于深度学习的道路交通状态检测方法。

[0148]

在一个实施例中,提供了一种计算机设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,处理器执行计算机程序时实现以下步骤:

[0149]

获取交通图像训练集,对所述交通图像训练集中的训练样本执行r-mosaic数据增强处理;

[0150]

采用r-mosaic数据增强后的训练样本训练预设的h-fpn深度卷积网络,其中,所述h-fpn深度卷积网络采用三层预测层从输入图像中提取交通流的特征参数;

[0151]

获取待处理的交通图像,通过训练好的h-fpn深度卷积网络提取所述交通图像对应的特征参数;

[0152]

通过预设的判别模型根据所述交通流的特征参数生成并输出交通状态预测值。

[0153]

本领域普通技术人员可以理解实现上述实施例方法中的全部或部分流程,是可以通过计算机程序来指令相关的硬件来完成,所述的计算机程序可存储于一非易失性计算机可读取存储介质中,该计算机程序在执行时,可包括如上述各方法的实施例的流程。其中,本发明所提供的各实施例中所使用的对存储器、存储、数据库或其它介质的任何引用,均可

包括非易失性和/或易失性存储器。非易失性存储器可包括只读存储器(rom)、可编程rom(prom)、电可编程rom(eprom)、电可擦除可编程rom(eeprom)或闪存。易失性存储器可包括随机存取存储器(ram)或者外部高速缓冲存储器。作为说明而非局限,ram以多种形式可得,诸如静态ram(sram)、动态ram(dram)、同步dram(sdram)、双数据率sdram(ddrsdram)、增强型sdram(esdram)、同步链路(synchlink)dram(sldram)、存储器总线(rambus)直接ram(rdram)、直接存储器总线动态ram(drdram)、以及存储器总线动态ram(rdram)等。

[0154]

所属领域的技术人员可以清楚地了解到,为了描述的方便和简洁,仅以上述各功能单元、模块的划分进行举例说明,实际应用中,可以根据需要而将上述功能分配由不同的功能单元、模块完成,即将所述装置的内部结构划分成不同的功能单元或模块,以完成以上描述的全部或者部分功能。

[0155]

以上所述实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的精神和范围,均应包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。