1.本发明涉及施工安全技术领域,具体涉及一种融合人机视觉的施工安全隐患智能识别方法。

背景技术:

2.施工安全隐患的出现主要是人、物及管理管理的不安全状态造成的,具有隐蔽性、危险性、偶然性、因果性等特点。施工安全隐患不易被发现,随着施工的进行,逐渐显现,在一定的条件下激发,逐渐演变成安全事故。在施工中,隐患具有偶然性的特点,不加以重视,偶然事件也会发展成为必然事件。对于安全隐患,应该做到早发现、早处理、早预防。

3.目前,施工安全隐患需要依靠技术人员在现场识别、检测和整改,取决于技术人员的经验和专业水平,难以做到实时、全面和高效。在《建筑施工中常见安全隐患及防治措施》中,安全防范措施主要是:(1)提高安全管理意识(2)建立健全安全生产责任制(3)加大安全教育工作(4)按照标准和规范进行验收(5)施工设备按规范使用(6)加大安全督查力度。文章《建筑施工隐患排查方法研究》、《高层建筑施工中常见的安全隐患及防范措施》、《常见建筑施工安全隐患的应对措施的探讨》都是从管理的角度介绍安全隐患防范措施。在已有的专利文献cn111145046a中,介绍了一种用于水利水电工程施工过程的数字化管理方法及系统,通过数字化管理平台,实现对现场的监控,提高施工过程的作业水平和工程质量。上述方法的缺陷在于:无法自动识别隐患,仍然需要人工进行识别,人工识别隐患精准性取决于人的经验,对于人的依赖性过高。

4.施工安全隐患自动识别一方面提高安全管理效率,另一方面对作业人员进行监督,减少施工现场安全违规行为,具有隐患识别度高、全天候、成本低的特点,对于减少安全事故具有重大意义。

技术实现要素:

5.本发明的目的是解决现有技术的缺陷,提供一种融合人机视觉的施工安全隐患智能识别方法,该方法利用机器视觉、图像识别、语义关系推理,能够自动监测和识别施工安全隐患,具有识别度高、全天候、成本低的优点。

6.本发明采取的技术方案为:

7.融合人机视觉的施工安全隐患智能识别方法,首先采用眼动仪跟踪眼跳过程,获得基于人眼经验的目标显著图;然后识别隐患图像训练数据库,获得基于初级视觉特征的目标显著图;接着训练隐患部位的卷积神经网络参数;最后建立隐患知识语义判别模型,实现隐患自动判别。

8.融合人机视觉的施工安全隐患智能识别方法,包括以下步骤:

9.步骤一:首先,根据眼动仪实验,获得被试群体眼动特征参数;

10.步骤二,接着对注视聚类中心点进行坐标转换,求解隐患检测最优路径,对隐患检测最优路径上的隐患场景进行图像拼接,得到大视野图像,依据群体注视点聚集特征,进一

步精准定位大视野图像中的隐患位置,获取基于初级视觉特征的目标显著图s1;

11.步骤三,然后对眼动数据进行分析,区分注视显著区和非注视显著区,输入训练安全隐患图像,获取基于人眼注视经验的目标显著图s2;

12.步骤四,然后在精准定位隐患暴露部位的基础上,进一步识别图像目标,结合建立的隐患图像数据库,训练隐患部位的卷积神经网络参数;

13.步骤五,最后建立隐患知识语义判别模型,过程如下:计算隐患信息输入与隐患知识库的相似度矩阵sim,组合形成隐患判别信息,实现隐患自动判别。

14.融合人机视觉的施工安全隐患智能识别方法,包括以下步骤:

15.步骤1:将现场采集的大量隐患图片与视频作为预实验素材,建立群体视觉认知实验样本库,为施工安全隐患机器视觉识别模型提供训练数据库。

16.步骤2:招募经验丰富的施工安全管理人员作为被试群体,在被试群体眼前逐一展示样本图像,每张样本图像刺激一定时间,被试群体口述隐患部位与特征。记录每位被试群体的隐患识别正确率,挑选隐患正确识别率高、识别稳定性好的被试群体。以预实验筛选的被试群体为正式实验被试群体。

17.步骤3:依据施工进程,邀请实验被试群体头戴眼动仪设备进入实验场景,所有实验被试群体按照各自经验搜寻安全隐患。通过眼动仪采集被试群体识别隐患时的第一视角视频、注视点坐标、注视点时长等眼动特征参数。

18.步骤4:将眼动仪采集的注视点坐标转化为世界坐标系下的目标点坐标,对注视聚类中心点进行坐标转化,将其作为摄像机监控施工现场的自动扫视路径关键定位点,以扫视所有施工现场的最短时间和为目标函数,求解隐患检测的最优路径。对隐患检测路径的多个清晰局部隐患场景进行图像拼接。

19.步骤5:依据群体注视点聚集特征,进一步精准定位大视野图像中的隐患位置,依据隐患图像训练数据库,提取输入图像的红、绿、蓝三颜色通道以及图像的像素点坐标等参数,分析不同尺度l的场景图像亮度i、颜色rgb、方向lb等基本特征,获取亮度、颜色、方向特征的显著图i(cθs)、rgb(cθs)、lb(cθs),将三种显著图归一化处理后,组合特征权重wi、w

rgb

、w

lb

,建立基于初级视觉特征的目标显著图s1:

20.s1=wi·

i(cθs) w

rgb

·

rgb(cθs) w

lb

·

lb(cθs)

ꢀꢀ

(4)

21.步骤6:以每个注视点r时间、顺序以及到聚类中心点v的欧几里德距离d(r,v)为权重,分别建立注视时间加权高斯图gs

t

、注视顺序加权图gsr以及注视中心距离加权图gsd。将gs图像输入线性支持向量机进行训练,区分注视显著区和非注视显著区,构建基于人眼注视经验目标显著图的注意模型,求解线性超平面模型的最优w、b参数,提取基于人眼注视经验的目标显著图s2:

[0022][0023]

步骤7:综合两类目标显著图构建方法,建立施工安全隐患视觉仿生感知模型。依据隐患图像训练数据库,优化模型权重参数,训练机器视觉算法学习人眼识别隐患经验。

[0024]

步骤8:将现场采集的大量隐患图片、视频、眼动数据等实验素材按照隐患分类进行归类,形成卷积神经网络构架,深度采集图像特征信息,找出可能含有目标的候选区,获

取候选区域包含的图像特征,将图像特征输入全连接层,接入softmax分类函数,实现目标图像的分类识别,结合建立的隐患图像数据库,训练隐患部位的卷积神经网络参数。

[0025]

步骤9:采用包围盒算法,建立施工目标的二维平面包络空间,将空间位置及其关系数据转化为语义概念表达,建立隐患知识语义判别模型,建立过程如下:对比隐患规范知识库,提取隐患信息输入与隐患规范知识库的基础语义概念v1、v2,计算语义要素v1、v2之间的相似度s,经由隐患语义相似度算法,输出最大匹配度语义概念集合max{sim},组合形成隐患判别信息,实现隐患自动判别。

[0026][0027]

本发明一种融合人机视觉的施工安全隐患智能识别方法,技术效果如下:

[0028]

1)本发明将传统的人工检查施工安全隐患转变为机器自动检测施工安全隐患,节省人力成本。

[0029]

2)本发明将专家检测安全隐患的模式运用在机器上,使得机器拥有近似于专家检测安全隐患的能力去对安全隐患自动检测,隐患识别度高。

附图说明

[0030]

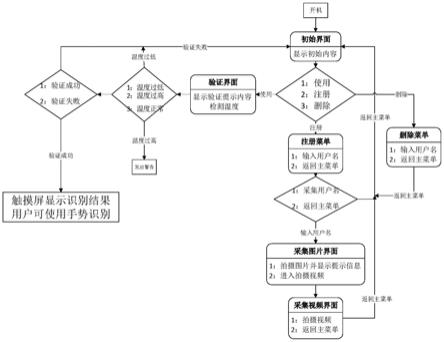

图1为隐患视觉仿生感知模型图。

[0031]

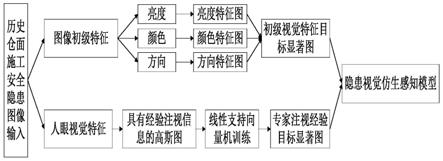

图2为隐患部位图像目标识别流程图。

[0032]

图3为施工隐患语义判别流程图。

具体实施方式

[0033]

融合人机视觉的施工安全隐患智能识别方法,包括如下步骤:

[0034]

1、将现场采集的大量隐患图片与视频作为预实验素材,建立群体视觉认知实验样本库,为施工安全隐患机器视觉识别模型提供训练数据库。

[0035]

2、招募经验丰富的施工安全管理人员作为被试群体,在被试群体眼前逐一展示样本图像,每张样本图像刺激一定时间,被试群体口述隐患部位与特征。记录每位被试群体的隐患识别正确率,挑选隐患正确识别率高、识别稳定性好的被试群体。以预实验筛选的被试群体为正式实验用被试群体。

[0036]

3、依据施工进程,邀请专家群体头戴眼动仪设备进入实验场景,所有实验被试按照各自经验搜寻路线在施工现场中巡视。通过眼动仪采集被试识别隐患时的第一视角视频、注视点坐标、注视点时长等眼动特征参数。

[0037]

4、根据眼睛成像与眼动仪数据采集原理,该原理使用瞳孔-角膜反射技术,该技术的基本原理是:(1)使用红外线照射眼睛;(2)使用摄像机采集从角膜和视网膜上反射的红外光线;(3)由于眼球的生理结构和物理性质,在光源和头部相对位置不变的前提下,角膜反射形成的光斑不会移动而(4)视网膜上反射的光线方向标示了瞳孔的朝向(光源光线从瞳孔射入,视网膜反射光线从瞳孔射出);最后(5)根据角膜与瞳孔反射光线之间的角度可

以计算出眼动的方向。结合被试群体对目标点的眼动水平视角α与垂直视角β,按照隐患部位空间点与被试之间的测量距离d,计算x,y,z坐标轴视角缩放比例px

α

(d)、py

β

(d)、pz

α

(d)。将基于眼动仪坐标系的注视点坐标(v

x

,vy,vz)按照比例缩放,计算同一坐标原点下的注视点空间坐标(vz

x

,vzy,vzz),实现眼动仪注视点的空间信息映射。

[0038]

vz

x

=px

α

×vx

,vzy=py

β

×

vy,vzz=pz

α

×

vzꢀꢀ

(1);

[0039]

其中:px

α

、py

β

、pz

α

分别表示以眼动仪为坐标原点,注视点在实际空间位置的坐标与眼动仪中的坐标的x,y,z方向的比值。vz

x

、vzy、vzz分别表示以眼动仪为坐标原点,注视点的实际空间位置坐标。考虑到眼动仪坐标系与世界空间坐标系的差异性,以注视点空间坐标为基础,以基于摄像机原点的注视点实物坐标(x,y,z)为参考,建立空间坐标系转换方程,求得坐标系转换矩阵m,将眼动仪采集的注视点坐标转化为世界坐标系下的目标点坐标。

[0040]

[x,y,z]=m[vz

x

,vzy,vzz]

ꢀꢀ

(2);

[0041]

对注视聚类中心点进行坐标转化,注视聚类中心点指的是注视点聚集在一定范围内的中心点,将其作为摄像机监控施工现场的自动扫视路径关键定位点,以扫视所有施工现场的最短时间和为目标函数,求解隐患检测的最优路径。对隐患检测路径的多个清晰局部隐患场景进行图像拼接。

[0042]

上述求解隐患检测的最优路径具体过程如下:

[0043]

依据各注视聚类区域内注视点累计时间总和∑ms,推算每个场景的停留时间tsk,以扫视所有施工区域所需总时间最短min∑tsk为目标函数,考虑检测部位的优先顺序ζk,建立基于旅行商问题的施工安全隐患检测遍历模型,运用粒子群算法,求解最优隐患检测最优遍历路径。依据隐患检测路径,结合路径上的关键注视区域,大量采集隐患局部图像,为隐患识别提供图像数据基础。

[0044]

施工安全隐患检测的旅行商问题:以隐患检测效果(检测所有施工区域的时间、识别率)最佳为目标函数,综合考虑检测部位的优先顺序、关键注视区域停留时间与采集图像数量(人员及机械设备数量、作业类型及其隐患发生频率与严重程度)等约束条件。

[0045]

上述对隐患检测路径的隐患场景的图像拼接过程如下:

[0046]

首先,设定隐患检测路径上两个邻次场景图像的拍摄重叠率,保证拍摄的相邻图像具有重叠区域。

[0047]

其次,对隐患图像进行多尺度空间划分,提取同一尺度平面与不同尺度之间的像素变化幅度明显区域,获取尺度变化下的稳定特征点集合p={p1,p2,...,pn};

[0048]

然后,计算每一个特征点的像素(x,y)梯度方向θ(x,y)与梯度幅值m(x,y),将特征点按照其特征向量p(θ(x,y),m(x,y))进行描述,形成多维特征描述子集;

[0049]

最后,依据特征点的特征向量,遍历计算相邻图像中特征点之间的欧式距离l,以距离最小为匹配特征点:

[0050][0051]

基于图像特征点匹配策略算法,将具有重叠区域的邻次图像拼接为大视野隐患图像,在最有可能具有施工安全隐患的路径上,完成施工场景的图像采集工作,囊括施工安全隐患。

[0052]

5、获取初级视觉特征目标显著图s1的具体过程如下:

[0053]

(5.1)、依据群体注视点集聚特征,进一步精准定位大视野图像中的隐患位置。依据隐患图像训练数据库,提取输入图像的红r

l

、绿g

l

、蓝b

l

三颜色通道以及图像的像素点坐标(x,y)等参数,提取不同尺度l的场景图像亮度i、颜色rgb、方向lb等基本特征,训练基于初级视觉特征的目标显著注意模型:

[0054][0055]

式(3)中:i

l

表示l尺度下的场景亮度,r

l

表示l尺度下输入图像的红色通道,g

l

表示l尺度下输入图像的绿色通道,b

l

表示l尺度下输入图像的蓝色通道,rgb

l

表示l尺度下的三种颜色的特征,f

rgbl

(r

l

,g

l

,b

l

)表示三种颜色的颜色特征函数,lb(x,y)表示像素点坐标(x,y)的方向特征,f

lb

(x,y)表示像素点坐标(x,y)的方向特征的函数。

[0056]

(5.2)、通过计算图像区域中心像素与周边像素的梯度差值θ,针对图像尺度空间中高分辨率c与低分辨率s的尺度因子,获取亮度、颜色、方向特征的显著图i(cθs)、rgb(cθs)、lb(cθs),将三种显著图归一化处理后,组合特征权重wi、w

rgb

、w

lb

,建立基于初级视觉特征的目标显著图s1:

[0057]

s1=wi·

i(cθs) w

rgb

·

rgb(cθs) w

lb

·

lb(cθs)

ꢀꢀ

(4)

[0058]

式(4)中:s1表示基于初级视觉特征的目标显著图,wi、w

rgb

、w

lb

表示亮度、颜色、方向特征的显著图的特征权重,i(cθs)、rgb(cθs)、lb(cθs)表示亮度、颜色、方向特征的显著图。

[0059]

6、获取基于人眼注视经验的目标显著图s2的具体过程如下:

[0060]

(6.1)、以每个注视点r时间、顺序以及到聚类中心点v的欧几里德距离d(r,v)为权重,分别建立注视时间加权高斯图gs

t

、注视顺序加权图gsr以及注视中心距离加权图gsd。基于权重α、β、γ加权三图,形成多目标检测注视高斯图gs:

[0061]

gs=αgs

t

βgsr γgsdꢀꢀ

(5)

[0062]

(6.2)、采用线性支持向量机对多目标检测注视高斯图gs进行二分类,二分类即寻找一个超平面,区分注视显著区和非注视显著区。将gs图像输入线性支持向量机中进行训练,找出超平面,区分注视显著点与非注视显著点,线性超平面的求解模型如下:

[0063][0064]

式(6)中w为权重,b为偏差向量,y为样本真实类别标签。

[0065]

通过输入训练安全隐患图像,求解最优参数w、b,构建基于人眼注视经验目标显著图的注意模型,提取基于人眼注视经验的目标显著图s2。

[0066]

7、综合基于初级视觉特征和人眼注视经验的目标显著注意模型,构建施工安全隐患视觉仿生感知模型,其流程如图1所示。训练机器视觉学习人的隐患识别经验,精准定位隐患暴露部位。构建施工安全隐患视觉仿生感知模型的过程如下:

[0067]

首先输入隐患图像训练数据库中的图像,接着获得初级视觉特征目标显著图,人

眼注视经验目标显著图,结合两者成为施工安全隐患视觉仿生感知模型。

[0068]

8、在精准定位隐患暴露部位的基础上,进一步识别图像目标,具体过程如下:

[0069]

(8.1)、将现场采集的大量隐患图片、视频、眼动数据等实验素材按照隐患分类进行归类,为训练卷积神经网络参数提供基础数据。

[0070]

(8.2)、将隐患部位原始图像输入卷积神经网络vgg16中,经由vgg16网络的卷积层conv与池化层pooling交替反复处理,接着通过全连接层与softmax分类层,提取图像特征向量,获取隐患部位图像的卷积特征图。生成卷积特征图的过程如下:

[0071]

红,绿,蓝为三原色,基本可以合成人眼可以分辨的颜色,将输入的隐患部位的原始图像进行卷积操作,利用红绿蓝这三个特征过滤器,获得一个三通道的输出,通道中某一处数值的强弱就是对当前特征强弱的反应,即卷积特征图,

[0072]

(8.3)、针对已提取的卷积特征图,采用edgeboxes方法,利用特征图的纹理、边缘颜色等信息,确定候选框内的轮廓个数和与候选框边缘重叠的边数,找出可能含有目标的候选区,生成候选区的回归边界。将候选区域及其对应的卷积特征图在池化层中重组,接入全连接层与softmax分类层,检测目标类别与区域边界。结合建立的隐患图像数据库,训练卷积神经网络参数。隐患部位图像目标识别流程如图2所示。

[0073]

9、隐患语义关系推理过程如下:

[0074]

(9.1)、考虑施工人员、机械、设备等目标形状不规则特征,采用包围盒算法,建立施工目标的二维平面包络空间,分别提取包络空间的最大值坐标点(x,y)

max

与最小值坐标点(x,y)

min

。

[0075]

(9.2)、通过训练的卷积神经网络参数,检测目标的图像坐标数据,计算图像缩放装换矩阵a1、对称等变换矩阵a2、角度转换矩阵a3,构建图像目标图上坐标(x,y)与实际坐标(x',y')的变换矩阵实现图像目标与实际空间的位置映射变换:

[0076][0077]

(9.3)、建立隐患知识语义判别模型,过程如下:

[0078]

将空间位置及其关系数据转化为语义概念表达,对比隐患规范知识库,提取隐患信息输入与隐患规范知识库的基础语义概念v1、v2,定位v1、v2在语义网络的结构位置vl1、vl2,测度两者网络节点距离dist(vl1,vl2)与语义网络最大层级maxvl。综合上述参数,计算语义要素v1、v2之间的相似度s:

[0079][0080]

运用语义要素相似度算法,遍历隐患文本输入的m个语义概念vm={v

11

,v

12

,

···

,v

1m

}与隐患规范知识库中n个语义概念vn={v

21

,v

22

,

···

,v

2n

}之间的相似度,计算隐患信息输入与知识库的相似度矩阵sim:

[0081][0082]

式(9)中,vm为隐患文本输入的m个语义概念vm={v

11

,v

12

,

···

,v

1m

},vn为隐患规范知识库中n个语义概念vn={v

21

,v

22

,

···

,v

2n

},sim矩阵中的为任意隐患文本与隐患规范知识库的相似度。

[0083]

经由隐患语义相似度算法,输出最大匹配度语义概念集合max{sim},组合形成隐患判别信息,实现隐患自动判别。如图3所示。

[0084]

隐患自动判别即利用机器视觉识别施工现场,得到的信息就是需要判断是否是隐患的判别信息,将判别信息与隐患规范知识库进行相似度计算,如果与知识库中的隐患信息匹配,则在施工现场识别到隐患,需要进行预警与整改,然后形成知识案例,整合到隐患规范知识库中,如果与知识库中的隐患信息不匹配,则不是隐患。隐患自动判别能够自动监测和识别施工安全隐患,具有识别度高、全天候、成本低的优点,对于减少安全事故具有重大意义。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。