1.本技术涉及人工智能技术领域,特别是涉及一种评分方法、装置、计算设备及存储介质。

背景技术:

2.随着科技技术的发展,语音识别技术广泛应用于多个场景中。比如,为提高学生英语口语语言技能、促进学生英语综合能力的提升与发展,多个教育地区逐渐重视对于学生英语口语的训练和考核,并通过自动化智能语音评测技术为口语考试进行评分。

3.其中,一种常见的考核题型为问答题,即学生(或其他类型的考生)根据看到的文字描述,通过语音给出问题答案。相应的,在利用语音评测技术进行评分时,先基于通用的语音识别模型来识别学生回答的语音内容,该语音识别模型预先通过至少一组音频数据以及该音频数据对应的文本完成训练;然后,再根据语音识别得到的文本进行相应的评分。

4.但是,实际应用时,根据语音内容所最终得到的评分结果,与预期的评分结果经常会存在较大偏差,如部分回答正确的学生所获得的评分较低,甚至可能会低于回答错误的学生所获得的评分等,从而影响自动评分的准确性。

技术实现要素:

5.本技术实施例提供了一种评分方法、装置、计算设备及存储介质,以提高对答题音频的语音识别的准确性,进而提高对该答题音频进行自动评分的准确性。

6.第一方面,本技术实施例提供了一种评分方法,所述方法包括:

7.获取题目信息以及针对所述题目信息的答题音频;

8.根据所述题目信息,对所述答题音频进行语音识别,得到所述答题音频对应的语音识别文本;

9.根据所述语音识别文本,对所述答题音频进行评分。

10.在一种可能的实施方式中,所述根据所述题目信息,对所述答题音频进行语音识别,得到所述答题音频对应的语音识别文本,包括:

11.将所述题目信息以及所述答题音频输入至语音识别模型,得到所述语音识别模型输出的语音识别文本,所述语音识别模型预先通过样本数据进行训练,所述样本数据包括样本题目信息、针对所述样本题目信息的样本答题音频、所述样本答题音频对应的转写文本。

12.在一种可能的实施方式中,所述语音识别模型包括编码器以及解码器,所述方法还包括:

13.获取所述样本数据;

14.将所述样本数据中文本格式的样本题目信息、所述样本答题音频作为所述编码器的输入,将所述样本答题音频对应的转写文本作为所述解码器的输入,训练所述语音识别模型。

15.在一种可能的实施方式中,在利用所述样本数据训练所述语音识别模型之前,所述方法还包括:

16.获取初始样本数据,所述初始样本数据包括初始样本音频以及所述初始样本音频对应的转写文本;

17.将所述初始样本数据中所述初始样本音频、所述初始样本音频对应的转写文本中的部分文本作为所述编码器的输入,将所述初始样本音频对应的转写文本作为所述解码器的输入,训练所述语音识别模型。

18.在一种可能的实施方式中,在利用所述样本数据训练所述语音识别模型之后,所述方法还包括:

19.获取测试数据,所述测试数据包括测试题目信息以及所述测试题目信息对应的测试答题音频;

20.将所述测试数据输入至所述语音识别模型,得到所述语音识别模型输出的测试结果;

21.利用所述测试数据、所述测试结果以及所述样本数据,训练所述语音识别模型。

22.在一种可能的实施方式中,所述题目信息包括音频格式的题目信息或者文本格式的题目信息。

23.在一种可能的实施方式中,所述获取针对所述题目信息的答题音频,包括:

24.呈现答题界面,所述答题界面包括文本格式的题目信息;

25.获取用户输入的针对所述题目信息的答题音频。

26.在一种可能的实施方式中,所述方法还包括:

27.呈现评分界面,所述评分界面包括针对所述答题音频的评分分数。

28.第二方面,本技术实施例还提供了一种评分装置,所述装置包括:

29.第一获取模块,用于获取题目信息以及针对所述题目信息的答题音频;

30.语音识别模块,用于根据所述题目信息,对所述答题音频进行语音识别,得到所述答题音频对应的语音识别文本;

31.评分模块,用于根据所述语音识别文本,对所述答题音频进行评分。

32.在一种可能的实施方式中,所述语音识别模块,包括:

33.提取单元,用于提取所述题目信息对应的文本特征以及所述答题音频对应的声学特征;

34.编码单元,用于对所述文本特征以及所述声学特征进行编码,得到编码数据;

35.解码单元,用于对所述编码数据进行解码,得到所述答题音频对应的语音识别文本。

36.在一种可能的实施方式中,所述语音识别模块,具体用于将所述题目信息以及所述答题音频输入至语音识别模型,得到所述语音识别模型输出的语音识别文本,所述语音识别模型预先通过样本数据进行训练,所述样本数据包括样本题目信息、针对所述样本题目信息的样本答题音频、所述样本答题音频对应的转写文本。

37.在一种可能的实施方式中,所述语音识别模型包括编码器以及解码器,所述装置还包括:

38.第二获取模块,用于获取所述样本数据;

39.第一模型训练模块,用于将所述样本数据中文本格式的样本题目信息、所述样本答题音频作为所述编码器的输入,将所述样本答题音频对应的转写文本作为所述解码器的输入,训练所述语音识别模型。

40.在一种可能的实施方式中,在所述第一模型训练模块利用所述样本数据训练所述语音识别模型之前,所述装置还包括:

41.第三获取模块,用于获取初始样本数据,所述初始样本数据包括初始样本音频以及所述初始样本音频对应的转写文本;

42.第二模型训练模块,用于将所述初始样本数据中所述初始样本音频、所述初始样本音频对应的转写文本中的部分文本作为所述编码器的输入,将所述初始样本音频对应的转写文本作为所述解码器的输入,训练所述语音识别模型。

43.在一种可能的实施方式中,在所述第一模型训练模块利用所述样本数据训练所述语音识别模型之后,所述装置还包括:

44.第四获取模块,用于获取测试数据,所述测试数据包括测试题目信息以及所述测试题目信息对应的测试答题音频;

45.测试模块,用于将所述测试数据输入至所述语音识别模型,得到所述语音识别模型输出的测试结果;

46.第三模型训练模块,用于利用所述测试数据、所述测试结果以及所述样本数据,训练所述语音识别模型。

47.在一种可能的实施方式中,所述题目信息包括音频格式的题目信息或者文本格式的题目信息。

48.在一种可能的实施方式中,其特征在于,所述第一获取模块,包括:

49.呈现单元,用于呈现答题界面,所述答题界面包括文本格式的题目信息;

50.获取单元,用于获取用户输入的针对所述题目信息的答题音频。

51.在一种可能的实施方式中,所述装置还包括:

52.呈现模块,用于呈现评分界面,所述评分界面包括针对所述答题音频的评分分数。

53.第三方面,本技术实施例还提供了一种计算设备,该设备可以包括处理器以及存储器:

54.所述存储器用于存储计算机程序;

55.所述处理器用于根据所述计算机程序执行上述第一方面以及第一方面中任一种实施方式所述的方法。

56.第四方面,本技术实施例还提供了一种计算机可读存储介质,其特征在于,所述计算机可读存储介质用于存储计算机程序,所述计算机程序用于执行上述第一方面以及第一方面中任一种实施方式所述的方法。

57.在本技术实施例的上述实现方式中,获取题目信息以及针对该题目信息的答题音频;将该题目信息以及答题音频输入至语音识别模型,获得语音识别模型输出的答题音频对应的语音识别文本,该语音识别模型预先通过样本数据进行训练,该样本数据包括样本题目信息、针对该样本题目信息的样本答题音频以及该样本答题音频对应的转写文本;根据该语音识别文本对答题音频进行评分。

58.由于结合了题目信息来对答题音频进行语音识别,这相比于基于通用的语音识别

模型进行语音识别的方式而言,题目信息作为对答题音频进行语音识别的先验信息,可以用于提高语音识别的准确性,进而可以提高根据该语音识别文本对答题音频进行评分的准确性。

59.另外,题目信息与答题音频一并融入了语音识别模型的神经网络,这不仅能够提高利用题目信息来优化语音识别精度的效果,而且,语音识别模型无需融合其它的外部语言模型,从而可以提高语音识别模型的通用性,降低语音识别模型的部署难度。

附图说明

60.为了更清楚地说明本技术实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本技术中记载的一些实施例,对于本领域普通技术人员来讲,还可以根据这些附图获得其他的附图。

61.图1为本技术实施例中一示例性用于实现对答题音频自动化评分的系统架构示意图;

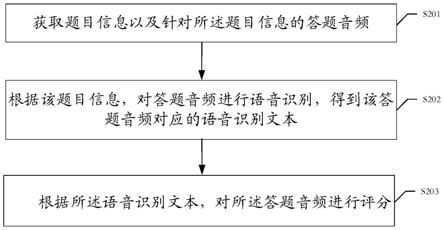

62.图2为本技术实施例中一种评分方法的流程示意图;

63.图3为一示例性答题界面示意图;

64.图4为本技术实施例中训练语音识别模型的流程示意图;

65.图5为一示例性语音识别模型的结构示意图;

66.图6为本技术实施例中一种评分装置结构示意图;

67.图7为本技术实施例中一种计算设备的硬件结构示意图。

具体实施方式

68.参见图1,为本技术实施例提供的用于实现对答题音频自动化评分的系统结构示意图。如图1所示,该系统100包括终端101以及服务器102。其中,终端101以及服务器102之间存在通信连接,并可以进行正常的数据通信。

69.其中,终端101可以向用户(如学生、考生等)呈现问答题,如呈现文本格式的问答题内容等,以便用户根据看到的问答题的题目内容在终端101上录入相应的答题音频。然后,终端101将题目信息以及采集到的答题音频发送给服务器102。

70.此时,如果服务器102采用通用的语音识别模型对用户答题的答题音频进行语音识别,该语音识别模型例如是通过循环神经网络(recurrent neural network,rnn)构建的模型或者为transformer模型等,其通过音频以及该音频对应的文本完成模型训练。则,通常情况下,该语音识别模型的识别准确性可能较低,这使得服务器102可能得到准确性较低的语音识别文本,从而服务器102基于该语音识别文本进行评分时,所给定的评分分数可能与用户实际应该获得的分数存在较大偏差。

71.例如,假设终端101所呈现的题目为“please tell me what can be used as food”(请说出什么东西可以作为食物),并且用户在终端101上所录入的答题音频的内容为“bread”(面包)。但是,服务器102在利用通用的语音识别模型对该答题音频进行语音识别时,有可能会将该答题音频识别为“bred”(木板),这使得即使用户回答正确,但是服务器102会因为根据错误的识别结果“bred”给出错误的评分(如0分),从而影响评分的准确性。

72.如果通过融合通用的语音识别模型以及针对题目信息所定制化训练的外部语言

模型,并采用浅融合技术来提高对于答题音频的语音识别的准确性,一方面,对于语音识别的精度提升有限,从而评分准确性仍然较低;另一方面,针对不同的题目,需要定制、训练不同的外部语言模型,通用性较低、部署难度较大。

73.基于此,本技术实施例提供了一种评分方法,以提高服务器102对于答题音频的评分准确性。具体实现时,服务器102在获取到客户端101发送的题目信息以及答题音频后,根据该题目信息对答题音频进行语音识别,得到该答题音频对应的语音识别文本,从而服务器102根据该语音识别文本对答题音频进行评分。

74.由于结合了题目信息来对答题音频进行语音识别,这相比于基于通用的语音识别模型进行语音识别的方式而言,题目信息作为对答题音频进行语音识别的先验信息,可以用于提高语音识别的准确性,进而可以提高服务器102根据该语音识别文本对答题音频进行评分的准确性。

75.仍以题目信息为“please tell me what can be used as food”,答题音频的内容为“bread”(面包)为例,在对该答题音频进行语音识别时,虽然与该答题音频的发音相同的单词包括“bread”、“bred”等,但是,能够将题目信息作为先验信息,确定最终输出的语音识别文本为属于食物类别的“bread”,而并非是“bred”,从而可以有效提高针对该答题音频的识别准确性,进而可以提高服务器102根据该语音识别文本“bread”对答题音频进行评分的准确性,如评分分数为满分等。

76.另外,当利用语音识别模型根据题目信息来识别答题音频时,题目信息与答题音频可以一并融入语音识别模型的神经网络,这不仅能够提高利用题目信息来优化语音识别精度的效果,而且,语音识别模型无需融合其它的外部语言模型,从而可以提高语音识别模型的通用性,降低对答题音频进行自动化评分的方案的部署难度。

77.可以理解的是,图1所示的用于实现对答题音频自动化评分的系统100的架构仅是本技术实施例提供的一个示例,实际应用时,该系统的架构不局限于图1所示示例。比如,在其它可能的实现方式中,系统100可以包括多个服务器,并且基于该多个服务器可以为终端101提供自动化评分的云服务。或者,用于实现对答题音频自动化评分的系统也可以是仅包括位于本地的计算设备,如用户设备、本地服务器等,并由该计算设备提供自动化评分的本地化服务。总之,本技术实施例可以应用于任何可适用的系统中,而不局限于上述示例。

78.为使本技术的上述目的、特征和优点能够更加明显易懂,下面将结合附图对本技术实施例中的各种非限定性实施方式进行示例性说明。显然,所描述的实施例是本技术一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其它实施例,都属于本技术保护的范围。

79.参阅图2,图2示出了本技术实施例中一种评分方法流程示意图,该方法可以应用于图1所示的系统100中,当然,也可以应用于其它可适用的系统。为便于说明与理解,下面以应用于图1所示的系统100并由服务器102执行针对答题音频的评分过程为例进行说明。该方法具体可以包括:

80.s201:获取题目信息以及针对该题目信息的答题音频。

81.本实施例中,题目信息,具体可以是问答题中的题目内容(如题目描述和/或问题等),通常与问题答案密切相关。如问答题的题目内容可以是上述“please tell me what can be used as food”,而问题答案可以是“bread”、“rice”、“noodles”等,均属于题目中

所提及的“food”。因此,题目信息中通常包括问题答案的先验知识。

82.示例性地,该题目信息,可以是通过文本格式进行呈现,如通过中文或者英文表达的题目文本,可以在终端101的显示界面上呈现给用户。或者,题目信息,也可以是通过音频格式进行呈现,如终端101可以向用户语音播放一段音频,并且,该音频中的语音内容即为题目内容。

83.在一种可能的实施方式中,以题目信息具体为文本格式的题目为例,终端101可以呈现答题界面,该答题界面包括文本格式的题目信息,如图3所示的“please tell me what can be used as food”(题目信息),并且,答题界面中还设置有语音录入控件。这样,用户在从答题界面上查看到题目信息后,可以点击语音录入控件以触发终端101启动音频录入,而用户可以开始向终端101中通过语音的方式输入问题答案,并在答题结束后点击停止录入控件以结束音频录入。这样,终端101可以获得用户针对该题目的答题音频,并将该答题音频以及相应的题目信息一并发送给服务器102。

84.当然,实际应用时,服务器102也可以是通过其它方式获取题目信息以及用户针对该题目信息所输入的答题音频,本实施例对此并不进行限定。

85.s202:根据该题目信息,对答题音频进行语音识别,得到该答题音频对应的语音识别文本。

86.本实施例中,由于答题音频是用户根据题目信息进行语音作答而给出,因此,题目信息中的内容可以用于指导答题音频的识别。比如,假设题目信息中包括“food”时,如果答题音频对应的语音识别结果可能是“bread”,也可能是“bred”时,则由于题目信息中的“food”与“bread”的相关性更高,因此,可以指导服务器102将答题音频识别为“bread”,而不是“bred”。

87.作为一种实现示例,服务器102可以提取该题目信息对应的文本特征以及该答题音频对应的声学特征。例如,服务器102可以对题目信息对应的文本进行分词处理,并对切分得到的多个分词进行向量化后,可以得到该题目信息对应的文本特征;同时,服务器102还可以从答题音频包括的多帧音频中提取出fbank特征,并将该fbank特征作为答题音频对应的声学特征等。然后,服务器102可以对该文本特征以及升学特征进行编码,例如在将文本特征以及声学特征进行拼接后,对拼接得到的特征进行编码,以此得到编码数据,从而服务器102再对该编码数据进行解码,即可得到该答题音频对应的语音识别文本。

88.而在其它可能的实施方式中,服务器102也可以是通过预先完成训练的语音识别模型,得到答题音频对应的语音识别文本。具体的,服务器102可以将获取的题目信息以及针对该题目信息的答题音频输入至语音识别模型,得到该语音识别模型输出的语音识别文本,该语音识别模型预先通过样本数据进行训练,该样本数据包括样本题目信息、针对该样本题目信息的样本答题音频、该样本答题音频对应的转写文本。

89.其中,该语音识别模型预先通过至少一组样本数据完成训练,该样本数据中包括作为语音模型输入的样本题目信息、针对该样本题目信息的样本答题音频,以及作为语音识别模型输出的样本答题音频对应的撰写文本。作为一种示例,语音识别模型可以是基于encoder-decoder(编码器-解码器)框架的端到端语音识别技术进行构建,或者可以是通过其它方式进行构建等,本实施例对此并不进行限定。其中,关于语音识别模型的具体训练过程,可以参见下文描述,在此不做赘述。

90.值得注意的是,由于语音识别模型结合题目信息来识别答题音频对应的文本,因此,通常情况下,语音识别模型能够利用题目信息中包括的先验知识,提高对于该答题音频的识别精度。

91.s203:根据该语音识别文本,对答题音频进行评分。

92.示例性地,服务器102可以根据语音识别模型输出的语音识别文本以及针对答题音频的语音强制对齐结果,提取评分特征,从而根据该评分特征给出相应的评分分数。本实施例中,关于服务器102根据语音识别文本进行评分的具体实现过程,在已有技术中存在相关应用,本实施例对此不再过多赘述。

93.进一步地,服务器102在得到答题音频对应的评分分数后,可以进一步将其呈现给用户。比如,服务器102可以通过终端101呈现评分界面,并且该评分界面上包括针对该答题音频的评分分数,这样,用户在完成语音答题后,可以从该评分界面上了解到相应的评分分数。

94.本实施例中,由于结合了题目信息来对答题音频进行语音识别,这相比于基于通用的语音识别模型进行语音识别的方式而言,题目信息作为对答题音频进行语音识别的先验信息,可以用于提高语音识别的准确性,进而可以提高服务器102根据该语音识别文本对答题音频进行评分的准确性。

95.上述实施例中,当服务器102利用语音识别模型进行语音识别时,该语音识别模型可以预先通过至少一组样本数据进行训练。下面,重点描述针对语音识别模型的训练过程进行示例性介绍。值得注意的是,训练语音识别模型的设备可以是服务器102,或者可以是其它计算设备,并且其它计算设备在完成语音识别模型的训练后将其发送给服务器102。下面,以服务器102执行语音识别模型的训练过程为例进行示例性说明。

96.参见图4,图4示出了本技术实施例中训练语音识别模型的流程示意图,如图4所示,该方法包括:

97.s401:构建基于encoder-decoder框架的语音识别模型。

98.本实施例中,服务器102可以构建基于encoder-decoder框架的端到端语音识别模型,该语音识别模型中可以包括编码器以及解码器。例如,服务器102所构建出的语音识别模型可以如图5所示。

99.其中,编码器包括卷积层(convolutional layer)以及多个编码器层(transformer encode layer),如包括12层的编码器层等,每层编码器层可以包括一层自注意力机制(self-attention mechanism)和一层前向神经网络(feed forward neural network)。编码器中的卷积层可以包括二维卷积层以及一维卷积层,其中,二维卷积层的步长为2、卷积层的层数为2,一维卷积层的步长为1、卷积层的层数为2。

100.解码器包括卷积层以及多个编码器层,如包括6层的解码器层等,每层解码器层可以包括一层自注意力机制、一层交叉注意力机制(cross attention mechanism)交叉注意力机制和一层前向神经网络。解码器中的卷积层可以包括一维卷积层,其中,一维卷积层的步长为1、卷积层的层数为2。

101.当然,上述所示的语音识别模型的结构仅作为一种示例性说明,实际应用时,语音识别模型的具体结构不限于上述示例,如语音识别模型中的编码器层以及解码器层的层数可以为其它数值,或者,每个编码层或者解码器层中的网络结构可以为其它结构设计,本实

施例对此并不进行限定。

102.s402:获取样本数据,该样本数据包括样本题目信息、针对该样本题目信息的样本答题音频、该样本答题音频对应的转写文本。

103.本实施例中,用于模型训练的数据称之为样本数据,并且,该样本数据中包括的题目信息称之为样本题目信息、样本数据中包括的答题音频称之为样本答题音频。该样本数据,还包括样本答题音频对应的转写文本。

104.作为一种实现示例,服务器102可以基于人工标注的方式生成样本数据。比如,服务器102可以获取大量不包括转写文本的问答场景数据,包括问答题的样本题目信息以及该样本题目信息对应的样本答题音频,然后,服务器102可以通过与标注人员之间的交互,获取标注人员输入的针对各个样本答题音频的转写文本,该样本答题音频与转写文本的内容保持一致。如此,服务器102可以根据人工标注结果,获得包括样本题目信息、答题音频以及转写文本的样本数据。

105.当然,实际应用时,服务器102也可以是通过其它方式获取该样本数据,本实施例对此并不进行限定。

106.s403:将样本数据中文本格式的样本题目信息、样本答题音频作为编码器的输入,将样本答题音频对应的转写文本作为解码器的输入,训练语音识别模型。

107.本实施例中,样本题目信息,可以是文本格式,也可以是音频格式。为便于理解与说明,本实施例以样本题目信息采用文本格式为例。相应的,当样本题目信息采用音频格式时,服务器102在利用该音频格式的样本题目信息进行模型训练的过程中,可以先将其转换成标准的文本内容。

108.在一种可能的实施方式中,针对样本数据中的样本答题音频,服务器102可以以特定长度的帧长和帧移(即相邻两帧的起始位置的时间差)对样本答题音频进行分帧,如以帧长为25ms(毫秒)、帧移为10ms对样本答题音频进行分帧等。然后,服务器102可以从每一帧中提取出预设维数的fbank特征,如每帧提取40维的fbank特征等,以此获取帧的特征序列,并将其作为编码器的声学特征部分的输入,该帧的特征序列可以通过向量化进行表示。针对样本数据中文本形式的样本题目信息,服务器102将该样本题目信息切分成多个分词,如通过字节对编码(byte pair encoding,bpe)算法进行子词切分等,并将切分后所得到的子词序列作为编码器的文本部分的输入,该切分后的子词序列可以通过向量化进行表示。

109.示例性地,基于图5所示的语音识别模型,服务器102在将样本答题音频以及样本题目信息输入至编码器时,具体可以是将样本答题音频对应的帧的特征序列以及样本题目信息对应的子词序列进行向量拼接。例如,编码器的输入为{x1,x2,...,x

t1

,w1,w2,...,w

t2

},其中,xi为样本答题音频对应的帧的特征序列中的第i个向量,wj为子词序列中的第j个向量。这样,语音识别模型可以同时学习样本题目信息以及样本答题音频。

110.而针对样本数据中的转写文本,服务器102可以同样将该转写文本切分成多个分词,如通过bpe算法进行子词切分等,并将切分后所得到的子词序列作为解码器的输入,该切分后的子词序列可以通过向量化进行表示。

111.如此,服务器102可以利用该样本数据来训练语音识别模型,并且,训练语音识别模型时的目标函数为解码器输出和转写文本之间的交叉熵、训练语音识别模型的学习率为0.0001。

112.实际应用时,由于考虑到人力成本、标注效率等原因,服务器102所能获取的针对问答题场景下的样本数据的数据量通常较小。因此,在一些可能的实施方式中,服务器102可以先基于通用的音频-文本数据初步训练语音识别模型,再根据样本数据对初步训练后的语音识别模型进行调整,以此来降低模型训练过程中对于样本数据的数据量要求,从而可以降低生成样本数据的成本。

113.具体实现时,服务器102在利用样本数据训练语音识别模型之前、构建出语音识别模型之后,还可以包括以下步骤:

114.a1:获取初始样本数据,该初始样本数据包括初始样本音频以及该初始样本音频对应的转写文本。

115.其中,该初始样本数据,例如可以是在训练已有的、通用场景下的语音识别模型时所使用的样本数据,这样,服务器102可以从网络上已有的数据库中获取到该初始样本数据。

116.a2:将初始样本数据中的初始样本音频、该初始样本音频对应的转写文本中的部分文本作为编码器的输入,将该初始样本音频对应的转写文本作为解码器的输入,训练该语音识别模型。

117.其中,服务器102利用初始样本数据训练语音识别模型的方式,与上述利用样本数据训练语音识别模型的方式类似,具体可参见上述过程的描述,在此不做赘述。其中,二者的区别在于,服务器102在利用初始样本数据训练语音识别模型时,输入至编码器的字词序列,为基于撰写文本中的部分文本生成的字词序列。

118.服务器102在执行完步骤a1、步骤a2之后,可以继续执行步骤s402、s403,以利用样本数据对经过初步训练的语音识别模型进行调整,以得到针对问答题场景下的语音识别模型。在此过程中,训练语音识别模型的学习率可以是0.001。

119.进一步地,基于上述训练过程,语音识别模型对于答题音频的识别精度通常能够达到较高的水平,而本实施例中,可以通过增加该问答题场景下的样本数据并训练语音识别模型,来进一步对该语音识别模型进行优化,以进一步提高语音识别模型的识别精度。基于此,本实施例还可以进一步包括如下步骤:

120.s404:获取测试数据,该测试数据包括测试题目信息以及该测试题目信息对应的测试答题音频。

121.s405:将该测试数据输入至语音识别模型,得到该语音识别模型输出的测试结果。

122.实际应用时,可能存在较多题目信息以及用户针对该题目信息的答题音频,但是由于人工标注出该答题音频对应的转写文本所需的人力成本较高、效率较低,因此,服务器102可以将这些题目信息作为测试题目信息、将答题音频作为测试答题音频,并将其输入至语音识别模型,得到语音识别模型输出的该测试答题音频对应的转写文本(也即测试结果)。

123.其中,与前述过程类似,服务器102在将测试数据输入至语音识别模型时,具体可以是对测试题目信息进行子词切分,得到相应的子词序列,并从测试答题音频中提取出帧的特征序列;然后,服务器102将提取出的帧的特征序列、子词序列输入至编码器中,从而经过语音识别模型的处理后,由解码器输出相应的撰写文本(即测试结果)。

124.s406:利用测试数据、测试结果以及样本数据,训练语音识别模型。

125.由于语音识别模型的识别精度已经达到较高的水平,因此,可以认定由该语音识别模型输出的测试结果具有较高的识别精度,此时,服务器102可以将测试数据以及测试结果作为新的样本数据,并复用之前模型训练时所使用的样本数据,继续对语音识别模型进行训练,以使得该语音识别模型的识别精度能够因为样本数据的增加而得到进一步的提升。

126.此外,本技术实施例还提供了一种评分装置。参阅图6,图6示出了本技术实施例中一种评分装置结构示意图,该装置600包括:

127.第一获取模块601,用于获取题目信息以及针对所述题目信息的答题音频;

128.语音识别模块602,用于根据所述题目信息,对所述答题音频进行语音识别,得到所述答题音频对应的语音识别文本;

129.评分模块603,用于根据所述语音识别文本,对所述答题音频进行评分。

130.在一种可能的实施方式中,所述语音识别模块602,包括:

131.提取单元,用于提取所述题目信息对应的文本特征以及所述答题音频对应的声学特征;

132.编码单元,用于对所述文本特征以及所述声学特征进行编码,得到编码数据;

133.解码单元,用于对所述编码数据进行解码,得到所述答题音频对应的语音识别文本。

134.在一种可能的实施方式中,所述语音识别模块602,具体用于将所述题目信息以及所述答题音频输入至语音识别模型,得到所述语音识别模型输出的语音识别文本,所述语音识别模型预先通过样本数据进行训练,所述样本数据包括样本题目信息、针对所述样本题目信息的样本答题音频、所述样本答题音频对应的转写文本。

135.在一种可能的实施方式中,所述语音识别模型包括编码器以及解码器,所述装置600还包括:

136.第二获取模块,用于获取所述样本数据;

137.第一模型训练模块,用于将所述样本数据中文本格式的样本题目信息、所述样本答题音频作为所述编码器的输入,将所述样本答题音频对应的转写文本作为所述解码器的输入,训练所述语音识别模型。

138.在一种可能的实施方式中,在所述第一模型训练模块利用所述样本数据训练所述语音识别模型之前,所述装置600还包括:

139.第三获取模块,用于获取初始样本数据,所述初始样本数据包括初始样本音频以及所述初始样本音频对应的转写文本;

140.第二模型训练模块,用于将所述初始样本数据中所述初始样本音频、所述初始样本音频对应的转写文本中的部分文本作为所述编码器的输入,将所述初始样本音频对应的转写文本作为所述解码器的输入,训练所述语音识别模型。

141.在一种可能的实施方式中,在所述第一模型训练模块利用所述样本数据训练所述语音识别模型之后,所述装置600还包括:

142.第四获取模块,用于获取测试数据,所述测试数据包括测试题目信息以及所述测试题目信息对应的测试答题音频;

143.测试模块,用于将所述测试数据输入至所述语音识别模型,得到所述语音识别模

型输出的测试结果;

144.第三模型训练模块,用于利用所述测试数据、所述测试结果以及所述样本数据,训练所述语音识别模型。

145.在一种可能的实施方式中,所述题目信息包括音频格式的题目信息或者文本格式的题目信息。

146.在一种可能的实施方式中,其特征在于,所述第一获取模块601,包括:

147.呈现单元,用于呈现答题界面,所述答题界面包括文本格式的题目信息;

148.获取单元,用于获取用户输入的针对所述题目信息的答题音频。

149.在一种可能的实施方式中,所述装置600还包括:

150.呈现模块,用于呈现评分界面,所述评分界面包括针对所述答题音频的评分分数。

151.需要说明的是,上述装置各模块、单元之间的信息交互、执行过程等内容,由于与本技术实施例中方法实施例基于同一构思,其带来的技术效果与本技术实施例中方法实施例相同,具体内容可参见本技术实施例前述所示的方法实施例中的叙述,此处不再赘述。

152.此外,本技术实施例还提供了一种计算设备。参阅图7,图7示出了本技术实施例中一种计算设备的硬件结构示意图,该设备700可以包括处理器701以及存储器702。

153.其中,所述存储器702,用于存储计算机程序;

154.所述处理器701,用于根据所述计算机程序执行上述方法实施例中所述的评分方法。

155.另外,本技术实施例还提供了一种计算机可读存储介质,所述计算机可读存储介质用于存储计算机程序,所述计算机程序用于执行上述方法实施例中所述的评分方法。

156.本技术实施例中提到的“第一获取模块”、“第一模型训练模块”等名称中的“第一”只是用来做名字标识,并不代表顺序上的第一。该规则同样适用于“第二”、“第三”等。

157.通过以上的实施方式的描述可知,本领域的技术人员可以清楚地了解到上述实施例方法中的全部或部分步骤可借助软件加通用硬件平台的方式来实现。基于这样的理解,本技术的技术方案可以以软件产品的形式体现出来,该计算机软件产品可以存储在存储介质中,如只读存储器(英文:read-only memory,rom)/ram、磁碟、光盘等,包括若干指令用以使得一台计算机设备(可以是个人计算机,服务器,或者诸如路由器等网络通信设备)执行本技术各个实施例或者实施例的某些部分所述的方法。

158.本说明书中的各个实施例均采用递进的方式描述,各个实施例之间相同相似的部分互相参见即可,每个实施例重点说明的都是与其他实施例的不同之处。尤其,对于装置实施例而言,由于其基本相似于方法实施例,所以描述得比较简单,相关之处参见方法实施例的部分说明即可。以上所描述的装置实施例仅仅是示意性的,其中作为分离部件说明的模块可以是或者也可以不是物理上分开的,作为模块显示的部件可以是或者也可以不是物理模块,即可以位于一个地方,或者也可以分布到多个网络单元上。可以根据实际的需要选择其中的部分或者全部模块来实现本实施例方案的目的。本领域普通技术人员在不付出创造性劳动的情况下,即可以理解并实施。

159.以上所述仅是本技术示例性的实施方式,并非用于限定本技术的保护范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。