1.本发明涉及计算机技术领域,深度学习,网络压缩技术领域,具体来说是一种基于浅深皮层双路径构架的卷积神经网络模型压缩优化方法。

背景技术:

2.图像识别技术是指对图像中的目标进行识别的技术。在无人驾驶领域,如何精准高效地识别道路场景中的目标,同时又需保证实时计算的速度以及对芯片算力的低要求,是机器学习、人工智能领域的一大挑战。

3.图像识别的探索过程经历了以下几个阶段:早期通过模版匹配;用模式识别完成识别、评价;用深度神经网络进行特征提取;直接训练端到端的网络进行识别。

4.图像识别中的模式识别(pattern recognition),是一种从大量信息和数据出发,在专家经验和已有认识的基础上,利用计算机和数学推理的方法对形状、模式、曲线、数字、字符格式和图形自动完成识别、评价的过程。模式识别包括两个阶段,即特征提取和分类,前者是对样本进行特征选择,后者是对未知样本集进行分类和识别。

5.随着机器学习算法和计算机硬件的进步,构建包含多层卷积的大规模深度卷积神经网络(convolutional neural networks,cnn)变得可能。在大量图片的数据集上,cnn在图像识别的模型表现上甚至超越了传统的图像特征提取方法。然而,在高性能gpu卡加持下得以有效训练的深度卷积神经网络却很难在以手机为代表的移动端设备上进行有效的部署,因此模型压缩和轻量化模型设计是近几年卷积神经网络研究的热点。

6.通道注意力机制(channel attention mechanism)从输入特征图通过两层全连接层来建模通道之间的关系,从而获得更加有效的特征表示。

7.通道注意力机制将输入特征图通过全局平均池化得到一组通道维度的权值,将这组权重通过两个全连接层捕捉通道之间的关系。其中两个全连接层之间有一个维度缩减用于减小该模块所需的参数量。最终将得到的权值通过sigmoid 激活映射至0到1的区间,再与原特征图相乘实现对通道的激活和抑制。

技术实现要素:

8.本发明的目的在于以resnet50和mobilenetv1构架为例建立双路径模型,然后通过特征分离模块来实现高效精准的通道特征提取,提供一种基于浅深皮层双路径构架的卷积神经网络模型压缩优化方法,该方法在图像识别数据集上达到良好的识别效果。

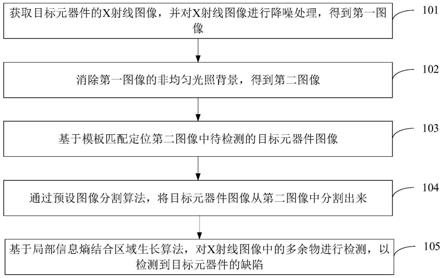

9.为了实现上述目的,设计一种基于浅深皮层双路径构架的卷积神经网络模型压缩优化方法,其特征在于,该方法包括如下步骤:

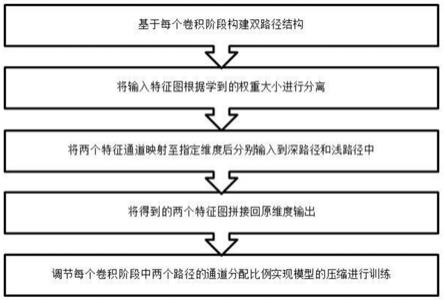

10.步骤一:将某个卷积神经网络中每个阶段的卷积块构建成双路径结构,卷积神经网络中包括深路径和浅路径,深路径中由若干个卷积块堆叠而成,浅路径中只包含一层维度映射;

11.步骤二:将输入特征图通过特征分离模块;

12.步骤三:将正权重的特征图映射至指定维度后输入到深路径中,将负权重的通道输入到浅路径中;

13.步骤四:将经过两个路径卷积运算的特征图拼接回原来的维度输出;

14.步骤五:通过调节每个卷积阶段中两个路径之间的通道比例实现模型不同程度的压缩后进行训练。

15.本发明还具有如下优选的技术方案:

16.1.步骤一的双路径架构是指每个卷积阶段包含两条路径,其中深路径由若干个卷积块堆叠,浅路径只包含一层维度映射。

17.2.步骤二的特征分离操作是指:首先通过通道注意力机制学习到一组通道权重,并映射至-1到1的区间,然后分别做relu激活和取反后做relu激活,将得到的两组权值与原特征图相乘即能将对应的特征通道分离,具体方法如下:

18.步骤a1:使用全局平均池化将特征通道的大小从h

×w×

c压缩到1

×1×ꢀ

c的表示:

[0019][0020]

步骤a2:将输入特征图通过两层全连接层建模通道之间的关系,采用tanh 激活函数将输出映射到-1到1的区间:

[0021]

ω=σ(w2relu(w1g(x)))#(2)

[0022]

步骤a3:在ω上执行relu激活函数使得其中正权重得以保留,取反做relu 激活得到负权重:

[0023]

ω1=relu(ω)#(3)

[0024]

ω2=relu(-ω)#(4)

[0025]

步骤a4:通过将ω1和ω2与原始特征图相乘,可以获得两个特征图,分别对应于具有正权重和负权重的通道。

[0026]

本发明同现有技术相比,其优点在于:本发明以resnet50和mobilenetv1 架构为例构建了双路径架构,这一架构进行模型压缩后在图像识别数据集上依然具有良好的识别效果,并且模型不同程度的压缩只需要调节通道超参数就能实现。具体体现为:

[0027]

1.将本发明构建的双路径结构在模型计算量压缩至二分之一和四分之一时,与其他剪枝方法和轻量化模型相比较,在imagenet数据集上取得了当前最优的测试成绩。

[0028]

2.在参数量从25.6m压缩到13.2m参数,和计算量从4.1g压缩到2.26g flops时,在imagenet数据集上达到了76.6%的top-1精度,比resnet-50的 76.4%略有提高。

[0029]

3.当模型参数量与计算量进一步压缩到6.8m参数和1.12g flops时,在 imagenet上实现了74.5%的top-1精度,这一结果优于当前最好的剪枝方法和轻量化设计模型。

[0030]

4.在轻量化模型mobilenetv1上通过构建双路径设计依然可以取得相比较剪枝方法更有竞争力的结果。

[0031]

5.提升实时计算的速度,降低了对芯片算力的要求。

附图说明

[0032]

图1为本发明流程图;

[0033]

图2为特征分离模块示意图;

[0034]

图3为双路径架构示意图。

具体实施方式

[0035]

下面结合附图对本发明作进一步说明,本发明的结构和原理对本专业的人来说是非常清楚的。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

[0036]

本发明提出一种基于浅深皮层双路径构架的卷积神经网络模型压缩优化方法,该方法以深度卷积神经网络模型为目标模型,通过构建一种双路径架构实现模型的压缩,通过特征分离模块保障通道的有效特征提取,得到了优秀的图像识别测试结果。

[0037]

本发明通过部署特征分离模块实现通道分离。但是特征分离模块中包含的两个全连接层具有较大的参数量。因此,本发明在深度卷积神经网路的每个阶段部署一个特征分离模块,只需要部署四个该模块。

[0038]

本发明包括如下步骤:

[0039]

1、构建双路径架构:

[0040]

一般卷积神经网络参数量和运算量较大,通过构建双路径结构实现模型的压缩。

[0041]

2、每个双路径架构中部署一个特征分离模块实现特征的分离。

[0042]

该模块包含两个全连接层,将学到的权重通过tanh激活函数映射至-1到1 的区间后通过relu激活和取反relu激活实现通道分离。

[0043]

3、将分离后的特征通道分别输入到两个路径中。

[0044]

具有正权重的通道输入至深路径中,低权重的通道输入至浅路径中,减少了模型的计算量。

[0045]

4、两部分特征通道进行拼接输出。

[0046]

两个特征通道拼接回原维度可以避免特征损失。

[0047]

5、训练深度卷积神经网络。

[0048]

6、训练完毕后进行测试。

[0049]

模型训练完毕,固定模型参数,在测试集上进行验证得到测试结果。

[0050]

以下是训练图像识别模型的具体实施例。在这个实施例中用于训练的图像数据集为imagenet。

[0051]

1、在包含1000类对象的imagenet数据集上利用交叉熵损失进行基于 resnet50和mobilenetv1构建的双路径模型的训练。

[0052]

2、训练完毕后,在imagenet的测试集进行性能测试。实验结果如下表1 和表2。

[0053][0054]

表1基于resnet50构建的双路径模型性能对比

[0055]

模型flopstop-1精度(%)0.75

×

mobilenetv1325m68.4amc285m70.5netadapt284m69.1meta_prunning281m70.6eagleeye281m70.9cisddp285m71.0

[0056]

表2基于mobilenetv1构建的双路径模型性能对比。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。