1.本发明涉及数字能源、物联网、深度学习和强化学习技术领域,具体地说是一种基于强化学习的电力系统仿真调度方法及系统。

背景技术:

2.近年来,强化学习技术受到了大家的广泛关注,特别是与深度学习结合,给人工智能领域带来了很大的进展。强化学习不同于传统的监督学习,主要表现在强化信号上,强化学习中由环境提供的强化信号是对产生动作的好坏作一种评价(通常为标量信号),而不是告诉强化学习系统rls(reinforcement learning system)如何去产生正确的动作。强化学习通过智能体agent与环境之间交互的任务,不断地学习在不同的环境下做出最优的动作,利用这些感知生成策略,因而可以创造更高的机器智能。强化学习在机器人控制、自动驾驶、推荐系统领域等都得到了应用,在很多领域都超越了人类表现。

3.电力系统调度是由许多发电厂提供电能,通过输电、变电、配电、供电网络向广大用户供电,是一个复杂的系统。其产、供、销过程在一瞬间同时完成和平衡。电力系统调度要随时保持发电与负荷的平衡,要求调度管辖范围内的每一个部门严格按质按量完成调度任务。随着近年来分布式光伏、分布式风电等可再生能源发展迅速,清洁能源的消纳给电力系统的调度带来了新的挑战。电力系统在新的发电能源比例构成下,对电力系统调度员有了更高的要求,电力系统调度员指挥与监控系统频率调整,在保证电力系统安全运行的前提下,可以尽可能多的消纳清洁能源。目前电力系统已针对新能源的比例增高及电力负荷侧消耗电力多样性的特点,通过各类传感器收集来自源网荷储的数据,通过数据分析来更好的了解参与电力系统的参与者的状态。能够提前发现问题并能及时响应处理电力系统出现的异常故障以及减少调度员人为操作失误,仍然是电力系统调度的最主要的挑战。故如何有效的利用强化学习技术通过对电力系统的虚拟仿真来模拟真实环境,形成电力系统调度员的准确高效的调度策略,辅助电力调度员决策,避免调度失误造成的不良后果成为亟需解决的问题。

技术实现要素:

4.本发明的技术任务是提供一种基于强化学习的电力系统仿真调度方法及系统,来解决如何有效的利用强化学习技术通过对电力系统的虚拟仿真来模拟真实环境,形成电力系统调度员的准确高效的调度策略,辅助电力调度员决策,避免调度失误造成的不良后果的问题。

5.本发明的技术任务是按以下方式实现的,一种基于强化学习的电力系统仿真调度方法,该方法是通过电力系统云数据中心采集来自电力系统各参与电力系统单元的数据,利用数字孪生技术形成电力系统模拟仿真环境,并设计强化学习电力系统调度员决策模型π,再根据实际电力系统调度员的情况,采用a3c训练方法与电力系统仿真环境进行交互,最终形成最佳执行策略,最佳执行策略用于辅助电力系统调度员执行决策。

6.作为优选,所述电力系统模拟仿真环境运行在电力系统云数据中心,通过对于与各个参与电力系统单元的数据采集及指令控制,实现各个参与电力系统单元的数据孪生运行体;

7.电力系统云数据中心用于提供计算、存储及网络的云基础设施服务,并且运行电力系统的业务系统,手机来自各个参与电力系统单元的传感数据,同时提供强化学习训练所需的算力和存储。

8.作为优选,所述强化学习电力系统调度员决策模型π是模拟调度员的实际操作形成的策略模型,通过强化学习训练得到,主体为序列化神经网络模型,根据当前电力系统的电力计划、频率情况、电压情况及检修情况的实际运行情况决定电力系统调度员要执行的调度操作。

9.作为优选,强化学习电力系统调度员决策模型π的训练过程具体如下:

10.(1)、收集海量的电力系统运行数据,电力系统运行数包括来自电力系统参与单元的实时状态数据、电力系统运行日志、电力系统调度计划、电力系统故障数据、检修数据以及电力系统调度员调度执行数据的信息;

11.(2)、根据收集的电力系统运行历史数据,构建数字孪生系统,形成电力系统模拟仿真环境;

12.(3)、根据电力系统调度员实际操作,结合电力系统实际操作的上下文状态环境,构建电力系统调度员调度操作指令执行序列exeseq(状态s,操作指令a);

13.(4)、设计强化学习电力系统调度员决策模型π,根据当前电力计划、各参与电力系统单元运行状态、电网频率状况、电压状况、检修情况、事故异常事件及事故拉闸序位表的数据,确定下一步执行调度操作;

14.(5)、根据电力系统调度员调度操作,基于历史数据实际执行效果,结合在电力系统模拟仿真环境,设定电力系统模拟仿真环境的奖励函数;

15.(6)、在电力系统云数据中心申请资源,采用a3c算法训练强化学习电力系统调度员决策模型π,设定worker线程数量、全局共享迭代次数、全局最大迭代次数、状态特征维度及操作指令集的全局参数;

16.(7)、初始化强化学习电力系统调度员决策模型π,设定全局模型公共神经网络,设置电力系统虚拟仿真环境初始化状态s0;其中,全局模型公共神经网络包括actor网络和critic网络;

17.(8)、利用a3c算法,每个worker线程采用actor网络和critic网络结构(与全局模型公共神经网络一样的网络结构),独立与电力系统虚拟仿真环境进行交互,执行调度操作获得反馈,并更新本地actor网络和critic网络梯度;

18.(9)、将更新后的结果汇集到全局模型公共神经网络,更新全局模型公共神经网络的模型参数;

19.(10)、循环执行步骤(8)至步骤(9),直至强化学习电力系统调度员决策模型π收敛,得到最优的强化学习电力系统调度员决策模型π。

20.作为优选,最佳执行策略用于辅助电力系统调度员执行决策具体如下:

21.①

、利用已经构建的数字孪生系统实时采集当前电力系统的实际运行数据,并实时更新到电力系统虚拟仿真环境;

22.②

、利用强化学习训练得到的强化学习电力系统调度员决策模型π,根据当前实际状况,输出下一步调度操作;

23.③

、记录当前电力系统虚拟仿真环境状态,强化学习电力系统调度员决策模型π推荐的下一步操作,反馈更新电力系统虚拟仿真环境;

24.④

、设定时间段,重复执行步骤

②

至步骤

③

,形成电力系统调度员推荐操作序列,用于辅助决策;

25.⑤

、电力系统调度操作员根据推荐操作,结合实际状况进行调度操作;

26.⑥

、电力系统获取实际操作结果,更新当前电力系统的实际运行数据,并实时更新到电力系统虚拟仿真环境,转到步骤

②

;

27.⑦

、持续更新运行状态,输出辅助推荐操作。

28.作为优选,强化学习电力系统调度员决策模型π的优化过程具体如下:

29.(一)、利用电力系统模拟仿真环境,针对实际每一位电力系统调度员的实际操作,采用强化学习方法训练其个性化强化学习电力系统调度员决策模型;

30.(二)、将电力系统调度员的个性化强化学习电力系统调度员决策模型作为模拟调度员,与电力系统模拟仿真环境进行持续交互,模拟电力系统运行和调度;

31.(三)、评价电力系统调度员个性化强化学习电力系统调度员决策模型的调度结果,并与最佳调度指令执行策略对比,发现其中的调度问题,进而改善调度策略;

32.(四)、根据实际排班情况,在电力系统模拟仿真环境下,模拟全部调度员的调度操作,并与最佳调度指令执行策略对比,发现异常环节,优化调度方式;

33.(五)、根据未来实际排班情况,在电力系统模拟仿真环境下,结合电力系统实际数据,模拟未来时刻电力系统运行和调度,提前发现问题,避免事故发生;

34.(六)、持续收集来自实际电力系统运行及调度的数据,用于优化强化学习电力系统调度员决策模型。

35.作为优选,所述参与电力系统单元包括发电系统、输电配电网以及用电负荷;

36.其中,发电系统用于产生电力,包括风力发电、光伏发电、水利发电及核电的清洁能源以及传统的火力发电的化石燃料发电;

37.输电配电网用于保证电力的安全传输;

38.用电负荷指电力的消耗,电力的消耗包括工业负荷、居民负荷、商业负荷。

39.更优地,所述电力系统调度操作包括设定机组出力的上限和下限、设定机组长落出力速度的调整发电机组出力设置以及调整修改电力计划、事故拉闸限电、倒闸操作和设备检修的操作。

40.一种基于强化学习的电力系统仿真调度系统,该系统包括,

41.电力系统云数据中心,用于提供计算、存储及网络的云基础设施服务,并且运行电力系统的业务系统,收集来自各个参与电力系统单元的传感数据,并提供强化学习训练所需的算力及存储;

42.强化学习电力系统调度员决策模型π,用于通过通过强化学习训练得到,主体是序列化神经网络模型,根据当前电力系统实际运行情况,决定电力系统调度员要执行的调度操作;其中,当前电力系统实际运行情况包括电力计划、频率情况、电压情况及检修情况;

43.电力系统仿真模拟环境,用于运行在电力系统云数据中心,通过对于各个参与电

力系统单元的数据采集及指令控制,实现各个参与电力系统单元的数字孪生运行体。

44.作为优选,强化学习电力系统调度员决策模型π的训练过程具体如下:

45.(1)、收集海量的电力系统运行数据,电力系统运行数包括来自电力系统参与单元的实时状态数据、电力系统运行日志、电力系统调度计划、电力系统故障数据、检修数据以及电力系统调度员调度执行数据的信息;

46.(2)、根据收集的电力系统运行历史数据,构建数字孪生系统,形成电力系统模拟仿真环境;

47.(3)、根据电力系统调度员实际操作,结合电力系统实际操作的上下文状态环境,构建电力系统调度员调度操作指令执行序列exeseq(状态s,操作指令a);

48.(4)、设计强化学习电力系统调度员决策模型π,根据当前电力计划、各参与电力系统单元运行状态、电网频率状况、电压状况、检修情况、事故异常事件及事故拉闸序位表的数据,确定下一步执行调度操作;

49.(5)、根据电力系统调度员调度操作,基于历史数据实际执行效果,结合在电力系统模拟仿真环境,设定电力系统模拟仿真环境的奖励函数;

50.(6)、在电力系统云数据中心申请资源,采用a3c算法训练强化学习电力系统调度员决策模型π,设定worker线程数量、全局共享迭代次数、全局最大迭代次数、状态特征维度及操作指令集的全局参数;

51.(7)、初始化强化学习电力系统调度员决策模型π,设定全局模型公共神经网络,设置电力系统虚拟仿真环境初始化状态s0;其中,全局模型公共神经网络包括actor网络和critic网络;

52.(8)、利用a3c算法,每个worker线程采用actor网络和critic网络结构(与全局模型公共神经网络一样的网络结构),独立与电力系统虚拟仿真环境进行交互,执行调度操作获得反馈,并更新本地actor网络和critic网络梯度;

53.(9)、将更新后的结果汇集到全局模型公共神经网络,更新全局模型公共神经网络的模型参数;

54.(10)、循环执行步骤(8)至步骤(9),直至强化学习电力系统调度员决策模型π收敛,得到最优的强化学习电力系统调度员决策模型π;

55.强化学习电力系统调度员决策模型π的优化过程具体如下:

56.(一)、利用电力系统模拟仿真环境,针对实际每一位电力系统调度员的实际操作,采用强化学习方法训练其个性化强化学习电力系统调度员决策模型;

57.(二)、将电力系统调度员的个性化强化学习电力系统调度员决策模型作为模拟调度员,与电力系统模拟仿真环境进行持续交互,模拟电力系统运行和调度;

58.(三)、评价电力系统调度员个性化强化学习电力系统调度员决策模型的调度结果,并与最佳调度指令执行策略对比,发现其中的调度问题,进而改善调度策略;

59.(四)、根据实际排班情况,在电力系统模拟仿真环境下,模拟全部调度员的调度操作,并与最佳调度指令执行策略对比,发现异常环节,优化调度方式;

60.(五)、根据未来实际排班情况,在电力系统模拟仿真环境下,结合电力系统实际数据,模拟未来时刻电力系统运行和调度,提前发现问题,避免事故发生;

61.(六)、持续收集来自实际电力系统运行及调度的数据,用于优化强化学习电力系

统调度员决策模型。

62.本发明的基于强化学习的电力系统仿真调度方法及系统具有以下优点:

63.(一)本发明充分考虑到分布式清洁能源的消纳给电力系统安全运行带来的挑战以及电力系统调度员的人为操作影响,通过大量传感设备来收集电力系统数据,基于海量数据利用数字孪生技术形成仿真环境,设计强化学习电力系统调度员决策模型,并根据实际电力系统调度员的情况,采用a3c训练方法与仿真环境进行交互,最终形成最佳执行策略,用于辅助电力系统调度员决策执行,尽量消除人为操作失误带来的影响,提升调度效率及准确度;

64.(二)本发明与传统的基于电力系统特性的数学模拟调度相比,采用强化学习训练形成的强化学习电力系统调度员决策模型,能够更加真实的模拟现实电力系统调度员个性化的操作,进而更好的模拟现实环境操作,更加准确的发现调度存在的问题,进而改善调度策略;

65.(三)本发明通过对于真实电力系统调度员的模拟,并与最佳调度指令执行策略对比,及时发现电力系统调度员调度问题,持续改善和优化调度策略,保证电网的安全运行。

附图说明

66.下面结合附图对本发明进一步说明。

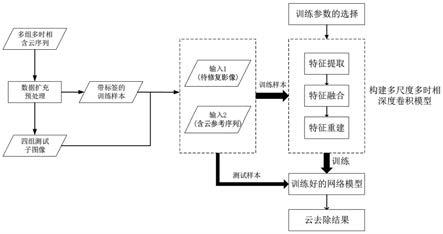

67.附图1为电力系统及电力系统模拟仿真环境的组成示意图。

具体实施方式

68.参照说明书附图和具体实施例对本发明的基于强化学习的电力系统仿真调度方法及系统作以下详细地说明。

69.实施例1:

70.本发明的基于强化学习的电力系统仿真调度方法,该方法是通过电力系统云数据中心采集来自电力系统各参与电力系统单元的数据,利用数字孪生技术形成电力系统模拟仿真环境,并设计强化学习电力系统调度员决策模型π,再根据实际电力系统调度员的情况,采用a3c训练方法与电力系统仿真环境进行交互,最终形成最佳执行策略,最佳执行策略用于辅助电力系统调度员执行决策。

71.如附图1所示,本实施例中的参与电力系统单元包括发电系统、输电配电网以及用电负荷;其中,发电系统用于产生电力,包括风力发电、光伏发电、水利发电及核电的清洁能源以及传统的火力发电的化石燃料发电;输电配电网用于保证电力的安全传输;用电负荷指电力的消耗,电力的消耗包括工业负荷、居民负荷、商业负荷。

72.本实施例中的电力系统模拟仿真环境运行在电力系统云数据中心,通过对于与各个参与电力系统单元的数据采集及指令控制,实现各个参与电力系统单元的数据孪生运行体;

73.本实施例中的电力系统云数据中心用于提供计算、存储及网络的云基础设施服务,并且运行电力系统的业务系统,手机来自各个参与电力系统单元的传感数据,同时提供强化学习训练所需的算力和存储。

74.本实施例中的强化学习电力系统调度员决策模型π是模拟调度员的实际操作形成

的策略模型,通过强化学习训练得到,主体为序列化神经网络模型,根据当前电力系统的电力计划、频率情况、电压情况及检修情况的实际运行情况决定电力系统调度员要执行的调度操作。

75.本实施例中的电力系统调度操作包括设定机组出力的上限和下限、设定机组长落出力速度的调整发电机组出力设置以及调整修改电力计划、事故拉闸限电、倒闸操作和设备检修的操作。

76.本实施例中的强化学习电力系统调度员决策模型π的训练过程具体如下:

77.(1)、收集海量的电力系统运行数据,电力系统运行数包括来自电力系统参与单元的实时状态数据、电力系统运行日志、电力系统调度计划、电力系统故障数据、检修数据以及电力系统调度员调度执行数据的信息;

78.(2)、根据收集的电力系统运行历史数据,构建数字孪生系统,形成电力系统模拟仿真环境;

79.(3)、根据电力系统调度员实际操作,结合电力系统实际操作的上下文状态环境,构建电力系统调度员调度操作指令执行序列exeseq(状态s,操作指令a);

80.(4)、设计强化学习电力系统调度员决策模型π,根据当前电力计划、各参与电力系统单元运行状态、电网频率状况、电压状况、检修情况、事故异常事件及事故拉闸序位表的数据,确定下一步执行调度操作;

81.(5)、根据电力系统调度员调度操作,基于历史数据实际执行效果,结合在电力系统模拟仿真环境,设定电力系统模拟仿真环境的奖励函数;

82.(6)、在电力系统云数据中心申请资源,采用a3c算法训练强化学习电力系统调度员决策模型π,设定worker线程数量、全局共享迭代次数、全局最大迭代次数、状态特征维度及操作指令集的全局参数;

83.(7)、初始化强化学习电力系统调度员决策模型π,设定全局模型公共神经网络,设置电力系统虚拟仿真环境初始化状态s0;其中,全局模型公共神经网络包括actor网络和critic网络;

84.(8)、利用a3c算法,每个worker线程采用actor网络和critic网络结构(与全局模型公共神经网络一样的网络结构),独立与电力系统虚拟仿真环境进行交互,执行调度操作获得反馈,并更新本地actor网络和critic网络梯度;

85.(9)、将更新后的结果汇集到全局模型公共神经网络,更新全局模型公共神经网络的模型参数;

86.(10)、循环执行步骤(8)至步骤(9),直至强化学习电力系统调度员决策模型π收敛,得到最优的强化学习电力系统调度员决策模型π。

87.本实施例中的最佳执行策略用于辅助电力系统调度员执行决策具体如下:

88.①

、利用已经构建的数字孪生系统实时采集当前电力系统的实际运行数据,并实时更新到电力系统虚拟仿真环境;

89.②

、利用强化学习训练得到的强化学习电力系统调度员决策模型π,根据当前实际状况,输出下一步调度操作;

90.③

、记录当前电力系统虚拟仿真环境状态,强化学习电力系统调度员决策模型π推荐的下一步操作,反馈更新电力系统虚拟仿真环境;

91.④

、设定时间段,重复执行步骤

②

至步骤

③

,形成电力系统调度员推荐操作序列,用于辅助决策;

92.⑤

、电力系统调度操作员根据推荐操作,结合实际状况进行调度操作;

93.⑥

、电力系统获取实际操作结果,更新当前电力系统的实际运行数据,并实时更新到电力系统虚拟仿真环境,转到步骤

②

;

94.⑦

、持续更新运行状态,输出辅助推荐操作。

95.本实施例中的强化学习电力系统调度员决策模型π的优化过程具体如下:

96.(一)、利用电力系统模拟仿真环境,针对实际每一位电力系统调度员的实际操作,采用强化学习方法训练其个性化强化学习电力系统调度员决策模型;

97.(二)、将电力系统调度员的个性化强化学习电力系统调度员决策模型作为模拟调度员,与电力系统模拟仿真环境进行持续交互,模拟电力系统运行和调度;

98.(三)、评价电力系统调度员个性化强化学习电力系统调度员决策模型的调度结果,并与最佳调度指令执行策略对比,发现其中的调度问题,进而改善调度策略;

99.(四)、根据实际排班情况,在电力系统模拟仿真环境下,模拟全部调度员的调度操作,并与最佳调度指令执行策略对比,发现异常环节,优化调度方式;

100.(五)、根据未来实际排班情况,在电力系统模拟仿真环境下,结合电力系统实际数据,模拟未来时刻电力系统运行和调度,提前发现问题,避免事故发生;

101.(六)、持续收集来自实际电力系统运行及调度的数据,用于优化强化学习电力系统调度员决策模型。

102.实施例2:

103.本发明的基于强化学习的电力系统仿真调度系统,该系统包括,

104.电力系统云数据中心,用于提供计算、存储及网络的云基础设施服务,并且运行电力系统的业务系统,收集来自各个参与电力系统单元的传感数据,并提供强化学习训练所需的算力及存储;

105.强化学习电力系统调度员决策模型π,用于通过通过强化学习训练得到,主体是序列化神经网络模型,根据当前电力系统实际运行情况,决定电力系统调度员要执行的调度操作;其中,当前电力系统实际运行情况包括电力计划、频率情况、电压情况及检修情况;

106.电力系统仿真模拟环境,用于运行在电力系统云数据中心,通过对于各个参与电力系统单元的数据采集及指令控制,实现各个参与电力系统单元的数字孪生运行体。

107.本实施例中的强化学习电力系统调度员决策模型π的训练过程具体如下:

108.(1)、收集海量的电力系统运行数据,电力系统运行数包括来自电力系统参与单元的实时状态数据、电力系统运行日志、电力系统调度计划、电力系统故障数据、检修数据以及电力系统调度员调度执行数据的信息;

109.(2)、根据收集的电力系统运行历史数据,构建数字孪生系统,形成电力系统模拟仿真环境;

110.(3)、根据电力系统调度员实际操作,结合电力系统实际操作的上下文状态环境,构建电力系统调度员调度操作指令执行序列exeseq(状态s,操作指令a);

111.(4)、设计强化学习电力系统调度员决策模型π,根据当前电力计划、各参与电力系统单元运行状态、电网频率状况、电压状况、检修情况、事故异常事件及事故拉闸序位表的

数据,确定下一步执行调度操作;

112.(5)、根据电力系统调度员调度操作,基于历史数据实际执行效果,结合在电力系统模拟仿真环境,设定电力系统模拟仿真环境的奖励函数;

113.(6)、在电力系统云数据中心申请资源,采用a3c算法训练强化学习电力系统调度员决策模型π,设定worker线程数量、全局共享迭代次数、全局最大迭代次数、状态特征维度及操作指令集的全局参数;

114.(7)、初始化强化学习电力系统调度员决策模型π,设定全局模型公共神经网络,设置电力系统虚拟仿真环境初始化状态s0;其中,全局模型公共神经网络包括actor网络和critic网络;

115.(8)、利用a3c算法,每个worker线程采用actor网络和critic网络结构(与全局模型公共神经网络一样的网络结构),独立与电力系统虚拟仿真环境进行交互,执行调度操作获得反馈,并更新本地actor网络和critic网络梯度;

116.(9)、将更新后的结果汇集到全局模型公共神经网络,更新全局模型公共神经网络的模型参数;

117.(10)、循环执行步骤(8)至步骤(9),直至强化学习电力系统调度员决策模型π收敛,得到最优的强化学习电力系统调度员决策模型π;

118.本实施例中的强化学习电力系统调度员决策模型π的优化过程具体如下:

119.(一)、利用电力系统模拟仿真环境,针对实际每一位电力系统调度员的实际操作,采用强化学习方法训练其个性化强化学习电力系统调度员决策模型;

120.(二)、将电力系统调度员的个性化强化学习电力系统调度员决策模型作为模拟调度员,与电力系统模拟仿真环境进行持续交互,模拟电力系统运行和调度;

121.(三)、评价电力系统调度员个性化强化学习电力系统调度员决策模型的调度结果,并与最佳调度指令执行策略对比,发现其中的调度问题,进而改善调度策略;

122.(四)、根据实际排班情况,在电力系统模拟仿真环境下,模拟全部调度员的调度操作,并与最佳调度指令执行策略对比,发现异常环节,优化调度方式;

123.(五)、根据未来实际排班情况,在电力系统模拟仿真环境下,结合电力系统实际数据,模拟未来时刻电力系统运行和调度,提前发现问题,避免事故发生;

124.(六)、持续收集来自实际电力系统运行及调度的数据,用于优化强化学习电力系统调度员决策模型。

125.最后应说明的是:以上各实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述各实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分或者全部技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。