一种基于agv及机器视觉进行工件自动上下料系统及方法

发明领域

1.本发明涉及智能制造、自动化控制和智能机器人技术领域,更具体地说,涉及一种基于agv底盘及机器视觉进行工件上下料的物流系统。

背景技术:

2.目前,在智能数字工厂中,物料的定点抓取、摆放等工作,主要依赖于agv导航定位技术及串联机器人视觉补偿技术,使不同种类的机器人进行协作,完成作业流程。

3.现有的系统对工件的抓取运输,决定了工业机器人的应用效率和可靠性,目前主要有在线示教、离线编程和基于视觉技术等三种方法,示教和离线编程对工件进行定位,需要设计、制造、安装精度高的工装定位装置,设计较复杂,抓取率低,同时也增加了成本和生产周期。现有的轮廓检测方法,常会得到孤立的、小段连续的非目标轮廓,干扰工件轮廓的准确检测,降低检测效率和正确性,同时,采用传统的主轴法获取工件位置矢量数据后,还要考虑工件的夹持方向,给机器人末端带来不便,甚至干涉影响整体的上下料及运输效率。

4.鉴于此,有必要提供一种新型基于agv底盘及机器视觉进行工件上下料的系统及方法来解决问题。

技术实现要素:

5.本发明要解决的技术问题在于,针对现有技术中工业机器人定位抓取工件存在效率低、准确性差等缺点,本发明提供一种基于agv底盘及机器视觉进行工件上下料系统和方法。

6.一种基于agv及机器视觉进行工件自动上下料系统,包括agv本体1,agv本体1包括agv底盘11和agv控制器12,agv控制器12安装在agv底盘1内,其特征在于,在agv底盘11安装有夹持系统3、视觉系统4和控制系统2,控制系统2安装在agv底盘11上部,夹持系统3安装在控制系统2上,夹持系统3包括协作机器人31和机械手臂32,机械手臂32安装在协作机器人31端头;在协作机器人31端头上还安装有视觉系统4,视觉系统4包括视觉系统模块41和相机42,视觉系统模块41与相机42电路连接,视觉系统模块41又与控制系统2连接,所述的控制系统2包括plc、人机交互界面22。

7.控制系统2上还设有应急开关21。

8.一种基于agv及机器视觉进行工件自动上下料方法,其特征在于,包括视觉系统标定和执行运输过程,具体步骤如下:

9.视觉系统标定

10.步骤一:物料的准备和路径规划

11.将待拾取的工件物料放在一个托盘中,即作为物料仓,此步为上下料前准备工作;同时将agv本体的路径通过roboshopr规划完成;

12.步骤二:视觉系统4的标定

13.在完成视觉系统搭建的基础上,要对视觉系统4标定,标定步骤如下:

14.1)对相机进行标定,采用张正友标定法,获得相机内外参数和镜头畸变参数;

15.2)对视觉系统与机械臂进行手眼标定,采用九点标定法,获得相机坐标系与机器人坐标系间的转换关系。

16.步骤三:目标识别算法搭建

17.目标识别算法:分为两步骤;粗提取和精提取;

18.1)目标粗提取,采用yolo_v3神经网络对目标进行粗提取,具体流程如下:具体对待识别的三类工件进行样本图像采集,将三类工件按照乱序放置,改变其相对位置,共采集500张图像,其中400张图像作为训练图像,剩余100张图像作为测试图像。为了提高深度学习模型的识别鲁棒性,将训练图像进行分割、旋转、增加噪声等操作,将训练图像扩增到1000张,对训练图像进行人工标注,将图像中的三类目标工件分别进行框选,并命名为3种不同名称。利用darknet深度学习框架搭建yolo_v3神经网络,设定初始训练参数,将1000张已标注的训练图像输入yolo_v3神经网络中进行训练,直至网络收敛,获得训练好的神经网络模型。将100张测试图像输入神经网络模型进行预测,统计识别准确率,若识别准确率符合要求,则完成神经网络模型的搭建,否则修改训练参数,继续训练,重复以上步骤,直至识别准确率符合要求。

19.2)目标精提取,通过目标粗提取将识别到的不同工件进行框选,将框选区域作为目标区域,再利用阈值分割的方法对各个工件目标区域进行目标精提取,准确提取工件轮廓,并对轮廓形心进行拟合,最终获取工件准确位置。

20.步骤四:工件识别准确率验证

21.对工件图像进行获取,构建样本数据集,通过数据集训练卷积神经网络,使用训练后的模型进行图像分析处理,进行工件识别分类,由此完成工件识别检测算法的开发。构建工件识别测试集,使用训练好的神经网络模型进行识别测试。对识别结果准确率进行统计,并根据技术指标判断是否符合要求。

22.步骤五:工件拾取运输

23.将识别框选好的工件的目标位置和特征,得到工件的矢量信息,进行笛卡尔与关节坐标变换,然后反馈给夹持系统的夹持机构去抓取完成相关的执行动作。拾取之后,控制系统通过信号传输给agv,进行不同工位间移动,具体过程如下,

24.a.agv底盘11到达指定上下料位置,agv底盘11内的agv控制器12将位置到达信号发送给控制系统2的plc;

25.b.控制系统2的plc获得agv控制器12的指令后,通过以太网通讯协议将拍照指令发送给视觉系统模块41;

26.c.视觉系统模块41接收到指令后,视觉系统模块41让相机42采集图像采集,获取当前工件图像;

27.d.视觉系统模块41获取图像后,执行目标识别算法,识别图像中的工件特征,对其进行分类及定位;

28.e.视觉系统模块41将图像信息、工件种类和位置发送给控制系统2的plc;

29.f.控制系统2的plc接收到图像信息数据后,将数据反馈给机械臂32;

30.g.机械臂32收到数据后,执行对工件的抓取操作;

31.h.抓取完毕后,机械臂32发送抓取完成指令给控制系统2的plc;

32.i.控制系统2的plc收到指令后,将指令反馈给agv控制器12,agv控制器12控制agv底盘11完成运动指令,输送工件。

33.机器视觉技术使用工业机器人来代替人眼进行操作,减少人工操作带来的误差,视觉技术可以实现短时间内获取信息和自动处理,将视觉技术结合到制造业生产过程中,不但可以提升生产过程中的工作效率,而且可以取代人力生产的步骤。机器视觉对工业生产过程中的自动化程度给予了很大的帮助,未来将大规模地应用在生产流水线上。机器视觉通过代替人眼来采集图像信息,完成目标识别或轨迹执行,可连续稳定高效工作,同时也有助于实现分拣、搬运和监控等功能的统一管理,提高生产车间信息化水平。

附图说明

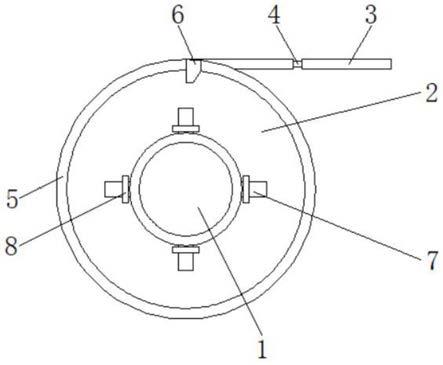

34.图1、本发明工作原理图;

35.图2、本发明结构示意图;

36.图3、本发明实施例结构示意图。

具体实施方式

37.本发明为达到上述目的所采用的技术方案为:一种基于agv底盘及机器视觉进行工件上下料系统,包括以下视觉系统的标定和工件拾取运输,具体为,

38.视觉系统的标定

39.步骤一:物料的准备

40.将待拾取的工件物料放在一个托盘中,即作为物料仓,此步为上下料前准备工作。同时将agv本体的路径通过roboshopr规划完成。

41.步骤二:视觉系统的标定

42.在完成视觉系统搭建的基础上,要对视觉系统标定,标定步骤如下:

43.1.对相机进行标定,采用张正友标定法,获得相机内外参数和镜头畸变参数;

44.3.对视觉系统与机械臂进行手眼标定,采用九点标定法,获得相机坐标系与机器人坐标系间的转换关系。

45.步骤三:目标识别算法搭建

46.目标识别算法:分为两步骤;粗提取和精提取;

47.1.目标粗提取,采用yolo_v3神经网络对目标进行粗提取,具体流程如下:具体对待识别的三类工件进行样本图像采集,将三类工件按照乱序放置,改变其相对位置,共采集500张图像,其中400张图像作为训练图像,剩余100张图像作为测试图像。为了提高深度学习模型的识别鲁棒性,将训练图像进行分割、旋转、增加噪声等操作,将训练图像扩增到1000张,对训练图像进行人工标注,将图像中的三类目标工件分别进行框选,并命名为3种不同名称。利用darknet深度学习框架搭建yolo_v3神经网络,设定初始训练参数,将1000张已标注的训练图像输入yolo_v3神经网络中进行训练,直至网络收敛,获得训练好的神经网络模型。将100张测试图像输入神经网络模型进行预测,统计识别准确率,若识别准确率符合要求,则完成神经网络模型的搭建,否则修改训练参数,继续训练,重复以上步骤,直至识别准确率符合要求。

48.2.目标精提取。通过目标粗提取将识别到的不同工件进行框选,将框选区域作为

目标区域,再利用阈值分割的方法对各个工件目标区域进行目标精提取,准确提取工件轮廓,并对轮廓形心进行拟合,最终获取工件准确位置。

49.步骤四:工件识别准确率验证

50.对工件图像进行获取,构建样本数据集,通过数据集训练卷积神经网络,使用训练后的模型进行图像分析处理,进行工件识别分类,由此完成工件识别检测算法的开发。构建工件识别测试集,使用训练好的神经网络模型进行识别测试。对识别结果准确率进行统计,并根据技术指标判断是否符合要求。

51.步骤五:工件拾取运输

52.将识别框选好的工件的目标位置和特征,得到工件的矢量信息,进行笛卡尔与关节坐标变换,然后反馈给夹持系统的夹持机构去抓取完成相关的执行动作。拾取之后,控制系统通过信号传输给agv,进行不同工位间移动。

53.1.agv到达指定上下料位置,agv将位置到达信号发送给plc(可编程逻辑控制器);

54.2.plc获得agv的指令后,通过以太网通讯协议将拍照指令发送给视觉系统;

55.3.视觉系统接收到指令后,执行图像采集功能,获取当前工件图像;

56.4.视觉系统获取图像后,执行目标识别算法,识别图像中的工件特征,对其进行分类及定位;

57.5.视觉系统将图像信息(包括工件种类,位置坐标)发送给plc系统;

58.6.plc系统接收到图像信息数据后,将数据反馈给机械臂;

59.7.机械臂收到数据后,执行对工件的抓取操作;

60.8.抓取完毕后,机械臂发送抓取完成指令给plc;

61.9.plc收到指令后,将指令反馈给agv底盘,执行运输功能;

62.所述机器人控制系统包括以下步骤:

63.1)控制agv本体运输;

64.2)与视觉系统实时通讯,控制视觉系统采集图像;

65.3)控制机械臂执行动作。

66.一种基于agv底盘及机器视觉进行工件上下料的物流系统,集成agv移动机器人和通用工业机器人两项功能为一体式的物流运输系统。系统可以进行搬运和码垛等作业。在工业领域,通用协作机器人搭配自主研发视觉系统,替代人的胳膊和眼睛实现物料的抓取和分拣功能,而agv移动机器人则是替代人腿脚行走的功能。其特征在于包括以下系统:控制系统、夹持系统、视觉系统、agv本体4个单元:

67.1)其中所述控制系统主要负责对其他3个模块进行系统控制和信息处理及交互;

68.2)所述夹持系统负责搬运过程中的物料夹持;

69.3)所述agv本体负责搬运过程中的物料转移;

70.4)所述视觉系统模块,用于对工件进行识别、定位及分类,实时将物料信息反馈给机械臂。用于捕捉工位环境并根据所述车体的运动数据,获取物料的即时摆放位置,校正所述机械臂在所述工位处的抓取动作。

71.所述物流系统机器人为工业机器人或者agv本体机器人,所述系统包含至少一个所述的机器人且具有充电功能。

72.所述视觉系统采用基于slam进行地图规划;本组对视觉系统进行软件开发,软件

具备以下功能:

73.1)与plc的实时通讯功能;

74.2)图像自动采集功能;通过接收plc指令,软件自动控制相机硬件实现图像采集;

75.3)目标实时定位功能;本软件内置目标识别算法,实现对多个目标零部件的识别与分类,进而对零部件位置进行定位;

76.4)坐标系转换功能;利用张正友标定法实现相机标定,获得相机内参(包括相机主点位置、相机焦距、畸变参数),根据相机内参,对图像进行畸变矫正;利用九点标定法,实现对视觉系统与机械臂系统的坐标系转换,将图像中任意像素点转换到机械臂坐标系下。

77.一种基于agv底盘及机器视觉进行工件上下料的系统,其特征在于,所述agv本体系统采用视觉系统与物流小车通过以太网连接,基于tcp/ip通讯协议实现视觉系统与plc的通讯,从而完整实现达到点位后图像采集、调用深度学习模型识别定位工件、将坐标信息反馈给系统、执行抓取操作。通过传感对于环境的监测信息,获取环境中障碍物及工位的分布,并动态捕捉工作环境中移动个体的数量及运动状态信息,对所述车体与环境进行建模与实时修正适配,通过对于当前车速、运动方向向量及期望轨迹的分析,解算出最优化的抓取位置及对应的机器人姿态,进行协同规划。

78.所述机械臂夹持系统采用外购件夹具,通过设计工装,使得夹具和相机、光源和机械臂耦合在一起。

79.本发明涉及一种工业机器人的视觉识别、夹取、转运方法的系统及方法。所述系统包括agv底盘、夹持系统、视觉系统及控制系统。所述视觉执行系统连接在协作机械臂末端进行图像采集识别,所述机器人控制系统对图像进行处理进而反馈给机械臂实现抓取动作。最后通过agv小车进行物料工件在不同工位的运输。本发明的一种自动上下料系统,具有抓取精度高,工作效率高等优点。

80.机器人根据工件位置矢量信息,进行笛卡尔与关节坐标变换,通过控制系统反馈,机械爪具对工件进行定位抓取。

81.所述视觉系统与物流小车通过以太网连接,基于tcp/ip通讯协议实现视觉系统与plc的通讯,从而完整实现达到点位后图像采集、调用深度学习模型识别定位工件、将坐标信息反馈给系统、执行抓取操作。抓取完成后,由agv运输到指定的工位上。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。