1.本技术涉及计算机图形图像处理技术,尤其涉及一种多视频流融合方法、电子设备、存储介质。

背景技术:

2.在视频监控、工业控制、数字孪生等领域,一个摄像头传感器采集的画幅有限,展示出来的视野范围较小,为了获得更大的视野范围以及提高用户对于摄像头传感器采集场景的画面的真实体验感,人们提出了将多个摄像头传感器采集的内容进行拼接并进行虚拟现实视频(简称3d视频)展示的方法,即视频融合技术。以监控视频展示为例,在同一个场景内的不同位置安装有摄像头传感器对准该场景进行监控,可以将每个摄像头传感器采集的内容进行拼接并将二维视频投影到三维,得到一个更大视野的3d视频,然后再进行展示。

3.视频融合技术是指将多个视频流融合到一个三维的全景场景模型中,视频融合技术的本质是对各个视频流的每一帧的图片内容进行拼接。现有的视频融合技术大多是在三维空间中以二维图像拼接技术为基础,实现多视频流的融合,得到虚拟现实视频(简称3d视频)。

4.然而,对于二维图像拼接技术,在待拼接图像间存在较大深度变化或者图像的空间位置不符合单应关系时,现有的二维图像拼接技术无法实现待拼接图像重叠区域的对准,使得拼接效果较差,有时甚至无法拼接。受限制于二维图像拼接技术的缺陷,现有的视频融合技术在实现分散部署的摄像头传感器采集的多视频流的虚拟现实视频融合时,融合真实感效果较差。

技术实现要素:

5.本技术提供一种多视频流融合方法、电子设备、存储介质,以克服分散部署的摄像头传感器采集的多视频流的虚拟现实视频融合真实感效果较差的问题。

6.第一方面,本技术提供一种多视频流融合方法,包括:

7.基于各摄像头传感器采集的对应区域的视频流,以及,所述场景的地面图像,获取各区域在同一三维空间下的待拼接模型,所述待拼接模型用于表征对应区域的三维场景结构;

8.通过各相邻区域的待拼接模型的纹理图像,对各区域的待拼接模型的纹理图像进行变形,获得各区域的待拼接模型变形后的纹理图像,以及,各区域的待拼接模型的矫正映射文件;

9.基于各相邻区域的待拼接模型在各相邻区域的待拼接模型之间的虚拟视点的成像内容,获取各相邻区域的待拼接模型的融合掩码;

10.根据各区域的待拼接模型变形后的纹理图像、各相邻区域的待拼接模型的融合掩码,在所述三维空间下的对各区域的待拼接模型进行拼接,得到三维场景模型;

11.根据所述矫正映射文件、所述融合掩码,将各摄像头传感器采集的对应区域的视

频流融合到所述三维场景模型,得到所述场景的三维虚拟现实视频。

12.可选的,所述通过各相邻区域的待拼接模型的纹理图像,对各区域的待拼接模型的纹理图像进行变形,获得各区域的待拼接模型变形后的纹理图像,以及,各区域的待拼接模型的矫正映射文件,包括:

13.基于各相邻区域的待拼接模型的纹理图像,获取各相邻区域的待拼接模型之间的匹配特征点对,所述匹配特征点对的残差小于预设像素值;

14.基于各相邻区域的待拼接模型的匹配特征点对在所述三维空间中的三维坐标,以及,各相邻区域的待拼接模型的权重,得到各相邻区域的待拼接模型的匹配特征点对的插值点的三维坐标,所述待拼接模型的权重与所述待拼接模型与三维空间中心的距离负相关;

15.将各相邻区域的待拼接模型的匹配特征点对的插值点反投影至各相邻区域的待拼接模型的纹理图像,得到各区域的待拼接模型的纹理图像的控制点集;

16.利用各区域的待拼接模型的纹理图像的控制点集,对各区域的待拼接模型的纹理图像进行基于网格的图像变形,获得各区域的待拼接模型变形后的纹理图像;

17.根据各区域的待拼接模型变形前后的纹理图像的像素映射关系,生成所述待拼接模型的矫正映射文件。

18.可选的,所述基于各相邻区域的待拼接模型的纹理图像,获取各相邻区域的待拼接模型之间的匹配特征点对,包括:

19.基于相邻区域的待拼接模型的纹理图像,获取相邻区域的待拼接模型之间的初始特征点对;

20.将所述待拼接模型的面片结构投影至所述待拼接模型的纹理图像上,得到所述纹理图像的平面划分结果;

21.基于所述纹理图像的平面划分结果,将所述纹理图像上位于同一平面区域内的初始特征点划分至同一特征点集合中;

22.去除各特征点集合中满足预设条件的初始特征点所在的初始特征点对,得到相邻区域的待拼接模型的匹配特征点对,所述预设条件为所述初始特征点所在的特征点对的残差大于或等于第一预设阈值。

23.可选的,所述利用各区域的待拼接模型的纹理图像的控制点集,对各区域的待拼接模型的纹理图像进行基于网格的图像变形,获得各区域的待拼接模型变形后的纹理图像,并生成各区域的待拼接模型的矫正映射文件,包括:

24.为所述待拼接模型的纹理图像添加初始网格;

25.利用所述待拼接模型的纹理图像的控制点集作为约束条件、使用以网格顶点集合作为自变量的目标函数,对所述初始网格进行优化,得到所述待拼接模型的纹理图像的最优网格;

26.根据所述待拼接模型的纹理图像的初始网格与最优网格之间的对应关系,得到所述待拼接模型的纹理图像的仿射矩阵;

27.使用所述待拼接模型的纹理图像的仿射矩阵,对所述待拼接模型的纹理图像进行变形,得到所述待拼接模型变形后的纹理图像。

28.可选的,所述目标函数包括下述约束项:约束控制点变换到所述控制点对应的匹

配特征点的对准约束项、约束相邻网格的相对位置关系保持不变的相似变换约束项、约束所述待拼接模型的纹理图像变换前后相对尺度保持不变的尺度约束项、约束所述待拼接模型的纹理图像变换前后直线保持不变的直线约束项。

29.可选的,所述基于各相邻区域的待拼接模型在各相邻区域的待拼接模型之间的虚拟视点的成像内容,获取各相邻区域的待拼接模型的融合掩码,包括:

30.针对相邻区域的待拼接模型在虚拟视点的成像内容,计算成像内容的重叠区域的对准误差和颜色差异;

31.基于所述重叠区域的对准误差和颜色差异,得到所述重叠区域的差异图,以及,代价函数;

32.在所述差异图上使用图割算法,获取累积代价函数最小的缝合线;

33.对所述缝合线的两侧进行双线性插值后,反投影到相邻区域的待拼接模型上,得到相邻区域的待拼接模型的融合掩码。

34.可选的,所述根据各区域的待拼接模型变形后的纹理图像、各相邻区域的待拼接模型的融合掩码,在所述三维空间下的对各区域的待拼接模型进行拼接,得到三维场景模型,包括:

35.在所述三维空间下,使用所述各相邻区域的待拼接模型的融合掩码,对所述各区域的待拼接模型变形后的纹理图像进行拼接,得到所述三维场景模型。

36.可选的,所述根据所述矫正映射文件、所述融合掩码,将各摄像头传感器采集的对应区域的视频流融合到所述三维场景模型,得到所述场景的三维虚拟现实视频,包括:

37.将各区域的视频流映射至所述三维场景模型;

38.使用所述矫正映射文件,逐帧矫正映射后的三维场景模型的视频纹理,得到矫正后的视频纹理;

39.基于所述融合掩码,以及,所述视频纹理的透明度,对所述矫正后的视频纹理进行融合渲染,得到该场景的三维虚拟现实视频。

40.第二方面,本技术提供一种多视频流融合装置,所述装置应用于设置有多个摄像头传感器的场景,所述多个摄像头传感器用于采集所述场景的不同区域的视频流,相邻区域存在部分重叠,所述装置包括:

41.第一获取模块,用于基于各摄像头传感器采集的对应区域的视频流,以及,所述场景的地面图像,获取各区域在同一三维空间下的待拼接模型,所述待拼接模型用于表征对应区域的三维场景结构;

42.第二获取模块,用于通过各相邻区域的待拼接模型的纹理图像,对各区域的待拼接模型的纹理图像进行变形,获得各区域的待拼接模型变形后的纹理图像,以及,各区域的待拼接模型的矫正映射文件;

43.第三获取模块,用于基于各相邻区域的待拼接模型在各相邻区域的待拼接模型之间的虚拟视点的成像内容,获取各相邻区域的待拼接模型的融合掩码;

44.拼接模块,用于根据各区域的待拼接模型变形后的纹理图像、各相邻区域的待拼接模型的融合掩码,在所述三维空间下的对各区域的待拼接模型进行拼接,得到三维场景模型;

45.融合模块,用于根据所述矫正映射文件、所述融合掩码,将各摄像头传感器采集的

对应区域的视频流融合到所述三维场景模型,得到所述场景的三维虚拟现实视频。

46.第三方面,本技术提供一种电子设备,包括:存储器与处理器;

47.所述存储器,用于存储所述处理器的可执行指令;

48.所述处理器配置为经由执行所述可执行指令来执行第一方面任一所述的方法。

49.第四方面,本技术提供一种存储介质,其上存储有计算机程序,包括:该程序被处理器执行时实现第一方面任一所述的方法。

50.本技术提供的多视频流融合方法、电子设备、存储介质,通过对每个视频流都构建一个三维场景结构作为待拼接模型,对各待拼接模型的纹理图像进行变形,再对各个待拼接模型进行拼接,得到三维场景模型。再将各摄像头传感器采集的对应区域的视频流融合到该三维场景模型上,利用矫正映射文件对各个相邻视频流进行对准。然后利用融合掩码对对准后的各个相邻的视频流进行拼接,最终得到该场景的三维虚拟现实视频,从而实现分散部署的摄像头传感器采集的多视频流融合。

附图说明

51.为了更清楚地说明本技术或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图做一简单地介绍,显而易见地,下面描述中的附图是本技术的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

52.图1为本技术提供的多视频流融合方法的应用场景示意图;

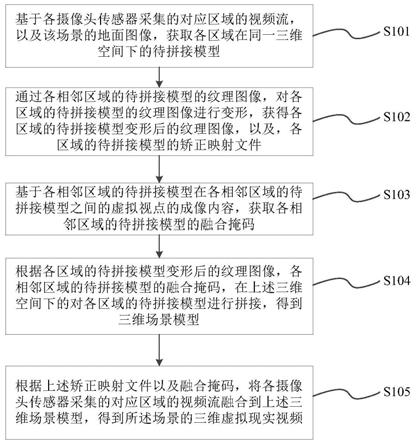

53.图2为本技术提供的一种多视频流融合的方法的流程图;

54.图3为本技术提供的一种获得三维场景模型的过程示意图;

55.图4为本技术提供的一种构建各区域在同一三维空间下的待拼接模型的方法的流程图;

56.图5为本技术提供的另一种多视频流融合的方法的流程图;

57.图6为本技术提供的一种获得各区域的待拼接模型的纹理图像的控制点集的方法示意图;

58.图7为本技术提供的一种目标函数相似变换约束项的计算方法示意图;

59.图8为本技术提供的再一种多视频流融合的方法的流程图;

60.图9为本技术提供的一种计算各相邻区域的待拼接模型在虚拟视点的成像内容的方法示意图;

61.图10为本技术提供的又一种多视频流融合的方法的流程图;

62.图11为本技术提供的一种多视频流融合装置示意图;

63.图12为本技术提供的一种电子设备结构示意图。

具体实施方式

64.为使本技术的目的、技术方案和优点更加清楚,下面将结合本技术中的附图,对本技术中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本技术一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本技术保护的范围。

65.本技术实施例涉及到的“待拼接模型”、“三维场景结构”为相同的概念,均表示对摄像头传感器所采集的视频流进行三维场景结构恢复得到的结果。为了便于对本技术实施例的描述,下述实施例中,对于两个相邻的待拼接模型,其中一个待拼接模型简称为ma,另外一个待拼接模型简称为mb。相应的,待拼接模型ma的纹理图像简称为ia,待拼接模型mb的纹理图像简称为ib。ia对应的初始视点为c1,ib对应的初始视点为c2。

66.图1为本技术提供的多视频流融合方法的应用场景示意图。如图1所示,例如在某一场景中(图1中位于摄像头传感器之间的椭圆形区域表示该场景)安装有多个摄像头传感器。每个摄像头传感器用于采集该场景的一个区域的视频,相邻的摄像头传感器的采集区域有部分重叠。图1是以4个摄像头传感器为例的示例图,对于摄像头传感器的具体数量可以根据场景中的实际设置确定。

67.电子设备可以获取上述4个摄像头传感器所采集的视频流。应理解,该电子设备可以是服务器、终端等具有处理功能的设备。

68.可选地,电子设备可以与摄像头传感器连接,获取该4个摄像头传感器所采集的视频流。或者,电子设备可以获取用户输入的该4个摄像头传感器所采集的视频流。或者,电子设备可以获取其他设备收集的该4个摄像头传感器所采集的视频流。

69.目前,电子设备在获取到上述4个摄像头传感器所采集的视频流后,以二维图像拼接技术为基础,实现多视频流的融合。然而,对于二维图像拼接技术,在待拼接图像间存在较大深度变化或者图像的空间位置不符合单应关系时,现有的二维图像拼接技术无法实现待拼接图像重叠区域的对准,使得拼接效果较差,有时甚至无法拼接。受限制于二维图像拼接技术的缺陷,现有的视频融合技术在实现分散部署的摄像头传感器采集的多视频流的虚拟现实视频融合时,待拼接视频流重叠区域无法对准,融合真实感效果较差。

70.考虑到现有技术中对于分散部署的摄像头传感器采集的多视频流的融合真实感效果较差原因,是基于二维图像拼接技术无法实现待拼接图像重叠区域的对准,本技术实施例提出了一种在三维空间下对多个摄像头传感器所采集的视频流进行对准、拼接的多视频流融合方法,不再受限于待拼接图像间是否存在较大深度变化或者图像的空间位置是否符合单应关系的约束,可以提高多视频流的融合真实感效果,增强融合后虚拟现实视频的真实感。

71.为了便于描述,下述实施例中以设置有摄像头传感器的相机为例,对本技术实施例进行说明。当然,具体实现时,也可以采用其他设置有摄像头传感器的设备,例如手机等采集场景中的某一区域的视频流。

72.下面结合具体地实施例对本技术的技术方案进行详细说明。下面这几个具体的实施例可以相互结合,对于相同或相似的概念或过程可能在某些实施例不再赘述。

73.图2为本技术提供的一种多视频流融合的方法的流程图。示例性的,图3为本技术提供的一种获得三维场景模型的过程示意图。结合图2和图3对本技术提供的多视频流融合的方法进行解释。如图2所示,该方法包括以下步骤:

74.s101、基于各摄像头传感器采集的对应区域的视频流,以及该场景的地面图像,获取各区域在同一三维空间下的待拼接模型。

75.上述电子设备除了接收各摄像头传感器采集的对应区域的视频流(例如图3中的视频流1、视频流2等)之外,还获取上述场景的地面图像,该地面图像是指能够描述该场景

完整的地形的图像,可以是该场景的航拍图像,或者是该场景的地图图像等。

76.作为一种可能的实现方式,电子设备提取各摄像头传感器采集的对应区域的视频流的背景帧,根据每个背景帧和上述地面图像,对每个摄像头传感器采集的对应区域的视频流进行三维场景结构恢复。电子设备对上述各个视频流的三维场景结构的恢复均基于同一个地面图像,即在同一三维空间下恢复各个视频流的三维场景结构,也就是说,在该场景的整体三维空间下恢复各个视频流的三维场景结构。恢复得到的各个三维场景结构,作为下一步拼接的输入,即上述各个三维场景结构为各区域在同一三维空间下的待拼接模型,例如图3中的待拼接模型1和待拼接模型2等。

77.应当理解的是,上述电子设备根据该场景的视频流以及地面图像恢复各个视频流的三维场景结构的过程,也可以采用现有的其他方式实现。

78.s102、通过各相邻区域的待拼接模型的纹理图像,对各区域的待拼接模型的纹理图像进行变形,获得各区域的待拼接模型变形后的纹理图像,以及,各区域的待拼接模型的矫正映射文件。

79.电子设备获得各区域在同一三维空间下的待拼接模型,有重叠部分的两个待拼接模型即为相邻区域的待拼接模型,例如图3中所示,待拼接模型1与待拼接模型2为相邻区域的待拼接模型,待拼接模型2还与待拼接模型3为相邻区域的待拼接模型,待拼接模型3还与待拼接模型4为相邻区域的待拼接模型,待拼接模型4还与待拼接模型1为相邻区域的待拼接模型。

80.电子设备提取各个待拼接模型的背景帧的纹理作为该待拼接模型的纹理图像。电子设备根据相邻待拼接模型重叠区域的特征,对待拼接模型的纹理图像进行变形,使得相邻待拼接模型中的其中一个待拼接模型的纹理图像与另一个待拼接模型的纹理图像的重叠区域实现对准。例如根据待拼接模型1与待拼接模型2的纹理图像重叠区域的特征,对待拼接模型1和待拼接模型2重叠区域的纹理图像进行变形,使得在同一坐标系下两者重叠区域中表示同一物体的点的坐标相同。电子设备得到变形后的待拼接模型1和待拼接模型2的纹理图像。

81.作为一种可能的实现方式,电子设备可以根据变形前后的待拼接模型的纹理图像的像素对应关系,生成待拼接模型的矫正映射文件。该生成的矫正映射文件用于表达待拼接模型的纹理图像变形前后的像素的映射关系。此处所说的像素对应关系可以是所有像素点的对应关系,也可以是部分像素点的对应关系,对此不进行限定。

82.s103、基于各相邻区域的待拼接模型在各相邻区域的待拼接模型之间的虚拟视点的成像内容,获取各相邻区域的待拼接模型的融合掩码。

83.该场景中安装的相机对该场景的各个区域进行拍摄,各个相机在该场景三维空间中的位置即为对应待拼接模型的初始视点。虚拟视点指的是电子设备根据各相邻区域的待拼接模型的初始视点,在该三维空间下生成的虚拟视点。将各相邻区域的待拼接模型投影至虚拟视点所在的平面上,得到各相邻区域的待拼接模型在虚拟视点的成像内容。例如,如图3中所示,待拼接模型1和待拼接模型2根据两者分别对应的初始视点合成待拼接模型1和待拼接模型2的虚拟视点,然后待拼接模型1和待拼接模型2投影到该虚拟视点所在的平面,得到待拼接模型1和待拼接模型2在虚拟视点的成像内容。

84.作为一种可能的实现方式,在虚拟视点所在的平面上,电子设备基于上述成像计

算各相邻区域的待拼接模型的缝合线,再将该缝合线反投影回各相邻区域的待拼接模型上,获得待拼接模型的融合掩码。此时,该融合掩码也可以视为是该待拼接模型的三维缝合线。

85.s104、根据各区域的待拼接模型变形后的纹理图像,各相邻区域的待拼接模型的融合掩码,在上述三维空间下的对各区域的待拼接模型进行拼接,得到三维场景模型。

86.如图3中所示,以变形后的纹理图像1和变形后的纹理图像2为例,待拼接模型1和待拼接模型2的融合掩码分别作用于变形后的纹理图像1和变形后的纹理图像2上,电子设备根据上述融合掩码,在上述三维空间下的对待拼接模型1和待拼接模型2进行拼接,以此类推,得到该场景的三维场景模型。

87.s105、根据上述矫正映射文件以及融合掩码,将各摄像头传感器采集的对应区域的视频流融合到上述三维场景模型,得到所述场景的三维虚拟现实视频。

88.电子设备对各区域的待拼接模型进行拼接,得到三维场景模型,三维场景模型用于引导该场景的不同区域的视频流的融合,融合过程提取上述矫正映射文件以及融合掩码对视频流进行矫正和融合,最终得到该场景的三维虚拟现实视频。

89.在得到该场景的三维虚拟现实视频之后,电子设备还可以对该三维虚拟现实视频进行显示,或者,电子设备可以将该三维虚拟现实视频输出至用户侧的终端设备进行显示,比如说输出至手机、电视机等终端。

90.在本实施例中,通过对每个视频流都构建一个三维场景结构作为待拼接模型,对各待拼接模型的纹理图像进行变形,再对各个待拼接模型进行拼接,得到三维场景模型。再将各摄像头传感器采集的对应区域的视频流融合到该三维场景模型上,利用矫正映射文件对各个相邻视频流进行对准。然后利用融合掩码对对准后的各个相邻的视频流进行拼接,最终得到该场景的三维虚拟现实视频,从而实现分散部署的摄像头传感器采集的多视频流融合。

91.图4为本技术提供的一种构建各区域在同一三维空间下的待拼接模型的方法的流程图,作为一种可能的实现方式,上述步骤s101例如可以包括如下步骤:

92.s1011、获取各个视频流的背景帧。

93.该电子设备获取各摄像头传感器采集的对应区域的视频流之后,在每个视频流中随机的抽取一帧图像,对该帧图像采用背景差分法,去除该帧图像中明显的动态物体(例如行人、车辆、飞鸟等),保留该帧图像中的静态物体(例如建筑物、树木、道路、道路标志等)作为对应视频流的背景帧。

94.s1012、提取背景帧中的直线特征,采用组分期望最大化(expectation maximization,em)迭代技术对直线特征分组,并求取灭点,然后使用灭点方向特征对各个背景帧对应的相机进行标定。

95.该电子设备在获得各个视频流的背景帧之后,提取各个背景帧中的直线特征,并使用迭代最小二乘直线拟合法对提取到的直线特征进行优化,得到优化后的直线特征。然后该电子设备采用组分em迭代技术对上述优化后的直线特征进行分类,并在每轮迭代过程中以直线分组为单位,在e步骤中求取每个分组对应的灭点。该电子设备再根据该灭点,结合j-linkage算法,合并直线分组,在m步骤中根据合并后直线分组对应的灭点,对直线进行再分组,迭代以上过程直到直线分组稳定。最后,该电子设备根据上述迭代得到的直线分组

结果,获得灭点方向,再根据灭点方向特征完成各个相机的标定。

96.s1013、在上述相机标定的基础上,通过2d-3d注册技术将各个背景帧注册到地面图像中,实现各相机的时空关系定位。

97.s1014、根据上述步骤得到的各相机的时空关系,通过视线交点的方法获取背景帧中每个像素点的深度;根据背景帧中每个像素点的深度,定义平面图元,生成与之对应的平面体元。

98.s1015、通过用户交互操作得到背景帧平面上图元和图元的关系,然后将相应的图元及图元的关系转换为空间中的体元及相应体元之间的关系;使用场景图来存贮用户交互操作得到的中间结果。

99.s1016、完成用户交互操作后,根据场景图中各体元之间的关系来组合生成最终的三维场景结构,该三维场景结构即为对应各区域在同一三维空间下的待拼接模型。

100.如前述所说,电子设备可以通过各相邻区域的待拼接模型的纹理图像,对待拼接模型的纹理图像进行变形,获得各区域的待拼接模型变形后的纹理图像,以及各区域的待拼接模型的矫正映射文件。作为一种可能的实现方式,图5为本技术提供的另一种多视频流融合的方法的流程图,如图5所示,该方法包括以下步骤:

101.s201、基于各相邻区域的待拼接模型的纹理图像,获取各相邻区域的待拼接模型之间的匹配特征点对。

102.如上所述,电子设备获取各个待拼接模型的背景帧的纹理作为对应待拼接模型的纹理图像,示例性的,假设两个待拼接模型的纹理图像分别为第一纹理图像和第二纹理图像。电子设备通过尺度不变特征变换(scale-invariant feature transform,sift)的检测方法,对第一纹理图像和第二纹理图像的重叠区域进行特征点检测,得到多对初始特征点对。

103.为了得到更高匹配精度的初始特征点对,电子设备通过将上述待拼接模型的面片结构投影至对应待拼接模型的纹理图像上,对对应纹理图像进行平面划分,即将对应纹理图像以该平面划分结果划分成多个不同的区域,将上述纹理图像上位于同一平面区域内的初始特征点划分至同一特征点集合中。

104.由于上述构建每个视频流对应的三维场景结构的过程,是基于单幅图像(视频流对应的背景帧)与地面图像恢复得到的三维场景结构,所以恢复每个视频流对应三维场景结构的过程充分还原了每个视频流对应的背景帧在三维空间中的成像模型,使得恢复的三维场景结构与场景的真实空间结构更加贴合。而上述平面划分的过程是将待拼接模型的面片结构(即三维场景结构的面片结构)投影至对应待拼接模型的纹理图像上,对对应纹理图像进行平面划分,所以,上述平面划分的过程提高了平面划分的准确性,且使得平面划分更集中。

105.对于上述同一特征点集合内的初始特征点对,以一对初始特征点对中特征点a和特征点b为例,以其中一个初始特征点(例如特征点a)所在的纹理图像为参考图像,电子设备对特征点b是否满足预设条件进行判断,若特征点b满足预设条件,则从特征点集合中去除特征点a和特征点b。可选的,上述预设条件可以由下述方法确定:可以对上述特征点b使用直接线性变换(direct linear transform,dlt)算法求取特征点a和特征点b间的残差γ,当上述该残差γ大于或等于第一预设阈值,则认为特征点a和特征点b所属初始特征点

对在实际三维空间不是相匹配的,因此需要去除该对初始特征点对。上述第一预设阈值可以由用户在电子设备中输入,例如可以是像素值大小的数值等。

106.依上述方法,电子设备对所有初始特征点对进行判断,去除各特征点集合中满足预设条件的初始特征点所在的初始特征点对,最终留下的初始特征点对作为各相邻区域的待拼接模型的匹配特征点对。因为实际匹配的特征点是场景中的同一个点,像素值差异不会存在较大差异,而上述过程去除了像素值差异较大的的特征点对,所以提高了获取各相邻区域的待拼接模型之间的匹配特征点对的准确性。

107.s202、基于各相邻区域的待拼接模型的匹配特征点对在该三维空间中的三维坐标,以及,各相邻区域的待拼接模型的权重,得到各相邻区域的待拼接模型的匹配特征点对的插值点的三维坐标。

108.作为一种可能的实现方式,图6为本技术提供的一种获得各区域的待拼接模型的纹理图像的控制点集的方法示意图。如图6所示,电子设备给待拼接模型ma和待拼接模型mb分别分配权重为ω1、ω2,该权重由待拼接模型ma的模型中心到三维空间中心的距离以及待拼接模型mb的模型中心到三维空间中心的距离决定。具体的,到三维空间中心距离越小的待拼接模型,电子设备给该待拼接模型赋予的权重越高,到三维空间中心距离越大的待拼接模型,电子设备给该待拼接模型赋予的权重越低,即待拼接模型的权重与待拼接模型与三维空间中心的距离负相关。

109.如图6所示,在得到各相邻区域的待拼接模型的匹配特征点对之后,以任意一对匹配特征点对为例,假设该对匹配特征点对为(p,q)。其中特征点p为相邻区域的待拼接模型中的其中一个待拼接模型ma对应纹理图像ia上的特征点,q为相邻区域的待拼接模型中另一个待拼接模型mb对应纹理图像ib上的特征点。p为p在对应待拼接模型ma中的三维的投影点,q为q在对应待拼接模型mb中的三维的投影点。连接点p和点q,得到线段pq。电子设备根据待拼接模型ma和待拼接模型mb对应的权重ω1、ω2,在线段pq上得到线段插值点t,插值点t=ω1p ω2q。以此计算各相邻区域的待拼接模型的匹配特征点对的插值点的三维坐标。

110.s203、将各相邻区域的待拼接模型的匹配特征点对的插值点反投影至各相邻区域的待拼接模型的纹理图像,得到各区域的待拼接模型的纹理图像的控制点集。

111.如图6所示,电子设备将上述插值点t分别反投影回纹理图像ia和纹理图像ib上,得到对应的控制点p

′

以及控制点q

′

。电子设备依据上述方法,对各相邻区域的待拼接模型的所有的匹配特征点对进行上述操作,得到各区域的待拼接模型的纹理图像的控制点集。

112.应当理解的是,电子设备还可以通过其他方式获得各区域的待拼接模型的纹理图像的控制点集。

113.s204、利用各区域的待拼接模型的纹理图像的控制点集,对各区域的待拼接模型的纹理图像进行基于网格的图像变形,获得各区域的待拼接模型变形后的纹理图像,并生成各区域的待拼接模型的矫正映射文件。

114.电子设备在获得各区域的待拼接模型的纹理图像的控制点集之后,为待拼接模型的纹理图像添加初始网格,该初始网格是指将纹理图像均匀的划分为多个小格。其中小格的形状可以是方形、三角形等形状,本技术对小格的形状不做限定。示例性的,以小格形状为方格为例,每个方格有四个顶点,即得到初始网格的顶点集合。上述方格的数量可以是用户在电子设备中根据需求设置的,也可以是电子设备根据待拼接模型的纹理图像的大小进

行计算得到的,即本技术对小格的数量以及数量获取方式不做限定。

115.为了在保证各个相邻待拼接模型对准精度的同时,待拼接模型的纹理图像整体畸变程度更小,更好地保留纹理图像的原始结构,电子设备使用以上述初始网格的顶点集合作为自变量的目标函数,即利用上述初始网格的顶点集合的坐标来作为目标函数的自变量,并将上述待拼接模型的纹理图像的控制点集作为上述目标函数的约束条件。上述控制点集中,每个控制点的坐标可以由四个上述初始网格的顶点坐标表示。

116.电子设备在得到上述目标函数之后,采用共轭梯度法对目标函数进行最小化优化,当该目标函数达到第二预设阈值时,停止优化,此时得到的目标函数为最小化目标函数,此时对应的上述初始网格的顶点坐标构成新的网格,此时将该新的网格视为待拼接模型的纹理图像的最优网格。该第二预设阈值可以是用户根据最终优化效果以及优化时间来均衡决定,并由用户在电子设备中输入,还可以是电子设备根据目标函数的优化过程进行判断,自动设定该第二预设阈值。

117.作为一种可能的实现方式,电子设备可以从以下四个约束项进行上述目标函数的优化:

118.第一,对准约束项,用于约束控制点变换到所述控制点对应的匹配特征点。例如,该对准约束项可以根据下述公式(0)确定:

[0119][0120]

其中,s

(a,b)

为上述纹理图像ia和纹理图像ib中匹配特征点对的集合,p

′

和q

′

分别表示纹理图像ia和纹理图像ib上的控制点的二维坐标,φ(p)和φ(q)分别表示匹配特征点p变换后的实际二维坐标和匹配特征点q变换后的实际二维坐标,ea即为对准约束项。

[0121]

第二,相似变换约束项,用于约束相邻网格进行相似变换,约束相邻网格的相对位置关系保持不变。

[0122]

在对相邻网格的相对位置关系进行约束之前,对于待拼接模型的纹理图像上的每个方格,电子设备按照每个方格的对角线,将每个方格划分成两个三角形。然后基于该三角形组成的网格对相邻网格的相对位置关系进行约束。图7为本技术提供的一种目标函数相似变换约束项的计算方法示意图,如图7中的(a)所示,v1、v2、v3、v4表示上述网格中的其中一个方格的四个顶点的坐标,其中,顶点v1的坐标可用顶点v2的坐标以及顶点v3的坐标表示,具体的,可由下述公式(1)实现:

[0123]

v1=v3 u(v

2-v3) vr

90

(v

2-v3)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0124]

其中,u和v是由初始网格计算出的坐标系,该坐标系的原点位于顶点v3的位置,u轴的方向为从v3指向v2的方向,v2和v3的坐标在u和v的坐标参数下都是已知的,旋转矩阵表示将v

2-v3的结果按逆时针旋转90度。

[0125]

如图7中的(b)所示,v1′

、v2′

、v3′

、v4′

分别表示优化过程中的网格顶点二维坐标,分别表示目标网格顶点的二维坐标,在已知u、v、分别表示目标网格顶点的二维坐标,在已知u、v、的情况下,

[0126][0127]

由此,该约束相邻网格进行相似变换的相似变换约束项可以根据下述公式(3)确

定:

[0128][0129]

其中,ti表示第i个纹理图像上三角形组成的网格中三角形的数量,即可以表示纹理图像ia或者纹理图像ib上三角形组成的网格中三角形的数量,表示第i个纹理图像上第j个三角形的误差。

[0130]

其中,第i个纹理图像上第j个三角形的误差由下述公式(4)表示,k表示三角形网格的三个顶点,v'k、分别表示优化过程中的三角形网格顶点二维坐标以及目标三角形网格顶点的二维坐标。

[0131][0132]

第三,尺度约束项,用于约束所述待拼接模型的纹理图像变换前后相对尺度保持不变。例如,该尺度约束项可以根据下述公式(5)确定:

[0133][0134]

其中,es是尺度约束项,i表示待拼接模型的纹理图像的集合,ii是其中一个待拼接模型的纹理图像,s(i

i*

)是变换后的待拼接模型的纹理图像的尺度矩阵,s(ii)变换前的待拼接模型的纹理图像的尺度矩阵,si表示最优缩放因子。

[0135]

其中待拼接模型的纹理图像的尺度矩阵s(ii)由待拼接模型的纹理图像的上、下、左、右四条边的长度决定,具体的||b

t

||、||bb||、||b

l

||、||br||分别代表待拼接模型的纹理图像的上、下、左、右四条边的长度。

[0136]

此外,上述最优缩放因子si可以由下述公式(6)确定:

[0137][0138]

其中,(i,h∈i)表示纹理图像集合i中的一对待拼接模型的纹理图像i和待拼接模型的纹理图像h,γ

ih

表示该对待拼接模型的纹理图像的相对尺度因子。其中,pi、ph分别表示纹理图像i和纹理图像h的外包多边形,e

pi

、e

ph

分别表示外包多边形pi以及外包多边形ph对应的周长。si、sh分别表示纹理图像i和纹理图像h的绝对尺度因子,根据公式(6)所示,使得的值最小的纹理图像i的绝对尺度因子si,视为最优缩放因子,且si满足的条件,ni表示待拼接模型的纹理图像的集合i中纹理图像的数量。显然,公式(6)是一个条件极值公式,作为一种可能的实现方式,可以使用拉格朗日乘数法进行求解最优缩放因子si。

[0139]

第四,直线约束项,用于约束所述待拼接模型的纹理图像变换前后纹理图像中的直线保持不变。例如,该直线约束项可以根据下述公式(7)确定:

[0140][0141]

其中,e

l

是直线约束项,l表示待拼接模型的纹理图像中所有直线的集合,l表示其中一条直线,n表示直线l上采样点的个数,[a

l

,b

l

]

⊥

表示直线l的正交向量,pi、p

i 1

表示是直线l上相邻的两个采样点。

[0142]

完成目标函数优化,电子设备获得待拼接模型的最优网格之后,将上述得到的最优网格与待拼接模型的纹理图像的初始网格进行比对,然后根据最优网格和初始网格的对应关系,获得待拼接模型的纹理图像的仿射矩阵,该仿射矩阵用于指示待拼接模型的纹理图像如何变形,电子设备将该仿射矩阵作用于待拼接模型的纹理图像,待拼接模型的纹理图像进行变形,得到所述待拼接模型变形之后的纹理图像。

[0143]

最后,电子设备将待拼接模型变形之后的纹理图像的像素值与待拼接模型变形之前的纹理图像的像素值进行比对,得到待拼接模型变形前后的纹理图像的像素映射关系,在根据该像素映射关系,生成待拼接模型的矫正映射文件。

[0144]

在本实施例中,电子设备在获取匹配特征点对时,对初始特征点对进行判断,获得最终匹配特征点对,提高了获取各相邻区域的待拼接模型之间的匹配特征点对的正确性。然后依据各相邻区域的待拼接模型到场景中心的距离给待拼接模型赋予权重,再获取各相邻区域的待拼接模型的纹理图像的控制点集,并通过使用以网格顶点集合作为自变量、以待拼接模型的纹理图像的控制点集作为约束条件的目标函数,对待拼接模型的纹理图像的变形过程进行约束,减小了待拼接模型纹理图像变形前后的视角的变化,在保证各个相邻待拼接模型对准精度的同时,待拼接模型的纹理图像整体畸变程度更小,更好地保留纹理图像的原始结构。

[0145]

电子设备在完成对待拼接模型的纹理图像进行矫正之后,对待拼接模型进行拼接。图8为本技术提供的再一种多视频流融合的方法的流程图,如图8所示,该方法包括以下步骤:

[0146]

s301、基于各相邻区域的待拼接模型之间的虚拟视点,重新计算各相邻区域的待拼接模型在虚拟视点的成像内容。

[0147]

图9为本技术提供的一种计算各相邻区域的待拼接模型在虚拟视点的成像内容的方法示意图。示例性的,如图9所示,电子设备基于两个相邻的待拼接模型,合成这两个待拼接模型的虚拟视点。在同一三维空间下,电子设备可以得到待拼接模型ma的初始视点c1和待拼接模型mb的初始视点c2、以及待拼接模型ma和待拼接模型mb重叠部分的中心点o的坐标,将上述三个点作为一个平行四边形的三个顶点,该平行四边形的第四个顶点的位置即为待拼接模型ma和待拼接模型mb的虚拟视点cv。其中,待拼接模型ma和待拼接模型mb分别对应的相机的位置叫做初始视点。

[0148]

电子设备得到该虚拟视点之后,将这两个相邻待拼接模型投影至该虚拟视点所在的平面,该虚拟视点所在的平面是指过该虚拟视点且与上述两个相邻待拼接模型的纹理图像所在平面平行的平面。电子设备将这两个相邻待拼接模型投影至该平面之后,获得的成像内容,即为各相邻区域的待拼接模型在虚拟视点的成像内容。示例性的,以图9中纹理图像ia和纹理图像ib上的为例,其中分别表示特征点p、q经过上述纹理变形之后对应的点,将上述分别投影到三维空间中,得到点w,再将点w投影到虚拟视点所在平

面得到点

[0149]

s302、针对相邻区域的待拼接模型在虚拟视点的成像内容,计算成像内容的重叠区域的对准误差和颜色差异。

[0150]

在上述将两个相邻待拼接模型投影至虚拟视点所在的平面的过程中,待拼接模型的纹理图像上的特征点也随之投影到该虚拟视点所在的平面上,该特征点即为上述步骤s203得到的特征点。针对待拼接模型在虚拟视点的成像内容的重叠区域,电子设备计算该重叠区域内特征点的对准误差和颜色差异。

[0151]

其中,对准误差的计算过程如下:

[0152]

首先,电子设备对特征点对的对准误差进行高斯平滑,该高斯平滑过程如公式(8)所示:

[0153][0154]

其中,s(p,q)∈s

(a,b)

,表示p和q分别为属于纹理图像ia和纹理图像ib上的特征点,和分别表示和在虚拟视点所在平面的投影点。σ1的大小由待拼接模型的纹理图像的对角线的长度决定,假设待拼接模型的纹理图像的对角线的长度为d,示例性的,σ1的大小可以为0.003d,其中,d之前的参数,如0.003,可以根据实际情况进行改变。

[0155]

然后,电子设备计算每个特征点对待拼接模型在虚拟视点的成像内容的重叠区域像素x的权重,以待拼接模型的纹理图像ia上的特征点p的权重计算过程为例,上述权重定义为:

[0156][0157]

其中,σ2的大小由待拼接模型的纹理图像的对角线的长度d决定,示例性的,σ2的大小可以为0.4d,其中,d之前的参数,如0.4,可以根据实际情况进行改变,π-1

表示待拼接模型的纹理图像投影到该三维空间中。根据该权重,待拼接模型的纹理图像ia上的特征点p在上述像素x处的对准误差如式(10)所示:

[0158][0159]

待拼接模型的纹理图像ib上的特征点q根据其权重w

(q,x)

,在上述像素x处的对准误差的计算过程与式(10)相同,得到待拼接模型的纹理图像ib上的特征点q在上述像素x处的对准误差

[0160]

最后,两个待拼接模型在虚拟视点的成像内容的重叠区域的对准误差为上述对准误差的均值,如式(11)所示:

[0161][0162]

待拼接模型在虚拟视点的成像内容的重叠区域的颜色差异计算过程如下:

[0163]

电子设备对待拼接模型在虚拟视点的成像内容的重叠区域的颜色差异进行计算,

如公式(12)所示:

[0164][0165]

其中,γa表示待拼接模型的纹理图像ia在虚拟视点的成像内容的重叠区域像素颜色,γb表示待拼接模型的纹理图像ib在虚拟视点的成像内容的重叠区域像素颜色,μ和σ分别为待拼接模型在虚拟视点的成像内容的重叠区域中像素rgb值的欧氏距离的统计平均值和标准偏差。

[0166]

s303、基于上述对准误差和颜色差异,得到重叠区域的差异图,以及,代价函数。

[0167]

电子设备通过上述对准误差和颜色差异,得到待拼接模型在虚拟视点的成像内容的重叠区域的差异图,并将上述对准误差和颜色差异相结合,得到待拼接模型在虚拟视点成像内容的重叠区域的代价函数,如公式(13)所示:

[0168][0169]

其中,max和min分别表示sa(x) sc(x)的最大值和最小值,即max和min分别表示对准误差和颜色差异的最大值和最小值。

[0170]

s304、在上述差异图上使用图割算法,获取累积代价函数最小的缝合线。

[0171]

电子设备在上述差异图的基础上,使用图割算法对上述代价函数进行最小化,在完成优化时,此时对应的相邻待拼接模型的纹理图像在虚拟视点的成像内容的缝合线达到最优,得到累积代价函数最小的缝合线。

[0172]

s305、对得到的缝合线的两侧进行双线性插值后,反投影到相邻区域的待拼接模型上,得到相邻区域的待拼接模型的融合掩码。

[0173]

对上述优化过程得到的缝合线的两侧进行双线性插值,将插值后得到的缝合线分别反投影回相邻区域的待拼接模型上,生成三维的缝合线,然后根据该缝合线生成相邻区域的待拼接模型的融合掩码。

[0174]

s306、在同一三维空间下,使用各相邻区域的待拼接模型的融合掩码,对各区域的待拼接模型变形后的纹理图像进行拼接,得到所述三维场景模型。

[0175]

此处所述各区域的待拼接模型变形后的纹理图像即为步骤204得到的各区域的待拼接模型变形后的纹理图像。电子设备根据上述相邻区域的待拼接模型的融合掩码,对各区域的待拼接模型变形后的纹理图像进行拼接,得到该场景下的三维场景模型。该三维场景模型用于引导同一场景下的多视频流的融合。

[0176]

在本实施例中,通过构建虚拟视点,将待拼接模型投影到虚拟视点所在平面的方法,将各个待拼接模型的纹理图像变换到同一平面内,在该平面坐标系内,计算待拼接模型在虚拟视点所在平面的缝合线,再通过投影方式得到融合掩码,再用于实现将该场景下各区域待拼接模型拼接成该场景的三维场景模型。

[0177]

图10为本技术提供的又一种多视频流融合的方法的流程图,如图10所示,该方法包括以下步骤:

[0178]

s401、将各区域的视频流映射至上述三维场景模型。

[0179]

电子设备获取上述拼接完成的三维场景模型,在接收到各个摄像头传感器输出的视频流之后,将接收到的各区域的视频流映射到该三维场景模型上,并形成视频纹理。

[0180]

s402、使用矫正映射文件,逐帧矫正映射后的三维场景模型的视频纹理,得到矫正后的视频纹理。

[0181]

在得到上述三维场景模型的过程中,电子设备生成了矫正映射文件。在电子设备得到各个视频流的视频纹理之后,提取上述矫正映射文件,用于对各个视频流的视频纹理进行矫正。上述对视频纹理的矫正过程是按照视频流中每一帧的顺序,依据上述矫正映射文件所指示的纹理变形前后的像素映射关系,对视频流中的每一帧图像对应的纹理进行纹理变形,使得两个相邻的视频流同一时间的每一帧图像的重叠区域实现对准。对准之后的视频纹理,即为矫正后的视频纹理。

[0182]

s403、基于融合掩码,以及,上述视频纹理的透明度,对矫正后的视频纹理进行融合渲染,得到该场景的三维虚拟现实视频。

[0183]

电子设备可以基于用户设置的视频纹理的透明度,以及上述融合掩码,对矫正后的视频纹理进行融合渲染。电子设备对输入进来的视频流的每一帧图像进行上述纹理变形、融合渲染的操作,最终形成该场景的三维虚拟现实视频。

[0184]

在本实施例中,通过该场景下的三维场景模型引导该场景下的视频流进行融合,得到该场景的三维虚拟现实视频,该过程使用矫正映射文件对各个相邻的视频流对应的视频纹理进行对准,而且所需的三维场景模型、矫正映射文件、融合掩码均是提前存储在电子设备中,以此达到既能保证多视频流融合的效率,又能达到提高多视频流融合真实感效果的目的。

[0185]

图11为本技术提供的一种多视频流融合装置示意图,如图11所示,该多视频流融合装置可以包括:

[0186]

第一获取模块51,用于基于各摄像头传感器采集的对应区域的视频流,以及,所述场景的地面图像,获取各区域在同一三维空间下的待拼接模型。

[0187]

第二获取模块52,用于通过各相邻区域的待拼接模型的纹理图像,对各区域待拼接模型的纹理图像进行变形,获得各区域的待拼接模型变形后的纹理图像,以及,各区域的待拼接模型的矫正映射文件。

[0188]

第三获取模块53,用于基于各相邻区域的待拼接模型在各相邻区域的待拼接模型之间的虚拟视点的成像内容,获取各相邻区域的待拼接模型的融合掩码。

[0189]

拼接模块54,用于根据各区域的待拼接模型变形后的纹理图像、各相邻区域的待拼接模型的融合掩码,在所述三维空间下的对各区域的待拼接模型进行拼接,得到三维场景模型。

[0190]

融合模块55,用于根据所述矫正映射文件、所述融合掩码,将各摄像头传感器采集的对应区域的视频流融合到所述三维场景模型,得到所述场景的三维虚拟现实视频。

[0191]

可选的,所述第二获取模块,具体用于基于各相邻区域的待拼接模型的纹理图像,获取各相邻区域的待拼接模型之间的匹配特征点对;基于各相邻区域的待拼接模型的匹配特征点对在所述三维空间中的三维坐标,以及,各相邻区域的待拼接模型的权重,得到各相邻区域的待拼接模型的匹配特征点对的插值点的三维坐标;将各相邻区域的待拼接模型的匹配特征点对的插值点反投影至各相邻区域的待拼接模型的纹理图像,得到各区域的待拼

接模型的纹理图像的控制点集;利用各区域的待拼接模型的纹理图像的控制点集,对各区域的待拼接模型的纹理图像进行基于网格的图像变形,获得各区域的待拼接模型变形后的纹理图像;根据各区域的待拼接模型变形前后的纹理图像的像素映射关系,生成所述待拼接模型的矫正映射文件。其中,所述匹配特征点对的残差小于预设像素值,所述待拼接模型的权重与所述待拼接模型与三维空间中心的距离负相关。

[0192]

可选的,所述第二获取模块,具体用于基于相邻区域的待拼接模型的纹理图像,获取相邻区域的待拼接模型之间的初始特征点对;将所述待拼接模型的面片结构投影至所述待拼接模型的纹理图像上,得到所述纹理图像的平面划分结果;基于所述纹理图像的平面划分结果,将所述纹理图像上位于同一平面区域内的初始特征点划分至同一特征点集合中;去除各特征点集合中满足预设条件的初始特征点所在的初始特征点对,得到相邻区域的待拼接模型的匹配特征点对,所述预设条件为所述初始特征点所在的特征点对的残差大于或等于第一预设阈值。

[0193]

可选的,所述第二获取模块,具体用于为所述待拼接模型的纹理图像添加初始网格;利用所述待拼接模型的纹理图像的控制点集作为约束条件、使用以网格顶点集合作为自变量的目标函数,对所述初始网格进行优化,得到所述待拼接模型的纹理图像的最优网格;根据所述待拼接模型的纹理图像的初始网格与最优网格之间的对应关系,得到所述待拼接模型的纹理图像的仿射矩阵;使用所述待拼接模型的纹理图像的仿射矩阵,对所述待拼接模型的纹理图像进行变形,得到所述待拼接模型变形后的纹理图像;根据所述待拼接模型变形前后的纹理图像的像素映射关系,生成所述待拼接模型的矫正映射文件。

[0194]

可选的,所述目标函数包括下述约束项:约束控制点变换到所述控制点对应的匹配特征点的对准约束项、约束相邻网格的相对位置关系保持不变的相似变换约束项、约束所述待拼接模型的纹理图像变换前后相对尺度保持不变的尺度约束项、约束所述待拼接模型的纹理图像变换前后直线保持不变的直线约束项。

[0195]

可选的,所述第三获取模块,具体用于针对相邻区域的待拼接模型在虚拟视点的成像内容,计算成像内容的重叠区域的对准误差和颜色差异;基于所述重叠区域的对准误差和颜色差异,得到所述重叠区域的差异图,以及,代价函数;在所述差异图上使用图割算法,获取累积代价函数最小的缝合线;对所述缝合线的两侧进行双线性插值后,反投影到相邻区域的待拼接模型上,得到相邻区域的待拼接模型的融合掩码。

[0196]

可选的,所述拼接模块,具体用于在所述三维空间下,使用所述各相邻区域的待拼接模型的融合掩码,对所述各区域的待拼接模型变形后的纹理图像进行拼接,得到所述三维场景模型。

[0197]

可选的,所述融合模块,具体用于将各区域的视频流映射至所述三维场景模型;使用所述矫正映射文件,逐帧矫正映射后的三维场景模型的视频纹理,得到矫正后的视频纹理;基于所述融合掩码,以及,所述视频纹理的透明度,对所述矫正后的视频纹理进行融合渲染,得到该场景的三维虚拟现实视频。

[0198]

本技术实施例提供的多视频流融合装置,可以执行上述电子设备所提供的多视频流融合方法,例如图2-图10所示的方法实施例,其实现技术效果与原理类似,对此不再赘述。

[0199]

图12为本技术提供的一种电子设备结构示意图。如图12所示,该电子设备可以包

括:至少一个处理器61和存储器62。

[0200]

存储器62,用于存放程序。具体地,程序可以包括程序代码,程序代码包括计算机操作指令。

[0201]

存储器62可能包含高速ram存储器,也可能还包括非易失性存储器(non-volatile memory),例如至少一个磁盘存储器。

[0202]

处理器61用于执行存储器62存储的计算机执行指令,以实现多视频流融合方法。

[0203]

其中,处理器61可能是一个中央处理器(central processing unit,简称为cpu),或者是特定集成电路(application specific integrated circuit,简称为asic),或者是被配置成实施本技术实施例的一个或多个集成电路。

[0204]

可选的,在具体实现上,如果通信接口、存储器62和处理器61独立实现,则通信接口、存储器62和处理器61可以通过总线相互连接并完成相互间的通信。总线可以是工业标准体系结构(industry standard architecture,简称为isa)总线、外部设备互连(peripheral component,简称为pci)总线或扩展工业标准体系结构(extended industry standard architecture,简称为eisa)总线等。总线可以分为地址总线、数据总线、控制总线等,但并不表示仅有一根总线或一种类型的总线。

[0205]

可选的,在具体实现上,如果通信接口、存储器62和处理器61集成在一块芯片上实现,则通信接口、存储器62和处理器61可以通过内部接口完成通信。

[0206]

本技术还提供了一种计算机可读存储介质,该计算机可读存储介质可以包括:u盘、移动硬盘、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)、磁盘或者光盘等各种可以存储程序代码的介质,具体的,该计算机可读存储介质中存储有程序指令,程序指令用于上述实施例中的方法。

[0207]

最后应说明的是:以上各实施例仅用以说明本技术的技术方案,而非对其限制;尽管参照前述各实施例对本技术进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分或者全部技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本技术各实施例技术方案的范围。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。