1.本发明属于计算机视觉技术领域,特别是涉及一种基于宽基线光场成像技术的垃圾堆场三维重建方法及系统。

背景技术:

2.随着我国经济的快速发展和城镇化进程的加快,工业和生活垃圾呈现爆炸式增长,科学有效处理垃圾是现代城市环境治理与可持续发展中的重要问题。垃圾焚烧发电是城镇垃圾处理的主要方式,在无害化、资源化垃圾处理中扮演着重要角色,是实现国家“碳中和、碳达峰”重大战略的过关键一环。垃圾在焚烧前必须在堆场经过5—7天的发酵和脱水,因此,实现垃圾堆场的数字孪生智能化管理对城市各区域的垃圾热值预测研究和垃圾溯源追踪及监控技术研究,实现高效稳定发电具有重要指导意义,是目前城市垃圾管理运行的重点与难点。其中的关键环节是垃圾堆场的三维场景重建。

3.三维重建技术是机器视觉领域的热点研究话题,但是面向于垃圾堆场的三维重建研究却比较匮乏。目前常见的三维重建方法研究主要包括:被动式三维重建技术和主动式三维重建技术。被动式三维重建技术一般利用周围环境如自然光的反射,使用相机获取图像,然后通过特定算法计算得到物体的立体空间信息,主要包括纹理恢复形状法、阴影恢复形状法和立体视觉法;主动式三维重建技术是指利用如激光、声波、电磁波等光源或能量源发射至目标物体,通过接收返回的光波来获取物体的深度信息。主要包括莫尔条纹法、飞行时间法、结构光法和三角测距法等四种方法。

4.垃圾堆场的场景本身具有占地面积大、表面不平整、遮挡区域多、变化速度较快等特点,大多数现有的被动式三维重建方法极易受到表面纹理及光照条件的影响,无法有效解决垃圾堆场的现有问题;同时,采用主动式三维建模技术也面临着设备造价高昂且容易腐蚀等问题,在经济成本上不适用于该场景。

技术实现要素:

5.本发明要解决的技术问题就在于:针对现有技术存在的问题,本发明提供一种成本低、精度高且实时性好的基于宽基线光场成像技术的垃圾堆场三维重建方法及系统。

6.为解决上述技术问题,本发明所采用的技术方案是,

7.一种基于宽基线光场成像技术的垃圾堆场三维重建方法,包括步骤:

8.步骤s1,利用多相机阵列采集垃圾堆场图像;

9.步骤s2,利用深度压缩感知技术对采集后的稀疏相机阵列图像恢复全光场图像;

10.步骤s3,在重建后的全光场图像中选择多个视角流的图像作为输入数据;

11.步骤s4,通过宽基线光场公开数据集llf和垃圾堆场采集到的光场图像序列作为模型训练样本;

12.步骤s5,利用模型训练样本训练深度神经网络得到相应的权重与偏置,得到权重与偏置带入验证数据集,计算出验证数据集的预测误差,并保存使训练集预测误差最小的

权重和偏置;

13.步骤s6,将步骤s5中使训练集预测误差最小的权重和偏置带入预测集合中,推理计算得到预测深度值。

14.优选地,所述步骤s2包括:

15.步骤s2.1,构建全光场恢复网络模型;

16.步骤s2.2,进行特征提取运算;

17.步骤s2.3,进行非线性映射运算;

18.步骤s2.4,进行特征聚合运算;

19.步骤s2.5,添加长连接。

20.优选地,在步骤s2.1中,全光场恢复网络模型包含初始恢复模型和深度恢复模型,可整体抽象描述为:

21.r(y)=d(i(y))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

22.其中y为步骤s1中相机阵列所得采样结果,i为初始恢复过程,d为深度恢复过程,r为整体恢复过程,具体如下:

23.初始恢复过程i(y)描述为:其中lb2×

nb矩阵为采样矩阵φb的逆矩阵,为恢复的数据;

24.在初始恢复模型中使用无偏差项卷积层来模拟这一过程,表述为w

int

为lb2个大小为1

×1×

nb的滤波器,步长为的滤波器,步长为中每列都是大小为1

×1×

lb2的的重建向量,对这些向量进行变形与链接处理得到初始重建光场数据

25.在步骤s2.2中,特征提取运算被用作从区域性感受野中产生高维度特征,其过程由一个卷积层连接激活层组成,设定卷积层由d个大小为f

×f×

l的滤波器组成;这一过程表述为其中w为一系列滤波器,be为大小为d

×

1的偏差项,act(

·

)为激活运算,采用relu激活函数;

26.在步骤s2.3中,非线性映射运算被用作增加网络非线性及相关感受野,保证重建质量;该运算过程由残差块、卷积层及激活层组成,可表述为:

[0027][0028][0029]

公式中i∈{1,2,3

···

,n}为残差块,及都包含了d个大小为f

×f×

d的滤波器,及为大小为

×

1的偏移项,

[0030]

在步骤s2.4中,特征聚合运算被用作从高维度特征恢复光场数据,该运算过程可表述为其中wa为l个大小为f

×f×

d的滤波器,ba为大小为l

×

1的偏差项;

[0031]

在步骤s2.5中,在初始重建光场数据与深度重建模型输出之间添加长连

接,以加速网络聚合,最终的深度重建过程可表述为接,以加速网络聚合,最终的深度重建过程可表述为

[0032]

优选地,所述步骤s5的过程为:

[0033]

步骤s5.1,确定神经网络反向传播的误差阈值ε并设置超参数;

[0034]

步骤s5.2,各个分支对输入的图像进行特征提取;

[0035]

步骤s5.3,对提取到的特征要素进行代价卷生成运算;

[0036]

步骤s5.4,对上述步骤产生的多尺度融合成本量进行自适应跨尺度聚合。

[0037]

步骤s5.5,代价回归;

[0038]

步骤s5.6,视差回归。

[0039]

步骤s5.7,计算损失函数用于模型训练的参数优化;

[0040]

步骤s5.8,返回。

[0041]

优选地,在步骤s5.1中,设置初始化迭代次数i=0,最大迭代次数为imat;随机初始化各网络层权重矩阵w和偏差β;

[0042]

在步骤s5.2中,特征提取运算被用作从区域性感受野中产生高维度特征,其过程由三个特征提取卷积模块组成,每个特征提取卷积模块包含一个跨步卷积层、一个2d卷积层、一个批量归一化层以及一个激活层,其中前一卷积层的步长设置为2用于下采样输入,而后者设置为1,采用relu激活函数;

[0043]

在步骤s5.3中,对生成的四个特征要素流使用移位插值、代价计算和融合等操作来生成代价体积;

[0044]

在步骤s5.4中,最终成本量是通过对在不同尺度上进行的成本聚合的结果进行自适应组合而得到的;将该算法近似为

[0045][0046]

其中,是跨规模成本聚合后的结果成本量,是刻度k的规模内聚合成本量。fk是一个通用函数,用于实现每个尺度成本量之间的自适应组合;具体地,对于成本量而言:

[0047][0048]

其中,i表示单位函数,(s-k)stride-2 3

×

3卷积用于2

s-k

次下采样以使分辨率一致,而表示首先对相同分辨率的双线性上采样,然后跟随1

×

1卷积以对齐通道数;

[0049]

在步骤s5.5中,使用视图注意力和流注意力两种类型的3d注意力网络,视图注意力模块用于利用相同角度方向的特征通道之间的相互依赖关系,而流注意力模块用于利用不同角度方向的特征通道之间的相互依赖关系;

[0050]

在步骤s5.6中,利用差分soft argmin算子计算加权视差的期望值来回归连续视差得到最终的视差图,如公式(8)中所示:

[0051][0052]

在步骤s5.7中,在模型中采用smooth l1损失函数,该损失函数计算了预测的视差值与真实视差值之间的差异,如公式(9)-(10)所示:

[0053][0054][0055]

其中为预测视差值,gi为真实视差值。

[0056]

步骤s5.8,当loss》ε或i≤imax时,返回步骤s5.1。

[0057]

优选地,所述步骤s5.3的具体过程为:

[0058]

步骤s5.31,移位插值;

[0059]

步骤s5.32,代价计算;

[0060]

步骤s5.33,融合。

[0061]

优选地,在步骤s5.31中,以中心视图的特征要素图作为参考,沿流方向的其他特征图作为目标特征图f

t

,通过视差范围内的每个假设视差目标视图f

t

的特征图向参考视图移位,然后采用双线性插值法对亚像素位置上的每个像素计算合适的值:

[0062][0063]

其中d

min

、d

max

和l分别表示范围内的最小视差、最大视差和离散视差;每个目标视图和参考视图的特征图的尺寸为(l

×

h1×

w1×

c1),其中l表示比例尺级别,c表示通道;

[0064]

在步骤s5.32中,从目标视图流中获取尺度l下的特征图后,使用参考视图和目标视图特征映射之间的连接来计算匹配成本,以形成4d成本卷,如公式(4)和公式(5)所示:

[0065][0066]ci

表示视图i的所有特征通道;

[0067]

在步骤s5.33中,对上一步骤中视图和流之间的计算代价进行融合,融合模块包含分割、拼接融合与和融合操作;

[0068]

具体地,将米字线光场输入分成(n-1)/2组,n为基线的总数,每组具有相同的视图基线,包含了五个视图,包括一个参考视图及其四个方向相邻的目标视图。对于每一组光场图像,首先对所有特征映射跨通道维度进行级联融合,然后对所有组进行和融合,最后的融合输出由水平部分cv_0

°

和垂直部分cv_90

°

组成,尺寸为l

l

×hl

×wl

×

6c。

[0069]

本发明还公开了一种基于宽基线光场成像技术的垃圾堆场三维重建系统,包括:

[0070]

第一模块,用于利用多相机阵列采集垃圾堆场图像;

[0071]

第二模块,利用深度压缩感知技术对采集后的稀疏相机阵列图像恢复全光场图像;

[0072]

第三模块,在重建后的全光场图像中选择多个视角流的图像作为输入数据;

[0073]

第四模块,通过宽基线光场公开数据集llf和垃圾堆场采集到的光场图像序列作为模型训练样本;

[0074]

第五模块,利用模型训练样本训练深度神经网络得到相应的权重与偏置,得到权重与偏置带入验证数据集,计算出验证数据集的预测误差,并保存使训练集预测误差最小的权重和偏置;

[0075]

第六模块,将第五模块中使训练集预测误差最小的权重和偏置带入预测集合中,推理计算得到预测深度值。

[0076]

本发明进一步公开了一种计算机可读存储介质,其上存储有计算机程序,所述计算机程序在被处理器运行时执行如上所述的基于宽基线光场成像技术的垃圾堆场三维重建方法的步骤。

[0077]

本发明还公开了一种计算机设备,包括存储器和处理器,所述存储器上存储有计算机程序,所述计算机程序在被处理器运行时执行如上所述的基于宽基线光场成像技术的垃圾堆场三维重建方法的步骤。

[0078]

与现有技术相比,本发明的优点在于:

[0079]

本发明的整体思路是提出了一种基于深度卷积神经网络(cnn)与宽基线光场相结合的多尺度宽基线光场深度神经网络模型(alfnet),以提取垃圾堆场多尺度的深度特征进行耦合进而预测中心视图的深度图。为了充分获取各个视角深度,提高预测精度,分别选择0

°

、90

°

、45

°

和135

°

四个视角的图像作为输入数据。在第一个网络模块中,采用了resnet残差网络结构,提取了多尺度的深度特征并进行相关联;在第二个网络模块中,在给定四个混合深度特征流的情况下,使用移位插值、代价计算和融合等一系列操作来生成代价体积;在第三个网络模块中引入了六个跨尺度聚合模块,通过融合不同尺度的深度特征进一步提高深度预测精度;在第四个网络模块中,使用3d注意力模块消除部分遮挡问题,同时使用3d编解码器规则化视差维度上的注意力网络的输出;最后引入soft argmin运算符计算加权差异的期望值来回归连续视差。通过构建这五部分模块对垃圾堆场中心视图的视差进行推理,获得更丰富的深度特征信息,进一步提高所构建的alfnet的建模精度。

[0080]

本发明的主要优点之一在于运用了深度压缩感知技术构建了全光场图像恢复网络,通过输入在垃圾堆场采集的3

×

3多相机阵列图像即可恢复9

×

9全光场图像,解决了现有光场相机设备昂贵、场景依赖性强等难点。

[0081]

本发明的主要优点之二在于针对垃圾堆场场景大、相似场景多等特性,采用跨尺度聚合算法。当对图像进行下采样时,在相同的块大小下纹理信息将更具区分性,在低纹理或无纹理区域中,在粗略尺度上搜索对应关系有利于重建质量。因此,本发明在传统的跨尺度成本聚合算法中引入了多尺度交互作用,进一步增强了对垃圾堆场相似场景的纹理识别度,降低误匹配概率。

[0082]

本发明的主要优点之三在于注意力机制的使用。在参考视图中可见的三维真实世界点可能被目标视图中的前景对象所遮挡,这导致难以找到对应关系。利用“目标点在水平视图流中被遮挡,但在垂直视图流中可能被较少遮挡或不被遮挡。对于由多个视图组成的

任何流,目标点在某些目标视图中看不到,但在其他视图中可能可见”的思想,设计了3d注意力模块,包含了视图注意力模块和流注意力模块,充分利用了相同角度方向的特征通道之间的相互依赖关系和不同角度方向(交叉方向)的特征通道之间的相互依赖关系,提高了遮挡物体的深度推理精度。

[0083]

本发明利用光场成像原理设计了宽基线相机阵列采集不同角度的垃圾堆场光场图像并采用深度压缩感知技术恢复全光场图像作为模型的输入的数据采集方法;针对垃圾堆场遮挡性强、场景大等特性,提出了一种基于深度学习的三维重建模型来实现垃圾堆场的实时三维重建,相较于传统的光场三维重建方法拥有更强的泛化性能和更好的实时推理性能;与传统的立体视觉匹配的三维重建方法不同,本方法针对垃圾堆场场景庞大、变化速度快等特点采用了跨尺度耦合和3d卷积块等手段提高了三维重建的实时推理性;同时通过3d注意力机制的使用,进一步克服了垃圾堆场遮挡性强等难点。

附图说明

[0084]

图1是本发明的方法在实施例的流程图。

[0085]

图2是本发明中的深度压缩感知技术恢复全光场图像的流程图。

[0086]

图3是本发明中的恢复全光场图像网络结构图。

[0087]

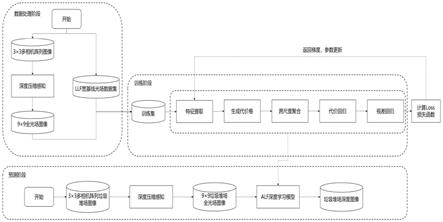

图4是本发明中的alfnet网络结构图。

[0088]

图5是本发明中的alfnet网络中代价融合模块的详细结构图。

[0089]

图6是本发明中的alfnet网络中注意力模块的详细结构图。

[0090]

图7是基于该方法的垃圾堆场三维重建深度预测图。

具体实施方式

[0091]

以下结合说明书附图和具体实施例对本发明作进一步描述。

[0092]

本发明的目的在于提供一种基于宽基线光场成像技术的垃圾堆场三维重建方法,以实现垃圾焚烧厂中垃圾堆场的实时三维建模成像,从而为后续数字孪生系统的搭建及垃圾溯源技术方案的实现奠定基础。

[0093]

如图1所示,本实施例的基于宽基线光场成像技术的垃圾堆场三维重建方法,具体包括步骤:

[0094]

步骤s1,利用3

×

3多相机阵列采集垃圾堆场图像;

[0095]

步骤s2,利用深度压缩感知技术对采集后的稀疏相机阵列图像恢复9

×

9全光场图像;

[0096]

步骤s3,在重建后的9

×

9全光场图像中选择0

°

、90

°

、45

°

和135

°

四个视角流的图像作为输入数据;

[0097]

步骤s4,通过宽基线光场公开数据集llf和垃圾堆场采集到的1000个光场图像序列作为模型训练样本,分成75%的训练数据集,20%的验证数据集,5%的测试数据集;

[0098]

步骤s5,利用训练数据集训练深度神经网络得到相应的权重与偏置,得到权重与偏置带入验证数据集,计算出验证数据集的预测误差,并保存使训练集预测误差最小的权重和偏置;

[0099]

步骤s6,将步骤s5中使训练集预测误差最小的权重和偏置带入预测集合中推理计

算得到预测深度值,完成垃圾堆场的重建。

[0100]

在一具体实施例中,如图2所示,步骤s2具体包括:

[0101]

步骤s2.1,构建全光场恢复网络模型;该网络模型包含初始恢复模型和深度恢复模型,可整体抽象描述为:

[0102]

r(y)=d(i(y))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(1)

[0103]

其中y为步骤s1中3

×

3相机阵列所得采样结果,i为初始恢复过程,d为深度恢复过程(又包含特征提取,非线性映射以及特征聚合),r为整体恢复过程,各部分具体解释如下:

[0104]

初始恢复过程i(y)可以描述为:其中lb2×

nb矩阵为采样矩阵φb的逆矩阵,为恢复的数据;

[0105]

在初始恢复模型中使用无偏差项卷积层来模拟这一过程,可表述为w

int

为lb2个大小为1

×1×

nb的滤波器,步长为1

×

1。中每列都是大小为1

×1×

lb2的的重建向量,对这些向量进行变形与链接处理可得到初始重建光场数据

[0106]

步骤s2.2,进行特征提取运算。该运算被用作从区域性感受野中产生高维度特征,其过程由一个卷积层连接激活层组成,设定卷积层由d个大小为f

×f×

l的滤波器组成。这一过程可以表述为其中we为一系列滤波器,be为大小为d

×

1的偏差项,act(

·

)为激活运算,采用relu激活函数;

[0107]

步骤s2.3,进行非线性映射运算。该运算被用作增加网络非线性及相关感受野,保证重建质量。该运算过程由残差块、卷积层及激活层组成,可表述为:

[0108][0109][0110]

公式中i∈{1,2,3

···

,n}为残差块(使得卷积层的输入输出可以短暂连接),及都包含了d个大小为f

×f×

d的滤波器,及为大小为d

×

1的偏移项,

[0111]

步骤s2.4,进行特征聚合运算。该运算被用作从高维度特征恢复光场数据,该运算过程可表述为其中wa为l个大小为f

×f×

d的滤波器,ba为大小为l

×

1的偏差项;

[0112]

步骤s2.5,在初始重建光场数据与深度重建模型输出之间添加长连接,其目的是为了加速网络聚合,最终的深度重建过程可表述为

[0113]

在一具体实施例中,如图3所示,步骤s5具体包括:

[0114]

步骤s5.1,确定神经网络反向传播的误差阈值ε并设置超参数。设置初始化迭代次数i=0,最大迭代次数为imax;随机初始化各网络层权重矩阵w和偏差β;

[0115]

步骤s5.2,各个分支对输入的图像进行特征提取。该运算被用作从区域性感受野

中产生高维度特征,其过程由三个特征提取卷积模块组成,每个特征提取卷积模块包含一个跨步卷积层、一个2d卷积层、一个批量归一化层以及一个激活层,其中前一卷积层的步长设置为2用于下采样输入,而后者设置为1,采用relu激活函数;

[0116]

步骤s5.3,对提取到的特征要素进行代价卷生成运算。对上述步骤中生成的四个特征要素流使用移位插值、代价计算和融合等操作来生成代价体积;

[0117]

其中步骤s5.3的具体过程为:

[0118]

步骤s5.31,移位插值。以中心视图的特征要素图作为参考,沿流方向的其他特征图作为目标特征图f

t

,通过视差范围内的每个假设视差目标视图f

t

的特征图向参考视图移位(参见公式(4)),然后采用双线性插值法对亚像素位置上的每个像素计算合适的值:

[0119][0120]

其中d

min

、d

max

和l分别表示范围内的最小视差、最大视差和离散视差。每个目标视图和参考视图的特征图的尺寸为(l

×

h1×

w1×

c1),其中l表示比例尺级别,c表示通道。

[0121]

步骤s5.32,代价计算。从目标视图流中获取尺度l下的特征图后,使用参考视图和目标视图特征映射之间的连接来计算匹配成本,以形成4d成本卷,如公式(4)和公式(5)所示:

[0122][0123]

表示视图i的所有特征通道。

[0124]

步骤s5.33,融合。对上一步骤中视图和流之间的计算代价进行融合,融合模块包含分割、拼接融合与和融合操作,旨在融合多个基准成本量的成本,其详细结构如图3和图5所示。为了消除相邻基线之间的图像冗余,采用跨基线融合的方式。具体地说,将米字线光场输入分成(n-1)/2组,n为基线的总数,每组具有相同的视图基线,包含了五个视图,包括一个参考视图及其四个方向相邻的目标视图。对于每一组光场图像,首先对所有特征映射跨通道维度进行级联融合,然后对所有组进行和融合。最后的融合输出由水平部分cv_0

°

和垂直部分cv_90

°

组成,尺寸为l

l

×hl

×wl

×

6c。

[0125]

步骤s5.4,对上述步骤产生的多尺度融合成本量进行自适应跨尺度聚合。最终成本量是通过对在不同尺度上进行的成本聚合的结果进行自适应组合而得到的。将该算法近似为

[0126][0127]

其中,是跨规模成本聚合后的结果成本量,是刻度k的规模内聚合成本量。fk是一个通用函数,用于实现每个尺度成本量之间的自适应组合。

[0128]

具体地说,对于成本量而言:

[0129][0130]

其中,i表示单位函数,(s-k)stride-23

×

3卷积用于2

s-k

次下采样以使分辨率一致,而表示首先对相同分辨率的双线性上采样,然后跟随1

×

1卷积以对齐通道数。

[0131]

步骤s5.5,代价回归。使用视图注意力和流注意力两种类型的3d注意力网络,如图6所示,视图注意力模块用于利用相同角度方向的特征通道之间的相互依赖关系,而流注意力模块用于利用不同角度方向的特征通道之间的相互依赖关系。注意力模块如图4所示,应用全局平均池来捕获成本量的通道级统计信息,然后使用简单的门控机制来捕获成本量的通道相关性。在该门控机制中,视图注意块中的softmax算子负责输出包含每个流中特征的多个不同权重的注意图;流注意块中的sigmoid算子将这两个权重分别分配给来自四个流的特征。因此,成本量的相互依赖的特征被分配给较大的权重,反之亦然。在注意力网络之后,使用3d编解码器网络来规则化视差维度上的注意力网络的输出,该网络由三个三维卷积和两个转置卷积构成。最后,使用双线性插值将输入的大小调整回相同的空间分辨率,输出的维度为l

×h×w×

1。

[0132]

步骤s5.6,视差回归。利用差分soft argmin算子计算加权视差的期望值来回归连续视差得到最终的视差图,如公式(8)中所示:

[0133][0134]

步骤s5.7,计算损失函数用于模型训练的参数优化。在该模型中采用smooth l1损失函数,该损失函数计算了预测的视差值与真实视差值之间的差异,如公式(9)-(10)所示:

[0135][0136][0137]

其中为预测视差值,gi为真实视差值。

[0138]

步骤s5.8,当loss》ε或i≤imax时,返回步骤s5.1。

[0139]

如图7所示,通过上述方法能够实现垃圾堆场的三维重建深度预测。

[0140]

本发明的整体思路是提出了一种基于深度卷积神经网络(cnn)与宽基线光场相结合的多尺度宽基线光场深度神经网络模型(alfnet),如图4所示,以提取垃圾堆场多尺度的深度特征进行耦合进而预测中心视图的深度图。为了充分获取各个视角深度,提高预测精度,分别选择0

°

、90

°

、45

°

和135

°

四个视角的图像作为输入数据。在第一个网络模块中,采用了resnet残差网络结构,提取了多尺度的深度特征并进行相关联;在第二个网络模块中,在给定四个混合深度特征流的情况下,使用移位插值、代价计算和融合等一系列操作来生成代价体积;在第三个网络模块中引入了六个跨尺度聚合模块,通过融合不同尺度的深度特

征进一步提高深度预测精度;在第四个网络模块中,使用3d注意力模块消除部分遮挡问题,同时使用3d编解码器规则化视差维度上的注意力网络的输出;最后引入soft argmin运算符计算加权差异的期望值来回归连续视差。通过构建这五部分模块对垃圾堆场中心视图的视差进行推理,获得更丰富的深度特征信息,进一步提高所构建的alfnet的建模精度。

[0141]

本发明的主要优点之一在于运用了深度压缩感知技术构建了全光场图像恢复网络,通过输入在垃圾堆场采集的3

×

3多相机阵列图像即可恢复9

×

9全光场图像,解决了现有光场相机设备昂贵、场景依赖性强等难点。

[0142]

本发明的主要优点之二在于针对垃圾堆场场景大、相似场景多等特性,采用跨尺度聚合算法。当对图像进行下采样时,在相同的块大小下纹理信息将更具区分性,在低纹理或无纹理区域中,在粗略尺度上搜索对应关系有利于重建质量。因此,本发明在传统的跨尺度成本聚合算法中引入了多尺度交互作用,进一步增强了对垃圾堆场相似场景的纹理识别度,降低误匹配概率。

[0143]

本发明的主要优点之三在于注意力机制的使用。在参考视图中可见的三维真实世界点可能被目标视图中的前景对象所遮挡,这导致难以找到对应关系。利用“目标点在水平视图流中被遮挡,但在垂直视图流中可能被较少遮挡或不被遮挡。对于由多个视图组成的任何流,目标点在某些目标视图中看不到,但在其他视图中可能可见”的思想,设计了3d注意力模块,包含了视图注意力模块和流注意力模块,充分利用了相同角度方向的特征通道之间的相互依赖关系和不同角度方向(交叉方向)的特征通道之间的相互依赖关系,提高了遮挡物体的深度推理精度。

[0144]

本发明还公开了一种基于宽基线光场成像技术的垃圾堆场三维重建系统,包括:

[0145]

第一模块,用于利用多相机阵列采集垃圾堆场图像;

[0146]

第二模块,利用深度压缩感知技术对采集后的稀疏相机阵列图像恢复全光场图像;

[0147]

第三模块,在重建后的全光场图像中选择多个视角流的图像作为输入数据;

[0148]

第四模块,通过宽基线光场公开数据集llf和垃圾堆场采集到的光场图像序列作为模型训练样本;

[0149]

第五模块,利用模型训练样本训练深度神经网络得到相应的权重与偏置,得到权重与偏置带入验证数据集,计算出验证数据集的预测误差,并保存使训练集预测误差最小的权重和偏置;

[0150]

第六模块,将第五模块中使训练集预测误差最小的权重和偏置带入预测集合中,推理计算得到预测深度值。

[0151]

本发明的系统,与上述的方法相对应,同样具有如上方法所述的优点。

[0152]

本发明进一步公开了一种计算机可读存储介质,其上存储有计算机程序,所述计算机程序在被处理器运行时执行如上所述的基于宽基线光场成像技术的垃圾堆场三维重建方法的步骤。本发明还公开了一种计算机设备,包括存储器和处理器,所述存储器上存储有计算机程序,所述计算机程序在被处理器运行时执行如上所述的基于宽基线光场成像技术的垃圾堆场三维重建方法的步骤。本发明实现上述实施例方法中的全部或部分流程,也可以通过计算机程序来指令相关的硬件来完成,计算机程序可存储于一个计算机可读存储介质中,该计算机程序在被处理器执行时,可实现上述各个方法实施例的步骤。其中,计算

机程序包括计算机程序代码,计算机程序代码可以为源代码形式、对象代码形式、可执行文件或某些中间形式等。计算机可读介质可以包括:能够携带计算机程序代码的任何实体或装置、记录介质、u盘、移动硬盘、磁碟、光盘、计算机存储器、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)、电载波信号、电信信号以及软件分发介质等。存储器可用于存储计算机程序和/或模块,处理器通过运行或执行存储在存储器内的计算机程序和/或模块,以及调用存储在存储器内的数据,实现各种功能。存储器可以包括高速随机存取存储器,还可以包括非易失性存储器,例如硬盘、内存、插接式硬盘,智能存储卡(smart media card,smc),安全数字(secure digital,sd)卡,闪存卡(flash card)、至少一个磁盘存储器件、闪存器件、或其它易失性固态存储器件等。

[0153]

以上所述仅为本发明的较佳实施例而已,并非用于限定本发明的保护范围。凡在本发明的精神和原则之内所作的任何修改、等同替换、改进等,均包含在本发明的保护范围内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。