1.本发明涉及一种图像配准方法,具体涉及一种用于多模态图像的无监督配准方法。

背景技术:

2.图像配准是图像处理的一个重要领域,图像配准指的是将两个或多个图像进行几何对齐,使浮动图像上的每一个点在固定图像上都有唯一的点与其对应,目的是寻找不同图像之间的空间变换关系,其目的是去除或者抑制待配准图像之间的几何不一致,图像配准是处理的重要组成部分,是图像融合、分析和目标识别的必要前提.

3.传统的配准方法是一个迭代优化的过程:首先提取图像中的特征信息,将图像间的特征进行匹配,然后选择空间变换方式,得到变换后的图像,计算变换后的图像和固定图像之间相似性,最后选择合适的优化方法不断迭代优化,使得配准后的图像相似性最高。近些年来,基于深度学习的图像配准方法逐渐出现在人们的视野当中,一定程度上克服了传统的配准方法上适用范围窄、计算速度不够快等瓶颈。基于深度学习的图像配准方法主要分为基于监督变换估计的配准和基于无监督学习的配准方法。监督方法首先将固定图像和移动图像输入网络中获得变换参数,根据标准标签数据与变换参数的差值获得损失值,然后将损失值反向传播至网络中迭代以获取更好的效果,最后得到效果良好的输出值。无监督方法配准对输入网络,获得变形场,对移动图像进行变形插值,即得配准图像,使用图像的相似性度量与常见的正则化策略来定义损失函数,使用损失函数梯度对网络做反向传播从而更新网络的参数,获得更好的变形场。

4.无监督学习的直接配准方法在单模图像中已经取得很大的成功,但是处理多模图像的配准却有很多困难。因为不同模态的外观差异很大,直接通过多模图像之间的相似度损失去训练网络效率低,配准精度差,导致在处理多模态配准问题上比处理单模态配准问题要难得多,所以目前无监督配准方法仍多用于处理单模配准问题,在处理多模态图像配准问题时趋于使用半监督的配准方法.。

技术实现要素:

5.本发明的目的在于克服现有技术的不足,提供一种多模态图像的无监督配准方法,所述图像配准方法可以实现对多模态图像的实现无监督学习的图像配准,相比直接用无监督配准的方法,大大提升了配准精度。

6.本发明解决上述技术问题的技术方案是:

7.一种用于多模态图像的无监督配准方法,包括以下步骤:

8.(s1)、使用两种不同成像模式的相机对配准目标主体拍摄两张不同模态的图像。

9.(s2)、任意指定其中一张图像为固定图像,记为a图像,另一张图像为浮动图像,记为b图像。

10.(s3)、将a图像作为风格图像,将b图像作为内容图像输入至可以使图像间颜色、纹

理等转移的卷积神经网络中,利用内容损失和风格损失共同作为损失函数,随后对损失函数的梯度值进行多次的反向传播,当迭代更新图片的次数达到预设值时,停止反向传播过程,获得b图像通过颜色、纹理变换后的c图像。

11.(s4)、将a图像作为固定图像和c图像作为浮动图像输入用于配准的卷积神经网络当中,神经网络的输出是一组变换参数,利用变换参数对浮动图像进行重采样,获得配准后的图像。

12.(s5)、将配准后的图像和固定图像进行相似性度量,将他们的差异值作为损失函数,随后对损失函数的梯度值进行多次的反向传播以更新神经网络的权重和偏置参数,当损失函数值小于预设的停止值时,停止更新神经网络的权重和偏置参数,得到一组能使固定图像与浮动图像对齐的变换参数。

13.(s6)、使用该组变换参数对风格迁移前的b图像进行重采样,获得两张多模态图像配准后的结果。

14.优选的,在步骤(s1)中,不同成像模式的相机与配准主体之间的连线所构成的夹角小于或等于20度。

15.优选的,在步骤(s1)中,所述的两种不同成像模式的相机中的两种不同成像的模式可为短波红外成像、中波红外成像、长波红外成像、光谱成像以及偏振成像等的其中任意两种。

16.优选的,在步骤(s3)中,所述的用于将图像间颜色、纹理等转移的卷积神经网络是由预训练过的vggnet的一些中间层赋予不同的权重组合而成,原理是使用卷积层的中间特征还原出对应这种特征的原始图像,首先选取原始图像,经过vggnet计算后得到各种卷积层特征。接下来,根据这些卷积层的特征,还原出对应这种特征的原始图像。浅层的还原效果往往比较好,卷积特征基本保留了原始图像中形状、位置、颜色、纹理等信息;深层对应的还原图像丢失了部分颜色和纹理信息,但大体保留原始图像中物体的形状和位置,故赋予权重时需要将浅层卷积层赋予比较大的权重,深层卷积赋予比较小的权重。

17.优选的,在步骤(s3)中,所述的图像间颜色、纹理等转移的卷积神经网络的卷积神经网络的损失函数由内容损失和风格损失两部分组成,利用内容损失还原图像内容,用风格损失还原图像风格,内容损失函数包括但不限于均方差损失函数,风格损失函数通过原始图像与生成图像的特征相关性矩阵项之间的均方距离。

18.优选的,在步骤(s3)中,所述的迭代更新图片的次数达到预设的停止值中的停止值至少为15000。

19.优选的,在步骤(s5)中,所述的相似性度量可以选择选择用于比较图像之间相似程度的交叉熵损失函数、归一化互相关函数损失函数、dice损失函数等等;其中,交叉熵损失函数主要用于度量两个概率分布间的差异性;dice损失函数是一种集合相似度度量函数,可用于计算两个样本的相似度。

20.本发明与现有技术相比具有以下的有益效果:

21.本发明用于多模态图像的无监督配准方法将卷积神经网络和无监督配准网络相结合,通过可以将图像间颜色、纹理等转移的卷积神经网络可以将问题从多模态图像无监督配准转变为单模态无监督配准,以便于在后续的无监督配准网络中采用归一化互相关等常用的损失函数也能得到使两张图像对齐即令两者相似性最大的变换参数,得到重采样之

后的配准图像,大大提高多模态图像完成无监督配准时的精度。

附图说明

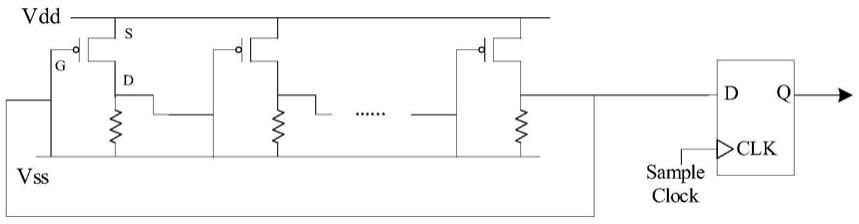

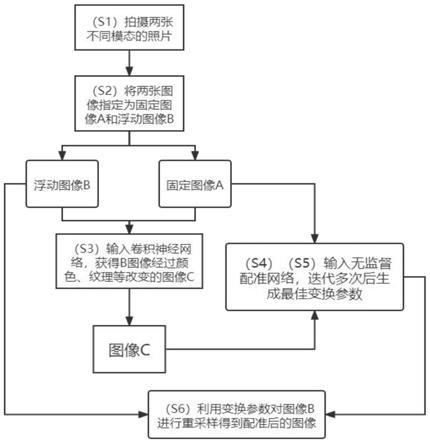

22.图1为本发明的用于多模态图像的无监督配准方法的流程框图。

23.图2为本发明的用于多模态图像的无监督配准方法中用于配准的无监督配准神经网络框架图。

具体实施方式

24.下面结合实施例及附图对本发明作进一步详细的描述,但本发明的实施方式不限于此。

25.参见图1,本发明的用于多模态图像的无监督配准方法包括以下步骤:

26.(s1)、使用两种不同成像模式的相机对配准目标主体拍摄两张不同模态的图像。

27.(s2)、任意指定其中一张图像为固定图像,记为a图像,另一张图像为浮动图像,记为b图像。

28.(s3)、将a图像作为风格图像,将b图像作为内容图像输入至可以使图像间颜色、纹理等转移的卷积神经网络中,利用内容损失和风格损失共同作为损失函数,随后对损失函数的梯度值进行多次的反向传播,当迭代更新图片的次数达到预设值时,停止反向传播过程,获得b图像通过颜色、纹理变换后的c图像。

29.(s4)、将a图像作为固定图像和c图像作为浮动图像输入用于配准的卷积神经网络当中,神经网络的输出是一组变换参数,利用变换参数对浮动图像进行重采样,获得配准后的图像。

30.(s5)、将配准后的图像和固定图像进行相似性度量,将他们的差异值作为损失函数,随后对损失函数的梯度值进行多次的反向传播以更新神经网络的权重和偏置参数,当损失函数值小于预设的停止值时,停止更新神经网络的权重和偏置参数,得到一组能使固定图像与浮动图像对齐的变换参数。

31.(s6)、使用该组变换参数对风格迁移前的b图像进行重采样,获得两张多模态图像配准后的结果。

32.参见图1,在步骤(s3)中,所述的用于将图像间颜色、纹理等转移的卷积神经网络是由预训练过的vggnet的一些中间层赋予不同的权重组合而成,原理是使用卷积层的中间特征还原出对应这种特征的原始图像,首先选取原始图像,经过vggnet计算后得到各种卷积层特征。接下来,根据这些卷积层的特征,还原出对应这种特征的原始图像。浅层的还原效果往往比较好,卷积特征基本保留了原始图像中形状、位置、颜色、纹理等信息;深层对应的还原图像丢失了部分颜色和纹理信息,但大体保留原始图像中物体的形状和位置,故赋予权重时需要将浅层卷积层赋予比较大的权重,深层卷积赋予比较小的权重。

33.参见图1,在步骤(s3)中,所述的图像间颜色、纹理等转移的卷积神经网络的卷积神经网络的损失函数由内容损失和风格损失两部分组成,利用内容损失还原图像内容,用风格损失还原图像风格,内容损失函数包括但不限于均方差损失函数,风格损失函数通过原始图像与生成图像的特征相关性矩阵项之间的均方距离。

34.参见图1,在步骤(s5)中,所述的相似性度量可以选择选择用于比较图像之间相似

程度的交叉熵损失函数、归一化互相关函数损失函数、dice损失函数等等;其中,交叉熵损失函数主要用于度量两个概率分布间的差异性;dice损失函数是一种集合相似度度量函数,可用于计算两个样本的相似度。本实施例中使用的是归一化互相关损失函数。

35.另外,本实施例中所述的两种不同成像模式的相机中的两种不同成像的模式选用的是短波红外成像相机和偏振成像相机。

36.另外,参见图1,在步骤(s1)中,不同成像模式的相机与配准主体之间的连线所构成的夹角小于或等于20度。本实施例中选用的是15度。

37.另外,本实施例中所述的任意指定一张图像作为固定图像,该图像选择了短波红外相机所拍摄的图像。

38.另外,参见图2,本实施例中所述的迭代n次的次数为20000。

39.上述为本发明较佳的实施方式,但本发明的实施方式并不受上述内容的限制,其他的任何未背离本发明的精神实质与原理下所作的改变、修饰、替代、组合、简化,均应为等效的置换方式,都包含在本发明的保护范围之内。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。