1.本公开涉及一种信息处理方法、信息处理设备和程序,并且具体涉及一种使能容易地设计适合于期望任务的神经网络的信息处理方法、信息处理设备和程序。

背景技术:

2.已经有已知的用于深度学习的神经网络。在此类网络中,已经提出了用于从多个选项中搜索最优解的多种技术。

3.例如,专利文献1公开了一种信息处理设备,该信息处理设备基于与被评估的神经网络生成的网络结构不同的另一个神经网络的评估结果来更新被评估的神经网络的最优解。根据专利文献1中描述的信息处理方法,可以更高效地搜索适合于环境的网络结构。

4.此外,最近几年已经看到了可用的服务,这些服务只要给出输入数据和标签就自动设计用于图像识别的深度学习模型,而无需设计用于深度学习(深度学习模型)的神经网络。

5.现有技术文献

6.专利文献

7.专利文献1:pct专利公开号wo2017-154284

技术实现要素:

8.本发明要解决的问题

9.深度学习适用于许多任务,这些任务不仅包括图像识别,还包括生成模型、超分辨率、以及语音/语言处理。

10.然而,目前可用的神经网络的设计技术主要用于图像识别,而未考虑设计适合于其他任务的神经网络。

11.本公开鉴于前述内容而设计,并且本公开的目的是使能容易地设计适合于期望任务的神经网络。

12.问题的解决方案

13.本公开的信息处理方法是一种信息处理方法,该方法包括由信息处理设备接受用户对任务的选择、获取用于学习任务的输入数据、并且将具有适合于所选的任务和所获取的输入数据的结构的神经网络显示为默认模型。

14.本公开的信息处理设备是一种信息处理设备,该信息处理设备包括:接受部,适于接受用户对任务的选择;获取部,适于获取用于学习任务的输入数据;以及显示控制部,适于将具有适合于所选的任务和所获取的输入数据的结构的神经网络显示为默认模型。

15.本公开的程序是用于使得计算机执行以下处理的程序:接受用户对任务的选择,获取用于学习任务的输入数据,并且将具有适合于所选的任务和所获取的输入数据的结构的神经网络显示为默认模型。

16.在本公开中,接受用户对任务的选择,获取用于学习任务的输入数据,并且将具有

适合于所选的任务和所获取的输入数据的结构的神经网络显示为默认模型。

附图说明

17.图1是示出根据本公开实施例的信息处理系统的配置示例的图。

18.图2是示出信息处理设备的配置示例的框图。

19.图3是示出控制部的功能配置示例的框图。

20.图4是示出gui的示例的图。

21.图5是描述自动模型结构搜索处理的流程图。

22.图6是描述自动模型结构搜索处理的流程图。

23.图7是描述自动模型结构搜索处理的流程图。

24.图8是示出gui的示例的图。

25.图9是示出gui的示例的图。

26.图10是示出gui的示例的图。

27.图11是示出gui的示例的图。

28.图12是示出可以为结构搜索设定的参数的示例的图。

29.图13是示出可以为结构搜索设定的参数的示例的图。

30.图14是示出可以为结构搜索设定的参数的示例的图。

31.图15是示出gui的示例的图。

32.图16是示出gui的示例的图。

33.图17是示出可以为结构搜索设定的参数的示例的图。

34.图18是示出gui的示例的图。

35.图19是示出gui的示例的图。

36.图20是示出gui的示例的图。

37.图21是描述模型压缩处理的流程图。

38.图22是描述模型压缩处理的流程图。

39.图23是示出gui的示例的图。

40.图24是示出gui的示例的图。

41.图25是示出gui的示例的图。

42.图26是示出gui的示例的图。

43.图27是示出计算机的硬件配置示例的框图。

具体实施方式

44.下面将给出用于执行本公开的模式(以下被称为实施例)的描述。应注意,将按照以下顺序给出描述。

45.1.系统和设备的配置

46.2.自动模型结构搜索

47.3.模型压缩

48.4.计算机的配置示例

49.《1.系统和设备的配置》

50.(信息处理系统的配置示例)

51.图1是示出根据本公开实施例的信息处理系统的配置示例的图。

52.图1中的信息处理系统包括:信息处理终端10和信息处理服务器30。信息处理终端10和信息处理服务器30经由网络20连接以能够彼此通信。

53.信息处理终端10是用于向用户呈现与神经网络的设计相关联的gui(图形用户界面)的信息处理设备。信息处理终端10包括:pc(个人计算机)、智能电话、平板终端等。

54.信息处理服务器30是信息处理设备,该信息处理设备执行与神经网络的设计相关联的处理,向信息处理终端10供应设计神经网络所需的数据,或者响应于来自信息处理终端10的请求执行其他处理。

55.网络20具有连接信息处理终端10和信息处理服务器30的功能。网络20包括:公共线路网络(诸如互联网、电话线网络和卫星通信网络)包括:以太网(注册商标)和wan(广域网)的各种lan(局域网)等。此外,网络20可以包括:租用线路网络,诸如ip-vpn(互联网协议-虚拟专用网络)。

56.(信息处理设备的配置示例)

57.图2是示出信息处理设备的配置示例的图,该信息处理设备包括在上述信息处理终端10中。

58.图2中的信息处理设备100包括:控制部110、输入部120、显示部130、通信部140、以及存储部150。

59.控制部110包括处理器,该处理器诸如gpu(图形处理单元)和cpu(中央处理单元),并且控制信息处理设备100的每个部。

60.输入部120将适合于用户的动作输入的输入信号供应给控制部110。例如,输入部120不仅被配置为键盘或鼠标,而且还被配置为触摸面板。

61.显示部130在控制部110的控制下显示gui和与神经网络的设计相关联的各种信息。

62.通信部140通过在控制部110的控制下经由网络20与信息处理服务器30通信,而向控制部110供应从信息处理服务器30供应的各种数据。

63.存储部150不仅存储用于由控制部110执行的处理的各种数据,而且还存储由控制部110执行的程序。

64.(控制部的功能配置示例)

65.图3是示出图2中的控制部110的功能配置示例的框图。

66.图3中的控制部110包括:接受部211、获取部212、决定部213、执行部214、以及显示控制部215。控制部110的各个部分作为由包括在控制部110中的处理器执行存储在存储部150中的给定程序的结果而实现。

67.接受部211基于来自输入部120的输入信号接受用户的动作输入。指示接受的用户动作输入的细节的接受信息被供应给控制部110的各个部分。例如,接受部211接受与神经网络的设计相关联的用户输入。

68.获取部212根据来自接受部211的接受信息,经由通信部140获取从信息处理服务器30供应的数据,并且获取存储在存储部150中的数据。由获取部212获取的数据根据需要而供应给决定部213和执行部214。

69.决定部213根据来自接受部211的接受信息,决定将作为候选神经网络呈现给用户的模型。

70.执行部214执行由决定部213决定的模型的结构搜索和压缩,并且基于来自接受部211的接受信息和来自获取部212的数据,使用模型执行学习。

71.显示控制部215控制与神经网络的设计相关联的gui和各种信息在显示部130上的显示。例如,显示控制部215控制由决定部213决定的模型、与模型的结构搜索相关联的信息、使用模型的学习结果等的显示。

72.顺便提及,允许用户直观地设计用于深度学习的神经网络的gui近年来已经为人所知。

73.同时,深度学习适用于许多任务,这些任务不仅包括图像识别,而且还包括生成模型、超分辨率和语音/语言处理。

74.然而,目前可用的gui主要用于图像识别,而没有考虑设计适合于其他任务的神经网络。

75.因此,下面将给出示例的描述,在该示例中提供能够设计适合于广泛任务的神经网络的gui。

76.《2.自动模型结构搜索》

77.首先将给出自动模型结构搜索的描述。自动结构搜索是用于自动搜索用于深度学习的神经网络结构的技术,并且是通过使用给定算法从多个组合中找到最优网络结构的技术。

78.例如,作为用户在信息处理设备100提供的gui中选择用于执行自动模型结构搜索的菜单的结果,启动自动模型结构搜索。

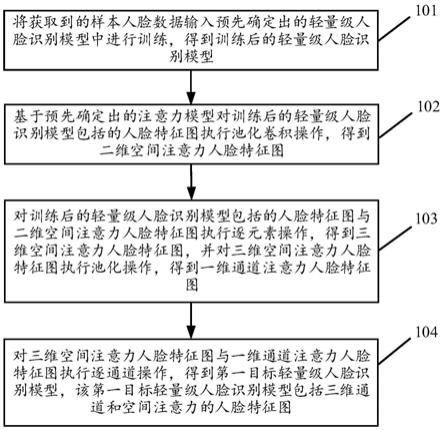

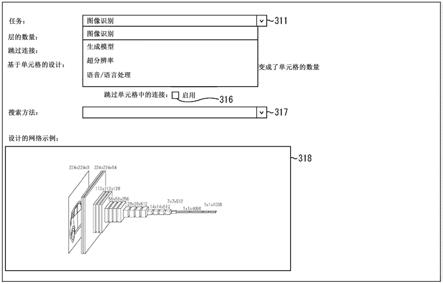

79.图4示出了在选择用于执行自动模型结构搜索的菜单的情况下在显示部130上显示的gui的示例。在下面给出的描述中,如图4所示的屏幕将被称为自动结构搜索执行屏幕。

80.下拉列表311、文本框312、复选框313、复选框314、文本框315、复选框316、以及下拉列表317被设置作为自动结构搜索执行屏幕上的各种gui部分。此外,在下拉列表317下方提供模型显示框318。

81.下拉列表311是用于选择任务的gui部分。这里,术语“任务”是指要通过深度学习来解决的问题,诸如图像识别、生成模型、超分辨率或语音/语言处理。

82.文本框312是用于输入被设为结构搜索的对象的神经网络的演算层数的gui部分。

83.复选框313是用于选择是否使用跳过连接的gui部分。

84.复选框314是用于选择是否执行基于单元格的结构搜索的gui部分。在基于单元格的结构搜索作为在复选框314上执行的动作的结果被选择的情况下,在文本框312中输入的演算层数表示单元格的数量。多个演算层被包括在单元格中。

85.文本框315是用于输入单元格中的节点(演算层)的数量的gui部分。

86.复选框316是用于选择是否在单元格中使用跳过连接的gui部分。

87.应注意,文本框315和复选框316仅在复选框314中选择执行基于单元格的结构搜索的情况下才被激活。

88.下拉列表317是用于选择结构搜索技术的gui部分。

89.模型显示框318是显示被设为结构搜索等的对象的神经网络模型的区域。

90.下面将参考图5至图7所示的流程图,给出在自动结构搜索执行屏幕上显示的各种gui部分的详细描述。

91.在步骤s11中,接受部211通过在下拉列表311上执行动作来接受用户对任务的选择。

92.具体地,如图8所示,在下拉列表311中显示四个任务,即“图像识别”、“生成模型”、“超分辨率”、以及“语音/语言处理”,并且用户可以选择四个任务中的任一者。在图8所示的示例中,选择了“图像识别”。

93.在步骤s12中,确定是否使用默认模型。默认模型是具有预先准备好的网络结构的模型,其被设计为适合于下拉列表311中可选择的任务。

94.在步骤s12中确定将使用默认模型的情况下,处理进行到步骤s13。

95.在步骤s13中,决定部213决定具有适合于在下拉列表311中选择的任务和由获取部212在给定定时获取的输入数据的结构的神经网络作为默认模型。然后,显示控制部215在模型显示框318中显示确定的默认模型。

96.输入数据可以是由用户预先准备好的数据或者从信息处理服务器30供应的数据。

97.此时,具有不仅适合于选择的任务和获取的输入数据而且还适合于信息处理设备100的硬件信息的结构的神经网络可以被决定并显示为默认模型。这里,术语“硬件信息”包括:与信息处理设备100的控制部110中包括的处理器的处理能力相关联的信息、以及与处理器数量相关联的信息。

98.在图8的示例中,在下拉列表311中选择“图像识别”。因此,在模型显示框318中将用于提取图像特征量的特征提取器(编码器)显示为适合于“图像识别”的默认模型。

99.此外,在如图9所示的下拉列表311中选择“超分辨率”的情况下,在模型显示框318中将自动编码器中包括的编码器和解码器显示为适合于“超分辨率”的默认模型。

100.应注意,可以仅使用模型显示框318中显示的默认模型的演算层中的一些作为稍后将描述设为结构搜索层的对象。例如,如果由用户在模型显示框318中的拖动动作指定给定区域,则如图10所示,在模型显示框318中显示边界框321。在这种情况下,仅由边界框321包围的默认模型的演算层设为结构搜索的对象。

101.此外,尽管未示出,但在下拉列表311中选择了“生成模型”的情况下,在模型显示框318中将解码器显示为适合于“生成模型”的默认模型。此外,在下拉列表311中选择“语音/语言处理”的情况下,在模型显示框318中将具有递归神经网络(rnn)结构的模型显示为适合于“语音/语言处理”的默认模型。

102.这里,在模型显示框318中显示的默认模型的数量不限于一个,并且接受部211响应于用户的动作接受显示的默认模型到其他默认模型的改变。这允许设为结构搜索的对象的候选模型被切换并且在模型显示框318中显示。

103.在步骤s14中,接受部211接受用户对默认模型的选择。这允许确认设为结构搜索的对象的默认模型。

104.另一方面,在步骤s12中确定将不使用默认模型的情况下,处理进行到步骤s15,并且接受部211接受用户的模型设计。用户设计的模型与默认模型一样显示在模型显示框318中。

105.在步骤s14中确认默认模型之后,或者在步骤s15中设计模型之后,处理进行到步

骤s16。

106.在步骤s16中,显示控制部215显示在模型显示框318中显示的模型以及该模型的网络结构的粗略轮廓。具体地,显示控制部215将模型显示框318中显示的模型的搜索空间大小和近似计算量显示为网络结构的粗略轮廓。

107.此后,在步骤s17中,响应于用户的动作,确定是否向模型显示框318中显示的模型添加演算层。也就是说,接受部211确定是否接受向默认模型添加演算层。

108.在步骤s17中确定将添加演算层的情况下,处理进行到图6中的步骤s18,并且确定是否使用预设演算层。

109.在步骤s18中确定将使用预设演算层的情况下,接受部211在步骤s19中接受用户对预设演算层的选择,并且处理返回到步骤s17。

110.另一方面,在步骤s18中确定将不使用预设演算层的情况下,接受部211在步骤s20中接受用户对演算层的设计,并且处理返回到步骤s17。

111.现在,如果在步骤s17中确定将不添加演算层,则处理进行到图7中的步骤s21。

112.在步骤s21中,显示控制部215根据模型显示框318中显示的模型,在下拉列表317中显示结构搜索技术的选项。具体地,显示控制部215优选地在下拉列表317中显示适合于在下拉列表311中选择的任务和由获取部212在给定定时获取的输入数据的结构搜索技术。

113.例如,如图11所示,下拉列表317中显示典型的结构搜索技术(诸如“强化学习”、“遗传算法”和“梯度方法”),并且用户可以选择这些结构搜索技术中的任一种。

114.例如,对于通过强化学习进行结构搜索,在“b.zoph,v.vasudevan,j.shlens,and q.v.le.learning transferable architectures for scalable image recognition.in cvpr,2018”中提出了nasnet,在“h.pham,m.y.guan,b.zoph,q.v.le,and j.dean.efficient neural architecture search via parameter sharing.in icml,2018”中提出了enas,并且使用了其他技术。例如,对于遗传算法的结构搜索,在“e.real,a.aggarwal,y.huang,and q.v.le.regularized evolution for image classifier architecture search.in aaai,2019”中提出了amoebanet,并且使用了其他技术。此外,例如,对于通过梯度法的结构搜索,在“h.liu,k.simonyan,and y.yang.darts:differentiable architecture search.in iclr,2019”中提出了darts,在“s.xie,h.zheng,c.liu,and l.lin.snas:stochastic neural architecture search.in iclr,2019”中提出了snas,并且使用了其他技术。

115.此时,不仅适合于选择的任务和获取的输入数据,而且适合于信息处理设备100的硬件信息的结构搜索技术可以优先显示在下拉列表317中。

116.在步骤s22中,接受部211接受通过用户对下拉列表317的动作而做出的结构搜索技术的选择。在图11的示例中,选择了“强化学习”。

117.此后,在步骤s23中,接受部211接受在下拉列表317中选择的结构搜索技术的设定输入。此时,例如,如图11所示,用于输入结构搜索技术的设定的设定输入部331显示在模型显示框318的右侧上。由用户在设定输入部331中输入可以针对下拉列表317中选择的结构搜索技术设定的参数。

118.这里将参考图12至图14描述可以针对结构搜索技术设定的参数的示例。

119.图12示出了可以针对通过强化学习的结构搜索设定的参数的示例。

120.可以针对通过强化学习的结构搜索设定的参数包括:rnn/lstm层的数量、子网络的数量、控制器学习率、架构参数优化器、搜索计数、以及子网络学习计数。

121.rnn/lstm层数是用于强化学习的rnn或lstm(长短期存储器)的演算层的数量,lstm是rnn的一种、并且通过输入int类型数字来设定。

122.子网络的数量是从控制器一次输出的子网络(候选网络)的数量,控制器将是用于预测主网络结构的父网络,并且通过输入int类型数字来设定。

123.控制器学习率是与上述控制器执行的学习相关联的参数,并且通过输入浮点(float)类型数字来设定。

124.架构参数优化器是一种学习率调整技术,并且通过下拉(下拉列表)选择设定。“adam”、“sgd”、“momentum”等都准备好为选项。

125.搜索计数是执行的搜索数量,并且通过输入整数(int)类型数字来设定。

126.子网络学习计数是每次搜索的子网络的纪元数量(训练数据被重复学习的数量),并且通过输入int类型数字来设定。

127.图13示出了可以针对通过包括遗传算法的进化计算的结构搜索设定的参数的示例。

128.关于通过使用多个候选网络执行学习的进化计算的结构搜索,可以设定的参数包括:存储的模型数量、学习计数、群体数量、样本数量、以及突变模式。

129.存储的模型数量是要存储的生成的候选网络(模型)的数量,并且通过输入int类型数字来设定。存储的模型数量约等于搜索计数。

130.学习计数是生成的模型的纪元数量,并且通过输入int类型数字来设定。

131.群体数量是群体大小,并且通过输入int类型数字来设定。

132.样本数是当选择了突变模型时从当前群体采样的模型数量,并且通过输入int类型数字来设定。

133.突变模式是一种突变模式,并且通过下拉(下拉列表)的选择设定。“演算和输入节点”、“仅演算”、“仅输入节点”等作为选项准备就绪。

134.图14示出可以针对通过梯度方法的结构搜索设定的参数的示例。

135.可以针对通过梯度方法的结构搜索设定的参数包括:搜索计数、架构参数学习率、以及架构参数优化器。

136.搜索计数是与学习计数一样的生成模型的纪元数量,并且通过输入int类型数字来设定。

137.架构参数学习率是与由生成的模型执行的学习相关联的参数,并且通过输入浮点类型数字来设定。

138.架构参数优化器是一种学习率调整技术,并且通过下拉(下拉列表)的选择设定。“adam”、“sgd”、“momentum”等都准备好为选项。

139.根据选择的结构搜索技术,可以在设定输入部331中设定如上所述的参数。

140.返回参考图7中的流程图,当结构搜索技术的设定被输入时,在步骤s24中,显示控制部215根据所选的结构搜索技术,在例如模型显示框318中的给定位置处,显示用设定的参数进行结构搜索所需的预测时间。

141.此后,在步骤s25中确定是否改变结构搜索技术的设定。

142.在步骤s25中确定将改变结构搜索技术的设定的情况下,处理返回到步骤s23,并且重复步骤s23和s24中的处理。

143.另一方面,在步骤s25中确定不会改变结构搜索技术的设定的情况下,处理进行到步骤s26。

144.在步骤s26中,执行部214用设定的参数启动结构搜索。

145.当结构搜索的执行结束时,在步骤s27中,显示控制部215显示具有在模型显示框318中搜索到的结构的模型。

146.此后,在步骤s28中确定是否执行进一步的结构搜索。

147.在步骤s28中确定将执行进一步的结构搜索的情况下,处理返回到步骤s26,并且重复步骤s26和s27中的处理。

148.另一方面,在步骤s28中确定将不执行进一步的结构搜索的情况下,处理终止。

149.根据上述处理,不仅可以选择诸如图像识别的任务,还可以选择生成模型、超分辨率和语音/语言处理,并且具有适合于选择的任务和获取的输入数据的结构的神经网络被显示为默认模型。此外,可以选择近年来提出的各种结构搜索技术,并且通过选择的结构搜索技术来执行结构搜索。

150.这使得能够容易地设计适合于期望任务的神经网络,并且通过扩展,使得能够优化适合于广泛任务的神经网络的结构。

151.(基于单元格的结构搜索示例)

152.尽管上面已经给出了在不执行基于单元格的结构搜索的情况下的gui的示例的描述,但是下面将给出在执行基于单元格的结构搜索的情况下的gui的示例的描述。

153.图15示出在执行基于单元格的结构搜索的情况下的gui的示例。

154.在图15的自动结构搜索执行屏幕中,基于单元格的结构搜索的执行被选择作为在复选框314上执行的动作的结果。

155.此外,在图15的自动结构搜索执行屏幕上提供模型显示框341和单元格显示框342,而不是上述自动结构搜索执行屏幕上的模型显示框318。

156.模型显示框341是显示作为整体要经受结构搜索的神经网络模型的区域。模型显示框341中显示的模型是包括多个单元格(单元框)的单元格累积模型。

157.此外,模型显示框341将模型显示框341中显示的模型的搜索空间大小和近似计算量显示为网络结构的粗略轮廓,并与包括多个单元格的模型一起显示。

158.单元格显示框342是显示设为结构搜索的对象的单元格的区域,单元格包括在模型显示框341中显示的模型中。在单元格显示框342中显示的单元格包括多个演算层。

159.在图15的自动结构搜索执行屏幕中,可以显示最差计算量等的粗略估计,以允许用户指定准许的计算量。这使得可以考虑对计算量的限制来执行结构搜索。

160.图16示出用于设定模型显示框341中显示的模型结构和显示在单元格显示框342中的单元格结构的设定屏幕的示例。例如,作为在模型显示框341或单元格显示框342的给定区域上执行的点击动作的结果,图16中的设定屏幕350在自动结构搜索执行屏幕上弹出。

161.在设定屏幕350上设置了文本框351、文本框352、文本框353和文本框354、以及下拉列表355。

162.文本框351是用于输入模型显示框341中显示的模型中包括的单元格的数量的gui

部分。

163.文本框352是用于输入模型显示框341中显示的模型中包括的单元格类型的数量的gui部分。

164.文本框353是用于输入在单元格显示框342中显示的单元格中的节点(演算层)的数量的gui部分。

165.文本框354是用于输入在单元格显示框342中显示的单元格中每个节点的输入数量的gui部分。

166.下拉列表355是用于在输出节点选择归约计算技术的gui部分。例如,在下拉列表355中显示三种归约计算技术,即“逐元素添加”、“连接”和“平均”,并且用户可以选择三种归约计算技术中的任一种。

167.以此类方式指定的设定细节实时反映模型显示框341中显示的模型和单元格显示框342中显示的单元格上。

168.应注意,根据设定屏幕350中的设定,不仅可以构建单元格累积模型,还可以构建多层前馈神经网络。尽管未示出,但是可以构建例如单元格的数量为1、单元格中的节点数量为8、并且单元格中每个节点的输入数量为1的模型。

169.此外,尽管已经描述了根据选择的结构搜索技术来设定用于结构搜索的参数,但是也可以设定独立于结构搜索技术的参数。

170.图17示出了独立于所选结构搜索技术并且可以为一般结构搜索进行设定的参数的示例。

171.可以为一般结构搜索设定的参数包括:模型学习率、模型参数优化器、以及特征映射的数量。

172.模型学习率是与通过经受结构搜索的模型所执行的学习相关联的参数,并且通过输入浮点类型数字来设定。

173.模型参数优化器是一种模型学习率调整技术,并且通过下拉(下拉列表)的选择设定。“adam”、“sgd”、“momentum”等都准备好为选项。

174.特征映射的数量是构建的模型的第一个单元格中的隐藏层过滤器的数量,并且通过输入int类型数字来设定。

175.无论选择的结构搜索技术如何,都可以设定此类参数。

176.(搜索空间的定义)

177.用户可以从预设演算层中选择用于结构搜索的演算层。

178.图18示出了当用户从预设演算层中选择要用于结构搜索的演算层时显示的屏幕的示例。

179.在图18中,选择部361设定在屏幕的区域360的上边缘。在选择部361中演算层的类型显示为选项。在图18的示例中,“affine”、“convolution”、“depthwiseconvolution”和“deconvolution”显示为选项,并且选择了“convolution”。

180.选择部362被设置在选择部361的下方。在选择部362中,预设为在选择部361中选择的类型的演算层显示为选项。在图18的示例中,“convolution_3

×

3”、“convolution_5

×

5”、“convolution_7

×

7”、“maxpooling_3

×

3”、以及“averagepooling_3

×

3”显示为选项。

181.包括从预设演算层中选择的演算层的模型显示在图18中的屏幕的区域370中。图

18中的示例显示包括输入层和卷积层的模型。

182.此外,用户可以唯一地定义用于结构搜索的演算层。

183.图19示出了当用户唯一地定义要用于结构搜索的演算层时显示的屏幕的示例。

184.设定部363设定在图19中屏幕的区域360的下部。例如,作为未示出计算添加按钮的按下的结果,显示设定部363。用户选择的演算层的各种参数显示在设定部363中。

185.用户可以通过在设定部363中将期望值设定为演算层的参数来唯一地定义要用于结构搜索的演算层。

186.应注意,在单元格累积模型的结构搜索中,有必要通过单元格中的计算来确保输入和输出大小保持不变。因此,可以由用户在设定部363中设定的参数可以限于参数中的一些,然后可以根据参数中的这些参数的设定自动设定其他参数。例如,对于卷积层的参数,通过设定滤波器大小来自动设定滤波器大小以外的参数。

187.(结构搜索执行结果)

188.当结构搜索的执行如上所述结束时,显示具有搜索到的结构的网络。

189.图20示出了显示了上述单元格累积模型的结构搜索执行结果的屏幕的示例。

190.在图20的示例中,具有搜索到的结构的模型和单元格在模型显示框341和单元格显示框342中显示。

191.此外,除了具有搜索到的结构的模型和单元格之外,还可以显示精度、计算量等。在图20的示例中,在单元格显示框342的上方设定精度/计算量显示部381。精度、参数数量(大小)、flops(每秒浮点运算)、功耗和中间缓冲器(大小)显示在精度/计算量显示部381中。

192.用户可以通过确认精度/计算量显示部381中显示的精度、计算量等来确定是否再次执行结构搜索。

193.特别地,没有考虑在与现有神经网络的设计相关联的gui中执行结构搜索的硬件的计算量的限制。

194.相比之下,根据上述配置,可以通过简单的动作实现考虑对计算量的限制的结构搜索。

195.《3.模型压缩》

196.接下来将给出模型压缩的描述。模型压缩是通过简化神经网络中的结构来降低计算成本的技术,并且作为示例,实现具有小规模网络等的大规模复杂网络的性能的净化(distillation)是已知的。

197.例如,作为用户在信息处理设备100提供的gui中选择用于执行模型压缩的菜单的结果,模型压缩被启动。此外,如图20所示,模型压缩可以作为选择按钮等的结果来启动,以用于在显示结构搜索执行结果的屏幕中执行模型压缩。

198.图21和图22描绘了描述模型压缩处理的流程图。

199.在步骤s51中,获取部212读取作为经受压缩的模型的基础模型。基础模型可以是预先设计的模型或执行上述结构搜索后的模型。

200.在步骤s52中,确定是否向读取的模型添加演算层。

201.在确定将演算层添加到基础模型的情况下,处理进行到步骤s53,并且接受部211接受将演算层添加到基础模型。

202.重复步骤s52和s53,直到确定不会将演算层添加到基础模型,并且当确定不会将演算层添加到基础模型时,处理进行到步骤s54。

203.在步骤s54中,显示控制部215显示当前压缩设定。

204.随后,在步骤s55中确定是否响应于用户动作改变压缩设定。

205.在步骤s55中确定压缩设定将被改变的情况下,处理进行到步骤s56,并且接受部211接受演算层的选择。此时,接受部211接受基础模型压缩技术的选择。

206.接下来,在步骤s57中,接受部211接受选择的演算层的压缩设定输入。此时,输入用于压缩所选演算层的条件作为压缩设定。在步骤s57之后,处理返回到步骤s55。

207.以此类方式确定所选演算层的压缩设定。

208.另一方面,在步骤s55中确定不会改变压缩设定的情况下,处理进行到图22中的步骤s58。

209.在步骤s58中,执行部214基于为每个演算层指定的压缩设定来执行模型压缩。

210.在步骤s59中,执行部214计算每个演算层的压缩率。此时,显示控制部215显示每个演算层的压缩率作为压缩结果。

211.在步骤s60中,执行部214确定为每个演算层计算的压缩率是否满足为每个演算层设定的压缩条件。

212.在确定压缩率不满足条件的情况下,处理返回到步骤s58,并且重复模型压缩的执行和压缩率的计算。

213.另一方面,在确定压缩率满足条件的情况下,处理进行到步骤s61。

214.在步骤s61中,确定是否响应于用户动作对基础模型执行进一步压缩。

215.在确定将执行进一步压缩的情况下,处理返回到图21中的步骤s55,并且重复后续处理。

216.另一方面,在步骤s61中确定不会执行进一步压缩的情况下,处理进行到步骤s62,并且执行部214存储压缩的模型并且终止处理。

217.(gui的示例)

218.下面将给出在模型压缩处理中在显示部130中显示的gui的示例的描述。

219.图23示出了其中指定了与模型压缩相关联的设定的屏幕的示例。

220.在图23中,下拉列表411和按钮412被提供在屏幕的区域410的下部。下拉列表411是用于选择压缩技术的gui部分。

221.下拉列表411中显示了三种压缩技术,即“修剪”、“量化”和“净化”,并且用户可以选择三种压缩技术中的任一种。

222.按钮412是用于通过下拉列表411中选择的压缩技术来执行压缩的gui部分。

223.在图23的屏幕的区域420中,显示设为压缩对象的基础模型421。在基础模型421的右侧指示基础模型421中包括的每个演算层的计算量。当假设全部存储器使用为100%时,每个演算层的计算量被指示为每个演算层的存储器使用的比率。

224.用户可以通过确认基础模型421中包括的每个演算层的计算量来找出哪个演算层可以是基础模型421中的瓶颈。

225.此外,对于使用在下拉列表411中选择的压缩技术的压缩,可以由用户设定作为精度劣化容许程度的指标的精度劣化容许值和目标压缩率。

226.在图23的示例中,可以渲染包括在基础模型421中的全部演算层,或者仅渲染设为压缩对象的演算层中的一些。

227.图24示出了为包括在基础模型421中的每个演算层指定压缩设定的示例。

228.在图24中,从包括在基础模型421中的演算层中,选择“affine_3”层,并且显示子屏幕431。子屏幕431是用于为所选演算层的每个指标(即,延时、存储器、中间缓冲器和功耗)设定准许范围(压缩条件)的屏幕。

229.在子屏幕431中提供用于启用每个指标的准许范围设定的单选按钮和用于输入准许范围的最小值和最大值的文本框。通过启用准许范围的设定并且输入准许范围的最小值和最大值来设定与所选演算层相关联的压缩条件。

230.图25和图26示出了显示压缩结果的屏幕的示例。

231.在图25和图26中的每个屏幕的区域410的下部设置了用于选择显示压缩结果的指标的指标选择部441和用于显示由压缩产生的精度变化率的精度变化率显示部442。

232.在图25和图26中的每个屏幕的区域420中设为压缩对象的基础模型421的右侧指示在基础模型421中包括的每个演算层的压缩结果。在指标选择部441中选择的指标的压缩率被指示为每个演算层的压缩结果。

233.具体地,在图25中的示例中,在指标选择部441中选择了存储器,并且存储器的压缩率被指示为包括在基础模型421中的每个演算层的压缩结果。

234.此外,在图26的示例中,在指标选择部441中选择了功耗,并且功耗的压缩率被指示为包括在基础模型421中的每个演算层的压缩结果。

235.这使得用户能够确定哪个演算层将进一步设为压缩的对象。

236.根据上述处理,不仅可以对已经执行结构搜索的模型执行压缩,还可以对现有模型执行压缩,从而允许降低计算成本。

237.上面已经描述了在被配置为信息处理设备100的信息处理终端10上执行与自动模型结构搜索和模型压缩相关联的处理和gui显示。然而,本公开不限于此,信息处理服务器30可以包括信息处理设备100,并且可以在信息处理服务器30上执行与自动模型结构搜索和模型压缩相关联的处理,并且可以在信息处理终端10上执行仅gui显示。此外,由上述信息处理设备100执行的各个处理由图1中的信息处理系统的信息处理终端10或信息处理服务器30来执行就足够了。

238.《4.计算机配置示例》

239.可以通过硬件或软件来执行上述一系列处理。在通过软件执行一系列处理的情况下,包括在软件中的程序从程序记录介质安装到并入专用硬件的计算机、通用个人计算机等。

240.图27是示出通过程序执行上述一系列处理的计算机的硬件配置示例的框图。

241.上述信息处理设备100由具有图27所示配置的计算机1000实现。

242.cpu 1001、rom 1002、以及ram 1003通过总线1004相互连接。

243.输入/输出接口1005也连接到总线1004。包括键盘、鼠标等的输入部1006和包括显示器、扬声器等的输出部1007连接到输入/输出接口1005。此外,包括硬盘、非易失性存储器等的存储部1008、包括网络接口的通信部1009、以及驱动可移动介质1011的驱动器1010连接到输入/输出接口1005。

244.在如上所述的配置的计算机1000中,例如,作为由cpu 1001经由输入/输出接口1005和总线1004将存储在存储部1008中的程序加载和执行到随机存取存储器1003中的结果,执行上述一系列处理。

245.由cpu 1001执行的程序例如以记录在可移动介质1011上的方式或者经由诸如局域网、互联网或数字广播的有线或无线传输介质来提供,并且被安装到存储部1008。

246.应注意,由计算机1000执行的程序可以是根据本说明书中描述的顺序按时间顺序执行处理的程序,或者并行地或在必要的时刻(诸如当程序被调用时)执行处理的程序。

247.应注意,本技术的实施例不限于上述实施例并且可以在不脱离本技术的主旨的情况下以各种方式进行修改。

248.此外,在本说明书中描述的有利效果仅是说明性的而不是限制性的,并且可能存在其他有利效果。

249.此外,本公开可以具有以下配置。

250.(1)

251.一种信息处理方法,包括:

252.由信息处理设备:

253.接受用户对任务的选择;

254.获取用于学习任务的输入数据;并且

255.显示具有适合于所选的任务和所获取的输入数据的结构的神经网络作为默认模型。

256.(2)

257.特征(1)的信息处理方法,还包括:

258.将具有不仅适合于该任务和输入数据而且适合于信息处理设备的硬件信息的结构的神经网络显示为默认模型。

259.(3)

260.特征(2)的信息处理方法,其中,

261.硬件信息包括与处理器的处理能力相关联的信息。

262.(4)

263.特征(2)的信息处理方法,其中,

264.硬件信息包括与处理器的数量相关联的信息。

265.(5)

266.特征(1)至(4)中任一项的信息处理方法,还包括:

267.与默认模型一起显示默认模型的搜索空间大小和近似计算量中的至少一者。

268.(6)

269.特征(1)至(5)中任一项的信息处理方法,还包括:

270.接受用户对默认模型的更改。

271.(7)

272.特征(6)的信息处理方法,还包括:

273.接受向默认模型添加演算层。

274.(8)

275.特征(1)至(7)中任一项的信息处理方法,还包括:

276.优先显示适合于该任务和输入数据的结构搜索技术,作为神经网络的结构搜索技术的选项。

277.(9)

278.特征(8)的信息处理方法,还包括:

279.优先显示不仅适合于该任务和输入数据、而且适合于信息处理设备的硬件信息的结构搜索技术。

280.(10)

281.特征(8)或(9)的信息处理方法,还包括:

282.接受用户从选项中选择的结构搜索技术的设定输入。

283.(11)

284.特征(8)至(10)中任一项的信息处理方法,还包括:

285.根据用户从选项中选择的结构搜索技术,显示结构搜索所需的预测时间。

286.(12)

287.特征(8)至(11)中任一项的信息处理方法,还包括:

288.执行基于用户从选项中选择的结构搜索技术的结构搜索;并且

289.显示具有搜索到的结构的神经网络。

290.(13)

291.特征(12)的信息处理方法,其中

292.将用户在神经网络中选择的演算层设为结构搜索的对象。

293.(14)

294.特征(12)的信息处理方法,其中

295.将在神经网络中包括的单元格设为结构搜索的对象。

296.(15)

297.特征(1)至(14)中任一项的信息处理方法,还包括:

298.还接受对神经网络的压缩技术的选择。

299.(16)

300.特征(15)的信息处理方法,还包括:

301.针对神经网络的演算层,接受针对用户选择的每个指标的压缩条件的设定。

302.(17)

303.特征(16)的信息处理方法,还包括:

304.通过所选择的压缩技术压缩神经网络;并且

305.显示演算层的压缩结果。

306.(18)

307.特征(17)的信息处理方法,还包括:

308.对于用户选择的指标,显示演算层的压缩率。

309.(19)

310.一种信息处理设备,包括:

311.接受部,适于接受用户对任务的选择;

312.获取部,适于获取用于学习任务的输入数据;并且

313.显示控制部,适于显示具有适合于所选的任务和所获取的输入数据的结构的神经网络作为默认模型。

314.(20)

315.一种程序,该程序使计算机执行以下处理:

316.接受用户对任务的选择;

317.获取用于学习任务的输入数据;并且

318.显示具有适合于所选的任务和所获取的输入数据的结构的神经网络作为默认模型。

319.附图标记列表

320.10:信息处理终端

321.30:信息处理服务器

322.100:信息处理设备

323.110:控制部

324.120:输入部

325.130:显示部

326.140:通信部

327.150:存储部

328.211:接受部

329.212:获取部

330.213:决定部

331.214:执行部

332.215:显示控制部

333.1000:计算机。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。