1.本公开大体上涉及地图处理领域,且更明确地说涉及一种基于大数据的高精地图制作系统。

背景技术:

2.高精地图是用于自动驾驶的专用地图,在精确定位中扮演着核心角色,高精度地图由含有语义信息的车道模型、道路部件、道路属性等矢量信息,以及用于多传感器定位的特征图层构成,自动驾驶汽车在高精度地图的辅助下更容易判断自身位置,可行驶区域、目标类型、行驶方向、前车相对位置、红绿灯状态及行驶车道等信息,同时,还可以辅助汽车预先感知坡度、曲率、航向等路面复杂信息,再结合路径规划算法,让汽车做出正确决策,因此,高精地图是保障自动驾驶安全性与稳定性的关键,在自动驾驶的感知、定位、规划、决策、控制等过程中都发挥着重要作用。

3.现在已经开发出了很多地图制作系统,经过我们大量的检索与参考,发现现有的地图制作系统有如公开号为kr101223245b1,kr100722365b1、cn106097444b和kr101312652b1所公开的系统,获取用于生成高精地图的三维激光点云数据以及网格地图的相关信息;确定所述三维激光点云数据中每个三维激光点数据在所述网格地图中的位置信息;对所述网格地图中的每个像素点,使用所述三维激光点云数据中相应的三维激光点数据的反射值渲染该像素点,从而生成所述网格地图中的各个网格图像;采用机器学习算法,对所述网格地图中的每个网格图像,识别该网格图像中的交通信息;对所述网格地图中各个网格图像的交通信息聚类,得到所述网格地图的交通信息;将所述网格地图的交通信息加载到所述网格地图中以生成高精地图。但该系统生成的地图精度不够高,仍存在提高空间。

技术实现要素:

4.本发明的目的在于,针对所存在的不足,提出了一种基于大数据的高精地图制作系统,

5.本发明采用如下技术方案:

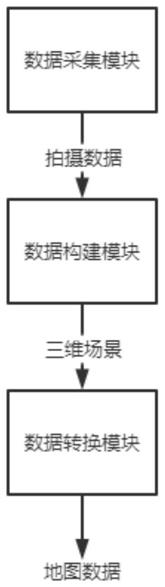

6.一种基于大数据的高精地图制作系统,包括数据采集模块、数据构建模块和数据转换模块,所述数据采集模块用于拍摄目标区域的视频,所述数据构建模块用于对拍摄的数据进行处理构建成三维模型,所述数据转换模块用于对三维模型进行转换形成地图数据;

7.所述数据构建模块包括对象识别单元、对象定位单元、对象管理单元、对象建模单元和场景展示单元,所述对象识别单元用于识别视频中的独立个体,所述独立个体称为对象,所述对象定位单元用于确定对象的位置信息,所述对象管理单元用于存储对象的所有信息,所述对象建模单元用于建立每个对象的三维模型,所述场景展示单元用于将所有对象的三维模型搭建成一个区域三维场景;

8.所述对象定位单元以一个对象作为坐标原点,并根据视频数据依次计算出其余对象的坐标信息,坐标计算公式为:

[0009][0010]

其中,(x,y)为需要计算的对象坐标,(x0,y0)为已知的对象坐标,r为这两个坐标之间的直线距离,θ为两对象的坐标连线与x轴正方向之间的夹角;

[0011]

所述区域三维场景搭建完成后,设置虚拟相机,所述虚拟相机以与数据采集模块相同的拍摄参数对区域三维场景进行拍摄,得到对照视频,所述对象定位单元根据对照视频和数据采集模块拍摄的主视频进行比较,对每个对象的坐标进行修正得到横坐标修正量和纵坐标修正量,修正公式为:

[0012][0013][0014]

其中,x1(t)是对象出现在对照视频中的横坐标的时间函数,y1(t)是对象出现在对照视频中的纵坐标的时间函数,x2(t)是对象出现在主视频中的横坐标的时间函数,y2(t)是对象出现在主视频中的纵坐标的时间函数,t1是对象同时出现在主视频和对照视频中的最早时间,t2是对象同时出现在主视频和对照视频中的最晚时间,k为比例参数;

[0015]

进一步的,所述对象识别单元采用边缘算法识别出疑似个体,当两个疑似个体在所有画面中均处于相连状态时,将这两个疑似个体合并成一个个体并作为一个独立的对象;

[0016]

进一步的,所述数据采集模块拍摄的视频包括空中拍摄视频和地面拍摄视频,将空中拍摄视频中的一条视频作为主视频,其余视频作为辅视频;

[0017]

进一步的,通过地面拍摄视频确定r,在地面拍摄过程中,两对象在画面中的距离在发生变化,当画面距离l最大时,拍摄者处在两对象连线的中垂线上,此时测量对象与拍摄者的距离为s,两对象与拍摄者的夹角为α,则两对象之间的距离r为:

[0018][0019]

进一步的,通过空中拍摄视频确定θ,在空中拍摄过程中,拍摄者的前进方向与x轴正方向的夹角为β,两对象在拍摄画面中会形成直线轨迹,其中,已知坐标对象的轨迹与两对象的连线夹角为φ,则两对象的θ为:

[0020]

θ=β φ-π。

[0021]

本发明所取得的有益效果是:

[0022]

本系统通过对象识别、对象建模、对象定位、场景搭建先创建成与实际大致符合的三维场景,再通过虚拟相机对三维场景进行拍摄,将拍摄视频与实际场景的拍摄视频进行对比,根据对比的区别对每一个对象的坐标进行修正,不断重复对比和修正过程,直至不出现偏差,通过此方式能够搭建出一个误差极小的场景,再将该场景转换成地图数据,使最终的地图能够达到高精度的要求。

[0023]

为使能更进一步了解本发明的特征及技术内容,请参阅以下有关本发明的详细说

明与附图,然而所提供的附图仅用于提供参考与说明,并非用来对本发明加以限制。

附图说明

[0024]

图1为本发明整体结构框架示意图;

[0025]

图2为本发明数据构建模块构成示意图;

[0026]

图3为本发明相连状态示意图;

[0027]

图4为本发明两对象直线距离计算示意图;

[0028]

图5为本发明部分路段高精地图示意图。

具体实施方式

[0029]

以下是通过特定的具体实施例来说明本发明的实施方式,本领域技术人员可由本说明书所公开的内容了解本发明的优点与效果。本发明可通过其他不同的具体实施例加以施行或应用,本说明书中的各项细节也可基于不同观点与应用,在不悖离本发明的精神下进行各种修饰与变更。另外,本发明的附图仅为简单示意说明,并非依实际尺寸的描绘,事先声明。以下的实施方式将进一步详细说明本发明的相关技术内容,但所公开的内容并非用以限制本发明的保护范围。

[0030]

实施例一。

[0031]

本实施例提供了一种基于大数据的高精地图制作系统,结合图1,包括数据采集模块、数据构建模块和数据转换模块,所述数据采集模块用于拍摄目标区域的视频,所述数据构建模块用于对拍摄的数据进行处理构建成三维模型,所述数据转换模块用于对三维模型进行转换形成地图数据;

[0032]

所述数据构建模块包括对象识别单元、对象定位单元、对象管理单元、对象建模单元和场景展示单元,所述对象识别单元用于识别视频中的独立个体,所述独立个体称为对象,所述对象定位单元用于确定对象的位置信息,所述对象管理单元用于存储对象的所有信息,所述对象建模单元用于建立每个对象的三维模型,所述场景展示单元用于将所有对象的三维模型搭建成一个区域三维场景;

[0033]

所述对象定位单元以一个对象作为坐标原点,并根据视频数据依次计算出其余对象的坐标信息,坐标计算公式为:

[0034][0035]

其中,(x,y)为需要计算的对象坐标,(x0,y0)为已知的对象坐标,r为这两个坐标之间的直线距离,θ为两对象的坐标连线与x轴正方向之间的夹角;

[0036]

所述区域三维场景搭建完成后,设置虚拟相机,所述虚拟相机以与数据采集模块相同的拍摄参数对区域三维场景进行拍摄,得到对照视频,所述对象定位单元根据对照视频和数据采集模块拍摄的主视频进行比较,对每个对象的坐标进行修正得到横坐标修正量和纵坐标修正量,修正公式为:

[0037]

[0038][0039]

其中,x1(t)是对象出现在对照视频中的横坐标的时间函数,y1(t)是对象出现在对照视频中的纵坐标的时间函数,x2(t)是对象出现在主视频中的横坐标的时间函数,y2(t)是对象出现在主视频中的纵坐标的时间函数,t1是对象同时出现在主视频和对照视频中的最早时间,t2是对象同时出现在主视频和对照视频中的最晚时间,k为比例参数;

[0040]

所述对象识别单元采用边缘算法识别出疑似个体,当两个疑似个体在所有画面中均处于相连状态时,将这两个疑似个体合并成一个个体并作为一个独立的对象;

[0041]

所述数据采集模块拍摄的视频包括空中拍摄视频和地面拍摄视频,将空中拍摄视频中的一条视频作为主视频,其余视频作为辅视频;

[0042]

通过地面拍摄视频确定r,在地面拍摄过程中,两对象在画面中的距离在发生变化,当画面距离l最大时,拍摄者处在两对象连线的中垂线上,此时测量对象与拍摄者的距离为s,两对象与拍摄者的夹角为α,则两对象之间的距离r为:

[0043][0044]

通过空中拍摄视频确定θ,在空中拍摄过程中,拍摄者的前进方向与x轴正方向的夹角为β,两对象在拍摄画面中会形成直线轨迹,其中,已知坐标对象的轨迹与两对象的连线夹角为φ,则两对象的θ为:

[0045]

θ=β φ-π。

[0046]

实施例二。

[0047]

本实施例包含实施例一的全部内容,提供了一种基于大数据的高精地图制作系统,包括数据采集模块、数据构建模块和数据转换模块,所述数据采集模块用于拍摄目标区域的视频,所述数据构建模块用于对拍摄的数据进行处理构建成三维模型,所述数据转换模块用于对三维模型进行转换形成地图数据;

[0048]

结合图2,所述数据构建模块包括对象识别单元、对象定位单元、对象管理单元、对象建模单元和场景展示单元,所述对象识别单元用于识别出图像中的各个独立物体,每一个独立物体称为一个对象,所述对象管理单元为每一个对象建立档案,所述档案用于存储对象的相关信息,所述对象定位单元用于测量对象之间的相对距离并确定每个对象的位置信息,所述位置信息确定后存储在所述对象管理单元中对应对象的档案中,所述对象建模单元根据一个对象的多角度图像信息构建成一个完整的三维模型,所述三维模型构建完成后存储在所述对象管理单元对应对象的档案中,当所述对象管理单元中所有对象的位置信息和三维模型确定后,所述场景展示单元根据所述位置信息和三维模型搭建成一个区域三维场景,所述区域三维场景被发送至所述数据转换模块;

[0049]

所述拍摄的数据包括视频数据和拍摄者数据,所述视频数据为拍摄的视频画面信息,所述拍摄者数据为拍摄的位置以及角度信息,所述视频数据和所述拍摄者数据具有一致的时间条,拍摄者可以是无人机、地面采集车或背负式rtk相机;

[0050]

所述对象识别单元将一个视频作为主视频,其余视频作为辅视频,所述对象识别单元使用一个时间窗口从所述主视频中截取一段子主视屏,并获取该段子主视频中的拍摄者数据,根据所述拍摄者数据确定所述子主视频中的大致位置,然后根据所述大致位置和

辅视频的拍摄者数据从所述辅视频中截取对应的子辅视频,所述子辅视频具有和所述子主视频相同的大致位置;

[0051]

所述对象识别单元从所述子主视频中获取分析帧,所述分析帧之间具有相同的帧间隔,所述对象识别单元采用边缘算法计算出每个分析帧中的边缘线,根据边缘线以及边缘线所围成区域的色彩信息确定多个疑似个体,当两个疑似个体在不同的分析帧中均处于相连状态时,这两个疑似个体合并成一个疑似个体,结合图3,所述相连状态包括相邻、全部包含和部分包含;

[0052]

所述对象识别单元根据所述子辅视频对在子主视频中合并成的疑似个体进行分析,当出现该合并的疑似个体能够分成两个不相连的疑似个体时,再次拆分该合并的疑似个体;

[0053]

将疑似个体作为对象在所述对象管理单元中建立档案,并在档案中添加该对象所在的大致位置和色彩信息;

[0054]

所述对象识别模块改变时间窗口,不断重复上述过程,将在视频中出现的所有对象都在所述对象管理单元中建立档案;

[0055]

需要注意的是,在所述主视频中未出现,但在辅视频中出现的疑似个体也作为对象在所述对象管理单元中建立档案;

[0056]

特别的,所述对象识别单元在视频中识别出的人将不会在对象管理单元中建立档案;

[0057]

所述对象建模单元根据所述对象管理单元档案中的大致位置和色彩信息,从主视频和辅视频中获取到含有该对象的视频段作为建模参考视频,所述对象建模单元根据所述建模参考视频创建三维模型,所述对象建模单元根据所述建模参考视频对应的拍摄者数据确定三维模型在某一视角下的表面纹理;

[0058]

所述对象定位单元根据以一个对象作为坐标原点,该对象可以是任意一个对象,但为方便起见,以主视频中最先出现的画面中体积最大的对象作为原点对象,并根据主视频的拍摄顺序依次计算其余对象的坐标;

[0059]

坐标计算公式为:

[0060][0061]

其中,(x,y)为需要计算的对象坐标,(x0,y0)为已知的对象坐标,r为这两个坐标之间的直线距离,θ为两对象的坐标连线与x轴正方向之间的夹角;

[0062]

计算完所有对象的坐标后,所述场景展示单元根据坐标对每个对象的三维模型进行放置,搭建成区域三维场景;

[0063]

上述计算公式中的r和θ均是将两个对象作为质点处理计算得到的,且r通过地面拍摄数据计算得到,θ通过空中拍摄数据计算得到;

[0064]

在地面拍摄过程中,结合图4,两对象在画面中的距离在发生变化,当画面距离l最大时,拍摄者处在两对象连线的中垂线上,此时测量对象与拍摄者的距离为s,两对象与拍摄者的夹角为α,则两对象之间的距离r为:

[0065]

[0066]

在空中拍摄过程中,拍摄者的前进方向与x轴正方向的夹角为β,两对象在拍摄画面中会形成直线轨迹,其中,已知坐标对象的轨迹与两对象的连线夹角为φ,则两对象的θ为:

[0067]

θ=β φ-π;

[0068]

由于坐标计算中的r和θ存在误差,需要对区域三维场景中的对象进行位置调整;

[0069]

在所述区域三维场景中设置虚拟相机,所述虚拟相机根据主视频的拍摄者数据对区域三维场景进行拍摄,得到对照视频,所述对象定位单元对主视频和对照视频进行对比,当对照视频中的对象三维模型与主视频中的实物在画面中的位置出现偏差时,根据偏差值对对象三维模型的坐标进行调整,所有对象的坐标调整后,再次重新拍摄对照视频并调整坐标,不断重复该过程,直至对照视频中所有对象的三维模型和实物在画面中的位置一致;

[0070]

出现偏差时的调整公式为:

[0071][0072][0073]

其中,x1(t)是对象出现在对照视频中的横坐标的时间函数,y1(t)是对象出现在对照视频中的纵坐标的时间函数,x2(t)是对象出现在主视频中的横坐标的时间函数,y2(t)是对象出现在主视频中的纵坐标的时间函数,t1是对象同时出现在主视频和对照视频中的最早时间,t2是对象同时出现在主视频和对照视频中的最晚时间,k为比例参数;

[0074]

对于只出现在辅视频中的对象,所述虚拟相机根据辅视频的拍摄者数据对区域三维场景进行拍摄得到对照视频,并与辅视频中进行对比对这类对象的坐标位置进行调整;

[0075]

所述数据转换模块对所述区域三维场景中的对象进行识别,结合图5,对每个对象赋予基础属性,所述基础属性分为道路、固定物和移动物,所述数据转换模块以道路对象为基准,根据道路的宽度和长度等信息建立通行区域,所述数据转换模块根据区域三维场景中固定物在通行区域中的占位在所述通行区域中设立碰撞区域,所述数据转换模块根据三维场景中移动物在通行区域中的占位在所述通行区域中设立可疑区域,所述可疑区域会随着移动物的移动而发生变化;

[0076]

所述数据转换模块为道路属性的对象添加通行属性,所述通行属性包括行车方向、斑马线、限速值、禁停区域、道路坡度,所述通行属性可在最后生成的地图中进行人为编辑。

[0077]

以上所公开的内容仅为本发明的优选可行实施例,并非因此局限本发明的保护范围,所以凡是运用本发明说明书及附图内容所做的等效技术变化,均包含于本发明的保护范围内,此外,随着技术发展其中的元素可以更新的。

再多了解一些

本文用于企业家、创业者技术爱好者查询,结果仅供参考。